1、安装

bash

conda create -n llama_factory python=3.11

# 如果要加学术加速的话,git clone https://ghfast.top/https://github.com/hiyouga/LLaMA-Factory.git

git clone https://github.com/hiyouga/LLaMA-Factory.git

cd LLaMA-Factory

source activate llama_factory

pip install -e .2、使用

bash

# 打开UI页面进行微调

cd /root/autodl-tmp/LLaMA-Factory

source activate llama_factory

llamafactory-cli webui3、训练设置

将这要训练的数据集丢到/root/autodl-tmp/LLaMA-Factory/data里面

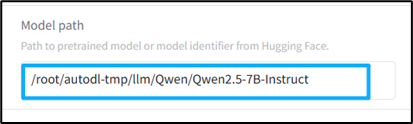

页面上的设置:

调整batch size,让GPU使用达到80%左右

4、llamafactory要求的数据集格式

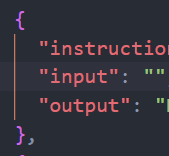

单论对话

instruction是问,output是回答

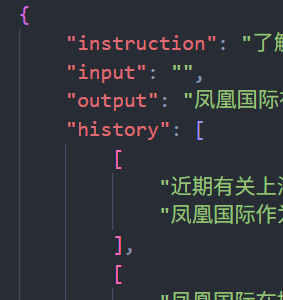

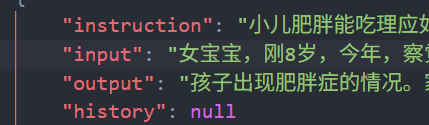

多轮对话

instruction是最新一轮的问,output是最新一轮的回答,history是之前的问和回答

input是对instruction数据的补充。

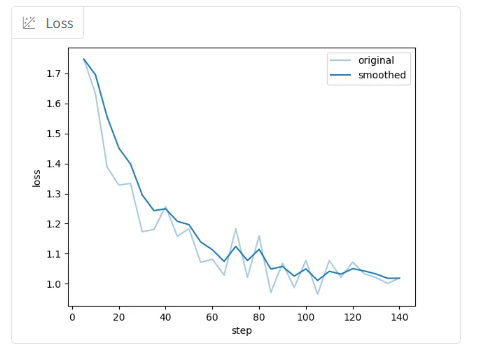

4、查看结果

将训练得到的lora模型,加载到checkpoint里