打工人的痛:内网 Kafka 调试,比搬砖还累

你有没有过这种经历?

在家远程办公,刚接了个 Kafka 新业务模块的调试需求,结果发现:公司测试环境的 Kafka 集群藏在内网,没公网 IP,9092 端口被防火墙锁得死死的。想创建个测试 Topic?连不上 Broker;想跑个生产者发消息?本地终端直接报错;想验证消费逻辑?只能提交代码等 CI/CD 部署,或者卑微求运维临时开端口 ------ 一套流程走下来,半天时间没了,喝口水的功夫,隔壁同事都写完 3 个接口了。

要是早知道 cpolar,这事儿能简单到像喝可乐:不用改 Kafka 配置,不用求运维开防火墙,5 分钟把内网 Kafka 的 9092 端口映射到公网,本地电脑直接连公网地址,想怎么测就怎么测,生产者发消息、消费者收消息、创建 Topic,全程丝滑,比在公司内网操作还顺手。

Kafka+cpolar 的出色功能

Kafka 本身就像个 "高速消息快递站",能扛住高并发的消息收发,给微服务、大数据场景当 "数据管道";但这个快递站只开在 "内网小区" 里,外面的人进不来。

而 cpolar 就是这个小区的 "万能门禁",不用改小区的任何布局(Kafka 配置),不用找物业(运维)开大门(防火墙),一键给快递站开个 "公网小门":

- 支持 TCP 协议,完美适配 Kafka/Zookeeper 的端口映射;

- 能生成临时 / 固定公网 TCP 地址,避免每次调试都换地址;

- 跨系统兼容,Linux/Windows/macOS 都能用,和 Kafka 的部署环境无缝适配;

- 无需公网 IP,不用配置路由器,小白也能 5 分钟上手。

实用场景

场景 1:远程办公调试 Kafka 生产消费逻辑(打工人刚需)

- 痛点:居家办公,内网 Kafka 集群无公网访问权限,调试新业务需反复提交代码到 CI/CD,或求运维临时开放端口,沟通成本高、效率低;

- 爽点:用 cpolar 映射内网 Kafka 的 9092 端口到公网,本地终端直接执行

kafka-console-producer.sh发送消息、kafka-console-consumer.sh消费消息,实时验证逻辑,改一行代码测一次,10 分钟搞定原本半天的活儿。

场景 2:跨团队协作测试 Kafka 数据流转(团队协作)

- 痛点:测试团队在异地,无法访问内网 Kafka 集群验证数据准确性,只能靠开发人员 "口头反馈",易出测试遗漏;

- 爽点:运维给测试团队开放 cpolar 生成的固定公网地址,测试人员本地就能模拟生产环境发消息、查 Topic,直接验证数据流转是否符合预期,协作效率提升 80%。

cpolar 内网穿透技术带来的便利

用 cpolar 打通内网 Kafka 到公网的链路后,你会发现之前的 "麻烦事" 全变成了 "顺手事":

- 不用求任何人:再也不用找运维提权限、开防火墙端口,自己在 cpolar 上点几下,公网地址就有了,调试自由拿捏;

- 成本几乎为 0:cpolar 支持免费使用临时公网地址,固定地址也无需额外买服务器 / 公网 IP,个人调试完全够用;

- 操作无门槛:不用懂复杂的网络配置,无论是 Linux 终端敲一键安装命令,还是可视化 Web 界面配置隧道,跟着指引走,新手也能秒会;

- 不改动原有环境:映射公网的过程中,Kafka 的配置、Zookeeper 的参数、内网的网络架构都不用动,调试完关掉隧道,内网环境恢复原样,零风险;

- 跨设备 / 跨网络通用:不管是用家里的电脑、咖啡厅的笔记本,还是出差的手机(终端工具),只要能上网,就能连到内网 Kafka,随时随地调试;

- 地址可固定:临时地址不够用?cpolar 能保留固定 TCP 公网地址,一次配置,长期使用,不用每次调试都改生产者 / 消费者的连接地址;

- 兼容全流程:不仅能调生产消费,还能远程创建 Topic、查看 Topic 列表、监控 Kafka 运行状态,内网能做的事,公网全能干。

总结

Kafka 是分布式系统的 "消息大动脉",但内网部署的特性让远程调试成了技术人的 "老大难";而 cpolar 就像给这条大动脉接了一根 "公网延伸管",无需大动干戈改配置、求权限,就能让内网 Kafka 突破网络限制,实现跨网络的自由访问。

对开发、运维、SRE 来说,这套组合拳直接把 Kafka 调试的效率拉满:远程办公不用等、协作测试不用催、权限申请不用求,5 分钟搞定网络打通,把更多时间花在核心业务上,而不是繁琐的环境适配。

不管你是刚接触 Kafka 的新手,还是常年跟集群打交道的老司机,cpolar 都能让内网 Kafka 的使用体验 "升一个档次"------ 毕竟,技术人的快乐,就是把复杂的事变简单。

好用的组合当然要优先装备!教程准备好喽!加油!

本文将深入Kafka的核心原理------从分区与副本机制、日志存储结构、Controller选举,到生产者幂等性、消费者位移管理,并结合多年线上实践经验,总结出一套高可用、高性能、易运维的Kafka最佳实践。无论你是刚接触Kafka的开发者,还是负责生产环境稳定性的SRE,都能从中获得可落地的参考方案,真正打造出稳定、可靠、高效的消息中间件系统。

1.安装前准备

1.1 操作系统要求

Kafka可以在多种 [Linux 发行版](https://so.csdn.net/so/search?q=Linux 发行版&spm=1001.2101.3001.7020)上运行,本文以CentOS 7为例,其他发行版步骤类似,只需调整包管理命令。

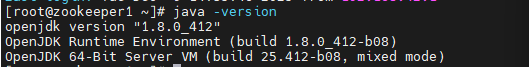

1.2 java环境要求

Kafka基于Java开发,需安装 JDK 8 或以上版本:

shell

java -version

1.3 安装JDK

下载 JDK

- Oracle 官网:https://www.oracle.com/java/technologies/javase/javase-jdk8-downloads.html

- 或 OpenJDK 官网下载 Linux 版本

- 示例(OpenJDK 8):

shell

wget https://download.java.net/openjdk/jdk8u41/ri/openjdk-8u41-b04-linux-x64-14_jan_2020.tar.gz解压安装包

shell

mkdir -p /usr/local/java

tar -zxvf openjdk-8u41-b04-linux-x64-14_jan_2020.tar.gz -C /usr/local/java配置环境变量

在 /etc/profile 末尾追加:

shell

export JAVA_HOME=/usr/local/java/jdk1.8.0_41

export PATH=$PATH:$JAVA_HOME/bin使配置生效:

shell

source /etc/profile验证安装

shell

java -version2.安装 Kafka

2.1 下载 Kafka

- 官网:https://kafka.apache.org/downloads

- 示例版本:3.6.2

linux系统可以直接命令一键安装:

shell

wget https://downloads.apache.org/kafka/3.9.1/kafka_2.13-3.9.1.tgz

tar -xzf kafka_2.13-3.9.1.tgz

mv kafka_2.13-3.9.1 kafka

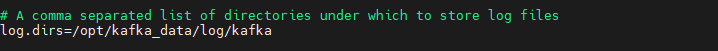

2.2 创建数据日志目录

在kafka解压目录同一路径下:创建一个kafka_data,用于装kafka和zookeeper的log和数据等:

shell

mkdir -p /opt/kafka_data

mkdir -p /opt/kafka_data/zookeeper

mkdir -p /opt/kafka_data/log

mkdir -p /opt/kafka_data/log/kafka

mkdir -p /opt/kafka_data/log/zookeeper

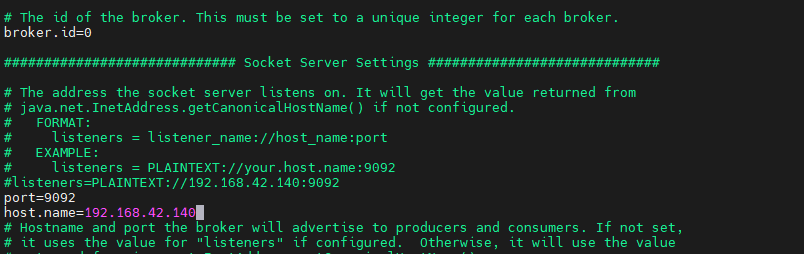

2.3 配置Kafka配置文件

编辑这个文件:

shell

broker.id=0

port=9092

host.name=ip

log.dirs=/opt/kafka_data/log/kafka

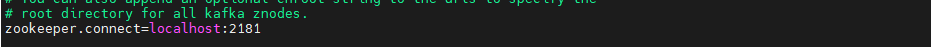

zookeeper.connect=localhost:2181

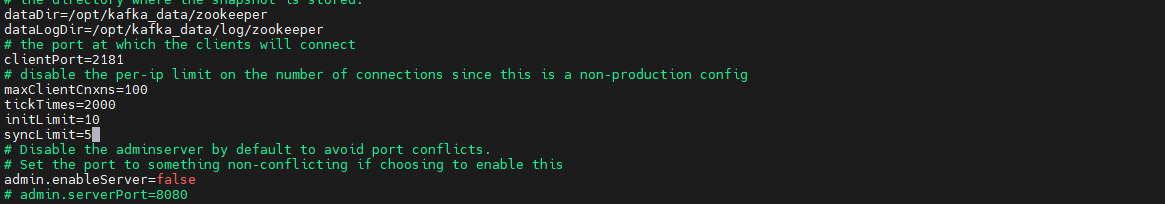

2.4 配置zookeeper配置文件

shell

dataDir=/opt/kafka_data/zookeeper

dataLogDir=/opt/kafka_data/log/zookeeper

clientPort=2181

maxClientCnxns=100

tickTimes=2000

initLimit=10

syncLimit=5

3.启动与停止Kafka

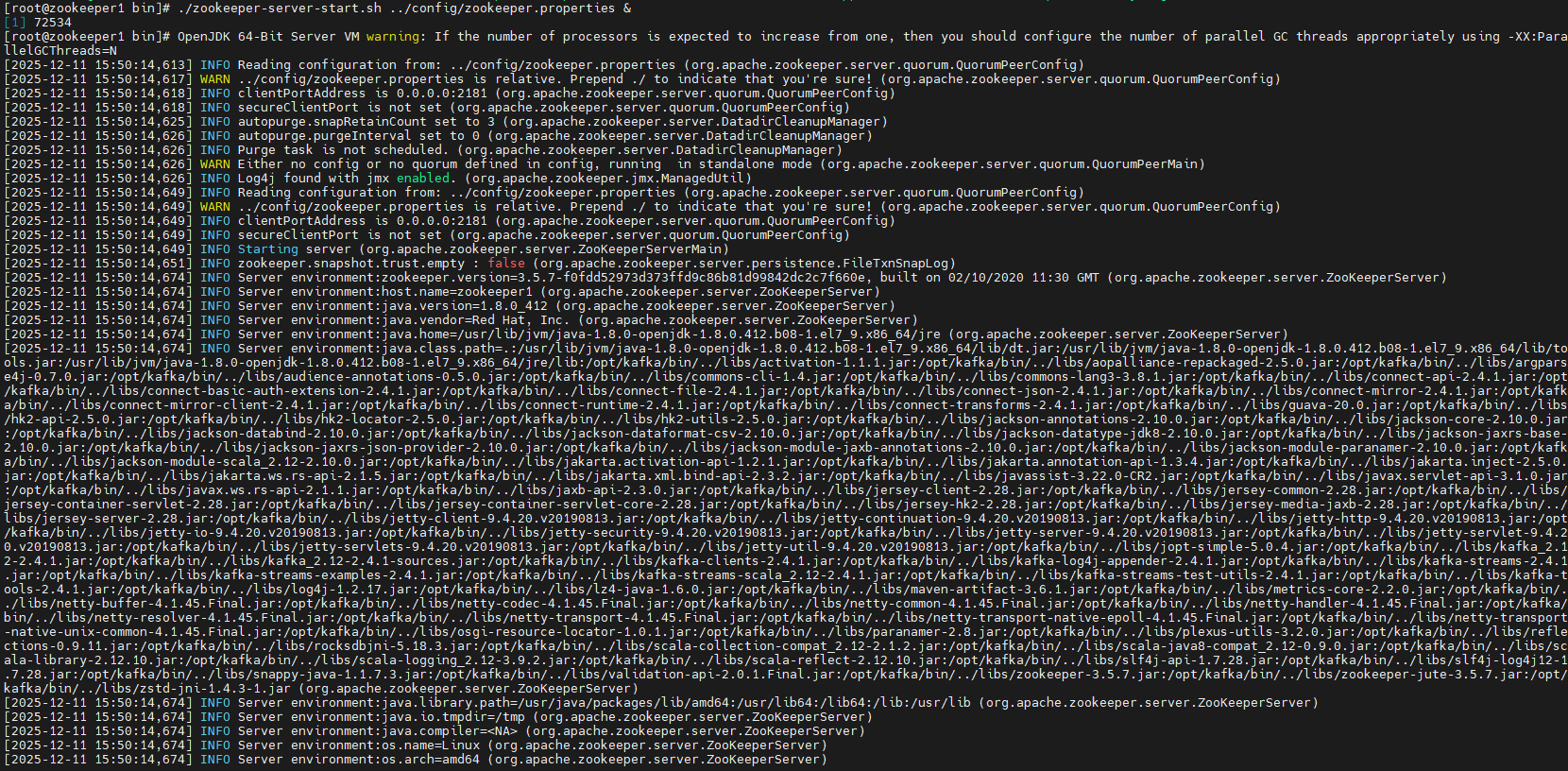

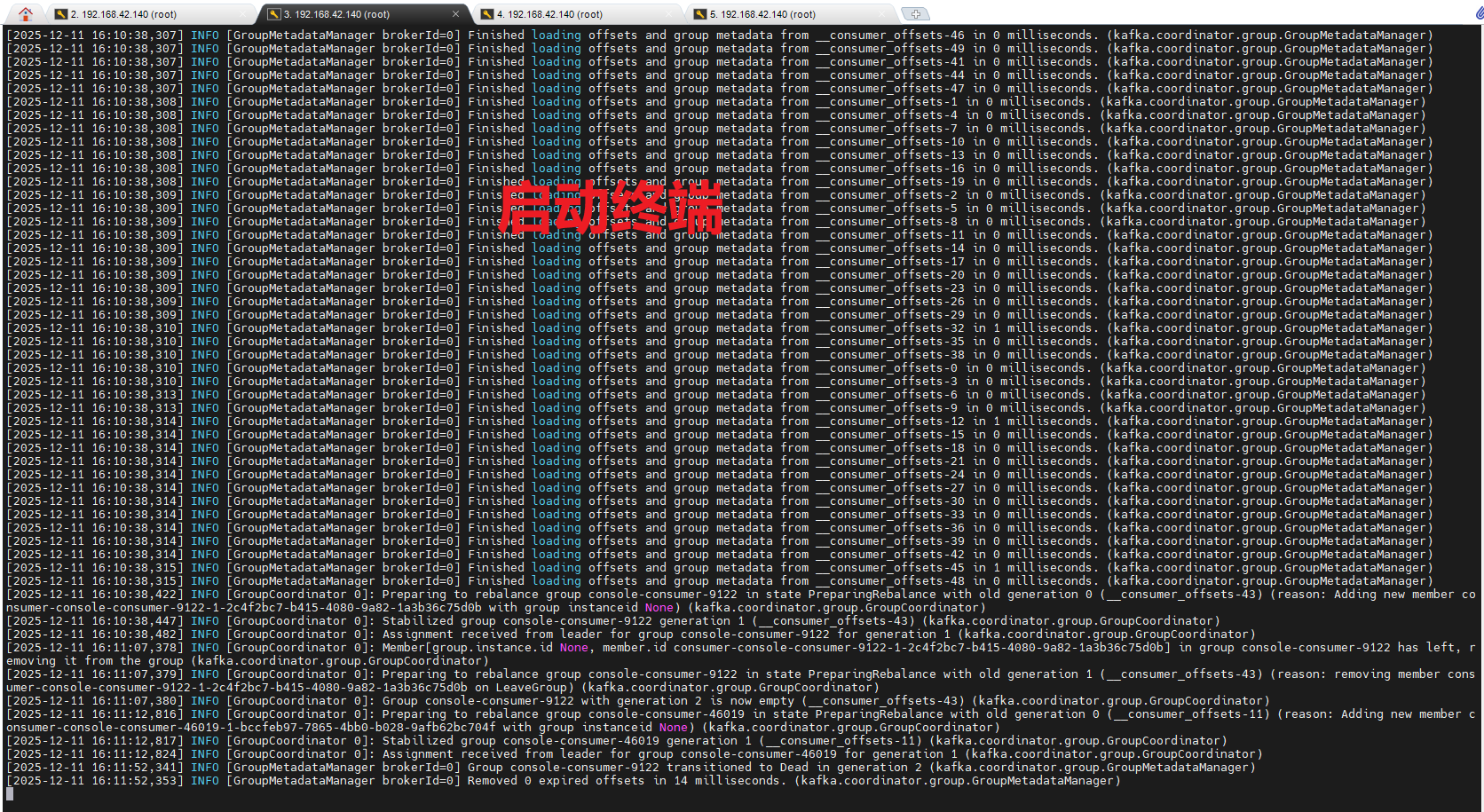

3.1开启ZooKeeper

开启ZooKeeper:

shell

./zookeeper-server-start.sh ../config/zookeeper.properties &

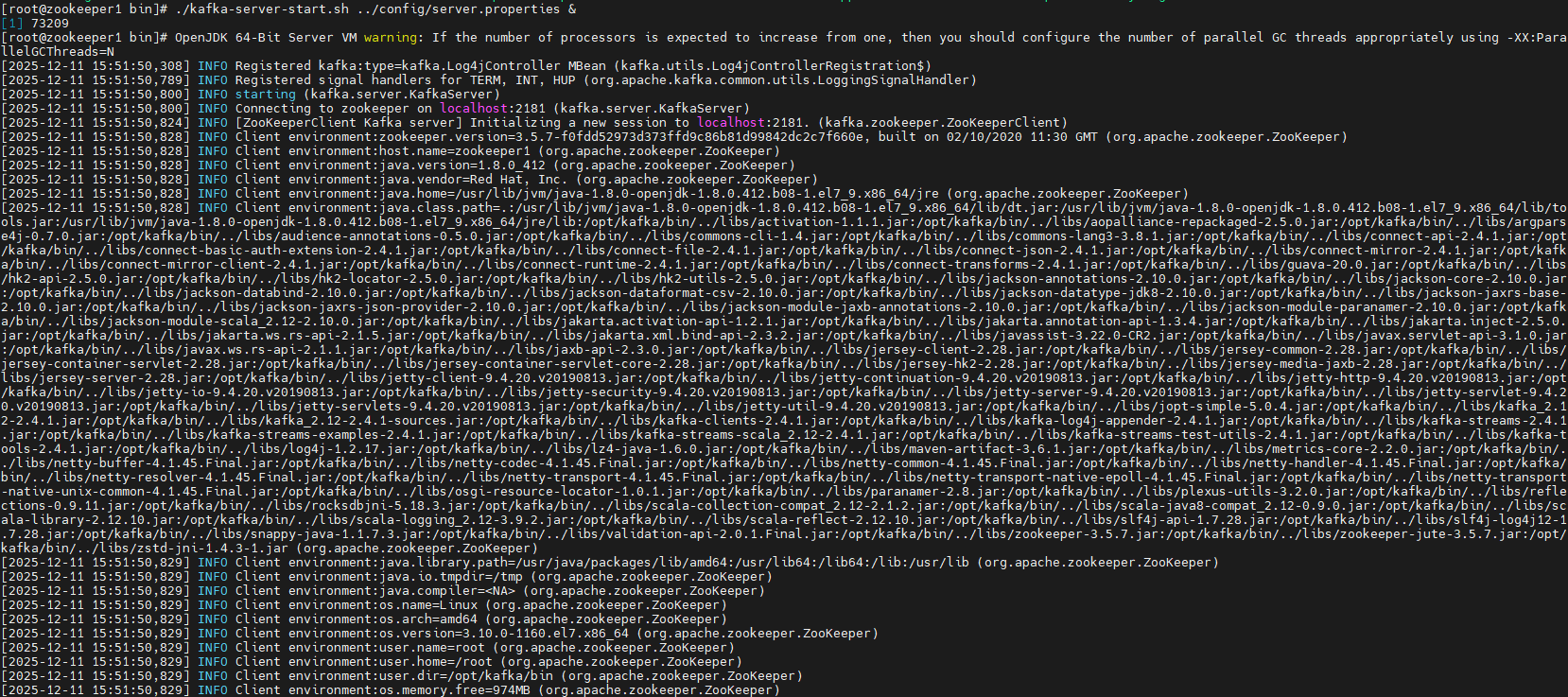

3.2启动Kafka:

shell

./kafka-server-start.sh ../config/server.properties &

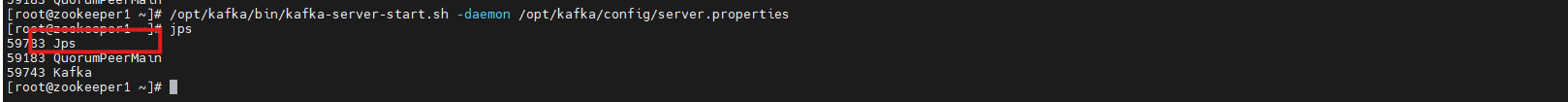

验证是否启动成功:

shell

jps输出应包含:

shell

QuorumPeerMain

Kafka

3.3停止zookeeper

shell

./zookeeper-server-stop.sh ../config/zookeeper.properties &3.4停止kafkfa

shell

./kafka-server-stop.sh ../config/server.properties &4.创建生产者topic和消费者topic简单示例

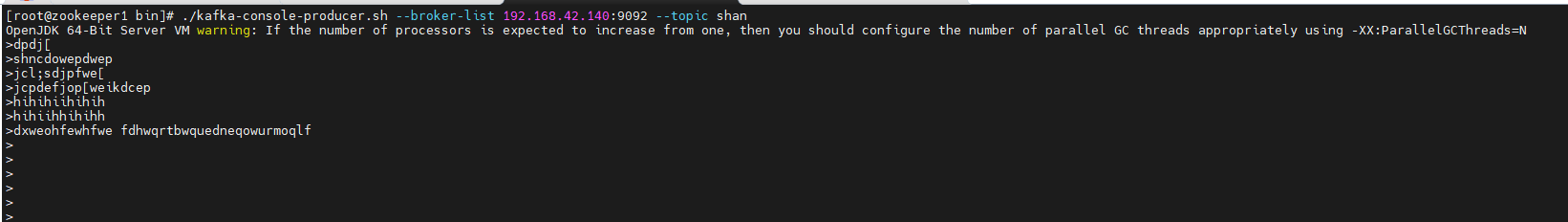

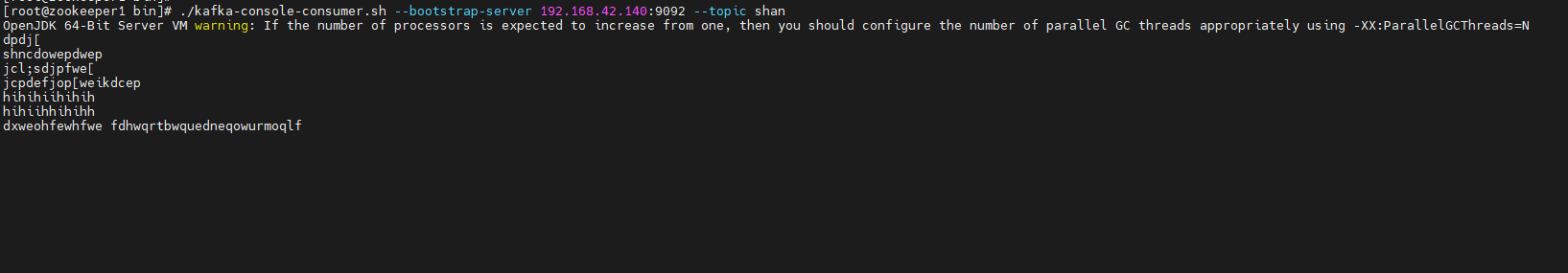

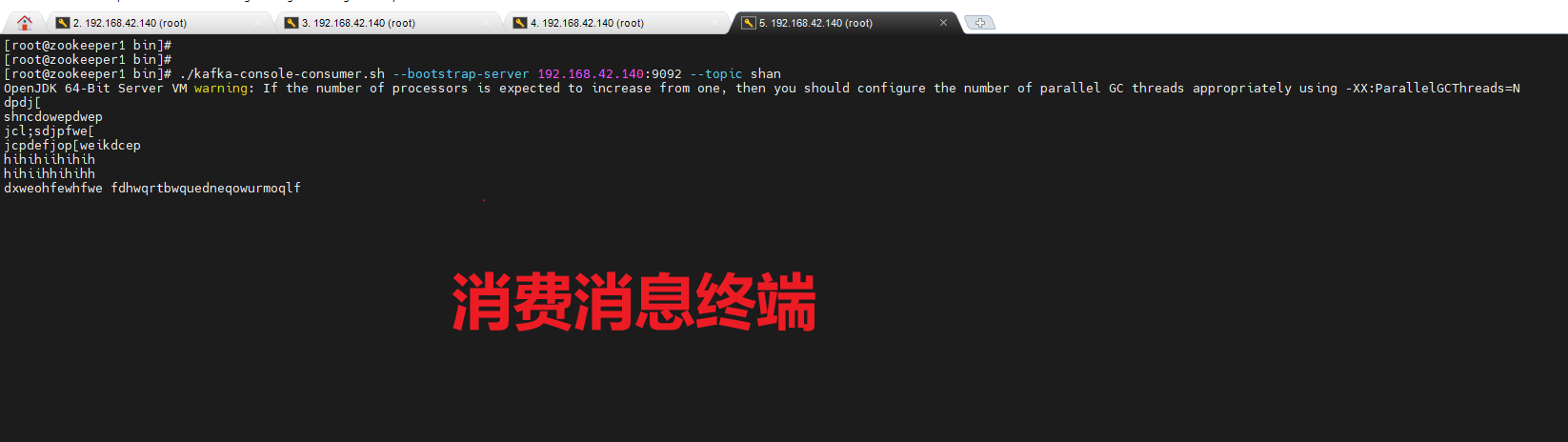

在一个终端执行创建生产者: (推消息到shan)

shell

cd /opt/bin/ #进入kafka目录

./kafka-console-producer.sh --broker-list 192.168.42.140:9092 --topic wd_test #wd_test你要建立的topic名

在一个终端执行创建消费者: (从shan上消费消息)

shell

cd /opt/bin/ #进入kafka目录

./kafka-console-producer.sh --broker-list 192.168.42.140:9092 --topic wd_test #消费shan中topic消息

查看效果: 一个终端不断输入推送的消息,另一个终端则消费这个消息

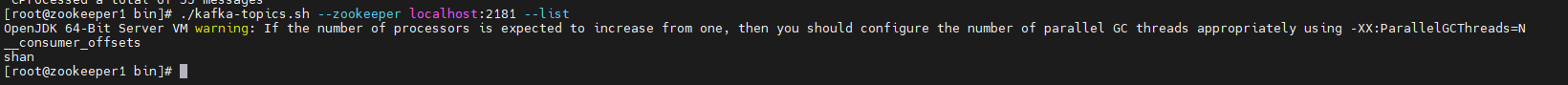

查看当前主题:

shell

./kafka-topics.sh --zookeeper localhost:2181 --list

你正在家里远程办公,突然接到任务:需要验证一个新业务模块的消息生产与消费逻辑。

但Kafka集群部署在公司内网测试环境,没有公网IP,防火墙也不开放9099/9092端口------你既无法连接Broker创建Topic,也无法从本地启动生产者或消费者进行调试。

传统的做法是:

- 提交代码到CI/CD触发部署(慢)

- 求运维临时开防火墙(麻烦)

- 或干脆去公司(不现实)

有没有更敏捷的方式?

有!借助内网穿透工具,我们可以将内网Kafka的9092端口安全暴露到公网。

只需一条隧道命令,你的本地开发机就能像在内网一样:

- 通过 kafka-topics.sh 创建测试 Topic

- 用 kafka-console-producer.sh 发送消息

- 用 kafka-console-consumer.sh 实时消费验证

整个过程无需改动 Kafka 配置、无需网络权限审批,5 分钟打通内外网,让开发调试回归高效。

跟我一起来操作吧~

5.安装cpolar内网穿透工具

cpolar 可以将你本地电脑中的服务(如 SSH、Web、数据库)映射到公网。即使你在家里或外出时,也可以通过公网地址连接回本地运行的开发环境。

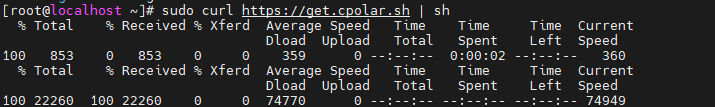

❤️以下是安装cpolar步骤:

使用一键脚本安装命令:

shell

sudo curl https://get.cpolar.sh | sh

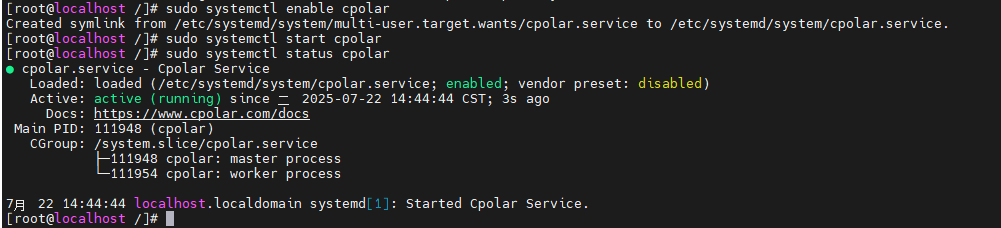

安装完成后,执行下方命令查看cpolar服务状态:(如图所示即为正常启动)

shell

sudo systemctl status cpolar

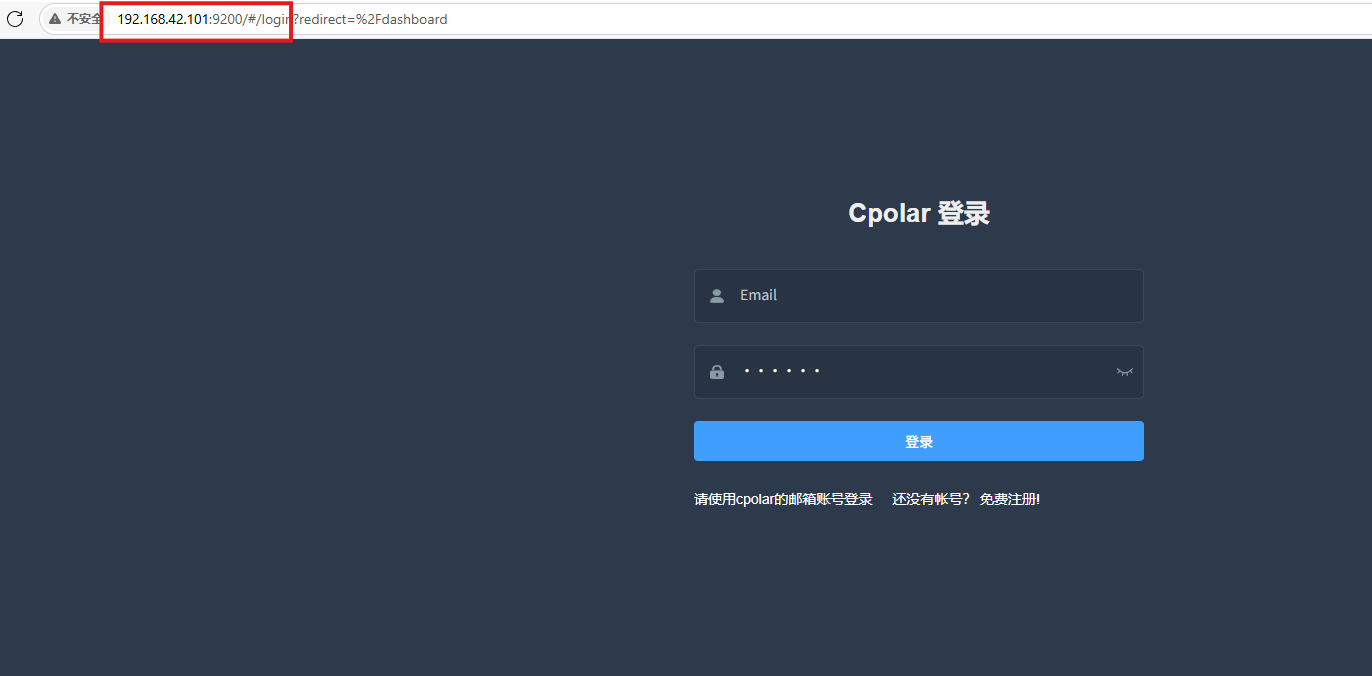

Cpolar安装和成功启动服务后,在浏览器上输入虚拟机主机IP加9200端口即:【ip:9200】访问Cpolar管理界面,使用Cpolar官网注册的账号登录,登录后即可看到cpolar web 配置界面,接下来在web 界面配置即可:

打开浏览器访问本地9200端口,使用cpolar账户密码登录即可,登录后即可对隧道进行管理。

6.配置公网地址

通过配置,你可以在本地 WSL 或 Linux 系统上运行 SSH 服务,并通过 Cpolar 将其映射到公网,从而实现从任意设备远程连接开发环境的目的。

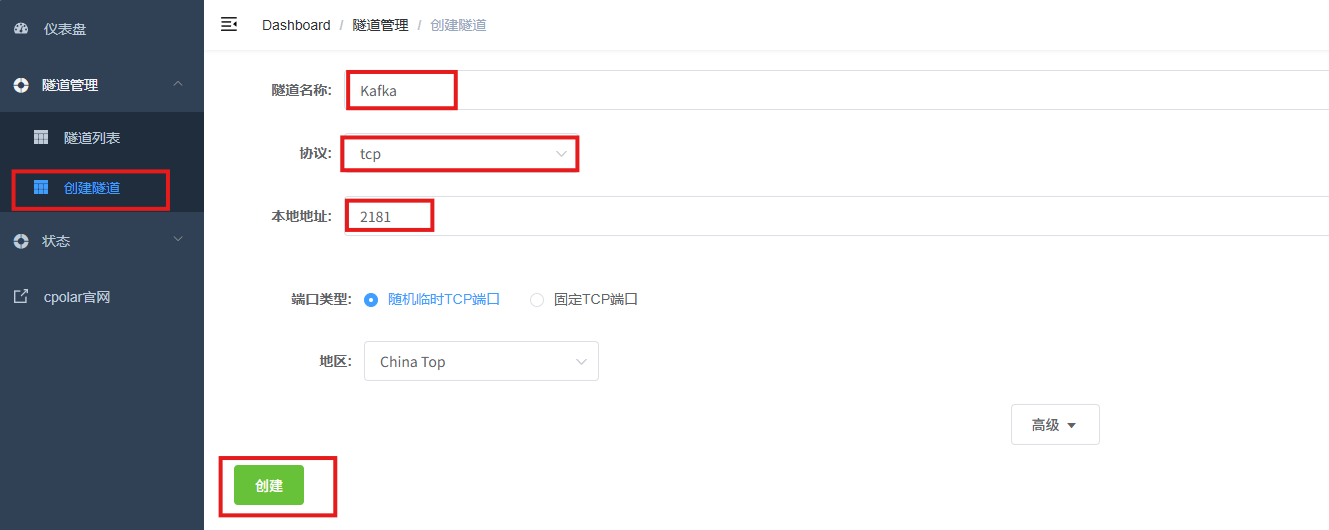

- 隧道名称:可自定义,本例使用了:zookeeper,注意不要与已有的隧道名称重复

- 协议:tcp

- 本地地址:2181

- 端口类型:随机临时TCP端口

- 地区:China Top

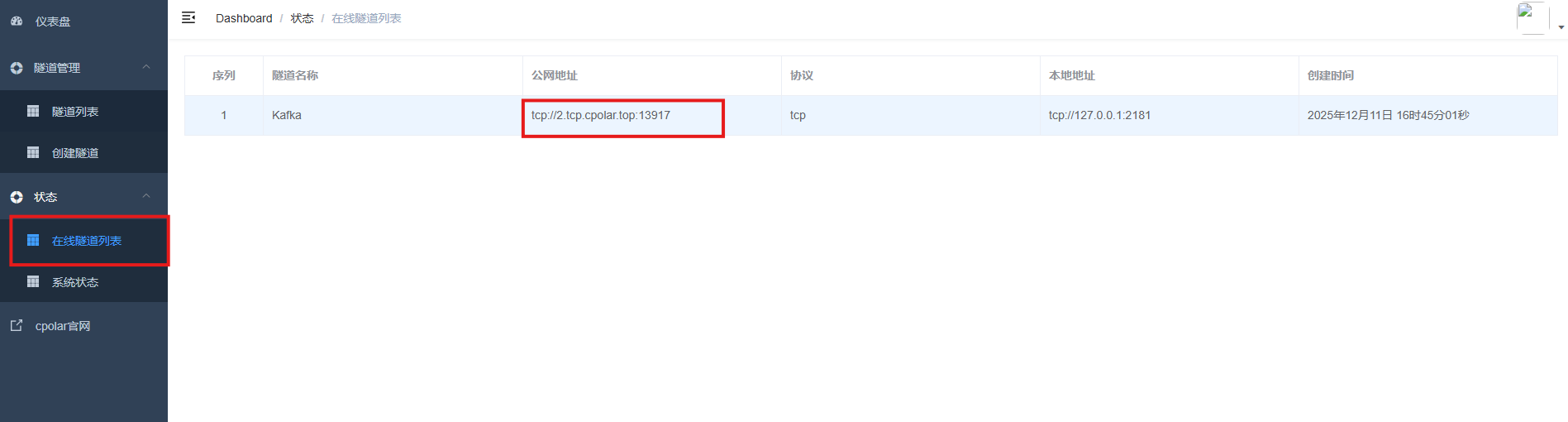

创建成功后,打开左侧在线隧道列表,可以看到刚刚通过创建隧道生成了公网地址,接下来就可以在其他电脑或者移动端设备(异地)上,使用任意一个地址在终端中访问即可。

-

tcp 表示使用的协议类型

-

2.tcp.cpolar.top是 Cpolar 提供的域名

-

13917是随机分配的公网端口号

通过Cpolar提供的公网地址和端口,Kafka就能从本地启动生产者或消费者进行调试啦!

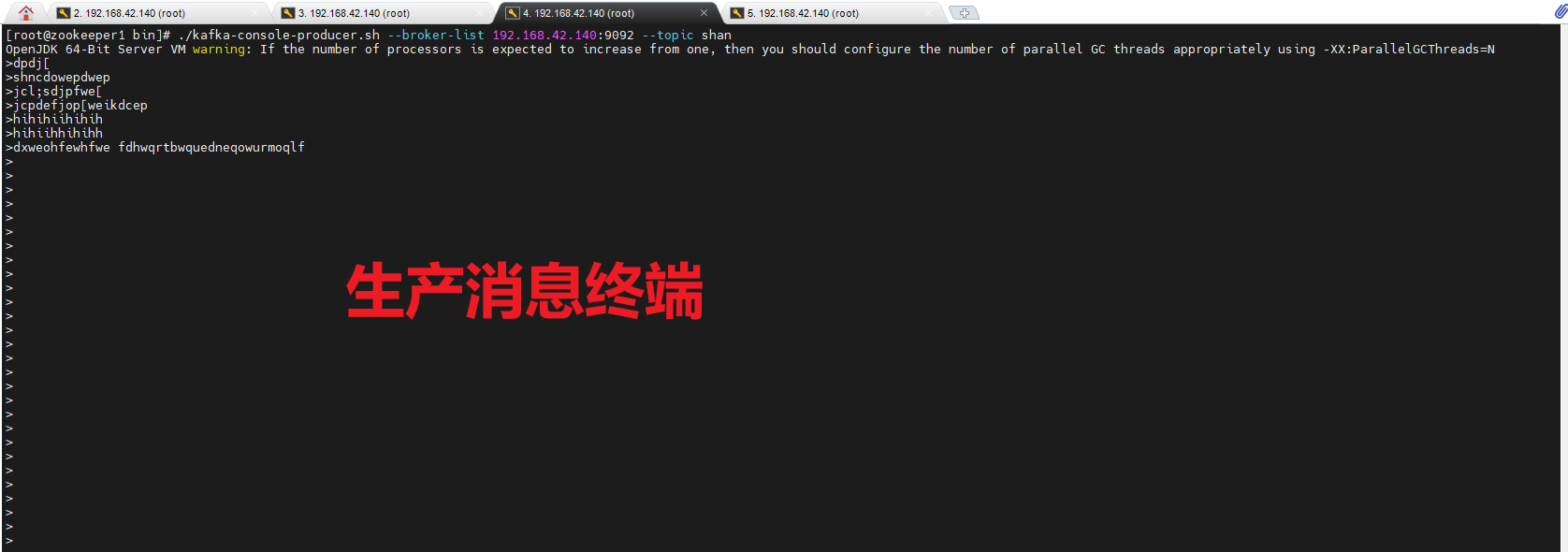

生产:

shell

./kafka-console-producer.sh --broker-list 2.tcp.cpolar.top:13917 --topic shan消费:

shell

./kafka-console-consumer.sh --bootstrap-server 2.tcp.cpolar.top:13917 --topic shan7.保留固定TCP公网地址

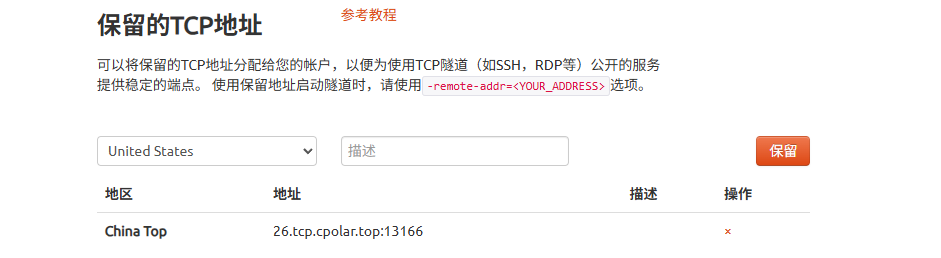

使用cpolar为其配置TCP地址,该地址为固定地址,不会随机变化。

选择区域和描述:有一个下拉菜单,当前选择的是"China Top"。

右侧输入框,用于填写描述信息。

保留按钮:在右侧有一个橙色的"保留"按钮,点击该按钮可以保留所选的TCP地址。

列表中显示了一条已保留的TCP地址记录。

-

地区:显示为"China Top"。

-

地址:显示为"26.tcp.cpolar.top:13166"。

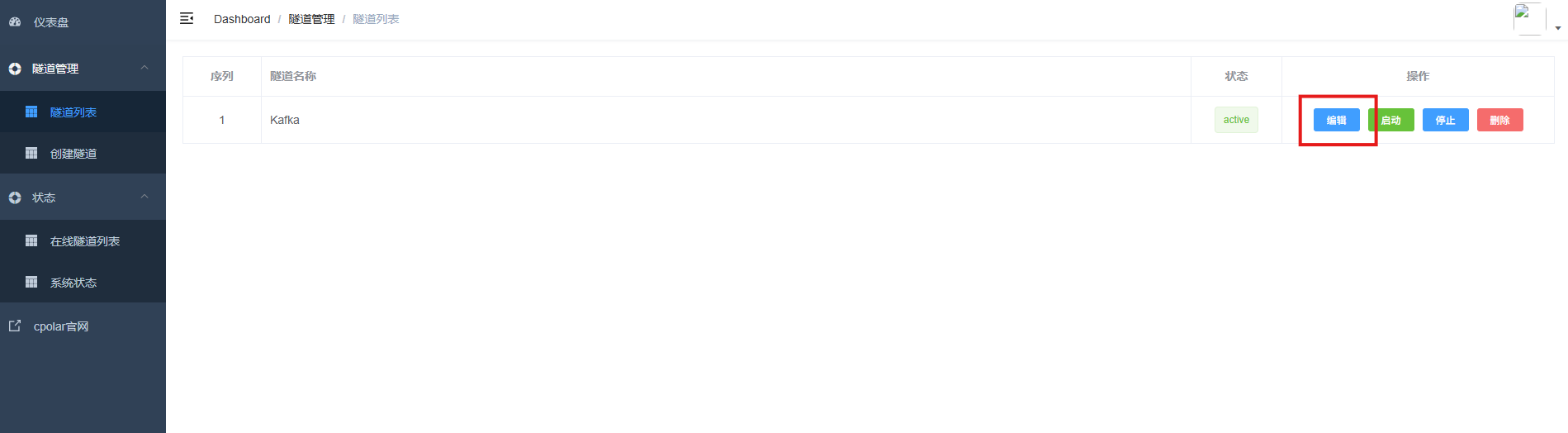

登录cpolar web UI管理界面,点击左侧仪表盘的隧道管理------隧道列表,找到所要配置的隧道Kafka,点击右侧的编辑。

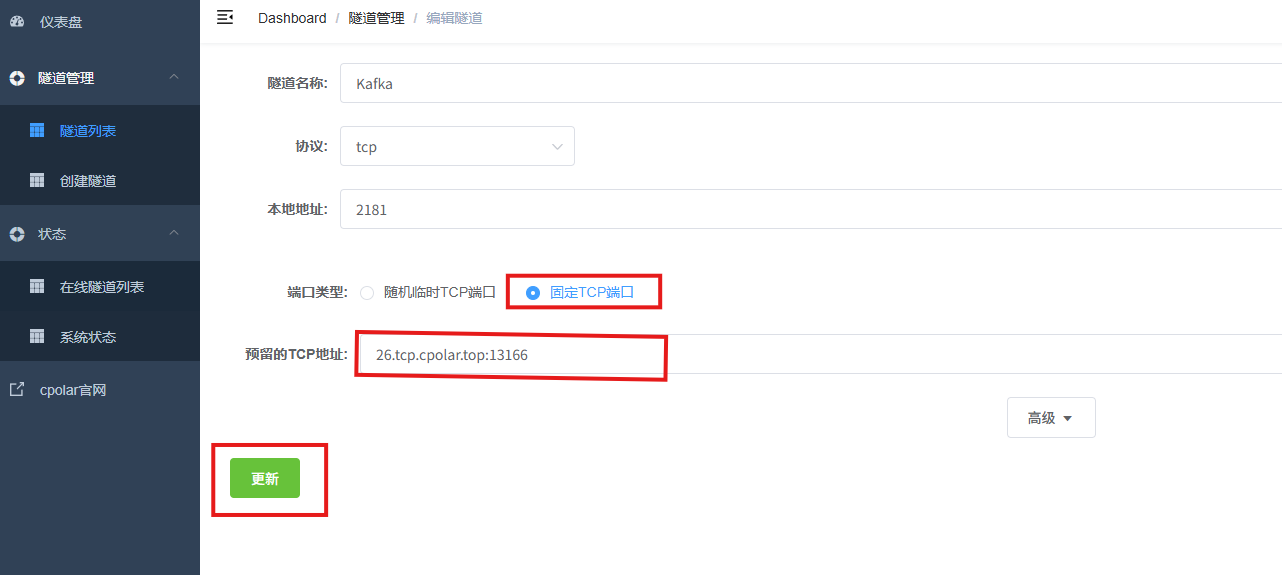

修改隧道信息,将保留成功的TCP端口配置到隧道中。

- 端口类型:选择固定TCP端口

- 预留的TCP地址:填写保留成功的TCP地址

点击更新。

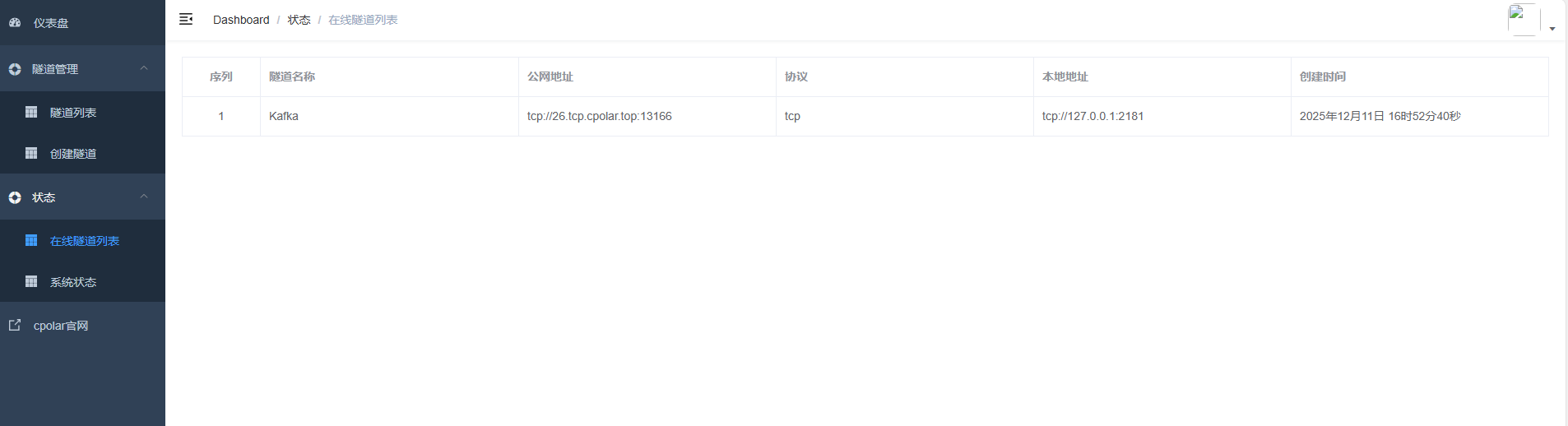

创建完成后,打开在线隧道列表,此时可以看到随机的公网地址已经发生变化,地址名称也变成了保留和固定的TCP地址。

最后就可以使用命令测试啦!

总结

Kafka的强大不仅在于其性能,更在于其围绕"可靠性""可扩展性""可观测性"构建的完整生态。掌握其核心原理,结合严谨的配置与运维规范,才能真正发挥Kafka在实时数据处理、事件驱动架构和微服务解耦中的价值,打造坚如磐石的消息基础设施。

感谢您对本篇文章的喜爱,有任何问题欢迎留言交流。cpolar官网-安全的内网穿透工具 | 无需公网ip | 远程访问 | 搭建网站