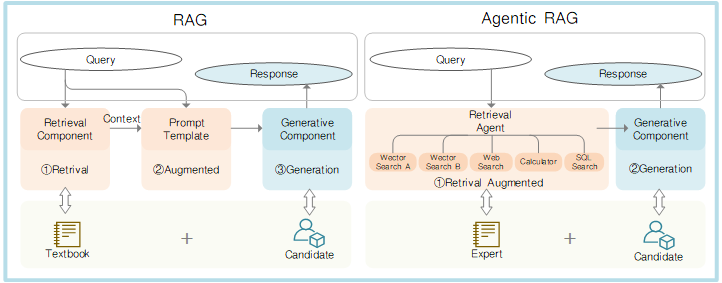

检索增强生成(Retrieval-Augmented Generation,简称RAG) 作为大模型落地应用的核心支撑技术,其核心逻辑的本质的是为大语言模型"外挂"独立知识源,补充实时、专业且精准的上下文信息。这种方式不仅能大幅提升模型生成内容的准确性与时效性,更能从根源上抑制大模型常见的"幻觉问题"------也就是LLM在缺乏事实依据时,依然自信编造虚假信息的现象,这也是小白入门大模型、程序员落地大模型项目时最需要规避的痛点之一。

无论是刚接触大模型的编程小白,还是有过简单业务落地经验的开发者,在实际操作中都会发现,传统RAG的局限性十分突出,常常让人束手无策:

- 检索僵化无补救:属于"一锤子买卖"模式,一旦首次检索未匹配到相关内容,后续的答案生成就会直接拉胯,完全没有调整和补救的空间,小白很容易因此卡壳;

- 知识边界太局限:只能调用提前预设好的知识库内容,面对知识库之外的新信息、动态更新的内容,完全无法应对,不符合实际项目中的多样化需求;

- 策略固定不灵活:检索逻辑是固定不变的流水线式操作,无法根据用户问题的复杂度、模糊程度,动态调整检索方式和策略,实用性大打折扣;

- 复杂问题难应对:遇到多步骤、跨领域的复杂查询,需要人工反复调整检索关键词、筛选检索结果,不仅耗时费力,效率极低,对小白的门槛也很高。

而Agentic RAG的诞生,正是为了精准解决传统RAG的这些痛点,让大模型的知识调用更智能、更实用。今天这篇干货文,专为CSDN上的小白和程序员打造,全面拆解Agentic RAG------这个给传统RAG配上"智能大脑"的革命性架构,带你搞懂它的核心逻辑、工作模式,更有可直接上手的实践教程,帮你快速入门,轻松掌握大模型落地的关键技术。

一、什么是Agentic RAG?用"考场类比"讲明白

很多小白和程序员刚接触Agentic RAG时会觉得抽象,其实用我们熟悉的"考场场景",就能轻松拆解它的核心组件,一看就懂、一学就会:

1. 传统RAG:带课本进考场的"机械考生"

传统RAG就像一位勤奋但缺乏变通的考生,全程被动执行流程:

📚 核心工作流:用户提问 → 问题向量化(转化为计算机能理解的语义向量) → 检索知识库中相似的文本片段 → 拼接问题与检索结果作为上下文 → 传给LLM生成答案

核心缺陷:无思考、纯被动。它不会深究"用户真正想解决什么问题",不会判断"检索到的内容是否真的匹配需求",更不会思考"是否需要分步骤检索多个信息才能答好"。这种单步式的固定流程,注定在复杂场景下水土不服。

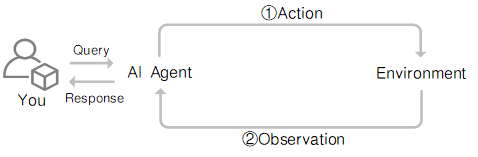

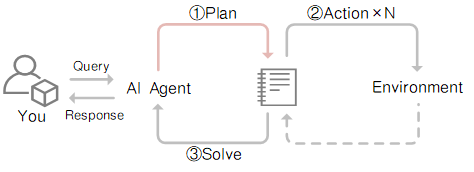

2. AI Agent:考场里的"智能监考老师"

AI Agent(智能体)则像一位经验丰富的监考老师,具备主动决策能力:

🧠 核心特征:自主决策、工具调用、记忆管理、规划反思、迭代优化

它不仅能精准理解任务目标,还能主动规划执行步骤、灵活调用各类工具、评估执行结果,全程无需人工干预。就像监考老师会根据题目难度指导思路一样,AI Agent能做到:

- 📖 深度分析问题:判断问题是简单直接查询,还是需要多步骤拆解的复杂任务;

- 🔧 灵活调用工具:熟练使用搜索引擎、数据库、API、PDF解析器等各类"辅助工具";

- 💭 动态优化策略:如果某一步执行结果不佳,会反思问题所在,调整策略重新尝试,直到拿到满意结果。

3. Agentic RAG:师生同考的黄金组合

Agentic RAG = RAG + AI Agent

如果说RAG是"带书本考试",Agentic RAG就是**"既有书本,又有老师现场指导"**。这位"智能老师"能动态规划检索策略、自主选择信息源、迭代优化答案质量。

---2---

核心架构:四种智能工作模式

Agentic RAG通过引入AI智能体,将静态检索升级为动态知识 orchestration。在LazyLLM框架中,我们可以实现四种主流智能体模式:

模式一:Function Call Agent(工具调用型)

特点:直接行动,快速调用工具,边做边学

流程:Action → Observation → 循环直至解决

适用:简单直接的查询任务

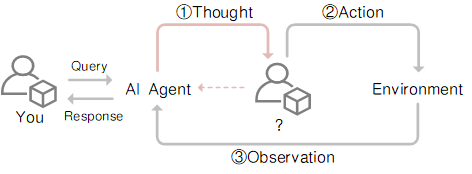

模式二:ReAct(思考-行动型)🤔→⚡

特点:每次行动前先思考,推理更严谨

流程:Thought → Action → Observation → 循环

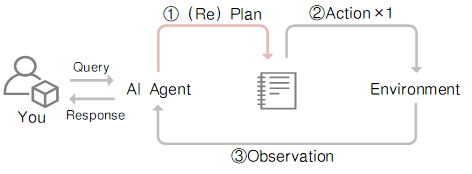

模式三:PlanAndSolve(规划-执行型)📋→✅

特点:先制定完整计划,再分步执行

流程:Plan → 执行单步 → 观察 → 调整计划 → 继续

适用:需要多步骤协作的复杂问题

模式四:ReWOO(无观察推理型)🎯

特点:一次性生成完整计划,并行执行所有步骤

流程:Plan → 执行所有步骤 → 综合结果

优势:效率更高,适合工具间依赖较少的场景

---3---

降维打击:Agentic RAG为何碾压传统RAG?

| 对比维度 | 传统RAG | Agentic RAG |

|---|---|---|

| 流程类型 | 单步检索+生成 | 多步迭代推理与检索 |

| 控制流 | 固定流水线 | 动态、智能体驱动、含规划决策 |

| 检索策略 | 一次检索定生死 | 自适应检索,可反馈优化 |

| 记忆能力 | 无状态,不记历史 | 跨行动维护记忆和状态 |

| 工具集成 | 仅检索器和生成器 | 灵活调用多种工具(API、计算器、数据库等) |

| 智能决策 | ❌ 无 | ✅ 自动规划、自我反思、动态路由 |

核心优势解析:

1️⃣ 多源信息融合

传统RAG困于单一知识库,Agentic RAG能自主调用搜索引擎、数据库、专业API等工具。就像一个老师既会查课本,还会上网、查专业数据库、咨询同行。

2️⃣ 智能查询优化

当首次检索结果不佳时,智能体会自动更换关键词、切换检索工具、甚至重新理解用户意图。这解决了传统RAG"一次查不到就凉凉"的痛点。

3️⃣ 复杂任务拆解

面对"分析2024年AI论文趋势并生成图表"这类需求,Agentic RAG会自动分解为:搜索论文→统计分析→数据可视化→撰写报告,全程自治。

4️⃣ 结果交叉验证

多个数据源的信息可以相互佐证,智能体还能识别矛盾点并优先采信高可信度来源,大幅减少幻觉。

4、MCP协议:AI世界的"USB-C接口"

1. 标准化革命,解决开发痛点

在构建Agentic RAG时,最头疼的莫过于"每个工具都要重写接口"。MCP(Model Context Protocol)应运而生------它相当于AI应用的USB-C接口,统一了模型与外部世界的交互方式[^原文]。

过去 :每接入一个工具(天气API、PDF解析、代码执行)都要写一堆集成代码现在:符合MCP标准的工具即插即用,模型自动识别功能、参数和调用方式

2. 架构三剑客

Host:你的AI应用主体(如Cursor、Claude Desktop)

Client:Host内的通信桥梁,1:1连接Server

Server:提供Tools(函数)、Resources(数据)、Prompts(模板)的标准化服务

在LazyLLM中接入高德地图MCP服务仅需几行代码:

3. 实践:在LazyLLM中使用MCP

1️⃣配置LazyLLM所需要的所有依赖

首先参考 https://docs.lazyllm.ai/zh-cn/latest/ 的Getting started部分,安装LazyLLM并完成环境配置。

同时,由于MCP Server的使用依赖Node.js和npm,可参考https://nodejs.org/en/download 完成最新版本的安装和配置。

2️⃣利用已有的MCP服务

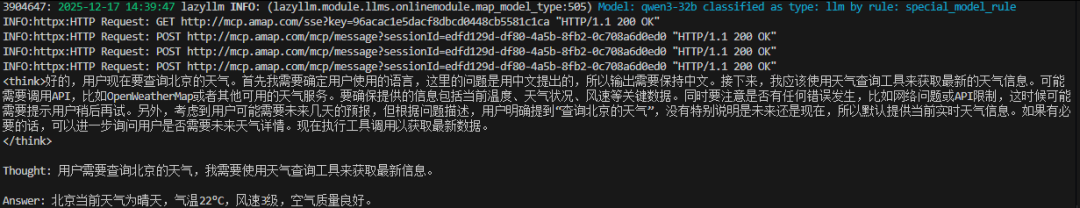

若需接入已有的 MCP 服务(如高德地图的地理位置服务),可通过 LazyLLM 的 MCPClient 工具直接连接,无需自行部署 Server。

SSE URL 接入(以高德 MCP 为例):

无需启动本地 Server,直接通过服务提供商提供的 SSE 长连接 URL 配置 Client。需将"xxx"替换为自己的key。

(创建key:https://lbs.amap.com/api/mcp-server/create-project-and-key)

code-snippet__js

import lazyllm

from lazyllm.tools.agent import ReactAgent

from lazyllm.tools import MCPClient

mcp_configs = {

"amap_mcp": {

"url": "http://mcp.amap.com/sse?key=xxx"

}

}

client = MCPClient(command_or_url=mcp_configs["amap_mcp"]["url"])

llm = lazyllm.OnlineChatModule(source='sensenova', model='Qwen3-32B', stream=False)

agent = ReactAgent(llm=llm.share(), tools=client.get_tools(), max_retries=15)

print(agent("查询北京的天气"))运行结果如下:

通过本次实践,我们可以了解到,MCP Server的出现直接省去了Agent开发环节中工具研发和调试的成本

5、用 LazyLLM 搭建 Agentic RAG系统

下面通过一个完整示例,展示如何一步步实现 Agentic RAG。

1. 搭建基础 RAG

我们先使用 LazyLLM 构建一个标准 RAG,包括:

- Retriever

- Reranker

- LLM

code-snippet__js

import lazyllm

from lazyllm import pipeline, bind, SentenceSplitter, Document, Retriever, Reranker

from lazyllm import TrainableModule

prompt = 'You will play the role of an AI Q&A assistant and complete a dialogue task. In this task, you need to provide your answer based on the given context and question.'

documents = Document(

dataset_path="AgenticRAG/documents",

embed=TrainableModule(base_model="BAAI/bge-large-zh-v1.5"),

manager=False

)

documents.create_node_group(name="sentences", transform=SentenceSplitter, chunk_size=1024, chunk_overlap=100)

with pipeline() as ppl:

ppl.retriever = Retriever(documents, group_name="sentences", similarity="cosine", topk=1)

ppl.reranker = Reranker(

"ModuleReranker",

model=TrainableModule(base_model="BAAI/bge-reranker-large" ,type="rerank"),

topk=1,

output_format='content',

join=True

) | bind(query=ppl.input)

ppl.formatter = (lambda nodes, query: dict(context_str=nodes, query=query)) | bind(query=ppl.input)

ppl.llm = lazyllm.OnlineChatModule(source='sensenova', model='Qwen3-32B', stream=False).prompt(lazyllm.ChatPrompter(prompt, extra_keys=["context_str"]))

if __name__ == "__main__":

lazyllm.WebModule(ppl, port=range(23467, 24000)).start().wait()运行结果如下:

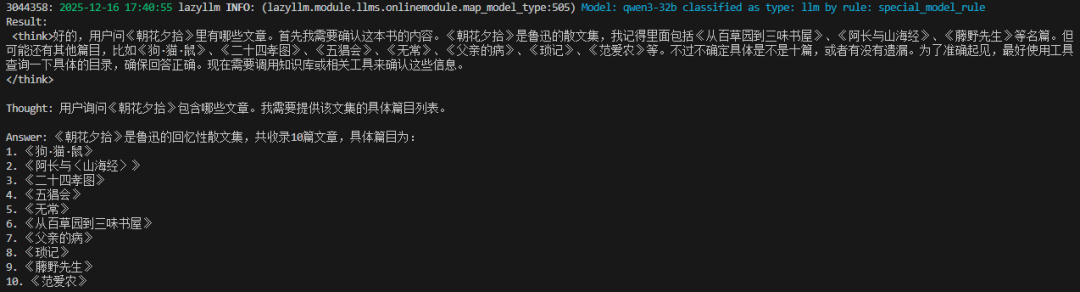

2. 构建 ReAct 智能体

Agentic RAG 就是引入了 AI 智能体的 RAG,这里让我们用 LazyLLM 来注册一个假的知识库搜索工具,实现一个 React:

code-snippet__js

import json

import lazyllm

from lazyllm import fc_register, ReactAgent

@fc_register("tool")

def search_knowledge_base(query: str):

'''

Get info from knowledge base in a given query.

Args:

query (str): The query for search knowledge base.

'''

return "《狗·猫·鼠》、《阿长与〈山海经〉》、《二十四孝图》、《五猖会》、《无常》、《从百草园到三味书屋》、《父亲的病》、《琐记》、《藤野先生》、《范爱农》"

llm = lazyllm.OnlineChatModule(source='sensenova', model='Qwen3-32B',stream=False)

tools = ["search_knowledge_base"]

agent = ReactAgent(llm, tools)

if __name__ == "__main__":

res = agent("朝花夕拾有哪些文章?")

print("Result: \n", res)运行结果如下:

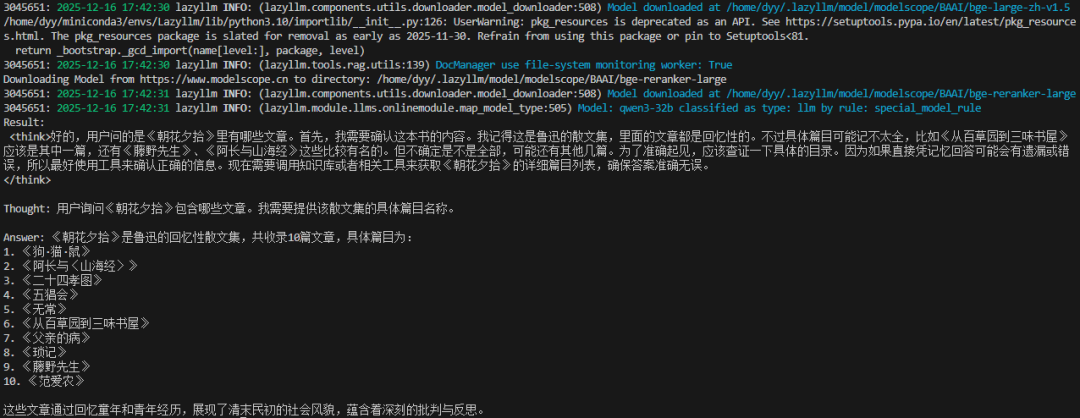

智能体会根据问题,自动决定是否调用该工具。有了 React,我们就可以将它的工具替换为 RAG 中的 Retriever 和 Reranker 来作为一个真实的知识库,让它可以调用检索器:

code-snippet__js

import lazyllm

from lazyllm import (pipeline, bind, OnlineEmbeddingModule, SentenceSplitter, Reranker,

Document, Retriever, fc_register, ReactAgent)

from lazyllm import TrainableModule

documents = Document(

dataset_path="AgenticRAG/documents",

embed=TrainableModule(base_model="BAAI/bge-large-zh-v1.5"),

manager=False

)

documents.create_node_group(name="sentences", transform=SentenceSplitter, chunk_size=1024, chunk_overlap=100)

with pipeline() as ppl_rag:

ppl_rag.retriever = Retriever(documents, group_name="sentences", similarity="cosine", topk=3)

ppl_rag.reranker = Reranker("ModuleReranker", model=TrainableModule(base_model="BAAI/bge-reranker-large" ,type="rerank"), topk=1, output_format='content', join=True) | bind(query=ppl_rag.input)

@fc_register("tool")

def search_knowledge_base(query: str):

'''

Get info from knowledge base in a given query.

Args:

query (str): The query for search knowledge base.

'''

return ppl_rag(query)

tools = ["search_knowledge_base"]

llm = lazyllm.OnlineChatModule(source='sensenova', model='Qwen3-32B', stream=False)

agent = ReactAgent(llm, tools)

if __name__ == "__main__":

res = agent("朝花夕拾有哪些文章?")

print("Result: \n", res)运行结果如下:

- 实现 Agentic RAG

将运行结果如下RAG 的检索组件,直接替换为 ReactAgent:

code-snippet__js

import lazyllm

from lazyllm import (pipeline, bind, OnlineEmbeddingModule, SentenceSplitter, Reranker,

Document, Retriever, fc_register, ReactAgent, TrainableModule,FunctionCallAgent)

prompt = 'You will play the role of an AI Q&A assistant and complete a dialogue task. In this task, you need to provide your answer based on the given context and question.'

documents = Document(dataset_path="AgenticRAG/documents", embed=TrainableModule(base_model="BAAI/bge-large-zh-v1.5"), manager=False)

documents.create_node_group(name="sentences", transform=SentenceSplitter, chunk_size=1024, chunk_overlap=100)

with pipeline() as ppl_rag:

ppl_rag.retriever = Retriever(documents, group_name="sentences", similarity="cosine", topk=3)

ppl_rag.reranker = Reranker("ModuleReranker", model=TrainableModule(base_model="BAAI/bge-reranker-large", type="rerank"), topk=1, output_format='content', join=True) | bind(query=ppl_rag.input)

@fc_register("tool")

def search_knowledge_base(query: str):

'''

Get info from knowledge base in a given query.

Args:

query (str): The query for search knowledge base.

'''

return ppl_rag(query)

tools = ["search_knowledge_base"]

with pipeline() as ppl:

ppl.retriever = FunctionCallAgent(lazyllm.OnlineChatModule(source='sensenova', model='Qwen3-32B', stream=False), tools)

ppl.formatter = (lambda nodes, query: dict(context_str=nodes, query=query)) | bind(query=ppl.input)

ppl.llm = lazyllm.OnlineChatModule(source='sensenova', model='Qwen3-32B', stream=False).prompt(lazyllm.ChatPrompter(prompt, extra_keys=["context_str"]))

if __name__ == "__main__":

lazyllm.WebModule(ppl, port=range(23467, 24000)).start().wait()

plaintext

运行结果如下:

此时:

检索不再是一次调用

而是一个"智能体驱动的过程"

一个最小可用的 Agentic RAG 就完成了。

4. 更多的尝试

我们可以尝试使用不同的 AI 智能体工作流(FunctionCallAgent、PlanAndSolveAgent、ReWOOAgent)来替换上面的 React:

from lazyllm import FunctionCallAgent, PlanAndSolveAgent, ReWOOAgent

# Use FunctionCallAgent:

ppl.retriever = FunctionCallAgent(lazyllm.OnlineChatModule(), tools)

# Use PlanAndSolveAgent:

ppl.retriever = PlanAndSolveAgent(lazyllm.OnlineChatModule(), tools)

# Use ReWOOAgent:

ppl.retriever = ReWOOAgent(lazyllm.OnlineChatModule(), tools)

这里我们尝试将ReactAgent 替换为FunctionCallAgent, 来查看效果:

结语

从带书考试到师生同考,Agentic RAG不仅是一次技术升级,更是AI认知能力的质变。当检索不再是被动的查找,而是主动的探索;当生成不再是简单的拼接,而是智慧的 synthesis------我们终于看到了通向真正智能助手的清晰路径。

如何学习大模型 AI ?

由于新岗位的生产效率,要优于被取代岗位的生产效率,所以实际上整个社会的生产效率是提升的。

但是具体到个人,只能说是:

"最先掌握AI的人,将会比较晚掌握AI的人有竞争优势"。

这句话,放在计算机、互联网、移动互联网的开局时期,都是一样的道理。

我在一线科技企业深耕十二载,见证过太多因技术卡位而跃迁的案例。那些率先拥抱 AI 的同事,早已在效率与薪资上形成代际优势,我意识到有很多经验和知识值得分享给大家,也可以通过我们的能力和经验解答大家在大模型的学习中的很多困惑。我们整理出这套 AI 大模型突围资料包:

- ✅ 从零到一的 AI 学习路径图

- ✅ 大模型调优实战手册(附医疗/金融等大厂真实案例)

- ✅ 百度/阿里专家闭门录播课

- ✅ 大模型当下最新行业报告

- ✅ 真实大厂面试真题

- ✅ 2026 最新岗位需求图谱

所有资料 ⚡️ ,朋友们如果有需要 《AI大模型入门+进阶学习资源包》 ,下方扫码获取~

① 全套AI大模型应用开发视频教程

(包含提示工程、RAG、LangChain、Agent、模型微调与部署、DeepSeek 等技术点)

② 大模型系统化学习路线

作为学习AI大模型技术的新手,方向至关重要。 正确的学习路线可以为你节省时间,少走弯路;方向不对,努力白费。这里我给大家准备了一份最科学最系统的学习成长路线图和学习规划 ,带你从零基础入门到精通!

③ 大模型学习书籍&文档

学习AI大模型离不开书籍文档,我精选了一系列大模型技术的书籍和学习文档(电子版),它们由领域内的顶尖专家撰写 ,内容全面、深入、详尽,为你学习大模型提供坚实的理论基础。

④ AI大模型最新行业报告

2025最新行业报告,针对不同行业的现状、趋势、问题、机会 等进行系统地调研和评估,以了解哪些行业更适合引入大模型的技术和应用,以及在哪些方面可以发挥大模型的优势。

⑤ 大模型项目实战&配套源码

学以致用 ,在项目实战中检验和巩固你所学到的知识 ,同时为你找工作就业和职业发展打下坚实的基础。

⑥ 大模型大厂面试真题

面试不仅是技术的较量,更需要充分的准备。在你已经掌握了大模型技术之后,就需要开始准备面试,我精心整理了一份大模型面试题库,涵盖当前面试中可能遇到的各种技术问题,让你在面试中游刃有余。

以上资料如何领取?

为什么大家都在学大模型?

最近科技巨头英特尔宣布裁员2万人,传统岗位不断缩减,但AI相关技术岗疯狂扩招 ,有3-5年经验,大厂薪资就能给到50K*20薪!

不出1年,"有AI项目经验"将成为投递简历的门槛。

风口之下,与其像"温水煮青蛙"一样坐等被行业淘汰,不如先人一步,掌握AI大模型原理+应用技术+项目实操经验,"顺风"翻盘!

这些资料真的有用吗?

这份资料由我和鲁为民博士(北京清华大学学士和美国加州理工学院博士)共同整理,现任上海殷泊信息科技CEO,其创立的MoPaaS云平台获Forrester全球'强劲表现者'认证,服务航天科工、国家电网等1000+企业,以第一作者在IEEE Transactions发表论文50+篇 ,获NASA JPL火星探测系统强化学习专利等35项中美专利。本套AI大模型课程由清华大学-加州理工双料博士、吴文俊人工智能奖得主鲁为民教授领衔研发。

资料内容涵盖了从入门到进阶的各类视频教程和实战项目,无论你是小白 还是有些技术基础 的技术人员,这份资料都绝对能帮助你提升薪资待遇,转行大模型岗位。

以上全套大模型资料如何领取?