大模型架构演进:从Transformer到MoE

一、 Transformer的辉煌与局限

二、 MoE:用"稀疏激活"撬动模型容量

三、 MoE为何成为大模型新范式?

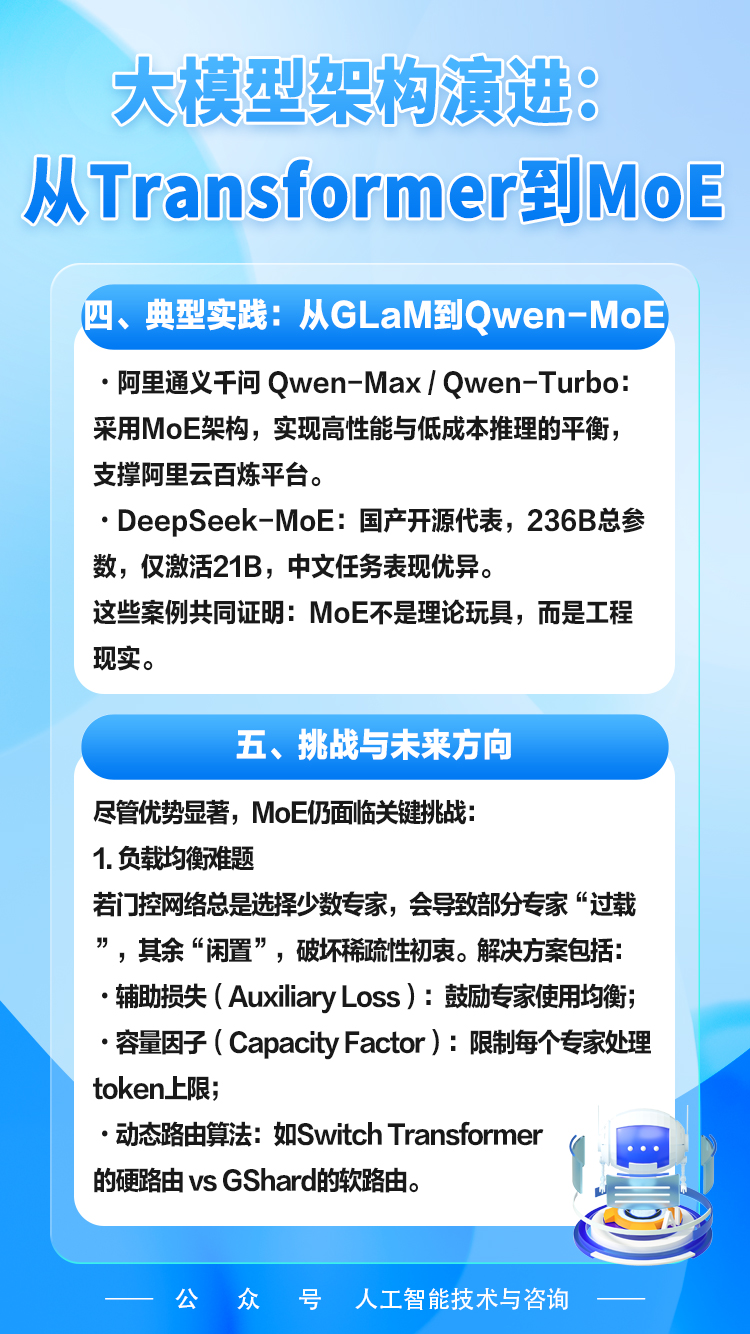

四、 典型实践:从GLaM到Qwen-MoE

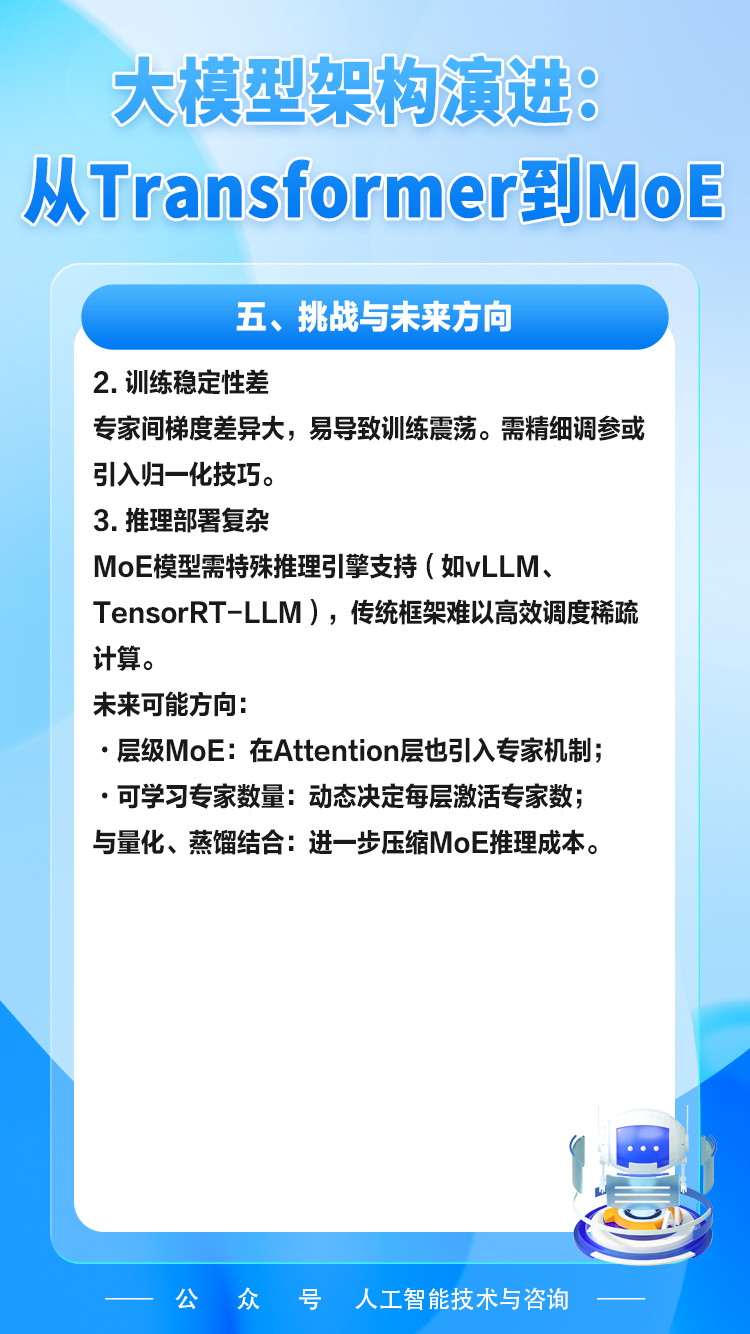

五、 挑战与未来方向

#Transformer#MoE(混合专家)#稀疏激活#专家#模型容量

大模型架构演进:从Transformer到MoE

一、 Transformer的辉煌与局限

二、 MoE:用"稀疏激活"撬动模型容量

三、 MoE为何成为大模型新范式?

四、 典型实践:从GLaM到Qwen-MoE

五、 挑战与未来方向

#Transformer#MoE(混合专家)#稀疏激活#专家#模型容量