前言

HI-SLAM好像是NERF-SLAM的一个方法,而本文的HI-SLAM2,应该就是在此基础上,把Nerf换成GS,然后进行一些改进的工作,接下来我们具体看一下 !

---

---

文章目录

1.背景介绍

- 单目三维重建的基本挑战源于缺乏明确的场景几何测量。传统的视觉SLAM方法通常只提供稀疏或半密集的地图表示,不足以实现详细的场景理解和完整的重建。虽然一些密集SLAM方法试图通过逐像素深度估计来解决这一限制,但它们仍然容易受到严重的深度噪声的影响,难以实现完整、准确的重建。

- 神经SLAM方法的出现,特别是基于神经隐式域和三维高斯溅射(3DGS)的方法,已经显示出令人鼓舞的结果。然而,这些方法通常要么优先考虑渲染质量,要么优先考虑几何精度,这造成了不受欢迎的权衡。

2.关键内容

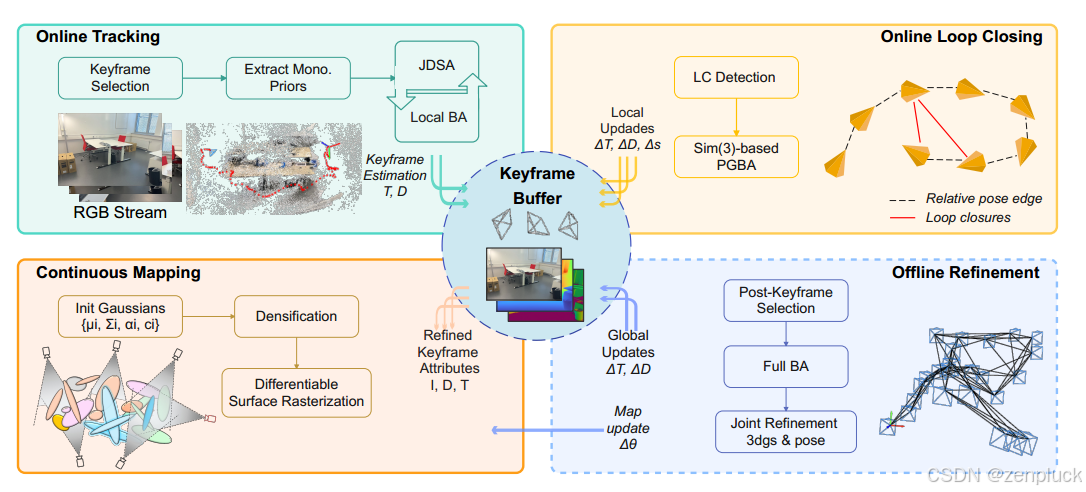

我们的系统旨在实现快速准确的摄像机跟踪和单目RGB输入的场景重建。如图所示,该系统包括四个关键组件:在线跟踪器、在线闭环模块、连续建图器和离线优化阶段。

2.1 在线跟踪

我们的在线跟踪模块建立在基于学习的密集视觉SLAM方法(DROID-SLAM)上,以估计关键帧的相机姿势和深度图。通过循环光流网络利用密集的逐像素信息,我们的系统可以在具有挑战性的场景中稳健地跟踪相机,例如低纹理环境和快速运动。为了匹配所有重叠帧之间的逐像素对应关系,我们构建了一个关键帧图(V, E),它表示每对关键帧之间的共视关系。图节点V对应关键帧,每个关键帧包含一个姿态T∈SE(3)和一个估计深度图d。图边E连接有足够重叠的关键帧,由它们的光流对应关系决定。为了使估计的状态与其他模块同步,帮助连续建图和在线闭环,维护一个关键帧缓冲区来存储所有关键帧及其各自的状态信息。

跟踪器从关键帧选择开始,其中评估每个传入帧以确定是否应该将其选择为关键帧。这个决定是基于通过光流网络(RAFT)的单次通道计算的相对于最后一个关键帧的平均流距离和预定义的阈值df low。对于选定的关键帧,我们通过预训练的神经网络(Omnidata)提取单目先验,包括深度先验和正常先验。当深度先验直接被跟踪器模块促进深度估计,正常先验被场景表示建图器用于3D高斯地图优化作为额外的几何线索。

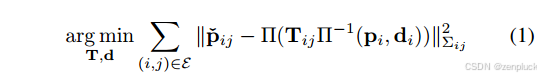

每次添加新的关键帧时,我们执行局部BA来估计当前关键帧图中关键帧的相机姿态和深度图。新关键帧和相邻关键帧之间有足够重叠的边被添加到图中。在光流预测f中,以流预测的目标(记为: p i j p_{ij} pij = p i p_i pi + f),以相机姿态和深度引起的当前重投影为源,使重投影误差最小化。局部BA优化问题可表示为:

置信度通过降低遮挡或低纹理区域引起的异常值的影响,有效地保证了优化的鲁棒性。在无法准确估计深度的欠自信区域,在后续步骤中使用单目深度先验进一步改进深度估计。

结合单目深度先验: 为了克服在低纹理或闭塞区域等困难区域进行深度估计的挑战,我们将易于获得的单目深度先验纳入在线跟踪过程。在RGB-D模式下,直接使用深度观测值来计算BA优化过程中的均方误差。然而,我们不能直接遵循同样的方式,因为预测的单目深度先验表现出不一致的尺度。为了解决这个问题,HI-SLAM提出了估计深度尺度和每个深度先验的偏移量作为优化参数。虽然这种方法有助于调整整体先验尺度,但我们发现它不足以完全纠正单目深度先验中固有的尺度扭曲。具体方法见论文。

2.2 在线回环

虽然我们的在线跟踪器可以稳健地估计相机姿势,但测量噪声不可避免地会随着时间和旅行距离而积累,从而导致姿势漂移。此外,由于固有的尺度不可观察性,单目系统容易发生尺度漂移。为了纠正姿态和比例漂移并增强3D地图的全局一致性,我们的在线闭环模块搜索潜在的闭环。并使用HI-SLAM中首次提出的基于Sim(3)的PGBA对关键帧的整个历史进行全局优化。

闭环检测:闭环检测与在线跟踪并行进行。对于每个选定的新关键帧,我们计算新关键帧与之前所有关键帧之间的光流距离。我们定义了三个标准来选择循环闭包候选者。首先,dof必须低于预定义的阈值τ flow,以确保足够的共同可见性,以便在循环流更新中可靠收敛。其次,基于当前姿态估计的方向差异应保持在阈值τori内。最后,帧索引差必须超过当前本地BA窗口之外的最小阈值τtemp。当所有条件都满足时,我们向前添加连接关键帧对的边,并在关键帧图中恢复重投影方向。

2.3 场景表达

2.4离线优化

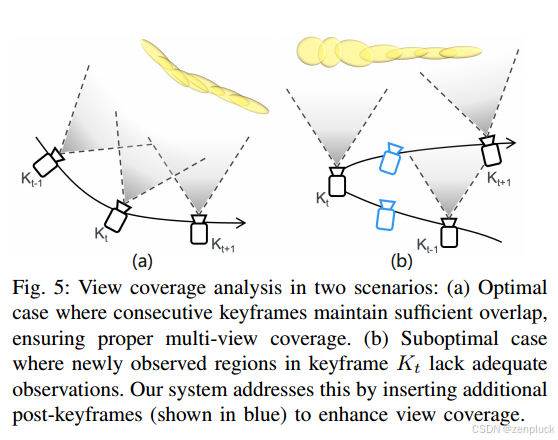

关键帧后插入:第一个细化阶段识别视野覆盖不足的区域,特别是靠近视锥边界的区域。如图5所示,这些区域通常出现在相机向前运动之后的向后旋转运动中。在在线处理过程中,关键帧的选择依赖于相邻帧之间的平均光流,因为如果没有未来的轨迹信息,则无法完全评估视图覆盖率。为了识别离线阶段未被观察到的区域,我们将每个关键帧的像素投影到相邻的关键帧上,并量化落在相邻关键帧视野之外的像素的百分比。当这个百分比超过预定的阈值时,我们将该区域标记为观测不足。然后在这些位置插入额外的关键帧实现更完整的重建,保留场景边界的关键细节。

全束调整:我们的在线闭环模块通过高效的基于Sim(3)的PGBA实现全局一致性,全束调整进一步提高了系统精度。与完整的BA相比,PGBA提供了更高的计算效率,但在将密集对应抽象到相对位姿边缘时引入了较小的近似误差。

具体来说,PGBA只计算环闭合边的重投影因子,而full BA则对所有重叠的关键帧对(包括相邻帧和环闭合帧)进行综合优化,在Eq. 1中重新计算重投影因子。如第IV-G节所示,这在更细的粒度上提高了相机姿势和场景几何形状的全局一致性。

联合姿态和映射优化:最后的优化阶段是基于全BA的结果联合优化高斯映射和相机姿态。虽然在线映射阶段限制了每个关键帧的优化迭代,以保持实时性能,但离线细化可以跨所有关键帧进行全面优化。为了方便关节姿态的细化,我们在基于栅格化的渲染过程中计算姿态雅可比矩阵。此外,我们还优化了每关键帧曝光补偿参数,以确保更好的全局色彩一致性。与使用高斯-牛顿算法的完整BA阶段不同,此联合细化步骤使用一阶梯度下降的Adam优化器[62],利用我们现有的映射管道。

3.文章贡献

- 一种几何感知的高斯SLAM框架,通过对相机姿态和高斯图的高效在线映射和联合优化,实现高保真的纯rgb重构。

- 一种增强的深度估计方法,利用几何先验和改进的尺度对准来补偿单眼先验失真,并实现精确的表面重建。

- 一个平衡的系统,在合成和现实世界数据集的几何和外观重建方面都取得了卓越的性能。