本篇技术博文摘要 🌟

- 文章开篇即阐明数据是深度学习项目的基石 ,并引入TensorFlow Dataset API 作为统一、高效的数据抽象接口,通过代码示例说明其核心优势。

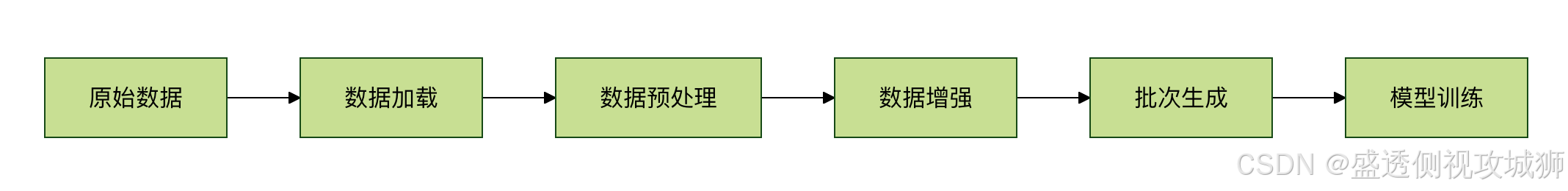

- 核心章节详尽拆解了管道构建的四大关键步骤:数据加载 (支持多种源与格式)、数据预处理 (标准化、归一化等)、数据增强 (如图像变换以扩充数据集)与批次处理,每一步均辅以具体代码。

- 进而,文章深入探讨了缓存、预取、并行化 等高级性能优化策略与内存管理 技巧。通过一个完整的图像分类实战示例 ,将理论串联为可运行的代码。针对工程实践中的痛点,文章提供了性能瓶颈排查 与数据倾斜处理的解决方案。

- 最后,文章总结了包括管道设计原则、监控工具使用与版本兼容性在内的一系列最佳实践,旨在为读者构建从理论认知、工具使用到工程落地的全方位能力。

引言 📘

- 在这个变幻莫测、快速发展的技术时代,与时俱进是每个IT工程师的必修课。

- 我是盛透侧视攻城狮,一个"什么都会一丢丢"的网络安全工程师,目前正全力转向AI大模型安全开发新战场。作为活跃于各大技术社区的探索者与布道者,期待与大家交流碰撞,一起应对智能时代的安全挑战和机遇潮流。

上节回顾

目录

[本篇技术博文摘要 🌟](#本篇技术博文摘要 🌟)

[引言 📘](#引言 📘)

[1.TensorFlow 数据处理与管道](#1.TensorFlow 数据处理与管道)

[2.TensorFlow 数据处理与管道核心概念](#2.TensorFlow 数据处理与管道核心概念)

[2.1Dataset API及示例](#2.1Dataset API及示例)

1.TensorFlow 数据处理与管道

- TensorFlow 数据处理管道是机器学习工作流中的关键环节,它负责高效地加载、预处理和传输数据到模型。

- 与传统的直接加载数据方式相比,TensorFlow 管道提供了三大优势

- 性能优化:通过并行化和预加载减少 I/O 瓶颈

- 内存效率:避免一次性加载全部数据到内存

- 代码整洁:将数据处理逻辑与模型代码解耦

2.TensorFlow 数据处理与管道核心概念

2.1Dataset API及示例

- TensorFlow Dataset API 是构建数据管道的核心工具,它提供了多种数据源接口和转换操作:

python

import tensorflow as tf

# 从内存创建Dataset

data = tf.data.Dataset.from_tensor_slices([1, 2, 3])

# 从文本文件创建

text_data = tf.data.TextLineDataset(["file1.txt", "file2.txt"])

# 从TFRecord创建

tfrecord_data = tf.data.TFRecordDataset("data.tfrecord")

2.2数据预处理技术

常见预处理操作包括:

- 标准化 :

(x - mean) / std- 归一化 :

(x - min) / (max - min)- 独热编码 :

tf.one_hot()- 填充/截断 :

tf.keras.preprocessing.sequence.pad_sequences

3.管道构建步骤

3.1数据加载及示例

- 根据数据来源选择适当的加载方式

python

# 图像数据加载示例

def load_image(path):

img = tf.io.read_file(path)

img = tf.image.decode_jpeg(img, channels=3)

return tf.image.resize(img, [256, 256])

image_dataset = tf.data.Dataset.list_files("images/*.jpg")

image_dataset = image_dataset.map(load_image)

3.2数据预处理及示例

- 使用

map()方法应用预处理函数

python

def normalize(image):

return image / 255.0 # 归一化到0-1范围

normalized_dataset = image_dataset.map(normalize)

3.3数据增强及示例

- 训练时常用的增强技术

python

def augment(image):

image = tf.image.random_flip_left_right(image)

image = tf.image.random_brightness(image, max_delta=0.2)

return image

augmented_dataset = normalized_dataset.map(augment)

3.4批次处理及示例

- 配置批次大小和预取

python

BATCH_SIZE = 32

train_dataset = augmented_dataset.batch(BATCH_SIZE)

train_dataset = train_dataset.prefetch(tf.data.AUTOTUNE)

4.高级优化技巧

4.1性能优化策略表

| 策略 | 方法 | 效果 |

|---|---|---|

| 并行化 | num_parallel_calls=tf.data.AUTOTUNE |

加速数据加载 |

| 预取 | prefetch(buffer_size=tf.data.AUTOTUNE) |

减少等待时间 |

| 缓存 | cache() |

避免重复计算 |

python

optimized_dataset = (tf.data.Dataset.list_files("data/*.png")

.map(load_image, num_parallel_calls=tf.data.AUTOTUNE)

.cache()

.map(augment, num_parallel_calls=tf.data.AUTOTUNE)

.batch(32)

.prefetch(tf.data.AUTOTUNE))4.2内存管理

- 处理大型数据集时

- 使用

TFRecord格式存储数据- 分片处理:

dataset.shard(num_shards, index)- 流式处理:避免

cache()大文件

5.实战示例之图像分类管道

5.1完整图像分类数据处理流程代码

python

def build_pipeline(image_dir, batch_size=32, is_training=True):

# 1. 加载数据

dataset = tf.data.Dataset.list_files(f"{image_dir}/*/*.jpg")

# 2. 解析和预处理

def process_path(file_path):

label = tf.strings.split(file_path, os.sep)[-2]

image = load_image(file_path)

return image, label

dataset = dataset.map(process_path, num_parallel_calls=tf.data.AUTOTUNE)

# 3. 训练时增强

if is_training:

dataset = dataset.map(

lambda x, y: (augment(x), y),

num_parallel_calls=tf.data.AUTOTUNE

)

# 4. 优化配置

dataset = dataset.batch(batch_size)

dataset = dataset.prefetch(tf.data.AUTOTUNE)

return dataset6.常见问题与解决方案

6.1性能瓶颈排查

CPU利用率低

- 增加

num_parallel_calls- 使用

interleave()并行化I/OGPU利用率低

- 增加

prefetch_buffer_size- 检查批次大小是否合适

6.2数据倾斜处理及示例

python

# 类别加权采样

dataset = dataset.apply(

tf.data.experimental.sample_from_datasets(

[class1_ds, class2_ds],

weights=[0.7, 0.3]

)

)7.最佳实践建议

7.1管道设计原则

- 将耗时操作放在早期阶段

- 保持预处理操作确定性

- 为验证集禁用数据增强

7.2监控工具及示例

python

tf.data.experimental.bytes_produced_stats()

tf.data.experimental.latency_stats()7.3版本兼容

- TF 2.x 推荐使用

tf.dataAPI- 避免混合使用

feed_dict方式

欢迎各位彦祖与热巴畅游本人专栏与技术博客

你的三连是我最大的动力

点击➡️指向的专栏名即可闪现

➡️计算机组成原理****

➡️操作系统

➡️****渗透终极之红队攻击行动********

➡️ 动画可视化数据结构与算法

➡️ 永恒之心蓝队联纵合横防御

➡️****华为高级网络工程师********

➡️****华为高级防火墙防御集成部署********

➡️ 未授权访问漏洞横向渗透利用

➡️****逆向软件破解工程********

➡️****MYSQL REDIS 进阶实操********

➡️****红帽高级工程师

➡️红帽系统管理员********

➡️****HVV 全国各地面试题汇总********