一、项目说明

1.1 仓库地址

- GIT URL:

https://github.com/huojichuanqi/ds#

1.2 项目介绍

gnina(发音为 NEE-na)是一个分子对接程序,集成了使用卷积神经网络对配体进行评分和优化的支持。它是 smina 的一个分支,而 smina 是 AutoDock Vina 的一个分支。

二、安装部署

2.1 环境准备

- 操作系统:Ubuntu22.04

- CUDA:>12.0

- cmake: > 2.25 (Ubuntu默认的是2.22.1,需要修改CMakeLists.txt)

- python:>=3.10.12

- torch: 需要和cuda的版本一致

- cuda12.4:

pip install torch==2.5.1 torchvision==0.20.1 torchaudio==2.5.1 --index-url https://download.pytorch.org/whl/cu124 - cuda12.6:

pip install torch==2.7.1 torchvision==0.22.1 torchaudio==2.7.1 --index-url https://download.pytorch.org/whl/cu126

- cuda12.4:

- wsl能访问github(宿主机配置好代理,关闭防火墙)

2.2 开始编译

2.2.1 安装依赖库

bash

apt update -y

apt-get install build-essential git cmake wget libboost-all-dev libeigen3-dev libgoogle-glog-dev libprotobuf-dev protobuf-compiler libhdf5-dev libatlas-base-dev python3-dev librdkit-dev python3-numpy python3-pip python3-pytest libjsoncpp-dev libxml2-dev

apt upgrade cmake

## 安装cuda

sudo apt-get remove nvidia-cuda-toolkit

wget https://developer.download.nvidia.com/compute/cuda/12.4.0/local_installers/cuda_12.4.0_550.54.14_linux.run

chmod 700 cuda_12.4.0_550.54.14_linux.run

sudo sh cuda_12.4.0_550.54.14_linux.run

## 安装cudnn

wget https://developer.download.nvidia.com/compute/cudnn/9.0.0/local_installers/cudnn-local-repo-ubuntu2204-9.0.0_1.0-1_amd64.deb

sudo dpkg -i cudnn-local-repo-ubuntu2204-9.0.0_1.0-1_amd64.deb

sudo cp /var/cudnn-local-repo-ubuntu2204-9.0.0/cudnn-*-keyring.gpg /usr/share/keyrings/

sudo apt-get update

sudo apt-get -y install cudnn-cuda-122.2.2 安装 OpenBabel3

注意,在 3.1.1 及更早版本中存在键级确定错误。

bash

git clone https://github.com/dkoes/openbabel.git

cd openbabel

mkdir build

cd build

cmake -DWITH_MAEPARSER=OFF -DWITH_COORDGEN=OFF -DPYTHON_BINDINGS=ON -DRUN_SWIG=ON ..

make

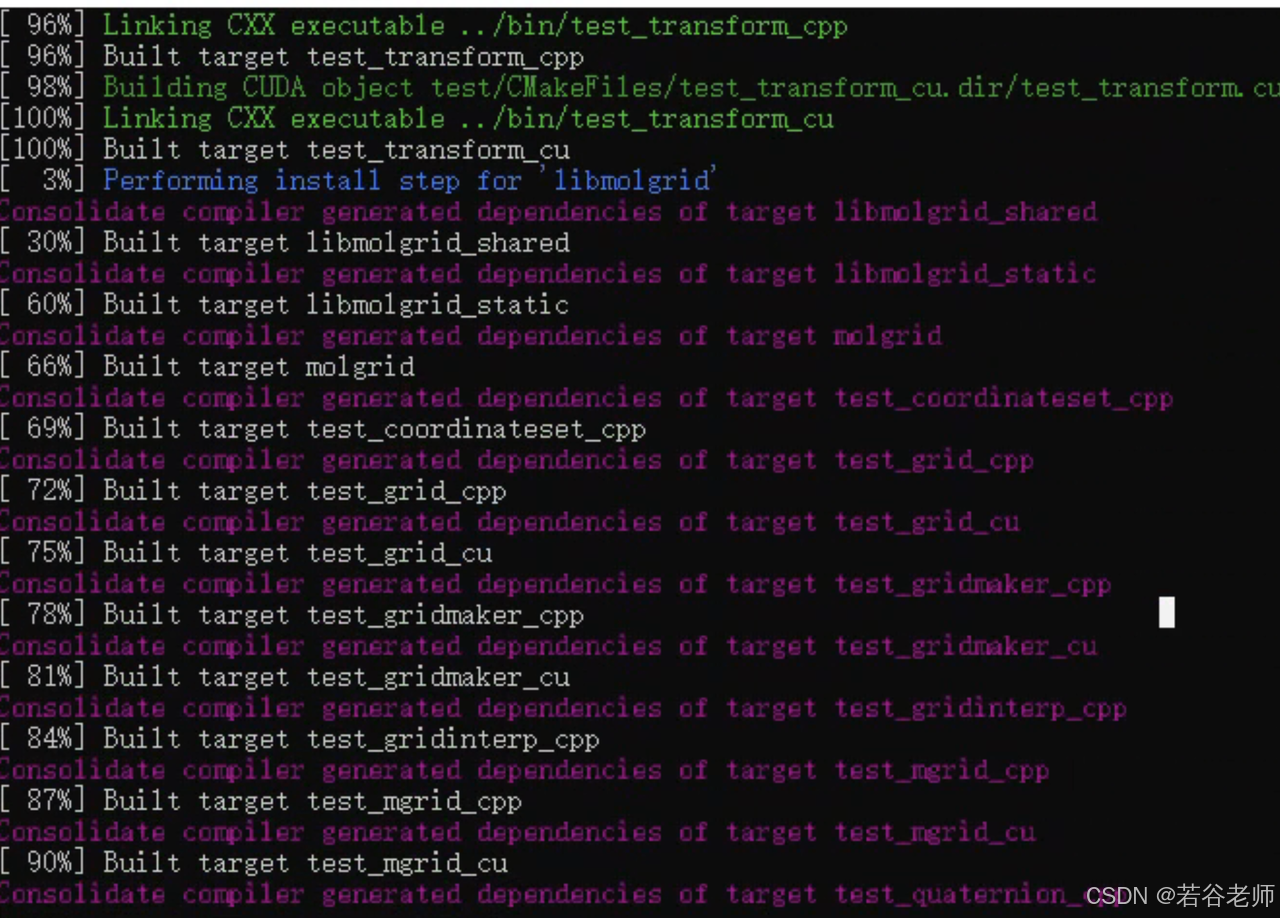

make install2.2.3 安装 gnina

bash

git clone https://github.com/gnina/gnina.git

cd gnina

mkdir build

cd build

cmake .. -DCMAKE_CUDA_ARCHITECTURES=75

make -j8

sudo make install

cmake .. \

-DOPENBABEL3_INCLUDE_DIR=/usr/local/include/openbabel3 \

-DOPENBABEL3_LIBRARIES= /usr/local/lib/libopenbabel.so \

-DJSONCPP_INCLUDE_DIR=/usr/include/jsoncpp \

-DJSONCPP_LIBRARY=/usr/lib/x86_64-linux-gnu/libjsoncpp.so \

-DBoost_USE_STATIC_LIBS=OFFgnina编译的时候对环境有要求,如果cmake的版本低于3.25,那么修改根目录的CMakeLists.txt的第一行cmake_minimum_required(VERSION 3.25)为实际的cmake的版本号,cmake的版本号可以通过cmake --version查看。

第二个要修改的也是根目录的CMakeLists.txt,在76行,将set(CMAKE_CUDA_ARCHITECTURES "all-major")改为实际的架构版本,实际的查看命令为nvidia-smi --query-gpu=compute_cap --format=csv。

cmakelist

#set(CMAKE_CUDA_ARCHITECTURES "all-major")

set(CMAKE_CUDA_ARCHITECTURES "75")