- 文章提出了一种提高decoder-only LLM的embedding能力的方法,叫echo embeddings

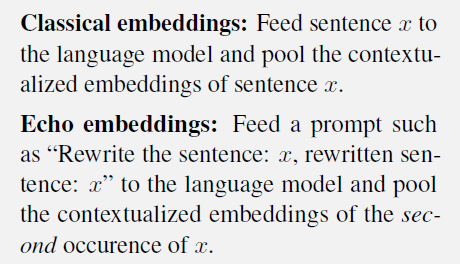

- last-token pooling(即直接选最后一个token作为句子的embedding)和直接mean pooling都不如文章提出的echo embedding,做法是把句子重复两次,然后取第二次的token是的mean pooling。mean pooling的缺点是太强调句子的前面部分,last-token pooling是太强调句子的后面部分,而重复两次后,第二次的句子的起始token也包含了完整句子的语义,从而不会出现直接mean pooling的问题。

- 另外一点是,输入要添加一些instruction以鼓励第二次的句子编码包含完整句子信息,如下: