RNN(Recurrent Neural Network,即循环神经网络)是一类用于处理序列数据的神经网络,广泛应用于自然语言处理(NLP)、时间序列预测、语音识别等领域。与传统的前馈神经网络不同,RNN具有循环结构,能够通过"记忆"前一时刻的信息来处理序列数据。

RNN的基本结构和工作原理

RNN的关键特性在于它的循环连接,即网络中的隐藏层节点不仅接收当前输入,还接收前一个时刻隐藏层的状态。这个结构使得RNN能够捕捉到数据序列中的时间依赖关系。

具体结构

- 输入层(Input Layer):接收当前时刻的输入数据。

- 隐藏层(Hidden Layer):具有循环连接,既接收当前时刻的输入,也接收前一个时刻隐藏层的输出。

- 输出层(Output Layer):根据隐藏层的状态生成当前时刻的输出。

RNN的工作流程

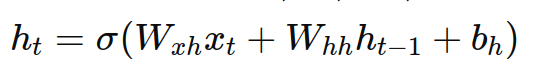

假设输入序列为 x1,x2,...,xT,其中xt 代表序列在时间 t 的输入。隐藏层的状态 ht 可以表示为:

其中:

- Wxh 是输入到隐藏层的权重矩阵。

- Whh 是隐藏层到隐藏层的权重矩阵。

- bh 是隐藏层的偏置向量。

- σ 是激活函数(例如tanh或ReLU)。

输出 yt 则可以表示为:

其中:

- Why 是隐藏层到输出层的权重矩阵。

- by 是输出层的偏置向量。

- ϕ 是输出层的激活函数(例如softmax用于分类任务)。

RNN的训练

RNN的训练过程使用反向传播算法,但因为其循环结构,具体使用的是"反向传播通过时间(Backpropagation Through Time,BPTT)"算法。BPTT算法将序列展开成多个时间步长,然后像传统的神经网络一样进行反向传播。

RNN的局限性

- 梯度消失和梯度爆炸:由于RNN在时间步长上进行反向传播,长序列训练时可能会遇到梯度消失或梯度爆炸的问题。这使得RNN难以学习长距离依赖关系。

- 长距离依赖问题:标准RNN难以捕捉到长时间步长之间的依赖关系。

RNN的改进

为了解决上述问题,有几种RNN的变体被提出:

- 长短期记忆网络(LSTM):通过引入遗忘门、输入门和输出门来控制信息的流动,有效缓解梯度消失问题。

- 门控循环单元(GRU):简化了LSTM的结构,但仍然能够有效处理长距离依赖。

代码示例

使用随机生成的销售数据作为输入序列,并尝试预测序列的下一个值。

python

import numpy as np

import tensorflow as tf

from tensorflow.keras.models import Sequential

from tensorflow.keras.layers import SimpleRNN, Dense

import matplotlib.pyplot as plt

# 生成随机销售数据

def generate_sales_data(seq_length, num_samples):

X = []

y = []

for _ in range(num_samples):

start = np.random.rand() * 100

data = np.cumsum(np.random.rand(seq_length + 1) - 0.5) + start

X.append(data[:-1])

y.append(data[-1])

return np.array(X), np.array(y)

# 参数设置

seq_length = 50

num_samples = 1000

X, y = generate_sales_data(seq_length, num_samples)

# 数据集拆分为训练集和测试集

split = int(0.8 * num_samples)

X_train, X_test = X[:split], X[split:]

y_train, y_test = y[:split], y[split:]

# 将数据调整为RNN输入的形状

X_train = X_train.reshape((X_train.shape[0], X_train.shape[1], 1))

X_test = X_test.reshape((X_test.shape[0], X_test.shape[1], 1))

# 模型构建

model = Sequential([

SimpleRNN(50, activation='tanh', input_shape=(seq_length, 1)),

Dense(1)

])

# 模型编译

model.compile(optimizer='adam', loss='mse')

# 打印模型摘要

model.summary()

# 模型训练

history = model.fit(X_train, y_train, epochs=20, validation_data=(X_test, y_test))

# 模型评估

loss = model.evaluate(X_test, y_test)

print(f"Test Loss: {loss}")

# 预测一些值并可视化

y_pred = model.predict(X_test)

plt.plot(y_test, label='True')

plt.plot(y_pred, label='Predicted')

plt.legend()

plt.show()RNN的应用

- 自然语言处理(NLP):如语言模型、机器翻译、文本生成等。

- 时间序列预测:如股票价格预测、天气预测等。

- 语音识别:如自动语音识别系统。

- 视频处理:如视频分类、动作识别等。

总之,RNN及其变体是处理序列数据的强大工具,通过循环结构捕捉时间依赖关系,为许多应用领域提供了有效的解决方案。