11天 本节学习到BERT全称是来自变换器的双向编码器表征量,它是Google于2018年末开发并发布的一种新型语言模型。BERT模型的主要创新点都在pre-train方法上,即用了Masked Language Model和Next Sentence Prediction两种方法分别捕捉词语和句子级别的representation。通过一个文本情感分类任务为例子来学习了BERT模型的整个应用过程。

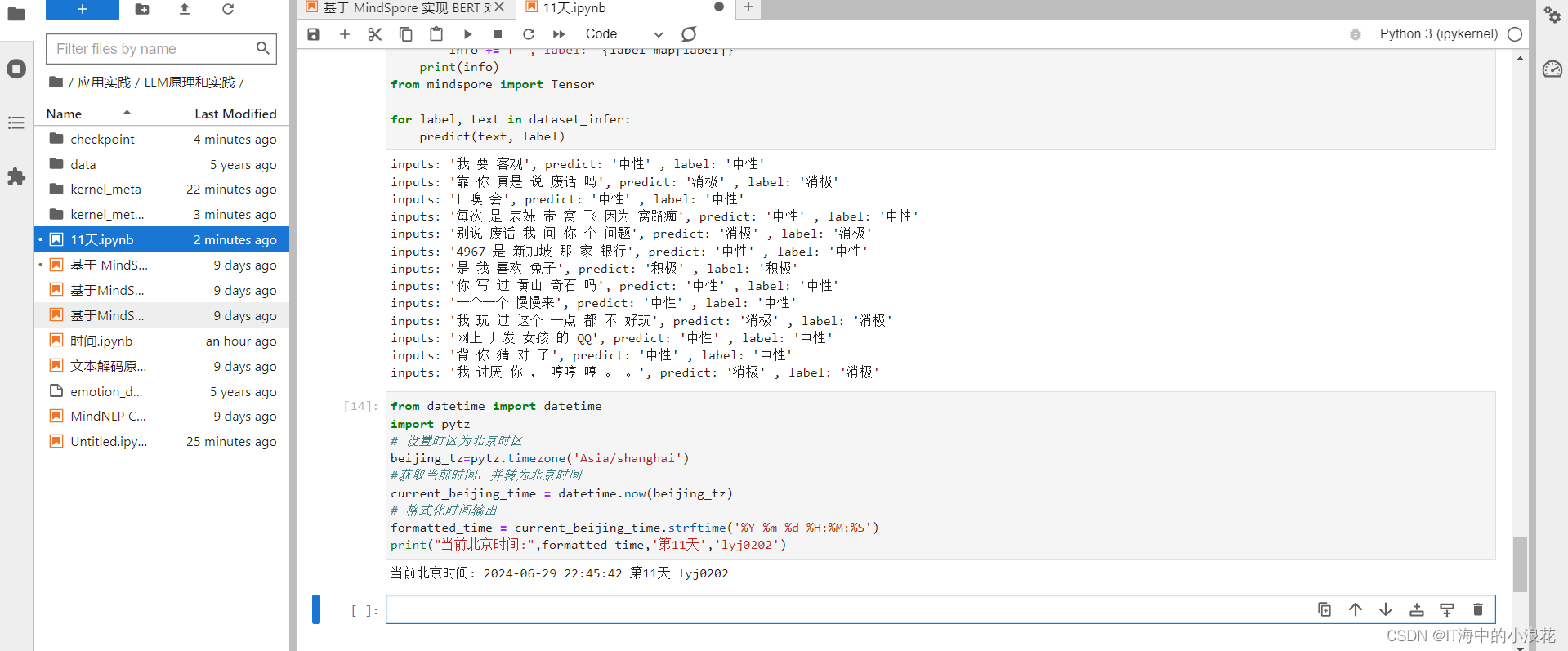

本节学习到BERT全称是来自变换器的双向编码器表征量,它是Google于2018年末开发并发布的一种新型语言模型。BERT模型的主要创新点都在pre-train方法上,即用了Masked Language Model和Next Sentence Prediction两种方法分别捕捉词语和句子级别的representation。通过一个文本情感分类任务为例子来学习了BERT模型的整个应用过程。

《昇思25天学习打卡营第11天 | 昇思MindSpore基于 MindSpore 实现 BERT 对话情绪识别》

IT海中的小浪花2024-07-03 14:11

相关推荐

牛马摆渡人52812 分钟前

OpenClaw实战--Day1: 本地化前端小豆13 分钟前

玩转 OpenClaw:打造你的私有 AI 助手网关BugShare25 分钟前

写一个你自己的Agent Skills机器之心1 小时前

英伟达护城河被AI攻破,字节清华CUDA Agent,让人人能搓CUDA内核后端小肥肠2 小时前

公众号躺更神器!OpenClaw+Claude Skill 实现自动读对标 + 写文 + 配图 + 存入草稿箱爱可生开源社区2 小时前

SCALE | 重构 AI 时代数据库能力的全新评估标准Jahzo2 小时前

openclaw本地化部署体验与踩坑记录--飞书机器人配置Narrastory2 小时前

明日香 - Pytorch 快速入门保姆级教程(一)数据智能老司机2 小时前

用于进攻性网络安全的智能体 AI——在 n8n 中构建你的第一个 AI 工作流数据智能老司机3 小时前

用于进攻性网络安全的智能体 AI——智能体 AI 入门