文章目录

- FastGPT连接OneAI接入网络模型

-

- 1.准备工作

- 2.开始部署

-

- [2.1下载 docker-compose.yml](#2.1下载 docker-compose.yml)

- 2.2修改docker-compose.yml里的参数

- 3.打开FastGPT添加模型

FastGPT连接OneAI接入网络模型

1.准备工作

本文档参考FastGPT的官方文档

| 主机ip | 接入模型 | 主机名称 | 系统 |

|---|---|---|---|

| 192.168.37.200 | 文心一言 | fastgpt | centos7 |

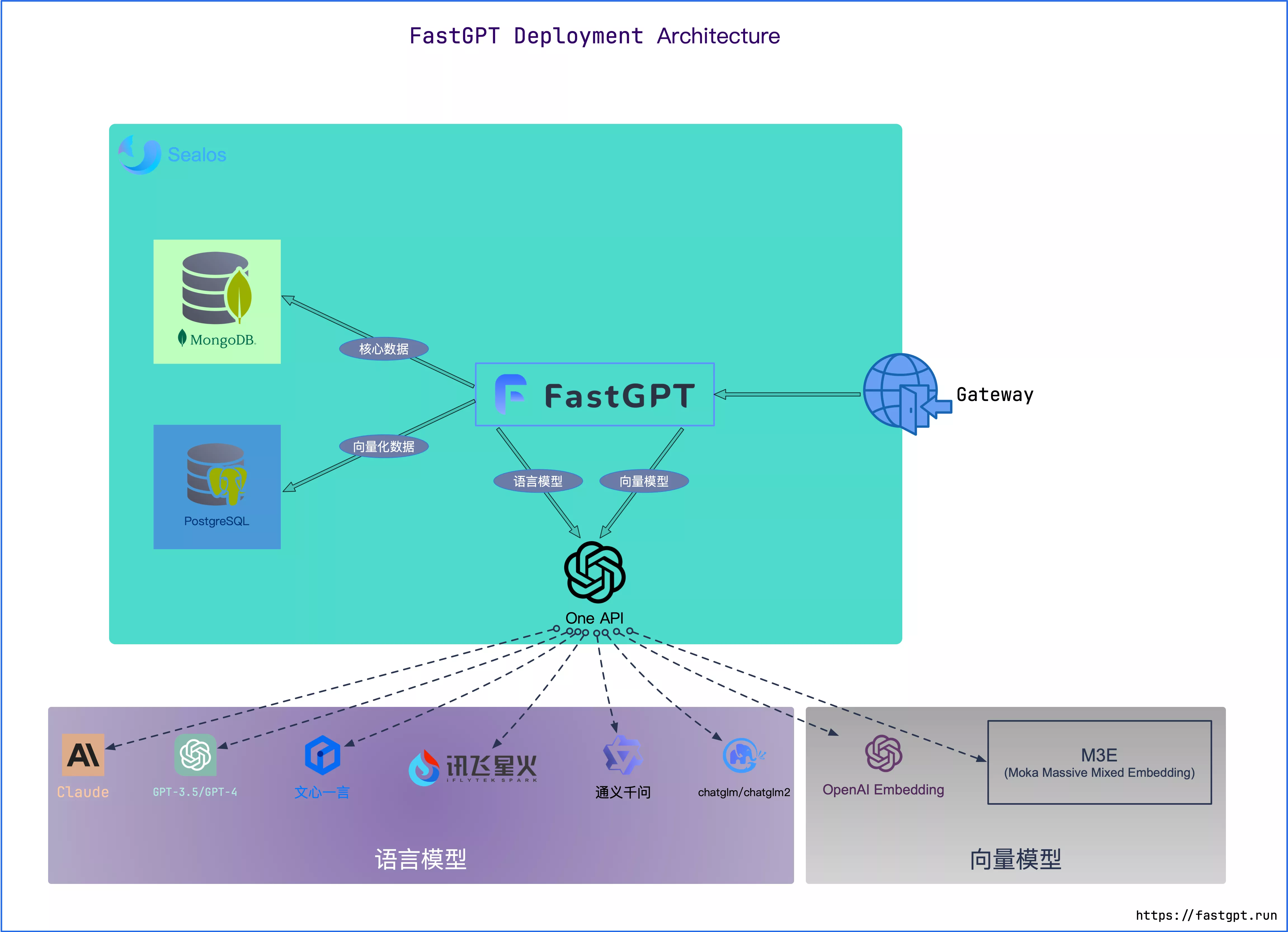

部署架构图

本架构是用docker-compose进行部署

安装docker

[root@fastgpt ~]# yum install -y yum-utils device-mapper-persistent-data lvm2

[root@fastgpt ~]# yum-config-manager --add-repo https://mirrors.aliyun.com/docker-ce/linux/centos/docker-ce.repo

[root@fastgpt ~]# sed -i 's+download.docker.com+mirrors.aliyun.com/docker-ce+' /etc/yum.repos.d/docker-ce.repo

[root@fastgpt ~]# yum -y install docker-ce

[root@fastgpt ~]# systemctl enable --now docker

[root@fastgpt ~]# systemctl disable --now firewalld

[root@fastgpt ~]# setenforce 0

安装docker-compose

[root@fastgpt ~]# curl -L https://github.com/docker/compose/releases/download/v2.20.3/docker-compose-`uname -s`-`uname -m` -o /usr/local/bin/docker-compose

% Total % Received % Xferd Average Speed Time Time Time Current

Dload Upload Total Spent Left Speed

0 0 0 0 0 0 0 0 --:--:-- --:--:-- --:--:-- 0

100 56.6M 100 56.6M 0 0 168k 0 0:05:44 0:05:44 --:--:-- 225k

[root@fastgpt ~]# chmod +x /usr/local/bin/docker-compose

[root@fastgpt ~]# docker -v

Docker version 26.1.4, build 5650f9b

[root@fastgpt ~]# docker-compose -v

Docker Compose version v2.20.32.开始部署

2.1下载 docker-compose.yml

[root@fastgpt ~]# mkdir fastgpt

[root@fastgpt ~]# cd fastgpt/

[root@fastgpt fastgpt]# curl -O https://raw.githubusercontent.com/labring/FastGPT/main/projects/app/data/config.json

% Total % Received % Xferd Average Speed Time Time Time Current

Dload Upload Total Spent Left Speed

100 5109 100 5109 0 0 236 0 0:00:21 0:00:21 --:--:-- 1122

[root@fastgpt fastgpt]# curl -o docker-compose.yml https://raw.githubusercontent.com/labring/FastGPT/main/files/docker/docker-compose-pgvector.yml

% Total % Received % Xferd Average Speed Time Time Time Current

Dload Upload Total Spent Left Speed

100 5577 100 5577 0 0 9613 0 --:--:-- --:--:-- --:--:-- 9598

[root@fastgpt fastgpt]# ls

config.json docker-compose.yml2.2修改docker-compose.yml里的参数

有些容器的镜像可能很难拉下来,这时可以配一个加速器或者把docker-compose.yml里的镜像源换成国内的阿里源

[root@fastgpt fastgpt]# docker-compose up -d

[root@fastgpt fastgpt]# sleep 10

[root@fastgpt fastgpt]# docker restart oneapi #重启一次oneapi(由于OneAPI的默认Key有点问题,不重启的话会提示找不到渠道,临时手动重启一次解决,等待作者修复)3.打开FastGPT添加模型

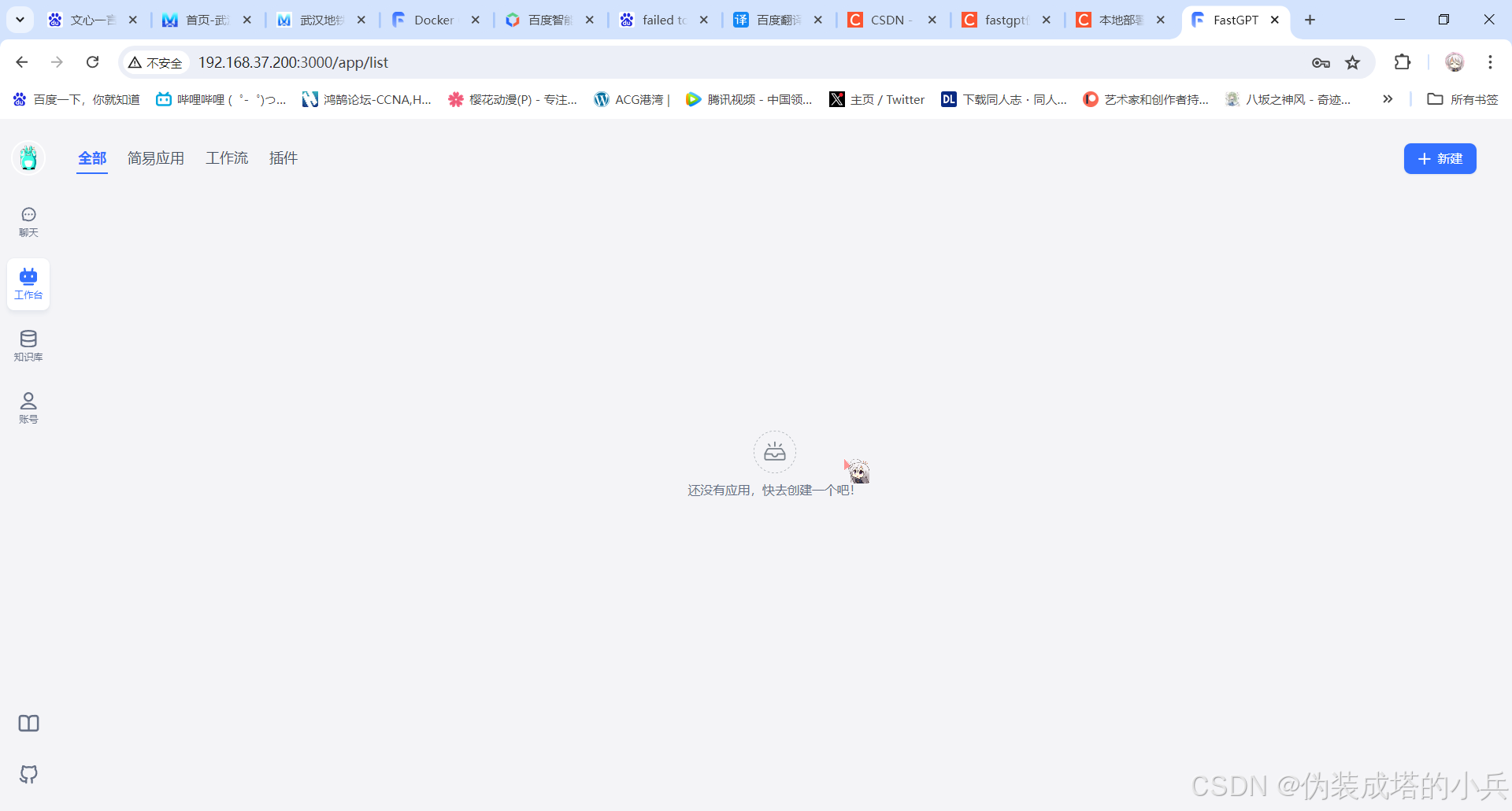

可以通过ip:3000访问FastGPT,默认账号为root密码为1234。

安装成功之后

访问时注意关防火墙

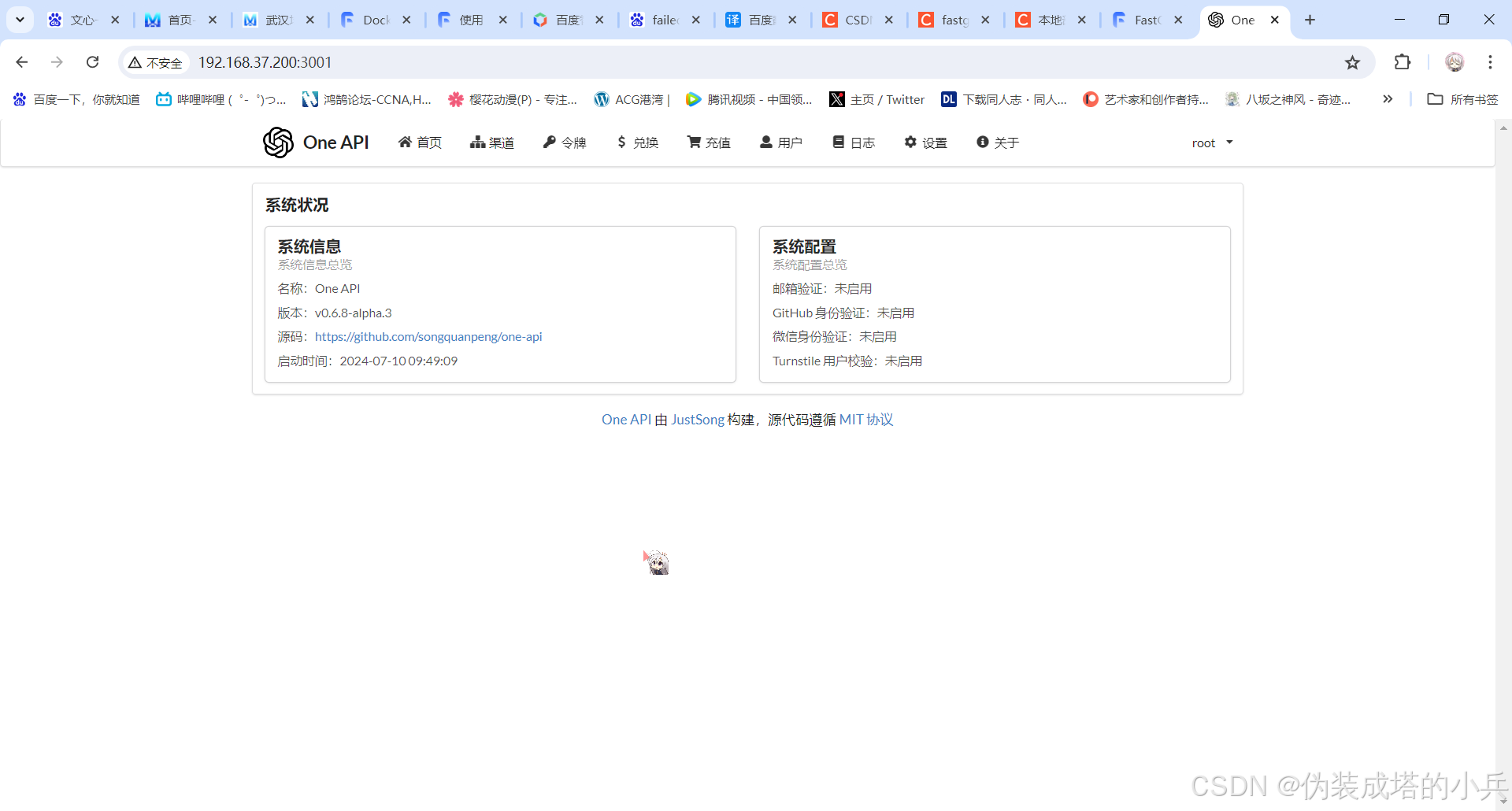

我们访问上去是不能用的,需要让oneapi当作一个跳板来连接外部模型

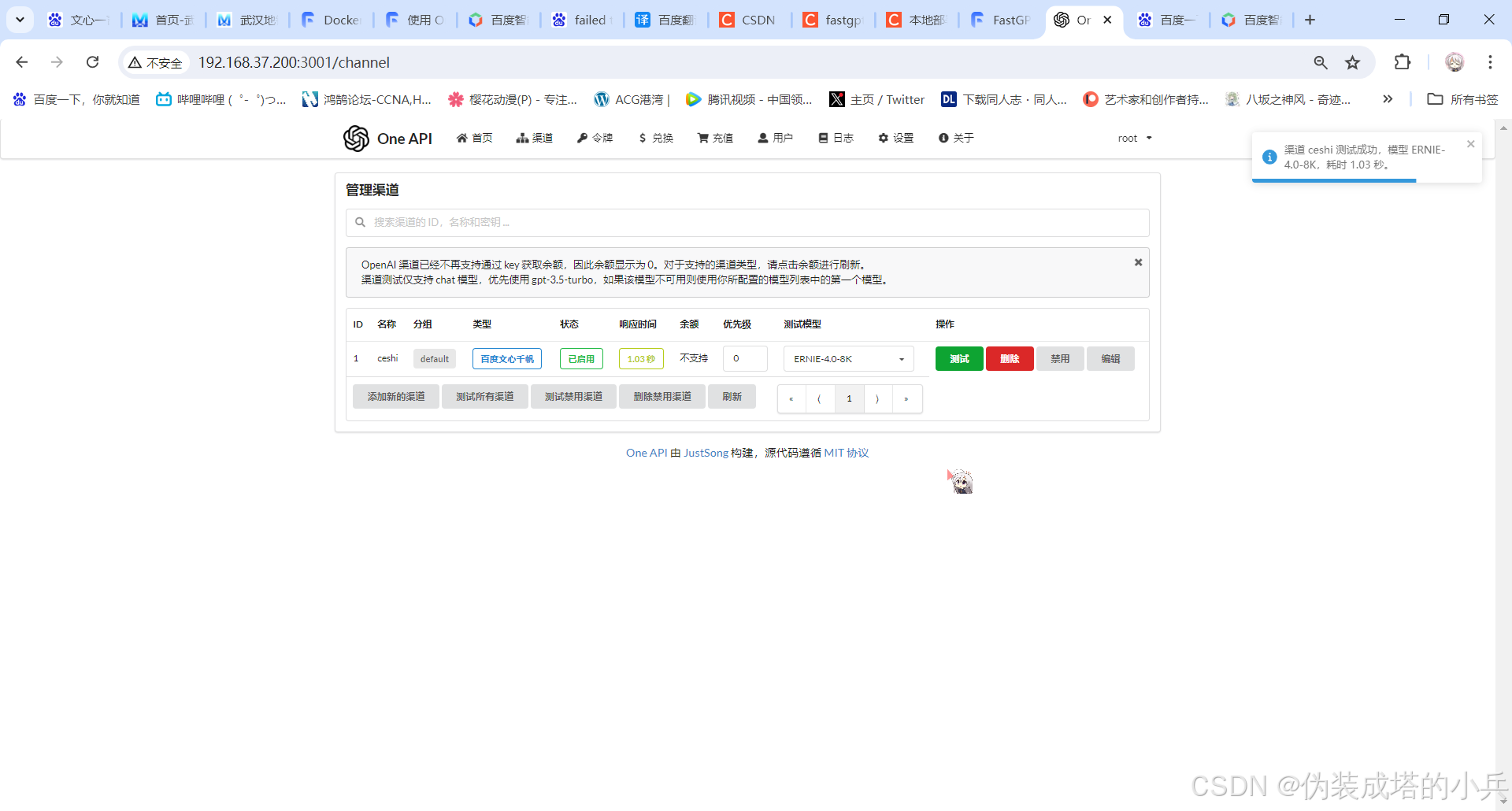

3.1打开OneAPI

通过ip:3001访问OneAPI,默认账户为root密码是123456

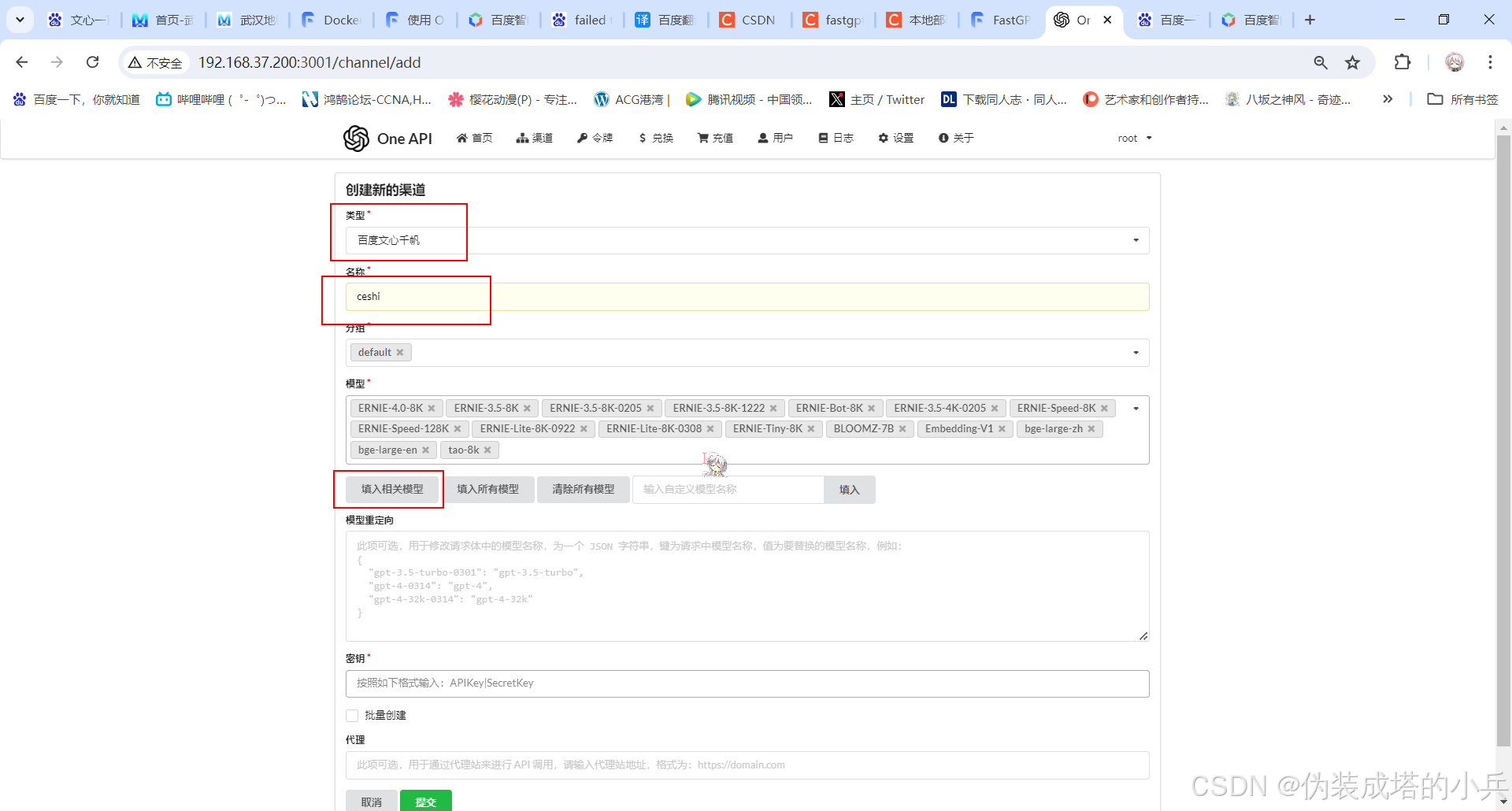

3.2接入网络模型

以文心一言为例

创建一个渠道

注意在填写密钥的时候一定要是apikey|SecretKey的格式,我因为只填写的apikey导致一直测试不了花了我1个小时时间排错

测试一下

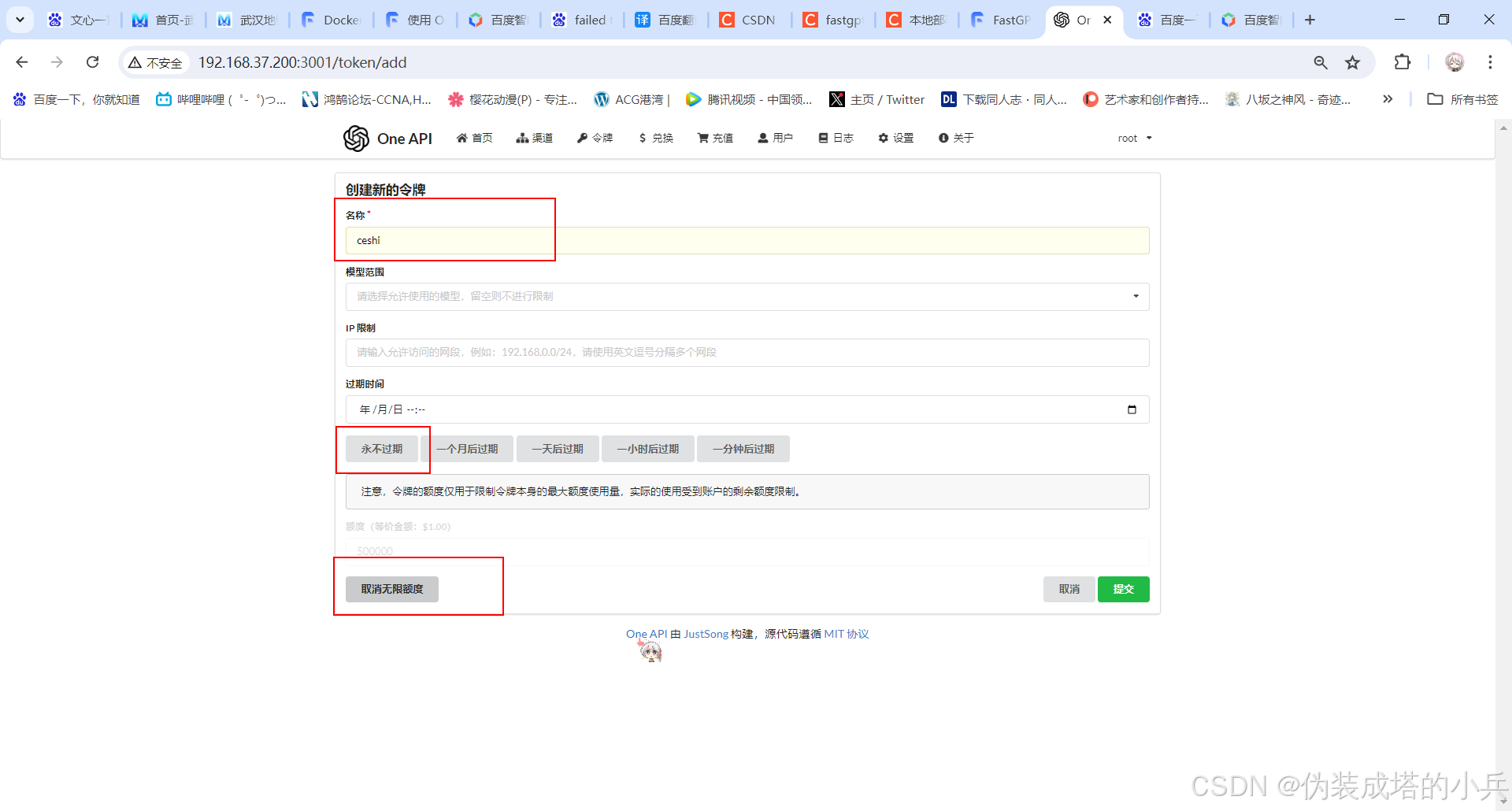

创建一个令牌

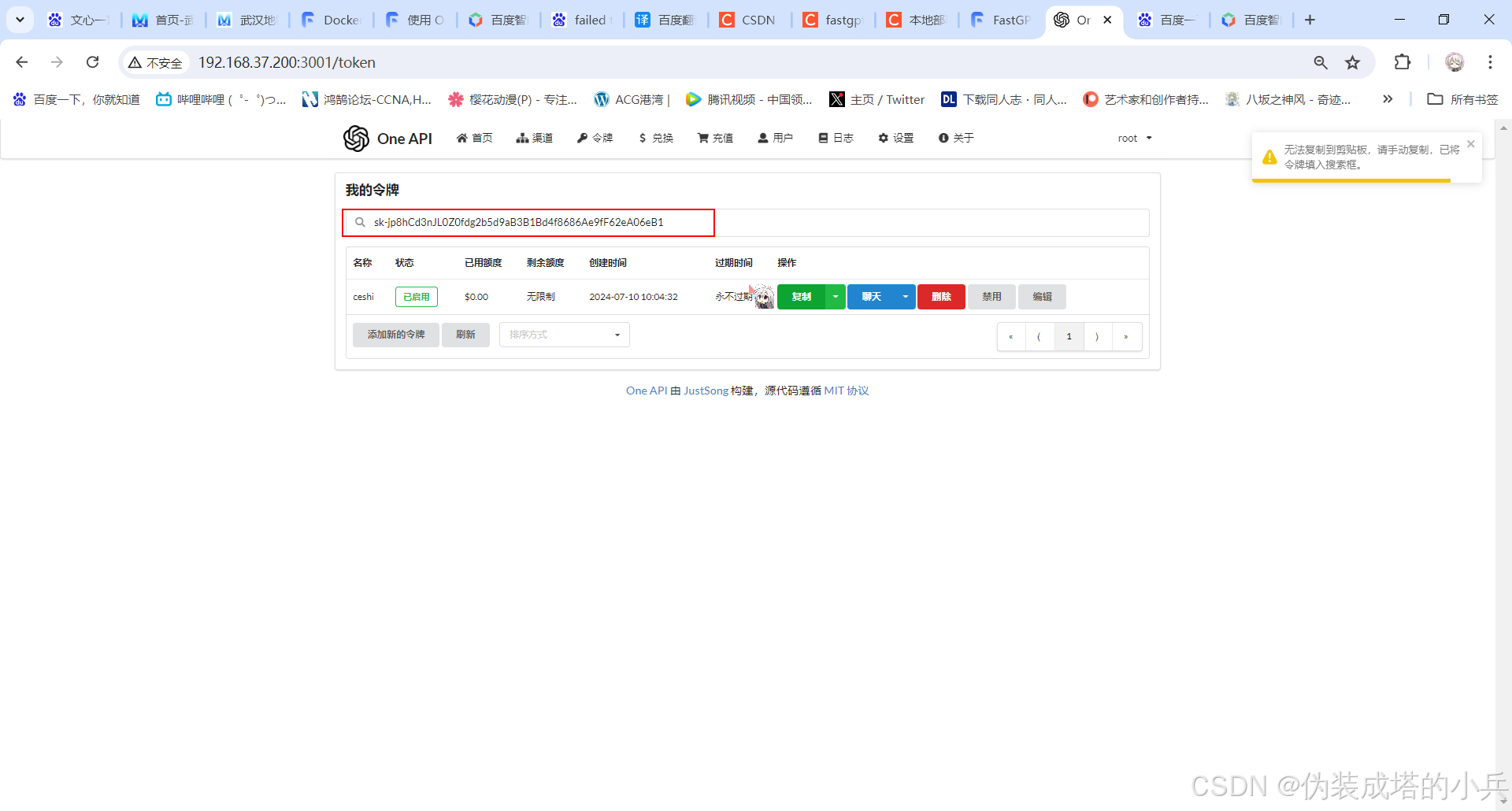

创建好令牌之后就可以获取OneAPI的APIkey了

获取到key之后回到docker-compose.yml中来

- OPENAI_BASE_URL=http://192.168.37.200:3001/v1 #这里填写OneAPI的访问地址,并在后面加上/v1

- CHAT_API_KEY=sk-jp8hCd3nJL0Z0fdg2b5d9aB3B1Bd4f8686Ae9fF62eA06eB1 #这里填写我们刚刚获取的APIkey然后再修改config.json文件

"llmModels": [

...

{

"model": "ERNIE-4.0-8K", // 这里的模型需要对应 One API 的模型

"name": "文心一言", // 对外展示的名称

"avatar": "/imgs/model/ernie.svg", // 模型的logo

"maxContext": 16000, // 最大上下文

"maxResponse": 4000, // 最大回复

"quoteMaxToken": 13000, // 最大引用内容

"maxTemperature": 1.2, // 最大温度

"charsPointsPrice": 0,

"censor": false,

"vision": false, // 是否支持图片输入

"datasetProcess": false, // 是否设置为知识库处理模型

"usedInClassify": true, // 是否用于问题分类

"usedInExtractFields": true, // 是否用于字段提取

"usedInToolCall": true, // 是否用于工具调用

"usedInQueryExtension": true, // 是否用于问题优化

"toolChoice": true, // 是否支持工具选择

"functionCall": false, // 是否支持函数调用

"customCQPrompt": "", // 自定义文本分类提示词(不支持工具和函数调用的模型

"customExtractPrompt": "", // 自定义内容提取提示词

"defaultSystemChatPrompt": "", // 对话默认携带的系统提示词

"defaultConfig":{} // 请求API时,挟带一些默认配置(比如 GLM4 的 top_p)

}

...

],添加模型向量

"vectorModels": [

......

{

"model": "text-embedding-ada-002",

"name": "Embedding-2",

"avatar": "/imgs/model/openai.svg",

"charsPointsPrice": 0,

"defaultToken": 700,

"maxToken": 3000,

"weight": 100

},

......

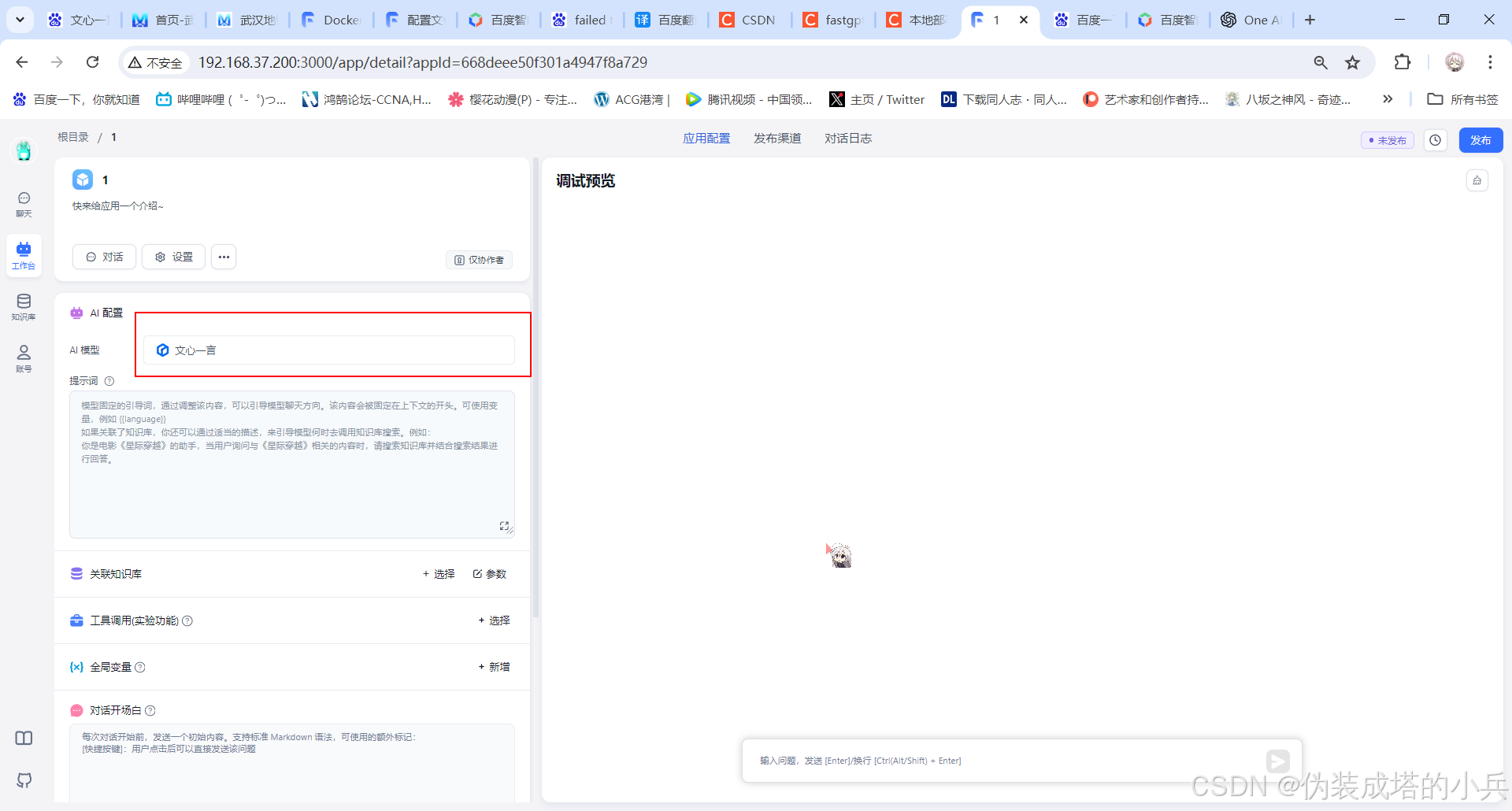

]3.3重启服务

[root@fastgpt fastgpt]# docker-compose down && docker-compose up -d

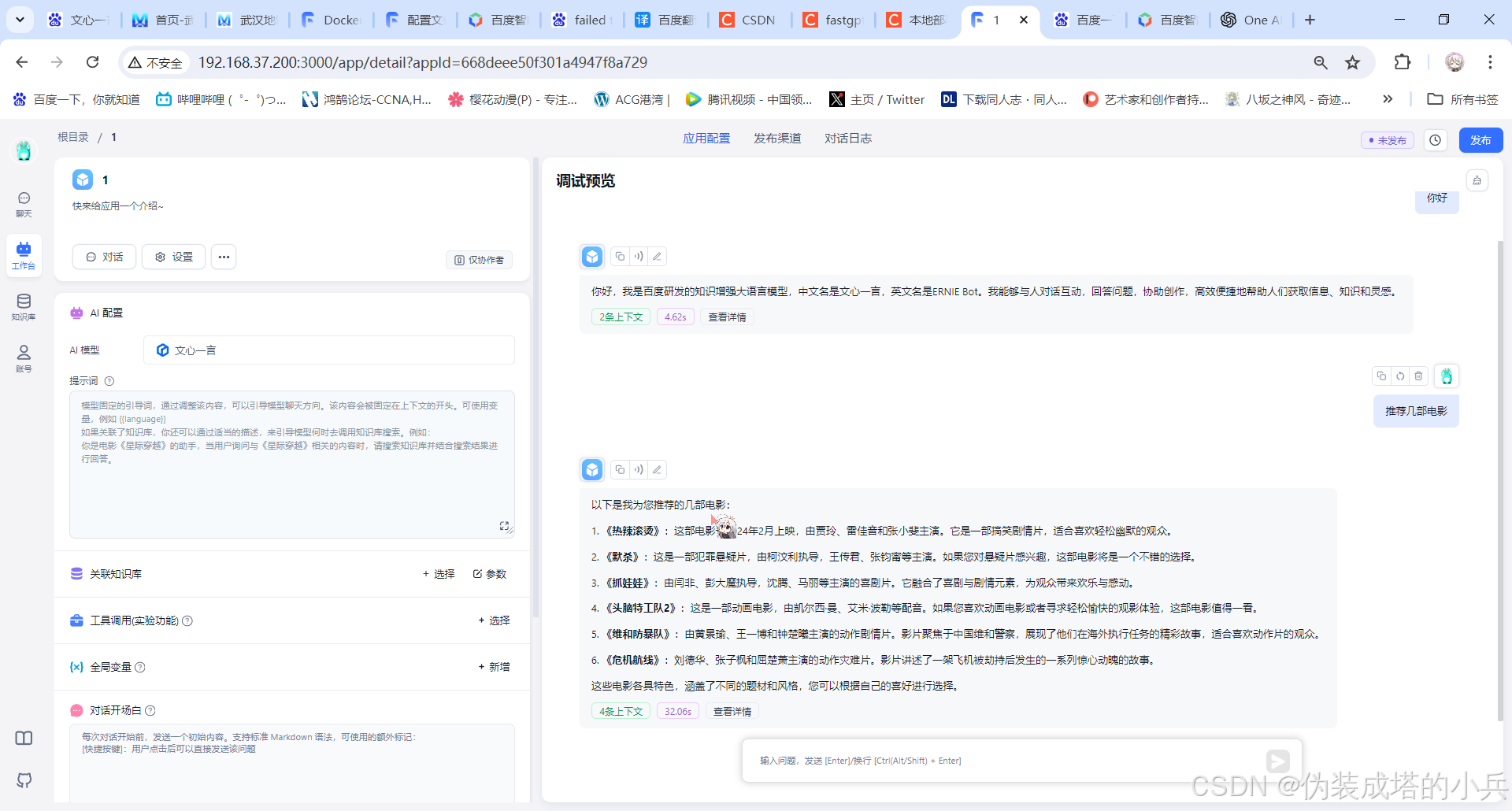

这里就可以选择文心一言进行对话了

我们尝试进行一次对话

这样我们就接入好了网络模型