Abstract

我们提出了UniDetector,一个通用的对象检测器,它有能力在开放世界中识别巨大的类别。UniDetector通用性的关键点是:

1)通过图像和文本空间的对齐,利用多源图像和异构标签空间进行训练,保证了足够的信息用于通用表示。

2)由于视觉和语言两种形态的丰富信息,它很容易泛化到开放世界,同时保持了可见和不可见类别之间的平衡。

3)通过我们提出的解耦训练方式和概率校准,进一步提升了对新类别的泛化能力。

这些贡献使UniDetector能够检测超过7k个类别,这是迄今为止最大的可测量类别大小,只有大约500个类参与培训。我们的UniDetector在大型词汇数据集上表现出强大的零概率泛化能力------在没有看到任何相应图像的情况下,它比传统的监督基线平均高出4%以上。在13个具有各种场景的公共检测数据集上,UniDetector仅使用3%的训练数据就达到了最先进的性能。

网络架构图

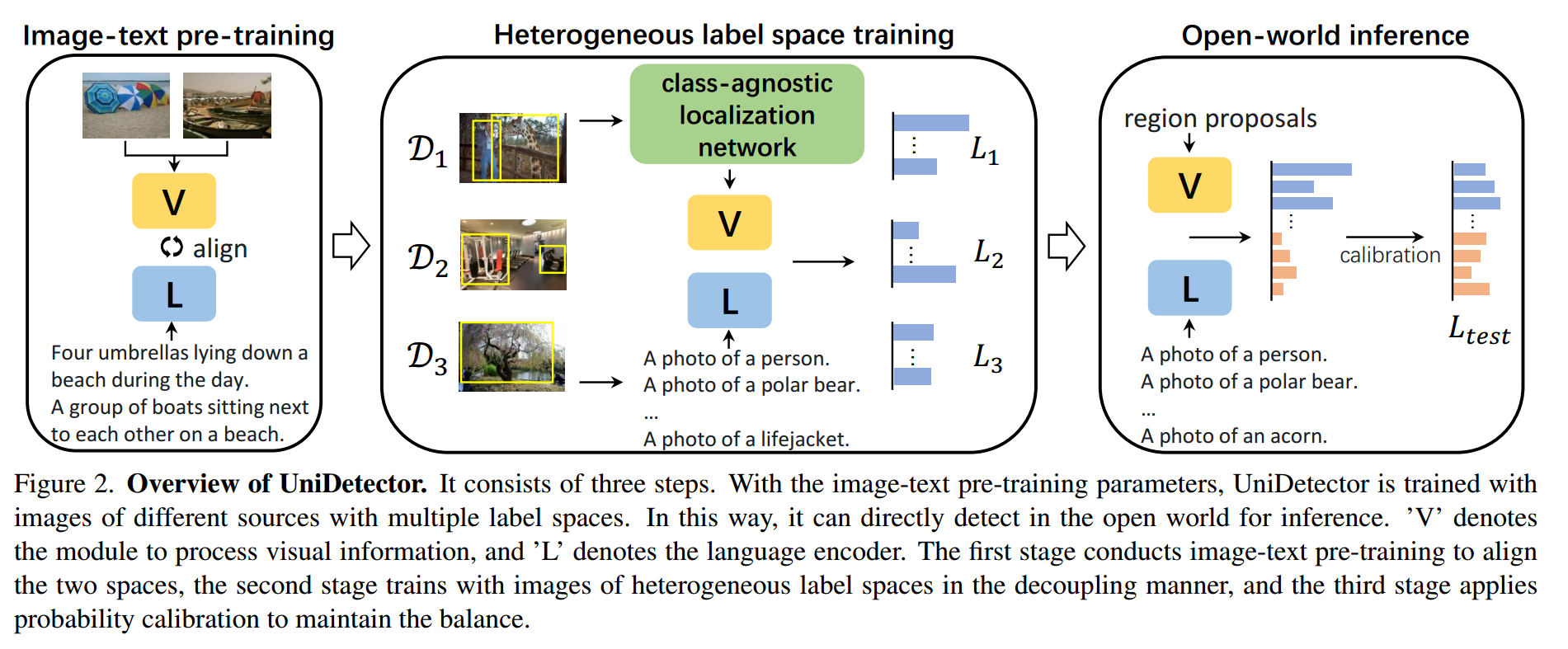

图2。UniDetector概述。它包括三个步骤。通过图像-文本预训练参数,UniDetector可以使用具有多个标签空间的不同来源的图像进行训练。这样,它可以直接在开放世界中进行检测进行推理。"V"表示处理视觉信息的模块,"L"表示语言编码器。第一阶段通过图像-文本预训练对齐两个空间,第二阶段通过解耦方式对异构标签空间的图像进行训练,第三阶段通过概率校准保持平衡。

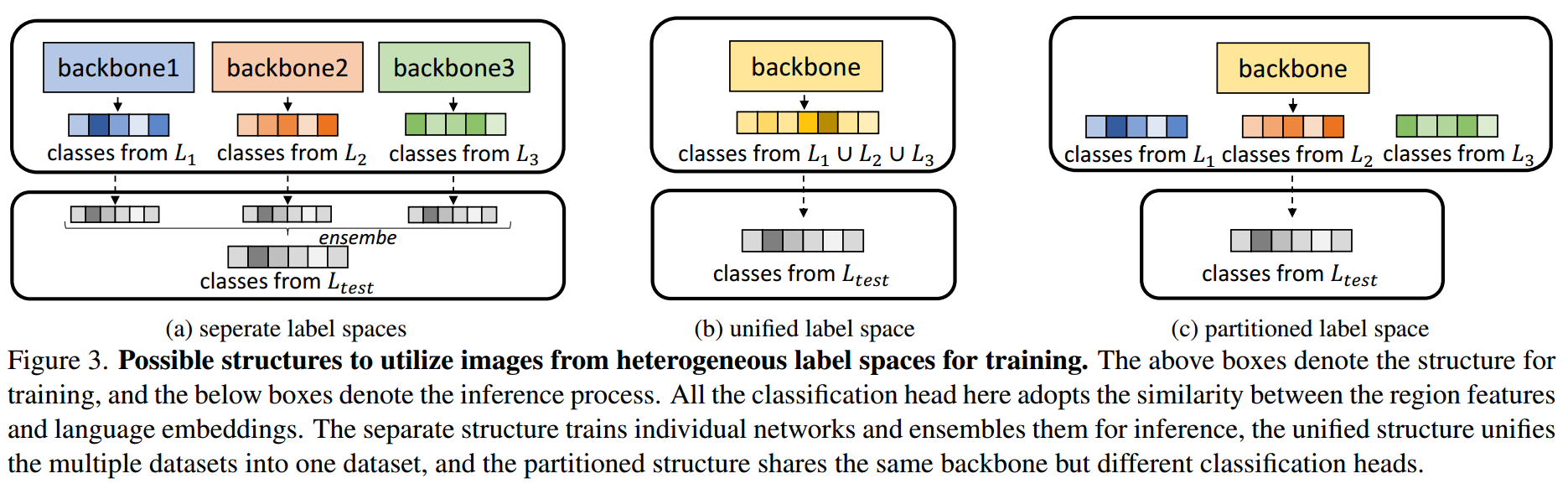

图3。利用来自异构标签空间的图像进行训练的可能结构。上面的方框表示训练结构,下面的方框表示推理过程。这里所有的分类头都采用了区域特征和语言嵌入之间的相似性。分离结构对单个网络进行训练并将其集成进行推理,统一结构将多个数据集统一为一个数据集,分割结构具有相同的主干但不同的分类头。

methods

- 异构标签空间训练:该框架在训练期间利用来自具有不同标签空间(L1、L2、...、Ln)的多个来源的图像。这种方法允许检测器从一组不同的类别中学习,促进特征共享并避免标签冲突 [T1]、[T3]。

- 解耦训练范式:UniDetector 将提案生成阶段与感兴趣区域 (RoI) 分类阶段解耦。这种分离允许每个阶段利用其独特的特性,增强检测器推广到新类别的能力 [T3]。

- 类别无关定位网络 (CLN):引入类别无关定位网络来生成广义区域提案。该网络旨在有效地跨各种类别工作,包括训练期间未看到的类别 [T3]。

- 概率校准:为了提高对新类别的预测能力,该框架采用了概率校准机制。这涉及估计所有类别的先验概率并相应地调整预测的类别分布,这有助于减少预测中的偏差 [T3]。

- 开放世界推理:该框架旨在处理开放世界推理,其中检测器可以从用户提供的新标签空间中预测类别标签,从而使其能够适应不属于训练集的新类别 [T1]、[T2]。

results

- 新类别上的性能:校准后,新类别的框平均精度 (AP) 和掩码 AP 均显着提高,提高了 2% 以上。这表明基类和新类别之间的性能差距显着缩小,而基类上的性能保持稳定。这种改进归因于概率校准,它减轻了训练模型中的偏差 [T1]。

- 与传统检测器的比较:在 LVIS v0.5 数据集上的实验中,传统监督检测器的 AP 为 17.7%。相比之下,UniDetector 仅使用 35k COCO 图像就实现了 16.4% 的 AP,而使用 60k Objects365 图像,AP 达到了 20.2%。这表明 UniDetector 可以实现与传统封闭世界检测器相当甚至更好的性能,同时需要的图像和带注释的类别明显更少 [T6]。

- 长尾问题缓解:UniDetector 还解决了传统检测器普遍面临的长尾问题。结果显示稀有类别和频繁类别之间的性能更加均衡,表明该框架有效地缓解了这一问题 [T5]。

- 最先进的结果:在封闭世界任务中,UniDetector 取得了最先进的结果,使用纯 CNN 模型 (ResNet50) 和 1× 调度在 COCO 数据集上获得了 49.3% 的 AP。这也凸显了该框架在定义明确的环境中的强大性能 [T3]。

conclusion

- 通用物体检测:UniDetector 是一种开创性的通用物体检测框架,可有效利用来自多个来源和异构标签空间的图像。这种能力使其能够很好地推广到开放世界,无需微调即可检测各种类别 [T6]。

- 强大的泛化能力:进行的大量实验证明了 UniDetector 具有很强的通用性。它显示了识别大量可测量类别的能力,与全监督方法相比,即使在没有接触这些类别的训练图像的情况下,也能在大词汇量数据集上实现更高的平均精度 (AP) [T5]。

- 弥合人工智能差距:该研究强调了通用性在弥合人工智能系统与生物机制之间的差距方面的重要性。通过解决检测新类别和提高不同场景下性能的挑战,UniDetector 为计算机视觉领域的发展做出了贡献 [T6]。

- 未来研究方向:作者认为,他们的工作将促进通用计算机视觉方向的进一步研究,鼓励探索能够增强物体检测系统在实际应用中的适应性和有效性的方法 [T6]。