快速入门 Jupyter notebook

- 一、前言

- 二、认识界面+快捷键

- [三、jupyter notebook中虚拟环境的配置](#三、jupyter notebook中虚拟环境的配置)

一、前言

(一)优点

- 以

代码块/单元格为单位运行,能够独立运行一个、几个或全部python代码块,可看到中间的结果,便于调试、找Bug - 可以

插入Markdown说明性文字、Latex数学公式,代码可读性强

Shift+Enter后的效果:

-

能够调用Ipython丰富的"魔法函数",如程序计时、自动重复运行、嵌入式显示图片等

-

写好的代码和文档能够

以网页、ppt的形式在线分享

-

可以在

云端远程服务器运行,不需本地安装配置各种环境

(二)特点

以ipython为内核 ------更高级的python解释器,相比原生的python交互式命令行,Ipython有更强大的命令计数、自动补全等交互功能

(三)调用运行

-

在默认目录

在 终端/Git Bash Here 令行直接输入 jupyter notebook

-

指定目录下(后面创建的文件也保存在该目录下)

法一:

法二:

注:跳转到 jupyter notebook网页版之后,原本的命令行窗口不能关

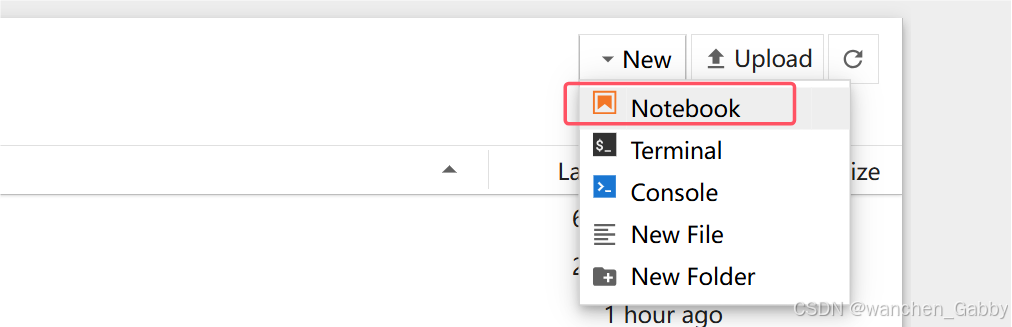

(四)新建

二、认识界面+快捷键

(一)三种模式

(1)蓝色模式:命令模式

按 Esc 进入,X 删除,Z 撤销

(2)绿色模式:编辑模式

摁 Enter 进入

(3)Markdown模式:解释说明

摁 M 进入,Shift+Enter 结束注释

另:摁 Ctrl+Shift+H 查看所有快捷键

(二)常用快捷键操作

- 编辑模式下:

上下键:在一个代码块中移动

Enter:下一行

Ctrl+Enter:只运行当前代码块

Shift+Enter:运行当前代码块并跳入下一代码块,如果当前代码块没有代码,就相当于新建的功能

Alt+Enter:运行当前代码块并在下方新建一个代码块

Esc:退出当前代码块 - 命令模式下:

上下键:在代码块之间移动

A:向上创建一个代码块

B:向下创建一个代码块

DD:删除本代码块

X:剪切代码块

V:粘贴到当前

M:变成 Markdown 单元格

Y:变成 代码 单元格

标记单元格可以用于输入文字 - Markdown模式下:

-

指单行公式,输出居中

三、jupyter notebook中虚拟环境的配置

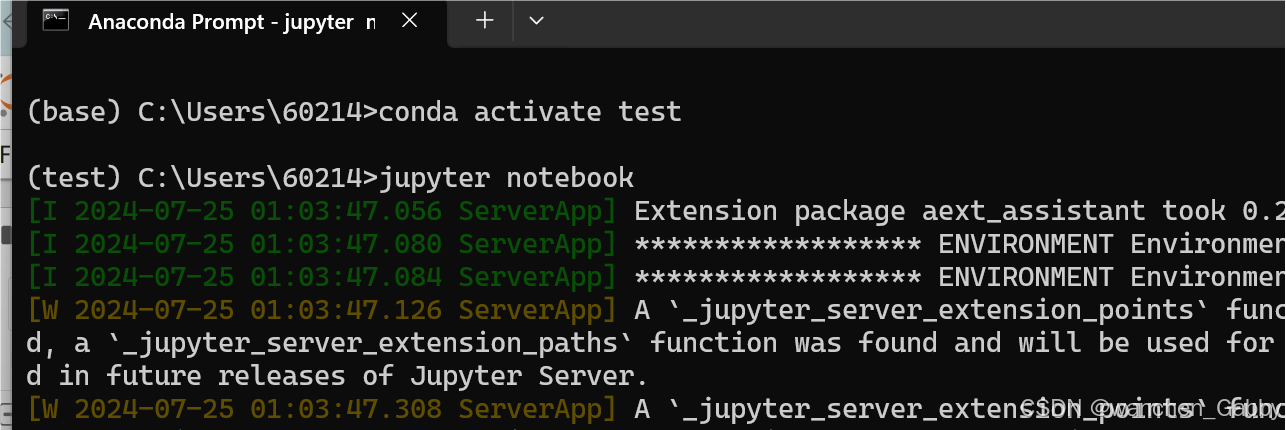

直接从命令行窗口的test虚拟环境下输入jupyter notebook进入,发现notebook中并没有进入我想要的虚拟环境

这时候就需要借助辅助的库

Step1:安装 ipykernel 库

python

conda install ipykernel

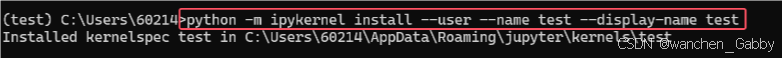

Step2:用 ipykernel 将当前环境写入notebook中

python

python -m ipykernel install --user --name 当前虚拟环境名称 --display-name 想在notebook中显示的虚拟环境的名称

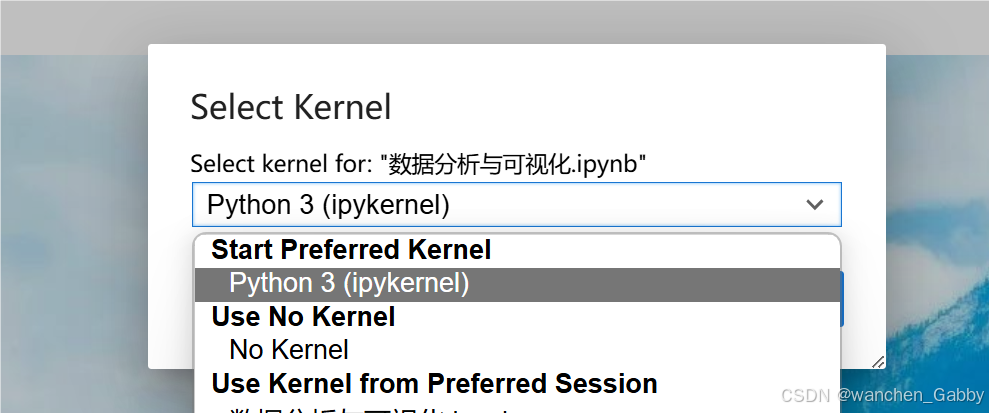

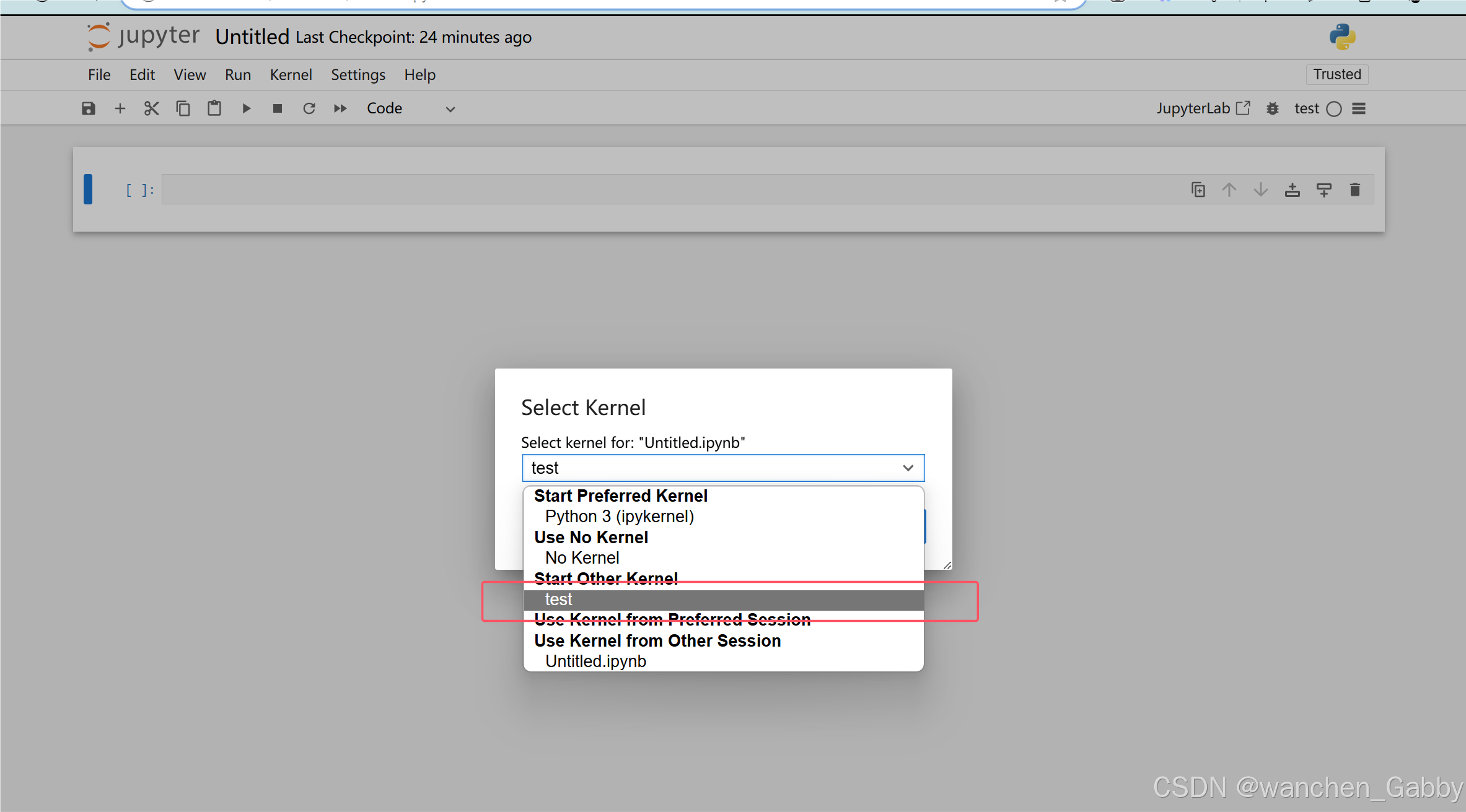

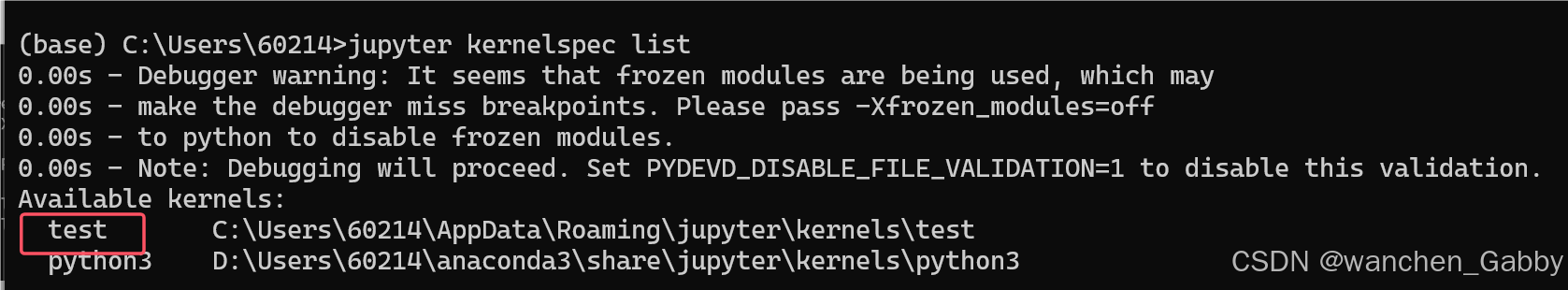

Step3:在 jupyter notebook 中即可找到此虚拟环境

python

# 在 Anaconda Prompt 中执行以下命令,也可查看 jupyter notebook 目前可用的内核

jupyter kernelspec list

拓展: .csv文件:用逗号分隔的值(可用Excel打开,逗号会默认被解析成单元格的边框)

完