音频播放开发概述

如何选择音频播放开发方式

系统提供了多样化的API,来帮助开发者完成音频播放的开发,不同的API适用于不同音频数据格式、音频资源来源、音频使用场景,甚至是不同开发语言。因此,选择合适的音频播放API,有助于降低开发工作量,实现更佳的音频播放效果。

-

AudioRenderer\]:用于音频输出的ArkTS/JS API,仅支持PCM格式,需要应用持续写入音频数据进行工作。应用可以在输入前添加数据预处理,如设定音频文件的采样率、位宽等,要求开发者具备音频处理的基础知识,适用于更专业、更多样化的媒体播放应用开发。

-

OpenSL ES\]:一套跨平台标准化的音频Native API,同样提供音频输出能力,仅支持PCM格式,适用于从其他嵌入式平台移植,或依赖在Native层实现音频输出功能的播放应用使用。

除上述方式外,也可以通过Media Kit实现音频播放。

-

AVPlayer\]:用于音频播放的ArkTS/JS API,集成了流媒体和本地资源解析、媒体资源解封装、音频解码和音频输出功能。可用于直接播放mp3、m4a等格式的音频文件,不支持直接播放PCM格式文件。

开发音频播放应用须知

应用如果要实现后台播放或熄屏播放,需要同时满足:

- 使用媒体会话功能注册到系统内统一管理,否则在应用进入后台时,播放将被强制停止。

- 申请长时任务避免进入挂起(Suspend)状态。

当应用进入后台,播放被中断,如果被媒体会话管控,将打印日志"pause id";如果没有该日志,则说明被长时任务管控。

AudioRenderer是音频渲染器,用于播放PCM(Pulse Code Modulation)音频数据,相比AVPlayer而言,可以在输入前添加数据预处理,更适合有音频开发经验的开发者,以实现更灵活的播放功能。

开发指导

使用AudioRenderer播放音频涉及到AudioRenderer实例的创建、音频渲染参数的配置、渲染的开始与停止、资源的释放等。本开发指导将以一次渲染音频数据的过程为例,向开发者讲解如何使用AudioRenderer进行音频渲染,建议搭配[AudioRenderer的API说明]阅读。

下图展示了AudioRenderer的状态变化,在创建实例后,调用对应的方法可以进入指定的状态实现对应的行为。需要注意的是在确定的状态执行不合适的方法可能导致AudioRenderer发生错误,建议开发者在调用状态转换的方法前进行状态检查,避免程序运行产生预期以外的结果。

为保证UI线程不被阻塞,大部分AudioRenderer调用都是异步的。对于每个API均提供了callback函数和Promise函数,以下示例均采用callback函数。

图1 AudioRenderer状态变化示意图

在进行应用开发的过程中,建议开发者通过[on('stateChange')]方法订阅AudioRenderer的状态变更。因为针对AudioRenderer的某些操作,仅在音频播放器在固定状态时才能执行。如果应用在音频播放器处于错误状态时执行操作,系统可能会抛出异常或生成其他未定义的行为。

- prepared状态: 通过调用[createAudioRenderer()]方法进入到该状态。

- running状态: 正在进行音频数据播放,可以在prepared状态通过调用[start()]方法进入此状态,也可以在paused状态和stopped状态通过调用[start()]方法进入此状态。

- paused状态: 在running状态可以通过调用[pause()]方法暂停音频数据的播放并进入paused状态,暂停播放之后可以通过调用[start()]方法继续音频数据播放。

- stopped状态: 在paused/running状态可以通过[stop()]方法停止音频数据的播放。

- released状态: 在prepared、paused、stopped等状态,用户均可通过[release()]方法释放掉所有占用的硬件和软件资源,并且不会再进入到其他的任何一种状态了。

开发步骤及注意事项

-

配置音频渲染参数并创建AudioRenderer实例,音频渲染参数的详细信息可以查看[AudioRendererOptions]。

import { audio } from '@kit.AudioKit';

let audioStreamInfo: audio.AudioStreamInfo = {

samplingRate: audio.AudioSamplingRate.SAMPLE_RATE_48000, // 采样率

channels: audio.AudioChannel.CHANNEL_2, // 通道

sampleFormat: audio.AudioSampleFormat.SAMPLE_FORMAT_S16LE, // 采样格式

encodingType: audio.AudioEncodingType.ENCODING_TYPE_RAW // 编码格式

};let audioRendererInfo: audio.AudioRendererInfo = {

usage: audio.StreamUsage.STREAM_USAGE_VOICE_COMMUNICATION,

rendererFlags: 0

};let audioRendererOptions: audio.AudioRendererOptions = {

streamInfo: audioStreamInfo,

rendererInfo: audioRendererInfo

};audio.createAudioRenderer(audioRendererOptions, (err, data) => {

if (err) {

console.error(Invoke createAudioRenderer failed, code is ${err.code}, message is ${err.message});

return;

} else {

console.info('Invoke createAudioRenderer succeeded.');

let audioRenderer = data;

}

}); -

调用on('writeData')方法,订阅监听音频数据写入回调。

import { BusinessError } from '@kit.BasicServicesKit';

import { fileIo } from '@kit.CoreFileKit';let bufferSize: number = 0;

class Options {

offset?: number;

length?: number;

}let path = getContext().cacheDir;

//确保该路径下存在该资源

let filePath = path + '/StarWars10s-2C-48000-4SW.wav';

let file: fileIo.File = fileIo.openSync(filePath, fileIo.OpenMode.READ_ONLY);let writeDataCallback = (buffer: ArrayBuffer) => {

let options: Options = {

offset: bufferSize,

length: buffer.byteLength

}

fileIo.readSync(file.fd, buffer, options);

bufferSize += buffer.byteLength;

}audioRenderer.on('writeData', writeDataCallback);

-

调用start()方法进入running状态,开始渲染音频。

import { BusinessError } from '@kit.BasicServicesKit';

audioRenderer.start((err: BusinessError) => {

if (err) {

console.error(Renderer start failed, code is ${err.code}, message is ${err.message});

} else {

console.info('Renderer start success.');

}

}); -

调用stop()方法停止渲染。

import { BusinessError } from '@kit.BasicServicesKit';

audioRenderer.stop((err: BusinessError) => {

if (err) {

console.error(Renderer stop failed, code is ${err.code}, message is ${err.message});

} else {

console.info('Renderer stopped.');

}

}); -

调用release()方法销毁实例,释放资源。

import { BusinessError } from '@kit.BasicServicesKit';

audioRenderer.release((err: BusinessError) => {

if (err) {

console.error(Renderer release failed, code is ${err.code}, message is ${err.message});

} else {

console.info('Renderer released.');

}

});

完整示例

下面展示了使用AudioRenderer渲染音频文件的示例代码。

import { audio } from '@kit.AudioKit';

import { BusinessError } from '@kit.BasicServicesKit';

import { fileIo } from '@kit.CoreFileKit';

const TAG = 'AudioRendererDemo';

class Options {

offset?: number;

length?: number;

}

let context = getContext(this);

let bufferSize: number = 0;

let renderModel: audio.AudioRenderer | undefined = undefined;

let audioStreamInfo: audio.AudioStreamInfo = {

samplingRate: audio.AudioSamplingRate.SAMPLE_RATE_48000, // 采样率

channels: audio.AudioChannel.CHANNEL_2, // 通道

sampleFormat: audio.AudioSampleFormat.SAMPLE_FORMAT_S16LE, // 采样格式

encodingType: audio.AudioEncodingType.ENCODING_TYPE_RAW // 编码格式

}

let audioRendererInfo: audio.AudioRendererInfo = {

usage: audio.StreamUsage.STREAM_USAGE_MUSIC, // 音频流使用类型

rendererFlags: 0 // 音频渲染器标志

}

let audioRendererOptions: audio.AudioRendererOptions = {

streamInfo: audioStreamInfo,

rendererInfo: audioRendererInfo

}

let path = getContext().cacheDir;

//确保该路径下存在该资源

let filePath = path + '/StarWars10s-2C-48000-4SW.wav';

let file: fileIo.File = fileIo.openSync(filePath, fileIo.OpenMode.READ_ONLY);

let writeDataCallback = (buffer: ArrayBuffer) => {

let options: Options = {

offset: bufferSize,

length: buffer.byteLength

}

fileIo.readSync(file.fd, buffer, options);

bufferSize += buffer.byteLength;

}

// 初始化,创建实例,设置监听事件

function init() {

audio.createAudioRenderer(audioRendererOptions, (err, renderer) => { // 创建AudioRenderer实例

if (!err) {

console.info(`${TAG}: creating AudioRenderer success`);

renderModel = renderer;

if (renderModel !== undefined) {

(renderModel as audio.AudioRenderer).on('writeData', writeDataCallback);

}

} else {

console.info(`${TAG}: creating AudioRenderer failed, error: ${err.message}`);

}

});

}

// 开始一次音频渲染

function start() {

if (renderModel !== undefined) {

let stateGroup = [audio.AudioState.STATE_PREPARED, audio.AudioState.STATE_PAUSED, audio.AudioState.STATE_STOPPED];

if (stateGroup.indexOf((renderModel as audio.AudioRenderer).state.valueOf()) === -1) { // 当且仅当状态为prepared、paused和stopped之一时才能启动渲染

console.error(TAG + 'start failed');

return;

}

// 启动渲染

(renderModel as audio.AudioRenderer).start((err: BusinessError) => {

if (err) {

console.error('Renderer start failed.');

} else {

console.info('Renderer start success.');

}

});

}

}

// 暂停渲染

function pause() {

if (renderModel !== undefined) {

// 只有渲染器状态为running的时候才能暂停

if ((renderModel as audio.AudioRenderer).state.valueOf() !== audio.AudioState.STATE_RUNNING) {

console.info('Renderer is not running');

return;

}

// 暂停渲染

(renderModel as audio.AudioRenderer).pause((err: BusinessError) => {

if (err) {

console.error('Renderer pause failed.');

} else {

console.info('Renderer pause success.');

}

});

}

}

// 停止渲染

async function stop() {

if (renderModel !== undefined) {

// 只有渲染器状态为running或paused的时候才可以停止

if ((renderModel as audio.AudioRenderer).state.valueOf() !== audio.AudioState.STATE_RUNNING && (renderModel as audio.AudioRenderer).state.valueOf() !== audio.AudioState.STATE_PAUSED) {

console.info('Renderer is not running or paused.');

return;

}

// 停止渲染

(renderModel as audio.AudioRenderer).stop((err: BusinessError) => {

if (err) {

console.error('Renderer stop failed.');

} else {

fileIo.close(file);

console.info('Renderer stop success.');

}

});

}

}

// 销毁实例,释放资源

async function release() {

if (renderModel !== undefined) {

// 渲染器状态不是released状态,才能release

if (renderModel.state.valueOf() === audio.AudioState.STATE_RELEASED) {

console.info('Renderer already released');

return;

}

// 释放资源

(renderModel as audio.AudioRenderer).release((err: BusinessError) => {

if (err) {

console.error('Renderer release failed.');

} else {

console.info('Renderer release success.');

}

});

}

}当同优先级或高优先级音频流要使用输出设备时,当前音频流会被中断,应用可以自行响应中断事件并做出处理。

最后呢

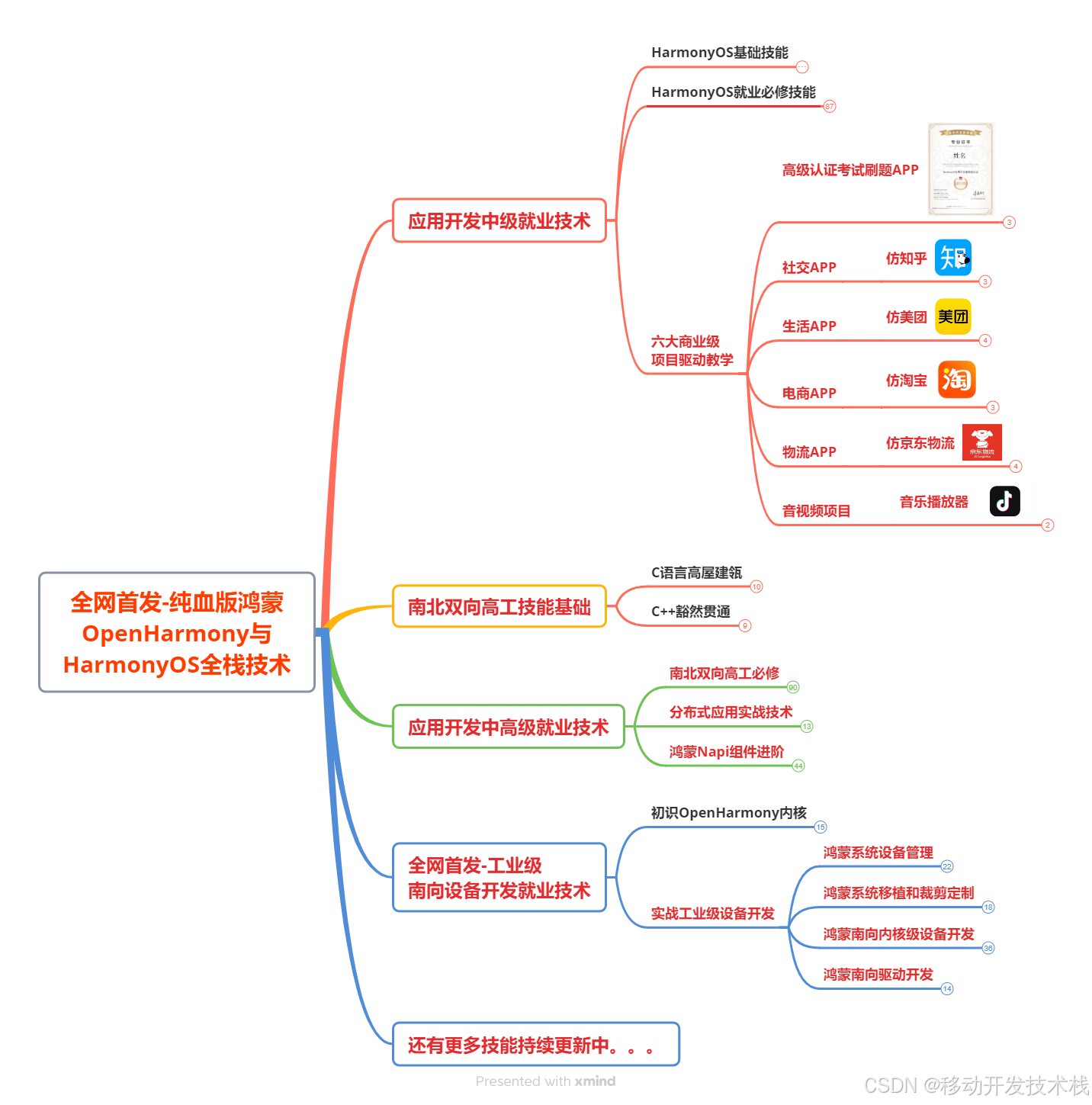

很多开发朋友不知道需要学习那些鸿蒙技术?鸿蒙开发岗位需要掌握那些核心技术点?为此鸿蒙的开发学习必须要系统性的进行。

而网上有关鸿蒙的开发资料非常的少,假如你想学好鸿蒙的应用开发与系统底层开发。你可以参考这份资料,少走很多弯路,节省没必要的麻烦。由两位前阿里高级研发工程师联合打造的《鸿蒙NEXT星河版OpenHarmony开发文档 》里面内容包含了(ArkTS、ArkUI开发组件、Stage模型、多端部署、分布式应用开发、音频、视频、WebGL、OpenHarmony多媒体技术、Napi组件、OpenHarmony内核、Harmony南向开发、鸿蒙项目实战等等)鸿蒙(Harmony NEXT)技术知识点

如果你是一名Android、Java、前端等等开发人员,想要转入鸿蒙方向发展。可以直接领取这份资料辅助你的学习。下面是鸿蒙开发的学习路线图。

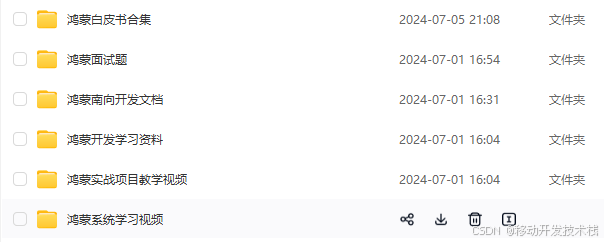

针对鸿蒙成长路线打造的鸿蒙学习文档。话不多说,我们直接看详细鸿蒙(OpenHarmony )手册(共计1236页)与鸿蒙(OpenHarmony )开发入门视频,帮助大家在技术的道路上更进一步。

- 《鸿蒙 (OpenHarmony)开发学习视频》

- 《鸿蒙生态应用开发V2.0白皮书》

- 《鸿蒙 (OpenHarmony)开发基础到实战手册》

- OpenHarmony北向、南向开发环境搭建

- 《鸿蒙开发基础》

- 《鸿蒙开发进阶》

- 《鸿蒙开发实战》

总结

鸿蒙---作为国家主力推送的国产操作系统。部分的高校已经取消了安卓课程,从而开设鸿蒙课程;企业纷纷跟进启动了鸿蒙研发。

并且鸿蒙是完全具备无与伦比的机遇和潜力的;预计到年底将有 5,000 款的应用完成原生鸿蒙开发,未来将会支持 50 万款的应用。那么这么多的应用需要开发,也就意味着需要有更多的鸿蒙人才。鸿蒙开发工程师也将会迎来爆发式的增长,学习鸿蒙势在必行! 自↓↓↓拿