传统视频监控系统作为安全体系的"眼睛",长期停留在"记录回放"的被动阶段。据统计,企业部署的摄像头中,高达92%的视频数据从未被查看,99%的潜在风险被淹没在海量视频中。视频安全监测系统通过融合计算机视觉、深度学习与边缘计算技术,实现了三大核心突破:

- 感知智能化突破

系统采用多尺度特征融合网络,在1080P分辨率下可实现97.3%的人体检测准确率,同时对15类安全违规行为(如未佩戴安全帽、区域入侵、烟雾火焰等)实现90%以上的识别准确率。相比传统人工监控,风险发现效率提升300倍。

- 分析实时化突破

基于边缘计算架构,系统可在摄像头端完成90%的视频分析任务,实现200毫秒级事件识别与响应。典型场景下,从异常发生到系统报警的平均延时从传统方案的15分钟缩短至3秒以内。

- 决策精准化突破

通过时空上下文建模与多摄像头协同分析,系统误报率控制在5%以下。在化工厂等高危环境中,系统可准确区分正常作业与违规操作,避免因环境干扰导致的误报警。

系统架构:四层智能视觉处理体系

2.1 感知采集层:多维视觉感知网络

多光谱成像系统:集成可见光、热成像、微光增强三通道传感器,实现全天候监测能力。热成像模块可检测-20℃至550℃温度范围,精度达±2℃。

智能摄像机组网:采用分级部署策略,关键区域部署AI智能摄像头(算力4-16TOPS),普通区域采用普通摄像头+边缘分析单元方案,优化整体投资成本。

编码传输优化:采用H.265+智能编码技术,在同等画质下节省40%带宽,支持4K视频的实时分析与存储。

2.2 边缘计算层:分布式智能分析

在摄像头或近端部署边缘计算设备,实现:

实时视频结构化:提取人、车、物等目标的特征向量,生成结构化元数据

轻量化模型推理:部署经知识蒸馏优化的YOLOv5s模型,在Jetson系列设备上实现30fps实时分析

本地规则引擎:执行500+条安全规则,支持复杂逻辑组合(如"区域A有人入侵AND未佩戴安全装备→立即报警")

2.3 平台分析层:深度认知与关联分析

云端分析平台构建四大核心能力:

3.1 多目标跟踪与行为分析

-

采用DeepSORT算法实现多摄像头间目标连续跟踪

-

基于Transformer架构的行为识别模型,可识别20类安全相关行为

-

轨迹异常检测准确率达89.2%,有效识别徘徊、滞留等风险行为

3.2 场景理解与事件推理

-

构建场景知识图谱,关联设备状态、环境参数、人员权限等信息

-

采用图神经网络进行事件关联分析,识别复杂安全事件

-

支持"如果...那么..."规则的自定义与优化

3.3 预测性预警模型

-

基于LSTM的时间序列预测,预警准确率较传统阈值法提升42%

-

融合多模态数据的风险评分模型,输出0-100风险指数

-

支持风险发展趋势可视化展示

3.4 大规模视频检索

-

采用特征向量相似度搜索,3秒内完成百万级视频片段检索

-

支持"以图搜图""以行为搜视频"等智能检索方式

-

检索准确率可达95%以上

2.4 应用交互层:智能运营与决策支持

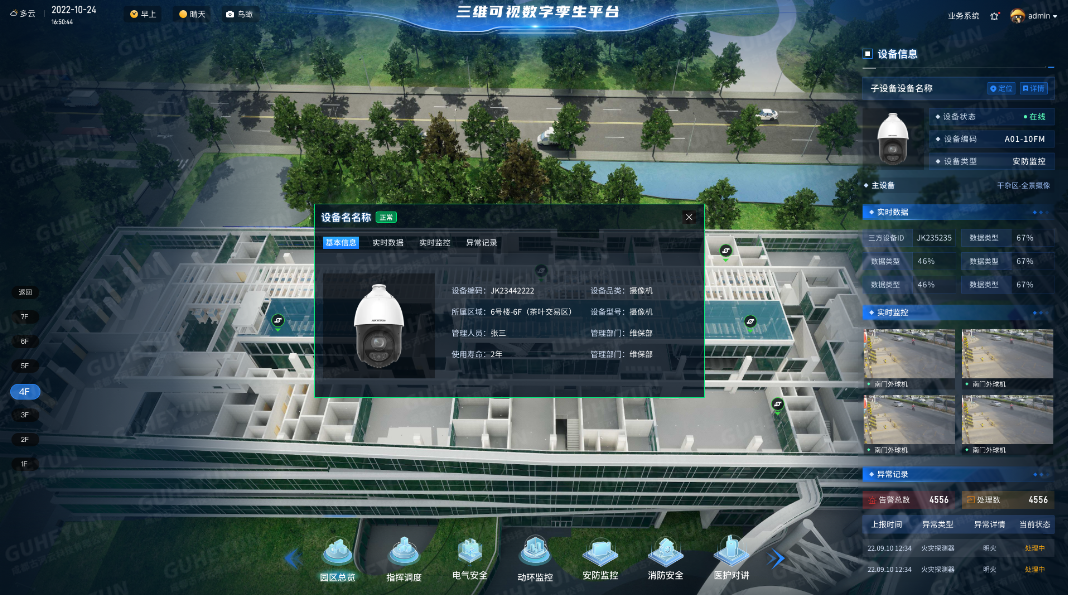

视频实况一张图:融合GIS地图与实时视频流,支持全局态势感知

智能告警中心:多级告警(提示/预警/报警/紧急)与智能分发

AR增强实战:移动端支持AR标签、远程标注、专家协同

数据分析驾驶舱:多维度安全数据可视化与统计分析

核心技术实现与性能指标

3.1 高精度目标检测算法

系统采用改进的YOLOv5架构,在自建工业安全数据集(包含10万张标注图像)上训练,实现:

-

安全帽/反光衣检测准确率:98.7%/97.2%

-

烟雾火焰检测准确率:96.5%

-

人员跌倒检测准确率:94.3%

-

每帧处理时间:15ms

3.2 复杂场景下的行为识别

针对工业环境挑战(光照变化、遮挡、视角变化),系统采用:

-

时空双流网络架构,融合外观特征与运动特征

-

自适应注意力机制,聚焦关键区域

-

在UT-Interaction等标准数据集上,行为识别准确率达91.8%

3.3 多摄像头协同分析

通过跨摄像头目标重识别与轨迹关联,系统实现:

-

跨摄像头目标ID保持准确率:93.5%

-

全局轨迹重建完整度:88.7%

-

协同监控区域覆盖率提升至100%

视频安全监测系统的智能化转型,本质上是将海量视频数据从"存储负担"转变为"安全资产"。系统通过深度学习算法赋予摄像头"理解"场景的能力,通过边缘计算架构实现"实时"响应,通过平台化分析达成"精准"预警。

在当前数字化转型的浪潮中,智能视频监控已从安防系统的可选组件升级为企业安全生产的必备基础设施。它不仅大幅提升了安全管理的效率与效果,更为企业构建了数据驱动的安全决策体系。