笔记整理:汪俊杰,浙江大学硕士,研究方向为知识图谱、大预言模型

论文链接:http://arxiv.org/abs/2311.13314

发表会议:AAAI2024

1. 动机

大型语言模型(LLMs)在生成文本时常常会生成与事实不符的错误陈述,这种现象被称为"事实幻觉"。 为了解决这一问题,研究者们提出了将存储大量高质量事实信息的知识图谱(KGs)与LLMs结合的方法,可以显著减少事实幻觉的发生。尽管已有一些方法尝试通过检索知识图谱中的实体来增强LLMs的事实知识,但这些方法通常仅限于检索与给定查询中明确提及的实体相关的知识,而忽略对于LLMs推理过程的验证。因此,现有方法在处理LLMs推理过程中的事实幻觉方面存在不足。为了解决上述问题,本文提出了一种名为"Knowledge Graph-based Retrofitting"(KGR)的新框架。KGR的核心思想是自主地根据知识图谱中存储的事实知识来校验和改造LLMs的初始响应。

2. 方法

图1. KGR框架示意图

如图1所示,KGR框架总共分为5个步骤:

(1).声明提取:从生成的初始回答中提取需要验证的事实声明。

(2).实体检测和知识图谱检索:检测声明中的关键实体,并从知识图谱中检索相关的知识三元组。

(3).事实选择:从检索到的知识三元组中选择与初始回答相关的事实陈述。

(4).声明验证:使用检索到的事实知识验证提取的事实声明的正确性。

(5).回答改造:根据验证结果改造初始回答。

框架中的每一步都通过精心设计Prompt来引导另外的LLMs自动化地完成框架中的指定模块。在声明提取、实体检测和事实选择中,作者在Prompt中给定一些Few-shot上下文学习样例,从而提取出原回答中需要被校验的声明以及KGs中对应的事实知识。在声明验证中,作者利用KGs中的事实知识让LLMs判断声明的正确性,并将这一步的判断结果输送给下一个模块的LLMs,让其对回答进行改造。

3. 实验

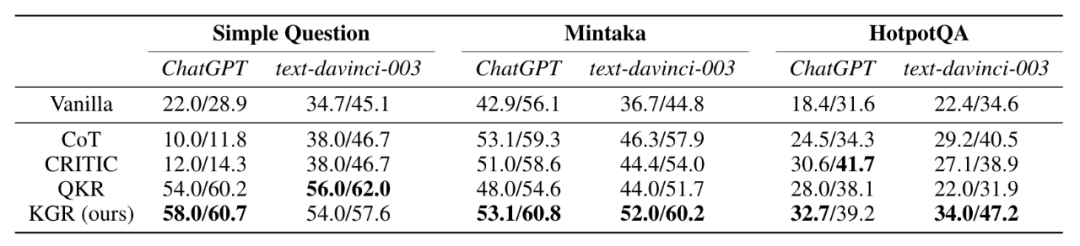

表1 基于ChatGPT和text-danvinci-003在常见事实性问答数据集上的实验结果

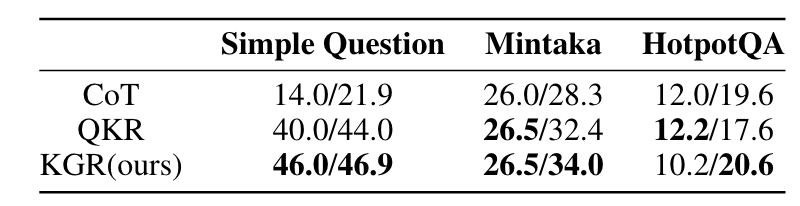

表2 基于Vicuna 13B在常见事实性问答数据集上的实验结果

3.1 实验细节

评估指标:实验结果通过精确度(Exact Match, EM)和F1分数来报告。这些指标在每个数据集的验证集上的50个样本中进行了评估。

模型和KGs选择:实验评估了KGR框架在闭源和开源大型语言模型上的有效性,闭源模型选择了text-davinci-003和ChatGPT (gpt-3.5-turbo-0301),开源模型选择了Vicuna 13B。KGs选择了Wikidata。

基线方法:1.Vanilla:直接提示模型为给定问题生成答案;2. CoT:通过提示LLMs生成更全面和详细的解释来生成更可靠的答案;3. CRITIC:基于网络文本修订答案;4. QKR:使用知识图谱中检索到的问题相关事实作为提示来生成答案。

3 .2 实验结果

如表1和表2所示,KGR框架在三个不同的数据集上均取得了性能提升。与CoT和CRITIC基线相比,KGR框架更有效,因为它依赖于可靠的知识库,而基于IR的方法,如CRITIC,可能会引入外部噪声。同时,在面对复杂问题和多跳问题时(Mintaka、HotpotQA),KGR框架的优越性更为显著,对比基线方法有了更大的提升。此外,KGR框架不仅在闭源模型上表现良好,还在开源模型Vicuna 13B上展示了其泛化能力,证明了KGR框架的通用性。

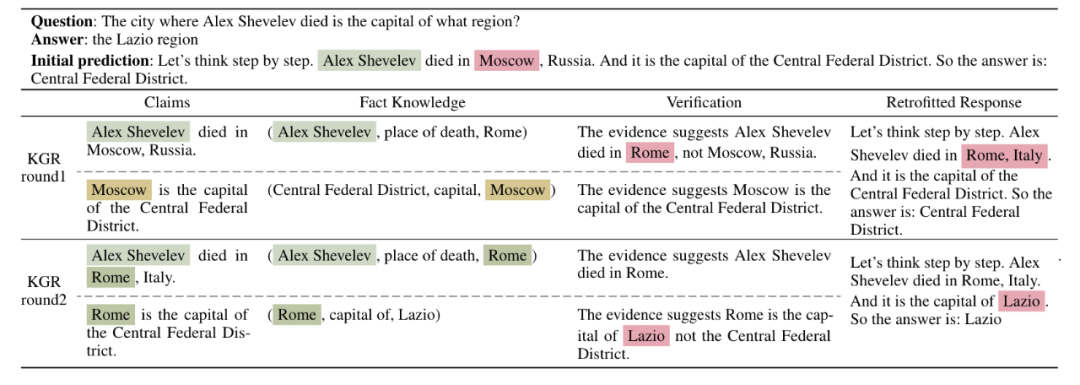

表3 Case study

表3中展示了一个多跳问题例子的多轮改造过程,说明了KGR框架如何逐步纠正事实错误。例如,在处理"Alex Shevelev死于哪个地区"的问题时,模型最初错误地认为他在莫斯科去世,并错误地将莫斯科识别为中央联邦区的首府。通过KGR的迭代过程,模型最终能够正确地识别出Alex Shevelev实际上在罗马去世,并且罗马是拉齐奥地区的首府。

3.3 错误分析

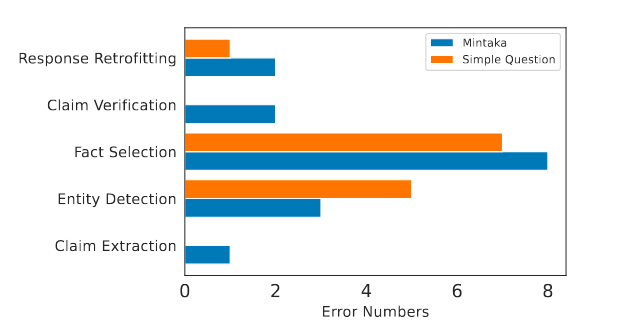

图2 错误分析

图2为KGR框架的错误分析,具体而言:1. 在声明提取中,有时声明提取无法充分表达核心声明,这可能是由于过度使用代词,导致模型理解混淆;2. 在实体检测中,实体检测在提取实体时的粒度控制存在问题,有时会捕获太多普通实体(如"电影"或"苹果"),导致检索到的三元组过多且无关紧要;3.在事实选择中,对于包含噪声的多个三元组,难以提取关键的三元组;4.在声明验证和响应改造中,这两个步骤更依赖于模型遵循少量示例提示(few-shot prompts)提供的线索的能力。

与声明提取、声明验证和响应改造相比,实体检测和事实选择的准确性较低。这些发现突出了进一步改进实体检测和事实选择的重要性。

4. 总结

这篇论文提出了一种名为KGR(Knowledge Graph-based Retrofitting)的新框架,旨在通过结合知识图谱(KGs)来减轻大型语言模型(LLMs)在推理过程中产生的事实幻觉问题。KGR框架自主地提取、验证和改造LLMs生成的响应,确保其与知识图谱中存储的事实知识一致。作者设计了一个包含声明提取、实体检测、事实选择、声明验证和响应改造的流程,并通过少量示例提示引导LLMs自主完成这些步骤。实验结果表明,KGR框架显著提升了LLMs在事实问答基准测试中的性能,特别是在处理复杂推理任务时。这项工作不仅展示了KGR框架的在缓解LLMs幻觉问题时的有效性,为未来该领域的改进提供了方向。

OpenKG

OpenKG(中文开放知识图谱)旨在推动以中文为核心的知识图谱数据的开放、互联及众包,并促进知识图谱算法、工具及平台的开源开放。

点击阅读原文 ,进入 OpenKG 网站。