概述

论文地址:https://arxiv.org/pdf/2403.19876.pdf

近年来,大规模语言模型发展迅速。它们给研究和教育领域带来了许多变化。这些模型也是对人机交互(HCI)研究过程的有力补充,可以分析定性和定量数据,再现社会科学实验,模拟新的社会动态。另一方面,已经发现了错误信息、歧视和侵犯隐私的风险,因此需要仔细考虑如何安全使用大规模语言模型。

过去曾对人机交互领域的伦理问题进行过研究,但大规模语言模型的应用带来了前所未有的挑战。关于如何将大规模语言模型纳入项目、存在哪些伦理问题以及如何解决这些问题,已经进行了大量的研究和讨论,以填补实际应用中的空白,实现大规模语言模型的有效和伦理整合。

本文通过对 50 名人机交互研究人员进行问卷调查和 16 次访谈得出的数据,展示了大规模语言模型在整个人机交互研究过程中的应用情况。这包括从创意生成到系统开发和论文撰写的一系列应用。本文还探讨了研究人员对与大规模语言模型相关的潜在伦理问题的预期和应对措施。

最后,基于这些发现,报告提出了研究伦理的重要性以及相关的具体建议,如与伦理审查委员会等合作、改进知情同意程序、扩大伦理教育机会、修改研究激励结构等。人机交互领域一直在与大型语言模型合作,这表明未来的主要挑战将是如何在整合模型时促进这些伦理考虑因素。

问卷调查

本文重点探讨人机交互研究人员如何将大规模语言模型纳入其研究过程,以及他们如何解决伦理方面的问题。为了全面了解这方面的情况,我们采用了顺序解释设计(SED)方法,通过调查和半结构化访谈来收集来自不同角度的意见。通过这种方法,可以深入调查研究人员处理伦理问题的具体方法。请注意,本研究项目已获得贵机构 IRB 的批准。

调查使用 Qualtrics 实施的在线问卷,收集了 50 名受访者的数据。参与者是通过社交媒体广告、直接电子邮件和大学邮件列表等多种渠道招募的。调查开始时已征得参与者的知情同意,个人身份信息不予记录。选择标准是,参与者必须是从事人机交互相关领域工作的研究人员,并具有使用大规模语言模型的经验。

在最后 77 名参与者中,有 50 人完成了所有部分(不包括人口信息)。在回答人口统计学信息的 43 位参与者中,许多人表示他们在学术界、工业界或非营利组织工作。这些参与者来自美国、阿富汗、德国、阿尔及利亚、香港、中国、西班牙、尼日利亚、澳大利亚和日本等不同国家,在人机交互领域的不同子领域工作。参与者从事人机交互研究的平均时间为四年。

它还使用了一份由 18 个问题组成的调查问卷。其中包括 14 个多项选择题和 4 个开放式问题。调查问卷将大规模语言模型定义为 "生成式(和多模态)语言模型的一个子集,其规模随参数数量和训练数据规模的增加而增加",并将GPT-4、GPT-3.5、Llama 2 和 Vicuna描述为具体示例。

调查参与者被要求根据他们在近期研究项目中使用大规模语言模型的经验回答问题,这些问题分为三个部分

- 关于在人机交互研究项目中使用大规模语言模型的问题

- 在人机交互研究中使用大规模语言模型的伦理问题。

- 与研究相关的人口统计学问题。

问卷的第一部分用一句话描述了该项目,并询问了所使用的主要研究方法、人机交互子领域以及纳入大规模语言模型的研究过程的各个阶段。它还重点关注了与使用大规模语言模型相关的潜在伦理考虑因素,询问 "您在研究项目中是否遇到或观察到任何与大规模语言模型相关的伦理挑战?"来询问有关伦理挑战的封闭式和开放式问题。它还询问了这些伦理挑战是如何发现、解决和报告的。最后,还包括有关受访者机构类型、国家和从事人机交互研究年限的人口统计学问题。请注意,此回答为可选回答。

数据分析使用 SPSS 计算描述性统计,分析研究人员如何处理与大规模语言模型相关的伦理问题。特别是,它纳入了提供多项选择答案的问题的统计数据(例如,使用大规模语言模型时的伦理问题)。对于只有部分受访者完成的问题,我们会计算特定问题的回复率以及回答该问题的受访者比例。

访谈调查

2023 年 10 月至 11 月间,16 位使用大规模语言模型开展研究项目的人机交互研究人员接受了采访。每次访谈都从描述参与者最近的项目开始,探讨大规模语言模型在项目中的应用情况。访谈的重点是大规模语言模型在整个研究过程中的使用、具体的伦理考虑因素、如何驾驭伦理考虑因素、IRB 的作用、伦理框架和工具包的作用、激励机制和责任。

参与者是通过分发名单、专业网络和个人联系等方式招募的,并采用滚雪球式抽样和目的性抽样进行重复抽样。样本包括来自美国、中国、新加坡和德国的研究人员,其中许多是在学术界工作的男性和女性研究人员。

访谈通过视频会议在线进行,所有环节均以英语进行。访谈前,我们会向参与者解释访谈目的,并获得电子版知情同意书,参与者可以随时拒绝回答问题或要求暂停录制。每次访谈大约持续 40-60 分钟,逐字记录的笔记和视频将用于日后分析。参与者可获得价值 30 美元的礼品卡。

采用了布劳恩和克拉克的反思性专题分析方法来分析定性数据。研究小组多次阅读每次访谈的记录,首先对伦理因素和问题进行开放式编码。研究小组定期召开会议,根据初始编码反复确定主题和类别。由此确定了研究过程、伦理问题和伦理考虑方法等类别,并最终将这些类别作为最高级别纳入研究结果中。

研究结果:人机交互研究人员在日常工作中使用的大规模语言模型

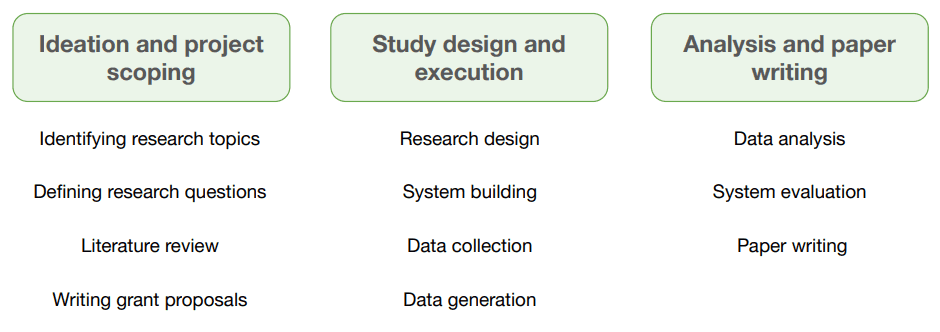

本文介绍了人机交互研究人员如何将大规模语言模型纳入日常研究工作的发现。它揭示了大规模语言模型是如何应用于研究的各个阶段的,包括构思、文献综述、研究设计、数据分析、系统构建、评估和撰写论文。

特别是,它们最常用于论文撰写和研究设计阶段,其次是项目范围界定、系统开发、数据生成和收集以及分析。研究表明,人们认识到,大规模语言模型为研究 "开辟了新的可能性",而且 "如果使用得当,它们可以让人们做一些很酷的事情,真正增强能力"。

在研究的早期阶段,参与者使用大规模语言模型确定新的研究问题,然后将这些问题细化为具体的研究目标。例如,一位学员在大规模语言模型中输入了一个广泛的主题领域,并根据生成的研究问题确定了研究目标。另一位参与者则利用大规模语言模型寻求职业导师的建议,并探索人工智能与网络安全交叉领域的研究课题。这些活动让人机交互研究人员迅速产生了各种各样的想法,对头脑风暴大有帮助。

此外,大规模语言模型在数据相关任务中的应用也在不断扩大。许多研究人员正在利用大规模语言模型综合网络来源的信息,从而大大简化了通常需要花费大量时间和精力的任务。大规模语言模型还被纳入数据分析的每个过程,包括定性数据编码、绘图和数据可视化,有助于提高研究的质量和速度。

这项研究的结果表明了人机交互领域中法律硕士的多样化应用和潜力,并为研究人员提供了新的研究方法。

研究结果:人机交互研究人员对使用大规模语言模型的伦理关切

人机交互研究人员在使用大规模语言模型时遇到了各种伦理挑战。研究结果显示,30 位研究人员发现了伦理问题,10 位感到不确定,10 位没有意识到这些问题。数据隐私、版权、有害输出、版权问题和同意等问题尤为突出。这些问题在研究设计、执行、分析和撰写阶段都很常见。

当大规模语言模型被整合到与用户直接交互的系统和工具中时,研究对象接触有害输出结果的伦理问题也日益受到关注。大规模语言模型的输出结果可能会通过社会偏见和刻板印象造成不成比例的伤害,尤其是对那些不被认为重要的群体。

此外,大规模语言模型还可能带来新的风险,强化对残疾人的偏见。大规模语言模型生成的信息看似权威,实则捏造,会影响研究的可信度。特别是,识别大规模语言模型生成的虚假引文和不一致的文章参考文献对研究人员来说是一个巨大的挑战。

在研究设计和评估阶段从大规模语言模型中继承的偏见也是一个问题。研究人员对大规模语言模型产生同质内容和概括不同观点的倾向表示担忧。这种 "扁平化人类多样性和细微差别 "的趋势强调了在研究中捕捉生活经验复杂性的重要性。

研究人员对输入到大规模语言模型中的数据如何使用以及隐私如何受到侵犯也非常关注。尤其令人担忧的是大规模语言模型如何处理语音转录和导航数据等敏感信息。这些数据泄露给外界甚至可能导致人身伤害。研究人员还非常关注与 LLM 提供商共享数据所带来的个人数据泄露风险,指出安全漏洞可能会导致个人数据意外泄露。

此外,知识完整性也是一个问题,因为大规模语言模型生成的文本和视觉效果的所有权并不明确。在共同生产过程中,很难区分哪些部分是研究人员的原创贡献,哪些部分是大规模语言模型的功劳。当大规模语言模型成为研究成果的一部分时,还有关于剽窃风险的争论。研究人员对大规模语言模型生成的内容的所有权提出了质疑,尤其是在论文的写作阶段,因此需要适当地注明出处。

此外,使用大规模语言模型的研究成果的可重复性尤其受到技术快速和不透明更新的影响。如果研究人员不知道他们使用的是哪个版本的 LLM,那么过去有效的方法在未来就可能无法很好地发挥作用。这可能会削弱研究成果的可靠性。

随着大规模语言模型使用范围的扩大,这些问题使得加强人机交互研究中的道德准则和提高透明度势在必行。

研究结果:解决人机交互研究人员对大规模语言建模的伦理问题

在此,我们调查了人机交互研究人员如何应对与使用大规模语言模型相关的伦理挑战。我们发现,研究人员会根据大规模语言模型的使用环境和研究领域来调整他们的伦理对策。

研究表明,许多人机交互研究人员都意识到潜在的伦理问题,但却发现很难具体确定或解决这些问题。例如,当一个研究领域被认为风险较低时,大规模语言建模的伦理挑战往往会被忽视,并被认为不那么紧迫。另一方面,高风险领域需要采取更加积极主动的伦理措施,但在实践中却很少采取此类措施。

受访的研究人员将具体情况和伦理考虑作为优先考虑的理由,并表示与使用大规模语言模型相关的一般伦理问题并不适用于他们自己的研究。这种被动处理问题的方法导致人们寻求解决问题的直接办法,但解决根本问题往往被搁置一旁。

此外,由于大多数人机交互研究都是在实验室环境中进行的,因此伦理问题的表现形式与日常问题不同,短期可用性测试不太可能面对大规模语言建模的有害输出。然而,在长期研究中可能会出现更严重的问题。

人机交互研究人员也将大规模语言模型视为常规工具。因此,许多参与者显然认为没有必要向研究参与者、伦理审查委员会(IRB)或更广泛的学术界正式报告他们使用大规模语言模型的情况。

这项调查显示了人机交互研究人员如何看待大规模语言建模的伦理问题。

总结:人机交互研究中大规模语言模型的整合与伦理问题

本文揭示了人机交互(HCI)研究人员如何使用大规模语言模型(LLM)以及他们面临的伦理问题。本文基于通过问卷调查和访谈收集的数据,探讨了研究人员如何将 LLMs 整合到他们的研究中,以及他们如何应对遇到的伦理问题。

研究表明,尽管人机交互研究人员在研究的各个阶段都使用了大规模语言模型,但他们在有效识别和解决伦理问题方面却举步维艰。在每个项目中明确识别和充分解决伦理问题被认为是一项挑战。

本文还提出了一种新的方法来制定伦理规范,以促进在人机交互研究中负责任地使用大规模语言模型。它鼓励研究人员与伦理审查委员会(IRB)合作,并与政策制定者和生成式人工智能公司合作制定指导方针。他们还指出,有必要重新评估知情同意程序,并提供技术援助以中断大规模语言模型的供应链。此外,还需要在人机交互领域提供更多的伦理教育机会,并改变学术激励机制,以关注伦理问题。

希望这些举措将有助于在未来营造一个更加合乎伦理的研究环境。