1 介绍

在本篇文章中,将介绍如何使用Transformer和LSTM模型进行时间序列预测。这两种模型分别擅长处理序列数据和捕捉时间序列中的长短期依赖关系。我们将结合这两种模型的优势,构建一个强大的预测模型。单输入单输出预测,适合风电预测,功率预测,负荷预测等等。

2 方法

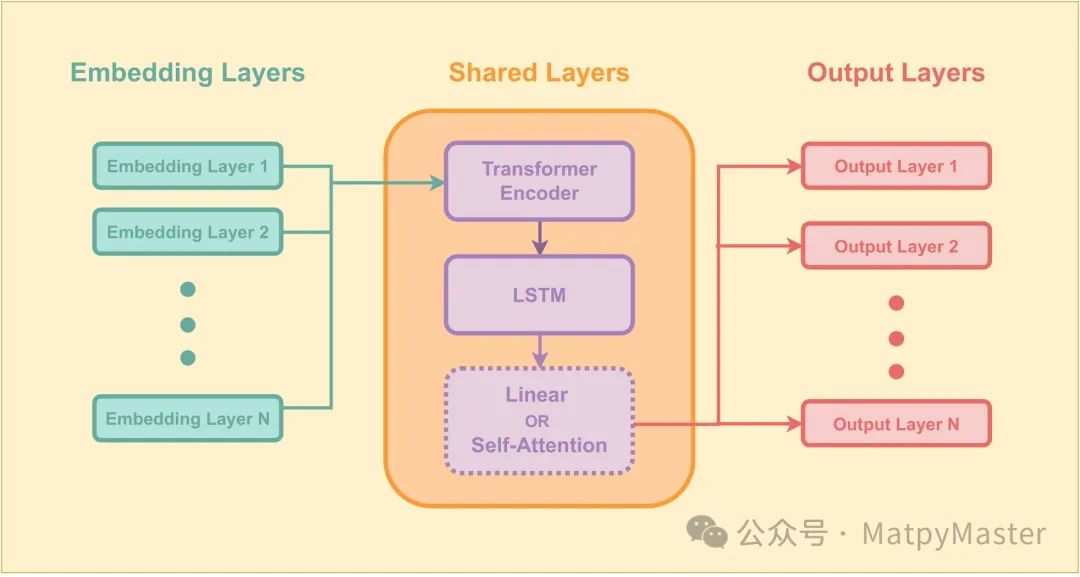

Transformer模型最初用于自然语言处理任务,但其强大的序列建模能力也适用于时间序列预测。在我们的模型中,我们使用了Transformer编码器来提取输入序列中的特征。Transformer的核心优势在于其自注意力机制,能够捕捉序列中不同位置之间的依赖关系。

由于Transformer本身不具备处理序列位置信息的能力,我们使用了位置编码来为每个输入数据点添加位置信息。这一过程涉及到对每个位置应用正弦和余弦函数,从而使模型能够区分序列中的不同位置。

长短期记忆(LSTM)网络是一种特殊类型的循环神经网络,能够有效地学习时间序列中的长期依赖关系。在我们的模型中,LSTM解码器负责根据Transformer编码器提取的特征进行预测。LSTM能够处理输入序列中的短期依赖,并通过注意力机制进一步增强对重要信息的关注。

3 结果

模型训练过程包括前向传播和反向传播。首先,输入序列通过Transformer编码器提取特征,然后传递给LSTM解码器进行预测。在训练过程中,我们使用均方误差(MSE)作为损失函数,以最小化预测值与真实值之间的差距。优化器用于更新模型参数,从而提高模型的预测性能。

python

def main():

# 数据集和数据加载器

dataset_train = StockDataset(file_path=args.data_path)

dataset_val = StockDataset(file_path=args.data_path, train_flag=False)

print('###1', len(dataset_train))

train_loader = DataLoader(dataset_train, batch_size=32, shuffle=True)

val_loader = DataLoader(dataset_val, batch_size=32, shuffle=False)

# 模型、优化器和损失函数

encoder = TransAm()

decoder = AttnDecoder(code_hidden_size=64, hidden_size=64, time_step=time_step)

encoder_optim = torch.optim.Adam(encoder.parameters(), lr=0.001)

decoder_optim = torch.optim.Adam(decoder.parameters(), lr=0.001)

# 初始化最佳验证损失为无穷大

best_val_loss = float('inf')

# 训练过程

total_epoch = 10

for epoch_idx in range(total_epoch):

train_loss = train_once(encoder, decoder, train_loader, encoder_optim, decoder_optim)

print("train, epoch:{:5d}, loss:{}".format(epoch_idx, train_loss))

# 评估过程

eval_loss, accuracy = eval_once(encoder, decoder, val_loader)

print("eval, epoch:{:5d}, loss:{}".format(epoch_idx, eval_loss))

# 如果当前验证损失小于最佳验证损失,则保存模型权重

if eval_loss < best_val_loss:

best_val_loss = eval_loss

# 保存模型

torch.save({

'encoder_state_dict': encoder.state_dict(),

'decoder_state_dict': decoder.state_dict(),

'encoder_optim_state_dict': encoder_optim.state_dict(),

'decoder_optim_state_dict': decoder_optim.state_dict(),

'epoch': epoch_idx,

'val_loss': eval_loss

}, 'best_model.pt')

print("Saved best model at epoch {:5d}".format(epoch_idx))

# 加载最佳模型权重

checkpoint = torch.load('best_model.pt')

encoder.load_state_dict(checkpoint['encoder_state_dict'])

decoder.load_state_dict(checkpoint['decoder_state_dict'])

encoder_optim.load_state_dict(checkpoint['encoder_optim_state_dict'])

decoder_optim.load_state_dict(checkpoint['decoder_optim_state_dict'])

# 进行最终评估或预测

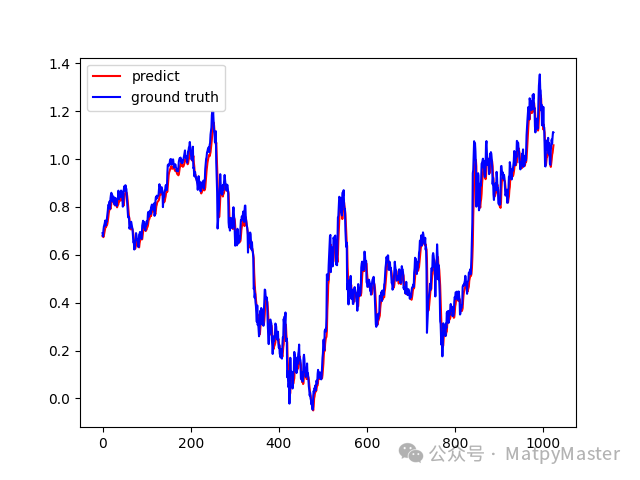

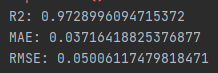

eval_plot(encoder, decoder, val_loader)在模型训练完成后,我们使用验证集对模型进行评估。评估指标包括R²评分、均方误差(MSE)和均绝对误差(MAE)。此外,我们还绘制了预测结果与真实值的对比图,以直观展示模型的预测性能。

代码下载链接: LSTM-Transformer时间序列预测(单输入单预测)------基于Pytorch框架 (qq.com)

最后:

小编会不定期发布相关设计内容包括但不限于如下内容:信号处理、通信仿真、算法设计、matlab appdesigner,gui设计、simulink仿真......希望能帮到你!