本文较长,建议点赞收藏,以免遗失。更多AI大模型应用开发学习视频及资料,尽在聚客AI学院

一、技术架构核心

1. Cherry Studio客户端

国产化AI桌面客户端,提供以下核心能力:

- 多模型调度:支持OpenAI/Gemini/Anthropic等云服务、网页端AI(Claude/Perplexity)、本地私有模型(Ollama/LM Studio)

- 文件交互中枢:通过MCP协议实现安全文件操作

- 隐私保护机制:所有数据存储在本地,支持完全离线运行

2. Filesystem MCP Server

开源文件系统操作服务端(Node.js实现),关键特性:

json

// 功能接口示例

{

"read_file": "读取UTF-8文件",

"write_file": "创建/覆盖文件(高危操作)",

"search_files": "全局模式匹配搜索",

"edit_file": "选择性内容编辑(高级)"

}

二、关键实施步骤

1. 环境部署方案对比

| 方案 | 隔离性 | 部署复杂度 | 适用场景 |

|---|---|---|---|

| Docker容器 | ★★★★★ | 中等 | 生产环境 |

| NPX直连 | ★★☆☆☆ | 简单 | 开发测试 |

Docker推荐命令:

bash

docker build -t mcp/filesystem -f src/filesystem/Dockerfile .

docker run -it --rm \

--mount type=bind,src=/Users/your_path,dst=/projects \

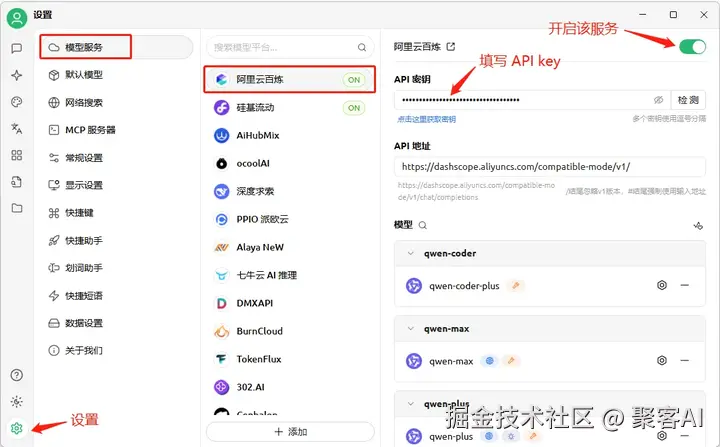

mcp/filesystem /projects2. Cherry Studio配置要点 在模型服务设置中选择供应商并启用MCP:

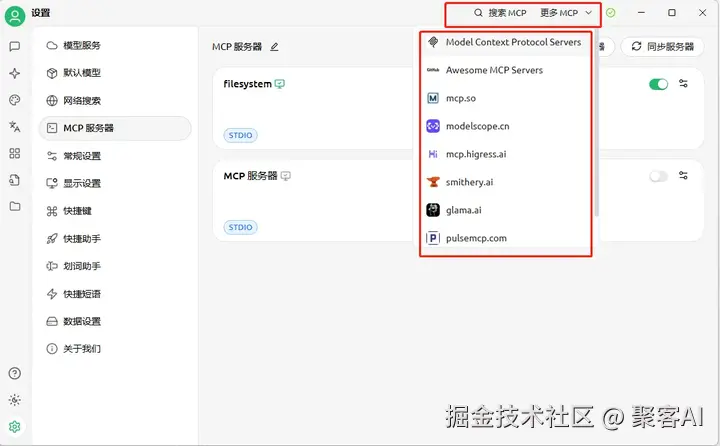

3. MCP服务端安全配置 通过JSON绑定授权目录(注意Windows路径转义):

perl

{

"mcpServers": {

"filesystem": {

"command": "npx",

"args": [

"-y",

"@modelcontextprotocol/server-filesystem",

"C:\Users\yuan_\Desktop",

"C:\Users\yuan_\Downloads"

]

}

}

}

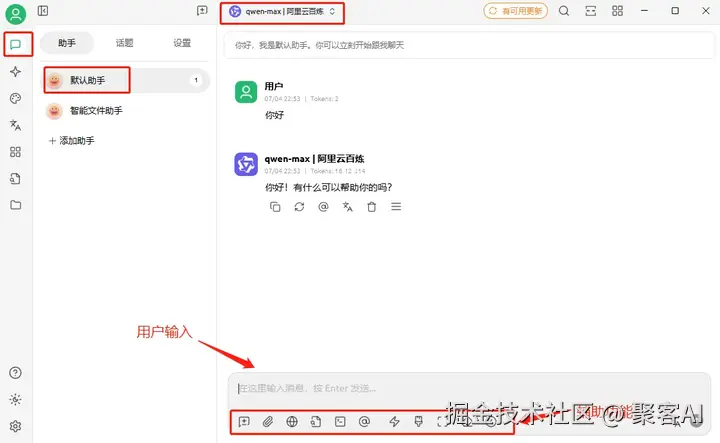

三、智能助手开发实战

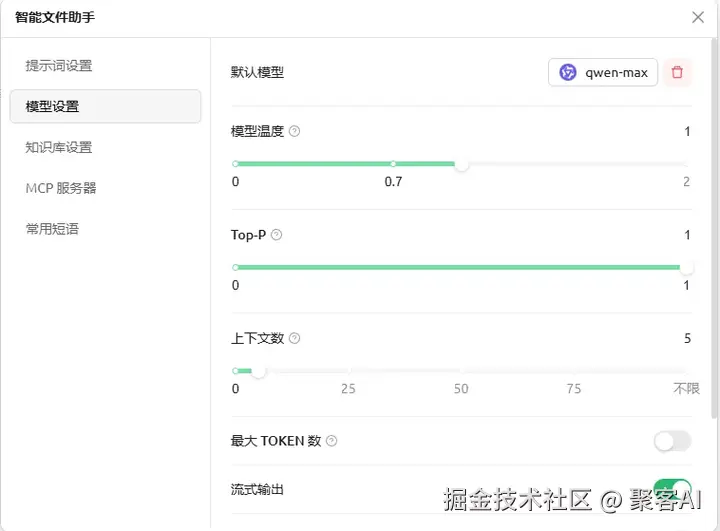

1. 助手创建流程

- 使用预设助手模板创建新助手

- 重命名为"智能文件助手"

- 设置系统提示词明确路径规范: "用户桌面路径:C:\Users\yuan_\Desktop,下载目录:C:\Users\yuan_\Downloads"

2. 核心功能启用 在助手配置中启用:

- 阿里云百炼qwen-max作为推理引擎

- Filesystem MCP服务端连接

四、典型应用场景测试

1. 文件系统操作

rust

用户指令: "桌面创建report.txt文件"

-> 调用write_file工具创建文件

-> 返回绝对路径确认

2. 智能内容编辑

rust

用户指令: "将天空为什么是蓝色的科学解释保存到report.txt"

-> 模型生成科普内容

-> 通过edit_file工具写入

3. 目录检索

rust

用户指令: "列出下载目录所有PDF文件"

-> 触发search_files工具

-> 使用模式匹配:*.pdf五、安全防护机制

- 沙箱隔离:Docker容器限制文件访问范围

- 权限控制:通过bind mount的ro参数实现只读保护

- 操作审计:所有文件变更记录在MCP日志中

- 高危操作警示:write_file需双重确认

⚠️ 关键提醒:避免直接绑定根目录,生产环境务必启用Docker的只读挂载(ro参数)

六、扩展应用场景

- 自动化文档管理:合同扫描件分类归档

- 代码助手:直接编辑项目文件

- 研究资料库:跨文档信息检索

- 本地知识库:与Cherry知识管理模块联动

技术演进方向:

- MCP生态市场:扩展数据库/API连接器

- 智能内容选择:精准定位编辑位置

- 操作回滚机制:文件版本快照管理

- 多助手协作:专用写作助手+文件助手联动

此方案成功解决了Claude Desktop的国内访问限制问题,同时通过模块化设计实现了企业级文件操作安全管控。更多AI大模型应用开发学习视频内容和资料,尽在聚客AI学院。