地址:Do As I Can, Not As I Say: Grounding Language in Robotic Affordances

摘要

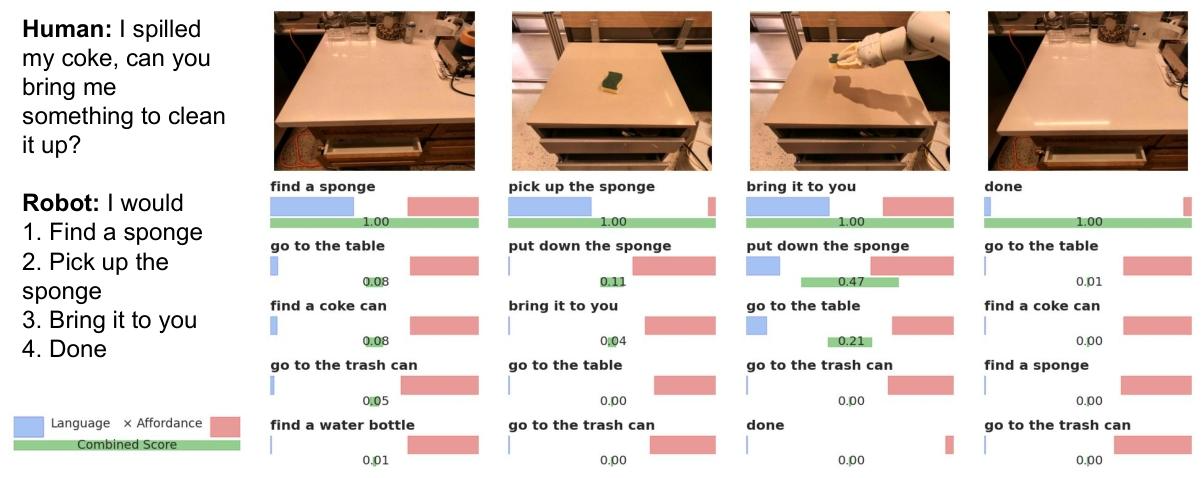

大型语言模型(LLM)能够编码丰富的世界语义知识,这类知识对于机器人执行自然语言表达的高层级、时间扩展指令具有重要价值。然而,语言模型的一大显著缺陷是缺乏现实世界经验,这使其难以在特定实体(如机器人)中用于决策。例如,让语言模型描述如何清理洒出的液体,可能会得到合理的叙述,但该叙述未必适用于特定智能体(如机器人)在特定环境中执行此任务的场景。本文提出通过预训练技能 实现现实世界接地:利用预训练技能约束模型,使其提出既可行又符合上下文的自然语言动作。其中,机器人可作为语言模型的 "手和眼",而语言模型则为任务提供高层级语义知识。我们展示了如何将低层级技能与大型语言模型结合:语言模型提供执行复杂、时间扩展指令的高层级流程知识,而与这些技能相关的价值函数则提供必要的接地能力,将该知识与特定物理环境关联。我们在多个现实世界机器人任务上评估了该方法,结果表明现实世界接地的必要性,且该方法能够让移动操作机器人完成长时程、抽象的自然语言指令。项目网站、演示视频及桌面领域的开源代码可在this https URL获取。

概述

1. 研究背景与问题

- LLM 的优势与局限:LLM 从海量文本中学习到丰富的语义知识,能理解高层级任务指令,但无物理世界交互经验,输出可能 "不落地"(如建议机器人用 "吸尘器清理洒出的饮料",但场景中无吸尘器或机器人无法操作)。

- 核心挑战:如何让具身智能体(如机器人)提取并利用 LLM 的知识,将抽象语言指令转化为符合自身能力和当前环境的可执行动作序列。

2. 解决方案:SayCan 方法

SayCan 的核心是 "Say(说) " 与 "Can(做)" 的协同:

- Say(LLM 的角色) :提供 "任务接地",通过语义知识判断低层级技能对高层级任务的相关性(即 "该技能是否有助于完成任务"),量化为概率

(

为技能的语言描述,

i为用户指令)。 - Can(价值函数的角色) :提供 "世界接地",通过预训练的价值函数判断技能在当前环境状态下的可行性(即 "机器人能否成功执行该技能"),量化为概率

(

s为当前状态,为技能成功执行的伯努利变量)。

- 协同逻辑 :技能的综合优先级由两者乘积决定

,迭代选择最优技能执行,直至输出 "done" 终止。

3. 实验验证与关键结果

-

实验设置:

- 环境:模拟厨房(技能训练环境)和真实办公厨房(泛化测试环境);

- 机器人:Everyday Robots 的移动操作机器人(7 自由度机械臂 + 两指夹爪);

- 任务:7 类共 101 个指令(单原语、抽象名词 / 动词、结构化语言、具身状态、众包指令、长时程任务);

- 评估指标:计划成功率(技能序列是否符合任务目标)、执行成功率(机器人是否实际完成任务,均由 3 名人类标注者多数投票判定)。

-

核心结果:

- 接地有效性:在模拟厨房中,SayCan(基于 PaLM-540B)实现 84% 计划成功率和 74% 执行成功率;真实厨房中为 81% 计划成功率和 60% 执行成功率,接地机制使性能较无接地基线接近翻倍。

- LLM 规模影响:LLM 参数越大,机器人性能越好 ------PaLM-540B(84% 计划成功率)优于 PaLM-62B(72%)和 PaLM-8B(38%),且 PaLM 系列优于同等规模的 FLAN(70% 计划成功率)。

- 扩展能力:支持添加新技能(如抽屉操作,计划成功率 100%)、链式思维处理否定指令(如 "带无咖啡因的果味饮料")、多语言指令(中 / 法 / 西语计划成功率接近 100%)。

4. 局限性与未来方向

- 局限性:继承 LLM 的训练偏差;技能范围和鲁棒性是系统瓶颈;无法动态调整技能失败后的策略。

- 未来方向:利用机器人现实经验反哺 LLM(提升事实性与物理常识);扩展接地来源(非机器人场景);探索自然语言作为机器人编程本体的合理性。

一、论文动机

1. LLM 缺乏 "世界接地":输出技能无法执行

LLM 仅通过文本学习语义知识,无物理世界交互经验,导致其生成的技能序列可能与机器人能力或当前环境冲突,无法实际执行。例如,用户要求 "清理洒出的饮料" 时,LLM 可能建议 "用吸尘器",但场景中无吸尘器或机器人无法操作吸尘器(1-4、1-13);或生成 "去商店买苹果" 这类脱离机器人能力范围的抽象步骤,无法转化为具体动作(1-26)。

2. 传统策略缺乏 "任务接地":无法理解高层级指令

单纯的行为克隆(BC)或强化学习(RL)策略仅能执行低层级、固定的技能(如 "拾取苹果"),无法解析高层级、抽象的自然语言指令(如 "拿一个健康的零食")。例如,BC 策略直接输入 "补充米饼" 这类抽象指令时,无法拆解为 "找米饼→拾取→放置到操作台" 的序列,执行成功率为 0%(1-69、1-73);且无法动态调整策略以适应长时程任务(如 "扔可乐 + 拿清洁用品")(1-67)。

3. 技能选择无动态可行性判断:难以应对环境变化

传统 LLM 生成模式(如直接输出动作文本)仅考虑 "任务相关性",忽略 "环境可行性",导致技能选择僵化。例如,机器人已持有苹果时,LLM 仍可能因 "拿苹果" 的任务相关性高而选择该技能,造成冗余或失败;或在无目标物体的场景中,仍输出 "拾取" 技能(1-30、1-70)。

4. 系统扩展性差:新技能、多语言等需求适配成本高

传统机器人系统添加新技能(如抽屉操作)需重构策略网络,处理多语言指令需额外训练多语言模型,无法利用 LLM 的现有能力快速适配。例如,新增 "打开抽屉" 技能时,传统方法需重新采集数据、训练独立模型,而无法通过简单扩展技能描述实现(1-80、1-99);且对否定指令(如 "不要苹果")、模糊指代(如 "拿那个红色的")处理能力不足(1-67、1-96)。

二、设计架构

SayCan 的核心原理是通过 "双接地机制 " 将 LLM 的抽象语义知识与机器人的物理执行能力绑定,解决 "语言不落地" 问题,具体逻辑如下:

1. 核心概念定义

- 技能(Skill, π) :机器人的低层级原子行为(如 "找海绵""拿起海绵"),每个技能包含:

- 语言描述

(自然语言标签,用于与 LLM 交互);

- 执行策略(控制机器人完成动作的算法,由行为克隆 BC 或强化学习 RL 训练);

- 可供性函数

(即价值函数,量化当前状态

s下技能成功执行的概率)。

- 语言描述

- 任务接地(Task Grounding) :由 LLM 计算

,即 "技能

ℓ_π是完成指令i的有效步骤的概率",本质是利用 LLM 的语义知识关联 "任务目标" 与 "技能用途"。 - 世界接地(World Grounding) :由价值函数计算

,即 "在当前环境状态

s下,机器人成功执行技能ℓ_π的概率",本质是将技能与物理环境的可行性绑定。

2. 概率协同逻辑

SayCan 的技能选择基于 "综合概率最大化",公式推导如下:

- 目标:选择 "既能推进任务,又能成功执行" 的技能,即最大化 "技能成功执行且推进任务" 的概率

。

- 分解假设:若技能成功(

),则推进任务的概率为

;若技能失败(

),则推进任务概率为 0。

- 最终公式:

(比例关系源于忽略全局归一化常数)。

3. 迭代执行流程

- 输入用户指令

i和当前环境状态s; - LLM 对所有预训练技能的

评分,得到

;

- 价值函数模块对所有技能评分,得到

;

- 计算每个技能的综合概率,选择概率最大的技能执行;

- 将已执行的

追加到 LLM 的查询上下文,更新环境状态

s; - 重复步骤 2-5,直至 LLM 输出 "done"(终止令牌)。

三、训练方法

SayCan 的实现需分三部分:预训练技能与价值函数、LLM 适配、技能选择与执行,具体方法如下:

1. 预训练技能与价值函数

(1)技能策略训练

- 训练方法 :结合行为克隆(BC)和强化学习(RL),按需选择:

- BC 策略 :基于 BC-Z 方法,用 10 台机器人 11 个月收集的 6.8 万条远程操作演示数据,辅以 12 万条成功的自主执行数据训练;采用 ResNet-18 架构,以 "通用句子编码器(USE)" 生成的

ℓ_π嵌入作为 FiLM 条件,输出机械臂位姿、夹爪状态和终止动作。 - RL 策略 :基于 MT-Opt 方法,在仿真环境中训练(用 RetinaGAN 减少 sim-to-real 差距),通过 "仿真演示初始化 + 在线数据迭代优化" 提升性能;架构类似 MT-Opt,输入图像、

ℓ_π嵌入、机器人状态(如夹爪高度),输出 Q 值。

- BC 策略 :基于 BC-Z 方法,用 10 台机器人 11 个月收集的 6.8 万条远程操作演示数据,辅以 12 万条成功的自主执行数据训练;采用 ResNet-18 架构,以 "通用句子编码器(USE)" 生成的

- 多任务优化:不单独为每个技能训练策略,而是训练 "语言条件的多任务模型",降低训练成本(支持 551 个技能,涵盖拾取、放置、导航等 7 类)。

(2)价值函数训练

-

本质定义 :稀疏奖励下的 "技能成功概率"------ 任务完成时奖励为 1,否则为 0,价值函数

Q^π(s,a)即 "从状态s执行动作a后,遵循策略π的折扣奖励和",对应技能成功概率。 -

训练方法 :基于时序差分(TD)的 RL 方法,最小化以下 TD 损失:

L_TD(θ) = E_{(s,a,s')~D} [ R(s,a) + γ·E_{a*~π} Q_θ^π(s',a*) - Q_θ^π(s,a) ]其中

D为状态 - 动作数据集,θ为 Q 函数参数,γ为折扣因子,R(s,a)为稀疏奖励(0 或 1)。 -

可行性校准 :对不同技能的价值函数结果进行归一化(如拾取技能

),确保输出为 0-1 的概率值。

2. LLM 适配:从 "生成" 到 "评分"

LLM 默认生成自由文本,需通过以下方法约束其输出为 "机器人可执行的技能序列":

- 提示工程(Prompt Engineering):在 LLM 输入中加入示例(如 "人类:帮我拿苹果?机器人:1. 找苹果,2. 拿苹果,3. 递给你,4.done"),定义 "人类指令 - 机器人技能序列" 的对话格式,约束输出结构(附录 D.3 提供 17 个示例的完整 Prompt)。

- 评分模式(Scoring Mode) :不使用 LLM 的 "生成模式"(避免输出无效动作),而是用 "评分模式" 计算每个预定义

的概率

------ 即查询 LLM 对 "将

作为指令

i的下一步" 的置信度。 - 迭代上下文更新:每次选择技能后,将其追加到 LLM 的对话历史(如 "机器人:1. 找海绵,2.XXX"),确保 LLM 理解任务进度,避免重复或无关技能。

3. 系统集成与执行

- 语言条件输入 :技能的策略和价值函数均以 "USE 嵌入的

" 为输入,实现 "语言 - 动作" 的绑定;LLM 与技能的语言模型可独立(如 LLM 用 PaLM,技能嵌入用 USE),适配不同抽象层级需求。

- 环境反馈机制 :通过价值函数实时获取环境状态

s(如物体位置、机器人位姿),确保技能可行性判断的时效性;若技能执行失败(如未拿起物体),价值函数会降低该技能的后续评分。 - 终止判断 :为 "done" 技能设置固定低可行性(

p_{terminate}^{affordance}=0.1),仅当所有有效技能的综合概率均低于 "done" 时,系统终止任务。

四、数据集

论文中数据集主要服务于低层级技能的策略训练(行为克隆 BC、强化学习 RL) 和系统性能评估,具体来源可分为三类:训练数据集(BC/RL 策略)、评估数据集(101 个指令),两类数据集的采集场景、方式和规模均有明确界定。

1. 训练数据集:技能策略与价值函数训练

训练数据集用于学习机器人的低层级技能(如拾取、放置、导航)及其对应的价值函数,分为行为克隆(BC)策略训练数据 和强化学习(RL)策略训练数据两类,均围绕 "厨房场景中的机器人操作" 展开。

(1)行为克隆(BC)策略训练数据

BC 策略的数据以 "真实机器人远程操作演示" 为核心,辅以 "自主执行数据" 扩充规模,具体来源如下:

- 核心演示数据 :通过 10 台机器人组成的机器人 fleet,在 11 个月内持续采集的68000 条远程操作演示数据。采集时,操作员使用 VR 头显控制器追踪手部动作,动作被映射为机器人末端执行器的位姿;同时可通过操纵杆控制机器人底座移动,确保演示覆盖 "拾取 - 放置 - 导航" 等核心技能场景(如厨房中的物体搬运、位置移动)。

- 自主执行扩充数据 :为提升数据规模和多样性,补充了276000 条机器人自主执行的技能 episode (即机器人按已学策略执行技能的过程记录)。对这些自主数据进行 "成功筛选"------ 仅保留人类标注为 "成功完成技能" 的 episode,最终得到12000 条有效自主数据,与核心演示数据合并用于 BC 训练。

(2)强化学习(RL)策略训练数据

RL 策略的数据以 "仿真环境数据" 为主,通过 "仿真 - 真实迁移" 技术减少环境差异,具体来源如下:

- 仿真演示初始化数据 :在 Everyday Robots 模拟器中,生成技能演示数据(如 "打开抽屉""拾取可乐罐" 的标准动作序列),用于初始化 RL 策略的基础性能,避免策略从 "零经验" 开始学习导致的收敛缓慢。

- 在线仿真迭代数据 :初始化后,通过 3000 个 CPU worker 持续在仿真环境中采集在线 episode 数据 (机器人执行技能的实时过程记录),并基于这些数据迭代优化 RL 策略。同时,为缩小 "仿真 - 真实" 环境差距,使用RetinaGAN技术对仿真环境的图像进行处理 ------ 让仿真图像更接近真实场景,同时保留物体结构特征,确保 RL 策略迁移到真实机器人时性能稳定。

(3)价值函数训练数据

价值函数(用于判断技能可行性)的数据与策略训练数据共享:BC 策略的价值函数基于 BC 训练数据的 "成功 / 失败标签" 学习,RL 策略的价值函数则直接使用 RL 训练数据中的稀疏奖励(任务成功为 1,失败为 0)进行时序差分(TD)学习,无需额外采集独立数据、、。

2. 评估数据集:101 个机器人任务指令

评估数据集用于验证 SayCan 系统在真实场景中的性能,包含7 类共 101 个自然语言指令,来源兼顾 "标准化" 和 "自然性",具体如下:

- 众包指令:通过 Amazon Mechanical Turk(MTurk)平台向人类用户征集 ------ 向用户描述 "厨房场景事件"(如 "苹果被移到你面前"),让用户以自然语言向机器人下达任务;同时在真实办公厨房中,让工作人员基于机器人能力下达指令,最终得到 15 条非结构化众包指令、。

- 基准参考指令:参考现有机器人语言指令基准(如 ALFRED、BEHAVIOR),设计结构化、可对比的指令(如 "把米饼移到远操作台"),确保评估结果可与现有方法对标。

- 自定义测试指令 :为覆盖特定能力测试目标(如 "具身状态理解""长时程推理"),人工设计 56 条指令,包括:

- 单原语指令(如 "放开可乐罐",15 条);

- 抽象名词 / 动词指令(如 "给我拿一个水果""补充米饼",各 15 条);

- 具身状态指令(如 "把可乐放操作台上",初始状态不同,11 条);

- 长时程指令(如 "可乐洒了,扔掉并拿清洁用品",15 条)、至。

五、实验设计

1. 系统模块组成

| 模块名称 | 功能描述 | 关键技术 / 工具 |

|---|---|---|

| LLM 模块(Say) | 计算技能与任务的相关性 |

PaLM-540B/62B/8B、FLAN,提示工程 |

| 价值函数模块(Can) | 计算技能在当前状态的可行性,提供世界接地 |

| 技能库 | 存储机器人的低层级原子技能,包含 |

BC-Z(策略)、MT-Opt(策略) |

| 执行控制模块 | 解析最优技能,控制机器人执行动作,更新环境状态和 LLM 上下文 | 移动操作机器人控制栈 |

2. 实验细节与关键对比

(1)实验环境与任务

-

环境 :

- 模拟厨房:与技能训练环境一致,包含 5 个语义位置(2 个操作台、桌子、垃圾桶、用户位置)和 15 类厨房物体;

- 真实厨房:办公场景真实厨房,环境更复杂(物体位置不固定、干扰物更多)。

-

任务分类 (7 类共 101 个,示例见表 1):

任务类别 数量 核心测试目标 示例指令 NL Single Primitive 15 单技能指令的识别与终止 "放开可乐罐" NL Nouns 15 抽象名词(如 "水果")的理解 "给我拿一个水果" NL Verbs 15 抽象动词(如 "补充")的理解 "把米饼补充到远操作台" Structured Language 15 结构化指令与自然语言的对比 "把米饼移到远操作台" Embodiment 11 环境 / 机器人状态的理解(如手中是否有物体) "把可乐放在操作台上"(初始状态不同) Crowd-Sourced 15 非结构化自然指令的适配 "我最喜欢红牛,帮我拿一罐" Long-Horizon 15 长时程多步骤推理 "可乐洒在桌子上,扔掉它并拿清洁用品"

(2)关键对比实验(Ablation Study)

通过对比不同方案,验证接地机制和 LLM 的必要性:

| 方案 | 核心逻辑 | 总计划成功率 | 总执行成功率 | 结论 |

|---|---|---|---|---|

| PaLM-SayCan(本文) | 结合 LLM 的 和价值函数的 | 84% | 74% |

| No VF(无价值函数) | 仅用 LLM 选择 |

67% | - | 世界接地不可或缺,否则技能可能无法执行 |

| Generative(生成模式) | LLM 生成自由文本,再通过 USE 嵌入匹配到最近技能 | 74% | - | 评分模式优于生成模式,生成模式丢失概率信息,可解释性差 |

| BC NL(无 LLM) | 直接将指令i输入 BC 策略,无技能序列规划 |

0% | 0% | LLM 的任务接地是必要的,单纯行为克隆无法理解高层级指令 |

| BC USE(无 LLM) | 将指令i通过 USE 嵌入匹配到最近技能序列,无动态规划 |

9% | 9% | 仅单技能任务有效(60%),无法处理长时程或抽象任务 |

3. 扩展能力验证

- 添加新技能 :以 "抽屉操作" 为例,仅需添加 "打开抽屉""关闭抽屉" 等

、对应的 BC 策略和价值函数(基于距离的启发式),并补充 2 个 Prompt 示例,即可实现 100% 计划成功率(执行成功率 33%,失败源于机械臂操作精度)。

- 链式思维(Chain of Thought):通过 Prompt 添加 "Explanation" 环节(如 "用户要无咖啡因的果味饮料,我选青柠苏打"),让 LLM 先推理再输出技能,解决否定指令(如 "不要苹果")和复杂推理问题,示例见表 4。

- 多语言支持:利用 LLM 的多语言训练数据,无需额外适配即可处理中、法、西语指令,计划成功率接近 100%(仅 1 条法语指令失败,源于语法复杂度)。

4. 局限性与未来方向

(1)当前局限性

- LLM 继承问题:继承 LLM 的训练偏差(如对特定物体的偏好)和常识错误(如物理规律误解);

- 技能瓶颈:系统性能受限于技能库的范围和鲁棒性(如抽屉操作执行成功率低,无 "擦拭" 技能);

- 闭环能力弱:无法动态应对技能失败(如未拿起物体时,不会调整策略重新尝试);

- 否定与歧义处理不足:虽可通过链式思维改善,但对复杂否定(如 "不要甜的且无咖啡因的饮料")和模糊指代(如 "拿那个红色的")仍存在困难。

(2)未来研究方向

- 双向反馈:利用机器人的现实执行经验微调 LLM,提升 LLM 的物理常识和事实性;

- 技能扩展:开发更鲁棒的多模态技能(如基于视觉的动态物体抓取),降低技能库的局限性;

- 闭环规划:结合环境反馈(如物体检测、人类纠正)实现动态策略调整,参考 "Inner Monologue" 方法;

- 本体探索:验证自然语言作为机器人编程本体的合理性,对比 "图像目标" 等其他本体的效率。

六、评价指标

论文采用2 个核心指标量化系统性能,覆盖 "计划合理性" 与 "执行有效性",均通过 "人类标注" 确保客观,具体定义与计算方式如下:

1. 核心指标 1:计划成功率(Plan Success Rate)

- 定义:衡量 "SayCan 输出的技能序列是否能完成用户指令目标",不考虑机器人实际执行结果(仅评估 "计划逻辑")。

- 评估方式 :

- 向 3 名标注者提供 "用户指令 + 技能序列"(如 "拿清洁用品"+"1. 找海绵→2. 拿海绵→3. 递给你");

- 标注者判断 "该序列是否能达成指令目标",允许 "多解"(如先扔可乐再拿海绵也视为有效);

- 统计 "2/3 标注者同意成功" 的任务占比,即为计划成功率。

- 核心结果:PaLM-SayCan 在模拟厨房中达 84%,真实厨房中 81%,无接地对照组(No VF)仅 67%。

2. 核心指标 2:执行成功率(Execution Success Rate)

- 定义:衡量 "SayCan 系统(含机器人执行)是否实际完成用户指令",需结合 "计划合理性" 与 "机器人操作精度"。

- 评估方式 :

- 向 3 名标注者提供 "用户指令 + 机器人执行完整视频";

- 标注者回答 "机器人是否达成指令描述的任务",忽略 "微小操作误差"(如物体放置偏移但未影响目标);

- 统计 "2/3 标注者同意成功" 的任务占比,即为执行成功率。

- 核心结果:PaLM-SayCan 在模拟厨房中达 74%,真实厨房中 60%,无 LLM 对照组(BC NL)为 0%。

3. 辅助分析指标

- 误差来源:65% 的失败源于 LLM(如早期终止、否定指令处理错误),35% 源于价值函数(如误判技能可行性);

- LLM 规模关联:PaLM-540B(74% 执行成功率)> PaLM-62B(72%)> PaLM-8B(38%),证明 LLM 规模与机器人性能正相关。

七、创新点分析

1. 创新 1:双接地机制(Task Grounding + World Grounding),解决 LLM 与机器人的接地断层

这是论文最核心的创新,通过 "LLM 的任务接地" 与 "价值函数的世界接地" 协同,让技能同时满足 "任务相关性" 与 "环境可行性":

- 任务接地(Say) :利用 LLM 的语义知识,计算技能描述(

ℓ_π)与用户指令(i)的相关性概率p(ℓ_π | i),回答 "该技能是否有助于完成任务"。例如,指令 "清理洒出饮料" 时,LLM 会优先选择 "找海绵"(p高)而非 "拿可乐"(p低),实现任务层面的接地(1-14、1-25)。 - 世界接地(Can) :利用强化学习训练的价值函数,计算技能在当前环境状态(

s)下的可行性概率p(c_π | s, ℓ_π),回答 "该技能能否成功执行"。例如,场景中无吸尘器时,"用吸尘器" 的p为 0,避免选择无效技能;基于距离的导航价值函数(如 "去桌子" 的概率随距离减小而升高)确保技能可行(1-14、1-22、1-32)。 - 协同逻辑 :通过概率乘积(

p(c_i | i,s,ℓ_π) ∝ p(c_π | s,ℓ_π) × p(ℓ_π | i))选择最优技能,既保证技能符合任务目标,又确保可执行,解决了 "LLM 输出不可行" 和 "策略无任务理解" 的双重问题(1-25、1-33)。实验验证,该机制使性能较无接地基线(如 No VF、Generative)接近翻倍(1-73)。

2. 创新 2:基于 "评分模式" 的 LLM 适配,提升技能选择的可解释性与准确性

摒弃 LLM 的 "自由生成模式",采用 "评分模式" 计算技能概率,解决生成模式 "丢失概率信息、可解释性差" 的问题:

- 评分模式设计 :让 LLM 对预定义的技能描述(

ℓ_π)逐一评分,输出p(ℓ_π | i),而非生成自由文本。例如,指令 "拿清洁用品" 时,LLM 直接计算 "找海绵""找抹布" 等技能的概率,而非生成 "去厨房拿清洁工具" 这类模糊表述(1-27、1-30)。 - Prompt 工程约束:通过添加 "人类 - 机器人对话示例"(如 "人类:拿苹果→机器人:1. 找苹果,2. 拿苹果,3. 递给你"),让 LLM 输出结构化技能序列,确保可解析性。例如,17 个示例的 Prompt 使计划成功率从无示例的 10% 提升至 88%(1-323、1-324)。

- 迭代规划:每次选择技能后,将其追加到 LLM 上下文,动态调整后续技能选择(如 "拿海绵" 后,LLM 不再重复选择该技能),适配长时程任务的步骤依赖(如 "扔可乐→拿海绵" 的顺序规划)(1-33、1-60)。

3. 创新 3:多任务与扩展能力优化,降低系统适配成本

无需重构核心模块,即可支持新技能、多语言、复杂推理,解决传统系统扩展性差的问题:

新技能快速集成 :仅需添加新技能的ℓ_π、对应的 BC/RL 策略及 2-3 个 Prompt 示例,即可融入现有系统。例如,添加 "抽屉操作" 技能时,仅补充 "打开抽屉""关闭抽屉" 的ℓ_π和价值函数(基于距离的启发式),计划成功率达 100%,且不影响原有技能性能(1-80、1-82)。

- 链式思维(Chain of Thought)处理复杂推理:通过 Prompt 添加 "Explanation" 环节(如 "用户要无咖啡因的果味饮料→选青柠苏打"),让 LLM 先推理再输出技能,解决否定指令(如 "不要苹果")和模糊需求(如 "拿健康的零食")问题,示例任务成功率提升至 80% 以上(1-96、1-98)。

- 多语言零适配支持:利用 LLM 的多语言训练数据,无需额外适配即可处理中、法、西语指令。实验显示,非英语指令计划成功率接近 100%(仅 1 条法语指令因语法复杂度失败),利用 LLM 的多语言能力降低适配成本(1-99、1-506)。

4. 创新 4:LLM 规模与机器人性能的正向关联验证,为跨领域协同提供依据

首次系统性验证 "LLM 语义能力提升可直接带动机器人性能提升",为后续 "语言 - 机器人" 跨领域研究提供方向:

- LLM 参数规模影响:实验表明,PaLM-540B(84% 计划成功率、74% 执行成功率)显著优于 PaLM-62B(72% 计划成功率)和 PaLM-8B(38% 计划成功率),证明 LLM 的语义知识储备(如抽象指令理解、长时程规划)直接决定机器人任务规划能力(1-74、1-77)。

- 模型类型对比:通用 LLM(PaLM)优于指令微调 LLM(FLAN),PaLM-SayCan 计划成功率 84% vs FLAN-SayCan 70%,说明 "通用语义知识" 比 "指令响应优化" 更适配机器人的物理任务规划(1-74、1-77)。

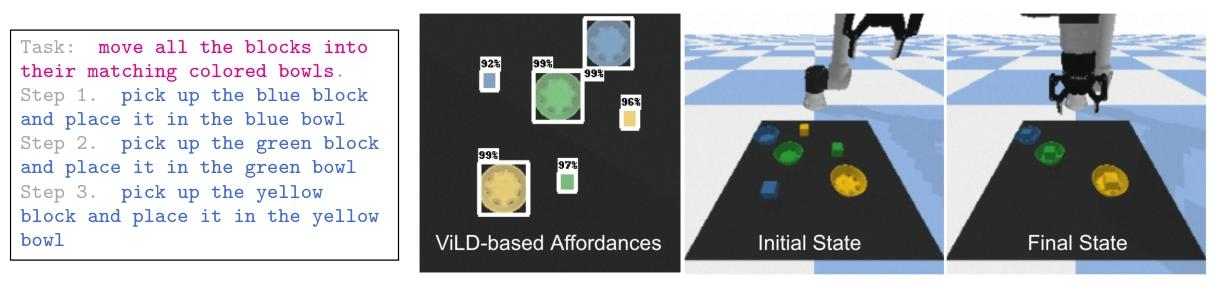

5. 创新 5:开源可复现的实验环境,降低研究门槛

提供基于 Google Colab 的开源桌面环境(含 UR5 机器人、CLIPort 策略、ViLD 物体检测器),支持 "移动色块到对应颜色碗中" 等任务,无需复杂机器人硬件即可复现 SayCan 核心逻辑。开源环境使用 GPT-3 作为 LLM,输出 "拾取 - 放置" 代码结构的技能序列,促进后续研究的扩展(1-102、1-103)。

八、本论文的相关工作

论文将相关工作分为语言模型接地 、语言条件行为学习 、任务与运动规划三类,每类均先总结现有研究的核心思路,再明确本文与现有工作的差异,核心逻辑是 "指出不足→凸显本文补充价值"。

1. 第一类:语言模型接地(Grounding Language Models)

(1)现有研究核心方向

现有工作聚焦 "如何让 LLM 关联物理世界或具体动作",主要分为三类方法(1-107):

- 环境输入增强:让 LLM 接受多模态输入(如图像、环境状态)以补充物理信息,例如 VideoBERT([152])、VisualBERT([153])、ViLBERT([154])等,通过融合视觉与语言特征提升接地能力;

- 动作输出直接映射:让 LLM 直接生成动作序列或控制指令,例如 Embodied BERT([157])、Episodic Transformer([159]),但这类方法多依赖仿真环境训练,缺乏真实物理交互验证;

- 提示工程(Prompt Engineering):通过设计示例让 LLM 生成符合任务需求的文本,例如 Huang 等人的 "LLM 作为零样本规划器"([23]),但该方法仅依赖文本生成,未结合环境可行性判断,属于 "无世界接地" 的生成模式。

(2)本文与现有研究的差异

现有方法的共性缺陷是 "缺乏真实物理交互反馈",导致 LLM 输出可能脱离机器人能力或环境约束(1-107);而本文的创新补充在于:

- 无需微调 LLM:通过 "预训练技能的价值函数" 为 LLM 提供世界接地,避免因环境数据微调 LLM 导致的泛化性损失;

- 零样本长时程任务:利用 LLM 的语义知识(任务接地)与价值函数的可行性判断(世界接地),实现真实机器人的零样本长时程任务规划,而现有方法多局限于单步骤或仿真任务。

2. 第二类:语言条件行为学习(Learning Language-Conditioned Behavior)

(1)现有研究核心方向

该领域旨在 "让机器人通过语言理解并执行行为",主要依赖两类学习范式(1-108):

- 模仿学习(Imitation Learning):通过人类演示数据训练 "语言→动作" 映射模型,例如 BC-Z([13])、CLIPort([26]),可处理拾取、放置等低层级技能,但无法理解高层级抽象指令(如 "拿健康的零食");

- 强化学习(Reinforcement Learning):通过奖励信号优化语言条件的行为策略,例如 MT-Opt([14])、Language as Abstraction([57]),部分方法可处理仿真环境的长时程任务,但真实场景中因奖励稀疏、环境复杂度高,性能受限。

(2)本文与现有研究的差异

现有方法的核心局限是 "技能序列规划能力弱"------ 仅能执行预定义的低层级技能,无法动态拆解高层级指令(1-108);而本文的创新补充在于:

- 高层级规划依赖 LLM:利用 LLM 的语义知识拆解抽象指令(如 "清理洒出的饮料"→"找海绵→拿海绵→递给用户"),突破传统行为克隆 / 强化学习的 "无规划" 缺陷;

- 多技能协同:通过 "LLM 评分 + 价值函数" 动态选择技能,而非依赖固定技能序列,适配真实场景的环境变化(如 "无海绵时不选择该技能")。

3. 第三类:任务与运动规划(Task and Motion Planning)

(1)现有研究核心方向

该领域聚焦 "如何将高层级任务拆解为低层级运动指令",分为两类方法(1-109 至 1-111):

- 传统符号规划 / 优化:基于显式规则或数学优化生成技能序列,例如 STRIPS([185])、Logic-Geometric Programming([189]),需手动定义物体属性、动作约束,泛化性差;

- 机器学习驱动规划:通过数据学习抽象任务的规划逻辑,例如 Neural Task Programming([191])、Hierarchical Foresight([204]),可处理部分长时程任务,但多依赖仿真数据,且缺乏语言与物理世界的动态关联。

(2)本文与现有研究的差异

现有方法的核心缺陷是 "语言理解能力弱"------ 无法通过自然语言动态调整规划逻辑(如用户指令从 "拿苹果" 改为 "拿香蕉" 时,需重新训练或定义规则)(1-111);而本文的创新补充在于:

- 自然语言驱动规划:利用 LLM 的语义理解能力,直接将自然语言指令转化为技能序列,无需手动定义符号规则;

- 真实场景鲁棒性:结合价值函数的环境可行性判断,避免传统规划 "仅考虑逻辑正确、忽略物理执行" 的问题,例如 "不选择无吸尘器场景中的'用吸尘器'技能"。