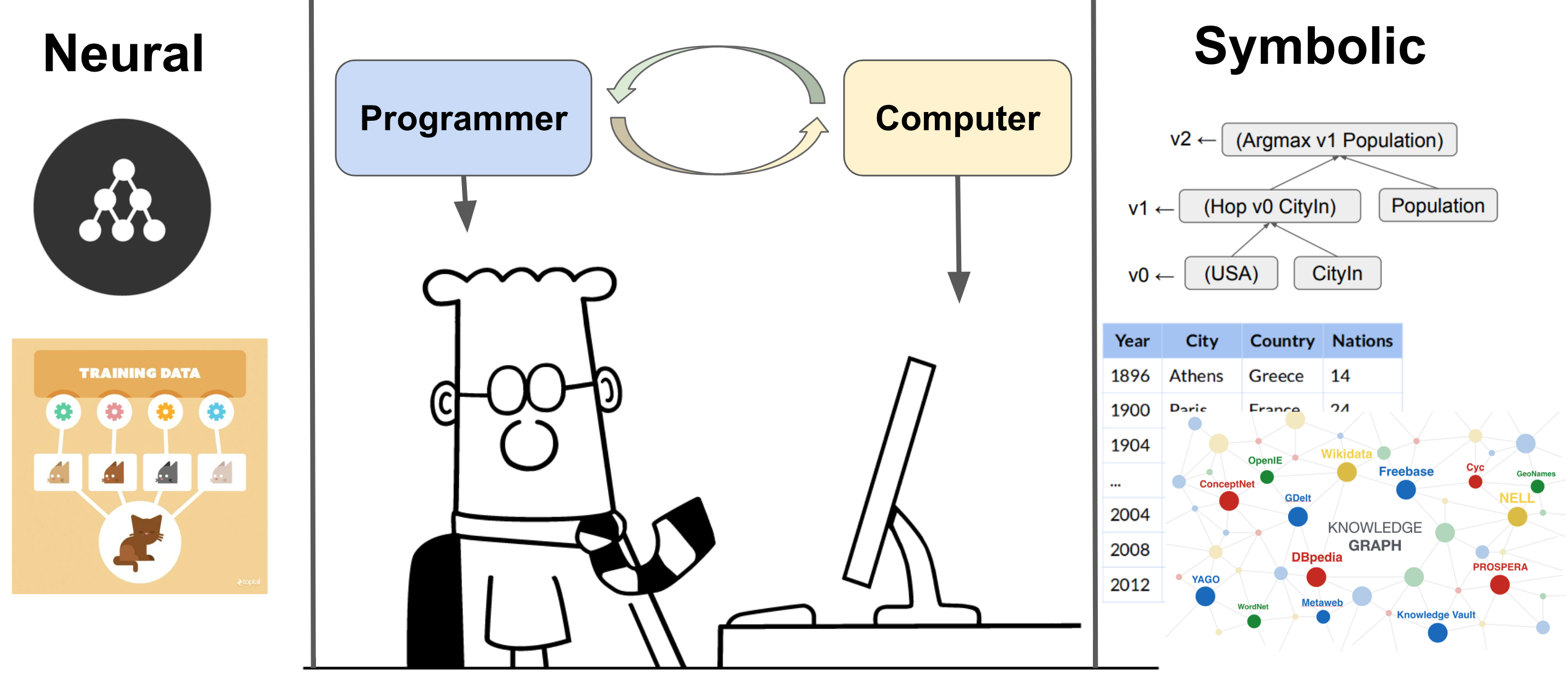

Neural-Symbolic-Machines核心目标是解决弱监督场景下的语义解析与程序合成问题,由Liang等人开发,相关成果发表于NeurIPS 2018和ACL 2017等顶会,目前遵循Apache-2.0开源协议。融合神经网络与符号计算,支持程序合成与语义解析。

一、项目定位

NSM的核心创新在于打破"神经网络擅长数据驱动学习"与"符号表示擅长逻辑推理"的割裂:通过强化学习作为桥梁,让模型既能从海量数据中学习模式(如自然语言与逻辑形式的映射),又能利用符号系统的结构化特性(如知识图谱约束、程序语法规则),最终实现弱监督下的高效学习------仅需"问答对"等易获取的弱监督数据,即可替代"问题-程序对"等难收集的全监督数据,显著降低工业应用中的数据成本。

二、核心技术与架构

1.核心训练方法:Memory Augmented Policy Optimization(MAPO)

MAPO是NSM专为"离散动作+确定性环境"设计的强化学习优化算法,解决传统政策梯度训练不稳定、收敛慢的问题,其核心逻辑如下:

记忆缓冲机制:存储"高奖励轨迹"(如能正确生成目标程序的推理路径),后续训练优先利用这些优质样本更新政策,减少无效探索;

适用场景:尤其适配程序合成、结构化预测、组合优化等任务(如从自然语言生成SQL语句),能加速收敛并提升模型稳定性。

2.分布式训练架构

NSM采用分布式Actor-Learner架构(借鉴DeepMind的IMPALA论文设计),支持多CPU/GPU协同训练,具体分工为:

Actor(执行者):多个并行Actor节点加载训练数据分片,与环境交互生成轨迹(如尝试生成程序),并将轨迹数据存入共享内存;

Learner(学习者):单个或多个Learner节点从内存中读取轨迹,更新模型参数,并将更新后的模型同步给所有Actor;

优势:大幅提升大规模数据(如WikiSQL、WikiTable)的训练效率,避免单机算力瓶颈。

三、应用场景

NSM的核心应用聚焦于"自然语言与符号系统的交互",典型场景包括:

| 应用方向 | 具体案例 | 项目验证场景 |

|---|---|---|

| 语义解析 | 将自然语言问题转化为逻辑形式(如Freebase知识图谱的查询语言) | Freebase知识图谱语义解析 |

| 程序合成 | 从自然语言生成结构化程序(如SQL语句、表格操作指令) | WikiSQL(生成SQL)、WikiTable(表格计算) |

| 工业级交互系统 | 虚拟助手、数据库自然语言接口、人机协作机器人(如通过语言控制机器人执行逻辑任务) | 数据库自然语言查询接口 |

| 项目已在Freebase、WikiSQL、WikiTable等公开数据集上验证效果,可直接复用代码适配类似场景(如自定义表格数据的自然语言查询)。 |

四、优势

1.融合神经网络与符号表示的优势

NSM的核心价值在于整合神经网络的感知能力与符号表示的逻辑推理能力:

神经网络擅长处理非结构化数据(如自然语言)并捕捉潜在模式;

符号表示(如逻辑程序、知识图谱)支持精确的逻辑推理和可解释性,弥补了纯神经网络"黑箱"特性的不足。

这种融合使其在语义解析、程序合成等需要"感知-推理"结合的任务中表现突出(如WikiTable、WikiSQL等结构化数据处理场景)。

2.高效稳定的训练机制

NSM采用记忆增强策略优化(MAPO) 进行训练,通过存储"有前景的轨迹"作为记忆缓冲,加速并稳定了强化学习的策略梯度更新。这一机制特别适合离散动作空间(如程序合成中的指令选择)和确定性环境,提升了训练效率和收敛稳定性。

3.支持弱监督学习

NSM能够从弱监督信号(如任务的最终结果而非中间步骤)中学习,降低了对精确标注数据的依赖。这在语义解析、知识图谱推理等标注成本极高的领域具有显著实用价值。

4.分布式架构的可扩展性

采用类似DeepMind IMPALA的分布式actor-learner架构,可利用多CPU和GPU进行大规模训练,支持处理更大规模的数据集和更复杂的任务,具备良好的工程扩展性。

五、不足

1.符号系统的构建依赖领域知识

符号表示(如逻辑规则、函数定义)的设计高度依赖特定领域的先验知识(如代码中的LispInterpreter需要预定义类型层次和函数词典)。对于新领域,符号系统的适配和构建成本较高,灵活性受限。

2.强化学习训练的固有挑战

尽管MAPO缓解了部分问题,但NSM仍面临强化学习的常见挑战:

稀疏奖励场景下(如程序合成中仅最终结果有奖励),训练效率可能下降;

策略容易陷入局部最优,尤其是在复杂逻辑推理任务中,长轨迹的探索和优化难度大。

3.泛化能力受限于任务场景

从应用案例来看,NSM的验证主要集中在WikiTable、WikiSQL等结构化数据任务,其在非结构化场景(如自由文本推理)或跨领域迁移中的表现尚未充分验证,泛化能力可能有限。

4.实现复杂度高

整合神经网络(如RNN、注意力机制)、符号推理(如LispInterpreter的解析与执行)和强化学习(如策略优化、轨迹采样)需要复杂的工程实现,且各模块的兼容性(如符号操作与神经网络输出的映射)增加了调试和维护难度。

5.技术栈的局限性

代码中明确依赖Python 2.7,而该版本已停止维护,可能导致与现代库(如新版TensorFlow、PyTorch)的兼容性问题,增加了二次开发和部署的成本。

六、结言

NSM通过融合神经与符号系统,在结构化任务的"感知-推理"整合上展现了独特优势,尤其在弱监督和高效训练机制上具有实用价值。但其性能高度依赖领域知识、训练复杂度高且泛化能力受限,这些问题仍需在后续研究中优化。