✨作者主页 :IT毕设梦工厂✨

个人简介:曾从事计算机专业培训教学,擅长Java、Python、PHP、.NET、Node.js、GO、微信小程序、安卓Android等项目实战。接项目定制开发、代码讲解、答辩教学、文档编写、降重等。

文章目录

一、前言

系统介绍

基于大数据的电信客户流失数据分析系统是一个集数据存储、处理、分析与可视化于一体的综合性大数据分析平台。该系统采用Hadoop+Spark大数据处理框架作为核心技术架构,利用HDFS进行海量客户数据的分布式存储,通过Spark SQL和Pandas进行高效的数据清洗与特征工程处理。系统支持Python/Java语言开发模式,后端基于Django/Spring Boot框架构建RESTful API服务,前端采用Vue.js+ElementUI构建响应式用户界面,结合Echarts图表库实现丰富的数据可视化展示。系统核心功能涵盖客户流失总体概览分析、用户人口属性维度分析、客户账户及合约维度分析、客户业务办理维度分析以及基于LTM模型的客户分群分析等五大模块。通过多维度的数据挖掘与机器学习算法,系统能够准确识别高风险流失客户群体,为电信运营商提供精准的客户留存策略建议,有效提升客户管理决策的科学性和针对性。

选题背景

随着电信行业市场竞争的日趋激烈和用户选择多样化程度的不断提升,客户流失已经成为制约电信运营商可持续发展的关键挑战。在移动通信技术快速迭代和携号转网政策全面实施的背景下,电信用户的转换成本显著降低,客户忠诚度面临前所未有的考验。传统的客户管理模式主要依靠人工经验和简单的统计报表,难以深入挖掘海量客户数据中蕴含的流失规律和预警信号,导致客户流失预测准确性不足,挽留措施缺乏针对性。同时,电信企业每日产生的客户行为数据、消费数据、服务数据等呈现出典型的大数据特征,包括数据量庞大、结构复杂、更新频繁等特点,传统的数据处理技术已无法满足实时分析和深度挖掘的业务需求。在这种形势下,运用大数据技术构建智能化的客户流失分析系统,通过对多维度客户数据的深度挖掘和机器学习建模,实现对客户流失风险的精准识别和预测,已成为电信行业数字化转型的重要方向。

选题意义

本课题的研究具有多方面的实际意义和应用价值。从企业经营角度来看,该系统能够帮助电信运营商更好地理解客户流失的内在机制和关键影响因素,通过数据驱动的方式识别高风险客户群体,制定个性化的客户挽留策略,从而降低客户流失率,提升客户生命周期价值,这对于改善企业经营效益具有直接的促进作用。从技术应用角度分析,该系统展现了大数据技术在传统行业中的实际应用场景,验证了Hadoop、Spark等大数据处理框架在处理海量客户数据方面的有效性和实用性,为类似行业的数字化转型提供了可借鉴的技术方案。从客户服务角度而言,通过精准的客户分群和个性化分析,系统有助于运营商更好地了解不同客户群体的需求特征和服务偏好,进而优化产品设计和服务流程,提升整体客户满意度。虽然作为毕业设计项目,本系统在规模和复杂度上相对有限,但其体现的数据分析思路和技术实现方法对于相关从业人员的能力提升和知识结构完善仍具有一定的参考价值。

二、开发环境

- 大数据框架:Hadoop+Spark(本次没用Hive,支持定制)

- 开发语言:Python+Java(两个版本都支持)

- 后端框架:Django+Spring Boot(Spring+SpringMVC+Mybatis)(两个版本都支持)

- 前端:Vue+ElementUI+Echarts+HTML+CSS+JavaScript+jQuery

- 详细技术点:Hadoop、HDFS、Spark、Spark SQL、Pandas、NumPy

- 数据库:MySQL

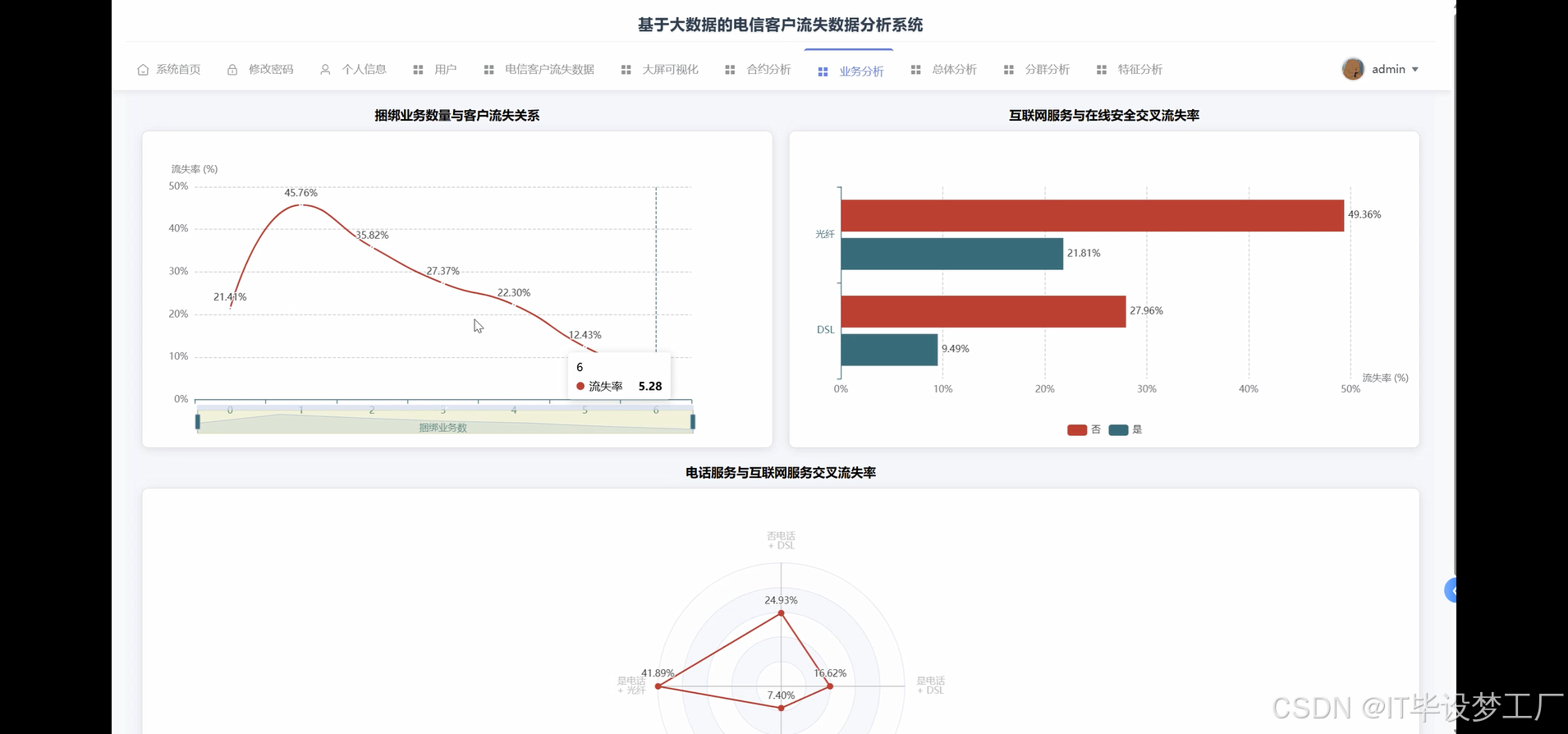

三、系统界面展示

- 基于大数据的电信客户流失数据分析系统界面展示:

四、部分代码设计

- 项目实战-代码参考:

java(贴上部分代码)

from pyspark.sql import SparkSession

from pyspark.sql.functions import col, when, count, avg, sum as spark_sum, desc

from pyspark.ml.feature import VectorAssembler

from pyspark.ml.clustering import KMeans

import pandas as pd

import numpy as np

from sklearn.preprocessing import StandardScaler

from django.http import JsonResponse

from django.views import View

import json

spark = SparkSession.builder.appName("TelecomChurnAnalysis").master("local[*]").config("spark.sql.adaptive.enabled", "true").config("spark.sql.adaptive.coalescePartitions.enabled", "true").getOrCreate()

def customer_churn_overview_analysis(request):

df = spark.read.csv("/data/telco_customer_churn.csv", header=True, inferSchema=True)

df_cleaned = df.filter(col("TotalCharges") != " ").withColumn("TotalCharges", col("TotalCharges").cast("double"))

total_customers = df_cleaned.count()

churned_customers = df_cleaned.filter(col("Churn") == "Yes").count()

overall_churn_rate = (churned_customers / total_customers) * 100

tenure_segments = df_cleaned.withColumn("tenure_segment",

when(col("tenure") <= 12, "0-12月")

.when(col("tenure") <= 24, "13-24月")

.when(col("tenure") <= 36, "25-36月")

.when(col("tenure") <= 48, "37-48月")

.when(col("tenure") <= 60, "49-60月")

.otherwise("61月以上"))

tenure_churn_analysis = tenure_segments.groupBy("tenure_segment").agg(

count("*").alias("total_count"),

spark_sum(when(col("Churn") == "Yes", 1).otherwise(0)).alias("churn_count")

).withColumn("churn_rate", (col("churn_count") / col("total_count")) * 100).orderBy("tenure_segment")

monthly_charges_segments = df_cleaned.withColumn("monthly_charges_segment",

when(col("MonthlyCharges") <= 30, "0-30元")

.when(col("MonthlyCharges") <= 60, "31-60元")

.when(col("MonthlyCharges") <= 90, "61-90元")

.otherwise("90元以上"))

monthly_charges_analysis = monthly_charges_segments.groupBy("monthly_charges_segment").agg(

count("*").alias("total_count"),

spark_sum(when(col("Churn") == "Yes", 1).otherwise(0)).alias("churn_count")

).withColumn("churn_rate", (col("churn_count") / col("total_count")) * 100).orderBy("monthly_charges_segment")

total_charges_segments = df_cleaned.withColumn("total_charges_segment",

when(col("TotalCharges") <= 1000, "0-1000元")

.when(col("TotalCharges") <= 3000, "1001-3000元")

.when(col("TotalCharges") <= 6000, "3001-6000元")

.otherwise("6000元以上"))

total_charges_analysis = total_charges_segments.groupBy("total_charges_segment").agg(

count("*").alias("total_count"),

spark_sum(when(col("Churn") == "Yes", 1).otherwise(0)).alias("churn_count")

).withColumn("churn_rate", (col("churn_count") / col("total_count")) * 100).orderBy("total_charges_segment")

result_data = {

"overall_churn_rate": round(overall_churn_rate, 2),

"total_customers": total_customers,

"churned_customers": churned_customers,

"tenure_analysis": [row.asDict() for row in tenure_churn_analysis.collect()],

"monthly_charges_analysis": [row.asDict() for row in monthly_charges_analysis.collect()],

"total_charges_analysis": [row.asDict() for row in total_charges_analysis.collect()]

}

return JsonResponse({"status": "success", "data": result_data})

def contract_payment_analysis(request):

df = spark.read.csv("/data/telco_customer_churn.csv", header=True, inferSchema=True)

df_cleaned = df.filter(col("TotalCharges") != " ").withColumn("TotalCharges", col("TotalCharges").cast("double"))

contract_analysis = df_cleaned.groupBy("Contract").agg(

count("*").alias("total_count"),

spark_sum(when(col("Churn") == "Yes", 1).otherwise(0)).alias("churn_count")

).withColumn("churn_rate", (col("churn_count") / col("total_count")) * 100).orderBy(desc("churn_rate"))

payment_method_analysis = df_cleaned.groupBy("PaymentMethod").agg(

count("*").alias("total_count"),

spark_sum(when(col("Churn") == "Yes", 1).otherwise(0)).alias("churn_count")

).withColumn("churn_rate", (col("churn_count") / col("total_count")) * 100).orderBy(desc("churn_rate"))

paperless_billing_analysis = df_cleaned.groupBy("PaperlessBilling").agg(

count("*").alias("total_count"),

spark_sum(when(col("Churn") == "Yes", 1).otherwise(0)).alias("churn_count")

).withColumn("churn_rate", (col("churn_count") / col("total_count")) * 100)

tech_support_analysis = df_cleaned.groupBy("TechSupport").agg(

count("*").alias("total_count"),

spark_sum(when(col("Churn") == "Yes", 1).otherwise(0)).alias("churn_count")

).withColumn("churn_rate", (col("churn_count") / col("total_count")) * 100)

contract_payment_correlation = df_cleaned.groupBy("Contract", "PaymentMethod").agg(

count("*").alias("total_count"),

spark_sum(when(col("Churn") == "Yes", 1).otherwise(0)).alias("churn_count")

).withColumn("churn_rate", (col("churn_count") / col("total_count")) * 100).orderBy("Contract", desc("churn_rate"))

auto_payment_impact = df_cleaned.withColumn("auto_payment",

when((col("PaymentMethod") == "Credit card (automatic)") |

(col("PaymentMethod") == "Bank transfer (automatic)"), "自动支付")

.otherwise("非自动支付"))

auto_payment_analysis = auto_payment_impact.groupBy("auto_payment").agg(

count("*").alias("total_count"),

spark_sum(when(col("Churn") == "Yes", 1).otherwise(0)).alias("churn_count"),

avg("MonthlyCharges").alias("avg_monthly_charges")

).withColumn("churn_rate", (col("churn_count") / col("total_count")) * 100)

result_data = {

"contract_analysis": [row.asDict() for row in contract_analysis.collect()],

"payment_method_analysis": [row.asDict() for row in payment_method_analysis.collect()],

"paperless_billing_analysis": [row.asDict() for row in paperless_billing_analysis.collect()],

"tech_support_analysis": [row.asDict() for row in tech_support_analysis.collect()],

"contract_payment_correlation": [row.asDict() for row in contract_payment_correlation.collect()],

"auto_payment_analysis": [row.asDict() for row in auto_payment_analysis.collect()]

}

return JsonResponse({"status": "success", "data": result_data})

def ltm_customer_segmentation_analysis(request):

df = spark.read.csv("/data/telco_customer_churn.csv", header=True, inferSchema=True)

df_cleaned = df.filter(col("TotalCharges") != " ").withColumn("TotalCharges", col("TotalCharges").cast("double"))

ltm_features = df_cleaned.select("customerID", "tenure", "MonthlyCharges", "Contract", "Churn").withColumn("contract_score",

when(col("Contract") == "Month-to-month", 1)

.when(col("Contract") == "One year", 2)

.when(col("Contract") == "Two year", 3)

.otherwise(1))

feature_assembler = VectorAssembler(inputCols=["tenure", "MonthlyCharges", "contract_score"], outputCol="features")

ltm_data = feature_assembler.transform(ltm_features)

kmeans = KMeans(k=5, seed=42, featuresCol="features", predictionCol="cluster")

kmeans_model = kmeans.fit(ltm_data)

clustered_data = kmeans_model.transform(ltm_data)

cluster_analysis = clustered_data.groupBy("cluster").agg(

count("*").alias("customer_count"),

avg("tenure").alias("avg_tenure"),

avg("MonthlyCharges").alias("avg_monthly_charges"),

avg("contract_score").alias("avg_contract_score"),

spark_sum(when(col("Churn") == "Yes", 1).otherwise(0)).alias("churn_count")

).withColumn("churn_rate", (col("churn_count") / col("customer_count")) * 100).orderBy("cluster")

cluster_naming = cluster_analysis.withColumn("cluster_name",

when((col("avg_tenure") > 40) & (col("avg_monthly_charges") > 70) & (col("churn_rate") < 15), "高价值忠诚客户")

.when((col("avg_tenure") < 20) & (col("avg_monthly_charges") > 60) & (col("churn_rate") < 30), "高消费潜力新客")

.when((col("avg_tenure") > 30) & (col("avg_monthly_charges") < 50) & (col("churn_rate") < 20), "稳定低消费客户")

.when((col("churn_rate") > 50), "高风险流失客户")

.otherwise("一般客户"))

business_preference_analysis = clustered_data.join(df_cleaned, "customerID").groupBy("cluster").agg(

avg(when(col("OnlineSecurity") == "Yes", 1).otherwise(0)).alias("online_security_rate"),

avg(when(col("OnlineBackup") == "Yes", 1).otherwise(0)).alias("online_backup_rate"),

avg(when(col("DeviceProtection") == "Yes", 1).otherwise(0)).alias("device_protection_rate"),

avg(when(col("TechSupport") == "Yes", 1).otherwise(0)).alias("tech_support_rate"),

avg(when(col("StreamingTV") == "Yes", 1).otherwise(0)).alias("streaming_tv_rate"),

avg(when(col("StreamingMovies") == "Yes", 1).otherwise(0)).alias("streaming_movies_rate")

).orderBy("cluster")

cluster_value_analysis = clustered_data.groupBy("cluster").agg(

count("*").alias("customer_count"),

avg("MonthlyCharges").alias("avg_monthly_revenue"),

spark_sum("MonthlyCharges").alias("total_monthly_revenue")

).withColumn("revenue_contribution", col("total_monthly_revenue") / spark_sum("total_monthly_revenue").over()).orderBy(desc("avg_monthly_revenue"))

result_data = {

"cluster_analysis": [row.asDict() for row in cluster_naming.collect()],

"business_preference_analysis": [row.asDict() for row in business_preference_analysis.collect()],

"cluster_value_analysis": [row.asDict() for row in cluster_value_analysis.collect()],

"total_clusters": 5

}

return JsonResponse({"status": "success", "data": result_data})五、系统视频

- 基于大数据的电信客户流失数据分析系统-项目视频:

大数据毕业设计选题推荐-基于大数据的电信客户流失数据分析系统-Hadoop-Spark-数据可视化-BigData

结语

大数据毕业设计选题推荐-基于大数据的电信客户流失数据分析系统-Hadoop-Spark-数据可视化-BigData

想看其他类型的计算机毕业设计作品也可以和我说~ 谢谢大家!

有技术这一块问题大家可以评论区交流或者私我~

大家可以帮忙点赞、收藏、关注、评论啦~

源码获取:⬇⬇⬇