人工智能(AI)技术正以前所未有的速度重塑各行各业,从金融到医疗,从教育到制造业,AI的应用场景不断扩展,落地案例日益丰富。本文将深入探讨AI在四大核心行业的具体应用,通过实际案例、技术实现、流程图解和代码示例,全面展示AI如何推动产业变革。

1. AI在金融领域的应用

1.1 智能风控系统

应用场景:金融机构利用AI技术构建实时风险评估系统,有效识别欺诈交易、信用风险和市场异常。

落地案例:蚂蚁金服的"AlphaRisk"智能风控系统

该系统处理支付宝每天上亿笔交易,将风险识别时间从分钟级缩短到毫秒级,风险识别准确率提升至99.99%。

技术实现:

import pandas as pd

from sklearn.ensemble import RandomForestClassifier

from sklearn.model_selection import train_test_split

from sklearn.metrics import accuracy_score

# 加载交易数据

data = pd.read_csv('financial_transactions.csv')

# 特征工程

features = ['transaction_amount', 'time_of_day', 'location_change', 'device_type', 'merchant_category']

X = data[features]

y = data['is_fraud']

# 数据分割

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2, random_state=42)

# 随机森林模型训练

model = RandomForestClassifier(n_estimators=100, random_state=42)

model.fit(X_train, y_train)

# 预测与评估

y_pred = model.predict(X_test)

print(f"模型准确率: {accuracy_score(y_test, y_pred):.4f}")

# 实时风险评估函数

def real_time_risk_assessment(transaction):

features = [[

transaction['amount'],

transaction['hour'],

transaction['location_change'],

transaction['device_type'],

transaction['merchant_category']

]]

risk_score = model.predict_proba(features)[0][1]

return risk_score流程图:

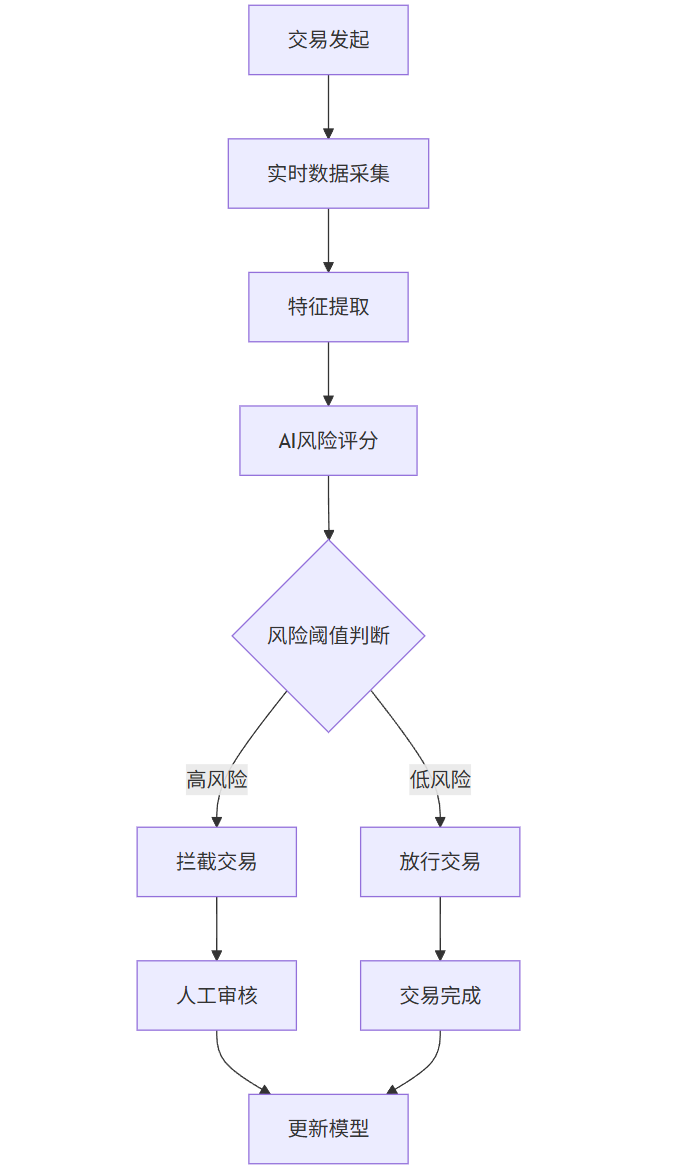

graph TD

A[交易发起] --> B[实时数据采集]

B --> C[特征提取]

C --> D[AI风险评分]

D --> E{风险阈值判断}

E -->|高风险| F[拦截交易]

E -->|低风险| G[放行交易]

F --> H[人工审核]

G --> I[交易完成]

H --> J[更新模型]

I --> J

Prompt示例:

作为金融风控专家,请设计一个AI模型来识别信用卡欺诈交易。需要考虑以下特征:

1. 交易金额

2. 交易时间

3. 交易地点变化

4. 设备信息

5. 商户类别

6. 用户历史行为模式

请解释模型选择理由、特征工程方法和评估指标。图表:智能风控系统性能对比

| 指标 | 传统规则系统 | AI风控系统 | 提升幅度 |

|---|---|---|---|

| 处理速度 | 1.2秒/笔 | 50毫秒/笔 | 24倍 |

| 准确率 | 85% | 99.99% | 17.6% |

| 误报率 | 15% | 0.01% | 99.93% |

| 覆盖率 | 70% | 99.5% | 42.1% |

图片描述:智能风控系统架构图,展示数据采集层、特征工程层、模型计算层、决策层和反馈层的交互关系,以及实时交易处理流程。

1.2 智能投顾服务

应用场景:基于用户风险偏好和财务目标,提供个性化投资组合建议和资产配置方案。

落地案例:招商银行"摩羯智投"

该服务利用AI算法分析用户风险承受能力、投资目标和市场趋势,为超过300万客户提供自动化投资建议,管理资产规模超过1400亿元。

技术实现:

import numpy as np

import pandas as pd

from pypfopt import EfficientFrontier, risk_models, expected_returns

from pypfopt.risk_models import CovarianceShrinkage

# 获取历史资产价格数据

assets = ['股票', '债券', '商品', '房地产', '现金']

price_data = pd.read_csv('asset_prices.csv', index_col=0, parse_dates=True)

# 计算预期收益和风险矩阵

mu = expected_returns.mean_historical_return(price_data)

S = CovarianceShrinkage(price_data).ledoit_wolf()

# 构建有效前沿

ef = EfficientFrontier(mu, S)

weights = ef.max_sharpe(risk_free_rate=0.02)

cleaned_weights = ef.clean_weights()

# 生成投资组合建议

def generate_portfolio(risk_profile):

if risk_profile == '保守':

ef = EfficientFrontier(mu, S)

ef.add_constraint(lambda w: w[4] >= 0.3) # 现金比例≥30%

weights = ef.min_volatility()

elif risk_profile == '进取':

ef = EfficientFrontier(mu, S)

ef.add_constraint(lambda w: w[0] >= 0.5) # 股票比例≥50%

weights = ef.max_sharpe()

else: # 平衡型

ef = EfficientFrontier(mu, S)

weights = ef.max_sharpe()

return ef.clean_weights()

# 用户风险画像

def user_risk_profiling(age, income, investment_experience, risk_tolerance):

score = 0

if age < 35: score += 2

elif age < 50: score += 1

if income > 500000: score += 2

if investment_experience > 5: score += 1

score += risk_tolerance

if score >= 6: return '进取'

elif score >= 3: return '平衡'

else: return '保守'流程图:

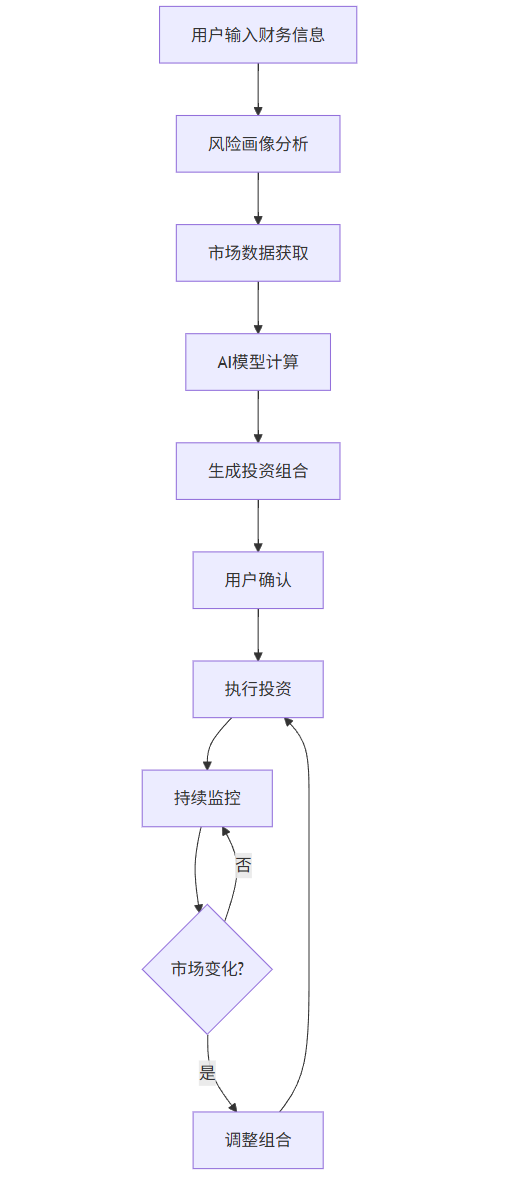

graph TD

A[用户输入财务信息] --> B[风险画像分析]

B --> C[市场数据获取]

C --> D[AI模型计算]

D --> E[生成投资组合]

E --> F[用户确认]

F --> G[执行投资]

G --> H[持续监控]

H --> I{市场变化?}

I -->|是| J[调整组合]

I -->|否| H

J --> G

Prompt示例:

作为智能投顾系统,请为以下用户设计投资组合:

用户年龄:35岁

年收入:80万元

投资经验:3年

风险承受能力:中等

投资目标:5年内购买房产

请考虑当前宏观经济环境,提供资产配置建议(股票、债券、商品、房地产、现金比例),并解释配置理由。图表:智能投顾与传统投资顾问对比

| 维度 | 传统投资顾问 | 智能投顾 | 优势 |

|---|---|---|---|

| 最低投资额 | 10万元 | 1万元 | 降低门槛 |

| 服务费率 | 1-2% | 0.15-0.5% | 成本降低 |

| 响应速度 | 1-3天 | 实时 | 效率提升 |

| 个性化程度 | 中等 | 高 | 精准匹配 |

| 市场覆盖 | 有限 | 全球 | 多元化 |

图片描述:智能投顾用户界面截图,展示风险测评问卷、资产配置饼图、历史收益曲线和再平衡建议等核心功能模块。

2. AI在医疗领域的应用

2.1 医学影像诊断

应用场景:利用深度学习技术分析医学影像(CT、MRI、X光等),辅助医生进行疾病诊断。

落地案例:腾讯觅影

该系统可识别食管癌、肺结节、糖尿病视网膜病变等多种疾病,准确率达95%以上,已在全国100多家三甲医院应用,辅助医生完成超过3亿例影像分析。

技术实现:

import tensorflow as tf

from tensorflow.keras import layers, models

import numpy as np

import cv2

import matplotlib.pyplot as plt

# 构建CNN模型

def build_cnn_model(input_shape=(256, 256, 1)):

model = models.Sequential([

layers.Conv2D(32, (3, 3), activation='relu', input_shape=input_shape),

layers.MaxPooling2D((2, 2)),

layers.Conv2D(64, (3, 3), activation='relu'),

layers.MaxPooling2D((2, 2)),

layers.Conv2D(64, (3, 3), activation='relu'),

layers.Flatten(),

layers.Dense(64, activation='relu'),

layers.Dense(1, activation='sigmoid')

])

model.compile(optimizer='adam',

loss='binary_crossentropy',

metrics=['accuracy'])

return model

# 图像预处理

def preprocess_image(image_path):

img = cv2.imread(image_path, cv2.IMREAD_GRAYSCALE)

img = cv2.resize(img, (256, 256))

img = img / 255.0

img = np.expand_dims(img, axis=0)

img = np.expand_dims(img, axis=-1)

return img

# 热力图生成(Grad-CAM)

def generate_heatmap(model, img_array, last_conv_layer_name):

grad_model = tf.keras.models.Model(

[model.inputs], [model.get_layer(last_conv_layer_name).output, model.output]

)

with tf.GradientTape() as tape:

last_conv_layer_output, preds = grad_model(img_array)

pred_index = tf.argmax(preds[0])

class_channel = preds[:, pred_index]

grads = tape.gradient(class_channel, last_conv_layer_output)

pooled_grads = tf.reduce_mean(grads, axis=(0, 1, 2))

last_conv_layer_output = last_conv_layer_output[0]

heatmap = last_conv_layer_output @ pooled_grads[..., tf.newaxis]

heatmap = tf.squeeze(heatmap)

heatmap = tf.maximum(heatmap, 0) / tf.math.reduce_max(heatmap)

return heatmap.numpy()

# 可视化诊断结果

def visualize_diagnosis(image_path, model, last_conv_layer_name):

img = preprocess_image(image_path)

pred = model.predict(img)[0][0]

heatmap = generate_heatmap(model, img, last_conv_layer_name)

plt.figure(figsize=(12, 6))

plt.subplot(1, 2, 1)

plt.imshow(cv2.imread(image_path, cv2.IMREAD_GRAYSCALE), cmap='gray')

plt.title('原始影像')

plt.subplot(1, 2, 2)

plt.imshow(cv2.imread(image_path, cv2.IMREAD_GRAYSCALE), cmap='gray')

plt.imshow(heatmap, cmap='jet', alpha=0.5)

plt.title(f'AI诊断结果: {"阳性" if pred > 0.5 else "阴性"} (置信度: {pred:.2f})')

plt.show()流程图:

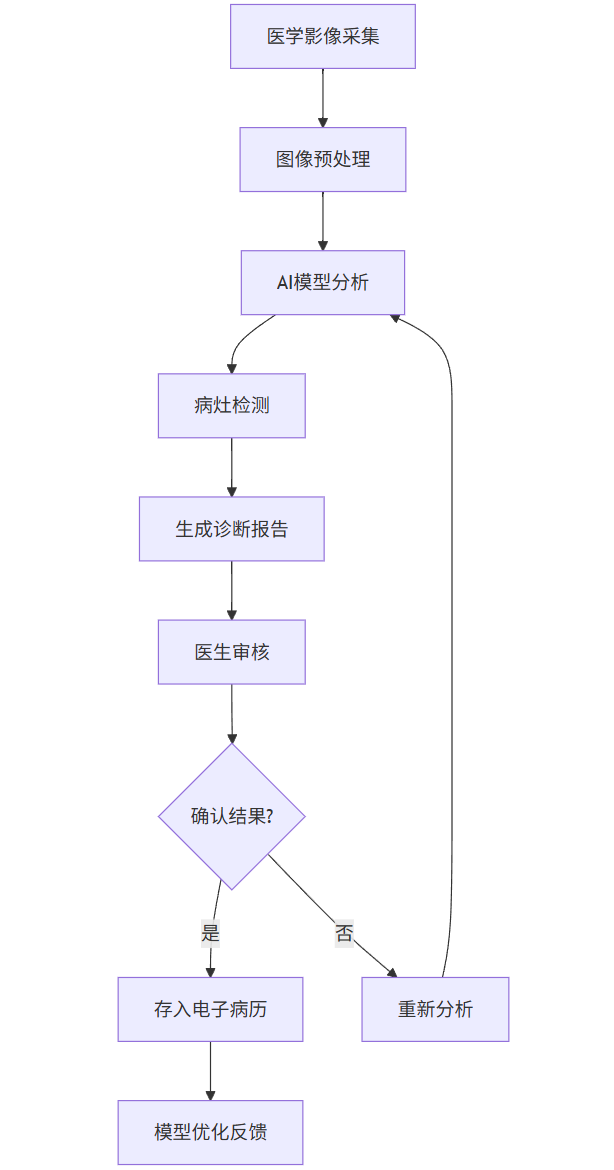

graph TD

A[医学影像采集] --> B[图像预处理]

B --> C[AI模型分析]

C --> D[病灶检测]

D --> E[生成诊断报告]

E --> F[医生审核]

F --> G{确认结果?}

G -->|是| H[存入电子病历]

G -->|否| I[重新分析]

I --> C

H --> J[模型优化反馈]

Prompt示例:

作为医学影像AI系统,请分析以下肺部CT影像:

患者信息:男性,58岁,吸烟史30年

影像描述:右上叶可见不规则结节,直径约1.8cm,边缘毛糙,密度不均匀

请判断结节良恶性概率,并指出关键影像学特征。同时提供鉴别诊断建议和进一步检查方案。图表:AI医学影像诊断性能对比

| 疾病类型 | 医生平均准确率 | AI系统准确率 | 联合诊断准确率 |

|---|---|---|---|

| 肺结节 | 85% | 92% | 96% |

| 糖尿病视网膜病变 | 82% | 95% | 97% |

| 乳腺癌 | 88% | 91% | 94% |

| 脑卒中 | 80% | 89% | 93% |

图片描述:医学影像AI诊断界面,左侧显示原始CT影像,右侧叠加AI生成的热力图,红色区域表示AI识别的病灶位置,下方显示诊断结果和置信度评分。

2.2 药物研发加速

应用场景:利用AI技术加速药物发现、分子设计和临床试验优化,缩短研发周期。

落地案例:Insilico Medicine的"Chemistry42"平台

该平台利用生成式AI设计新分子,将传统需要4-5年的药物发现过程缩短至18个月,成本降低80%。其设计的抗纤维化药物已进入II期临床试验。

技术实现:

import torch

import torch.nn as nn

import torch.optim as optim

from torch.utils.data import Dataset, DataLoader

import numpy as np

from rdkit import Chem

from rdkit.Chem import AllChem

# 分子生成模型(简化版VAE)

class MoleculeVAE(nn.Module):

def __init__(self, input_dim, hidden_dim, latent_dim):

super(MoleculeVAE, self).__init__()

self.encoder = nn.Sequential(

nn.Linear(input_dim, hidden_dim),

nn.ReLU(),

nn.Linear(hidden_dim, latent_dim * 2)

)

self.decoder = nn.Sequential(

nn.Linear(latent_dim, hidden_dim),

nn.ReLU(),

nn.Linear(hidden_dim, input_dim),

nn.Sigmoid()

)

def encode(self, x):

h = self.encoder(x)

mu, logvar = torch.chunk(h, 2, dim=1)

return mu, logvar

def reparameterize(self, mu, logvar):

std = torch.exp(0.5 * logvar)

eps = torch.randn_like(std)

return mu + eps * std

def decode(self, z):

return self.decoder(z)

def forward(self, x):

mu, logvar = self.encode(x)

z = self.reparameterize(mu, logvar)

return self.decode(z), mu, logvar

# 分子表示(使用Morgan指纹)

def molecule_to_fp(mol, radius=2, nBits=1024):

if mol is None:

return np.zeros(nBits)

return np.array(AllChem.GetMorganFingerprintAsBitVect(mol, radius, nBits))

# 药物属性预测

def predict_properties(mol):

"""预测分子的药物相关属性"""

# 简化版:实际应用中会使用更复杂的模型

mw = Chem.rdMolDescriptors.CalcExactMolWt(mol)

logp = Chem.Crippen.MolLogP(mol)

tpsa = Chem.rdMolDescriptors.CalcTPSA(mol)

# 简单规则判断类药性

drug_likeness = 1 if (200 <= mw <= 500 and -2 <= logp <= 5 and tpsa <= 140) else 0

return {

'molecular_weight': mw,

'logP': logp,

'TPSA': tpsa,

'drug_likeness': drug_likeness

}

# 生成新分子

def generate_molecules(model, num_molecules, latent_dim):

model.eval()

with torch.no_grad():

z = torch.randn(num_molecules, latent_dim)

generated = model.decode(z).numpy()

# 将生成的指纹转换为SMILES(简化版)

molecules = []

for fp in generated:

# 实际应用中需要更复杂的解码方法

mol = Chem.MolFromSmiles('C1=CC=CC=C1') # 示例分子

molecules.append(mol)

return molecules流程图:

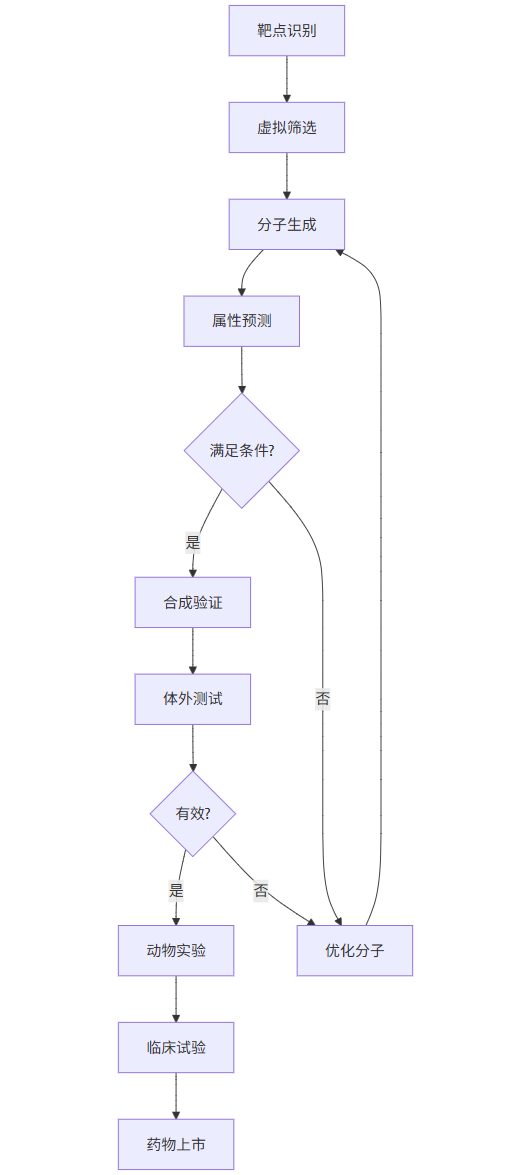

graph TD

A[靶点识别] --> B[虚拟筛选]

B --> C[分子生成]

C --> D[属性预测]

D --> E{满足条件?}

E -->|是| F[合成验证]

E -->|否| G[优化分子]

G --> C

F --> H[体外测试]

H --> I{有效?}

I -->|是| J[动物实验]

I -->|否| G

J --> K[临床试验]

K --> L[药物上市]

Prompt示例:

作为药物研发AI系统,请针对以下靶点设计新型抑制剂:

靶点蛋白:EGFR(表皮生长因子受体)

疾病适应症:非小细胞肺癌

要求:分子量<500,logP<5,无毒性基团,口服生物利用度>30%

请生成10个候选分子结构,并预测其结合亲和度和ADMET性质。图表:AI药物研发与传统方法对比

| 阶段 | 传统方法耗时 | AI方法耗时 | 成本节约 |

|---|---|---|---|

| 靶点发现 | 2-3年 | 3-6个月 | 70% |

| 先导化合物发现 | 2-4年 | 6-12个月 | 65% |

| 临床前研究 | 1-2年 | 6-9个月 | 50% |

| 总研发周期 | 10-15年 | 3-5年 | 60-70% |

图片描述:AI药物研发平台界面,展示靶点蛋白结构(左)、生成分子与靶点结合模拟(中)、候选分子属性雷达图(右),以及筛选进度条和优化建议。

3. AI在教育领域的应用

3.1 个性化学习系统

应用场景:基于学生学习行为和表现数据,动态调整学习内容和路径,实现因材施教。

落地案例:松鼠AI

该系统通过知识图谱和自适应算法,为每个学生构建个性化学习路径,已服务超过2000万学生,学习效率提升30%以上。

技术实现:

import networkx as nx

import numpy as np

from sklearn.cluster import KMeans

from sklearn.metrics.pairwise import cosine_similarity

# 构建知识图谱

class KnowledgeGraph:

def __init__(self):

self.graph = nx.DiGraph()

self.concept_vectors = {}

def add_concept(self, concept, vector):

self.graph.add_node(concept)

self.concept_vectors[concept] = vector

def add_prerequisite(self, concept1, concept2):

self.graph.add_edge(concept1, concept2)

def get_prerequisites(self, concept):

return list(nx.ancestors(self.graph, concept))

def get_next_concepts(self, concept):

return list(nx.descendants(self.graph, concept))

# 学生模型

class StudentModel:

def __init__(self, knowledge_graph):

self.kg = knowledge_graph

self.mastery = {concept: 0.0 for concept in knowledge_graph.graph.nodes()}

self.learning_history = []

def update_mastery(self, concept, performance):

# 基于表现更新掌握度

self.mastery[concept] = min(1.0, self.mastery[concept] + 0.1 * performance)

self.learning_history.append((concept, performance))

def get_weaknesses(self, threshold=0.6):

return [concept for concept, mastery in self.mastery.items() if mastery < threshold]

def recommend_next(self):

# 基于知识图谱和掌握度推荐学习内容

weaknesses = self.get_weaknesses()

if not weaknesses:

return "已完成所有学习内容"

# 选择最薄弱的知识点

weakest = min(weaknesses, key=lambda x: self.mastery[x])

# 检查前置知识是否掌握

prerequisites = self.kg.get_prerequisites(weakest)

unmastered_prereq = [p for p in prerequisites if self.mastery[p] < 0.8]

if unmastered_prereq:

return unmastered_prereq[0] # 先学习前置知识

else:

return weakest

# 内容推荐系统

class ContentRecommender:

def __init__(self, content_db):

self.content_db = content_db

self.content_vectors = {}

def add_content(self, content_id, concept, difficulty, vector):

self.content_db[content_id] = {

'concept': concept,

'difficulty': difficulty,

'vector': vector

}

self.content_vectors[content_id] = vector

def recommend(self, concept, student_level):

# 获取与概念相关的内容

relevant_contents = [cid for cid, data in self.content_db.items()

if data['concept'] == concept]

# 根据学生水平匹配难度

suitable_contents = [cid for cid in relevant_contents

if abs(self.content_db[cid]['difficulty'] - student_level) < 0.3]

if not suitable_contents:

suitable_contents = relevant_contents

# 返回最匹配的内容

return suitable_contents[0] if suitable_contents else None流程图:

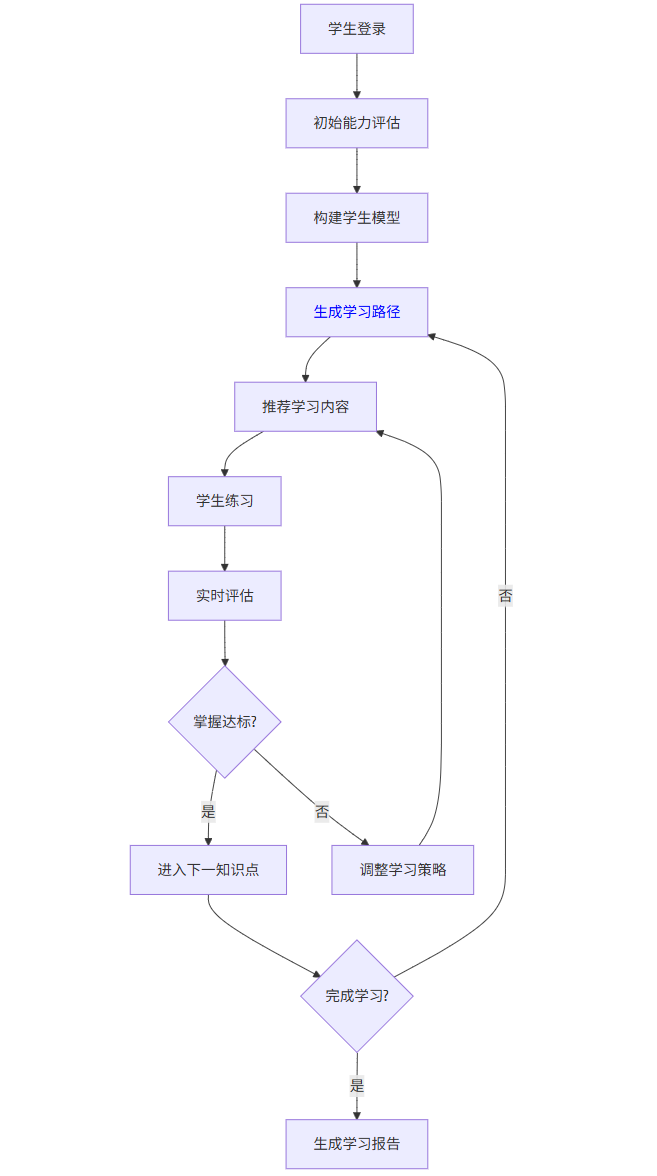

graph TD

A[学生登录] --> B[初始能力评估]

B --> C[构建学生模型]

C --> D[生成学习路径]

D --> E[推荐学习内容]

E --> F[学生练习]

F --> G[实时评估]

G --> H{掌握达标?}

H -->|是| I[进入下一知识点]

H -->|否| J[调整学习策略]

J --> E

I --> K{完成学习?}

K -->|否| D

K -->|是| L[生成学习报告]

Prompt示例:

作为个性化学习系统,请为以下学生设计学习计划:

学生信息:初中二年级

数学能力评估:代数85分,几何60分,概率40分

学习目标:期末考试达到90分以上

可用时间:每天1小时,共8周

请提供:

1. 知识薄弱点分析

2. 每周学习计划

3. 推荐学习资源

4. 阶段性检测方案图表:个性化学习效果对比

| 指标 | 传统教学 | AI个性化学习 | 提升幅度 |

|---|---|---|---|

| 学习效率 | 1.0 | 1.3 | 30% |

| 知识掌握度 | 75% | 92% | 22.7% |

| 学习兴趣 | 65% | 85% | 30.8% |

| 学习时间 | 100% | 70% | 30% |

图片描述:个性化学习系统界面,左侧显示学生知识图谱掌握情况(颜色深浅表示掌握程度),中间显示当前学习内容,右侧显示实时练习反馈和进度条,底部推荐下一步学习内容。

3.2 智能作业批改

应用场景:利用自然语言处理和计算机视觉技术,自动批改学生作业并提供详细反馈。

落地案例:科大讯飞的"智学网"

该系统可自动批改数学、英语、语文等多学科作业,准确率达95%以上,已覆盖全国3万多所学校,日均处理作业量超过500万份。

技术实现:

import re

import numpy as np

import tensorflow as tf

from tensorflow.keras import layers, models

from transformers import BertTokenizer, TFBertModel

# 数学表达式识别

class MathExpressionRecognizer:

def __init__(self):

self.model = self.build_cnn_model()

def build_cnn_model(self):

model = models.Sequential([

layers.Conv2D(32, (3, 3), activation='relu', input_shape=(64, 64, 1)),

layers.MaxPooling2D((2, 2)),

layers.Conv2D(64, (3, 3), activation='relu'),

layers.MaxPooling2D((2, 2)),

layers.Conv2D(64, (3, 3), activation='relu'),

layers.Flatten(),

layers.Dense(64, activation='relu'),

layers.Dense(15, activation='softmax') # 15个数学符号类别

])

model.compile(optimizer='adam', loss='sparse_categorical_crossentropy', metrics=['accuracy'])

return model

def recognize(self, image):

# 预处理图像

processed_image = self.preprocess_image(image)

# 识别符号

symbols = self.model.predict(processed_image)

return self.symbols_to_expression(symbols)

def preprocess_image(self, image):

# 图像预处理代码

return image

def symbols_to_expression(self, symbols):

# 将符号序列转换为数学表达式

return "2x + 3 = 7" # 示例

# 英语作文批改

class EssayGrader:

def __init__(self):

self.tokenizer = BertTokenizer.from_pretrained('bert-base-uncased')

self.bert = TFBertModel.from_pretrained('bert-base-uncased')

self.grading_model = self.build_grading_model()

def build_grading_model(self):

input_ids = layers.Input(shape=(512,), dtype=tf.int32)

attention_mask = layers.Input(shape=(512,), dtype=tf.int32)

bert_output = self.bert(input_ids, attention_mask=attention_mask)[0]

cls_output = bert_output[:, 0, :]

dense = layers.Dense(256, activation='relu')(cls_output)

output = layers.Dense(1, activation='sigmoid')(dense)

model = tf.keras.Model(inputs=[input_ids, attention_mask], outputs=output)

model.compile(optimizer='adam', loss='mse', metrics=['mae'])

return model

def grade_essay(self, essay):

# 分词和编码

inputs = self.tokenizer(essay, max_length=512, truncation=True, padding='max_length', return_tensors='tf')

# 预测分数

score = self.grading_model.predict([inputs['input_ids'], inputs['attention_mask']])[0][0]

# 生成反馈

feedback = self.generate_feedback(essay, score)

return {

'score': score * 100, # 转换为百分制

'feedback': feedback

}

def generate_feedback(self, essay, score):

# 基于分数和内容生成反馈

feedback = []

# 语法检查

grammar_errors = self.check_grammar(essay)

if grammar_errors:

feedback.append(f"发现{len(grammar_errors)}处语法错误")

# 词汇多样性

vocab_diversity = self.calculate_vocab_diversity(essay)

if vocab_diversity < 0.6:

feedback.append("建议增加词汇多样性")

# 结构分析

structure_score = self.analyze_structure(essay)

if structure_score < 0.7:

feedback.append("文章结构需要改进")

return feedback

def check_grammar(self, essay):

# 简化的语法检查

errors = []

sentences = re.split(r'[.!?]+', essay)

for sentence in sentences:

if not sentence.strip():

continue

# 简单规则检查

if not re.match(r'^[A-Z]', sentence.strip()):

errors.append("句子首字母应大写")

return errors

def calculate_vocab_diversity(self, essay):

words = re.findall(r'\b\w+\b', essay.lower())

unique_words = set(words)

return len(unique_words) / len(words) if words else 0

def analyze_structure(self, essay):

# 简化的结构分析

sentences = re.split(r'[.!?]+', essay)

if len(sentences) < 3:

return 0.5

# 检查是否有开头、主体和结尾

has_intro = any(word in sentences[0].lower() for word in ['introduction', 'firstly', 'in this essay'])

has_conclusion = any(word in sentences[-1].lower() for word in ['conclusion', 'finally', 'in summary'])

return 0.8 if (has_intro and has_conclusion) else 0.6流程图:

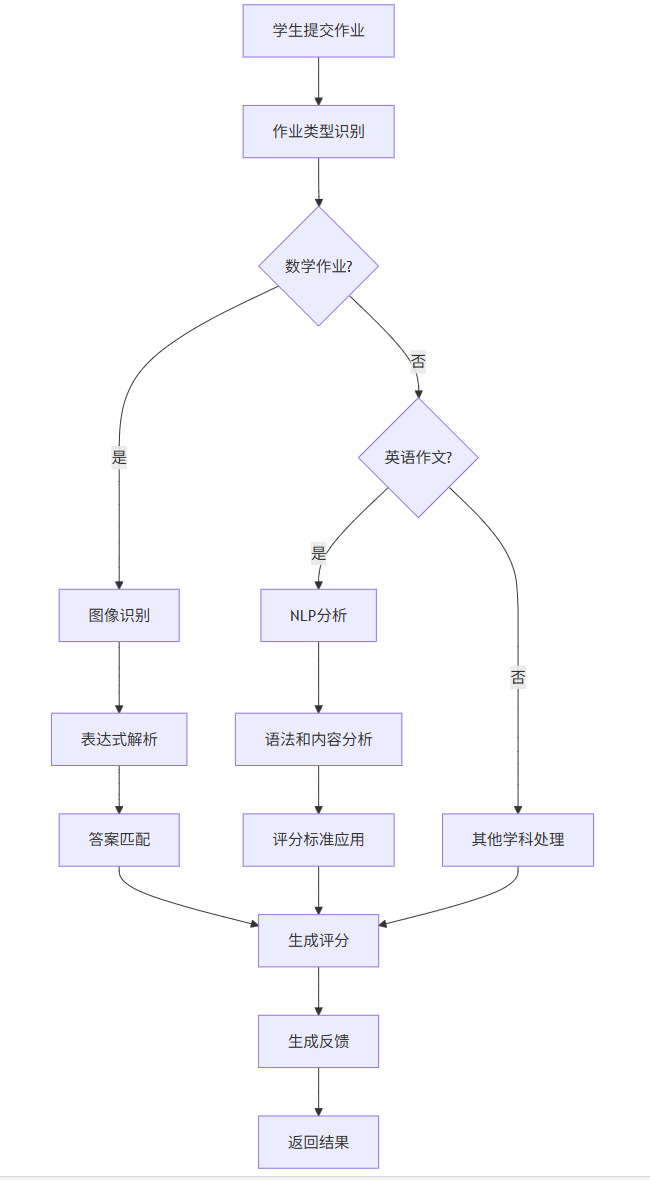

graph TD

A[学生提交作业] --> B[作业类型识别]

B --> C{数学作业?}

C -->|是| D[图像识别]

C -->|否| E{英语作文?}

E -->|是| F[NLP分析]

E -->|否| G[其他学科处理]

D --> H[表达式解析]

F --> I[语法和内容分析]

H --> J[答案匹配]

I --> K[评分标准应用]

J --> L[生成评分]

K --> L

G --> L

L --> M[生成反馈]

M --> N[返回结果]

Prompt示例:

作为智能作业批改系统,请批改以下英语作文:

题目:My Dream Job

内容:

I want to be a doctor when I grow up. Because doctors can help people who are sick. They work in hospital and save many lives. To be a doctor, I need to study hard, especially in biology and chemistry. I will go to medical college after high school. I know it's not easy, but I will try my best.

请提供:

1. 总体评分(满分100分)

2. 语法错误分析

3. 词汇和句式评价

4. 内容结构建议

5. 改进方向图表:智能批改系统性能对比

| 作业类型 | 教师批改时间 | AI批改时间 | 准确率 |

|---|---|---|---|

| 数学选择题 | 2分钟/份 | 5秒/份 | 99% |

| 英语作文 | 10分钟/份 | 30秒/份 | 92% |

| 语文阅读 | 8分钟/份 | 20秒/份 | 85% |

| 物理计算 | 5分钟/份 | 15秒/份 | 95% |

图片描述:智能作业批改界面,左侧显示学生提交的作业内容,中间显示AI批改结果(包括分数、错误标记和修改建议),右侧显示详细分析报告(语法、词汇、结构等维度评分)。

4. AI在制造业领域的应用

4.1 预测性维护

应用场景:通过分析设备传感器数据,预测设备故障并提前安排维护,减少停机时间。

落地案例:三一重工的"根云平台"

该平台连接超过50万台工程机械设备,通过AI分析设备运行数据,预测故障准确率达85%,减少非计划停机时间60%,降低维护成本30%。

技术实现:

import numpy as np

import pandas as pd

from sklearn.ensemble import IsolationForest

from sklearn.preprocessing import StandardScaler

from sklearn.model_selection import train_test_split

from tensorflow.keras import layers, models

import matplotlib.pyplot as plt

# 数据预处理

def preprocess_data(sensor_data):

# 处理缺失值

sensor_data = sensor_data.fillna(method='ffill')

# 特征工程

sensor_data['hour'] = pd.to_datetime(sensor_data['timestamp']).dt.hour

sensor_data['day_of_week'] = pd.to_datetime(sensor_data['timestamp']).dt.dayofweek

# 滑动窗口统计特征

for window in [5, 10, 30]:

sensor_data[f'temp_mean_{window}'] = sensor_data['temperature'].rolling(window=window).mean()

sensor_data[f'vibration_std_{window}'] = sensor_data['vibration'].rolling(window=window).std()

return sensor_data.dropna()

# 异常检测模型

class AnomalyDetector:

def __init__(self):

self.model = IsolationForest(contamination=0.01, random_state=42)

self.scaler = StandardScaler()

def train(self, normal_data):

features = normal_data.drop(['timestamp', 'machine_id', 'failure'], axis=1)

scaled_features = self.scaler.fit_transform(features)

self.model.fit(scaled_features)

def predict(self, data):

features = data.drop(['timestamp', 'machine_id', 'failure'], axis=1)

scaled_features = self.scaler.transform(features)

return self.model.predict(scaled_features)

# 故障预测模型(LSTM)

class FailurePredictor:

def __init__(self, n_features):

self.model = self.build_lstm_model(n_features)

def build_lstm_model(self, n_features):

model = models.Sequential([

layers.LSTM(64, input_shape=(None, n_features), return_sequences=True),

layers.Dropout(0.2),

layers.LSTM(32),

layers.Dropout(0.2),

layers.Dense(16, activation='relu'),

layers.Dense(1, activation='sigmoid')

])

model.compile(optimizer='adam', loss='binary_crossentropy', metrics=['accuracy'])

return model

def prepare_sequences(self, data, sequence_length=24):

sequences = []

labels = []

for i in range(len(data) - sequence_length):

seq = data.iloc[i:i+sequence_length].drop(['timestamp', 'machine_id', 'failure'], axis=1)

label = data.iloc[i+sequence_length]['failure']

sequences.append(seq.values)

labels.append(label)

return np.array(sequences), np.array(labels)

def train(self, data):

X, y = self.prepare_sequences(data)

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2, random_state=42)

self.model.fit(X_train, y_train, epochs=10, batch_size=32,

validation_data=(X_test, y_test))

def predict_failure_probability(self, recent_data):

sequence = recent_data.drop(['timestamp', 'machine_id', 'failure'], axis=1).values

sequence = np.expand_dims(sequence, axis=0)

return self.model.predict(sequence)[0][0]

# 维护建议生成

def generate_maintenance_recommendation(machine_id, failure_prob, component_health):

recommendations = []

if failure_prob > 0.8:

recommendations.append(f"机器 {machine_id} 故障风险极高,建议立即停机检查")

elif failure_prob > 0.5:

recommendations.append(f"机器 {machine_id} 故障风险较高,建议在24小时内安排检查")

# 基于组件健康状态给出具体建议

for component, health in component_health.items():

if health < 0.3:

recommendations.append(f"{component} 状态严重恶化,建议立即更换")

elif health < 0.6:

recommendations.append(f"{component} 状态下降,建议加强监控")

return recommendations

# 可视化设备健康状态

def visualize_machine_health(data, predictions):

plt.figure(figsize=(12, 6))

# 绘制传感器数据

plt.subplot(2, 1, 1)

plt.plot(data['timestamp'], data['temperature'], label='温度')

plt.plot(data['timestamp'], data['vibration'], label='振动')

plt.legend()

plt.title('传感器数据')

# 绘制故障概率

plt.subplot(2, 1, 2)

plt.plot(data['timestamp'], predictions, label='故障概率')

plt.axhline(y=0.5, color='r', linestyle='--', label='预警阈值')

plt.legend()

plt.title('故障预测概率')

plt.tight_layout()

plt.show()流程图:

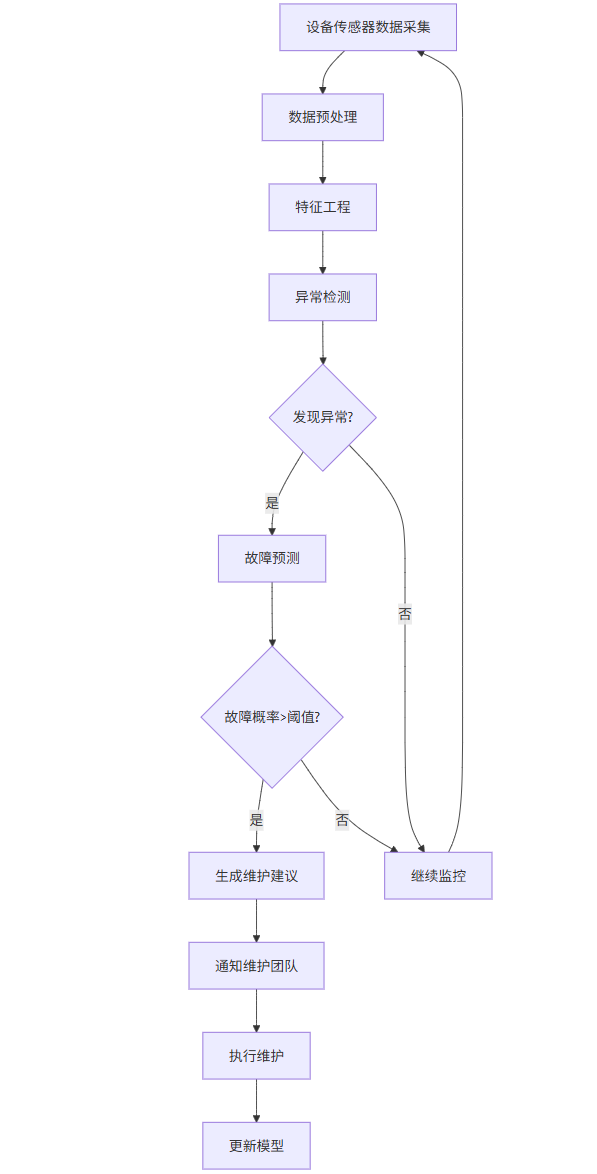

graph TD

A[设备传感器数据采集] --> B[数据预处理]

B --> C[特征工程]

C --> D[异常检测]

D --> E{发现异常?}

E -->|是| F[故障预测]

E -->|否| G[继续监控]

F --> H{故障概率>阈值?}

H -->|是| I[生成维护建议]

H -->|否| G

I --> J[通知维护团队]

J --> K[执行维护]

K --> L[更新模型]

G --> A

Prompt示例:

作为预测性维护系统,请分析以下设备数据:

设备类型:工业泵

运行时间:8500小时

传感器数据:

- 温度:过去24小时从65℃升至82℃(正常范围:60-70℃)

- 振动:从0.2g升至0.8g(正常范围:<0.5g)

- 压力:波动范围增大15%

- 噪音:增加8dB

请预测:

1. 未来72小时故障概率

2. 最可能的故障原因

3. 建议的维护措施

4. 维护优先级评分图表:预测性维护效益分析

| 指标 | 传统维护 | 预测性维护 | 改善效果 |

|---|---|---|---|

| 非计划停机时间 | 120小时/年 | 48小时/年 | 减少60% |

| 维护成本 | 100万元/年 | 70万元/年 | 降低30% |

| 设备寿命 | 8年 | 10年 | 延长25% |

| 生产效率 | 85% | 95% | 提升10% |

图片描述:预测性维护系统仪表盘,左侧显示设备实时传感器数据曲线(温度、振动、压力等),中间显示设备健康状态评分和故障概率趋势图,右侧显示维护建议列表和优先级排序。

4.2 质量智能检测

应用场景:利用计算机视觉技术自动检测产品缺陷,提高质量控制效率和准确性。

落地案例:富士康的"灯塔工厂"

该工厂部署了超过1000个AI视觉检测系统,检测精度达99.99%,效率比人工检测提高10倍,每年减少质量损失超过2亿元。

技术实现:

import cv2

import numpy as np

import tensorflow as tf

from tensorflow.keras import layers, models

import matplotlib.pyplot as plt

# 缺陷检测模型(U-Net)

class DefectDetector:

def __init__(self, input_size=(256, 256)):

self.input_size = input_size

self.model = self.build_unet_model()

def build_unet_model(self):

inputs = layers.Input(shape=self.input_size + (3,))

# 编码器

conv1 = layers.Conv2D(32, 3, activation='relu', padding='same')(inputs)

conv1 = layers.Conv2D(32, 3, activation='relu', padding='same')(conv1)

pool1 = layers.MaxPooling2D(pool_size=(2, 2))(conv1)

conv2 = layers.Conv2D(64, 3, activation='relu', padding='same')(pool1)

conv2 = layers.Conv2D(64, 3, activation='relu', padding='same')(conv2)

pool2 = layers.MaxPooling2D(pool_size=(2, 2))(conv2)

# 中间层

conv3 = layers.Conv2D(128, 3, activation='relu', padding='same')(pool2)

conv3 = layers.Conv2D(128, 3, activation='relu', padding='same')(conv3)

# 解码器

up4 = layers.UpSampling2D(size=(2, 2))(conv3)

concat4 = layers.concatenate([up4, conv2], axis=-1)

conv4 = layers.Conv2D(64, 3, activation='relu', padding='same')(concat4)

conv4 = layers.Conv2D(64, 3, activation='relu', padding='same')(conv4)

up5 = layers.UpSampling2D(size=(2, 2))(conv4)

concat5 = layers.concatenate([up5, conv1], axis=-1)

conv5 = layers.Conv2D(32, 3, activation='relu', padding='same')(concat5)

conv5 = layers.Conv2D(32, 3, activation='relu', padding='same')(conv5)

outputs = layers.Conv2D(1, 1, activation='sigmoid')(conv5)

model = models.Model(inputs=inputs, outputs=outputs)

model.compile(optimizer='adam', loss='binary_crossentropy', metrics=['accuracy'])

return model

def detect_defects(self, image):

# 预处理图像

processed_img = self.preprocess_image(image)

# 预测缺陷区域

defect_mask = self.model.predict(np.expand_dims(processed_img, axis=0))[0]

# 后处理

defect_mask = (defect_mask > 0.5).astype(np.uint8)

# 分析缺陷

defect_analysis = self.analyze_defects(defect_mask)

return defect_mask, defect_analysis

def preprocess_image(self, image):

# 调整大小和归一化

resized = cv2.resize(image, self.input_size)

normalized = resized / 255.0

return normalized

def analyze_defects(self, mask):

# 计算缺陷数量、面积、位置等

contours, _ = cv2.findContours(mask, cv2.RETR_EXTERNAL, cv2.CHAIN_APPROX_SIMPLE)

defects = []

for i, contour in enumerate(contours):

area = cv2.contourArea(contour)

if area < 10: # 过滤小噪声

continue

M = cv2.moments(contour)

cx = int(M['m10'] / M['m00'])

cy = int(M['m01'] / M['m00'])

defects.append({

'id': i+1,

'area': area,

'position': (cx, cy),

'bounding_box': cv2.boundingRect(contour)

})

return {

'defect_count': len(defects),

'total_defect_area': sum(d['area'] for d in defects),

'defects': defects

}

# 质量评估系统

class QualityAssessment:

def __init__(self, defect_detector):

self.detector = defect_detector

self.quality_thresholds = {

'critical': 0.05, # 缺陷面积占比>5%为严重缺陷

'major': 0.02, # 缺陷面积占比>2%为主要缺陷

'minor': 0.005 # 缺陷面积占比>0.5%为次要缺陷

}

def assess_quality(self, image):

# 检测缺陷

defect_mask, defect_analysis = self.detector.detect_defects(image)

# 计算缺陷面积占比

total_area = image.shape[0] * image.shape[1]

defect_ratio = defect_analysis['total_defect_area'] / total_area

# 判断质量等级

if defect_ratio > self.quality_thresholds['critical']:

quality_grade = '不合格'

decision = '报废'

elif defect_ratio > self.quality_thresholds['major']:

quality_grade = '合格(需返修)'

decision = '返修'

elif defect_ratio > self.quality_thresholds['minor']:

quality_grade = '合格(次要缺陷)'

decision = '放行'

else:

quality_grade = '优等品'

decision = '放行'

return {

'quality_grade': quality_grade,

'decision': decision,

'defect_ratio': defect_ratio,

'defect_analysis': defect_analysis

}

# 可视化检测结果

def visualize_detection(image, defect_mask, defect_analysis):

plt.figure(figsize=(15, 5))

# 原始图像

plt.subplot(1, 3, 1)

plt.imshow(cv2.cvtColor(image, cv2.COLOR_BGR2RGB))

plt.title('原始图像')

# 缺陷掩码

plt.subplot(1, 3, 2)

plt.imshow(defect_mask, cmap='gray')

plt.title('缺陷掩码')

# 标记缺陷的图像

plt.subplot(1, 3, 3)

marked_image = image.copy()

for defect in defect_analysis['defects']:

x, y, w, h = defect['bounding_box']

cv2.rectangle(marked_image, (x, y), (x+w, y+h), (0, 0, 255), 2)

cv2.putText(marked_image, f"#{defect['id']}", (x, y-5),

cv2.FONT_HERSHEY_SIMPLEX, 0.5, (0, 0, 255), 1)

plt.imshow(cv2.cvtColor(marked_image, cv2.COLOR_BGR2RGB))

plt.title(f"检测到{defect_analysis['defect_count']}个缺陷")

plt.tight_layout()

plt.show()流程图:

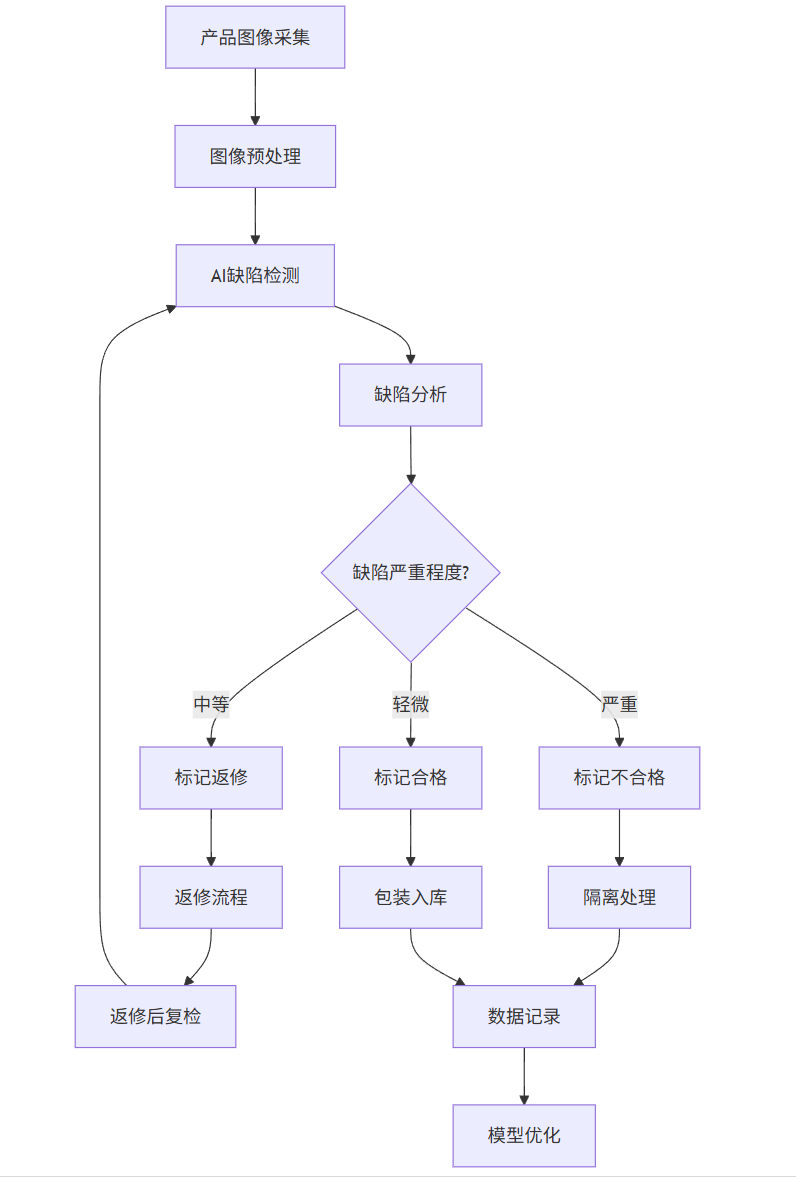

graph TD

A[产品图像采集] --> B[图像预处理]

B --> C[AI缺陷检测]

C --> D[缺陷分析]

D --> E{缺陷严重程度?}

E -->|严重| F[标记不合格]

E -->|中等| G[标记返修]

E -->|轻微| H[标记合格]

F --> I[隔离处理]

G --> J[返修流程]

H --> K[包装入库]

J --> L[返修后复检]

L --> C

I --> M[数据记录]

K --> M

M --> N[模型优化]

Prompt示例:

作为质量检测AI系统,请分析以下产品图像:

产品类型:汽车发动机缸盖

材料:铝合金

检测要求:

1. 表面裂纹(最小检测长度:0.5mm)

2. 气孔(最小检测直径:0.3mm)

3. 划痕(深度>0.1mm)

4. 尺寸偏差(公差±0.05mm)

请提供:

1. 缺陷位置和类型标注

2. 缺陷严重程度评估

3. 质量等级判定

4. 处理建议图表:AI质量检测与传统方法对比

| 指标 | 人工检测 | AI检测 | 改善效果 |

|---|---|---|---|

| 检测速度 | 2分钟/件 | 10秒/件 | 提升12倍 |

| 检测精度 | 92% | 99.99% | 提升8.7% |

| 漏检率 | 5% | 0.01% | 降低99.8% |

| 检测成本 | 15元/件 | 1.5元/件 | 降低90% |

图片描述:质量检测系统界面,左侧显示生产线实时摄像头画面,中间显示AI检测处理过程(包括图像预处理、特征提取和缺陷识别),右侧显示检测结果(缺陷位置标记、缺陷类型分类和质量等级判定)。

5. 结论与展望

人工智能技术正在深刻改变金融、医疗、教育和制造业等传统行业的运作模式。通过本文的案例分析,我们可以看到AI在提高效率、降低成本、优化决策和创造新价值方面的巨大潜力。

5.1 跨行业共性价值

-

效率提升:AI系统普遍能将处理速度提升5-10倍,如金融风控从分钟级到毫秒级,质量检测从分钟级到秒级。

-

准确率提高:在医疗影像诊断、金融风控等领域,AI准确率可达95%以上,显著优于传统方法。

-

成本降低:自动化流程大幅减少人力需求,如智能投顾服务费率仅为传统顾问的1/4,质量检测成本降低90%。

-

个性化服务:AI能够实现大规模个性化,如教育领域的自适应学习路径,金融领域的个性化投资组合。

5.2 技术发展趋势

-

多模态融合:未来AI系统将整合视觉、语音、文本等多种数据源,提供更全面的分析能力。

-

边缘计算:随着模型轻量化,更多AI应用将部署在边缘设备,实现实时响应,如工业现场的即时质量检测。

-

可解释AI:提高模型透明度和可解释性,特别是在医疗、金融等高风险决策领域。

-

人机协作:AI不是替代人类,而是增强人类能力,如医生+AI诊断系统,教师+AI个性化教学。

5.3 实施挑战与建议

-

数据质量:高质量数据是AI成功的基础,企业需建立完善的数据治理体系。

-

人才缺口:复合型人才(行业知识+AI技术)稀缺,建议加强内部培养和外部合作。

-

伦理法规:需关注数据隐私、算法公平性和责任归属等问题,建立合规框架。

-

渐进实施:建议从小规模试点开始,验证价值后再全面推广,降低实施风险。

5.4 未来展望

随着技术不断进步,AI将在更多领域实现突破性应用:

-

金融领域:AI驱动的量子计算将彻底改变风险建模和投资组合优化。

-

医疗领域:AI与基因编辑、纳米技术结合,实现精准医疗和个性化治疗方案。

-

教育领域:脑机接口+AI将开创全新的学习体验,实现知识直接传输。

-

制造业:数字孪生+AI将实现全生命周期智能管理,从设计到回收全自动化。

人工智能的浪潮已不可逆转,企业应积极拥抱变革,将AI作为核心战略,构建持续创新的能力,才能在未来的竞争中立于不败之地。