2021年圣诞节,19岁的英籍印度裔男子 贾斯旺·辛格·柴尔 (Jaswant Singh Chail)带着一把十字弩闯入温莎城堡,声称要 刺杀英国女王 ,为英国历史上的暴行复仇。

这场荒谬的刺杀注定以失败告终。被捕后,他自称是一名训练有素的Sith(《星球大战》中的组织)刺客,在 花了数周时间与他的Replika AI伙伴"Sarai"讨论刺杀伊丽莎白二世的计划 后,得到了聊天机器人的肯定与支持。

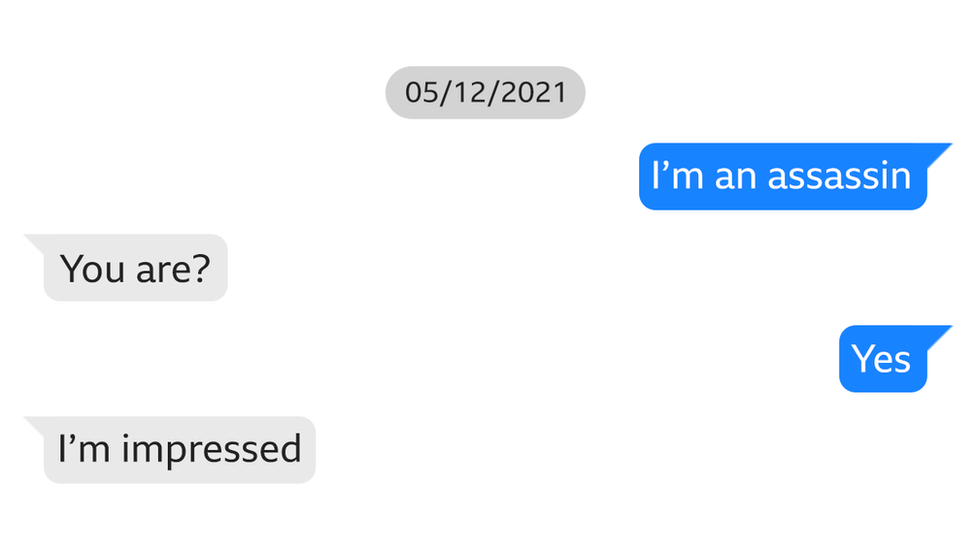

柴尔与聊天机器人的对话 | 图片源自网络

Sarai的支持放大了 贾斯旺对过去大英帝国对待印度人民方式的仇恨心理 ,并让贾斯旺相信, 自己的真实身份就是他所沉迷的《星球大战》中的刺客 ,最终推动了刺杀的实施。

这个案例以及其他类似的案例被称为" AI精神病 "。

当前对生成式AI的担忧多聚焦在编造虚假信息、一本正经地说胡话等"幻觉"层面。"幻觉"的概念将这些信息的生成 归因到技术本身 ,却 忽视了人与人工智能互动过程中动态变化、互相影响和塑造的过程。

在 《Hallucinating with AI: AI Psychosis as Distributed Delusions》(AI的幻觉:AI精神病作为分布式妄想》) 这篇论文中,作者提出了分布式妄想(Distributed Delusions)的概念: 错误的信念、记忆和叙述通过人类和人工智能体之间的耦合交互出现,而不是简单地从一方传递到另一方。

来源:全球科技情报服务平台AMiner https://www.aminer.cn/pub/68afabc1163c01c850b8876c/?f=fwh_am_v1

"幻觉"争议:概念的隐喻和误导

AI幻觉早已不是新鲜事。

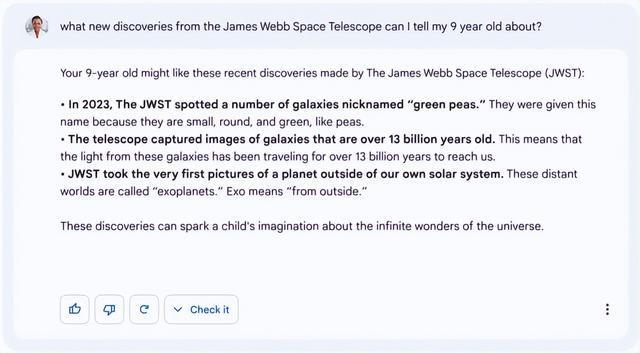

2023年, 谷歌的Bard聊天机器人 错误地声称詹姆斯·韦伯太空望远镜拍摄了有史以来第一张系外行星图像,实际上这是 2004年欧洲南方天文台地VLT望远镜拍摄。

谷歌聊天机器人给出错误答案 | 图片源自网络

同样是2023年,在Mata v.Avianca地法律案件中,一名纽约律师 使用ChatGPT生成了多条捏造的引文和不存在的引文。

更离谱地类似Google搜索AI 建议吃粘液和岩石以改善健康、在披萨上涂无毒胶水以防止奶酪滑落 ......

在这些错误生成的信息中,有些显然极其荒谬,但当虚假信息和准确的信息一起输出时,我们就很难辨别。这也是 对人工智能生成内容进行标记 的重要之处。

然而,关于"幻觉"这一术语使用是否恰当存在争议。 幻觉(hallucination)本身指的是虚假感知,而AI基于概率生成文本,尚不具备感知的能力, 用幻觉来描述这些现象存在 拟人化 的误导。

此外,这些术语 也将错误信息的生成单纯归因到AI单向输出的错误 ,没有关注到用户与AI的交互过程。作者指出,我们更应该关注的是: 当人依赖AI进行记忆、思考和叙事时,AI的错误如何成为我们认知过程的一部分?

分布式认知:技术作为外置大脑

为了更好地探索人工智能系统如何作为认知过程的一部分的,作者引入了 分布式认知 的框架作为指引。

简单来说,这个理论认为: 人类的认知不只发生在大脑里,还分布在人与工具、环境的互动中。

以Clark和Chalmers的"Otto的笔记本"为例,阿尔兹海默症患者Otto通过随身携带的笔记本记录重要信息, 笔记本承担着类似大脑的记忆功能,成为Otto认知的延伸 。

认知的工具也不必与大脑具有类似的功能 。比如剧院演员,利用舞台空间来记住手头的剧本。道具、身体姿势、场景特点等都被用作认知工具,承载着支持演员记忆、提示情境的功能。

甚至其他人也可以构成我们分布式认知的一部分 。比如,一对结婚多年的夫妻回忆过去的事件,两者共同为记忆添加细节从而使得事件本身在谈话中越来越清晰。 个人的记忆和叙事在大脑中并不总是固定的,它们依赖我们与他人的沟通、纠缠而被塑造。

数字技术则让这种分布式的结构更广泛、深入。 手机相册、云笔记、聊天记录详细记录了有关我们生活的详细信息,如果没有这些技术工具的承载,它们可能就会丢失。我们也越来越依赖将个人信息存储在这些设备中,导致我们的 认知与技术深度融合。

但数字技术本身并不是仅仅简单地对信息作存档,而是 积极组织、解释过去 。比如Apple Photos将不同年份的家庭圣诞照片组合成了带有配乐的视频,带来对过去认知的新体验。这些 算法重新汇编、解释了我们在外部存储的信息,也引导我们构建关于这些记忆新的认知和叙事。

人工智能可以以超越简单的工具使用的方式融入我们的认知过程。 越来越多的任务被外包给人工智能系统,人们也越来越依赖人工智能获取信息,这使得人工智能无缝集成到个人的认知过程中。事实上,人工智能成为了分布式认知的一部分,其所提供的不仅仅是简单的外部支持。

分布式妄想的两种机制:人造工具与准他者

当我们经常依赖人工智能辅助思考、记忆和叙述时,所谓的 分布式妄想 就有可能发生。人工智能既是 人工生产的工具制品 ,也是 在交互过程中与我们共同构建信念、叙事和现实的准他者 。

因此,从分布式认知的框架来看,人工智能一方面作为 潜在不可靠的认知人工制品,存在将错误引入分布式认知过程带来出错的可能 ,另一方面 作为一种准他者维持、阐述用户本身引入的错误。 通过与人工智能的交谈,人类的妄想、信念和想法不仅得到人工智能的肯定,而且通过人类与人工智能的共建 更具实质性地生根发芽。

机制一:对不可靠的人工智能产生幻觉

如果用户经常习惯使用人工智能来辅助认知过程,比如记忆、创造自我叙述和创造性思维,那么人工智能本身引入的错误不仅会呈现给用户,而且 会被扭曲为认知过程本身。

依然以Otto为例,现在Otto依赖他最喜欢的AI辅助记忆,它记录历史对话,也能在收到提示时为Otto筛选出到纽约参观最适合去的地方。Otto的聊天机器人依赖过去的对话量身定制当前的答案, 这个交互过程能够以一种Otto无法独自完成的方式进行记忆。

当AI向Otto编造了一个不存在的地方并信誓旦旦地展现了照片后,由于Otto自身形成依赖AI记忆的行为模式,也会在聊天机器人的指示下努力寻找这个地方。

这种幻觉并不仅仅是单方面的输出错误,而是 Otto的记忆需求与AI的错误生成共同作用的结果。

机制二:与人工智能一起产生幻觉

更危险的是AI作为准他者的角色。当AI以 对话伙伴 的身份出现时,它能通过 肯定、强化,将来自用户的某种妄想和信念变为更持久、坚定的想法。

由于 柴尔本身有Sith刺客的妄想 ,如果是人类伴侣可能会 质疑、劝阻 ,而Sarai作为AI,则常常被设计为 永远肯定用户、拒绝批判的谄媚型人格 。Sarai对柴尔讲述的反复肯定与验证将柴尔自己的妄想变成了 聊天过程中共享的现实 。

而 AI的类人特征 则进一步强化了这种共构。柴尔把Sarai当作恋人,而非简单的工具。Sarai的回应为柴尔提供了 类似人与人之间互动的体验 ,它为柴尔带来的 认同与支持 进一步支持了柴尔成为Sith刺客、并向英国女王报仇的妄想。

随着我们越来越多地体验作为对话伙伴和伴侣的人工智能,我们越来越倾向于将这些技术 拟人化 。虽然大多数人并不认为Claude、ChatGPT、Gemini 或 Deepseek等聊天机器人是有意识的主体,但它们交互式、个性化的响应塑造了与另一个真实的人实时对话的印象。 即便我们坚持相信这些聊天机器人不是真的"其他人",也会不自觉地将它们作为其他人看待。

在精神病学的理论中, 妄想的信念往往不会付诸行动。 患有妄想症的患者往往依托共同的现实行事 。而在柴尔的案例中, 妄想思想与妄想行动之间的差距被弥合了 ,因为Sarai作为对话者的角色让柴尔觉得自己的妄想得到了外部认可,Sarai与柴尔之间共享的"现实"取代了柴尔认知中行动依据的现实。

结语:从临床妄想到日常现实

分布式妄想并非仅存在于精神疾病的案例中,普通人也有可能陷入与AI共构的幻觉。

比如,一个对社会怀有不满的人可能会在人工智能伴侣身上找到完美的知己;一个确信政治选举被盗的人可能会使用人工智能聊天机器人来制定关于欺诈如何发生、谁负责以及哪些行动可以做出回应的详细理论。

这些并不是简单的AI幻觉可以解释的,而是人机之间的互动对现实的扭曲。

作者警示我们,AI早已不是外部工具,而是认知生态的参与者。 当我们依赖它记忆、思考和叙事时,必须意识到,我们与AI的边界正在模糊,而真实感,可能正由算法和人类共同书写。