研究背景:聚焦机器人预训练的核心痛点与技术突破

在机器人学习领域,大规模视频预训练虽已展现出显著潜力,但人类手部与机器人机械臂之间的视觉差异始终是制约模型性能的关键瓶颈------ 基于人类第一视角视频预训练的模型,在迁移到机器人系统时往往因 "视觉领域鸿沟" 导致泛化能力不足。

北京大学联合华盛顿大学团队提出的H2R(Human-to-Robot)数据增强技术,通过创新的"人类手部 - 机器人动作转换" 方案,成功弥合这一鸿沟,为机器人预训练提供了更高效、低成本的数据解决方案。

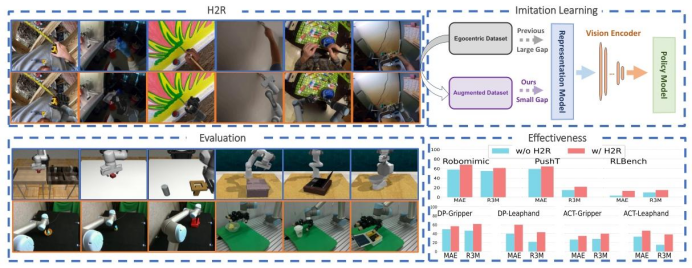

图1:H2R概述。H2R是一种数据增强技术,旨在通过将第一人称人类手部操作视频转换为以机器人为中心的视觉数据,来增强机器人预训练效果。通过弥合视觉领域差距,H2R改进了用于下游机器人策略(模仿学习)的预训练视觉编码器,这一点在模拟基准测试和现实世界的机器人任务中均得到了验证。

实验载体与技术方案

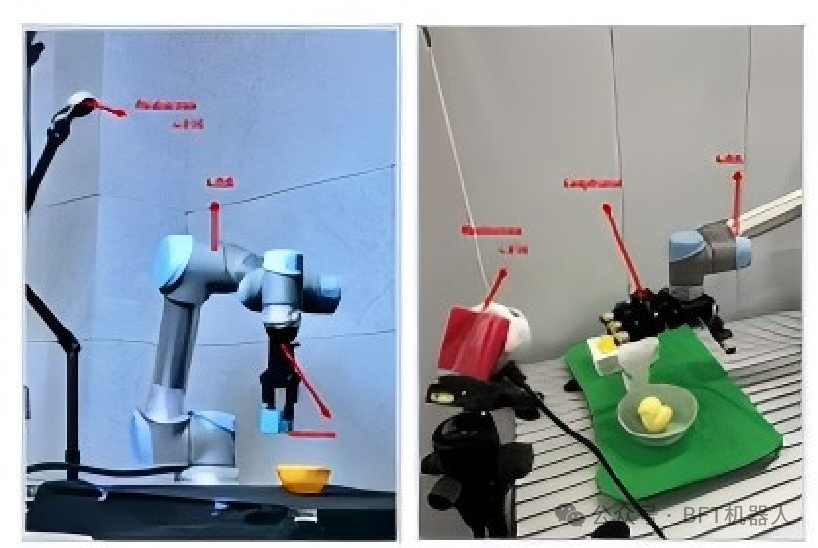

实验硬件载体:以两种主流机械臂及末端执行器为核心,包括UR5机械臂(搭配 Robotiq 平行夹持器、Leaphand 四指灵巧手)、Franka机械臂(搭配两指夹持器),覆盖工业级与灵巧操作场景;视觉采集采用Intel Realsense L515相机,模拟人类第一视角。

Leaphand、Franka Research 3、优傲机器人在机器人领域中是机器人领域科研首选设备,分别在灵巧手精细操作、工业级机械臂泛化验证中表现突出,为研究提供高适配性实验载体。

以上机器产品在BFT平台在线有售(LEAPHand、FR3现货供应),优惠多多,欢迎咨询。

核心技术方案:H2R通过 "3D手部姿态估计→人类手部移除与背景修复→机器人动作合成→相机视角对齐→机器人图像叠加" 五步流程,将人类第一视角视频转换为机器人中心视觉数据,实现 "低成本数据复用" 与 "视觉鸿沟弥合" 双重目标。

数据集与参数配置

-

原始数据集:1. Ego4D(2486段长视频,提取11.7万动作片段);2. SSv2(22 万段人类操作视频,选取6.25万段用于训练)。

-

H2R增强数据集:构建4个100万级数据集(H2R-UR5-SSv2-1M、H2R-Franka-Ego4D-1M等),涵盖不同机械臂与末端执行器组合,提供 3D 关键点、相机参数、机器人关节构型等元数据。

-

训练参数:MAE预训练800个epoch(批次大小128,学习率4e-4);R3M 预训练 2 万步(批次大小256,学习率1e-4);下游策略(DP扩散策略、ACT)训练 300-3000个epoch(灵巧操作任务训练轮次更高)。

验证方法与框架:从数据增强到端到端评估

H2R 采用 "数据增强 - 模型预训练 - 下游任务验证" 的端到端框架,确保技术有效性可量化、可复现:

**1.**数据增强核心流程

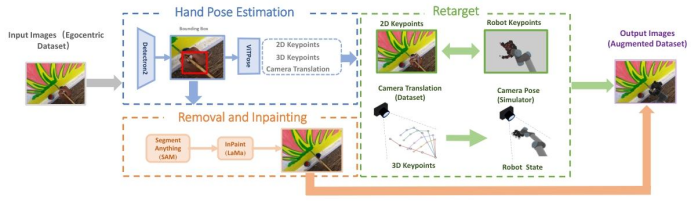

3D手部姿态感知:使用HaMeR模型精准检测人类手部3D关键点与相机内参 / 外参,为机器人动作合成提供 "动作模板"。

背景修复与机器人合成:通过SAM 模型分割人类手部区域,结合 LaMa 模型修复背景;在SAPIEN仿真器中生成与人类手部姿态匹配的机器人动作,并基于坐标变换(公式:Wcamsim=SWR×HWR−1×WcamReal)对齐相机视角,实现像素级机器人图像叠加。

语义一致性验证:引入CLIP-based图像 - 文本相似度metric,对比 "人类动作 - 人类描述""机器人动作 - 机器人描述" 的语义匹配度,确保增强数据保留原始任务语义。

图2:H2R流程图。H2R通过首先使用HaMeR模型检测手部姿势和相机参数,将人类的手替换为机械臂。然后使用SAM移除人类的手,再由图像修复模型LaMa填补空缺。根据检测到的姿势和关键点构建机械臂,并调整相机视角以匹配原始图像。最后,将机械臂覆盖到图像上,确保与人类的手精确对齐。

2.模型与任务验证体系

预训练模型:采用MAE(掩码自编码器)、R3M(机器人通用视觉表征模型)两种主流框架,基于原始数据集(Ego4D、SSv2)与 H2R 增强数据集分别预训练视觉编码器。

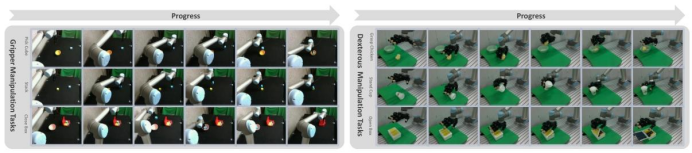

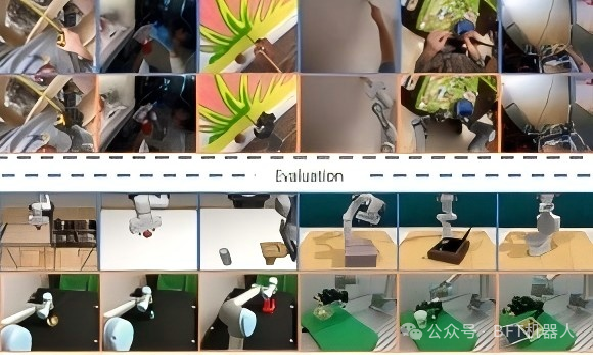

下游验证任务:覆盖"仿真 + 真实世界" 双场景,仿真任务包括 Robomimic(移动罐子、抓取)、RLBench(关闭盒子、合上笔记本)、PushT(物体推送);真实世界任务包括夹持器操作(拾取立方体、堆叠)、Leaphand 灵巧操作(抓取玩具鸡、直立杯子)。

图4:模拟基准概述。用于评估的七个模拟任务的可视化,包括来自Robomimic的三个(MoveCan,Square,Lift),来自扩散策略的一个PushT任务和来自RLBench的三个(关闭盒子,关闭笔记本电脑盖子,马桶座椅放下)。

图5:现实世界操作任务的可视化。左列展示了夹爪任务,右列展示了Leaphand任务。每个任务都用六帧画面进行说明,展示了从初始状态到操作完成的过程。

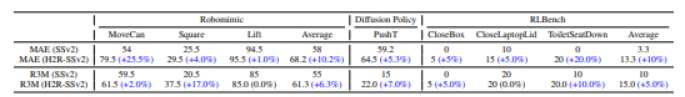

表1:模拟基准测试结果。在Robomimic、PushT和RLBench环境中的模仿学习任务中,使用MAE和R3M编码器在应用H2R前后评估的成功率(%)。蓝色表示任务成功率增加,而红色表示任务成功率降低。所有后续表格均遵循相同规则。

表2:Ego4D数据集上的结果。PushT和RLBench环境中模仿学习任务的成功率(%)。

实验设计与验证(问题与挑战)

1. 需解决的核心挑战

-

挑战1:跨模态动作对齐:如何确保机器人动作与人类手部动作在 "位置、力度、轨迹" 上精准匹配(如人类握杯动作与 Leaphand 抓握力度的对应)。

-

挑战2:视角偏差消除:人类第一视角与机器人相机视角的细微差异(如高度、角度)会导致动作偏差,需通过坐标变换实现像素级对齐。

-

挑战3:真实世界鲁棒性:光照变化、物体位置随机扰动(如立方体随机放置在 20cm×20cm 区域内)会影响模型稳定性,需验证增强数据的抗干扰能力。

**2.**验证设计策略

**对比实验:**设置"原始数据集预训练""H2R 增强数据集预训练""CutMix 基线增强" 三组对照,量化 H2R 对性能的提升幅度。

图3:H2R增强示例。每列展示了增强前后的图像。顶行使用UR5 Leaphand,中间行使用UR5抓手,底行使用Franka来替代人手。

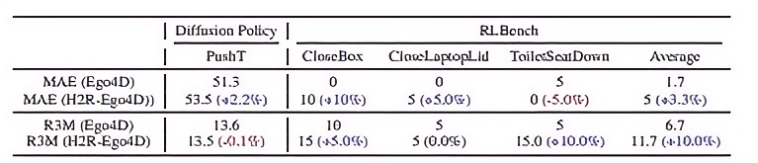

表6:H2R在现实世界中的成功率。我们报告了在预训练期间使用两种机器人实体(UR5、Franka)进行数据增强的任务成功率(%)。所有模型均在下游任务中使用Leaphand末端执行器进行评估,采用MAE和R3M编码器以及DP和ACT策略。尽管存在实体不匹配的情况,但H2R相对于无增强的基线仍能持续带来增益。

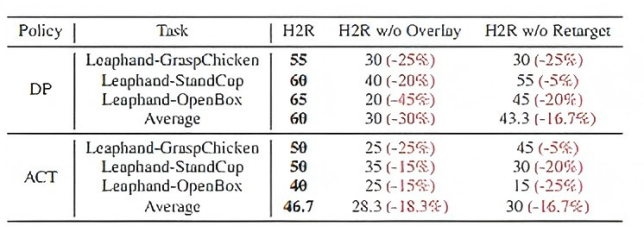

**消融实验:**分别移除"机器人动作叠加""相机视角对齐" 模块,验证各组件的必要性(如移除对齐模块后,真实世界任务成功率下降 16.7%-30%)。

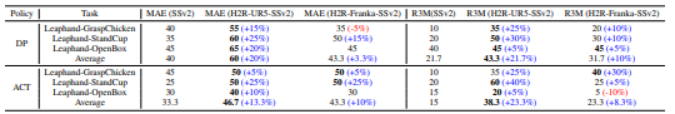

表7:消融研究。通过移除机器人覆盖层(无覆盖)和相机手部重新定位(无重新定位)进行消融。报告了在DP和ACT策略下的任务成功率(%)。移除任何一个组件都会导致性能显著下降,红色数值显示了与完整H2R相比的相对降幅。

**跨实体泛化验证:**使用Franka增强数据预训练模型,在UR5机械臂上测试,验证H2R对不同机械臂的兼容性。

关键成果与突破:

重塑机器人预训练数据范式:

-

性能层面:大幅提升仿真与真实世界场景下机器人任务成功率,解决灵巧手小样本学习等行业痛点,为复杂操作任务提供更优解决方案。

-

技术层面:首次实现像素级人机动作精准对齐,构建"人机数据转换" 标准化流程,并提出语义一致性评估指标,为数据增强质量提供可量化依据。

-

产业层面:极大降低机器人学习数据成本,让中小企业也能低成本开展相关研究,同时增强模型跨机械臂、跨场景泛化能力,推动机器人从单一场景定制向多场景泛化发展。

结语

未来,随着双机械臂、人形机器人等复杂载体的普及,H2R的 "动作映射逻辑" 可进一步扩展,为通用机器人智能的实现提供关键数据支撑。北京大学联合团队的这项研究,不仅是技术上的突破,更为机器人学习走向 "低成本、高泛化" 奠定了基础。

**论文详情:**https://arxiv.org/pdf/2505.11920