目录

[3.Self-supervised learning扩展](#3.Self-supervised learning扩展)

摘要

本篇文章继续学习李宏毅老师2025春季机器学习课程,学习内容是self-supervised learning GPT系列相关概念及self-supervised learning的其他应用

Abstract

1.GPT

self-supervised learning除了BERT,还有GPT系列。BERT做的事情是填空题,GPT做的是预测接下来要出现的token是什么。而GPT的模型架构有点像transformer的decoder。

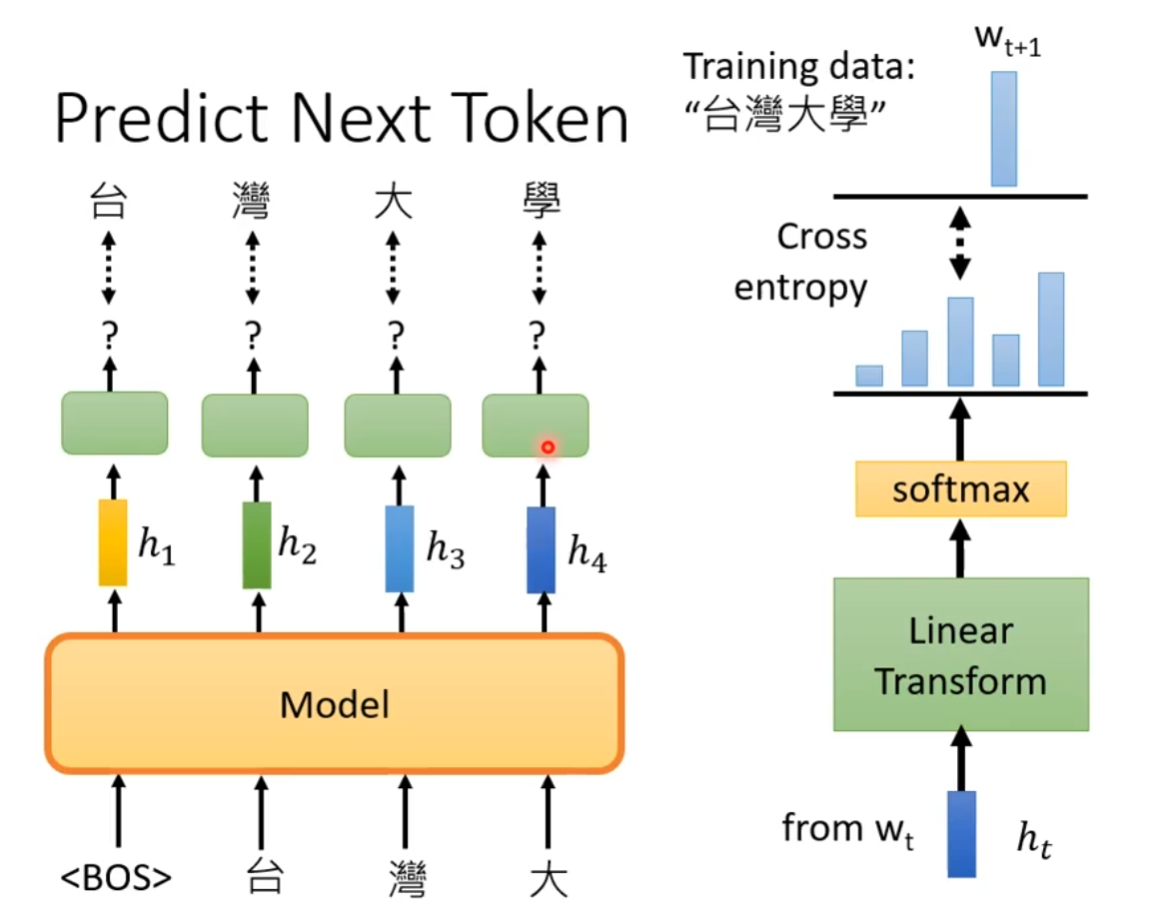

假设训练资料中有一个句子是"台湾大学",GPT在begin之后,输出一个embedding,接下来根据embbedding去预测下一个token是什么。例如begin之后应该输出"台",在输入begin,"台"之后输出"湾"等以此类推。在右侧图中,embedding用h表示,通过Linear Transform,再经过一个softmax,得到一个distribution,然后希望与正确答案的cross entropy越小越好。

2.如何使用GPT

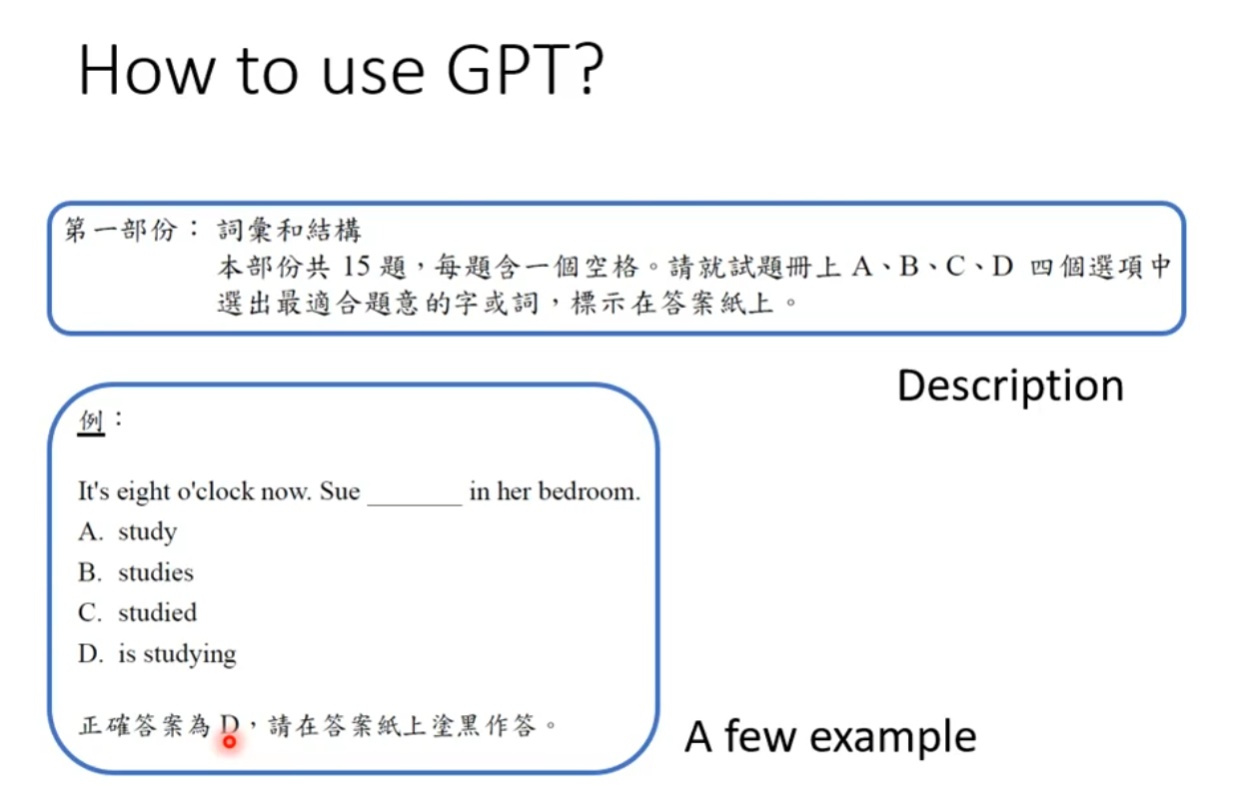

举一个例子,GPT如何用在QA问题上,GPT的想法跟BERT不一样。普通要做听力题,首先会有描述部分,然后会给出一个例子说明。

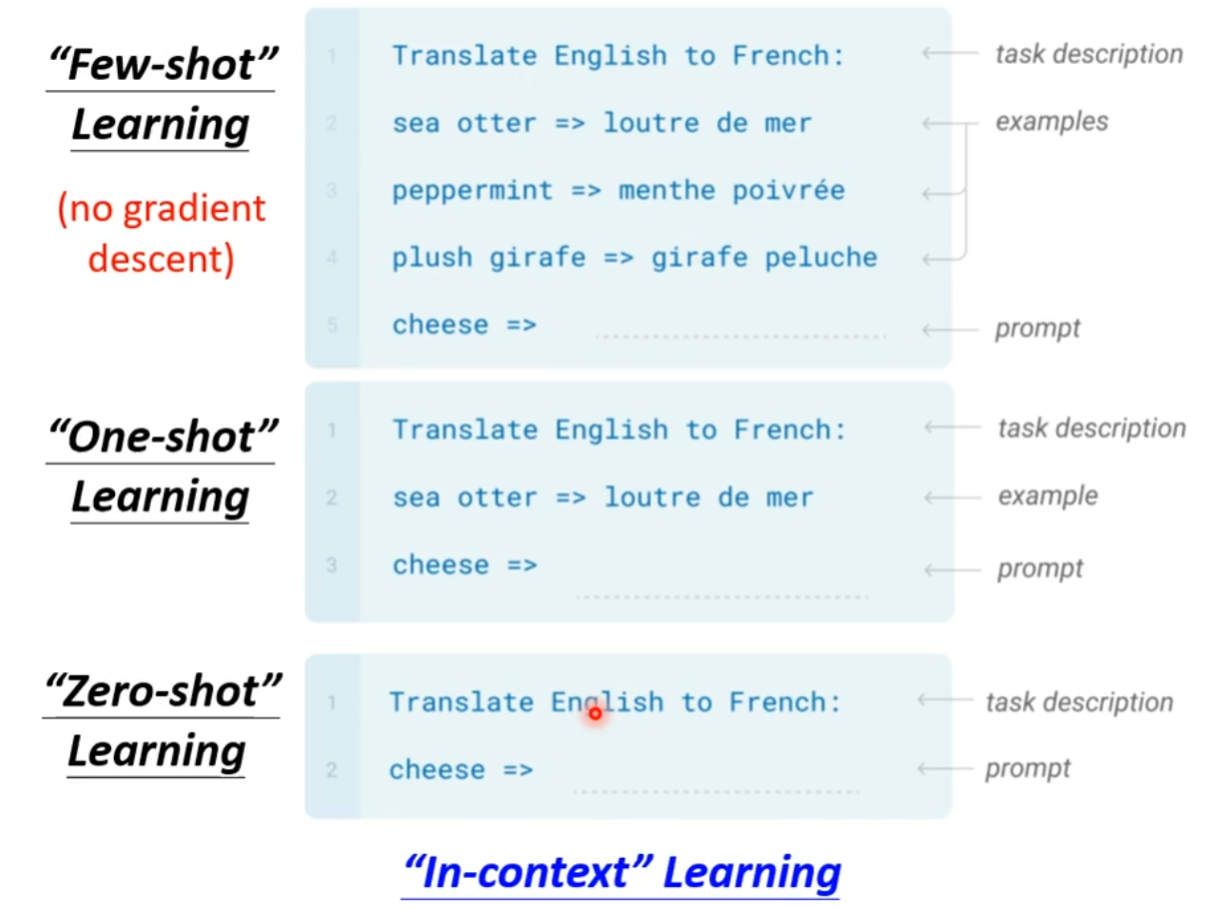

假设GPT需要做翻译,我们首先会有任务描述部分,对应上面正常做听力的例子,然后给出几个范例,接下来就可以让GPT补完,实际在训练时,GPT并没有学到如何做翻译。这个叫做few-shot learning,给出一点例子进行训练,但是不同于普通的few-shot learning,这里面完全没有gradient descent。因此,给出了一个特殊的名字叫做in-context learning。甚至于有一个例子(one-shot learning),或者没有例子(zero0-shot learning)。

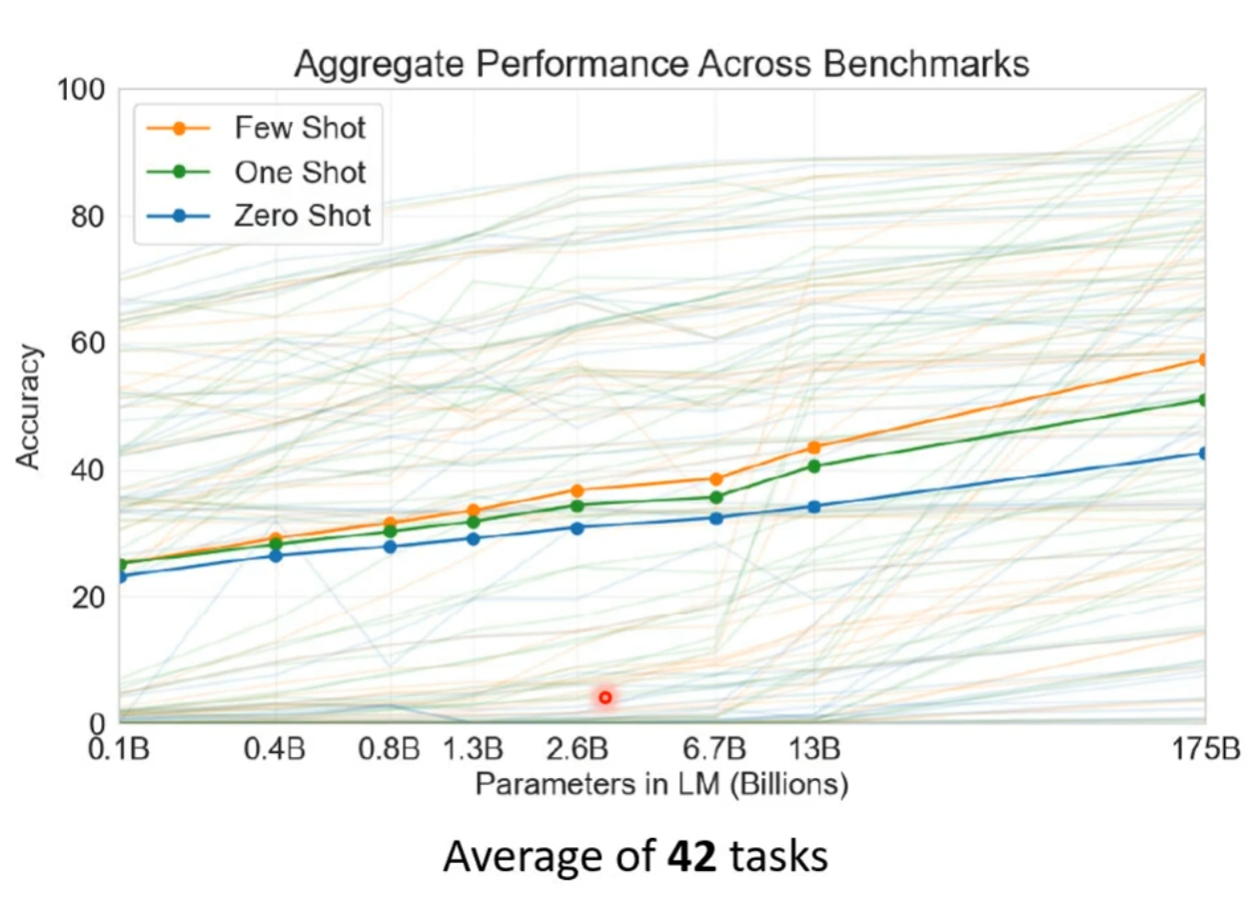

在实验中,他们正确率有点低,实验测试了42个任务,纵轴为正确率,横轴代表模型大小。随着模型不断变大,正确率也能打到50%左右。但是有些任务可能怎么学都学不会,例如逻辑推理相关的任务。

3.Self-supervised learning扩展

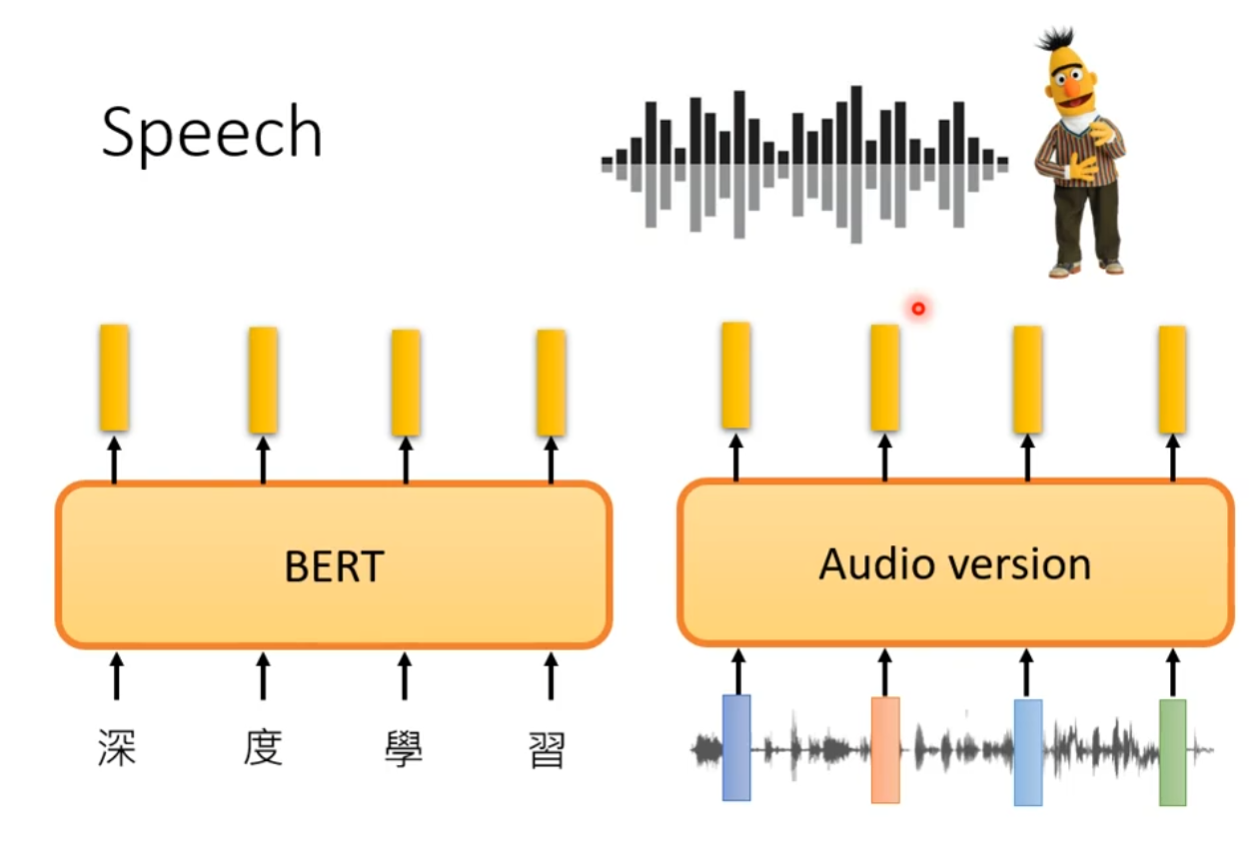

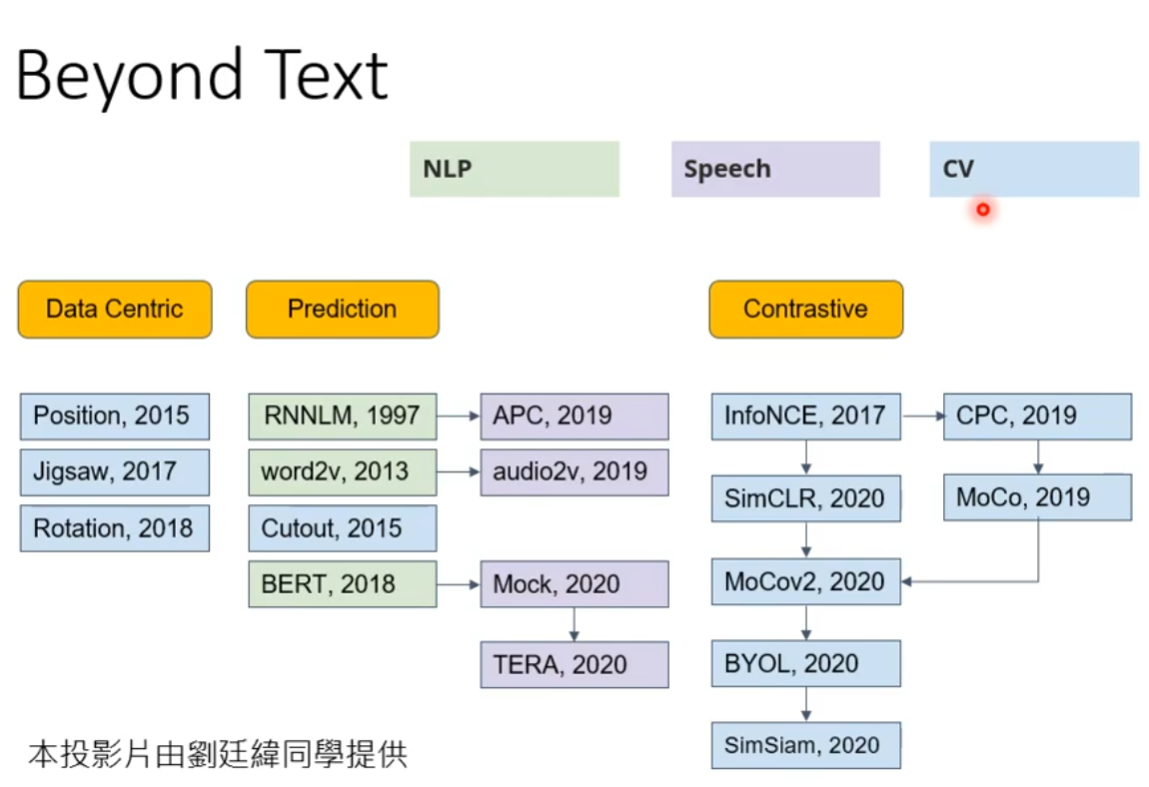

目前为止,所学习的Self-supervised learning技术都是用在文字上,实际上Self-supervised learning也可以用在语音,影像的应用上也都可以用Self-supervised learning技术。目前的Self-supervised learning的技术非常多,我们所学的BERT和GPT系列都只是Prediction类型的其中一种,还有很多其他类型。

在语音上如何使用BERT?那么我们回想文字的BERT如何训练------讲其中一些文字盖住,那么语音也是同样盖住一些部分,语音也可以预测接下来会出现的内容。