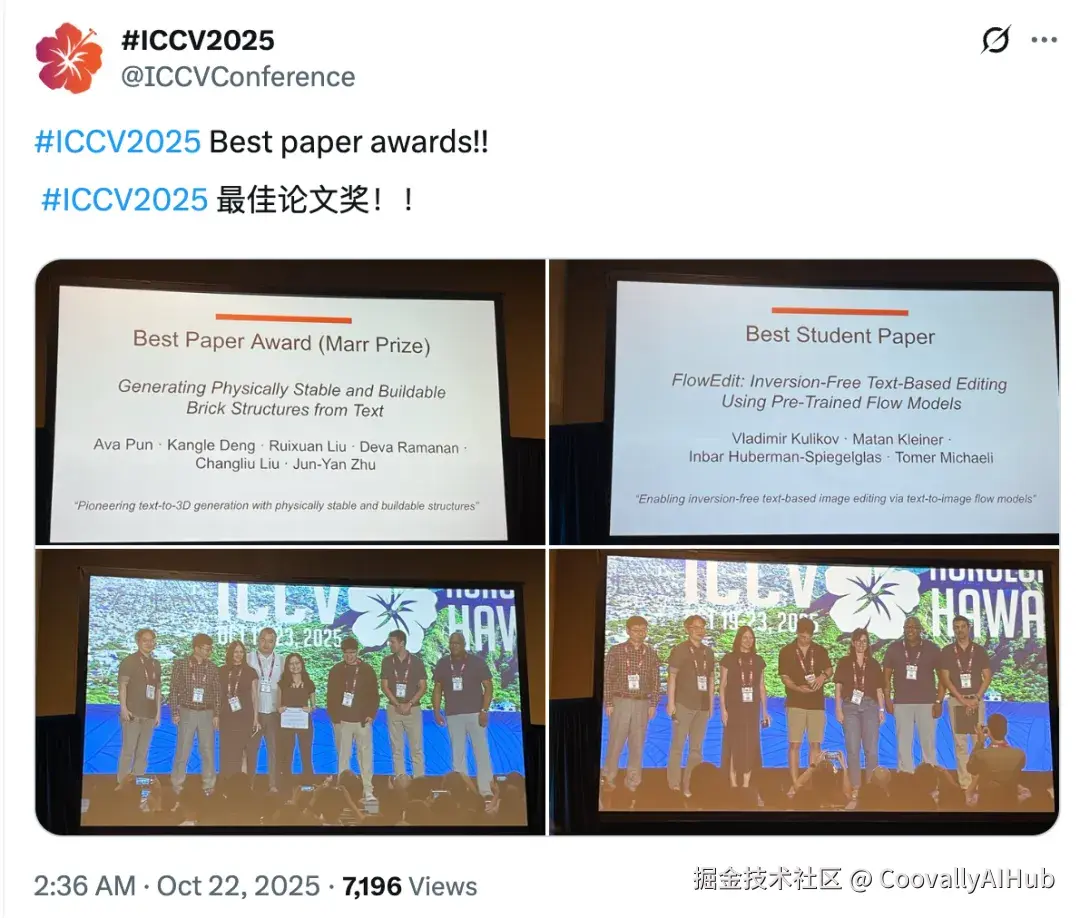

今天凌晨,在夏威夷举行的国际计算机视觉大会ICCV 2025揭晓了本届会议的最佳论文等奖项。全球计算机视觉三大顶会之一的ICCV今年共收到11239份有效投稿,最终录用2699篇论文,录用率为24%。

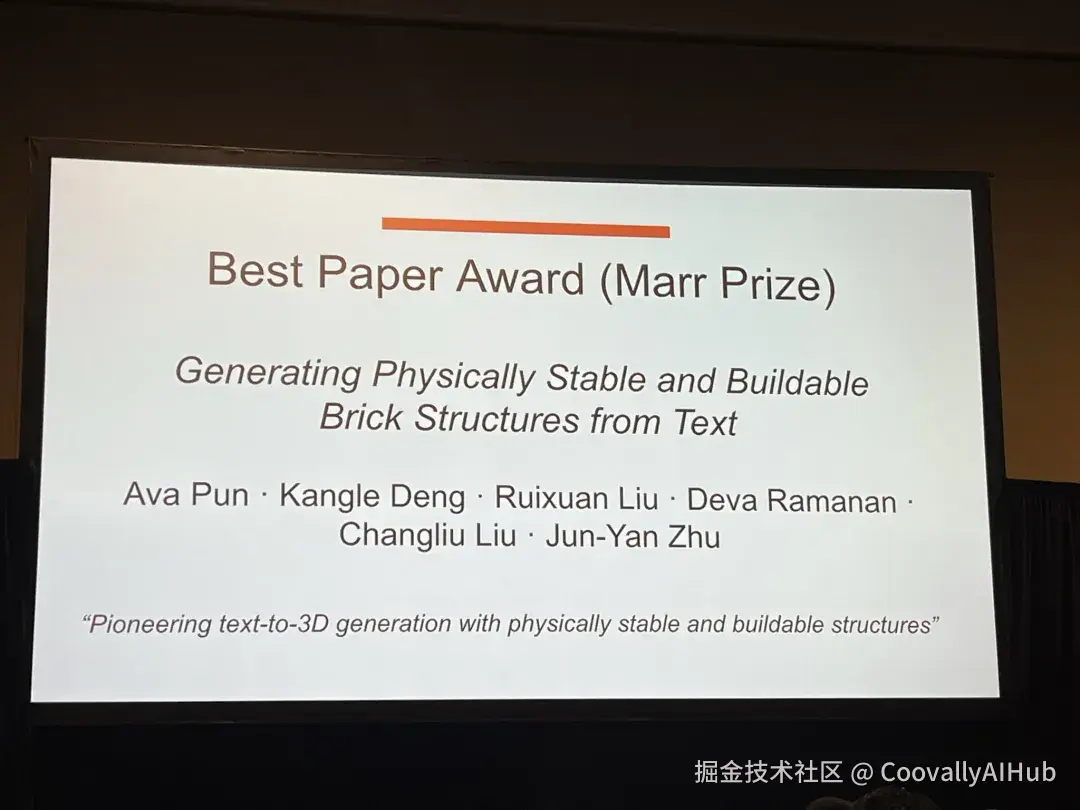

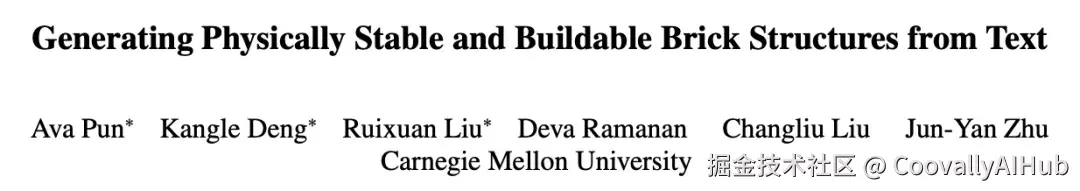

来自卡耐基梅隆大学的团队凭借论文 《Generating Physically Stable and Buildable Brick Structures from Text》 斩获最佳论文奖,而以色列理工学院的研究则获得最佳学生论文奖。

最佳论文:从文本到可建造的积木结构

当今生成式AI在3D内容创作领域蓬勃发展,但大多数生成模型只关注外观,却忽略了物理世界的约束。这些数字模型可能看起来很精美,但往往结构不稳定,或组件之间存在冲突,无法在现实世界中实际组装。

朱俊彦团队的研究漂亮地解决了这一问题。他们提出了BrickGPT------首个能够根据文本提示生成物理稳定、可实际搭建的积木结构的AI系统。

BrickGPT要解决的,就是这个长期被忽略的"现实可行性"问题。它的目标是:生成既好看、又能拼、还能稳的积木结构。

论文第一作者Ava Pun在其个人主页写道: "我希望回答一个问题:如何让AI不仅在我们的计算机上有用,而且在物理世界中也有用?" BrickGPT正是这一理念的完美体现。

作者团队

- 朱俊彦(Jun-Yan Zhu): CMU 助理教授,清华校友,前 Adobe 研究科学家。

- 合作者: Ava Pun、Kangle Deng、Ruixuan Liu、Deva Ramanan、Changliu Liu。

- 项目主页: avalovelace1.github.io/BrickGPT/

- 代码开源(1.3K⭐): GitHub - AvaLovelace1/BrickGPT

方法创新:给LLM加入"物理直觉"

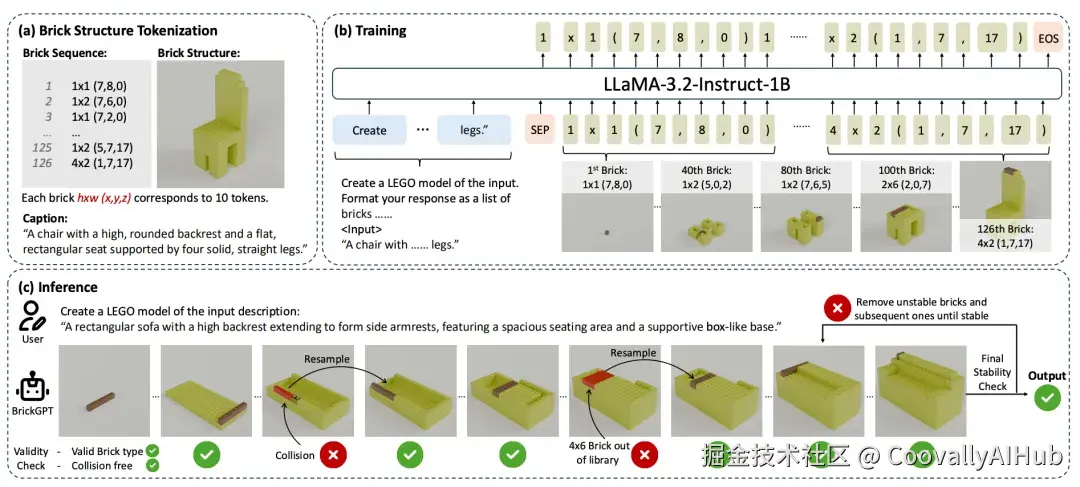

BrickGPT 的核心是基于 LLaMA-3.2-Instruct-1B 微调的大语言模型。

研究者巧妙地把"搭积木"的任务转化为"预测下一块砖"的语言生成问题。

整个流程分三步:

- 积木文本化:

每块积木被编码为类似 "4x2 (1,7,17)" 的 token,整个结构就是一串"积木语言"。

- 指令微调:

模型学习"描述 → 积木序列"的对应关系,就像"语言版蓝图"。

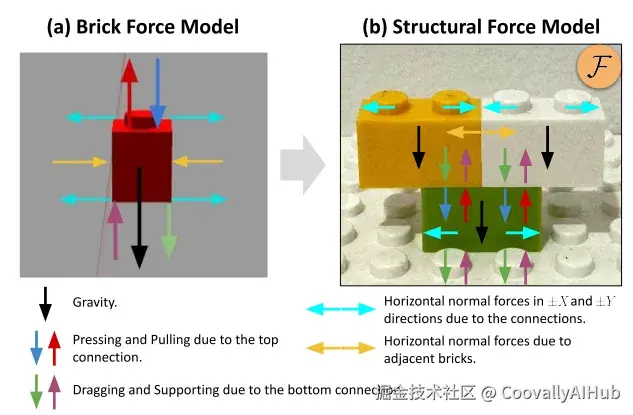

- 物理约束生成:

- 拒绝采样(Rejection Sampling):每放一块砖都检查是否合法。

- 物理感知回滚(Physics-aware Rollback):若整体结构不稳定,自动退回至上一个稳定状态重新生成。

这一机制相当于在AI的生成过程中,嵌入了"工程师思维"。

StableText2Brick:给AI准备的"积木教材"

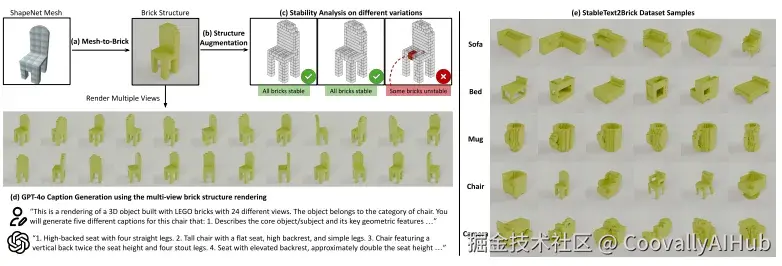

为了让AI学会搭积木,研究团队构建了一个超大规模数据集------StableText2Brick。

- 数据量: 超过 47,000 个积木结构

- 覆盖对象: 28,000+ 种独特3D物体

- 每个样本都附带: 稳定结构 + 文本描述 + 多角度视图

构建过程包含四步:

- 从3D网格到积木(Mesh-to-Brick): 把连续网格模型体素化为离散积木。

- 结构增强: 随机扰动积木排列,生成多样结构。

- 物理模拟: 剔除会倒塌的不稳定设计。

- 文本生成: 用 GPT-4o 为每个结构生成自然语言描述。

这让模型拥有了"图文并茂"的搭建教材,具备从描述到结构的学习能力。

实验结果:近乎完美的稳定性

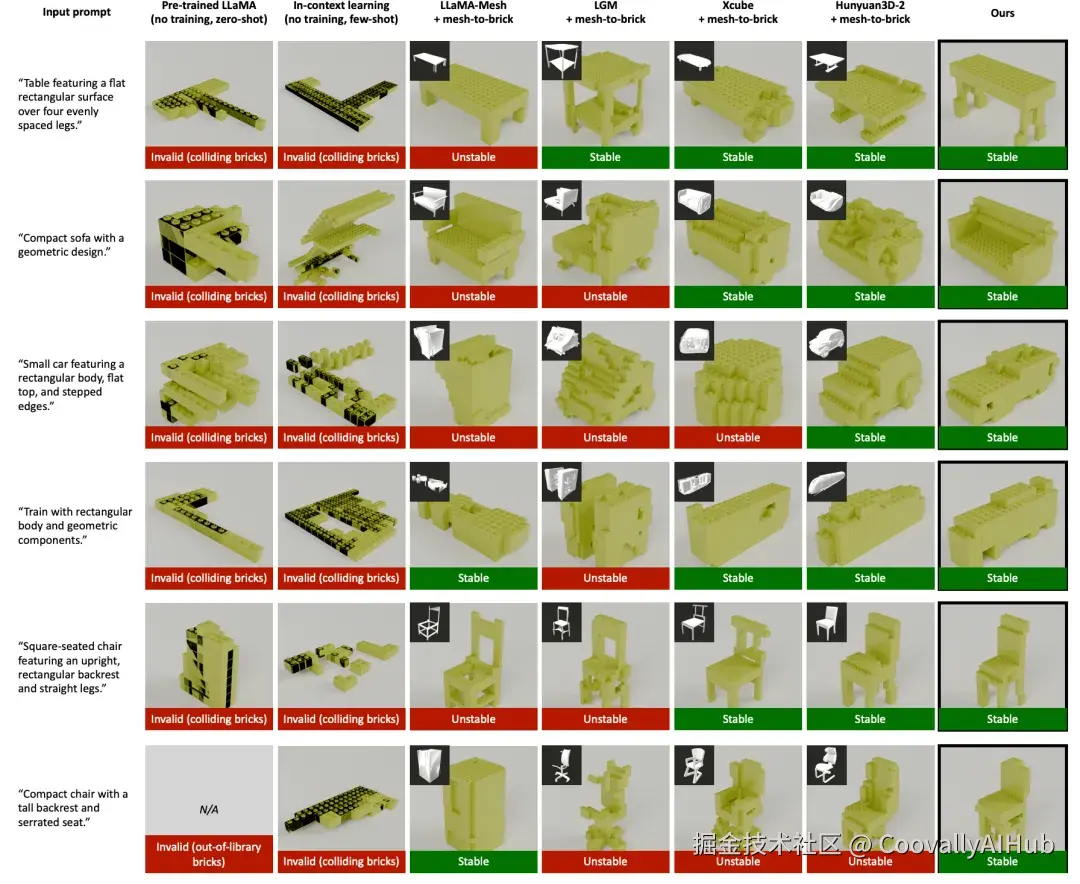

实验结果表明,BrickGPT在关键指标上表现卓越:

- 有效性(无违规积木或碰撞): 100%

- 稳定性(物理结构稳定): 98.8%

远超基线模型,同时保持较高的文本相似度。

从对比结果中可以直观看出:

其他方法生成的结构常有碰撞(黑色区域)或悬浮问题,而BrickGPT生成的积木既稳定又合理。

它还能根据描述自动生成带颜色与纹理的版本,兼顾创意与实用。

更重要的是------这些结构不仅能被人类拼搭,甚至还能让机械臂自动组装!

其他重要奖项

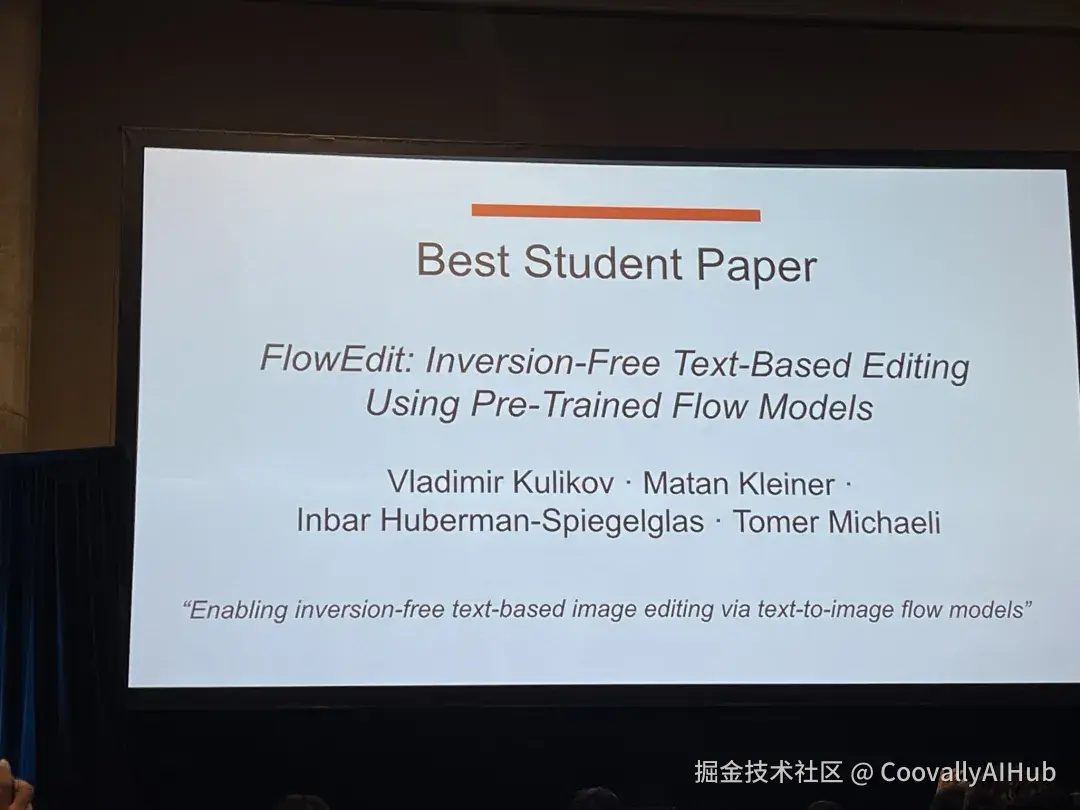

- 最佳学生论文

以色列理工学院的 《FlowEdit: Inversion-Free Text-Based Editing Using Pre-Trained Flow Models》 提出了一种无需反演的文本驱动图像编辑方法。

传统方法需要将图像反演到噪声空间,而FlowEdit通过构建常微分方程,直接在源图像分布与目标图像分布间建立映射路径,实现了更高效的编辑。

项目主页:matankleiner.github.io/flowedit/

Code&Data:github.com/fallenshock...

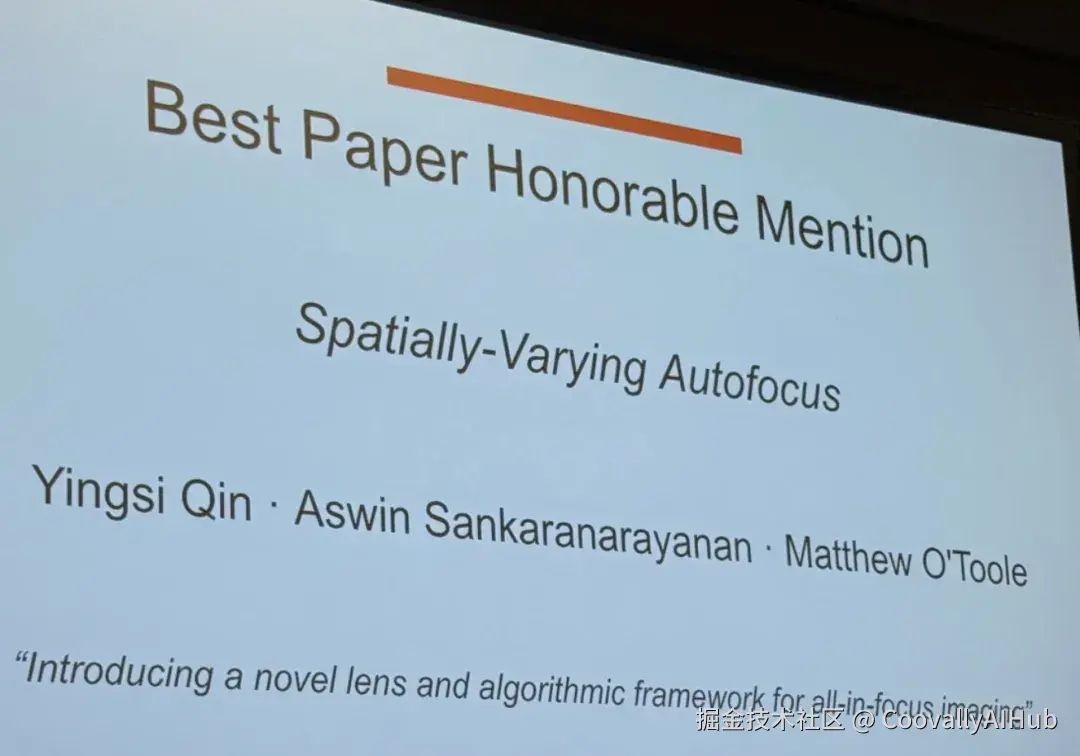

- 最佳论文荣誉提名

卡耐基梅隆大学的《Spatially-Varying Autofocus》打破了传统镜头只能单一平面清晰成像的限制,设计了一种能够任意调整景深的计算镜头,可同时使整个场景清晰成像。

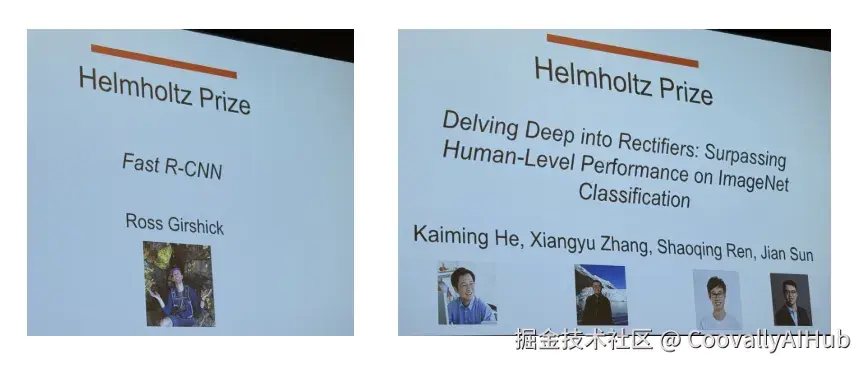

- 赫尔姆霍兹奖(测试方法奖)

两篇获奖论文均来自微软研究院:

《Fast R-CNN》:提出快速区域卷积网络,显著提升目标检测速度与精度

《Delving Deep into Rectifiers》:引入PReLU激活函数和He初始化方法,首次在ImageNet上超越人类水平分类性能

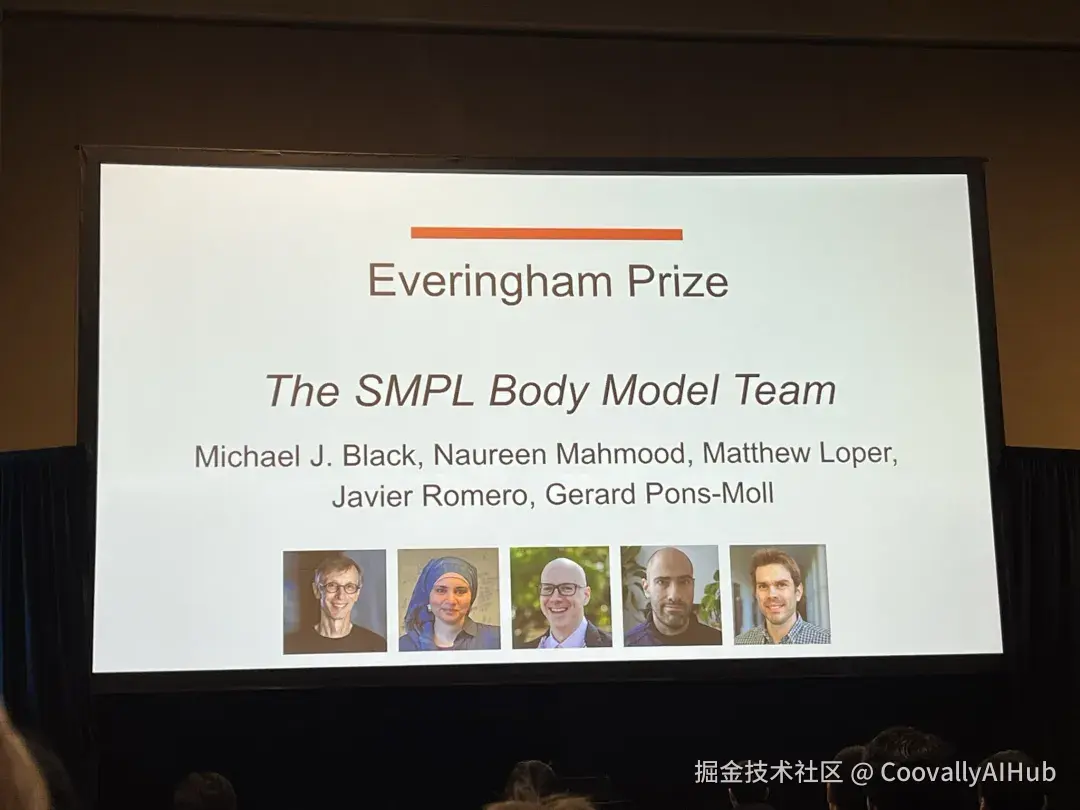

- 埃弗林厄姆奖(严谨评估奖)

SMPL人体模型团队:开发参数化三维人体模型,对数字人领域产生里程碑式影响

VQA数据集团队:创建视觉问答基准数据集,推动多模态AI发展

项目主页:smpl.is.tue.mpg.de/

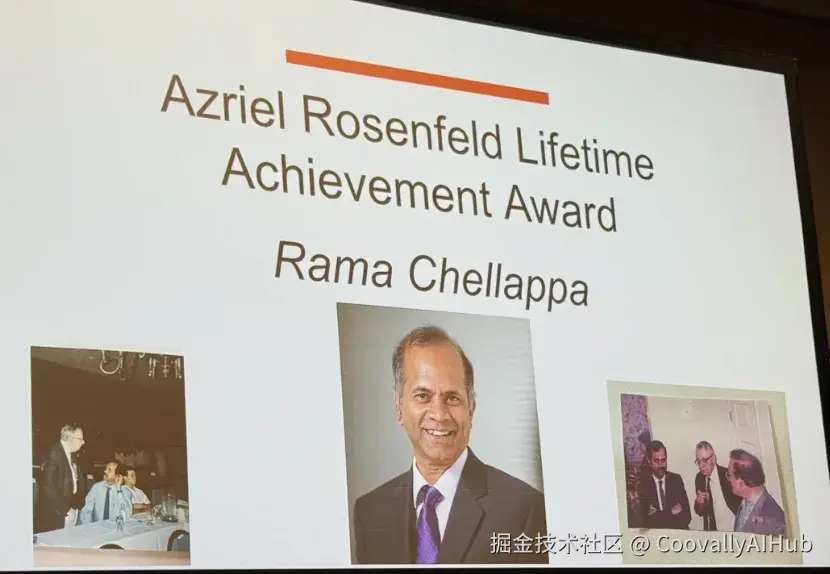

- 个人成就奖

杰出研究员奖:David Forsyth(UIUC)、Michal Irani(魏茨曼科学研究院)

阿兹列尔·罗森菲尔德终身成就奖:Rama Chellappa(约翰霍普金斯大学)

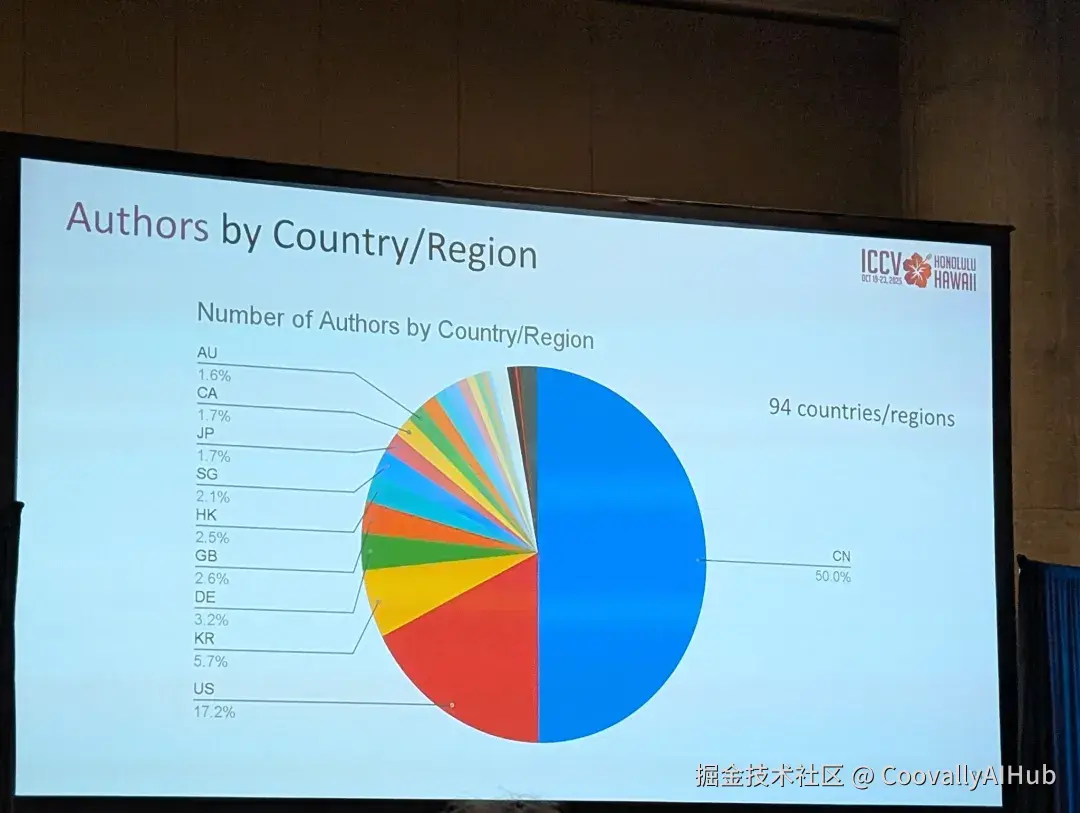

中国力量闪耀ICCV

本届ICCV数据显示,中国作者贡献了50%的投稿论文,再次彰显了中国在计算机视觉领域的强大实力。

从最佳论文的华人主导团队,到占半壁江山的投稿作者,中国学者正在全球计算机视觉舞台上扮演着越来越重要的角色。

总结

ICCV 2025 将最佳论文颁给 BrickGPT,不仅因为它"能搭出稳固积木",

更因为它象征着引领AIGC社区向着遵循物理规律、真实世界可用的方向迈进。

未来的AI,不只是内容创作者,更是数字工程师。