我试了Ollama、LM Studio,最后才发现"能离线用"的AI是什么样的

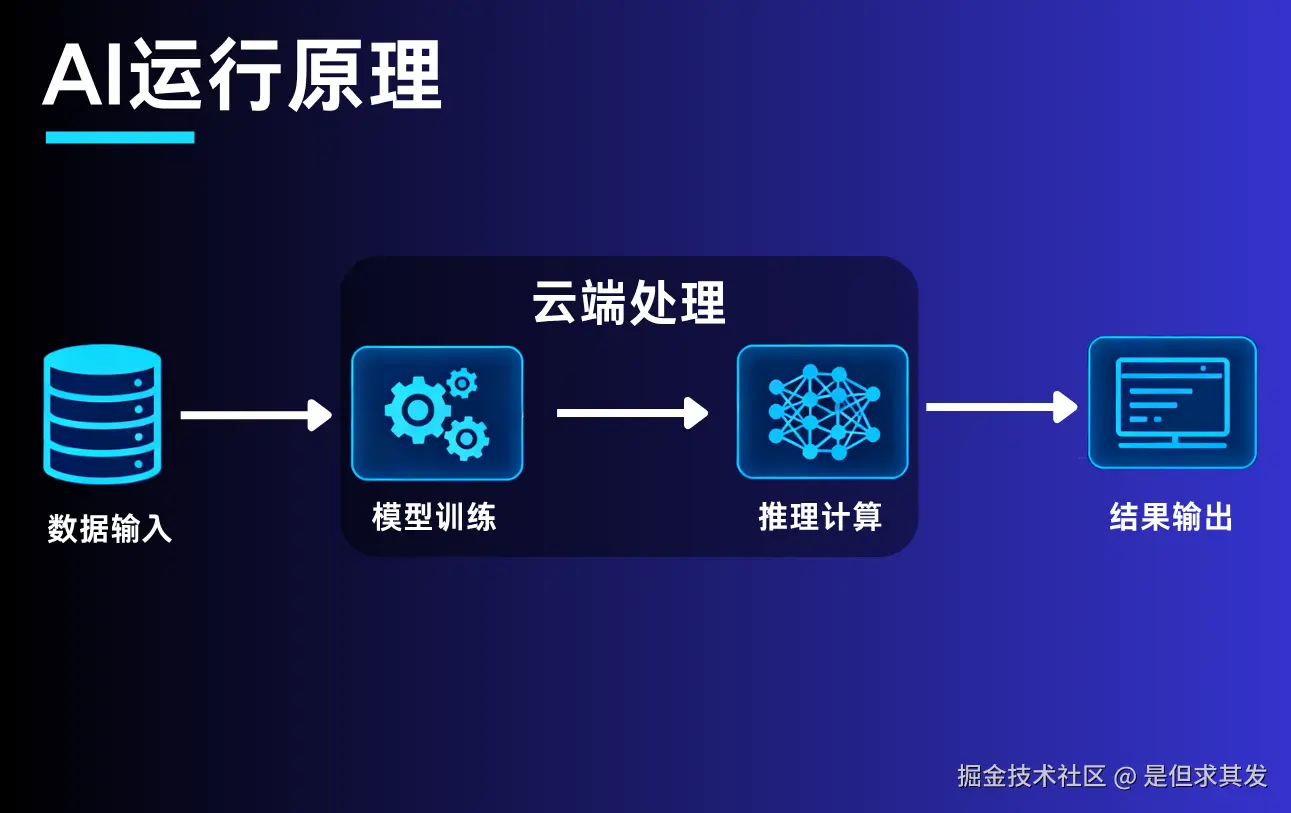

过去我们用AI,总是绕不开"云端"。

每次调用模型,都要联网、等待、上传、再下载结果。

可真正想在自己的电脑上 部署一个完全离线 的大模型,

过程往往没有想象中那么简单。

从Ollama到LM Studio,AI本地化任重道远

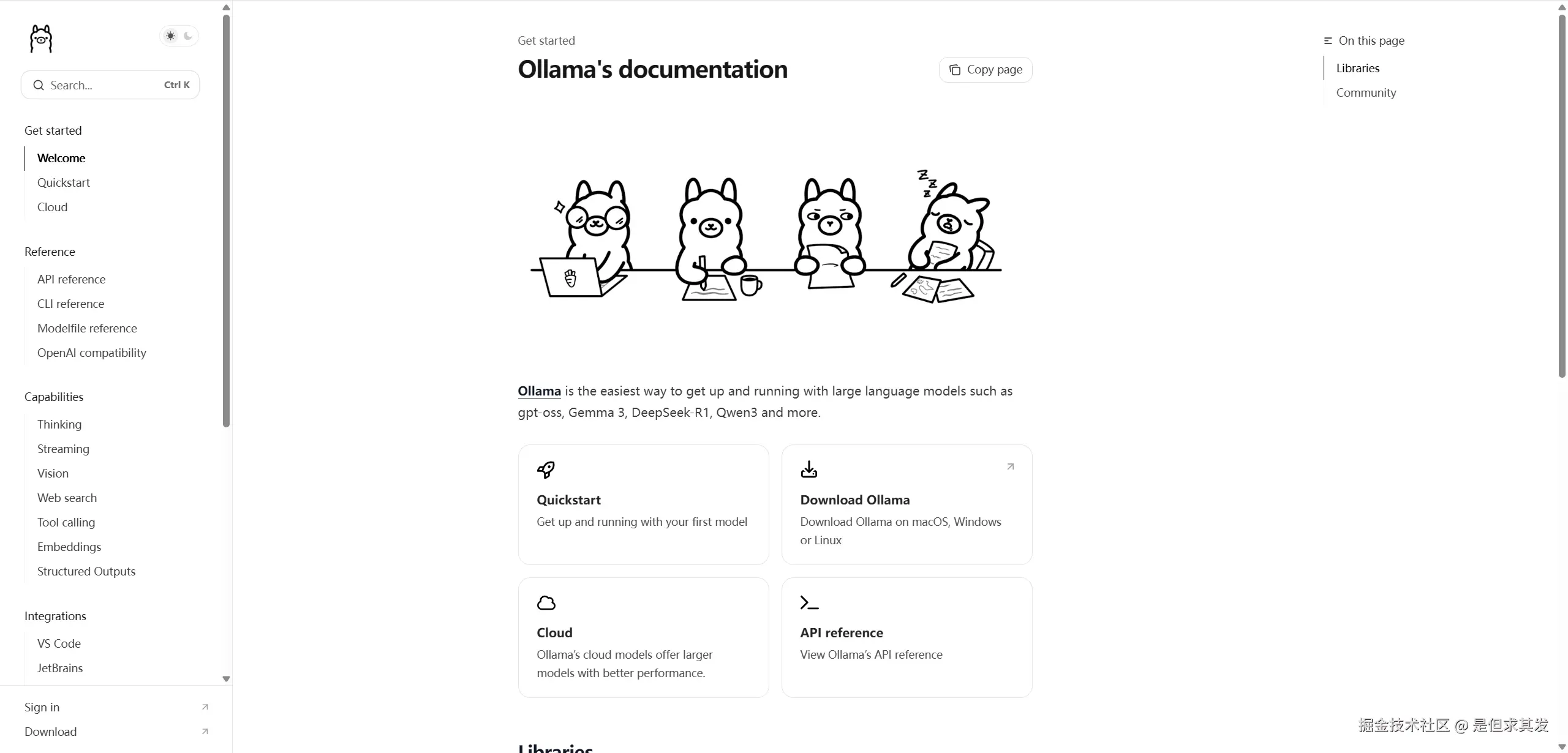

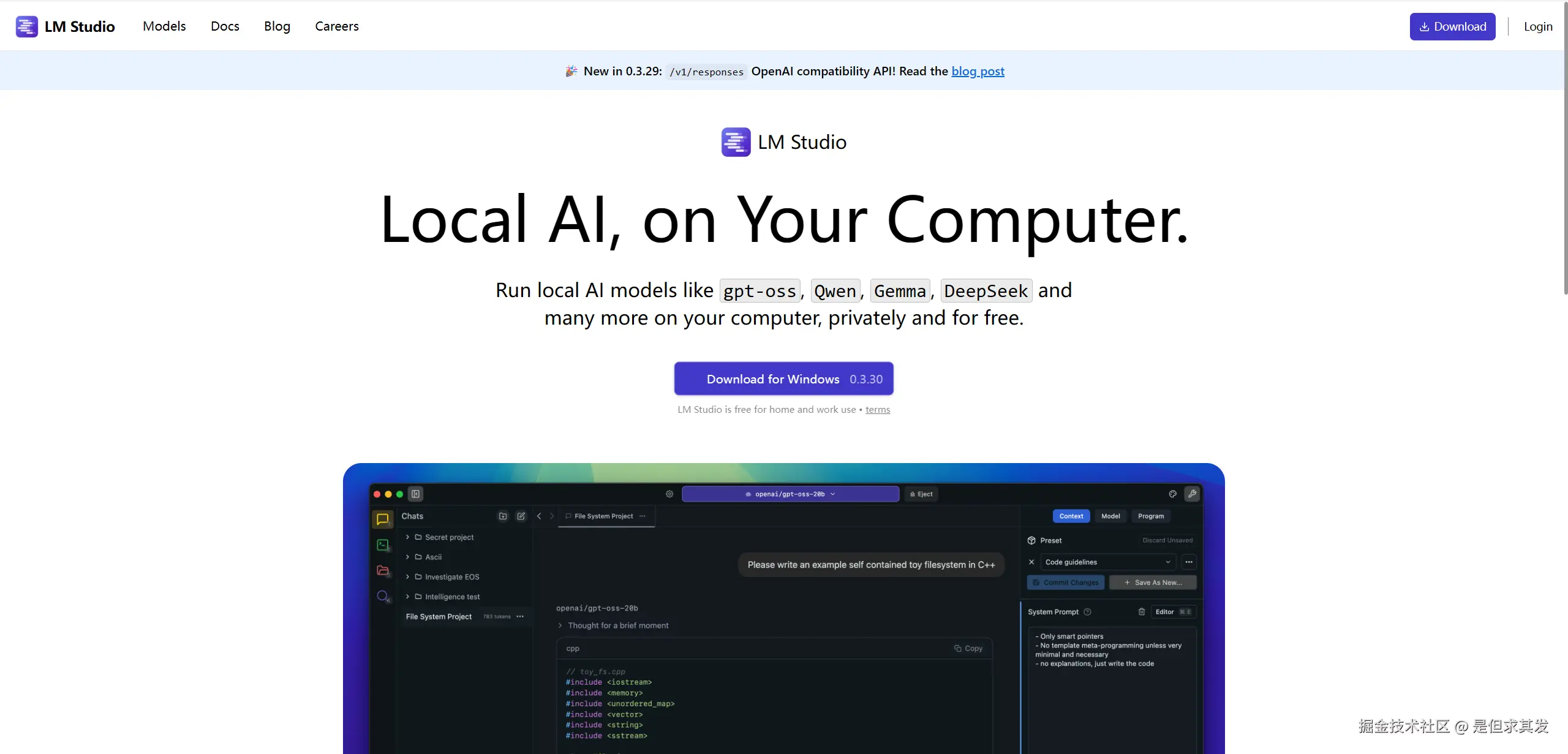

当我第一次尝试在Windows上部署AI模型时,最先接触到的两个名字,就是 Ollama 和 LM Studio。

它们确实能在本地加载模型,看起来好像就是"离线AI"的雏形。

它们确实能在本地加载模型,看起来好像就是"离线AI"的雏形。

但真用起来才发现------

Ollama更像一个命令行工具,模型下载依赖外网,离线时就彻底瘫痪;

LM Studio虽然界面友好,但依然要联网认证、更新插件,离线后功能缺一半。

比如你部署ollama以后,需要执行以下命令操作大模型或者是操作ollama服务

bash

#下载模型

ollama pull gemma3

# 删除模型

ollama rm gemma3

#列出模型

ollama ls

#启动ollama

ollama serve更关键的是,这两款软件都只解决了"模型能跑"的问题,

却没有把AI作为一个完整的本地工具系统来做。

换句话说:

Ollama偏部署,LM Studio偏体验。

一个"会跑",一个"好看",但都不算"能用"。

真正的离线AI,应该是什么样的?

真正的离线AI,不应该只是一个能跑模型的"容器"。

它应该能在完全本地环境下 完成从输入、理解、处理到输出的全链路体验------

哪怕电脑完全断网,也依然能工作。

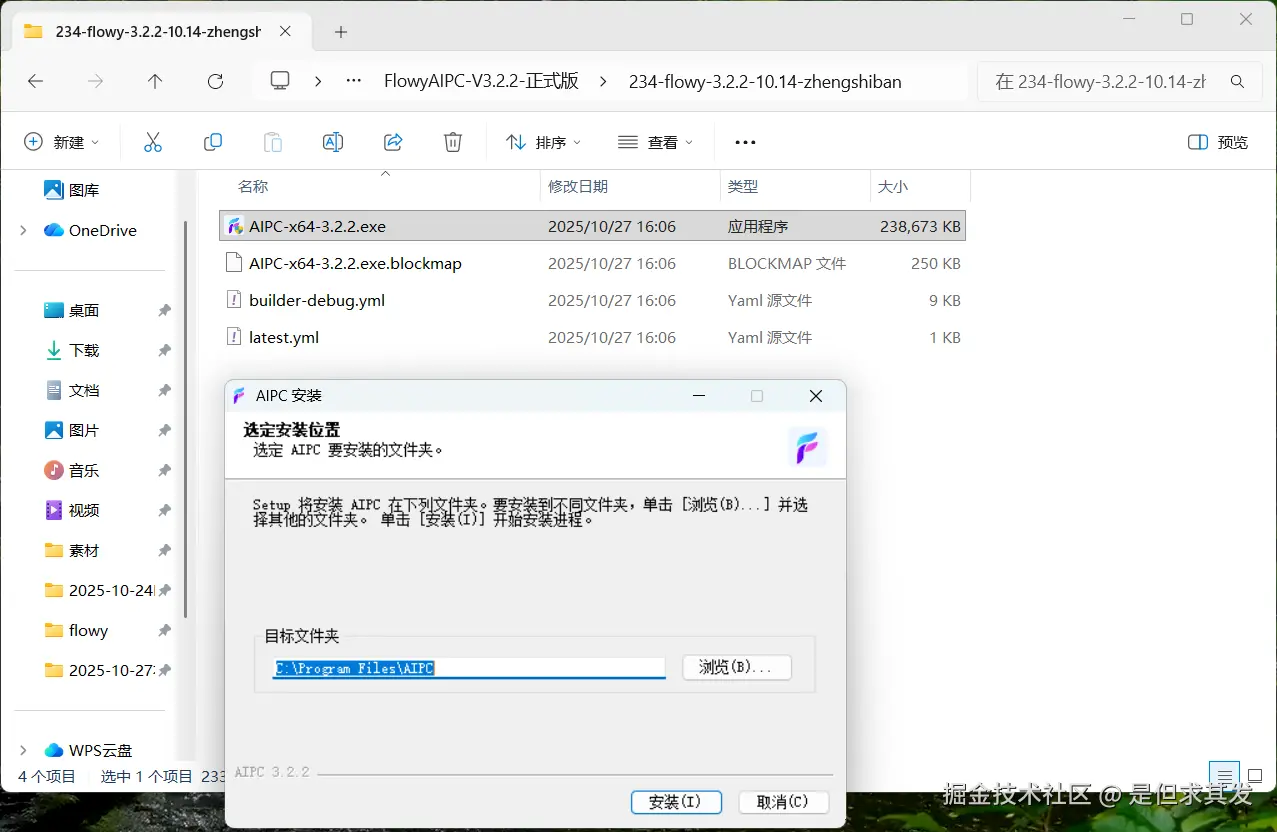

最近我发现了一款能做到这一点的工具:Flowy AIPC。

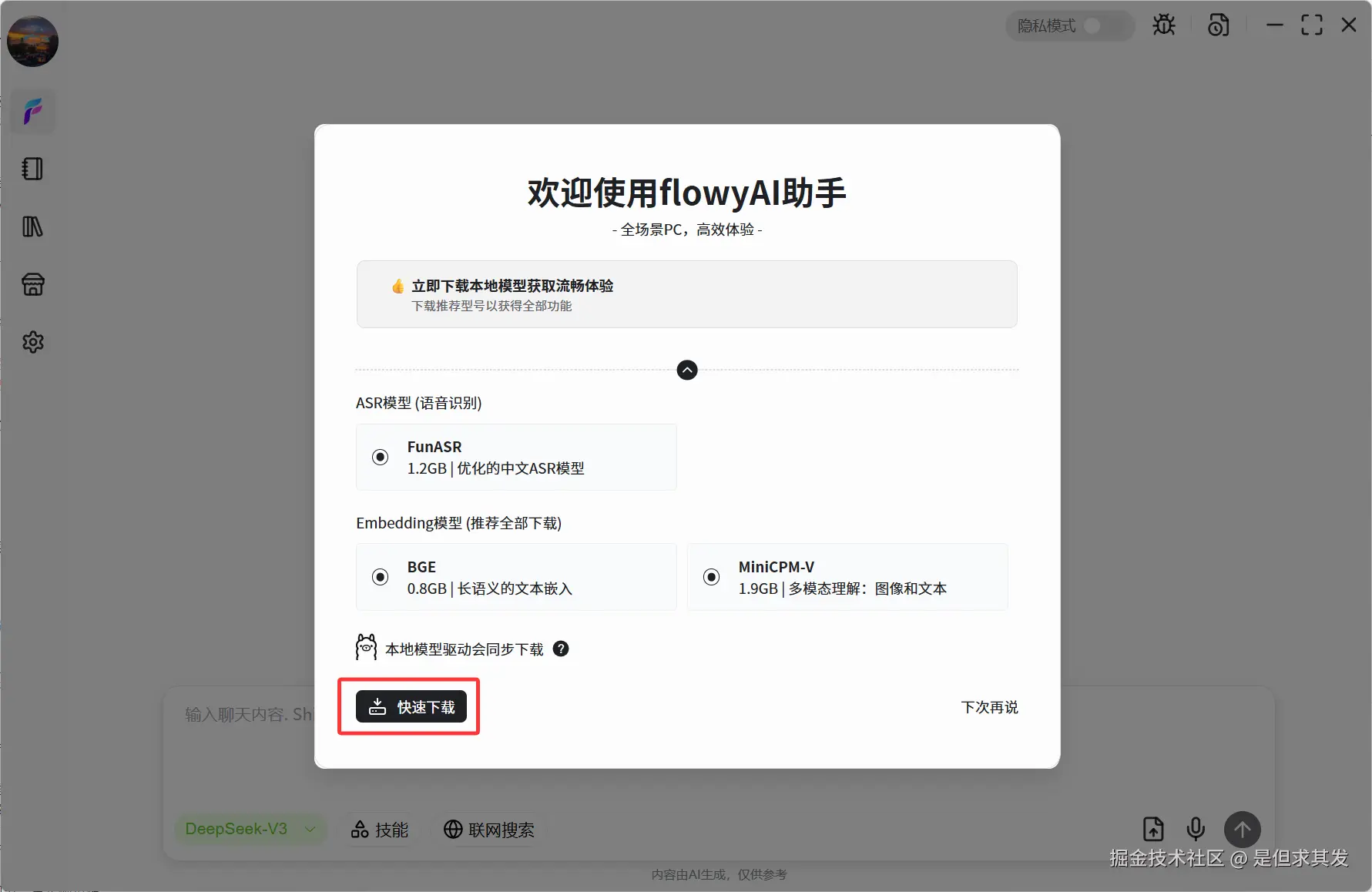

从FlowyAIPC官网下载安装包 → 一键安装 → 打开即可使用。

FlowyAIPC自动识别设备适配的大模型并支持一键安装

等待下载完成即可拥有本地大模型

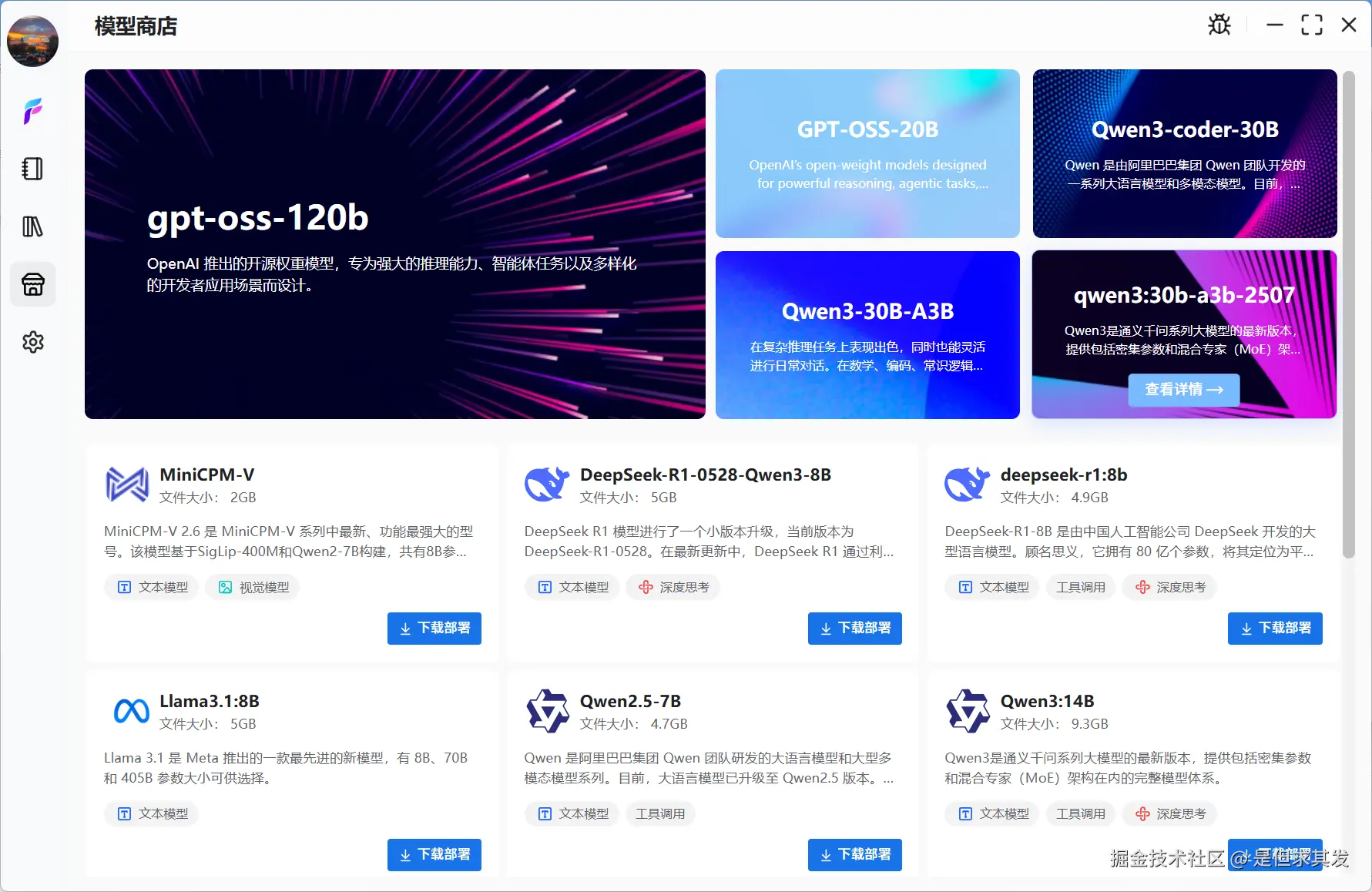

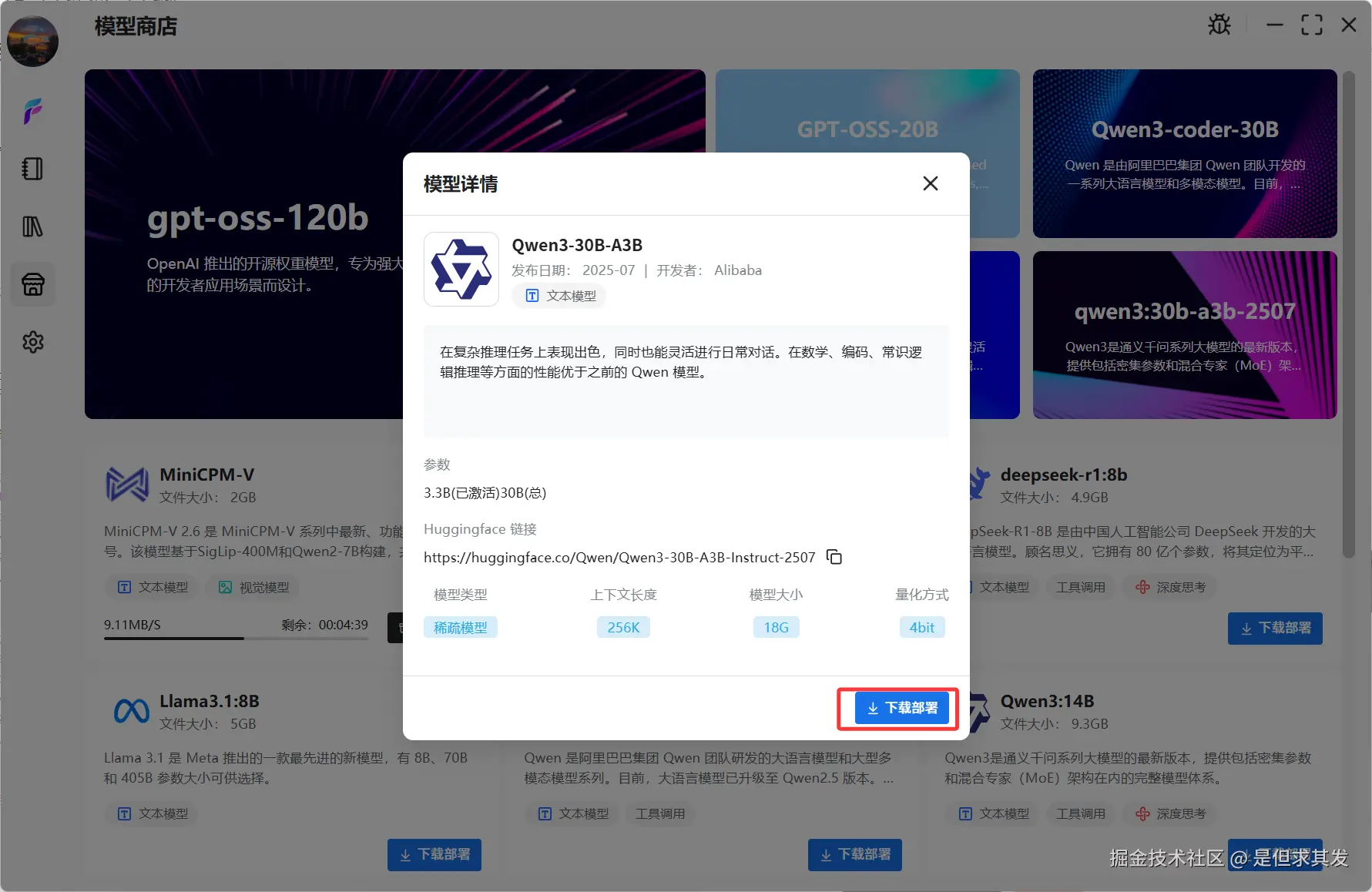

你还可以在FlowyAIPC模型商店一键部署自己想要的大模型

不需要命令行、不需要手动下载模型包,更不用担心联网验证、填写Key等。

不需要命令行、不需要手动下载模型包,更不用担心联网验证、填写Key等。

Flowy AIPC可以在完全离线状态下运行,

所有数据、聊天记录、知识库内容都保存在你的本地电脑中。

在联网的情况下,你可以选择云端模型进行提问,选择本地模型也可以打开联网搜索搭配最新信息回答

你也可以一键开启隐私模式,所有操作内容都完全保留在本地,尽情享受数据私有化的安全与私密  除了问答和生成,它还能直接应用到具体场景,比如:

除了问答和生成,它还能直接应用到具体场景,比如:

📝 会议纪要:支持会议现场实时录音转文字字幕,并支持实时翻译语言,会后支持一键生成会议总结以及思维导图,自动提炼会议重点,离线使用无需担心会议内容泄露

📚 知识库:知识库支持完全离线检索和数据处理,无需担心本地数据上传云端

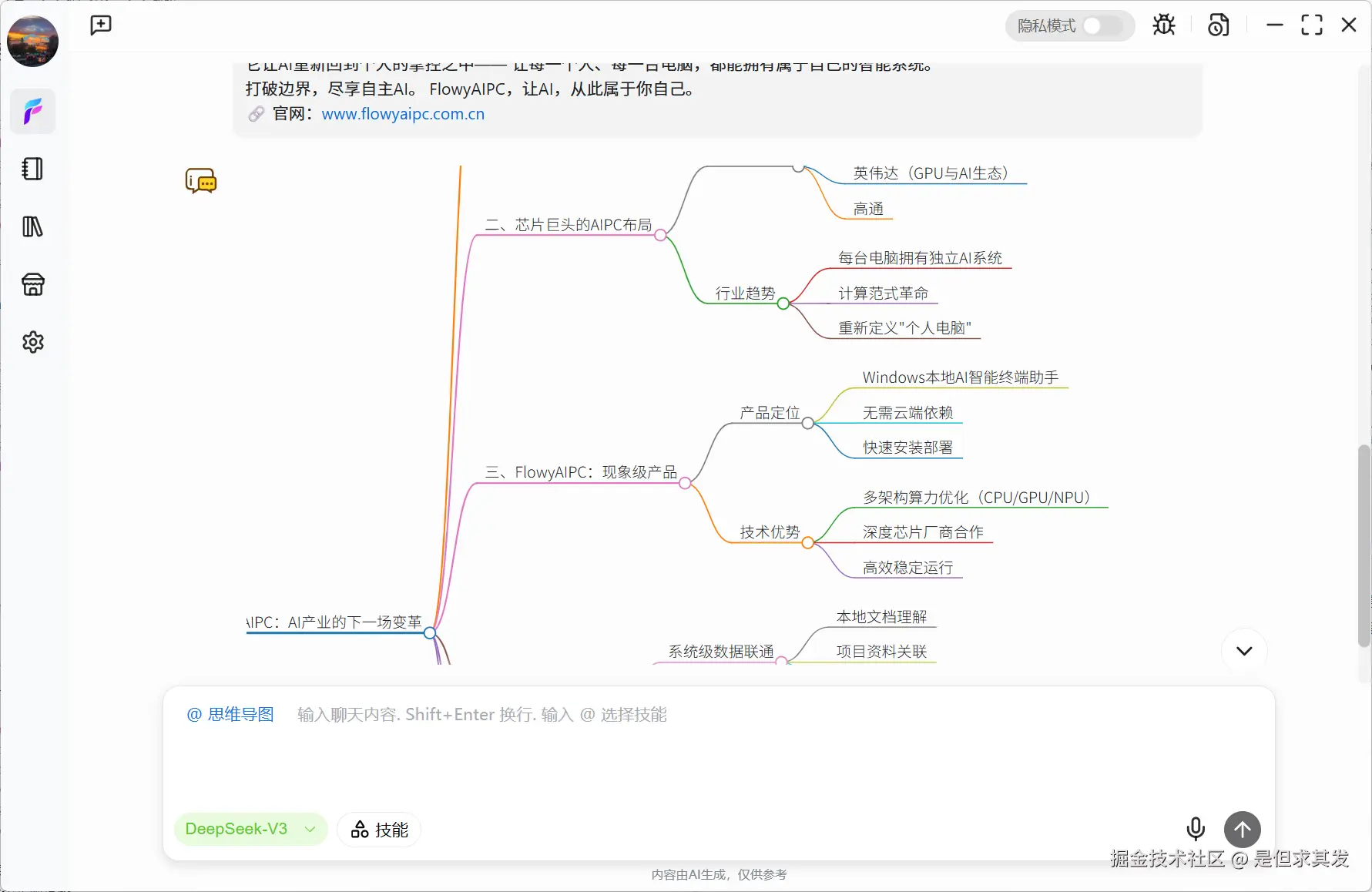

🧠 思维导图:输入主题想法或者长文,支持一键生成思维导图提炼所有重点信息

📁 文件内容分析与提炼、文本续写、周报生成、翻译等更多技能

这已经不只是一个模型运行环境,更是一个"个人AI工作台"。

当AI真正属于"你自己"

在经历了几轮尝试之后,我越来越确定------

离线AI的意义,在于对本地数据的绝对掌控感。 当AI不再依赖云端,不再上传任何数据,它才算真正属于"用户自己"。

Flowy AIPC做到了这一点。它让AI从"服务"变成"工具",从"云端"回到"桌面",从"使用者"变成"拥有者"。 这或许才是AI发展的正确道路。

👉 快速安装FlowyAIPC: www.flowyaipc.com.cn