在 Hive 生态系统中,从元数据库初始化到 HiveServer2 启动的每一步都可能暗藏 "陷阱"。本文将结合实际操作,详细解决 元数据库强制连接 Derby 和 HiveServer2 启动类缺失 两大核心问题,帮助你彻底打通 Hive 部署流程。

目录

[一、问题一:Hive 元数据库初始化时强制连接 Derby](#一、问题一:Hive 元数据库初始化时强制连接 Derby)

[1. 配置文件与驱动检查](#1. 配置文件与驱动检查)

[2. 手动初始化 MySQL 元数据库(终极方案)](#2. 手动初始化 MySQL 元数据库(终极方案))

[3. 验证与启动 Hive](#3. 验证与启动 Hive)

[二、问题二:HiveServer2 启动时类缺失(NoClassDefFoundError: HiveConf)](#二、问题二:HiveServer2 启动时类缺失(NoClassDefFoundError: HiveConf))

[1. 环境变量与类路径检查](#1. 环境变量与类路径检查)

[2. 重启 HiveServer2 并验证](#2. 重启 HiveServer2 并验证)

一、问题一:Hive 元数据库初始化时强制连接 Derby

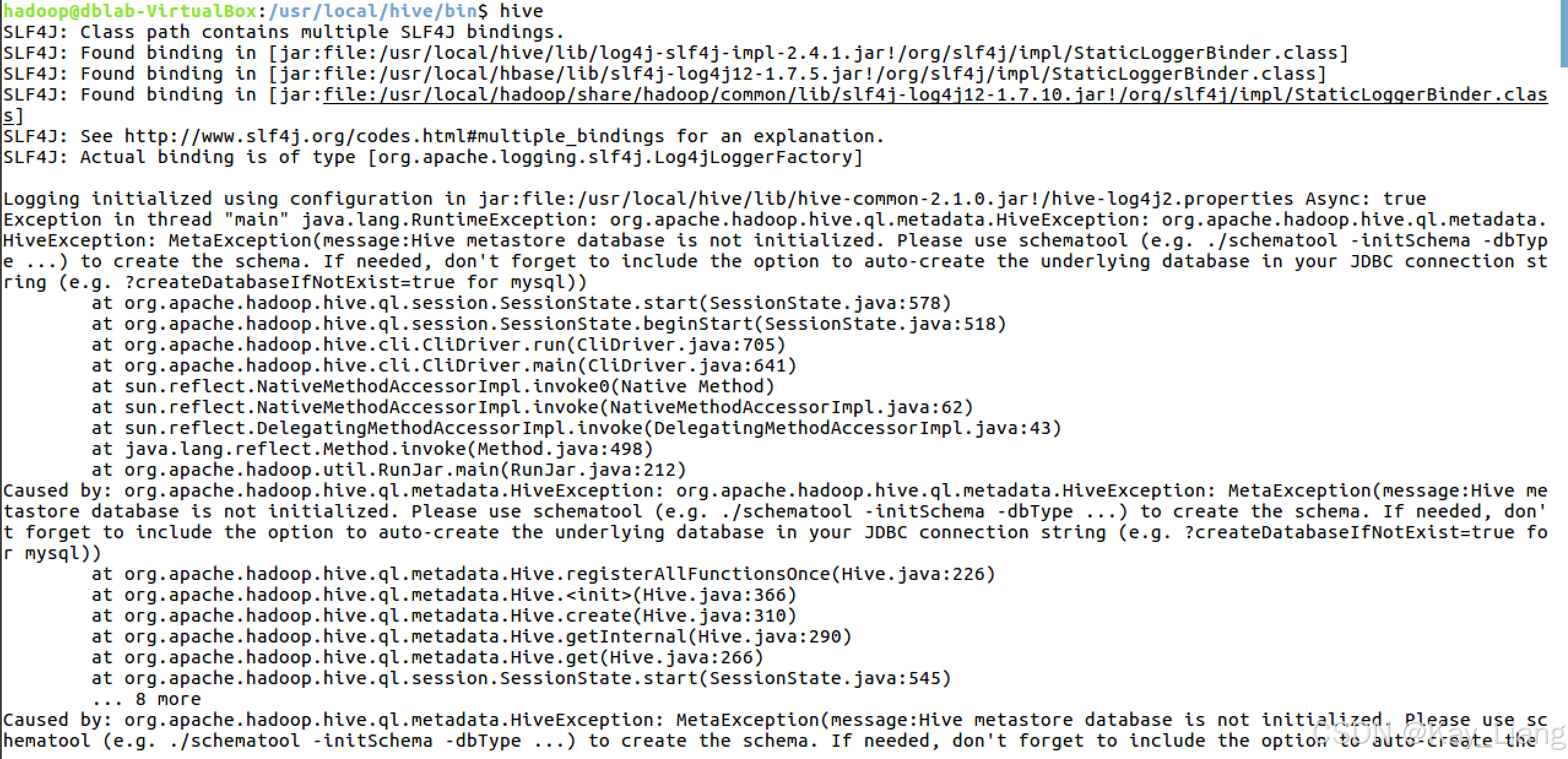

现象回顾

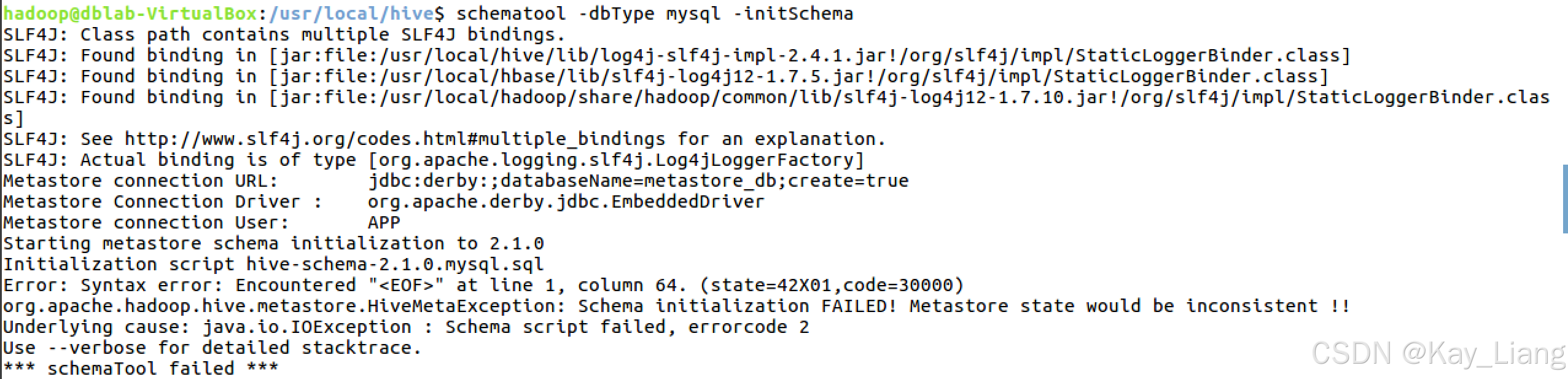

使用hive命令想要打开hive服务的时候无法打开,执行 schematool 初始化命令时,日志始终显示连接 Derby(而非配置的 MySQL),报错 "Schema initialization FAILED":

bash

Metastore connection URL: jdbc:derby:;databaseName=metastore_db;create=true

Metastore Connection Driver : org.apache.derby.jdbc.EmbeddedDriver

根本原因与解决步骤

1. 配置文件与驱动检查

-

hive-site.xml格式验证 :确保 XML 配置无语法错误,重点配置 MySQL 连接信息:xml

XML<property> <name>javax.jdo.option.ConnectionURL</name> <value>jdbc:mysql://localhost:3306/hive?createDatabaseIfNotExist=true&useSSL=false&serverTimezone=UTC</value> </property> <property> <name>javax.jdo.option.ConnectionDriverName</name> <value>com.mysql.jdbc.Driver</value> </property> <property> <name>javax.jdo.option.ConnectionUserName</name> <value>hive</value> </property> <property> <name>javax.jdo.option.ConnectionPassword</name> <value>hadoop</value> </property> -

MySQL 驱动安装 :Hive 依赖 MySQL JDBC 驱动,检查是否缺少,如果缺少需按照下面手动下载并放入

$HIVE_HOME/lib:bashcd $HIVE_HOME/lib wget https://repo1.maven.org/maven2/mysql/mysql-connector-java/5.1.47/mysql-connector-java-5.1.47.jar

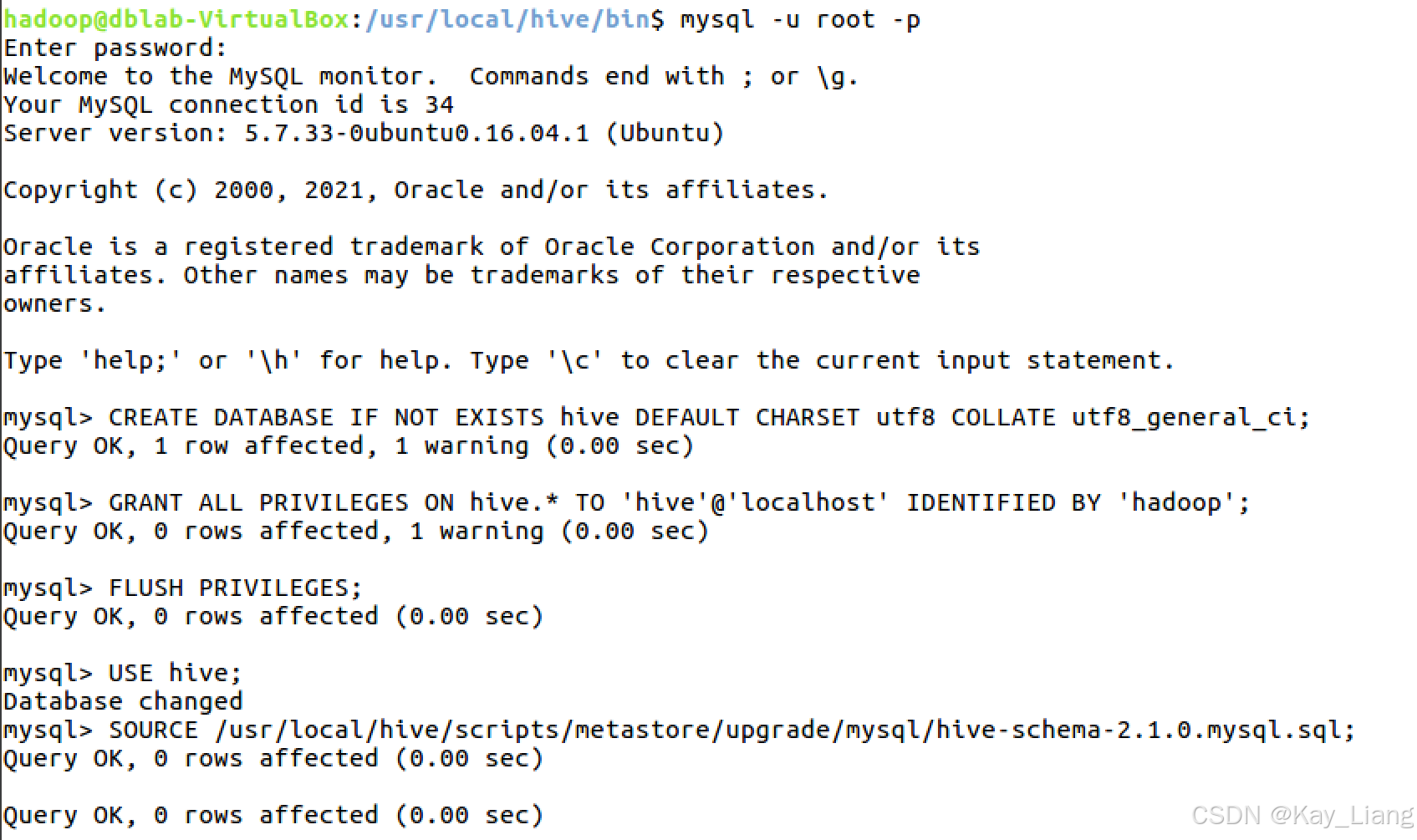

2. 手动初始化 MySQL 元数据库(终极方案)

若 schematool 始终失效,可直接在 MySQL命令行 中执行 Hive 元数据脚本:

sql

-- 登录 MySQL 并创建 Hive 数据库

mysql -u root -p

CREATE DATABASE hive DEFAULT CHARSET utf8;

GRANT ALL ON hive.* TO 'hive'@'localhost' IDENTIFIED BY 'hadoop';

FLUSH PRIVILEGES;

USE hive;

-- 执行 Hive 元数据初始化脚本

SOURCE /usr/local/hive/scripts/metastore/upgrade/mysql/hive-schema-2.1.0.mysql.sql;

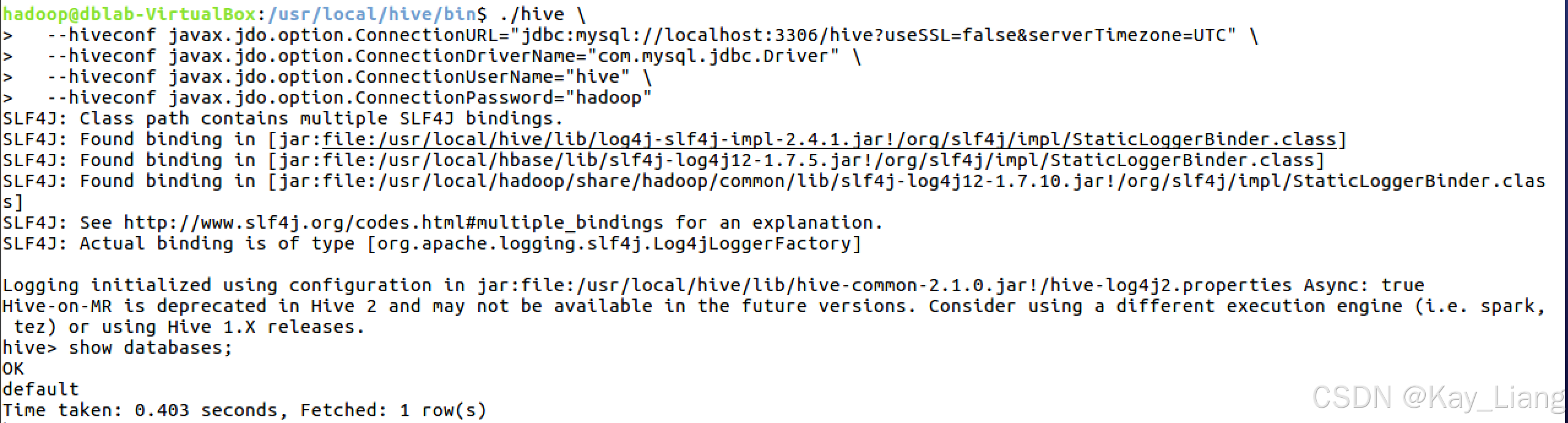

3. 验证与启动 Hive

删除 Derby 残留文件后启动 Hive,验证 MySQL 连接:

bash

cd $HIVE_HOME/bin

rm -rf metastore_db/ derby.log

./hive \

--hiveconf javax.jdo.option.connectionURL="jdbc:mysql://localhost:3306/hive?useSSL=false&serverTimezone=UTC" \

--hiveconf javax.jdo.option.connectionDriverName="com.mysql.jdbc.Driver" \

--hiveconf javax.jdo.option.connectionUserName="hive" \

--hiveconf javax.jdo.option.connectionPassword="hadoop" 执行

执行 show databases;,若输出 default 则说明配置成功。

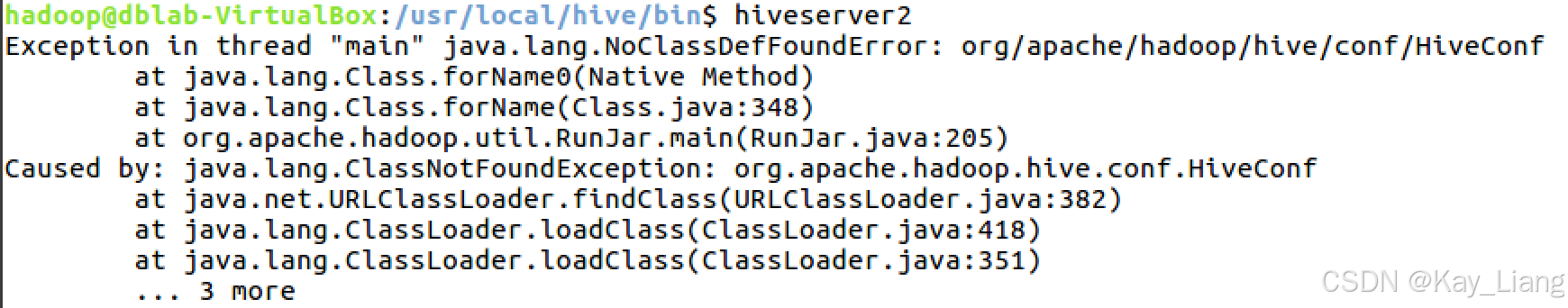

二、问题二:HiveServer2 启动时类缺失(NoClassDefFoundError: HiveConf)

现象回顾

执行 hiveserver2 时,报错类缺失:

bash

Exception in thread "main" java.lang.NoClassDefFoundError: org/apache/hadoop/hive/conf/HiveConf根本原因与解决步骤

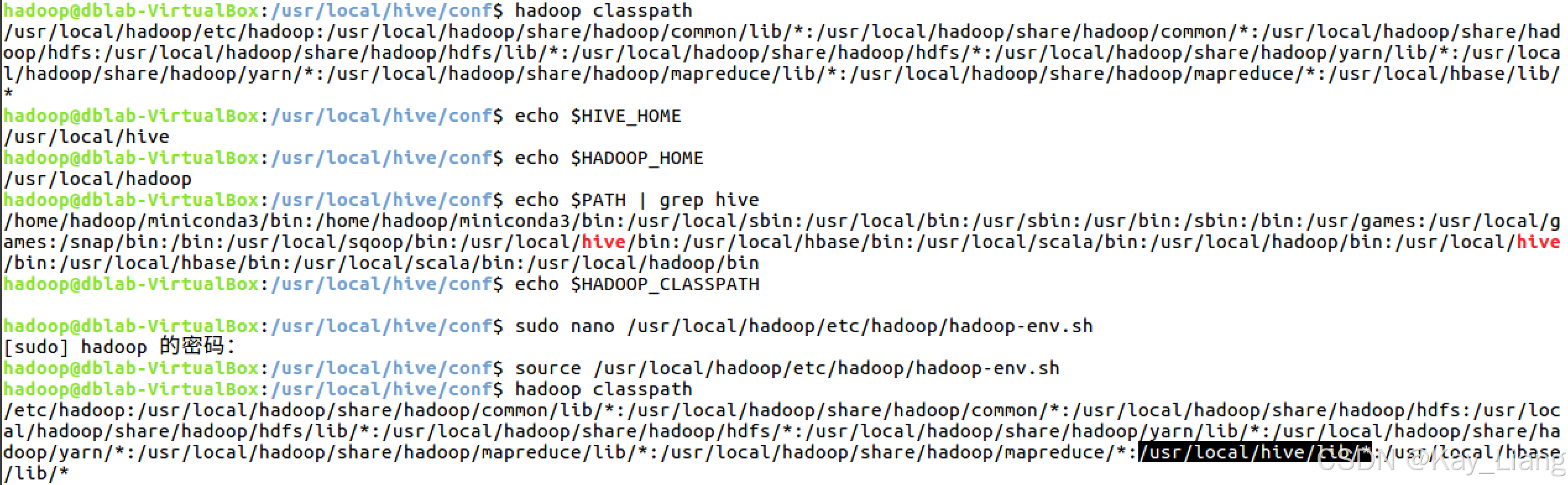

1. 环境变量与类路径检查

HiveServer2 依赖 Hadoop 和 Hive 的类路径,需确保 HADOOP_HOME、HIVE_HOME 环境变量正确,且 Hive 类被加入 Hadoop 类路径。

-

检查环境变量是否正确 :

bashcd /usr/local/hive/conf echo $HIVE HOME echo SHADOOP HOME -

配置 Hadoop 环境变量 :在

hadoop-env.sh中添加 Hive 类路径:bashsudo nano $HADOOP_HOME/etc/hadoop/hadoop-env.sh # 在末尾添加以下内容 export HIVE_HOME=/usr/local/hive export HADOOP_CLASSPATH=$HIVE_HOME/lib/*:$HADOOP_CLASSPATH export HIVE_CONF_DIR=/usr/local/hive/conf #如果发现改配置之后Hadoop集群无法关闭,则再在末尾加下面的内容 export HADOOP_CONF_DIR=/usr/local/hadoop/etc/hadoop -

生效配置并验证 :

bashsource $HADOOP_HOME/etc/hadoop/hadoop-env.sh hadoop classpath # 查看是否包含 $HIVE_HOME/lib/*

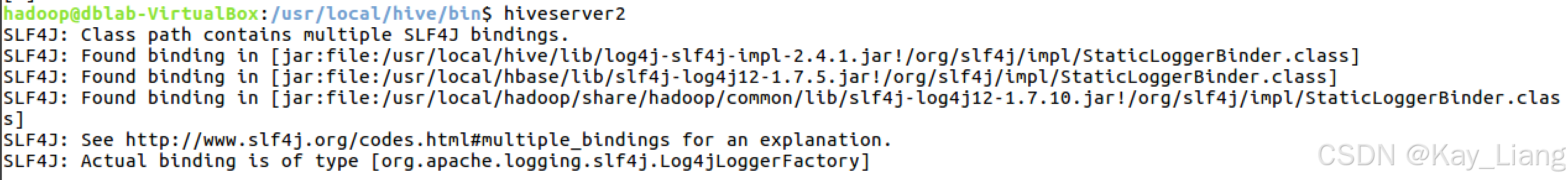

2. 重启 HiveServer2 并验证

配置生效后,重新启动 HiveServer2:

bash

cd /usr/local/hive/bin

hiveserver2

若启动无类缺失报错,说明问题解决。可通过 Beeline 连接验证(另开一个终端):

bash

beeline -u jdbc:hive2://localhost:10000 -n hadoop三、常见问题总结与延伸

-

SLF4J 绑定警告 :日志中 "SLF4J: Class path contains multiple SLF4J bindings" 是组件冲突,不影响功能,可忽略或删除 HBase/Hadoop 中冲突的

slf4j-log4j12-*.jar。 -

Hive-on-MR 过时提示 :Hive 2.x 中 MapReduce 执行引擎已过时,建议后续切换为 Tez 或 Spark 引擎(如

set hive.execution.engine=spark;)。 -

元数据库版本验证 :若手动初始化后仍提示 "元数据库未初始化",可通过

schematool -dbType mysql -info验证元数据版本是否匹配。

通过以上步骤,你可以从元数据库初始化到 HiveServer2 启动,完整解决 Hive 部署中的核心问题。若还有其他疑问,欢迎在评论区交流!