AI大模型面试圣经

大模型开发者宝藏

Dify高效AI工作流智能体

一、总体架构:实时翻译字幕系统流程

一个完整的实时字幕翻译系统通常包含以下 4 个核心模块:

最终输出可以是:

屏幕字幕(例如会议、直播)

翻译语音(同传)

双语字幕流(带时间戳)

二、引入大模型:它的作用在哪里?

大模型(LLM)可以在三个关键环节增强传统算法:

实际做法是:

Whisper(ASR)→ LLM(翻译+润色)→ Subtitle Stream

三、简单实现方案(本地+Python)

这里用一个 可跑通的轻量原型 来说明:

环境依赖

pip install faster-whisper openai transformers pyaudio numpy

实时语音输入 + Whisper识别 + 大模型翻译

import openai

import torch

from faster_whisper import WhisperModel

import queue, threading, sounddevice as sd

openai.api_key = "你的API密钥"

初始化ASR

model = WhisperModel("medium", device="cuda" if torch.cuda.is_available() else "cpu")

q = queue.Queue()

def audio_callback(indata, frames, time, status):

q.put(bytes(indata))

实时录音

def record_audio():

with sd.RawInputStream(samplerate=16000, blocksize=8000, dtype='int16', channels=1, callback=audio_callback):

print("🎤 正在监听中...")

while True:

audio_chunk = q.get()

with open("temp.wav", "wb") as f:

f.write(audio_chunk)

segments, _ = model.transcribe("temp.wav", beam_size=5)

text = " ".join([seg.text for seg in segments])

if text.strip():

translate_and_print(text)

翻译模块(用 GPT-4 / Qwen 等大模型)

def translate_and_print(text):

prompt = f"将以下内容翻译成自然流畅的中文口语字幕风格:\n{text}"

response = openai.ChatCompletion.create(

model="gpt-4o-mini",

messages=[{"role":"user","content":prompt}]

)

print("🗣️ 英文:", text)

print("🌏 中文:", response.choices[0].message.content.strip())

threading.Thread(target=record_audio).start()

这个脚本实现:

实时麦克风监听

Whisper 将音频识别为文字

GPT 翻译成中文字幕

终端实时输出结果

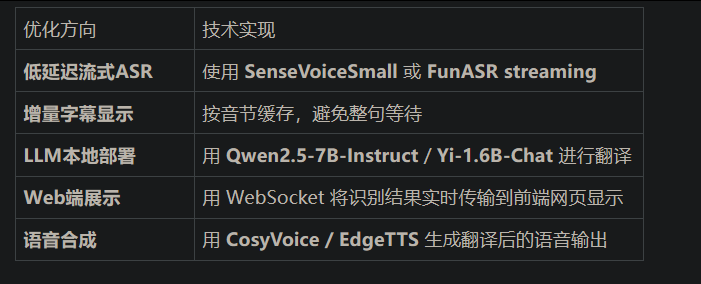

四、进阶优化方向

AI大模型面试圣经

大模型开发者宝藏

Dify高效AI工作流智能体