总目录 大模型相关研究:https://blog.csdn.net/WhiffeYF/article/details/142132328

https://arxiv.org/pdf/2508.13141

https://claude.ai/share/19b1b2fe-1d02-435c-8832-e972f6c01397

速览

OptimalThinkingBench论文

核心问题

想象一下,你有两个助手:

- 助手A(思考型):做数学题很棒,但你问他"1+1=?",他要思考10分钟才回答

- 助手B(非思考型):回答"1+1=?"秒答,但遇到复杂问题就做不出来

这就是当前AI大模型面临的困境:

- 思考型模型(如o3、DeepSeek-R1):简单问题也要"过度思考",浪费时间和资源

- 非思考型模型:复杂推理问题"思考不足",准确率低

论文的贡献

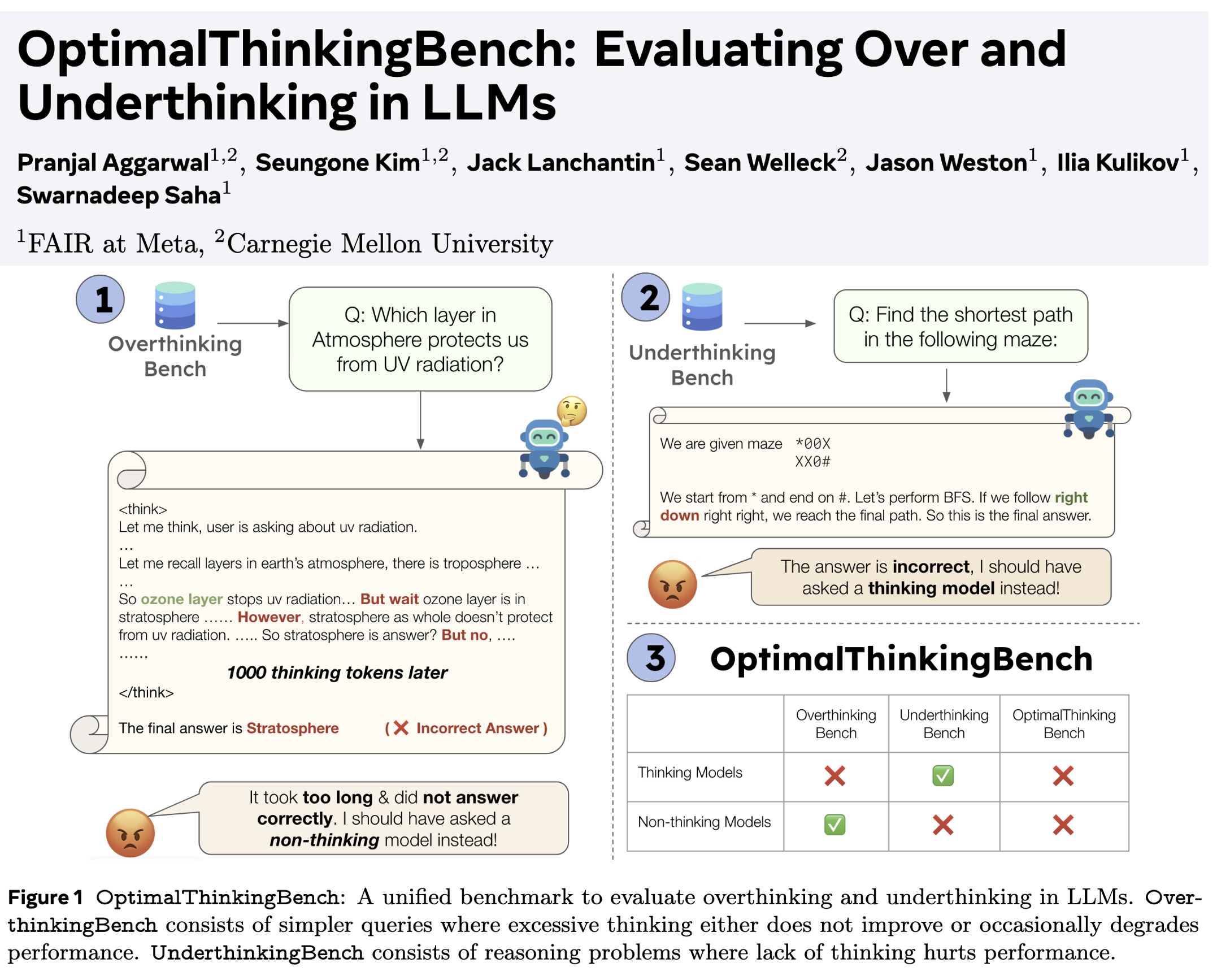

研究者开发了一个统一的评估基准,同时测试模型是否会"想太多"或"想太少":

1️⃣ OverthinkingBench(过度思考基准)

包含1460个简单问题,比如:

- "钢棒1米长,换算成厘米是多少?"

- "哪层大气层保护地球免受紫外线辐射?"

问题特点:

- 涵盖72个领域(物理、历史、工程等)

- 4种答案类型(数字、选择题、简答、开放式)

- 普通模型几乎都能答对,不需要复杂推理

评估指标:AUCOAA(面积under曲线)

- 既要答对,又要用最少的"思考token"

- 如果模型用了1000个token思考"1+1",得分会很低

2️⃣ UnderthinkingBench(思考不足基准)

包含610个复杂推理题,比如:

- 迷宫最短路径问题

- 进制转换运算

- 逻辑推理题

核心原则:

- 小的思考型模型(如1.7B参数)能做对

- 大的非思考型模型(如235B参数)反而做错

- 说明"思考"对这些问题是必需的

3️⃣ OptimalThinkingBench(最优思考基准)

用F1分数结合上述两个基准:

F1 = 2 × (AUCOAA × 准确率) / (AUCOAA + 准确率)理想模型:简单问题快速回答,复杂问题深度思考

主要发现

📊 33个模型的测试结果

| 模型类型 | 代表模型 | OverthinkingBench | UnderthinkingBench | F1分数 |

|---|---|---|---|---|

| 思考型(最强) | o3 | 78.6%(用235 tokens) | 65.0% | 71.1% ✅ |

| 思考型(开源最强) | GPT-OSS-120B | 83.3%(用154 tokens) | 57.9% | 68.3% |

| 思考型(中等) | Qwen3-8B思考模式 | 16.3%(用1588 tokens) | 47.7% | 24.3% |

| 非思考型(最强) | Sonnet-4非思考模式 | 97.4%(0 tokens) | 32.1% | 48.3% |

| 非思考型(中等) | Qwen3-235B非思考 | 96.7%(0 tokens) | 18.9% | 31.7% |

🔍 关键洞察

-

过度思考的严重性

- 大多数思考型模型在简单问题上用1300+ tokens

- 例子:Magistral模型回答"1米=多少厘米"用了3303个tokens!

- 即使思考这么久,准确率也没提高

-

思考的必要性

- Qwen3-32B:非思考模式14.9%准确率 → 思考模式51.0%(提升38%)

- 证明复杂推理任务必须要"思考"

-

没有完美模型

- 最好的o3也只有71.1%的F1分数

- 说明还有很大改进空间

改进方法测试

研究者尝试了多种方法:

❌ 效率优化方法(大多失败)

- L1正则化:减少思考长度,但准确率下降

- 模型合并:有一定效果

- AdaptThink:唯一成功的方法,但改进有限

⚠️ 路由方法(部分成功)

训练一个"路由器"判断问题难度:

- 简单问题 → 非思考模式

- 复杂问题 → 思考模式

- 问题:距离"完美路由器"还差15%

✅ 提示词方法(有效)

- 标准提示:26.3% F1

- 加上"不要过度思考":34.0% F1(提升7.7%)

- 加上"让我们一步步思考":18.3% F1(下降8%,证明会加重过度思考)

有趣的发现

🧮 数学问题更容易过度思考

GPT-OSS-20B模型:

- 简单数学题用130个tokens

- 简单常识题用850个tokens(多6.5倍!)

原因:模型在数学任务上训练太多,看到数字就"条件反射"要深度思考

📝 选项越多,思考越多

多选题实验:

- 4个选项:640 tokens

- 12个选项:980 tokens

- 每增加1个选项,平均多思考42个tokens(即使选项完全无关)

🎯 定性案例分析

过度思考案例:

- 问题:"哪层大气层保护地球免受紫外线辐射?"

- 模型初始答案:臭氧层 ✅

- 但继续思考1000+ tokens后:改成平流层 ❌

- 原因:过度纠结"是说臭氧层本身,还是包含臭氧层的平流层"

思考不足案例:

- 问题:迷宫最短路径

- 非思考型模型:"我用BFS算法"

- 实际行为:走第一条看到的路,没验证是否最短

- 原因:只会套用算法名称,不真正执行

实用启示

-

对用户:

- 简单问题别用思考型模型(浪费时间和钱)

- 复杂推理必须用思考型模型

- 可以用提示词"不要过度思考"

-

对开发者:

- 需要开发"自适应"模型,自动调整思考深度

- 当前的路由方法还不够好

- 数学训练数据可能导致过度思考

-

对研究者:

- 这是第一个统一评估"思考效率"的基准

- 可以用于跟踪模型进化

- 数据生成方法可防止"考试作弊"(合成数据可持续更新)

总结

这篇论文就像给AI模型做了一次"思维效率体检",发现:

- 🤔 会思考的模型常常"想太多"

- 💭 不会思考的模型常常"想太少"

- 🎯 理想模型应该"该快则快,该慢则慢"

- 📊 目前没有模型达到理想状态,最好的也只有71%分数

这为未来开发"智能调节思考深度"的AI模型指明了方向!