原文: https://mp.weixin.qq.com/s/a3gqAuKAJguAlC7gfZCE_g

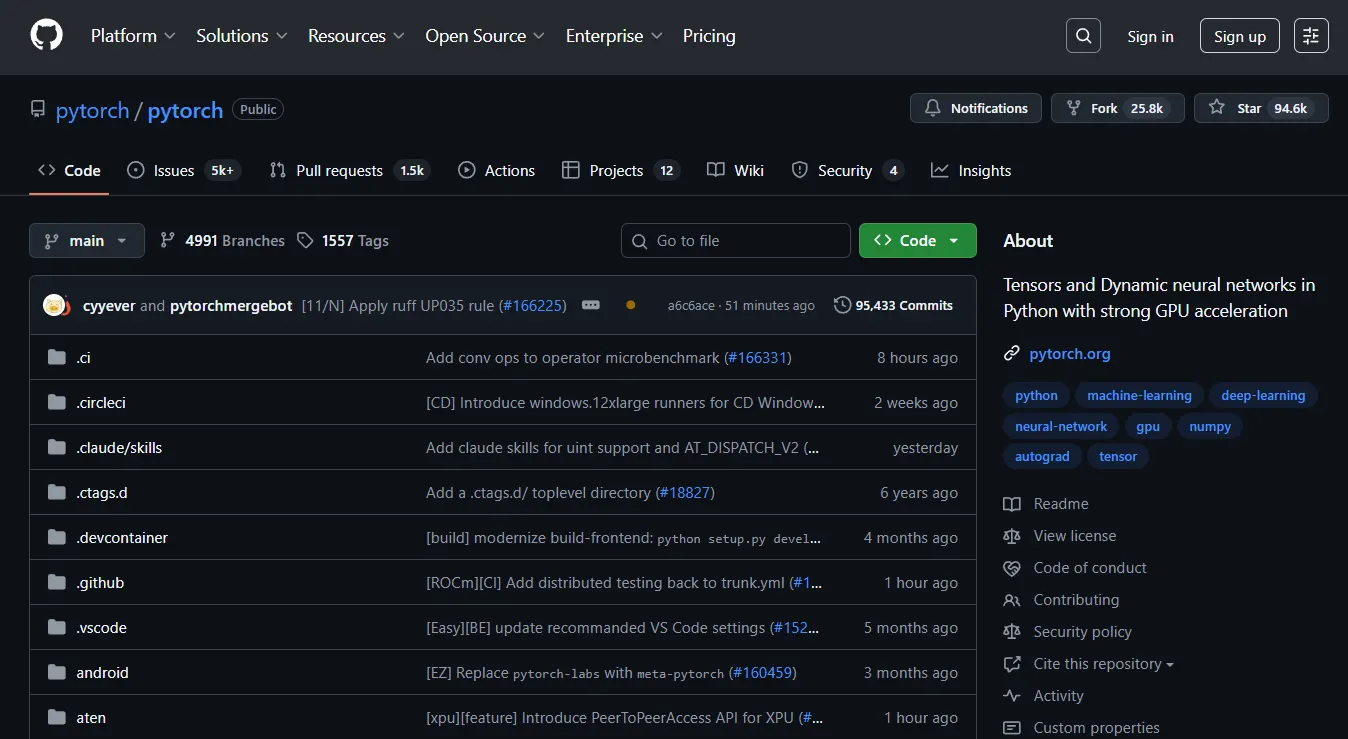

PyTorch:GPU加速、动态网络,深度学习平台的不二之选!

项目地址:https://github.com/pytorch/pytorch

主要语言:Python

stars: 94.6k

核心功能

PyTorch 是一个 Python 包,提供两大高级特性:

- 具备强大 GPU 加速功能的张量计算(类似于 NumPy)。

- 基于磁带式自动求导系统构建的深度神经网络。

它由多个组件构成:

torch:类似 NumPy 的张量库,支持强大的 GPU 计算。torch.autograd:基于磁带的自动求导库,支持torch中所有可微分的张量操作。torch.jit:一个编译栈(TorchScript),用于从 PyTorch 代码创建可序列化和可优化的模型。torch.nn:与自动求导深度集成的神经网络库,设计具有最大灵活性。torch.multiprocessing:Python 多进程,能在进程间实现torch张量的神奇内存共享,对数据加载和 Hogwild 训练很有用。torch.utils:包含DataLoader等实用工具函数,使用方便。

优势

- GPU 就绪的张量库:提供可在 CPU 或 GPU 上运行的张量,极大加速计算,拥有丰富的张量操作例程。

- 动态神经网络:基于磁带的自动求导:采用反向模式自动求导技术,可任意改变网络行为,零延迟、无开销,是该技术的快速实现之一。

- Python 优先:深度集成到 Python 中,可自然使用,还能利用喜欢的 Python 库扩展功能。

- 命令式体验:设计直观、易于使用,代码执行无异步视图,调试和错误处理简单。

- 快速轻量:框架开销极小,集成多种加速库,CPU 和 GPU 后端成熟,内存使用高效。

- 轻松扩展:编写新的神经网络模块或与张量 API 交互简单,支持用 Python 或 C/C++ 编写扩展。

安装方式

- 二进制安装 :可通过 Conda 或 pip 安装,具体命令见 官网。NVIDIA Jetson 平台有专门的 Python 轮子和 L4T 容器。

- 从源码安装:需要 Python 3.10 及以上版本、支持 C++17 的编译器,Windows 还需 Visual Studio 或 Visual Studio Build Tool。支持 NVIDIA CUDA、AMD ROCm 和 Intel GPU 等不同硬件,安装过程包括获取源码、安装依赖和安装 PyTorch 等步骤,还可调整构建选项。

- Docker 镜像:可使用预构建的镜像,也能自己构建。

- 文档构建:需要 Sphinx 和 pytorch_sphinx_theme2,可构建多种格式的文档,包括 PDF。

应用场景

- 替代 NumPy:利用 GPU 进行科学计算。

- 深度学习研究:作为研究平台,提供最大的灵活性和速度。

私藏本地AI神器AgenticSeek,隐私无忧还能自主干活!

agenticSeek 是一个完全本地运行的自主智能体AI工具。简单讲,它是一个无需联网、不依赖API、能在本地自动思考、浏览网页和编写代码的AI助手,只需付出电费成本。适用人群:注重隐私、希望低成本使用AI进行自动化任务的开发者和技术爱好者。

项目地址:https://github.com/Fosowl/agenticSeek

主要语言:Python

stars: 23.1k

项目概述

AgenticSeek 是一款 100% 本地化的 AI 助手,作为 Manus AI 的替代方案,它能在保证数据完全存储在本地设备的前提下,自主浏览网页、编写代码和规划任务。该项目专为本地推理模型设计,无需依赖云端,保障了用户数据的隐私安全。

项目优势

- 完全本地与隐私保护:所有操作都在本地设备上运行,无需云端支持,不会进行数据共享,确保用户的文件、对话和搜索记录的隐私性。

- 智能网页浏览:可自动进行网页搜索、阅读、信息提取和表单填写等操作,无需人工干预。

- 自主编程助手:能够独立编写、调试和运行 Python、C、Go、Java 等多种编程语言的程序。

- 智能代理选择:根据用户的需求自动选择最合适的代理,如同拥有一支专业团队随时提供帮助。

- 复杂任务规划与执行:可以将大型任务分解为多个步骤,并利用多个 AI 代理完成,适用于旅行规划和复杂项目等场景。

- 语音交互功能:支持语音输入和输出,让用户能像在科幻电影中与个人 AI 交流一样与它对话(该功能正在开发中)。

安装与配置

前提条件

- Git:用于克隆项目仓库。

- Python 3.10.x:建议使用此版本,其他版本可能导致依赖错误。

- Docker Engine 与 Docker Compose:用于运行如 SearxNG 等捆绑服务。

安装步骤

-

克隆仓库并设置:

git clone https://github.com/Fosowl/agenticSeek.git

cd agenticSeek

mv .env.example .env -

修改 .env 文件内容:根据需要更新文件中的各项配置,如服务端口、工作目录和 API 密钥等。API 密钥对于选择本地运行 LLM 的用户是可选的。

-

启动 Docker :确保 Docker 已安装并运行,可通过相应命令启动 Docker 服务,并使用

docker info验证其是否正常运行。

运行模式

本地运行 LLM

- 硬件要求:运行本地 LLM 需要足够的硬件资源,至少需要一个能够运行 Magistral、Qwen 或 Deepseek 14B 的 GPU。

- 配置本地提供商 :选择合适的本地提供商(如 Ollama、LM Studio 等),启动服务并更新

config.ini文件中的相关配置。

使用 API 运行

- 选择 API 提供商并获取 API 密钥:可选择 OpenAI、Google Gemini 等提供商,访问其网站注册并获取 API 密钥。

- 设置环境变量:将 API密钥设置为环境变量,不同操作系统的设置方法不同。

- 更新

config.ini文件 :将is_local设置为False,并根据选择的提供商和模型更新相应配置。

启动服务与运行

Docker 模式(使用 Web 界面)

./start_services.sh full # MacOS

start start_services.cmd full # Windows此步骤可能需要下载和加载 Docker 镜像,耗时较长。启动服务后,等待后端服务完全运行,然后访问 http://localhost:3000/ 即可看到 Web 界面。

CLI 模式

先在主机上安装相关包,修改 config.ini 中的 SEARXNG_BASE_URL,启动所需服务,最后使用 uv run cli.py 运行 CLI 界面。

使用方法

确保服务已启动,可通过 Web 界面或 CLI 界面与 AgenticSeek 交互。输入查询后,它会自动分配最合适的代理执行任务。由于该项目处于早期原型阶段,建议用户在提问时尽量明确需求。

语音识别功能

目前语音识别功能仅支持 CLI 模式和英语。要启用该功能,需在 config.ini 文件中将 listen 设置为 True,并设置 agent_name 作为触发关键词。

配置说明

config.ini 文件包含了项目的主要配置信息,分为 [MAIN] 和 [BROWSER] 两个部分,分别用于设置 LLM 提供商、会话恢复、语音功能和浏览器模式等参数。

故障排除

文档中详细列出了常见问题及解决方案,如 ChromeDriver 版本不兼容、连接适配器问题和 SearxNG 基础 URL 未提供等。

常见问题解答

- 硬件要求:不同模型大小对 GPU 的 VRAM 要求不同,建议根据实际需求选择合适的硬件。

- 错误处理 :确保本地服务运行正常,

config.ini文件配置正确,依赖项已安装。如问题仍未解决,可提交问题报告。 - 本地运行:使用 Ollama、LM Studio 或 server 提供商时,所有语音识别、LLM 和文本转语音模型均可在本地运行。

- 与 Manus 的比较:AgenticSeek 更注重独立性、隐私保护和避免 API 成本。

- 项目团队:由开发者及其两位朋友维护,还有来自开源社区的贡献者。