😊文章背景

题目:Brain-Like Cognition-Driven Model Factory for IIoT Fault Diagnosis by Combining LLMs With Small Models

期刊:IEEE

检索情况:计算机科学TOP EI检索 SCI升级版 计算机科学2区 SCI基础版 工程技术1区 IF:8.9

作者:Yuru Liu , Weishan Zhang , Member, IEEE, Zhicheng Bao , Xudong Chai, Mu Gu, Wei Jiang, Zichao Zhang, Ye Tian, and Fei-Yue Wang

单位:中国石油大学(华东)

发表年份:2025

❓ 研究问题

工业故障诊断面临的三大痛点:

-

**数据异构性:**工业现场设备多样,数据格式、特征空间千差万别(非独立同分布,Non-IID),导致传统诊断模型泛化能力差。

-

**知识壁垒:**故障诊断高度依赖专家经验,但专家资源稀缺,知识难以沉淀和复用。一线运维人员面对复杂故障时,人机交互效率低下。

-

"大模型"与"小模型"的困境:

-

**大语言模型:**虽具备强大的通用知识和自然语言交互能力,但难以直接、精确地处理和分析实时、异构的传感器数据,且存在"幻觉"问题。

-

**小模型:**虽在特定任务上高效、精准,但缺乏通用知识和推理能力,无法理解复杂的人类语言指令,难以适应动态变化的环境。

-

📌 研究目标

融合LLM的认知能力与小模型的执行能力,模仿人脑处理问题的认知流程,在保证数据隐私的前提下,实现跨多个数据源(纵向联邦学习场景)的协同精准诊断。

🧠 所用方法

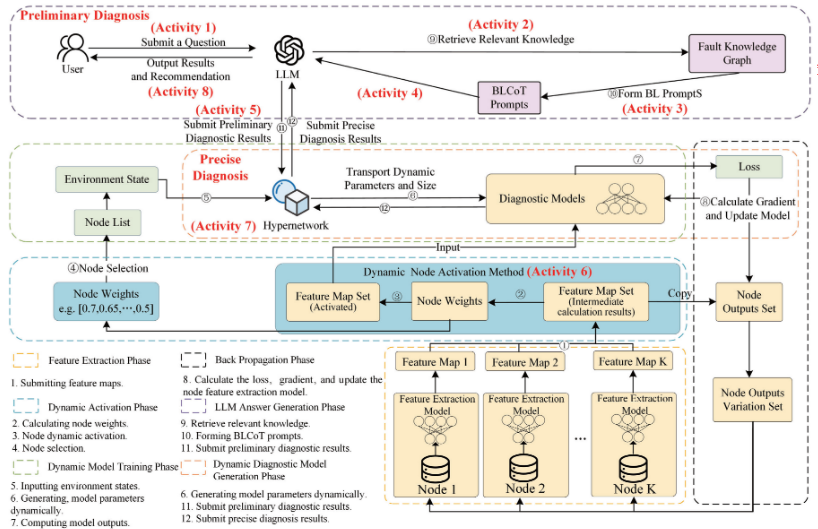

整体框架:脑体协同的完美闭环

BC-MF框架的强大之处在于它构成了一个完整的智能决策闭环:

-

LLM(大脑) 完成认知层面的初步诊断(result_initial)。

-

GVFL(身体) 完成执行层面的精确诊断(result_precise)。

-

结果再次反馈给LLM ,由其整合信息,生成最终的、包含具体维护方案的人性化解释与建议,交付给用户。

一、大脑级认知------大语言模型驱动的类脑思维链

传统的LLM在工业领域直接应用时,存在"幻觉"和缺乏领域知识的问题。我们并未采用简单的微调,而是设计了一种**类脑思维链(Brain-like Chain of Thoughts, BLCoT)**提示工程方法:

-

**问题接收与关键词提取(感知):**LLM接收用户以自然语言描述的问题(如"设备振动加剧并伴有异响"),并提取关键症状词汇。

-

知识关联(联想记忆): 这些关键词被发送到外部的**故障知识图谱(Fault Knowledge Graph, FKG)**中进行查询。该图谱如同一个庞大的专家知识库,存储了故障、症状、部件间的复杂关系。

-

**形成诊断思路(初步推理):**LLM将检索到的知识与原始问题融合,形成一个逻辑严谨的、包含"让我们一步步思考"指令的BLCoT提示。这个过程迫使LLM进行可解释的推理。

-

输出初步诊断(判断): LLM基于BLCoT提示,输出一个初步诊断结果(如"可能为轴承磨损或转子不平衡")。

核心创新: 为了克服LLM在专业领域可能存在的'幻觉'问题并提升其推理可靠性,本研究采用了类脑思维链提示工程方法 。该方法通过引入外部故障知识图谱 对LLM的推理过程进行约束和引导,使其初步诊断不再是黑箱生成,而是成为一种可解释、有据可循的逻辑推理。

二、身体级执行------生成式纵向联邦学习

当"大脑"完成初步判断后,需要"手脚"去执行具体的检查。面对工业数据分散、异构、隐私要求高的挑战,我们提出了生成式纵向联邦学习(Generative Vertical Federated Learning, GVFL)。

-

核心思想: 摒弃传统"一个模型走天下"的思路,转向 **"按需定制,动态生成"**的模型工厂模式。

-

工作流程(模拟人体的神经激活与精准操作):

-

**动态节点激活机制(神经激活):**系统根据初步诊断结果,构建了一个两层神经网络,首先计算节点的激活权重,然后将基于激活权重动态激活和选择节点与特征以参与本轮训练,避免了资源浪费。

-

模型生成(打造专用工具): 一个超网络(Hypernetwork) 被启动。它接收两大输入:LLM的初步诊断结果 + 被激活节点的特征信息。超网络据此实时生成一套全新的、为当前故障量身定制的诊断小模型的参数。

-

精确诊断(精准操作): 这个刚被"制造"出来的专用模型,立即对各方数据进行分析,得出精确的诊断结果(如"确诊为轴承内圈磨损,故障程度为二级")。

-

-

核心创新:

-

**动态适应性:**模型参数是动态生成的,能完美适应每次诊断时不同的数据特征组合,解决了异构数据的难题。

-

**隐私与效率:**数据始终保留在本地,仅上传中间特征(非原始数据),并通过节点激活机制大幅降低了通信成本。

-

🧪 实验设计与结果

- 实验目的:

- 1.评估BLCoT引导大型语言模型(LLM)获得正确响应的能力。

- 2.评估BC-MF框架解决故障诊断问题的能力。

- 3.评估使用GVFL执行故障诊断任务的性能。

- **数据集:**使用五个工业物联网(IIoT)数据集进行验证。

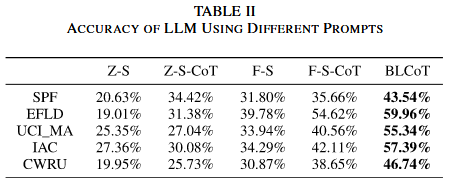

实验一:评估BLCoT引导大型语言模型(LLM)获得正确响应的能力。

- **基线对比方法:**使用零样本(Z-S)、零样本思维链(Z-S CoT)、少样本(F-S)和少样本思维链(F-S CoT)提示方法进行对比实验。

- **评价指标:**准确率

- 实验结果:通过与其他提示方法(零样本、思维链等)对比,证明BLCoT提示能显著提升LLM在故障诊断任务中的准确性。

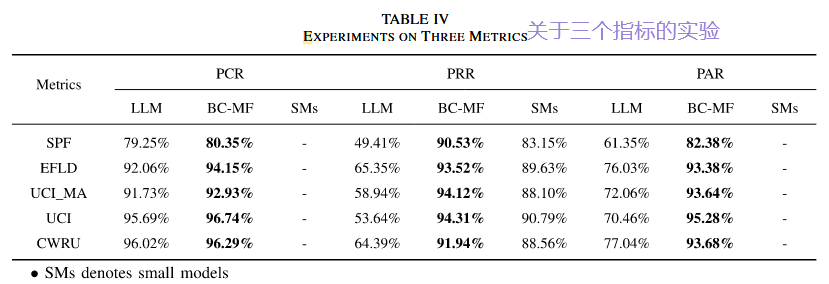

实验二:评估BC-MF框架解决故障诊断问题的能力。

- **基线对比方法:**ChatGPT, ChatGLM3, and LLaMA2

- 评价指标: 问题理解率 (PCR)、问题解决率 (PRR)、问题解答率 (PAR)

- 实验结果 :BC-MF在所有数据集和所有评估指标上均取得最佳性能,证明了其协同架构的强大优势

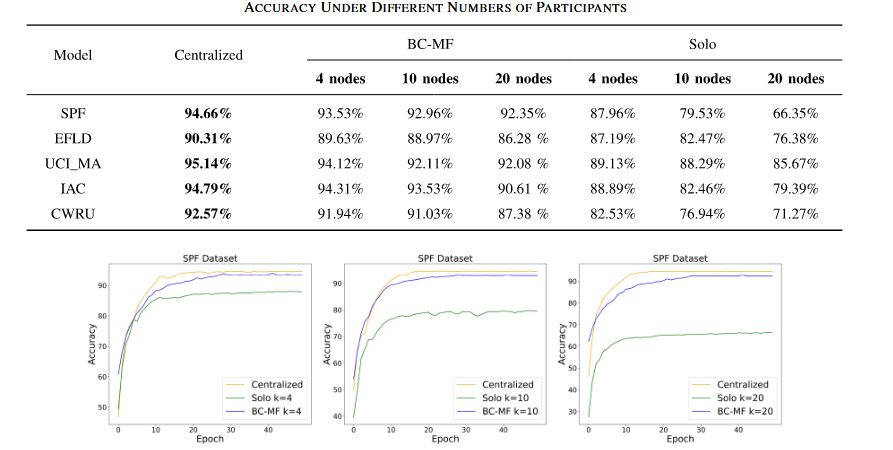

实验三:评估使用GVFL执行故障诊断任务的性能

- 生成式垂直联邦学习中训练模型的准确性:

- 基线对比方法:集中式和单机方法

- 评价指标:准确率

- 实验结果:

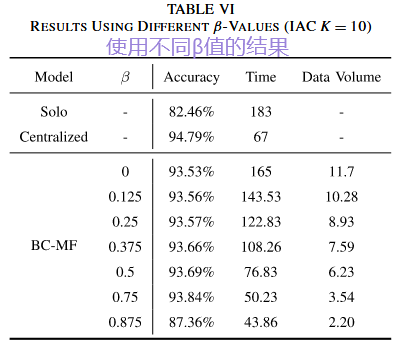

- 节点选择评估: β 参数控制动态节点激活方法中的选择强度

- 基线对比方法:使用随机选择方法。

- 实验结果:

- **实验结论:**GVFL的诊断精度接近理想的"集中式训练"(数据共享的理想情况),且远优于"单独训练",同时通信效率更高。

✅ 研究结论

-

成功提出并验证了BC-MF框架,它巧妙地融合了LLM的认知智能与小模型的计算智能。

-

通过BLCoT 和GVFL 两大创新,实现了精准、自适应、高交互性的工业故障诊断,有效解决了数据异构和知识壁垒的行业难题。

-

实验证明,该框架性能显著优于现有主流方法,为LLM在工业领域的落地提供了一种行之有效的新范式。

📈 研究意义

实现了一种**'脑体协同'的智能诊断新范式** 。它将LLM的通用认知能力 与小型化模型的专用计算效率 深度融合,通过仿生的闭环设计 ,最终实现了兼具专家级交互体验 和仪器级诊断精度的卓越性能。"

🔮 未来研究方向

-

**引入强化学习:**探索使用强化学习进一步优化框架中的超参数(如节点选择策略),使系统具备自我优化的能力。

-

**扩展应用场景:**将BC-MF框架应用于更广泛的工业场景,如预测性维护、生产流程优化等。

-

**探索多模态融合:**研究如何将图像、音频等多媒体数据与传感器数据、文本知识相结合,构建更全面的故障感知系统。

⭐个人总结

对文章的总结:

- 用户向LLM提出问题后,LLM采用类脑思维链提示工程方法进行初步诊断 :

- 首先提取出问题的关键词;

- 然后LLM在知识库中根据关键词进行检索,找到相关知识,并生成提示;

- LLM根据提示完成初步诊断;

- 初步诊断后,通过生成式纵向联邦学习进行精确诊断 :

- 首先根据初步诊断的结果,通过动态节点激活机制,选择适合的节点激活,

- 然后超网络根据激活的节点信息和初步诊断生成解决这次问题的专属小模型,由小模型得出精确的诊断结果,

- 最后再将精确的诊断结果反馈给用户。

收获与启发:

- 将大模型和小模型结合,优势互补;

- 了解了联邦学习(横向联邦学习、纵向联邦学习和联邦迁移学习);

- 用类脑思维链代替微调。

📕专业名词

核心概念与模型

-

IIoT (Industrial Internet of Things) - 工业物联网

- 定义: 指在工业环境中,将机器、传感器和设备通过网络连接起来,用于收集和分析数据,以实现智能制造和预测性维护。

-

LLM (Large Language Model) - 大语言模型

- 定义: 一种强大的人工智能模型(如ChatGPT),经过海量文本数据训练,能够理解、生成人类语言,并提供通用知识和人机交互能力。

-

VFL (Vertical Federated Learning) - 纵向联邦学习

- 定义: 一种联邦学习技术,适用于多个参与方拥有相同样本但不同数据特征(即特征空间不同)的场景。它允许在不共享原始数据的情况下,共同训练一个模型,以保护数据隐私。

-

GVFL (Generative Vertical Federated Learning) - 生成式纵向联邦学习

- 定义: 本文提出的一种VFL变体。它不仅能进行协同训练,还能根据动态变化的数据特征,实时生成个性化的、适用于当前任务的小模型参数。

-

BC-MF (Brain-Like Cognition-Driven Model Factory) - 类脑认知驱动的模型工厂

- 定义: 本文提出的核心框架。它模仿人脑处理问题的认知过程(如接收、记忆、推理、实践),利用LLM作为"大脑"进行协调,并动态生成小模型来适应具体任务。

-

BLCoTs (Brain-Like Chain of Thoughts) - 类脑思维链

- 定义: 一种专为LLM设计的提示方法。它模仿人脑的联想推理过程,通过多轮提示和外部知识库(如故障知识图谱)的辅助,引导LLM进行更准确、更符合逻辑的逐步推理。

-

Hypernetwork - 超网络

- 定义: 一种"生成其他网络的网络"。在本文中,它接收环境状态(如激活了哪些节点)作为输入,然后输出一个专门为当前状态定制的小模型的参数。

-

FKG (Fault Knowledge Graph) - 故障知识图谱

- 定义: 一个结构化的外部知识库,以图形方式存储了故障相关的实体(如部件、现象)和它们之间的关系(如"导致"、"表现为"),用于为LLM提供领域专业知识。

评估指标

-

PCR (Problem Comprehension Rate) - 问题理解率

- 定义: 衡量LLM正确理解用户问题并提取关键信息的比例。

-

PRR (Problem Resolution Rate) - 问题解决率

- 定义: 衡量模型(小模型或整个系统)正确预测故障类型的准确率。

-

PAR (Problem Answering Rate) - 问题回答率

- 定义: 一个综合性指标,用于评估LLM最终给出的答案(包括故障分类和维修建议)的质量,综合考虑了文本相似度、流畅度等因素。

其他技术术语

- 联邦学习

- **定义:**联邦学习(Federated Learning)是一种新兴的人工智能基础技术,其设计目标是在保障大数据交换时的信息安全、保护终端数据和个人数据隐私、保证合法合规的前提下,在多参与方或多计算结点之间开展高效率的机器学习。其中,联邦学习可使用的机器学习算法不局限于神经网络,还包括随机森林等重要算法。联邦学习有望成为下一代人工智能协同算法和协作网络的基础。

联邦学习(Federated Learning)-CSDN博客

-

Small Models - 小模型

- 定义: 与LLM相对,指规模较小、专用于特定任务的模型(如传统的神经网络)。它们计算效率高,但缺乏通用知识。

-

Non-IID (Non-Independent and Identically Distributed) - 非独立同分布

- 定义: 指数据在不同来源或不同时间点的统计分布不一致。这是分布式学习(如联邦学习)中的一个常见挑战,会导致模型性能下降。

-

Chain of Thought (CoT) - 思维链

- 定义: 一种提示技术,通过鼓励模型"一步一步地思考"来分解复杂问题,从而提高推理能力。BLCoTs是在此基础上的增强版本。