编者按: 推理模型的"推理能力"飞跃,究竟是模型本身的进步,还是工程编排的巧妙包装?

我们今天为大家带来的这篇文章提出了一个尖锐的观点:所谓"推理模型"的突破,本质上并非模型智能的根本性提升,而是通过工具调用与流程编排对模型能力停滞所做的工程性补偿。

文章深入剖析了 GPT-5 等最新模型在执行任务时严重依赖 Python 沙箱、API 调用等外部工具的现象,揭示出大语言模型在代码生成与语义理解上的深层瓶颈。作者指出,OpenAI 正从基础研究转向应用变现,其推出的 ChatGPT Apps、Atlas 浏览器等产品,反映的不是技术突破,而是对模型能力停滞的策略性回避。文章进一步探讨了行业面临的两种路径选择:一是在现有架构上不断优化 pipeline 系统,追求短期收益;二是直面 Transformer 架构的根本缺陷,投入高风险、长周期的基础架构创新。

本文系原作者观点,Baihai IDP 仅进行编译分享

作者 | Mani Doraisamy

编译 | 岳扬

01 工具使用(tool use)是如何成为难题求解的替代方案

当 OpenAI 于 2024 年 4 月发布 o1,并称之为"推理模型"时,整个行业为之欢呼,认为这是一次重大突破。终于,AI 能够一步步思考、解决复杂问题,甚至处理研究生级别的数学题了。

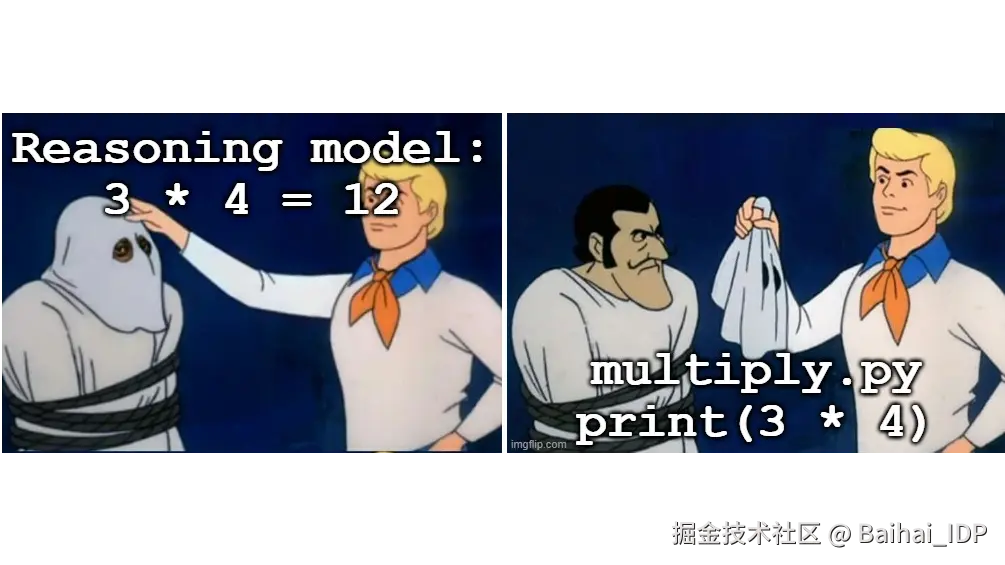

但仔细观察其运行机制我们就会发现,当我们让最新模型 ChatGPT-5 计算两个大数的乘积时,它并不会自己进行计算,而是生成一段 Python 代码,在沙箱中执行后返回结果。相比之下,ChatGPT-3 至少还会尝试在内部完成算术运算(尽管常常出错),而 ChatGPT-5 则将计算任务外包给了外部工具。[注释1]

这种模式无处不在。所谓"Agentic AI"的自主性?无非是一连串的工具调用,比如网页搜索、API 调用、数据库查询。真正的突破并不在于模型本身的智能水平,而在于协调外部系统的编排层。从推理能力到 Agentic AI,一切都不过是代码生成的高级应用。 这些能力并非模型本身的进步,而是为停滞不前的模型能力所设计的工程层面的变通方案。

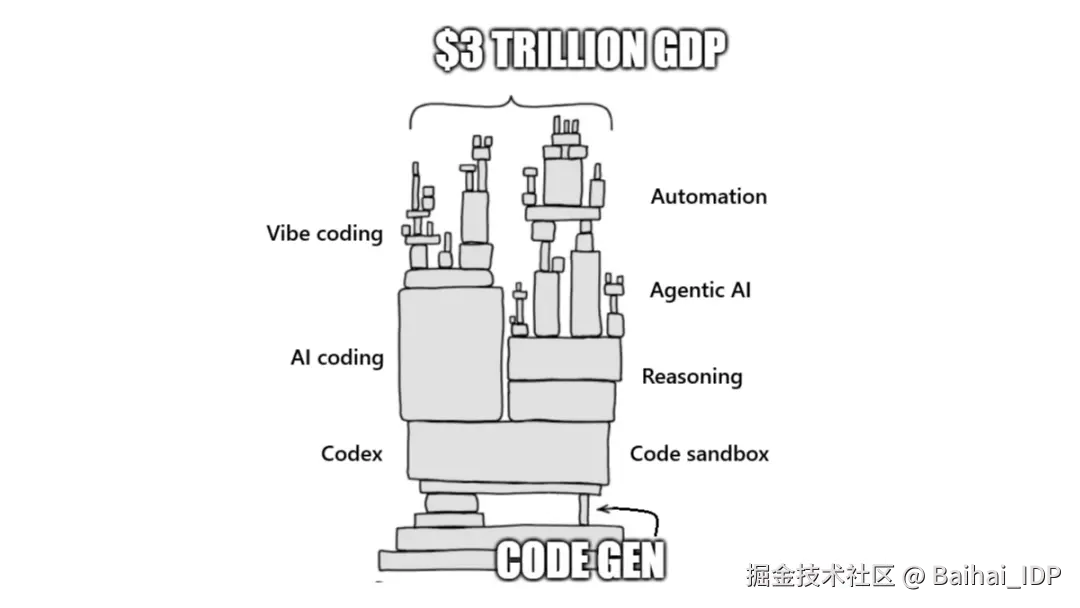

这一点至关重要,因为整个 AI 行业(从数万亿美元的 GDP 预测到独角兽公司的估值[1])都建立在模型能力持续进步的预期之上。而我们实际得到的,却是越来越复杂的"pipeline 工程",其底层基础却早已陷入停滞。

02 GPT-5:皇帝的新推理(不是"衣服"😏

2025 年 8 月本该是一场胜利。OpenAI 曾承诺"将博士级智能装进每个人的口袋",然而他们交付的成果在代码生成这一核心能力上几乎停滞不前 ------ 而其他能力都依赖于此。这正是瓶颈所在:代码生成是交通枢纽。更好的代码 → 更强的推理(通过工具执行)→ 更优的智能体 → 更高的生产力 → 万亿美元级市场。 一旦这个交通枢纽停滞,整条链条便随之停摆。

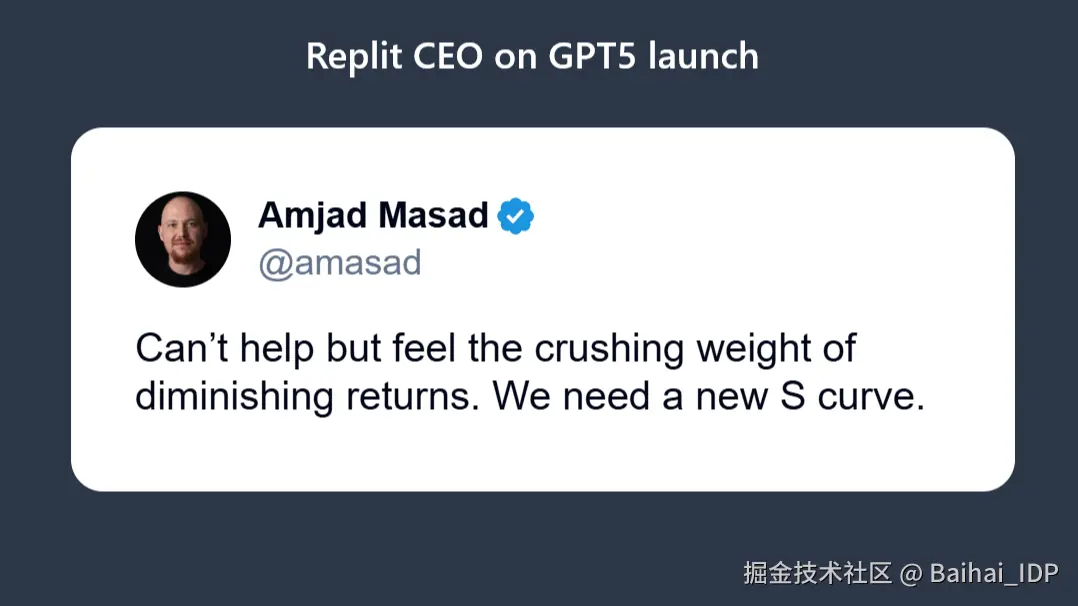

使用 AI 编程工具的开发者们明显感到了失望。基于 OpenAI 模型构建 AI 编程工具的公司(如 Cursor、Replit)曾押下数十亿美元,赌定每次模型发布都会带来指数级的进步。GPT-5 却打破了这一预期,而这本不该发生。从 GPT-3 笨拙的算术能力,到 GPT-4 生成连贯代码的能力,进步似乎势不可挡。整个行业正是建立在对持续进步的预期之上。但在过去一年里,这种进步明显停滞了。

03 从研究实验室到应用商店

与此同时,OpenAI 正将重心从模型研究转向应用开发。只需观察 OpenAI 在过去几个月的轨迹,这一趋势便已显而易见:

2025 年 10 月 6 日:ChatGPT Apps 上线

第三方应用可直接在 ChatGPT 内运行。通过 Expedia 预订航班,在 Canva 中设计图像,浏览 Zillow 上的房产信息,全程无需离开聊天界面。Apps SDK 为开发者开放了 8 亿用户生态。这标志着 OpenAI 正在变成一个应用商店。

2025 年 10 月 21 日:Atlas 浏览器发布

这是一款由 AI 驱动的新型网页浏览器,意在挑战 Chrome 的主导地位。该产品具备浏览器记忆、智能体模式,以及集成于浏览器的全链路 AI 助手。这标志着 OpenAI 正在转型为一家消费级产品公司。

他们正逐步从研究领域转向技术应用:

- 推理模型(贴近最前沿、最基础的核心研究)

- 带工作流构建器的 Agentic AI(离核心研究距离更远了)

- ChatGPT Apps(纯粹的生态运营)

- Atlas 浏览器(将 ChatGPT 深度嵌入浏览器)

OpenAI 的每一步都在远离"如何构建更优模型",迈向"如何将现有模型变现"。

04 关于 OpenAI 转型动因的两种解读

为何这家全球顶尖的 AI 实验室会从技术研究转向应用领域?现有两种主流解释。

解读一:遭遇技术瓶颈却秘而不宣

规模扩张已然失效。尽管投入数十亿美元的算力资源和全球顶尖的研究人员,模型质的飞跃却难再现。模型并未变得更智能,只是更擅长协调外部工具。

与其承认"无法突破模型性能瓶颈",不如转向变现赛道。ChatGPT Apps 无需技术研究实现突破即可创收,浏览器生态不依赖 GPT-6 就能构建用户壁垒。在摸索下一步方向时,应用业务能为他们争取缓冲时间 ------ 当然,这是一种悲观的解读:将技术进步的停滞包装成战略转型。

解读二:应用赛道的利润更丰厚

训练尖端模型耗资数十亿、历时数载,而基于现有模型开发应用成本低、见效快。后者利润空间更大,风险更低,变现路径更清晰。

或许 OpenAI 经过理性测算,发现应用开发能以更小投入获取更大回报,因而调整资源分配。既然六个月就能打造浏览器,何必耗费 50 亿美元训练 GPT-6?这是从现实主义的视角进行解读:利润空间优先于技术进步。

这两种解读可能都部分正确。但无论如何,结果殊途同归:当整个生态系统最需要突破时,领头羊却减少了对基础模型研发的投入。

05 没人愿面对的架构问题

工具编排(Tool orchestration)确实是令人印象深刻的工程成果。协调网页搜索、代码执行、数据库查询和 API 调用,需要复杂的软件架构。能够管理复杂工作流的智能体框架也的确具备实际价值。但这些都并未回答一个根本问题:模型为何从一开始就离不开工具?

早期模型如 GPT-3 曾饱受词元碎片化(token fragmentation)的困扰(例如将 "strawberry" 拆成 "straw" 和 "berry",而后者含义完全不同)。现代分词器已缓解了这一问题,但更深层的架构缺陷依然存在:大语言模型仍然缺乏真正的语义理解能力。这类语义问题在代码生成中尤为致命,因为代码对精确性要求极高。 当模型产生幻觉,或在长上下文中丧失连贯性时,引入网络搜索功能并不能根除病灶。固定维度的嵌入(embeddings)会有损地压缩语义信息,注意力窗口则对上下文施加了硬性边界。这些都是架构层面的限制,而非工程问题。

这就好比在一座仅能支撑三层楼的地基上建造摩天大楼。你可以不断加固结构、重新分配承重、安装精密的支撑系统,但最终,你需要的是一个全新的地基。无论围绕现有地基做多少精巧的工程优化,都无法让你建得更高。

06 行业必须面对的抉择

整个行业站在十字路口,尽管多数参与者仍在回避这个现实。

路径一:持续优化 pipeline 系统

延续当前轨迹:略微扩大模型规模,优化工具协调机制,深化与应用平台的整合。推出浏览器与应用商店,构建更完善的智能体框架,在既定架构限制下进行工程优化。

这条路径能带来可预测的短期收益。对许多尚未达到 AI 编程工具智能水平的领域而言尤其如此。由于 AI 编程工具最初是由开发者为自己打造的,他们深刻理解问题所在,并知道如何解决。类似的进步将在其他领域陆续出现,风险投资的资金流仍会持续一段时间。但 a16z 预测的 3 万亿美元 GDP 增长,其前提是生产力翻倍,而不是像当前 AI 编程工具那样仅停在约 20% 的提升水平。要实现突破,必须承认现有基本方法已遇阻。

路径二:承认我们需要全新的基础架构

承认模型规模扩大已触及天花板,投入能解决根本问题的架构创新。这意味着:

- 采用基于图结构的架构,保留结构化关系,避免分词造成的语义碎片化问题,根治 Transformer 架构的固有缺陷;

- 部署能高效处理长上下文的稀疏注意力机制;

- 借鉴生物神经组织原理的神经形态计算方案。

解决方案在于构建能保留信息而非有损压缩的架构。正如 AI 研究者 Andrej Karpathy 所言,现有模型只是"互联网的有损压缩"。真正的进步需要向无损表征迈进:保留原始信息中固有的组织形式、精确维护信息单元之间的具体关系、维护信息中概念的层级与从属关系。

这条路径成本高昂、前景未卜且进展缓慢。它要求我们直面现有路线的失败,且需要耗费数年的研究投入,且不保证成功。但这是唯一能真正解决问题而非回避问题的途径。

07 总结

目前,AI 编程工具市场正呈爆发式增长:

- Cursor:15 个月实现 5 亿美元年经常性收入(ARR),估值达 100 亿美元

- GitHub Copilot:数百万用户,年收入达数亿美元

- Windsurf:以 24 亿美元被收购

- 数十家初创公司正在融资,金额高达九位数

这一切都建立在同一个假设之上:模型在代码生成能力上将持续进步。如果这个假设是错的,整个市场就会变成一座纸牌屋 ------ 3 万亿美元的 GDP 预期将化为泡影,独角兽估值将失去支撑,生产力革命也将无限期推迟。

反之,谁若能解决底层架构问题,谁就将赢得一切。哪怕只是基础能力的小幅提升,也会在整个生态系统中产生连锁反应:

- 更优的代码生成能力 → 更强的推理能力(通过工具执行实现)

- 更强的推理能力 → 更强大的智能体

- 更强大的智能体 → 真正实现生产力翻倍

- 真正实现生产力翻倍 → 3 万亿美元市场成为现实

由此创造的价值将是天文数字。现在的问题是:是否有任何实验室愿意选择艰难的"修复地基"之路,而不是轻松地在停止加固的地基上继续搭建应用? 答案将决定这场 3 万亿美元的生产力革命究竟是现实,还是幻想。

注释:

1\] GPT-5 中有两种方式进行乘法运算: * Python 模式:使用 Python 沙箱执行 * 无工具模式:依赖模型内部推理 在 FrontierMath 基准测试中,Python 模式的准确率约为无工具模式的 2 倍(26.3% 对 13.5%),同时成本效益高出 4 到 10 倍。 GPT-5 API 默认使用无工具模式(必须在 API 调用中显式启用工具),而 ChatGPT 用户端很可能默认启用 Python 模式,因为"高级数据分析"(Advanced Data Analysis)已对所有订阅用户默认开启。这使得 OpenAI 在消费级产品中实现了大幅成本优化,而 API 用户若不手动启用工具使用,则需承担低效推理的全部成本。 **END** **本期互动内容 🍻** **❓文章指出,整个 AI 生态的繁荣建立在"代码生成能力持续进步"的假设上。你怎么看待这个观点?** **文中链接** \[1\][a16z.com/the-trillio...](https://link.juejin.cn?target=https%3A%2F%2Fa16z.com%2Fthe-trillion-dollar-ai-software-development-stack%2F "https://a16z.com/the-trillion-dollar-ai-software-development-stack/") ***本文经原作者授权,由** **Baihai IDP** **编译。如需转载译文,请联系获取授权。*** **原文链接:** [manidoraisamy.com/reasoning-n...](https://link.juejin.cn?target=https%3A%2F%2Fmanidoraisamy.com%2Freasoning-not-ai.html "https://manidoraisamy.com/reasoning-not-ai.html")