1. 引言

发展历程:

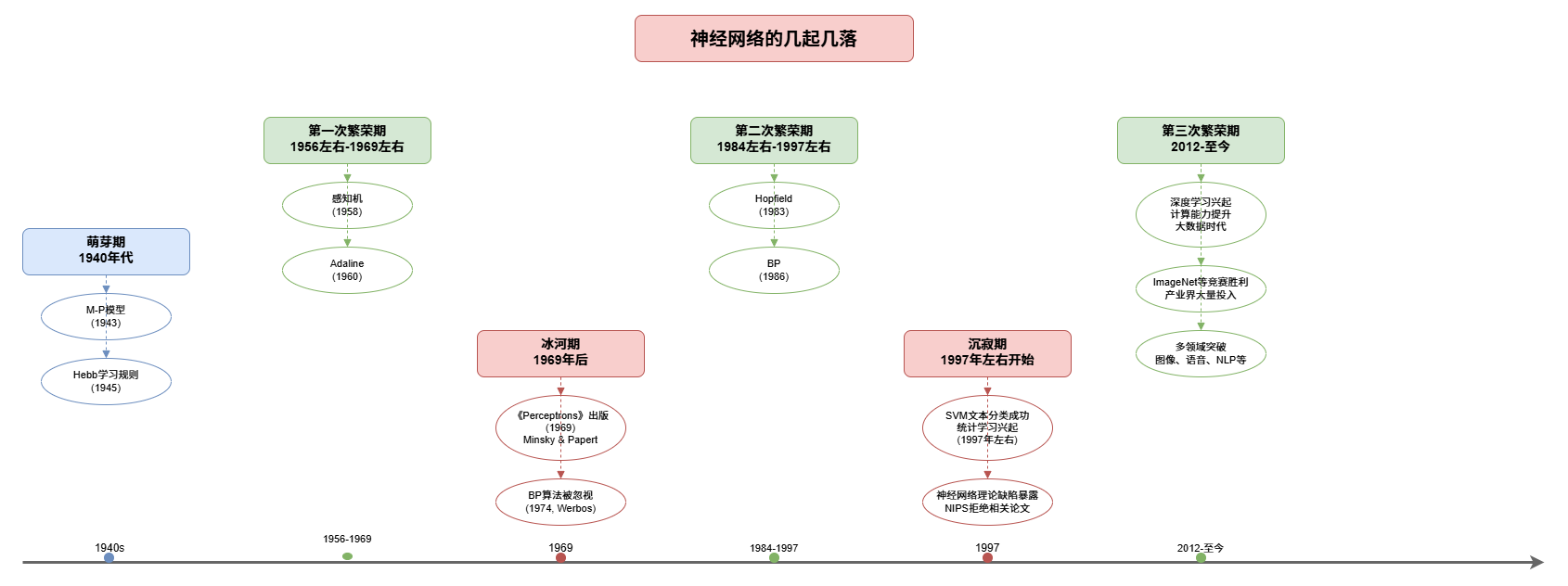

神经网络的发展并非一帆风顺,经历了多次起起落落。从最初的兴奋到低谷,再到重新崛起,神经网络研究经历了几个重要的历史阶段。

2. 萌芽期与第一次繁荣期(1940年代-1969年左右)

2.1 萌芽期(1940年代)

M-P神经元模型:

1943年,McCulloch和Pitts提出了M-P神经元模型,这是神经网络研究的理论基础,为后续研究奠定了基础。

Hebb学习规则:

1945年,Donald Hebb提出了Hebb学习规则,描述了神经元之间连接强度如何通过经验进行调整,这是神经网络学习机制的重要理论基础。

2.2 第一次繁荣期(1956年左右-1969年左右)

感知机:

1958年,Frank Rosenblatt提出了感知机(Perceptron),这是第一个能够学习的神经网络模型,引起了广泛关注。

Adaline:

1960年,Bernard Widrow和Marcian Hoff提出了Adaline(Adaptive Linear Neuron),进一步推动了神经网络研究的发展。

第一次繁荣期的特点:

- 神经网络研究开始兴起

- 出现了多个重要的理论模型

- 人们对神经网络的前景充满乐观

- 研究进入繁荣期

3. 冰河期(1969年后)

3.1 《Perceptrons》的出版

关键事件:

1969年,Marvin Minsky(1927-2016,1969年图灵奖得主)和Seymour Papert出版了《Perceptrons》一书。

主要观点:

书中指出:

- 单层神经网络无法解决非线性问题

- 多层网络的训练算法在当时看来并不乐观

影响:

这本书的出版对神经网络研究产生了巨大的负面影响,导致:

- 神经网络研究进入"冰河期"(ice age)

- 研究经费大幅削减

- 许多研究者离开该领域

3.2 BP算法的被忽视

重要发现:

1974年,Paul Werbos发明了BP算法(反向传播算法),这是训练多层神经网络的关键算法。

历史遗憾:

然而,由于当时神经网络研究处于低谷,这一重要发现并未引起足够的重视,BP算法被埋没多年。

冰河期的特点:

- 研究经费大幅减少

- 研究者流失严重

- 神经网络研究几乎停滞

- 重要算法被忽视

4. 第二次繁荣期(1984年左右-1997年左右)

4.1 Hopfield网络

重要突破:

1983年,John Hopfield在求解旅行商问题(Traveling Salesperson Problem)时使用了神经网络,引起了广泛关注。

影响:

Hopfield的工作重新点燃了人们对神经网络的兴趣,标志着神经网络研究的复苏。

4.2 PDP小组与BP算法的重新发现

PDP小组:

David Rumelhart和James McClelland领导的PDP小组 (Parallel Distributed Processing group)发表了《并行分布式处理:认知微结构的探索》(Parallel Distributed Processing: Explorations in the Microstructure of Cognition)。

BP算法的重新发现:

1986年,Rumelhart等人重新发现了BP算法,并成功应用于多层神经网络的训练。

第二次繁荣期的特点:

- BP算法的成功应用使多层神经网络训练成为可能

- 神经网络研究重新获得关注

- 出现了大量理论和应用研究

- 神经网络在各个领域得到应用

5. 沉寂期(1997年左右开始)

5.1 统计学习理论的兴起

关键事件:

1997年左右,SVM文本分类成功 及统计学习理论 兴起,以支持向量机(Support Vector Machine,SVM)为代表。

理论优势:

- 统计学习理论为机器学习提供了严密的数学基础

- SVM等方法的理论保证更加完善

- 在小样本情况下表现更好

5.2 神经网络的弱点暴露

理论缺陷:

神经网络学习的理论弱点逐渐暴露,包括:

- 缺乏严格的理论保证

- 训练过程依赖大量"技巧"(tricks)

- 容易过拟合

- 训练过程不稳定

学术界的冷遇:

- NIPS(Neural Information Processing Systems)等顶级会议连续多年拒绝神经网络相关论文

- 神经网络研究再次陷入低谷

沉寂期的特点:

- 统计学习方法占据主导地位

- 神经网络研究受到冷遇

- 理论缺陷被广泛讨论

- 研究经费和关注度下降

6. 第三次繁荣期(2012年至今)

6.1 深度学习的兴起

发展契机:

2012年,随着:

- 计算能力的快速提升(GPU、云计算等)

- 大数据时代的到来

- 训练算法的改进(如无监督逐层训练)

神经网络研究以"深度学习"(deep learning)的名义重新崛起。

6.2 重大突破

ImageNet竞赛:

深度学习在ImageNet等大型竞赛中取得重大胜利,证明了其在图像识别等任务中的强大能力。

产业投资:

- Google 、百度 、Facebook等大型科技公司大量投入

- 深度学习成为人工智能领域的热点

- 各种深度学习框架和工具不断涌现

应用领域:

深度学习在以下领域取得突破性进展:

- 图像识别

- 语音识别

- 自然语言处理

- 机器翻译

- 自动驾驶

第三次繁荣期的特点:

- 计算能力和数据量的支持

- 理论和方法的大幅改进

- 产业界的大力投入

- 在多个领域取得突破性成果

- 成为人工智能领域的核心方向

7. 历史启示

7.1 技术发展的曲折性

启示:

神经网络的发展历程表明,技术发展并非线性前进,而是经历起起落落的过程。

影响因素:

- 理论突破

- 计算能力

- 数据资源

- 应用需求

- 社会认知

7.2 理论与实践的关系

理论的重要性:

- 缺乏理论支撑的方法容易受到质疑

- 理论突破往往带来方法的重大进展

实践的价值:

- 实际应用中的成功能够推动理论发展

- 计算资源和数据的支持同样重要

7.3 持续创新的必要性

历史教训:

- 即使处于低谷,重要发现也可能被埋没

- 需要持续的理论和方法创新

- 跨学科合作的重要性

8. 总结

发展历程:

神经网络经历了萌芽期、三次繁荣期和两次低谷期:

- 萌芽期(1940年代):M-P模型(1943)、Hebb学习规则(1945)等基础理论建立

- 第一次繁荣期(1956年左右-1969年左右):感知机(1958)、Adaline(1960)等

- 冰河期(1969年后):《Perceptrons》的负面影响,BP算法(1974)被忽视

- 第二次繁荣期(1984年左右-1997年左右):Hopfield网络(1983)、BP算法重新发现(1986)等

- 沉寂期(1997年左右开始):SVM文本分类成功及统计学习理论兴起

- 第三次繁荣期(2012年至今):深度学习的崛起

当前状态:

深度学习正处于第三次繁荣期,在理论和应用方面都取得了重大突破,成为人工智能领域的核心方向之一。

周期模式的观察:

回顾神经网络的发展历程,可以发现一个有趣的周期模式:

- 第一次繁荣期(1956年左右-1969年左右):约13年

- 冰河期(1969年后-1984年左右):约15年

- 第二次繁荣期(1984年左右-1997年左右):约13年

- 沉寂期(1997年左右-2012年):约15年

- 第三次繁荣期(2012年至今):从2012年开始,到2025年已持续约13年

模式特点:

- 繁荣期和低谷期大致呈现13年繁荣、15年低谷的交替模式

- 这种周期性可能反映了技术发展的内在规律:

- 新技术出现后,经过一段时间的探索和应用,达到繁荣期

- 随着技术局限性的暴露和理论挑战的出现,进入低谷期

- 在低谷期中,新的理论和方法逐渐积累,为下一次繁荣做准备

当前思考:

按照这个周期模式,第三次繁荣期从2012年开始,到2025年已经持续了约13年。这是否意味着神经网络研究即将面临新的挑战或转折点?还是说,随着计算能力、数据资源和理论方法的持续进步,深度学习能够打破这个周期模式,进入一个更稳定的发展阶段?

未来展望:

虽然神经网络研究可能还会面临新的挑战,但基于当前的发展势头和技术积累,深度学习有望在未来继续取得重要进展。无论是否遵循历史周期模式,持续的理论创新、技术进步和应用拓展都是推动神经网络研究向前发展的关键因素。