博主介绍:✌全网粉丝50W+,前互联网大厂软件研发、集结硕博英豪成立软件开发工作室,专注于计算机相关专业项目实战6年之久,累计开发项目作品上万套。凭借丰富的经验与专业实力,已帮助成千上万的学生顺利毕业,选择我们,就是选择放心、选择安心毕业✌

> 🍅想要获取完整文章或者源码,或者代做,拉到文章底部即可与我联系了。🍅

2、大数据、计算机专业选题(Python/Java/大数据/深度学习/机器学习)(建议收藏)✅

1、项目介绍

- 技术栈:Python语言、Flask框架(后端业务逻辑)、Selenium爬虫(淘宝商品数据采集)、机器学习(多元线性回归预测模型)、LayUI框架(前端界面构建)、Echarts(可视化大屏与图表)、MySQL数据库(数据存储)、Pandas(数据清洗)、Bootstrap(前端样式辅助)

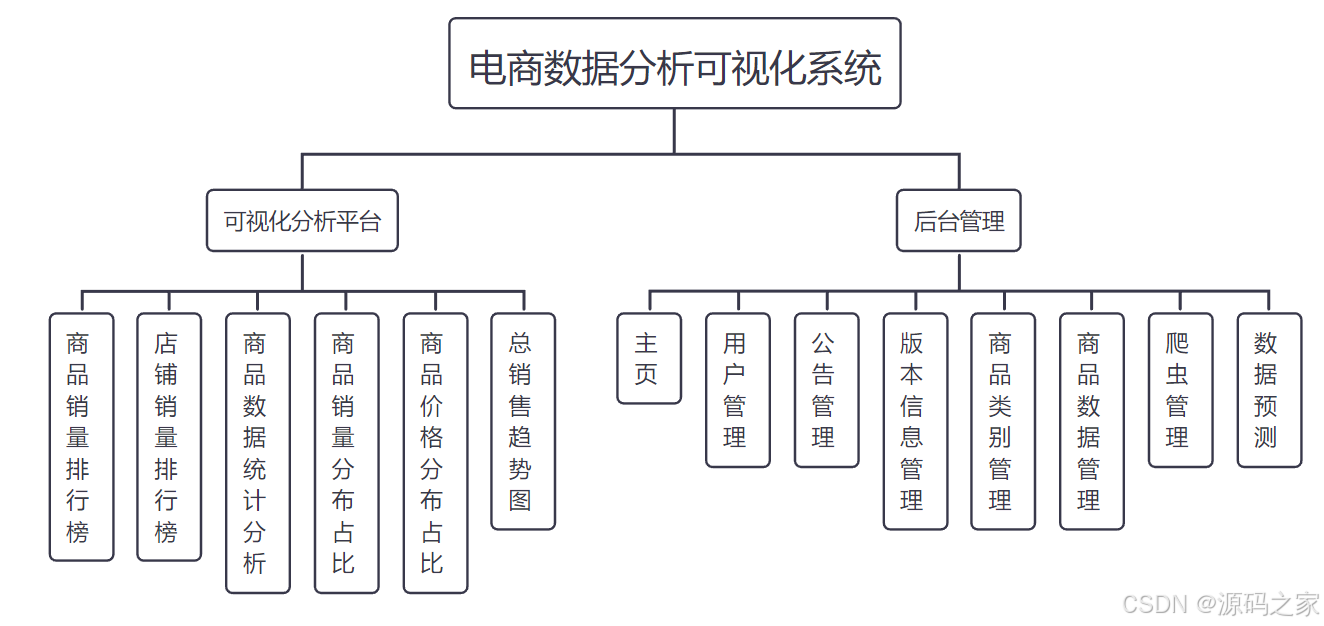

- 核心功能:淘宝商品数据自动化采集(支持定时爬虫任务)、数据清洗与结构化存储、多维度Echarts可视化大屏展示(销量/价格/品类趋势)、商品销量预测(多元线性回归驱动)、后台数据管理(商品/用户数据维护)、用户认证(注册登录/权限管控)

- 研究背景:电商行业数据量激增,传统平台面临三大核心痛点------商品数据管理低效导致更新滞后,疫情等动态因素使销量波动难预测(易引发库存失衡与亏损),数据价值隐藏于海量信息中难以直观挖掘,亟需"采集-分析-预测-管理"一体化系统破局。

- 研究意义:技术层面,实现爬虫、机器学习与Web开发的深度整合,构建完整电商数据处理链路;应用层面,为企业提供实时数据洞察与销量预判,优化库存与运营策略;学习层面,适合作为大数据+机器学习方向毕业设计,覆盖多技术实战应用。

2、项目界面

- 商品数据可视化大屏(全平台商品销量、价格、品类分布等核心数据总览)

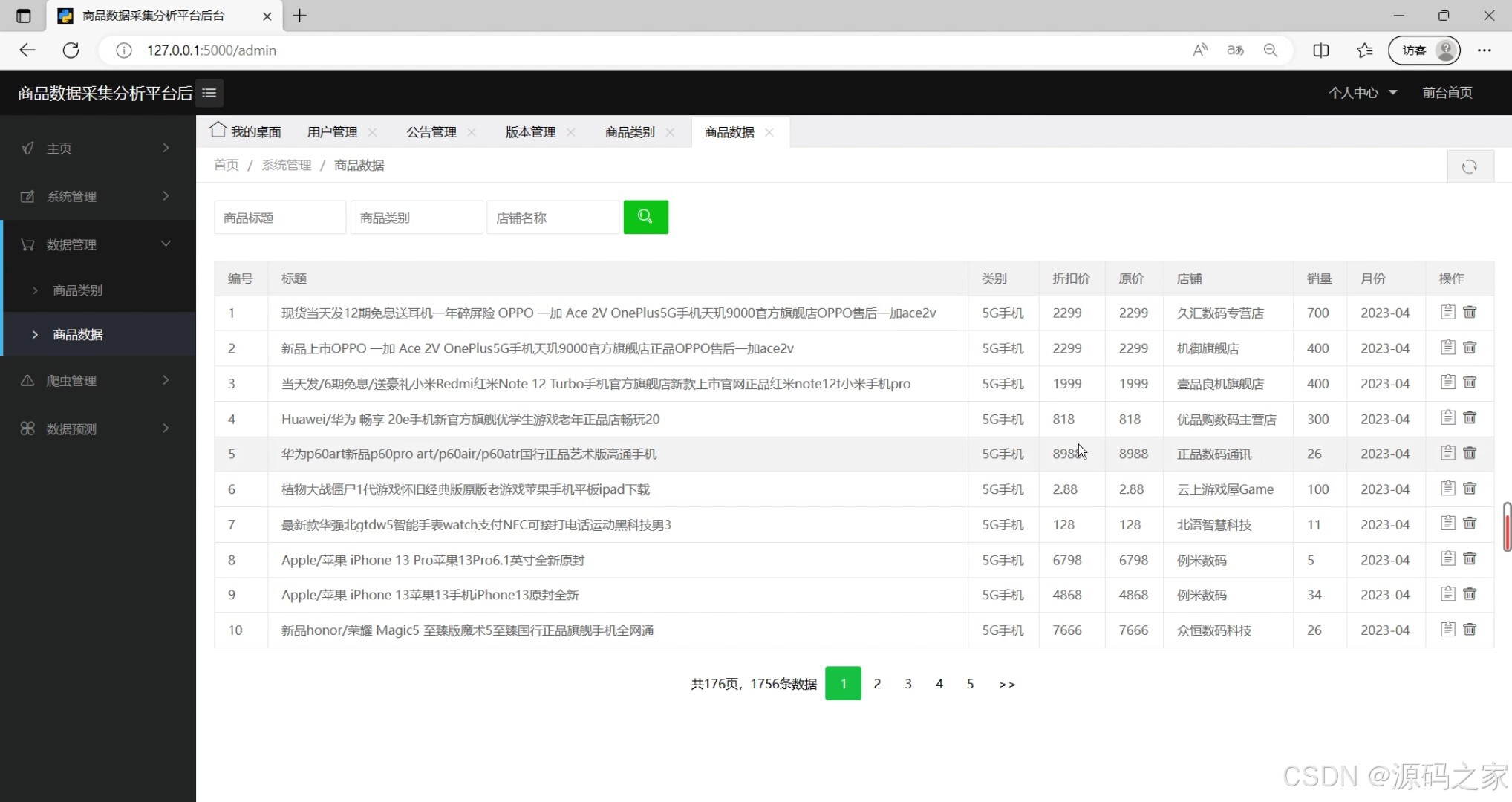

- 商品数据后台管理(商品基础信息查询、编辑与维护界面)

- 定时爬虫数据采集(爬虫任务配置、启动与采集进度监控界面)

-

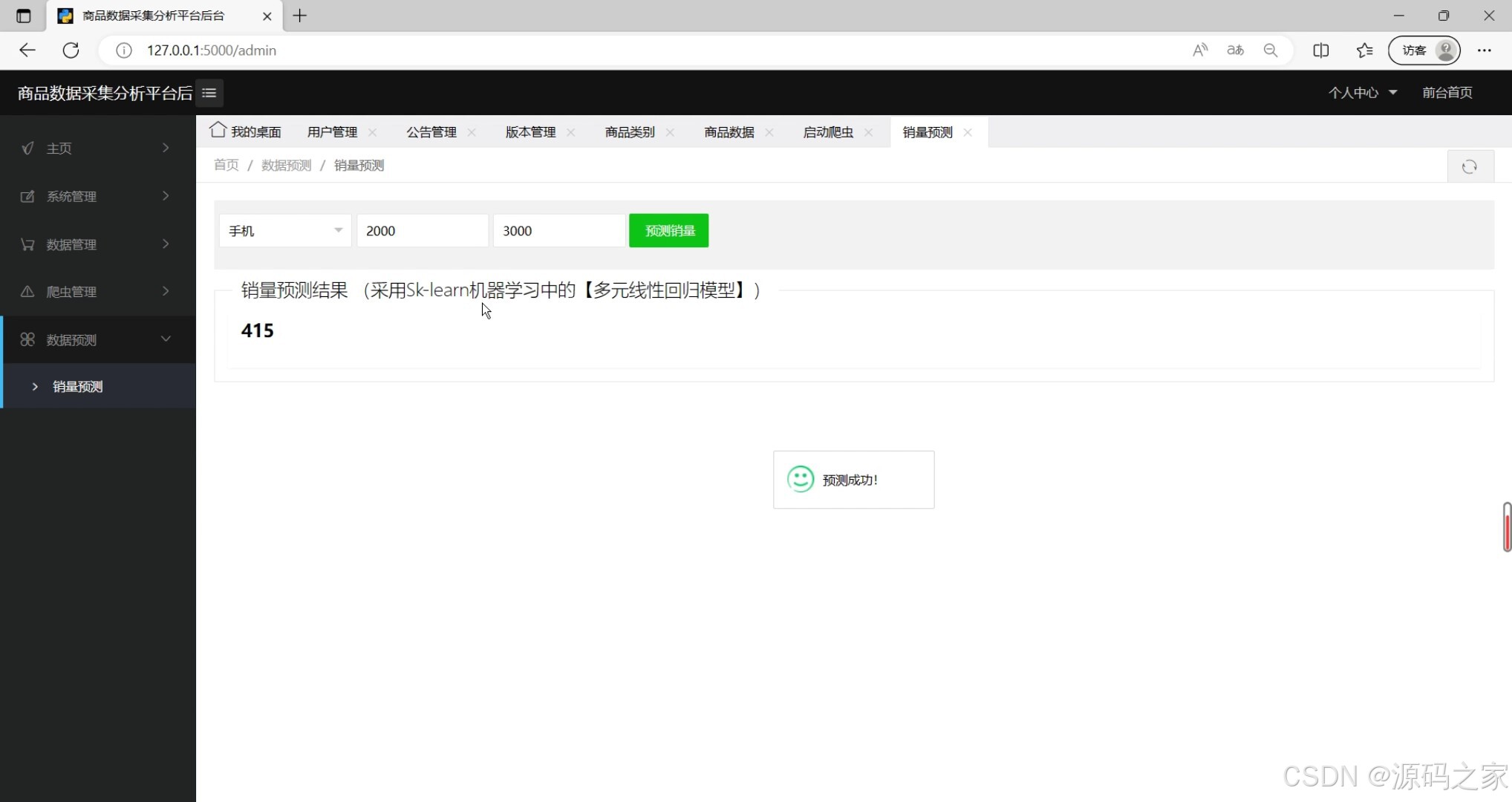

机器学习预测算法(多元线性回归模型输出的商品销量预测结果与趋势图)

-

后台管理页面(系统核心功能入口,含数据管理、用户管理等模块导航)

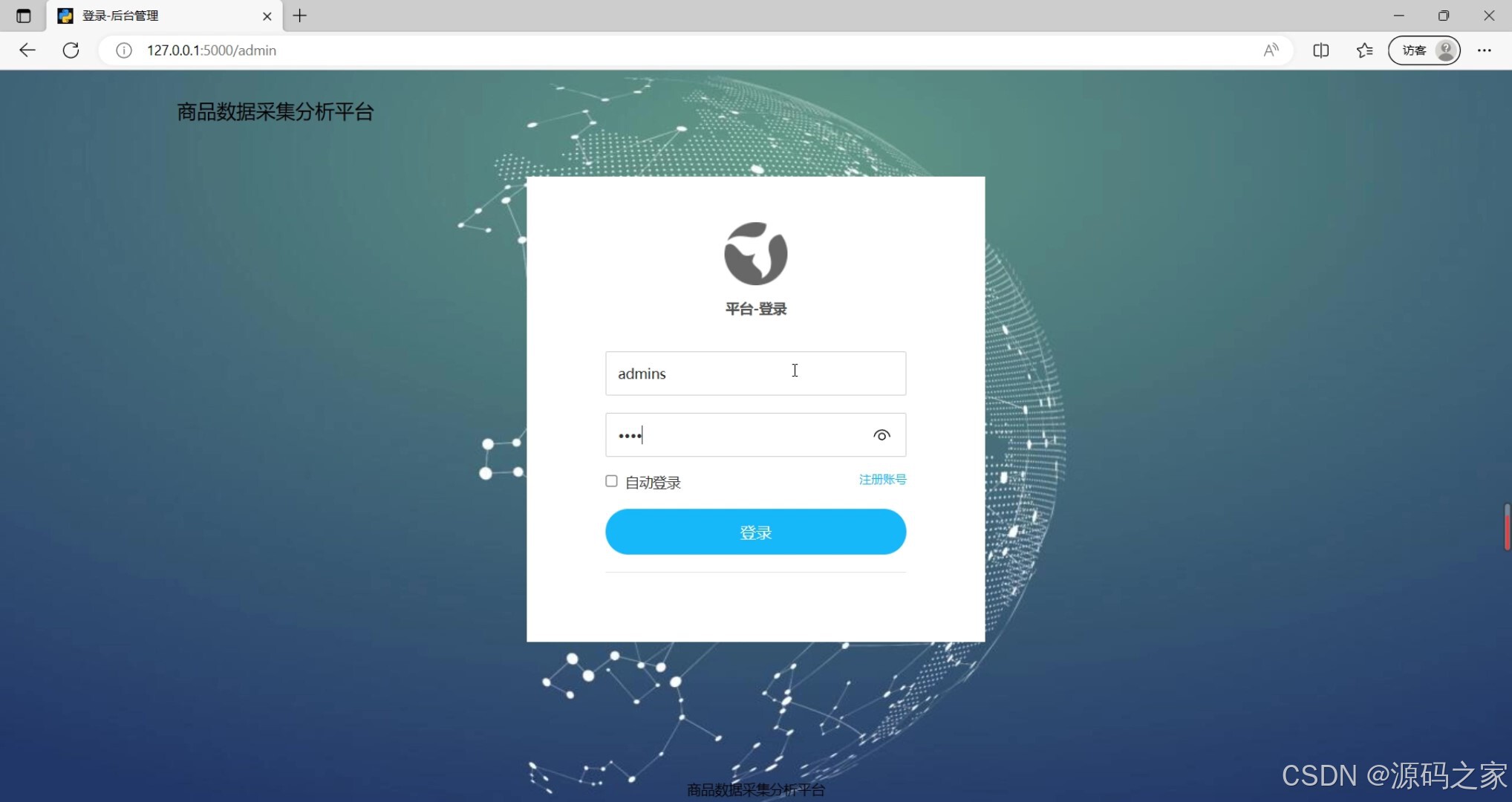

- 注册登录界面(用户身份认证入口,支持新用户注册与老用户登录)

- 用户管理(管理员对系统用户账号的新增、编辑、启用/停用等维护界面)

8.功能模块

3、项目说明

在电商行业数据爆炸与动态市场环境(如疫情)的双重挑战下,传统电商平台普遍存在商品数据更新滞后、销量波动难预测、数据价值挖掘不足等问题,直接导致库存管理失衡、运营效率低下与盈利风险增加。为此,本项目设计并实现了一款电商数据分析可视化管理系统,通过数字化技术整合构建高效解决方案。系统以Python为核心开发语言,后端采用Flask框架搭建稳定的业务逻辑层,负责调度Selenium爬虫完成淘宝商品数据(名称、价格、销量、评价、上架时间等)的自动化采集,同时处理用户请求与预测模型调用;数据采集后,借助Pandas库进行清洗,剔除重复值与异常数据(如极端价格),再将结构化数据存入MySQL数据库,确保数据的时效性与准确性。前端采用LayUI与Bootstrap框架构建响应式界面,结合Echarts实现多维度可视化------通过商品数据可视化大屏直观呈现销量趋势、价格分布、热门品类等核心指标,让隐藏的数据价值清晰可见;针对销量预测需求,系统引入机器学习中的多元线性回归模型,以历史销量为基础,融合价格、促销活动、疫情影响等多维度特征构建预测模型,输出未来一段时间的销量趋势,为企业库存调整与风险规避提供科学依据。系统功能划分为两大核心模块:数据管理模块涵盖数据爬取(支持定时任务自动执行)、存储、分析、可视化及销量预测;后台管理模块包含商品数据维护、用户管理(注册登录、权限管控)等。通过黑盒测试验证,系统各功能模块运行稳定,数据采集准确、预测结果可靠,有效解决了电商企业的核心痛点,同时其完整的技术链路(爬虫+机器学习+可视化+Web开发)使其成为大数据领域的实用工具,也适合作为毕业设计展示多技术融合的应用能力。

4、爆款标题

- 机器学习实战:淘宝商品数据预测平台(Flask+LayUI 可视化分析 毕业设计源码)✅

- 全栈项目:电商智能数据分析系统(定时爬虫+销量预测 淘宝数据应用 源码+文档)✅

4、核心代码

python

from flask import Flask as _Flask, flash

from flask import request, session

from flask import render_template

from flask.json import JSONEncoder as _JSONEncoder, jsonify

import decimal

import service.users_data as user_service

import service.notice_data as notice_data

import service.slog_data as slog_data

import service.goods_data as goods_data

import service.category_data as category_data

import service.view_data as view_data

import service.version_data as version_data

import machine_learning.goods_predict as gp

from spider import shopping_spider

from concurrent.futures import ThreadPoolExecutor

class JSONEncoder(_JSONEncoder):

def default(self, o):

if isinstance(o, decimal.Decimal):

return float(o)

super(_JSONEncoder, self).default(o)

class Flask(_Flask):

json_encoder = JSONEncoder

import os

app = Flask(__name__)

app.config['SESSION_TYPE'] = 'filesystem'

app.config['SECRET_KEY'] = os.urandom(24)

# -------------前台可视化大数据分析相关服务接口start-----------------

# 系统默认路径前台跳转

@app.route('/')

def main_page():

return render_template("main.html")

# -------------前台可视化大数据分析相关服务接口end-----------------

# -------------后台管理模块相关服务接口start-----------------

# 登录

@app.route('/login', methods=['POST'])

def login():

if request.method == 'POST':

account = request.form.get('account')

password = request.form.get('password')

if not all([account, password]):

flash('参数不完整')

return "300"

res = user_service.get_user(account, password)

if res and res[0][0] > 0:

session['is_login'] = True

session['role'] = res[0][1]

return "200"

else:

return "300"

# 新增系统版本数据

@app.route('/version/add', methods=["POST"])

def sys_version_add():

get_data = request.form.to_dict()

name = get_data.get('name')

version = get_data.get('version')

return version_data.add_sys_version(name, version)

# 修改系统版本数据

@app.route('/version/edit', methods=["PUT"])

def version_edit():

get_data = request.form.to_dict()

id = get_data.get('id')

name = get_data.get('name')

version = get_data.get('version')

version_data.edit_sys_version(id, name, version)

return '200'

# 删除系统版本数据

@app.route('/version/delete', methods=["DELETE"])

def version_delete():

get_data = request.form.to_dict()

id = get_data.get('id')

version_data.del_sys_version(id)

return '200'

# -----------------系统版本管理模块END-----------------

# -----------------类别管理模块START-----------------

# 公告管理页面

@app.route('/html/category')

def category_manager():

return render_template('html/category.html')

# 获取公告数据分页

@app.route('/category/list', methods=["POST"])

def category_list():

get_data = request.form.to_dict()

page_size = get_data.get('page_size')

page_no = get_data.get('page_no')

param = get_data.get('param')

data, count, page_list, max_page = category_data.get_category_list(int(page_size), int(page_no), param)

return jsonify({"data": data, "count": count, "page_no": page_no, "page_list": page_list, "max_page": max_page})

# 新增类别数据

@app.route('/category/add', methods=["POST"])

def category_add():

get_data = request.form.to_dict()

content = get_data.get('content')

return category_data.add_category(content)

# 修改类别数据

@app.route('/category/edit', methods=["PUT"])

def category_edit():

get_data = request.form.to_dict()

id = get_data.get('id')

content = get_data.get('content')

category_data.edit_category(id, content)

return '200'

# 删除类别数据

@app.route('/category/delete', methods=["DELETE"])

def category_delete():

get_data = request.form.to_dict()

id = get_data.get('id')

category_data.del_category(id)

return '200'

# -----------------类别管理模块END-----------------

# -----------------爬虫管理模块START-----------------

# 后台调用爬虫

@app.route('/spider/start', methods=["POST"])

def run_spider():

get_data = request.form.to_dict()

key = get_data.get('key')

total_pages = get_data.get('num')

executor = ThreadPoolExecutor(2)

executor.submit(shopping_spider.spider(key, total_pages))

return '200'

# 爬虫日志页面

@app.route('/html/slog')

def slog_manager():

return render_template('html/slog.html')

# 获取爬虫日志数据分页

@app.route('/slog/list', methods=["POST"])

def slog_list():

get_data = request.form.to_dict()

page_size = get_data.get('page_size')

page_no = get_data.get('page_no')

param = get_data.get('param')

data, count, page_list, max_page = slog_data.get_slog_list(int(page_size), int(page_no), param)

return jsonify({"data": data, "count": count, "page_no": page_no, "page_list": page_list, "max_page": max_page})

# 修改爬虫日志数据

@app.route('/slog/edit', methods=["PUT"])

def slog_edit():

get_data = request.form.to_dict()

id = get_data.get('id')

log = get_data.get('log')

slog_data.edit_slog(id, log)

return '200'

# 删除爬虫日志数据

@app.route('/slog/delete', methods=["DELETE"])

def slog_delete():

get_data = request.form.to_dict()

id = get_data.get('id')

slog_data.del_slog(id)

return '200'

# -----------------爬虫管理模块END-----------------

# -----------------商品管理模块START----------------

# 商品页面

@app.route('/html/goods')

def goods_manager():

return render_template('html/goods.html')

# 获取商品数据分页

@app.route('/goods/list', methods=["POST"])

def goods_list():

get_data = request.form.to_dict()

page_size = get_data.get('page_size')

page_no = get_data.get('page_no')

param = get_data.get('param')

data, count, page_list, max_page = goods_data.get_goods_list(int(page_size), int(page_no), param)

return jsonify({"data": data, "count": count, "page_no": page_no, "page_list": page_list, "max_page": max_page})

# 修改商品数据

@app.route('/goods/edit', methods=["PUT"])

def goods_edit():

get_data = request.form.to_dict()

id = get_data.get('id')

title = get_data.get('title')

category = get_data.get('category')

discount = get_data.get('discount')

original_price = get_data.get('original_price')

shop = get_data.get('shop')

monthly_sales = get_data.get('monthly_sales')

goods_data.edit_goods(id, title, category, discount, original_price, shop, monthly_sales)

return '200'

# 删除商品数据

@app.route('/goods/delete', methods=["DELETE"])

def goods_delete():

get_data = request.form.to_dict()

id = get_data.get('id')

goods_data.del_goods(id)

return '200'

# 预测页面

@app.route('/html/predict')

def html_predict():

return render_template('html/predict.html')

# 预测商品数据

@app.route('/goods/predict', methods=["POST"])

def goods_predict():

get_data = request.form.to_dict()

t = get_data.get('t')

p = get_data.get('p')

op = get_data.get('op')

return jsonify({"data": gp.predict(t, p, op)})

# -----------------可视化页面模块END-----------------

if __name__ == '__main__':

# 端口号设置

app.run(host="127.0.0.1", port=5000)🍅✌**感兴趣的可以先收藏起来,点赞关注不迷路,想学习更多项目可以查看主页,大家在毕设选题,项目编程以及论文编写等相关问题都可以给我留言咨询,希望可以帮助同学们顺利毕业!**🍅✌

5、源码获取方式

🍅**由于篇幅限制,获取完整文章或源码、代做项目的,拉到文章底部即可看到个人联系方式。**🍅

点赞、收藏、关注,不迷路,下方查看 👇🏻获取联系方式👇🏻