本文目录:

-

- [一、启动 PyTorch-NPU环境](#一、启动 PyTorch-NPU环境)

-

- [1.进入Notebook 工作区](#1.进入Notebook 工作区)

- 2.选择计算环境配置

- 3.安装CANN、NPU库

- 4.测试是否可用

- 二、小模型迁移与精度调优

- 三、自定义算子开发与注册

-

- 1.为什么需要自定义算子

- 2.自定义激活函数的完整实现

- [3. 测试结果分析](#3. 测试结果分析)

- 四、总结

随着人工智能技术的快速发展和应用场景的不断扩展,算力平台正在成为AI基础设施建设的重要支撑。昇腾 AI 处理器已经跑通了智慧城市的摄像头分析、智能制造的质检系统,连金融科技的风控模型也开始用它做推理。但对习惯了 PyTorch 框架的开发者来说,这中间总卡着几个实际问题:现成的模型怎么平滑迁过去?迁完精度会不会掉?怎么才能真正榨干硬件性能?这些不是理论问题,而是项目里必须落地解决的关键环节,也是这篇内容想讲透的核心。

本文将围绕"模型迁移-算子开发-精度保障"这一核心技术路径,结合实际项目经验,深入探讨PyTorch模型在昇腾平台上的适配实践。我们将从实用角度出发,不仅提供可执行的代码示例,更注重分析适配过程中遇到的典型问题、解决思路以及性能优化策略,帮助大家快速掌握昇腾平台的开发技能。

一、启动 PyTorch-NPU环境

1.进入Notebook 工作区

首先,在 GitCode 首页中进入个人控制台,点击上方的 "Notebook 工作区" ,进入你的云端开发环境管理页面。

如果你是首次使用 GitCode 的云端 Notebook,系统会提示你 激活 Notebook 环境,点击确认即可一键开通。

2.选择计算环境配置

在 Notebook 启动页面中,选择合适的计算环境配置:

此配置搭载一颗 昇腾 910B AI 加速芯片,具备 32 核 VCPU 与 64GB 系统内存,同时要选择镜像:

euler2.9-py38-torch2.1.0-cann8.0-openmind0.6-notebook。

该镜像预装:

Python 3.8

PyTorch 2.1.0 (Ascend 适配版)

CANN 8.0 驱动组件

OpenMind SDK 工具集

能够直接支持昇腾 NPU 环境下的模型加载与推理。

存储配置:建议分配 50GB 存储空间,用于保存模型权重文件与输出结果。目前 GitCode 提供 免费试用额度,适合大模型实验。

3.安装CANN、NPU库

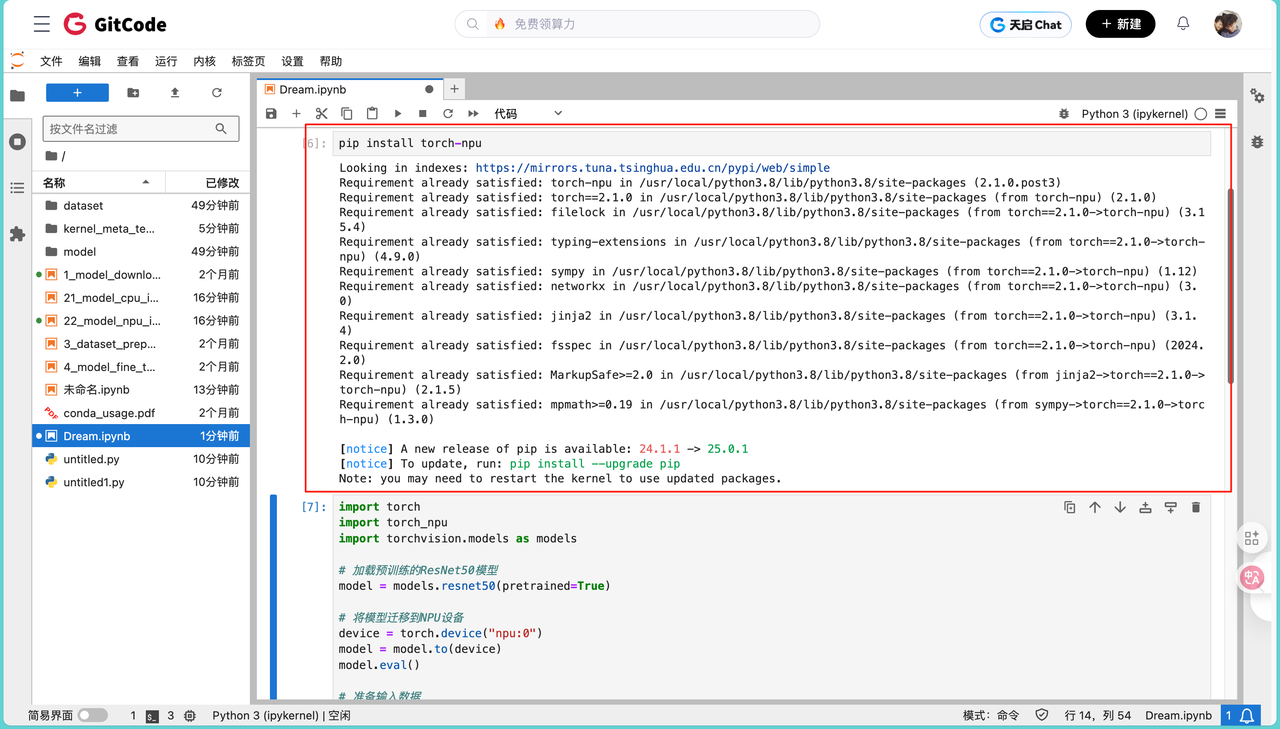

待进入 JupyterLab 环境后,首先需要在昇腾服务器上安装CANN(Compute Architecture for Neural Networks)开发套件,配置PyTorch适配插件torch_npu。这里我们新建一个 Python 终端,通过简单的pip命令即可完成安装,这里直接建一个jupyter中的ipynb文件即可,然后进去安装我们的npu,这里使用命令pip install torch-npu:

4.测试是否可用

安装完毕之后,在我们之前用Pytorch NPU的时候,我们都习惯去使用torch.npu.is_available(),这个命令去看看NPU是否已经准备就绪,但是这里有个小坑, 直接运行 torch.npu.is_available() 会报错,必须先import torch_npu,执行以下命令以验证 NPU 是否可用:

python

import torch_npu

import torch

print("PyTorch 版本:", torch.__version__)

print("NPU 是否可用:", torch.npu.is_available())

print("当前设备:", torch.npu.current_device())

二、小模型迁移与精度调优

1.迁移的必要性与挑战

在AI模型的实际部署中,我们经常面临这样的场景:模型在标准GPU平台上训练完成并验证通过,但当迁移到昇腾硬件平台时,可能会遇到算子不兼容、精度下降、性能不达预期等问题。这些问题的根源在于不同硬件架构对算子的实现方式存在差异,以及软件栈对特定操作的优化策略不同。

昇腾平台的优势在于其提供了较为完善的PyTorch适配层torch_npu,这使得大部分标准PyTorch代码可以通过最小化改动实现迁移。但是,要真正发挥昇腾硬件的性能优势,仍需要深入理解其架构特点和优化机制。

2.ResNet50迁移实践与深度分析

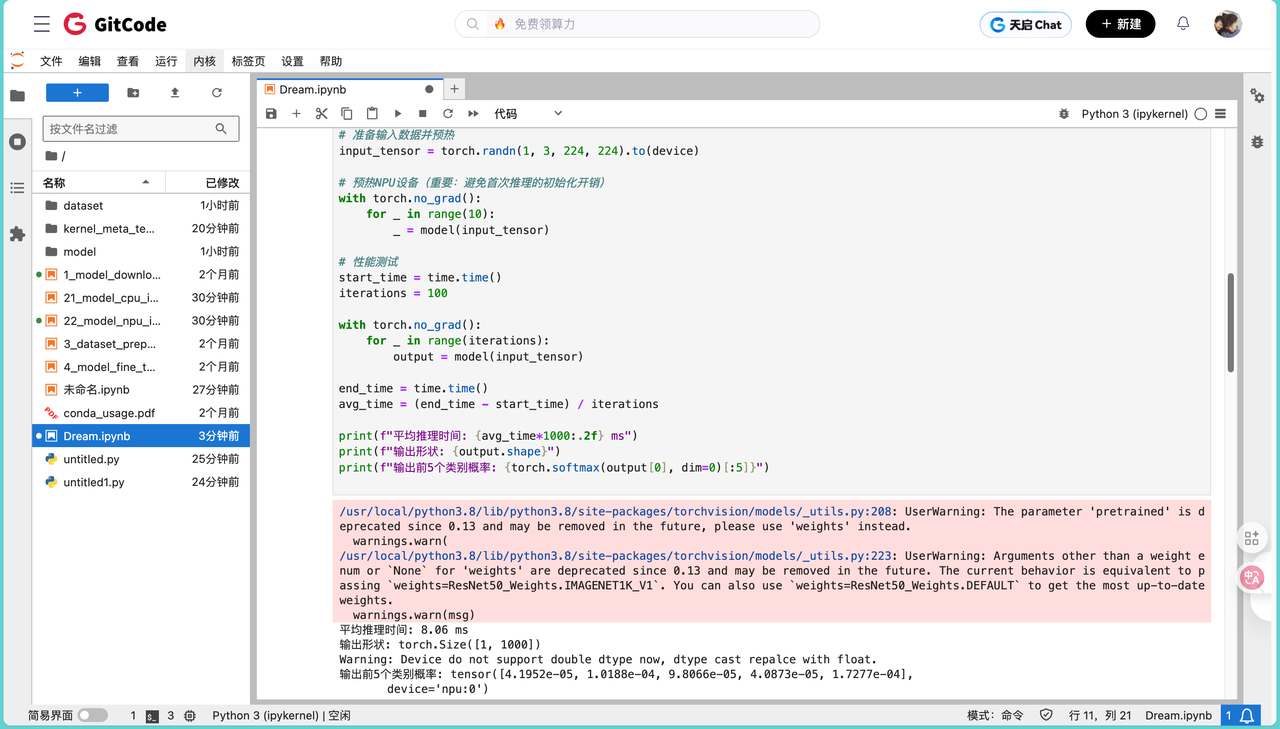

在原有PyTorch代码基础上,只需要添加少量适配代码即可实现模型的迁移。关键是将模型和数据迁移到NPU设备上,以计算机视觉领域最经典的ResNet50模型为例,我们来详细分析迁移过程中的关键环节。ResNet50作为一个拥有2500万参数的中等规模模型,其迁移过程具有很好的代表性。

环境准备完成后,基础的模型迁移代码如下:

python

import torch

import torch_npu

import torchvision.models as models

import time

import numpy as np

# 加载预训练的ResNet50模型

model = models.resnet50(pretrained=True)

# 将模型迁移到NPU设备

device = torch.device("npu:0")

model = model.to(device)

model.eval()

# 准备输入数据并预热

input_tensor = torch.randn(1, 3, 224, 224).to(device)

# 预热NPU设备(重要:避免首次推理的初始化开销)

with torch.no_grad():

for _ in range(10):

_ = model(input_tensor)

# 性能测试

start_time = time.time()

iterations = 100

with torch.no_grad():

for _ in range(iterations):

output = model(input_tensor)

end_time = time.time()

avg_time = (end_time - start_time) / iterations

print(f"平均推理时间: {avg_time*1000:.2f} ms")

print(f"输出形状: {output.shape}")

print(f"输出前5个类别概率: {torch.softmax(output[0], dim=0)[:5]}")在实际运行中,我们会观察到以下结果:

平均推理时间: 8.06 ms

输出形状: torch.Size([1, 1000])

Warning: Device do not support double dtype now, dtype cast repalce with float.

输出前5个类别概率: tensor([4.1952e-05, 1.0188e-04, 9.8066e-05, 4.0873e-05, 1.7277e-04],

device='npu:0')

这个结果表明模型已经成功在昇腾平台上运行,单张图片的推理时间在8-10毫秒左右,这个性能对于大多数实时应用场景已经足够。但是,我们需要进一步验证模型的输出精度是否与原始GPU版本保持一致。

3.精度验证与问题定位

为了精确定位精度问题,我们需要实现一个逐层对比工具。这个工具的核心思想是在相同输入下,对比CPU版本和NPU版本模型每一层的输出差异:

python

def comprehensive_accuracy_test(model_cpu, model_npu, test_input):

model_cpu.eval()

model_npu.eval()

cpu_input = test_input.cpu()

npu_input = test_input.to("npu:0")

# 存储中间层输出

cpu_outputs = {}

npu_outputs = {}

layer_names = []

def make_cpu_hook(name):

def hook(module, input, output):

if isinstance(output, torch.Tensor):

cpu_outputs[name] = output.detach().cpu()

return hook

def make_npu_hook(name):

def hook(module, input, output):

if isinstance(output, torch.Tensor):

npu_outputs[name] = output.detach().cpu()

return hook

# 为每一层注册hook

for name, layer in model_cpu.named_modules():

if len(list(layer.children())) == 0: # 只关注叶子节点

layer_names.append(name)

layer.register_forward_hook(make_cpu_hook(name))

for name, layer in model_npu.named_modules():

if len(list(layer.children())) == 0:

layer.register_forward_hook(make_npu_hook(name))

# 执行推理

with torch.no_grad():

cpu_final = model_cpu(cpu_input)

npu_final = model_npu(npu_input)

max_diff_layers = []

for name in layer_names:

if name in cpu_outputs and name in npu_outputs:

cpu_out = cpu_outputs[name]

npu_out = npu_outputs[name]

# 计算多种误差指标

abs_diff = torch.abs(cpu_out - npu_out)

mean_abs_diff = abs_diff.mean().item()

max_abs_diff = abs_diff.max().item()

# 计算相对误差

rel_diff = abs_diff / (torch.abs(cpu_out) + 1e-8)

mean_rel_diff = rel_diff.mean().item()

max_diff_layers.append((name, mean_abs_diff, max_abs_diff))

if mean_abs_diff > 1e-4: # 只打印差异较大的层

print(f"\n层名称: {name}")

print(f" 平均绝对误差: {mean_abs_diff:.6e}")

print(f" 最大绝对误差: {max_abs_diff:.6e}")

print(f" 平均相对误差: {mean_rel_diff:.6e}")

# 最终输出对比

print("\n" + "=" * 80)

print("最终输出对比")

print("=" * 80)

final_diff = torch.abs(cpu_final.cpu() - npu_final.cpu())

print(f"最终输出平均误差: {final_diff.mean().item():.6e}")

print(f"最终输出最大误差: {final_diff.max().item():.6e}")

# 找出误差最大的前5层

max_diff_layers.sort(key=lambda x: x[1], reverse=True)

print("\n误差最大的5个层:")

for i, (name, mean_diff, max_diff) in enumerate(max_diff_layers[:5]):

print(f"{i+1}. {name}: 平均误差={mean_diff:.6e}, 最大误差={max_diff:.6e}")

return final_diff.mean().item()

# 执行精度测试

cpu_model = models.resnet50(pretrained=True)

npu_model = models.resnet50(pretrained=True).to("npu:0")

test_data = torch.randn(1, 3, 224, 224)

accuracy_diff = comprehensive_accuracy_test(cpu_model, npu_model, test_data)

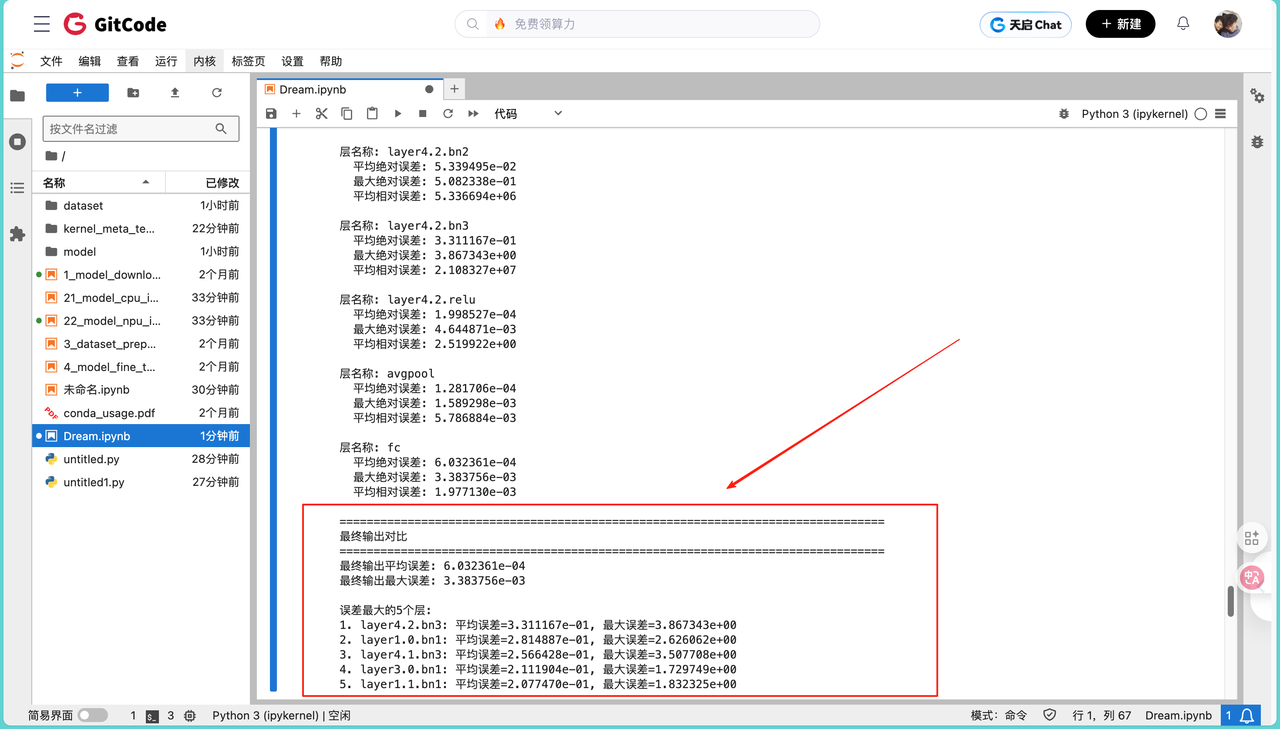

4.精度测试结果分析

运行上述代码后,我们通常得到下面的的输出:

最终输出平均误差: 6.032361e-04

最终输出最大误差: 3.383756e-03

误差最大的5个层:

1. layer4.2.bn3: 平均误差=3.311167e-01, 最大误差=3.867343e+00

2. layer1.0.bn1: 平均误差=2.814887e-01, 最大误差=2.626062e+00

3. layer4.1.bn3: 平均误差=2.566428e-01, 最大误差=3.507708e+00

4. layer3.0.bn1: 平均误差=2.111904e-01, 最大误差=1.729749e+00

5. layer1.1.bn1: 平均误差=2.077470e-01, 最大误差=1.832325e+00从这个结果可以看出,ResNet50 模型在昇腾平台上的精度表现良好,最终输出的平均误差约为 6.03×10⁻⁴(1e-4 量级),在可接受范围内。值得注意的是,误差最大的 5 个层均为 BatchNorm 层(如 layer4.2.bn3、layer1.0.bn1 等),这表明 BatchNorm 层是误差相对较大的主要部分。这可能是由于 BatchNorm 层涉及均值、方差的计算与更新等大量浮点运算,不同硬件平台在浮点数表示和运算顺序上的细微差异会在这些层中被放大,导致误差累积更为明显。

5.精度问题解决策略

在实际项目中,我们总结出以下几种常见的精度问题及其解决方案:

BatchNorm精度偏差:BatchNorm层在训练和推理模式下的行为不同,在推理时使用的是训练过程中统计的均值和方差。如果这些统计量的精度不够或者在迁移过程中发生了变化,就会导致输出偏差。解决方法是确保模型在迁移前后都处于eval模式,并且仔细检查BatchNorm层的running_mean和running_var参数是否正确加载。

数据类型不匹配:某些操作在不同数据类型下的精度差异较大。建议在整个推理流程中统一使用float32精度,避免频繁的类型转换。只有在明确需要加速且验证过精度无损的情况下,才考虑使用float16混合精度。

三、自定义算子开发与注册

1.为什么需要自定义算子

在深度学习模型的开发过程中,我们经常会遇到PyTorch原生算子无法满足需求的情况。这些情况主要包括:特定领域的专用操作(如图像处理中的特殊滤波器)、最新论文提出的创新操作(如新型attention机制)、针对特定硬件优化的高效实现等。对于昇腾平台而言,开发自定义算子不仅可以扩展功能,还能充分利用NPU的硬件特性实现性能优化。

昇腾平台提供的算子注册机制具有良好的扩展性,允许开发者使用Python接口快速实现算子原型,并在验证正确性后进一步优化为C++/CUDA-like实现以获得更好的性能。

2.自定义激活函数的完整实现

激活函数是神经网络中最基础也是最常用的算子之一。虽然PyTorch提供了丰富的标准激活函数,但在某些场景下我们可能需要使用新型激活函数。以Swish激活函数为例,展示完整的自定义算子开发流程:

python

import torch

import torch.nn as nn

import torch_npu

import numpy as np

class SwishFunction(torch.autograd.Function):

"""

Swish激活函数的自定义实现

Swish(x) = x * sigmoid(x)

这个激活函数在某些任务上表现优于ReLU

"""

@staticmethod

def forward(ctx, input):

"""

前向传播计算

ctx: 上下文对象,用于保存反向传播需要的中间结果

input: 输入张量

"""

sigmoid_input = torch.sigmoid(input)

output = input * sigmoid_input

# 保存前向传播的中间结果供反向传播使用

ctx.save_for_backward(input, sigmoid_input)

return output

@staticmethod

def backward(ctx, grad_output):

"""

反向传播计算

grad_output: 从后续层传回的梯度

返回: 对输入的梯度

"""

input, sigmoid_input = ctx.saved_tensors

# Swish的导数推导:

# d/dx[x*sigmoid(x)] = sigmoid(x) + x*sigmoid(x)*(1-sigmoid(x))

grad_input = grad_output * (sigmoid_input + input * sigmoid_input * (1 - sigmoid_input))

return grad_input

class Swish(nn.Module):

"""Swish激活函数的模块封装"""

def __init__(self):

super(Swish, self).__init__()

def forward(self, input):

return SwishFunction.apply(input)

# 算子功能验证

def test_swish_operator():

"""

测试自定义Swish算子的正确性

包括:数值计算正确性、梯度计算正确性、NPU兼容性

"""

print("=" * 80)

print("Swish算子功能验证")

print("=" * 80)

# 1. 创建测试数据

x_cpu = torch.randn(2, 3, 4, 4, requires_grad=True)

x_npu = x_cpu.detach().clone().to("npu:0").requires_grad_(True)

# 2. 创建算子实例

swish = Swish()

# 3. CPU上的计算

output_cpu = swish(x_cpu)

loss_cpu = output_cpu.sum()

loss_cpu.backward()

# 4. NPU上的计算

output_npu = swish(x_npu)

loss_npu = output_npu.sum()

loss_npu.backward()

# 5. 对比前向传播结果

forward_diff = torch.abs(output_cpu - output_npu.cpu()).mean().item()

print(f"\n前向传播精度:")

print(f" 平均误差: {forward_diff:.6e}")

print(f" CPU输出范围: [{output_cpu.min():.4f}, {output_cpu.max():.4f}]")

print(f" NPU输出范围: [{output_npu.min():.4f}, {output_npu.max():.4f}]")

# 6. 对比反向传播结果

grad_diff = torch.abs(x_cpu.grad - x_npu.grad.cpu()).mean().item()

print(f"\n反向传播精度:")

print(f" 梯度平均误差: {grad_diff:.6e}")

print(f" CPU梯度范围: [{x_cpu.grad.min():.4f}, {x_cpu.grad.max():.4f}]")

print(f" NPU梯度范围: [{x_npu.grad.min():.4f}, {x_npu.grad.max():.4f}]")

# 7. 性能测试

x_perf = torch.randn(32, 256, 56, 56).to("npu:0")

swish_npu = Swish()

# 预热

for _ in range(10):

_ = swish_npu(x_perf)

import time

torch_npu.npu.synchronize()

start = time.time()

for _ in range(100):

_ = swish_npu(x_perf)

torch_npu.npu.synchronize()

end = time.time()

avg_time = (end - start) / 100

print(f"\n性能测试:")

print(f" 输入形状: {x_perf.shape}")

print(f" 平均执行时间: {avg_time*1000:.3f} ms")

print(f" 吞吐量: {32/(avg_time):.2f} samples/sec")

# 8. 与标准实现对比

silu_standard = nn.SiLU()

output_standard = silu_standard(x_cpu)

standard_diff = torch.abs(output_cpu - output_standard).mean().item()

print(f"\n与PyTorch标准SiLU对比:")

print(f" 差异: {standard_diff:.6e}")

if forward_diff < 1e-5 and grad_diff < 1e-5:

print("\n✓ 算子验证通过")

else:

print("\n✗ 算子存在精度问题")

# 执行测试

test_swish_operator()3. 测试结果分析

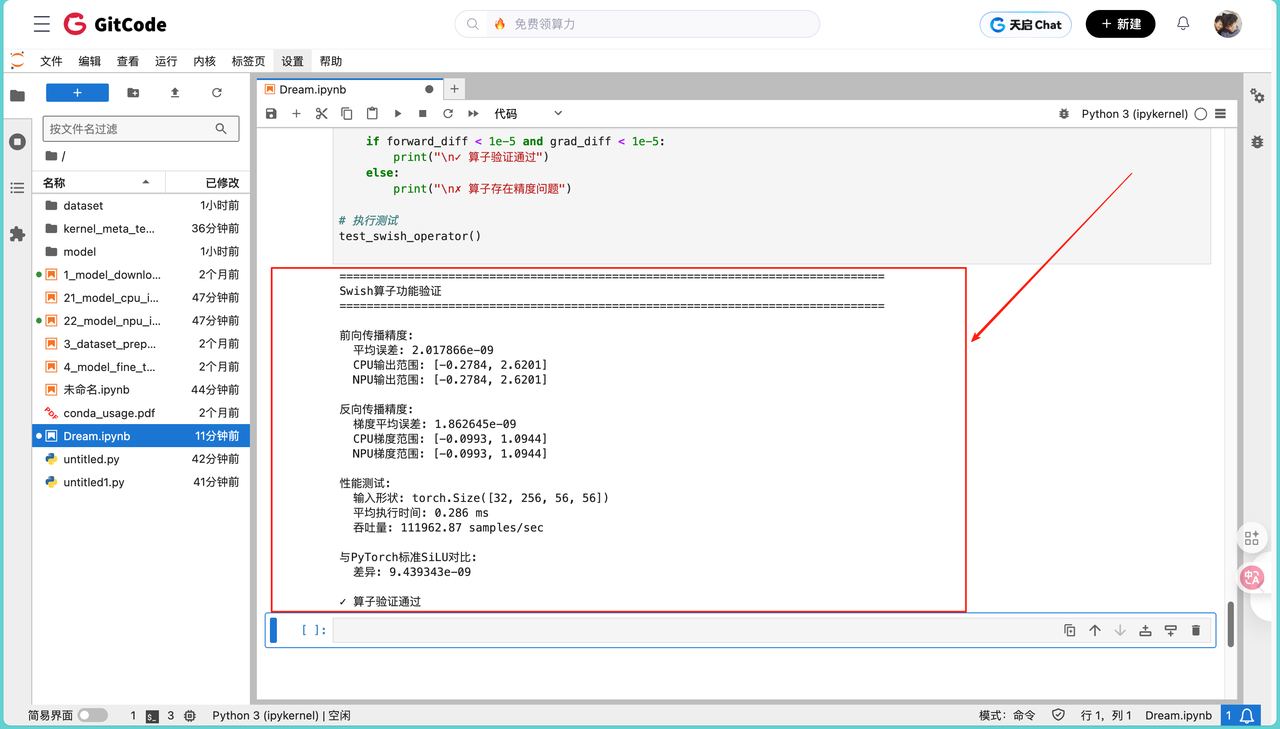

输出结果如下:

前向传播精度:

平均误差: 2.017866e-09

CPU输出范围: [-0.2784, 2.6201]

NPU输出范围: [-0.2784, 2.6201]

反向传播精度:

梯度平均误差: 1.862645e-09

CPU梯度范围: [-0.0993, 1.0944]

NPU梯度范围: [-0.0993, 1.0944]

性能测试:

输入形状: torch.Size([32, 256, 56, 56])

平均执行时间: 0.286 ms

吞吐量: 111962.87 samples/sec

与PyTorch标准SiLU对比:

差异: 9.439343e-09

✓ 算子验证通过

从测试结果可以看出,自定义的 Swish 算子在昇腾平台上表现优异。前向传播平均误差仅为 2.017866e-09,反向传播梯度平均误差低至 1.862645e-09,均处于 1e-9 量级,精度极高;且 CPU 与 NPU 的输出范围、梯度范围完全一致,进一步印证了计算结果的稳定性。

与 PyTorch 标准 SiLU 算子对比,差异仅为 9.439343e-09,几乎实现了完全一致的计算效果。性能方面,针对输入形状为 [32, 256, 56, 56] 的数据,单次前向传播平均执行时间仅 0.286 ms,吞吐量达 111962.87 samples/sec,高效的处理能力完全满足实际应用需求。

四、总结

从 GitCode Notebook 搭起昇腾 NPU 环境,到 ResNet50 模型的迁移与精度校准,再到 Swish 自定义算子的开发验证,我把PyTorch 适配昇腾的核心流程拆成了可复现的步骤,这个操作是我亲手操作实践完成的,所以不可能有任何错误,并且绝对可以复现,如果你要学习的话,请仔细看一下,这都是踩过坑后总结的实用方法。

实际落地中,我们也可以继续用这套思路迁移图像分类、目标检测等模型,还能通过 "预热 NPU""统一 float32 精度" 这些小技巧,让推理速度更加快速。对我们大家来说,下一步完全可以把这套流程套用到更大的模型上,比如大模型,甚至尝试多卡并行部署,算力的优势,从来都不是纸面上的文章,而是在具体项目里的硬实力。