1. **背景介绍**

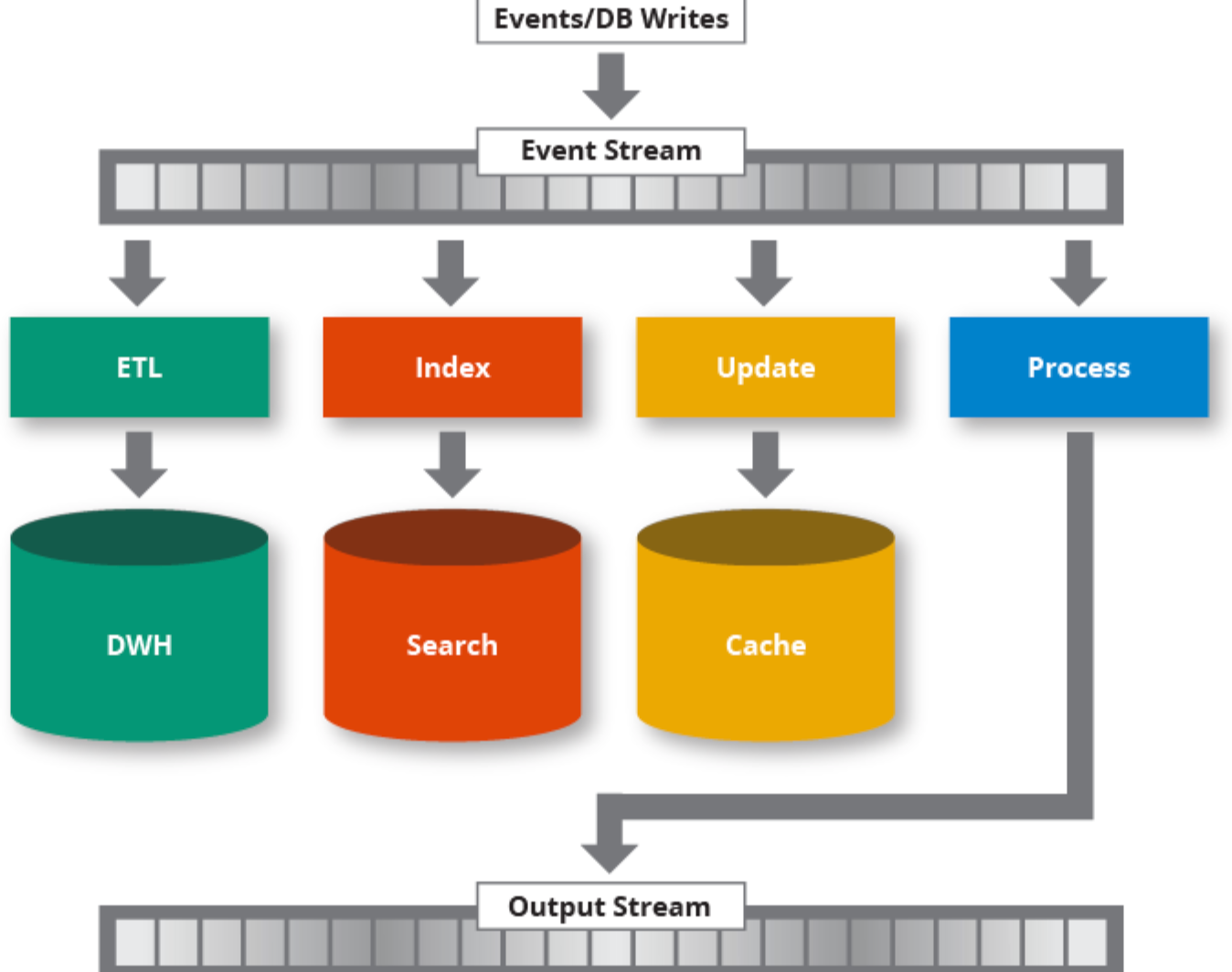

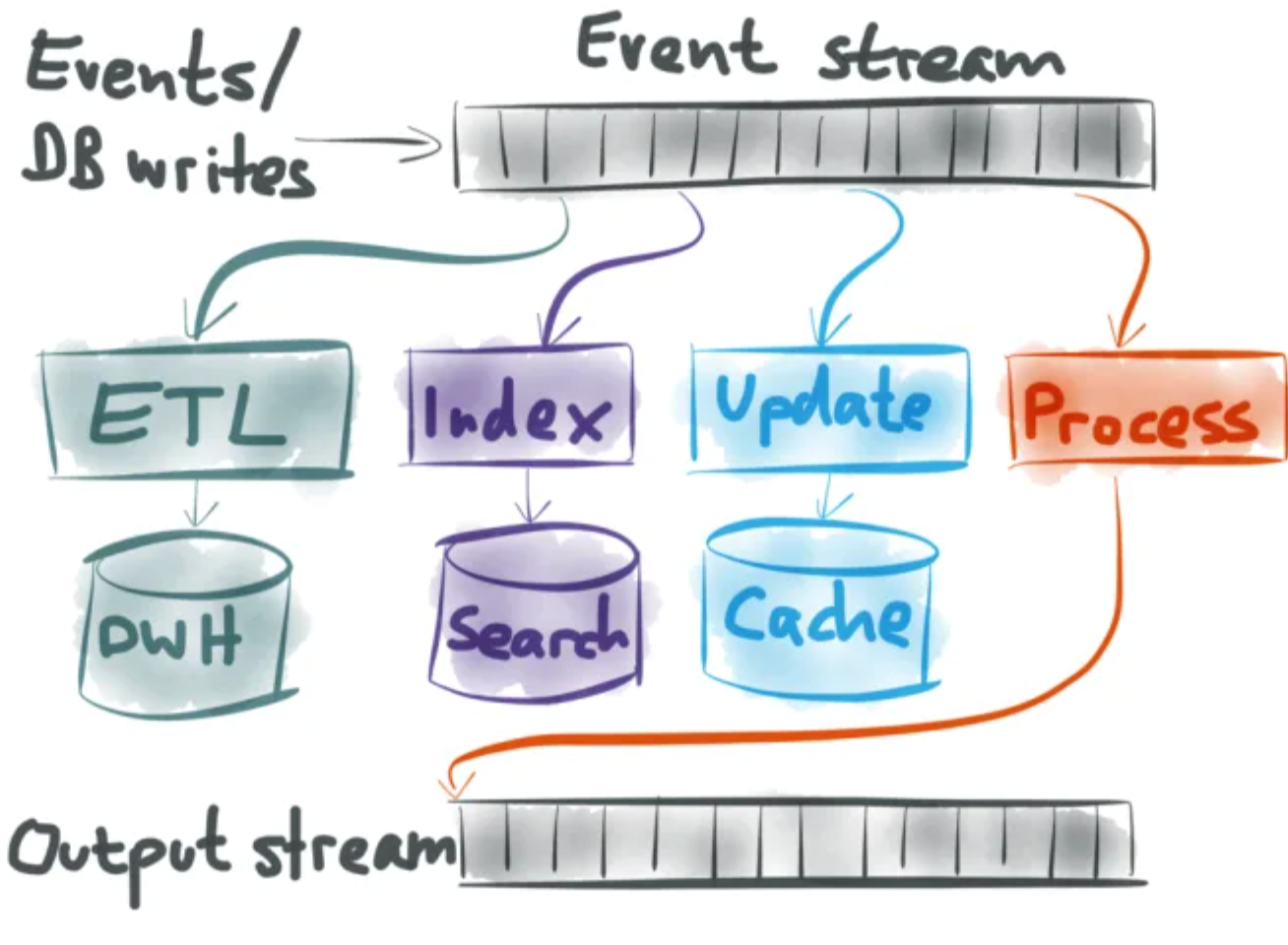

在现代Web应用中,`event-stream`是一种常用于服务器推送事件(Server-Sent Events, SSE)的技术,尤其是在需要实时更新客户端的场景中。与传统的HTTP请求/响应模型不同,SSE允许服务器在一个持久连接上向客户端推送消息。 它通常用于需要实时更新的应用,比如社交网络、股票市场数据、通知等。

它通常用于需要实时更新的应用,比如社交网络、股票市场数据、通知等。

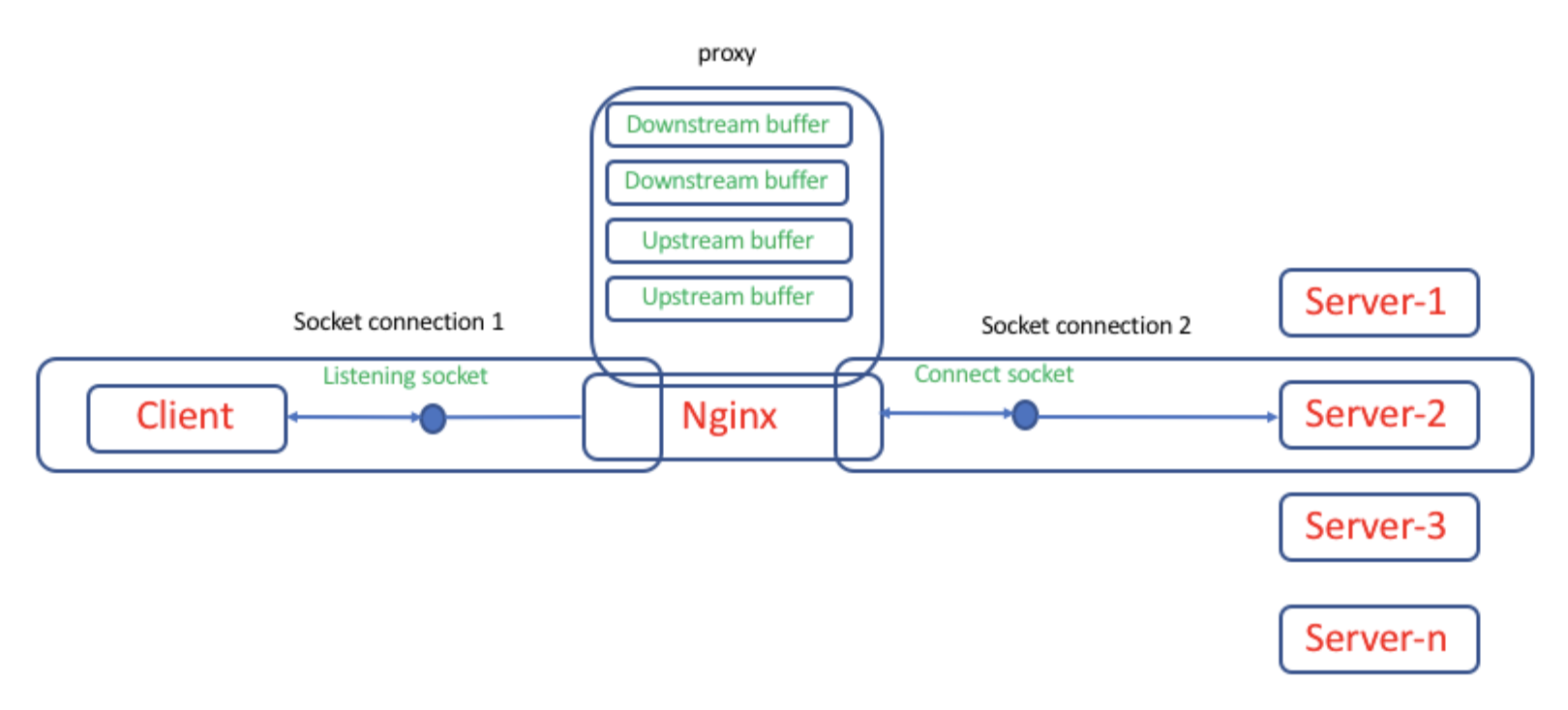

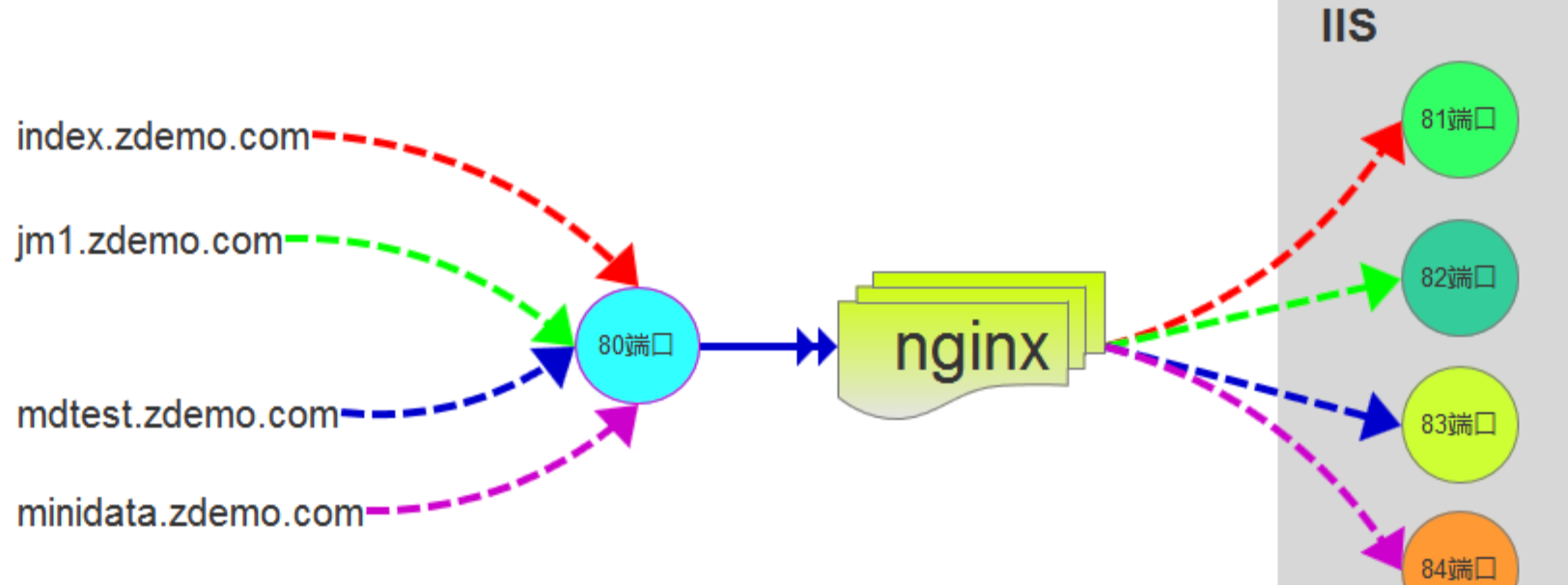

然而,使用 NGINX 作为反向代理时,可能会遇到一个问题:由于 NGINX的加速缓存机制,导致 `event-stream` 消息出现延迟或丢失。这主要是因为 NGINX会尝试缓存响应内容,以减少后端服务器的负载,但对于长连接和实时推送的数据(如 SSE),这就变得非常不适用。

2. **问题的根源**

NGINX 缓存机制的设计目标是优化性能,减少每次请求时的重复数据处理。当一个请求达到 NGINX 时,它会检查是否可以缓存响应结果,并在后续请求中直接提供缓存的内容。这个机制对于大多数静态文件和短连接的应用非常有效,但对于 `event-stream`(即长时间持久连接的实时数据流),就可能出现问题。

具体来说,Nginx 会对 SSE 或 `event-stream` 类型的消息进行缓存,导致以下问题:

-

**延迟**:缓存机制使得数据传输变得不及时。SSE 应该能够实时将消息推送给客户端,但如果 NGINX 缓存了某些数据,它可能会等缓存内容刷新之后才会发送数据,从而导致延迟。

-

**消息丢失**:缓存机制可能会忽略实时的推送消息,因为它依赖于缓存的刷新周期,这会导致客户端接收到的不是最新的事件。

3. **如何解决这个问题**

为了避免 NGINX 加速缓存机制导致 `event-stream` 消息的延迟,我们可以做出以下几个配置调整,以确保 SSE 能够顺畅地推送数据而不受缓存的影响。

(1) **禁用缓存**

首先,可以禁用 NGINX 对 SSE 的缓存。通过配置 NGINX 使其忽略缓存相关设置,从而避免缓存机制影响到流数据。

在 NGINX 配置文件中,可以设置 `proxy_cache` 相关指令来禁用缓存,具体配置如下:

```nginx

location /events {

proxy_pass http://backend-server;

proxy_cache off; # 禁用缓存

proxy_no_cache 1; # 禁止缓存

proxy_cache_bypass 1; # 允许绕过缓存

add_header Cache-Control no-cache;

add_header Connection keep-alive;

add_header Content-Type text/event-stream;

}

```

通过上面的配置:

-

`proxy_cache off`:禁用了缓存。

-

`proxy_no_cache 1`:确保不使用缓存。

-

`proxy_cache_bypass 1`:允许绕过缓存机制。

-

`add_header Cache-Control no-cache`:告诉客户端不要缓存响应。

-

`add_header Connection keep-alive`:保持连接不关闭,适用于 SSE。

-

`add_header Content-Type text/event-stream`:确保返回的响应类型正确。

(2) **调整缓存过期时间**

如果禁用缓存并不符合要求,可以通过配置缓存的过期时间,确保缓存过期后不会影响到实时数据传输。例如,可以将缓存设置为短时间过期,这样缓存不会对长连接造成太大影响。

```nginx

location /events {

proxy_pass http://backend-server;

proxy_cache my_cache;

proxy_cache_valid 200 1s; # 对 200 状态码的响应缓存1秒钟

proxy_cache_valid 404 10m; # 对 404 状态码的响应缓存10分钟

add_header Cache-Control no-cache;

add_header Content-Type text/event-stream;

add_header Connection keep-alive;

}

```

通过这种方式,尽量将缓存的有效时间设置为尽可能短的时间,以减少缓存对实时消息的干扰。

(3) **设置 `tcp_nodelay`**

SSE依赖于持续的TCP连接,如果 NGINX 配置不当,可能会导致连接在某些情况下缓慢地推送消息。`tcp_nodelay` 设置可以帮助优化长连接的性能,减少延迟。

```nginx

location /events {

proxy_pass http://backend-server;

tcp_nodelay on;

add_header Content-Type text/event-stream;

add_header Cache-Control no-cache;

add_header Connection keep-alive;

}

```

`tcp_nodelay on` 确保数据尽快发送,避免因为 TCP 队列积压而导致延迟。

(4) **调整缓冲区大小**

有时候,SSE 数据传输量较大,NGINX 默认的缓冲区大小可能会导致延迟。我们可以调整 NGINX 的缓冲区设置,确保消息不会被阻塞。

```nginx

location /events {

proxy_pass http://backend-server;

proxy_buffers 8 16k; # 设置缓冲区

proxy_buffer_size 16k; # 设置单个缓冲区大小

add_header Content-Type text/event-stream;

add_header Cache-Control no-cache;

add_header Connection keep-alive;

}

```

通过调整 `proxy_buffers` 和 `proxy_buffer_size`,可以根据实际情况优化缓冲区设置,减少消息的延迟。

4. **总结**

NGINX 的加速缓存功能对于静态文件和传统请求-响应模型的应用非常有效,但对于长连接和实时数据推送(如 SSE)来说,可能会带来延迟和消息丢失的问题。 通过禁用缓存、调整缓存过期时间、启用 `tcp_nodelay` 设置、以及调整缓冲区等方法,可以有效避免 NGINX 缓存引起的 Event-Stream 消息延迟问题,确保实时数据能够快速传输到客户端。

通过禁用缓存、调整缓存过期时间、启用 `tcp_nodelay` 设置、以及调整缓冲区等方法,可以有效避免 NGINX 缓存引起的 Event-Stream 消息延迟问题,确保实时数据能够快速传输到客户端。

这些配置可以根据实际需求灵活调整,确保系统能够高效且实时地处理大规模的 Event-Stream 消息。