A review of learning-based dynamics models for robotic manipulation

- 文章概括

- Abstract

- INTRODUCTION

- [LEARNING-BASED DYNAMICS MODELS](#LEARNING-BASED DYNAMICS MODELS)

-

- Background

-

- [Perception module 感知模块](#Perception module 感知模块)

- [Dynamics module 动力学模块](#Dynamics module 动力学模块)

- [Control module 控制模块](#Control module 控制模块)

- [Comparison with physics-based dynamics models 与基于物理的动力学模型的比较](#Comparison with physics-based dynamics models 与基于物理的动力学模型的比较)

- [STATE REPRESENTATIONS 状态表示](#STATE REPRESENTATIONS 状态表示)

-

- [2D pixel representations 二维像素表示](#2D pixel representations 二维像素表示)

-

- [Dynamics learning](#Dynamics learning)

- [Latent representations 潜在表示](#Latent representations 潜在表示)

-

- [Perception and representation learning](#Perception and representation learning)

- [Dynamics learning](#Dynamics learning)

- [3D particle representations 三维粒子表示](#3D particle representations 三维粒子表示)

-

- [Dynamics learning](#Dynamics learning)

- [Keypoint representations 关键点表示](#Keypoint representations 关键点表示)

-

- [Dynamics learning](#Dynamics learning)

- [Comparing and selecting state representations 比较与选择状态表示](#Comparing and selecting state representations 比较与选择状态表示)

- [CONNECTION TO ROBOTIC CONTROL](#CONNECTION TO ROBOTIC CONTROL)

-

- [Control methods 控制方法](#Control methods 控制方法)

-

- [Motion planning 运动规划](#Motion planning 运动规划)

- [Policy learning 策略学习](#Policy learning 策略学习)

- [Representative robotic tasks 代表性机器人任务](#Representative robotic tasks 代表性机器人任务)

-

- [Object repositioning(物体重新放置)](#Object repositioning(物体重新放置))

- [Deformable object manipulation(可变形物体操作)](#Deformable object manipulation(可变形物体操作))

- [Multiobject manipulation(多物体操作)](#Multiobject manipulation(多物体操作))

- [Tool-use manipulation(工具使用操作)](#Tool-use manipulation(工具使用操作))

- [FUTURE DIRECTIONS](#FUTURE DIRECTIONS)

-

- [Opportunities in perception(感知方面的机会)](#Opportunities in perception(感知方面的机会))

-

- [Partially observable domains(部分可观环境)](#Partially observable domains(部分可观环境))

- [Multimodal perception(多模态感知)](#Multimodal perception(多模态感知))

- [Opportunities in dynamics learning(动力学学习的机遇)](#Opportunities in dynamics learning(动力学学习的机遇))

-

- [Robust dynamics models(鲁棒动力学模型)](#Robust dynamics models(鲁棒动力学模型))

- [Foundation dynamics models(动力学基础模型)](#Foundation dynamics models(动力学基础模型))

- [Dynamics priors from foundation models(从基础模型获取动力学先验)](#Dynamics priors from foundation models(从基础模型获取动力学先验))

- [Emerging representations from graphics research(来自图形学的最新表示)](#Emerging representations from graphics research(来自图形学的最新表示))

- [Large-scale scene representations(大规模场景表示)](#Large-scale scene representations(大规模场景表示))

- [Opportunities in robotic control(机器人控制方面的机遇)](#Opportunities in robotic control(机器人控制方面的机遇))

-

- [Hierarchical dynamics modeling and planning(层级化动力学建模与规划)](#Hierarchical dynamics modeling and planning(层级化动力学建模与规划))

- [Learning to plan(学习规划)](#Learning to plan(学习规划))

- [Performance guarantees(性能保证)](#Performance guarantees(性能保证))

- CONCLUSIONS

文章概括

引用:

bash

@article{ai2025review,

title={A review of learning-based dynamics models for robotic manipulation},

author={Ai, Bo and Tian, Stephen and Shi, Haochen and Wang, Yixuan and Pfaff, Tobias and Tan, Cheston and Christensen, Henrik I and Su, Hao and Wu, Jiajun and Li, Yunzhu},

journal={Science Robotics},

volume={10},

number={106},

pages={eadt1497},

year={2025},

publisher={American Association for the Advancement of Science}

}

markup

Ai, B., Tian, S., Shi, H., Wang, Y., Pfaff, T., Tan, C., Christensen, H.I., Su, H., Wu, J. and Li, Y., 2025. A review of learning-based dynamics models for robotic manipulation. Science Robotics, 10(106), p.eadt1497.主页:

原文:

代码、数据和视频:

系列文章:

请在 《 《 《文章 》 》 》 专栏中查找

宇宙声明!

引用解析部分属于自我理解补充,如有错误可以评论讨论然后改正!

Abstract

用于预测物理交互效果的动力学模型,是机器人操作中进行规划和控制所不可或缺的关键基础。 尽管基于物理原理的模型通常具有良好的泛化能力,但它们往往需要完整的状态信息,而在复杂的真实场景中,这类信息往往很难甚至不可能从感知数据中准确提取出来。 基于学习的动力学模型通过仅依赖观测到的交互数据来学习状态转移函数,提供了一种替代方案,从而能够刻画传统模型难以建模的复杂因素与预测不确定性,并加速原本过于缓慢、难以满足实时控制需求的仿真过程。 该领域近期的成果已经在多个方面显著提升了机器人的能力,例如对可变形物体、颗粒材料的长时域操作,以及如装载与打包等复杂多物体交互任务。 在这些研究中,一个至关重要的因素是状态表示的选择,因为它决定了学习系统在对场景动力学进行降阶建模时所具备的归纳偏置。 本文对当前在设计学习型动力学模型方面的技术手段及其权衡进行了及时而全面的综述,重点强调了此类模型在与状态估计和控制方法相结合以提升机器人能力方面所发挥的作用,并指出了有待未来进一步探索的关键研究空白。

INTRODUCTION

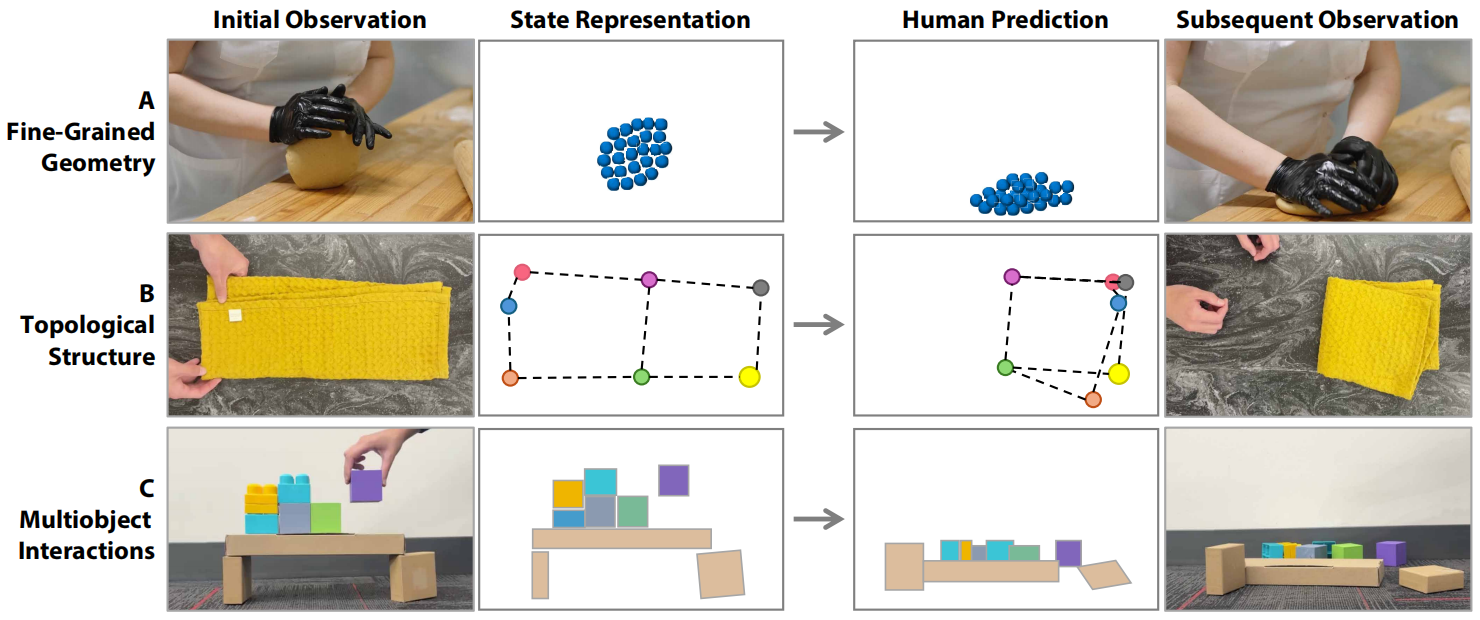

图1. 面向操作任务的人类直觉物理。 人类依赖直觉性的物理认识来完成复杂的操作任务。 根据具体任务和环境的不同,人类在心理表征中会采用不同层次的抽象:(A) 使用粒子来刻画细粒度的几何形状,(B) 使用关键点来表示结构细节,© 使用以物体为中心的表示来建模多物体交互。 我们基于上述抽象层次,示意性地展示了人类对操作动作结果的心理预测过程。 在机器人领域,基于学习的动力学模型试图通过结构化的状态表示,为机器人赋予与此类似的预测能力。

图1. 面向操作任务的人类直觉物理。 人类依赖直觉性的物理认识来完成复杂的操作任务。 根据具体任务和环境的不同,人类在心理表征中会采用不同层次的抽象:(A) 使用粒子来刻画细粒度的几何形状,(B) 使用关键点来表示结构细节,© 使用以物体为中心的表示来建模多物体交互。 我们基于上述抽象层次,示意性地展示了人类对操作动作结果的心理预测过程。 在机器人领域,基于学习的动力学模型试图通过结构化的状态表示,为机器人赋予与此类似的预测能力。

人类具有对物理世界的直觉性理解,这使我们能够与环境互动并预测其变化过程(1)。 通过处理多模态感官信息,人类会形成"心理模型",帮助我们预判自身动作将如何影响外部世界(图1)(2)。 这种直觉性的物理理解并不依赖分析性的数学方法。 然而,这种能力跨越不同材料和物体,支撑着多样化的交互技能,其表现远远超过当前机器人所能做到的。

在机器人中模仿这种直觉物理能力,本质上等同于构建能够预测动作结果并支持有效规划的预测模型。 基于物理原理的模型(3,4)通常泛化能力强,但依赖完整状态信息,而在真实操作任务中,这类信息往往难以获取。 学习型模型提供了一种替代方案:它们直接从原始感知数据中学习预测动力学,能够捕捉难以建模的因素(5,6)、推理不确定性(6--8),并加速原本过于缓慢、难以用于实时控制的高精度仿真(9,10)。 近期的研究进一步利用深度神经网络作为函数逼近器(8,11)。

尽管具有巨大潜力,学习型动力学模型仍面临一个根本挑战:如何设计能够保证样本效率与泛化能力的归纳偏置(12)。 在机器人领域这一点尤为关键,因为真实数据采集昂贵,而开放环境的状态空间巨大。 有效的模型需要紧凑的状态表示与结构化先验,以便高效处理这些信息。 然而这也带来权衡------紧凑的状态空间虽然提升泛化能力,却可能降低模型的表达能力,或增加状态估计的难度。 解决这些问题需要综合考虑任务需求、环境复杂度以及传感器类型。

本综述全面分析了学习型动力学模型,探讨其状态表示与模型结构中的权衡,以及这些选择对机器人能力的影响。 我们讨论了状态估计的感知需求、学习状态转移的模型结构,以及不同的状态表示如何影响样本效率、泛化能力与任务适应性。 鉴于学习型动力学模型越来越多地用于操作规划------包括物体重新定位(13--15)、可变形物体操作(16--19)、多模态感知(20,21)以及多物体交互(14,22,23)------因此深入讨论模型设计及其对规划的影响至关重要。 尽管已有综述讨论了相关方向,如可变形物体操作(24,25)、物理仿真(26,27)和直觉物理(28),但尚缺少专门针对学习型动力学模型的系统综述。 本工作弥补了这一空白,为机器人操作及更广泛的研究提供了重要启示。

本综述聚焦于学习型动力学模型与机器人操作的交叉领域。 因此,分析型动力学模型(如29)、可微但非学习的模型(如27)以及混合模型(如5,6)均不在本综述的讨论范围之内。 同样地,没有经过机器人操作任务验证的学习型动力学模型也不会被系统性纳入讨论。 在这一范围内,我们首先介绍学习型动力学模型,并将其与分析型仿真器进行对比。 随后,我们基于状态表示提出模型的分类方式,并讨论相关的感知与动力学学习技术。 之后,我们探讨规划算法与策略学习如何将这些学习到的动力学模型整合到机器人系统中,以实现更强的能力。 最后,我们对该领域的未来方向与挑战进行讨论。

LEARNING-BASED DYNAMICS MODELS

基于学习的动力学模型用于预测在动作作用下世界如何演化。 本文重点关注的是机器人外部环境动力学的模型。

Background

我们使用部分可观测马尔可夫决策过程(POMDP)这一框架来形式化"感知--行动"的过程。 在时间 t t t 时,智能体处于状态 s t ∈ S s_t\in\mathcal{S} st∈S ,其中 S \mathcal{S} S 表示状态空间。 智能体从环境中接收到观测 o t ∈ O o_t\in\mathcal{O} ot∈O ,随后依据策略 π \pi π 选择动作 a t a_t at,即 a t = π ( o t ) a_t=\pi(o_t) at=π(ot) ,其中 a t ∈ A a_t\in\mathcal{A} at∈A。 在动作 a t a_t at 给定的条件下,环境转移到下一状态 s t + 1 = T ( s t , a t ) s_{t+1}=\mathcal{T}(s_t,a_t) st+1=T(st,at) ,其中 T \mathcal{T} T 是环境的状态转移函数。 这一过程不断重复,直至任务目标达成,或时间步数达到任务时域 H H H。 智能体的目标是在给定时间范围内,找到一条策略,使基于状态 s t s_t st 和动作 a t a_t at 定义的代价函数 c c c 最小化,其形式为

min π E τ ∼ π [ ∑ t = 0 H c ( s t , a t ) ] (1) \min_\pi \mathbb{E}{\tau\sim\pi}\Bigg[\sum{t=0}^{H}c(s_t,a_t)\Bigg]\tag{1} πminEτ∼π[t=0∑Hc(st,at)](1)

这一形式化同时构成了经典机器人控制和基于模型的强化学习(RL)的基础:在这两种范式中,转移模型都会用于模拟未来轨迹,以支撑规划或策略学习。 关键问题在于应如何表示并构造策略函数 π \pi π。 学习得到的基于模型的方法会先用一个学习得到的函数 T ^ \hat{\mathcal{T}} T^ 来近似真实转移模型,然后再将其用于控制。 下面我们将逐一探讨这一框架的核心组成部分。

Perception module 感知模块

感知模块 g \text{g} g 根据过去的观测 o 0 : t o_{0:t} o0:t 和动作 a 0 : t − 1 a_{0:t-1} a0:t−1 来估计环境状态 s t s_t st ,即 s t = g ( o 0 : t , a 0 : t − 1 ) s_t=\text{g}(o_{0:t},a_{0:t-1}) st=g(o0:t,a0:t−1) ;在完全可观测情形下,这一关系可简化为 s t = g ( o t , a t − 1 ) s_t=\text{g}(o_t,a_{t-1}) st=g(ot,at−1)。 我们将 s t s_t st 视为从原始感知数据中推断出的、所有与任务相关信息的统一表示,它将作为后续各模块的输入。 一个核心挑战在于如何定义 s t s_t st ,使其既包含完成操作所需的充要信息,又尽可能保持紧凑。 本综述将回顾不同的 s t s_t st 选取方式及其权衡。

Dynamics module 动力学模块

动力学模型 T ^ \hat{\mathcal{T}} T^ 在给定动作 a t a_t at 的条件下,用于预测状态从 s t s_t st 到 s t + 1 s_{t+1} st+1 的转移。 其设计与 s t s_t st 的结构紧密相关,通常会利用归纳偏置来提升泛化能力和数据效率。 例如,由于具备空间等变性,图神经网络(GNN)非常自然地适用于粒子化的状态表示。 本综述将针对不同的状态表示,考察 T ^ \hat{\mathcal{T}} T^ 的模型结构设计。

Control module 控制模块

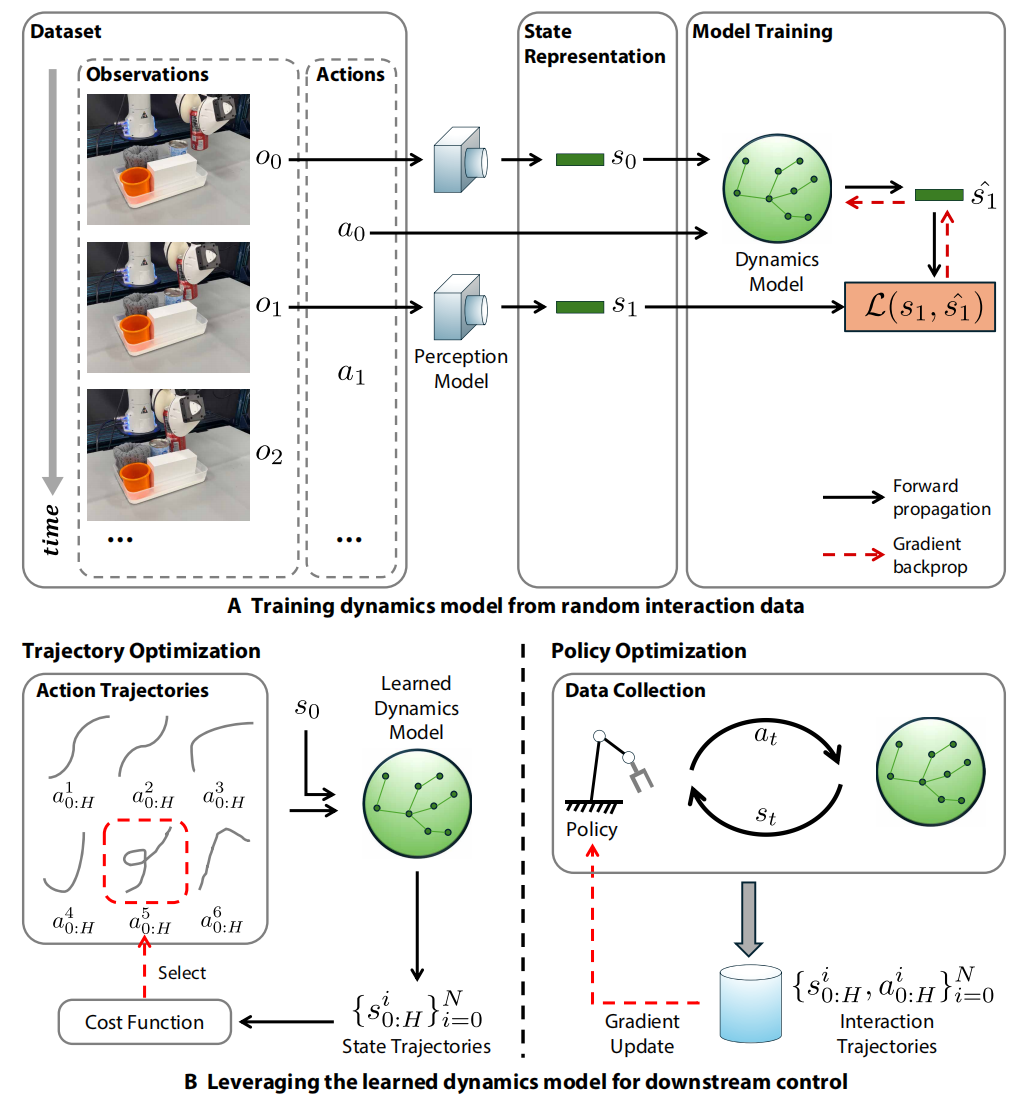

策略 π \pi π 生成控制信号,以最小化式(1)中的代价。 该策略可以通过规划或策略学习来实现,其输出既可以是基于位置的控制信号(例如末端执行器位姿),也可以是基于力的控制信号(例如关节力矩)。 策略的设计会直接影响计算效率与控制质量。 本综述将探讨控制算法如何与动力学模型相结合,从而求解具体的操作任务。 图2展示了动力学模型如何从物理交互数据中学习得到,并进一步与控制模块集成以执行下游任务。

图2. 利用基于学习的动力学模型进行机器人操作。 (A) 使用交互数据来训练一个动力学模型。 感知模型从观测 o t o_t ot 中提取状态表示 s t s_t st。 动力学以自监督的方式进行学习。 (B) 将学习到的动力学模型用于下游控制:要么通过评估用于规划的动作轨迹 { a 0 : H i } i = 0 N \{a^i_{0:H}\}{i=0}^N {a0:Hi}i=0N,要么通过生成用于策略学习的交互数据 { s 0 : H ′ i , a 0 : H i } i = 0 N \{s^i{0:H'},a^i_{0:H}\}_{i=0}^N {s0:H′i,a0:Hi}i=0N。

图2. 利用基于学习的动力学模型进行机器人操作。 (A) 使用交互数据来训练一个动力学模型。 感知模型从观测 o t o_t ot 中提取状态表示 s t s_t st。 动力学以自监督的方式进行学习。 (B) 将学习到的动力学模型用于下游控制:要么通过评估用于规划的动作轨迹 { a 0 : H i } i = 0 N \{a^i_{0:H}\}{i=0}^N {a0:Hi}i=0N,要么通过生成用于策略学习的交互数据 { s 0 : H ′ i , a 0 : H i } i = 0 N \{s^i{0:H'},a^i_{0:H}\}_{i=0}^N {s0:H′i,a0:Hi}i=0N。

Comparison with physics-based dynamics models 与基于物理的动力学模型的比较

传统上,动力学模型由解析求解器给出,这些求解器负责对控制运动的方程进行数值积分。 在机器人领域,这类方法包括刚体模拟器(30,31)以及用于可变形物体的求解器,如材料点法(material point method, MPM)(4)。 尽管经历了数十年的发展,这些模型在很多情况下仍会与真实世界行为产生偏差,这一问题通常被称为"仿真到现实"(simulation-to-reality, sim-to-real)鸿沟(32)。 这种鸿沟的产生,部分是因为诸如摩擦接触、执行器漂移等许多物理效应难以被精确建模,或者依赖难以准确测量的参数(33)。 即便参数本身估计得相当准确,诸如温度等未显式建模的潜在因素也会破坏仿真的精度。 此外,真实系统的部署还依赖精确的状态估计与系统辨识,而其中微小的误差会随时间不断累积(34)。

学习型动力学模型提供了一种替代路径:通过直接从交互数据中捕捉物理过程,从而缓解仿真到现实之间的鸿沟。 这类模型可以对状态估计误差进行补偿(35),或者在直接使用原始感知输入进行训练时,甚至完全绕开显式的状态估计过程。 除了弥合这一鸿沟之外,学习型模型通常在端到端意义上是可微的,从而支持基于梯度的规划、控制以及在线自适应。 有研究发现,与解析求解器相比,学习型模型往往提供更平滑的梯度(36),并且在计算效率上可能更具优势,尤其是在处理非刚体系统时(37)。

STATE REPRESENTATIONS 状态表示

对于基于学习的动力学模型,我们应该如何表示"世界的状态"? 一个自然的起点是使用原始观测数据,例如编码RGB(红、绿、蓝)的像素、深度信息或力场数据。 然而,状态本身只需要涵盖那些与准确预测和决策相关的环境要素。 这一需求促使我们寻找更紧凑且具结构化的状态表示方式。

一种思路是采用潜在表示,将原始观测压缩为低维编码,但这类表示往往缺乏显式的三维(3D)结构。 若要显式纳入几何信息,可以将世界离散化为粒子,用这些粒子来表示三维空间中的表面和体积。 对于许多任务而言,粒子级表示可能过于细致,而关键点通过抓取与任务密切相关的显著特征,提供了一种更抽象的替代方案。 然而,这些表示方式往往将场景视为无结构的元素集合,而人类在感知与交互时更倾向于处理离散的实体。 以物体为中心的表示会显式建模物体及其相互作用,在低层元素之上引入额外的结构。

上述各类表示反映了不同层次的抽象程度和建模假设。 更高层次的抽象表示通过聚焦于任务相关的动力学,有利于降阶建模、提升样本效率并增强泛化能力,但同时往往需要更强的感知先验,例如物体分割或关键点检测。 本节将综述针对不同表示形式的感知方法与动力学模型,并讨论其中的权衡与实际应用中的考量。

2D pixel representations 二维像素表示

也许最直接的状态表示方式就是观测到的原始像素,例如RGB(D)(其中D表示深度)数据组成的二维特征图。 这些数据通常直接来自摄像头,只需进行诸如下采样或裁剪等简单的后处理。

Dynamics learning

在像素空间中学习动力学模型可以被表述为动作条件下的视频预测问题。 在给定一个或多个上下文帧 o 0 : t o_{0:t} o0:t 以及动作序列 a 0 : H a_{0:H} a0:H的情况下,模型需要在这些动作条件下预测未来的观测 o t + 1 : H o_{t+1:H} ot+1:H。 尽管视频预测与生成在计算机视觉领域已被广泛研究,并使用与像素动力学模型相似的技术,但我们主要关注的是面向物理预测和用于规划的动作条件模型。

将像素空间模型应用于真实机器人规划的早期工作之一是 visual foresight(38)。 该方法在机器人物理交互数据上训练了一个基于光流的动作条件视频动力学模型,并将其用于规划推物任务。 此后相关扩展工作展示了其在机器人工具使用场景中的应用(39),并通过元学习实现对新物体的快速适应(40)。

Suh 与 Tedrake(41)表明,切换线性(switched-linear)像素模型同样能够取得良好表现。 基于 transformer 的模型也已被用于机器人操作(42)和大规模自动驾驶数据学习(43)。 此外,近期的视频扩散模型在学习视觉动力学方面展现了更好的可扩展性(44--46)。 这些非自回归模型不仅能够预测未来帧,还可以对中间帧进行补全(inpainting)。 Du 等人(46)利用这一特性并结合逆动力学模型实现了控制。

只要能表示为三维数组,像素预测方法就可以轻松应用于其他数据模态。 这些模态包括深度数据(47)、光学触觉传感器的感知数据(21)以及颗粒材料的密度场(48)。 像素空间模型通常通过最大似然目标,以自监督方式在视频序列上训练,其预测目标来自未来帧。 对于动作条件模型,其动作标签可以表示为末端执行器位姿或关节位置。 这些数据可通过本体感知传感器获取。 当动作标签缺失时,一些模型会推断潜在动作表示(49--51)。

像素动力学模型通常使用视频生成领域的指标进行评估。 然而,这些指标主要关注视觉外观,往往与规划性能无关(52)。 基于物理预测的基准测试(53)在一定程度上缩小了这种差距,但开发更多相关指标仍是开放挑战。

像素数据的广泛可获得性可能使得像素空间模型具备更强的泛化能力。 像素预测模型已在越来越多样化的数据集上进行训练,例如跨多台机器人和场景的机器人交互数据(54)。 GAIA-1(43)使用真实驾驶数据训练,而 UniSim(45)是一个单一模型,使用机器人数据、人类视频、互联网媒体和导航数据共同训练。

总体而言,基于像素的表示不需要显式的状态估计,并且原则上可以建模任意物理现象。 它们跳过了显式感知流水线,但由于观测空间维度高,需要大量数据才能有效学习。 卷积神经网络(CNN)是常用选择,而近期方法则使用 transformer 和扩散模型。 尽管取得了进展,这类模型仍常常难以处理物体永续性(object permanence)和时间一致性,即便在投入大量计算资源的情况下亦然(45,46)。 在控制层面,像素模型对部分可观测性十分敏感,容易产生"幻觉"(hallucination),且其高计算开销也使得实现高频控制变得困难。

Latent representations 潜在表示

由于原始观测 o t o_t ot 具有高维度与冗余性,从其直接预测动力学是具有挑战性的。 一种常见的替代方法是首先将 o t o_t ot 投影为低维的潜在向量 z t z_t zt。 尽管像素模型与潜在状态模型都可以基于像素数据训练,但二者的预测域不同: 像素模型是自回归地生成未来观测,而潜在状态模型则在抽象的潜在空间中进行预测。

这一投影通过假设状态空间可以用紧凑且平滑的参数化来表示,从而引入归纳偏置。 通过滤除无关变化,这种策略能显著提高学习效率与泛化能力。

Perception and representation learning

我们想从传感器观测里学一个"潜在状态" z t z_t zt,但要保证它真的对任务有用。 为此有两大类方法:

- "基于重建"的方法:让 z t z_t zt能把原始画面/点云"复原出来",强迫它包含足够多信息。

- "不重建"的方法:不要求复原画面,而是用其它任务(预测运动、动作、奖励等)作为学习信号,让 z t z_t zt只保留与任务相关的东西。

学习潜在表示的关键挑战在于确保潜在向量 z t z_t zt 能够编码与任务相关的特征,而不是退化到平凡解,例如将所有输入都映射到同一个常数向量。 现有方法通过施加监督结构来避免这种退化,可分为基于重建的方法与无需重建的方法。

基于重建的训练是一类常见方法,通过确保编码状态能够重建原始观测,使潜在表示保留足够的信息。 早期工作如 Embed to Control(55)利用KL散度使解码后的观测与真实观测对齐,但它假设状态依赖关系是线性的,这一限制较强。 更具表达能力的模型则使用深度网络学习非线性映射,例如变分自编码器(56)和图神经网络(57)。 通过重建体素场景训练的潜在状态还会引入强几何与三维先验(58,59)。 然而,这类模型计算开销大,不适合实时控制。

Embed to Control(55) 有一个强假设:状态之间的依赖是线性的。

- 就是说,在潜在空间里,下一步状态大概是:

z t + 1 ≈ A z t + B a t z_{t+1} \approx A z_t + B a_t zt+1≈Azt+Bat- 现实中的机器人世界往往高度非线性,这个假设太强,所以限制了模型表达能力。

变分自编码器(VAE):

- 一样是编码器--解码器结构,但对潜在变量 z z z 定义一个概率分布(高斯),

- 用 KL 散度把 q ( z ∣ o ) q(z|o) q(z∣o) 拉向先验 p ( z ) p(z) p(z),同时用重建损失逼近 o o o。

- 优点:可以生成样本、建模不确定性。

图神经网络(GNN):

- 把场景拆成"多个物体/粒子/点",每个是一个节点,节点之间有边表示相互作用(力、接触等)。

- 用图网络在这些节点之间做消息传递,实现复杂非线性交互。

- 很适合多物体系统、机器人与物体的交互。

体素(voxel):三维空间中的小立方体网格,你可以类比为 3D 版的像素。

"重建体素场景"就是:

- 给定 z t z_t zt,解码出一个 3D 体素网格(比如占据概率),

- 让它和真实场景的 3D 结构(从多视角、深度图得到)尽量一致。

这样训练出来的 z t z_t zt会天然知道"几何"和"三维结构" :哪儿有东西、物体形状如何,从而有很强的3D先验,对机器人推理物体关系很有用。

在部分可观测环境中,基于重建的训练可扩展用于推断被遮挡的状态。 动作条件隐式动力学(ACID)(60)将部分RGB-D输入编码为三维特征场,通过预测占据概率应对可变形物体操作中的遮挡。 当单步观测不足时,循环模型可汇聚历史信息(7,61)。

如果只看当前这一帧 o t o_t ot,很多信息是缺的(东西在后面挡住了)。

那就用RNN / GRU / LSTM / Transformer 等"带记忆"的模型,把过去多步的观测都结合起来:

- 每一步更新一个隐藏状态 h t h_t ht,

- z t z_t zt依赖于 h t h_t ht,而 h t h_t ht又总结了过去所有观测。

这样就能利用时间上的连续性:

前几帧看到的地方,现在虽然被挡住了,但记忆里还在,从而推断当前完整状态。

基于重建的训练可能导致潜在向量编码了与任务无关的细节。 为避免此问题,无重建方法会采用替代的学习信号。 一种方式是预测与任务相关的特征,例如用光流表示的物体运动(14)。 逆动力学学习通过训练模型预测导致状态转移的动作,使潜在特征仅保留与动作相关的信息(15)。 对比学习通过将预测的下一状态拉近真实状态、远离错误编码,从而避免平凡解(19)。 当奖励可用时,从潜在表示预测奖励可以获得紧凑、高效、任务相关的编码(62,63),但代价是模型的任务依赖性增强。

重建损失的目标是:"把整个画面尽量还原"。

但是对控制任务来说,很多细节其实没有用:

- 桌子上的纹理

- 背景墙上的海报

- 灯光细小变化......

为了重建出这些东西, z t z_t zt可能会塞满这些视觉细节,反而让表示变得:

- 维度高

- 难以泛化

- 对任务不够"专注"。

所以才会有第二类:"不要重建"的方法。

1 预测与任务相关的特征:例如光流

光流(optical flow) : 表示"像素在时间上的运动",比如从 t t t 到 t + 1 t+1 t+1,某个点从 ( x , y ) (x,y) (x,y) 走到 ( x ′ , y ′ ) (x',y') (x′,y′)。

训练方式大致是:

- 编码器提取 z t z_t zt,

- 再用网络预测当前帧到下一帧的光流场,

- 用真实估计的光流做监督。

由于光流直接反映物体运动 ,而运动跟控制任务强相关(抓、推、拉), 所以 z t z_t zt 会自然聚焦在能反映物体位姿和运动的信息上,而不去记桌子纹理这种无关细节。

2 逆动力学学习:预测"导致这个变化的动作"

正向动力学 :给定 ( s t , a t ) (s_t,a_t) (st,at),预测 s t + 1 s_{t+1} st+1。

逆向动力学(inverse dynamics) :给定 ( s t , s t + 1 ) (s_t,s_{t+1}) (st,st+1),预测中间的动作 a t a_t at: a ^ t = g ( z t , z t + 1 ) \hat a_t = g(z_t,z_{t+1}) a^t=g(zt,zt+1)

训练目标: L inv = ∣ a ^ t − a t ∣ \mathcal L_\text{inv} = |\hat a_t-a_t| Linv=∣a^t−at∣

关键点:要正确预测动作 a t a_t at, z t z_t zt和 z t + 1 z_{t+1} zt+1必须包含关于身体姿态、物体位置等"与动作相关的信息" 。 相反,那些跟动作无关的背景细节(墙面颜色)对预测 a t a_t at没帮助,所以模型不需要在 z t z_t zt里存它们。

结果:

潜在特征会专门保留"动作相关"的信息,有利于控制。

3 对比学习:拉近对的,推远错的

对比学习(contrastive learning) 大概是这样:

- 我们有真实下一状态编码 z t + 1 z_{t+1} zt+1(正样本);

- 模型从 ( z t , a t ) (z_t,a_t) (zt,at)预测出一个 z ^ t + 1 \hat z_{t+1} z^t+1;

同时,从其它时间步/其他轨迹拿来一些"不相关的状态"编码当负样本(错误编码)。

损失设计成:

- 让 z ^ t + 1 \hat z_{t+1} z^t+1和真实的 z t + 1 z_{t+1} zt+1 距离小;

- 和那些错误的状态编码距离大。

这样就有两个好处:

- z ^ t + 1 \hat z_{t+1} z^t+1必须"对得上"真实的未来状态 → 避免平凡解;

- 潜在空间被组织成"相似的放一起,不相似的分开",有利于区分不同状态。

4 用奖励作为监督:学习任务相关的紧凑编码

拆开讲:

如果我们的环境里有奖励信号 r t r_t rt(比如抓到物体+1,松手-1), 那我们可以训练一个函数: r ^ t = h ( z t ) \hat r_t = h(z_t) r^t=h(zt) 让它从 z t z_t zt预测奖励 r t r_t rt。

损失就是: L reward = ∣ r t − r ^ t ∣ \mathcal L_\text{reward} = |r_t-\hat r_t| Lreward=∣rt−r^t∣

因为奖励定义了"任务的重要性",

- 要想准确预测奖励, z t z_t zt必须保留与任务成败强相关的信息;

- 而那些对奖励完全没影响的视觉细节,自然可以被丢掉。

这会带来一个好处:

z t z_t zt变得紧凑、高效、非常任务相关。

但也有代价:

- 这个表示会高度依赖具体任务;

- 换一个任务(奖励函数变了),原来的 z t z_t zt可能就不够用了,需要重新学习或适配。

Dynamics learning

潜在动力学模型可以分为概率型 与确定性两类。 概率模型预测未来状态的概率分布,而确定性模型只估计最可能的一个结果。 两类模型通常都将动作与潜在状态拼接作为动力学预测器的输入。

概率模型利用经典统计方法或深度网络来预测未来状态的概率分布。 线性概率模型(如高斯状态空间模型)通常通过优化概率分布散度指标训练(55,64)。 更具表达能力的方法基于深度网络,且常常整合历史信息。 DayDreamer(7)与 DeformNet(59)将循环状态空间模型(RSSM)(65)应用于真实操作任务,通过循环结构保持时间记忆并捕捉不确定性。 概率模型还能通过混合密度网络与循环模型结合,输出多模态的未来预测(8)。

当环境动力学较为可预测时,确定性模型提供了更简单的替代方案。 它们可在低维潜在空间中使用多层感知机(15,57,58,62,63),在高分辨率特征图上使用卷积网络(14,60)。

总体而言,潜在状态模型已应用于多种操作场景,包括刚体、关节物体与流体。 训练目标从与任务无关的重建损失到包含奖励信号的高度任务特定损失不等。 RSSM 与 MLP 是建模低维潜在空间动力学的常用结构,其中良好结构化的表示通常带来更高的样本效率。 任务特定损失可能导致潜在表示的泛化能力不足,而任务无关方法虽可支持跨任务迁移,但在物体数量变化或场景配置变化方面的泛化仍有限。 紧凑的潜在表示计算效率高,使其能够支持快速的闭环控制。

3D particle representations 三维粒子表示

与潜在表示和像素表示不同,基于粒子的模型通过将物体表示为离散点来显式编码三维结构,从而同时刻画物体的表面与体积。 这种结构有助于精确建模物体间的相互作用,并且结合强物理先验可以提高样本效率。

粒子在基于物理的仿真方法中已被长期使用,例如材料点法(MPM)(4)。 这些技术构成了现代物理仿真器的基础(31,66),但由于依赖近似建模,会产生"仿真到现实"(sim-to-real)鸿沟,通常需要系统辨识来加以弥补(32)。 学习型粒子动力学模型则可以直接从真实数据中预测粒子的行为。

Perception and representation learning 感知与表示学习

在真实应用中,粒子通常从观测到的点云中采样得到(16,17,22,67)。 单相机方法可以通过基于梯度的优化重建点云(68),但这类重建往往噪声较大。 在训练前,数据通常会进行下采样(16,17)。 然而,在杂乱环境中,遮挡问题仍然是重要挑战。 一些方法通过引入几何先验来处理遮挡,例如假设面团会贴合与之接触的工具形状(16)。 结合历史观测和循环结构,引入触觉传感也有望提升粒子状态估计的质量(20)。

另一种方式是通过神经辐射场(NeRF)(69)利用多视角图像构建体素表示。 随后,可以通过三线性插值从体素网格中采样粒子(4)。

Dynamics learning

粒子动力学源于局部粒子间的相互作用,模型通常通过空间等变性与局部性等归纳偏置来刻画这些交互。 为此,现有方法主要采用基于图的结构或卷积模型。

图神经网络(GNN)被广泛用于建模粒子间的相互作用。 在这类模型中,粒子被视为图节点,节点特征可包含物理参数或运动与位移信息。 层次关系网络(HRN)(70)引入了分层图结构:叶节点粒子编码局部交互,而根节点则提供物体级抽象,用于处理刚体与非刚体变形。 为提升适应性,动态粒子交互网络(DPI-Nets)(57,71)在仿真过程中动态更新交互图,从而有效捕捉物体形变。 这种灵活性使 DPI-Nets 为弹塑性物体建模(17,72)、颗粒材料操作(22)、食物处理(16)以及物体装箱打包(20,73)奠定了基础。 基于图网络的仿真器(GNS)(74,75)在此基础上进一步推广,面向流体、刚体与可变形材料提供了结构更简单但精度更高的建模框架。

另一类方法使用卷积结构,在不显式构建图的情况下建模局部交互。 平滑粒子网络(SPNets)(76)使用特化卷积:ConvSP用于粒子间相互作用,ConvSDF用于与静态几何体的可微碰撞。 在此框架中,通过更新可控物体的位姿来施加动作,这些物体再与其他物体发生交互。 与图模型相比,卷积结构通常计算更高效、并行性更好,但在刻画长距离或不规则交互方面灵活性较弱。

总而言之,基于粒子的表示显式编码了几何结构,并通过粒子间的相互作用来保留物理属性。 这类表示尤其适用于可变形物体,但也已应用于刚体与流体建模。 从深度观测中估计粒子状态对遮挡非常敏感,因此常需通过点跟踪在帧间建立对应关系。 基于图的网络与卷积结构是常见的建模选择,它们提供了强归纳偏置与较高样本效率。 这些归纳偏置有助于对未见过的物体几何进行泛化,但也体现了一种权衡:更复杂的感知需求换来了基于结构化表示的更精确和更高效的动力学建模。 在控制层面,GNN在处理稠密图时可能面临可扩展性问题,而卷积网络通常更加轻量。 粒子表示还可以融合视觉、触觉等多模态输入,从而支撑精细化控制。

Keypoint representations 关键点表示

关键点表示由一些稀疏点组成,这些点可以编码隐式或显式的语义信息。 与利用密集三维点表示几何结构的粒子表示不同,关键点表示是一种更紧凑的状态表示,仅保留对任务相关的关键点。 关键点通常由一组二维或三维的坐标定义,例如,一个刚性盒子可以用其八个角点表示。 与无序的粒子集合不同,关键点通常被组织为有序列表,并且特定索引往往隐式关联某些语义信息(如视觉特征)。

想象你要让机器人操作一个杯子。

- 粒子表示:把杯子表面采样成几百上千个点,像点云那样------信息很多,但也很"重"。

- 关键点表示:只挑几个"重要点"来记,比如杯口中心、把手末端、底部中心......就几个坐标,信息少得多,却正好是操作时要用的地方。

形式上:

每个关键点是一个二维或三维坐标:

- 2D: ( x , y ) (x,y) (x,y),在图像坐标里;

- 3D: ( x , y , z ) (x,y,z) (x,y,z),在空间里。

一个物体的状态就是一串关键点:

( x 1 , y 1 , z 1 ) , ( x 2 , y 2 , z 2 ) , ... , ( x K , y K , z K ) \] \\big\[(x_1,y_1,z_1),(x_2,y_2,z_2),\\dots,(x_K,y_K,z_K)\\big\] \[(x1,y1,z1),(x2,y2,z2),...,(xK,yK,zK)

比如一个刚性盒子用 8 个角点表示,这 8 个点就能描述它的位姿和尺度。

有序列表 + 语义:

关键点通常按固定顺序排好,比如:

- index 0:杯口中心

- index 1:把手底端

- index 2:把手顶端 ...

这样,一看到"第3号关键点",模型就隐式知道"哦,那是把手末端",这就是"隐式语义"。

对比:

- 粒子 / 点云:无序的一堆点,谁是第1个谁是第20个没意义,适合用 GNN 这种"对顺序不敏感"的网络。

- 关键点列表:有顺序且每个 index 有含义,可以利用这个顺序信息。

Perception and representation learning 感知与表示学习

文献中的关键点提取方法主要包括三类:基于人工标注的监督学习、基于重建损失的无监督学习,以及利用预训练视觉模型的零样本预测。

这里分三类方法:

- 监督学习(要人工标注关键点);

- 无监督 + 重建(不标点,用"重建观测"的损失逼网络自己找关键点);

- 借助大模型做零样本(CLIP、DINO 等)。

监督学习方法通过带标注的数据训练网络来预测关键点,但关键点标注成本高、效率低,仍是主要挑战。 Keypoint affordances for category-level robotic manipulation (kPAM)(77)通过在三维空间标注关键点并将其投影到图像空间,缓解了这一问题。 Dense Object Nets(78)提出了稠密视觉描述符,通过特征相似性在时间上跟踪关键点。 该方法随后被扩展用于基于关键点的物体跟踪(13)以及可变形物体跟踪(79)。

1 监督学习:有人告诉你"关键点在哪"

原文要点:

- 用有标注的数据训练网络直接预测关键点位置;

- 但人工标注关键点很贵;

- kPAM(Keypoint affordances for category-level robotic manipulation)通过在3D空间标注点、再投影回图像,减轻标注负担;

- Dense Object Nets(DON)学"稠密描述符",通过特征相似性跟踪关键点,后续被扩展到刚体/可变形物体跟踪。

基本框架

- 有一个网络: f θ ( image ) → { p ^ k } k = 1 K f_\theta(\text{image}) \to \{\hat p_k\}_{k=1}^K fθ(image)→{p^k}k=1K 输出 K K K个关键点坐标。

- 有标注好的真实关键点 p k {p_k} pk,就可以用 L2 损失监督: L = ∑ k ∣ p k − p ^ k ∣ 2 \mathcal L = \sum_k |p_k-\hat p_k|^2 L=k∑∣pk−p^k∣2

- 问题:每张图手工点这些关键点非常耗时,特别是3D标注更难,所以这类方法标注成本高。

kPAM(77)怎么稍微省点力?

- 直接在3D空间标注少量关键点(比如在物体的 CAD 模型上点几个关键点);

- 然后,把这个3D点通过相机投影矩阵 K [ R ∣ t ] K[R|t] K[R∣t]投到图像上,得到2D位置: p 2 D = Π ( p 3 D ) p^{2D} = \Pi(p^{3D}) p2D=Π(p3D);

- 多个视角共享这些3D标注,就不用在每张图上重新手点 2D 关键点;

- 网络训练目标就变成:看到一张图片 → 预测这些 3D 关键点在图像上的位置。

Dense Object Nets(DON)(78)

这类方法稍微不一样,不是直接预测几个点,而是:

为图像的每个像素 输出一个"特征向量" f ( x , y ) f(x,y) f(x,y)(稠密描述符);

同一个物体表面的同一物理点,在不同视角和时间里,对应的像素特征向量应该很相似;

所以可以:

- 用对应关系(比如同一物体点的多视角匹配)做对比损失;

- 训练出一个能"识别物体表面点"的特征空间。

关键点怎么来?

- 你可以选某个像素点的特征当作"关键点descriptor",

- 在后续帧里,用"最近邻特征匹配"找到这个descriptor对应的位置,就能在时间上跟踪该关键点。

后续扩展:

这些稠密特征被扩展用在:

- 基于关键点的刚体物体跟踪(13);

- 可变形物体跟踪(79):比如布、绳子,通过跟踪特定表面点的特征来追踪形变。

无监督方法通常使用编码器--解码器结构,通过从关键点重建观测来提取关键点。 Transporter(80)是代表性二维方法,通过特征补全与重建,从RGB图像中提取关键点。 在三维任务中,KeypointDeformer(81)根据物体网格预测形状代表性关键点,通过源目标网格对训练以学习形变一致性。

2 无监督 + 重建:让网络自己找"重建用得上的点"

框架很像前一段"潜在表示+重建"的思路,只不过这里潜在表示就是一组关键点。

基本结构:Encoder--Decoder with keypoints

- 编码器:输入图像 → 输出一组关键点位置 & 可能还有局部特征: E ( o t ) → p k , f k k = 1 K E(o_t) \to {p_k, f_k}_{k=1}^K E(ot)→pk,fkk=1K

- 解码器:用这些关键点去"重建"原始图像或3D形状: o ^ t = D ( p k , f k ) \hat o_t = D({p_k,f_k}) o^t=D(pk,fk)

- 损失是重建误差 L ( o t , o ^ t ) \mathcal L(o_t,\hat o_t) L(ot,o^t)。

因为要重建成功,网络不得不把关键点放在对重建很关键的地方(物体的角、边缘、关节点等),于是就"自发地"学到了有意义的关键点。

Transporter(80):2D中的代表方法

任务:从RGB图像中自动提取关键点;

思路是"特征补全+重建":

- 先从源图像提取特征,

- 学习如何"transport"这些特征到目标位置,再解码成图像;

中间需要一些"锚点",这些锚点就是关键点,从它们的特征来补全和重建整个画面。

简单理解:

Transporter让网络学"场景里有几个重要的 anchor 点,从这些点搬运特征就能重建图像",这些 anchor 就是关键点。

KeypointDeformer(81):3D上的关键点 + 形变一致性

这里场景是 3D 物体网格(例如 CAD 网格);

模型要做两件事:

- 给每个物体网格预测一组代表性的关键点;

- 当同一物体在不同形变(弯曲、扭动)下,这些关键点的位置要保持对应关系一致。

训练数据是一堆源--目标网格对:

- 源形状: M src M_\text{src} Msrc

- 目标形状: M tgt M_\text{tgt} Mtgt

网络分别为两者计算关键点集合 p k src {p_k^\text{src}} pksrc、 p k tgt {p_k^\text{tgt}} pktgt,并通过某种损失(形变一致性)保证:

- 源的第 k k k个关键点 → 经过物体形变 → 对应到目标的第 k k k个关键点。

这样学到的关键点,就会自动对应物体的"稳定部位"和"形变结构",比如布料的角、边、抓取点等。

近期工作探索使用视觉基础模型进行零样本关键点检测。 RoboABC(82)通过对比语言--图像预训练(CLIP)及扩散模型特征(83,84),将机器人观测与人--物交互数据对齐以识别接触点。 B2-3D(85)通过将二维 DINO 特征投影至三维空间,以极少标注检测类别特定关键点。 "keypoints + instructions to execute" (KITE)(86)进一步扩展了这一方向,通过训练 grounding 模块,根据文本输入定位语义关键点。

3 视觉大模型 + 零样本关键点检测

这里的核心想法是:不想手动标很多关键点,也不想从头训练特征,就用已经预训练好的视觉大模型来帮忙。

视觉基础模型有哪些?

文中提到三类:

- CLIP:对比语言--图像预训练,学到"文本 ↔ 图像"的对齐空间;

- 扩散模型特征:图像扩散模型中间层的特征,包含丰富的结构信息(83,84);

- DINO:自监督视觉Transformer,输出对物体部位很敏感的 2D 特征。

RoboABC(82)

目标:在机器人场景中识别接触点(接触哪儿);

做法:

- 利用 CLIP 和扩散模型特征,把"机器人看到的画面"和"人--物交互数据"(比如人拿杯子的画面)对齐;

- 然后根据这种对齐,推断"人是在哪里抓的",转移到机器人视角,得到潜在接触关键点。

关键点在这里是"适合抓或按的位置",由人类交互示范 + 视觉大模型间接提供,而不是纯靠标注。

B2-3D(85)

- 先用 2D 的 DINO 特征处理图像,每个像素获得一个特征向量;

- 再把这些2D特征投影到3D空间(利用相机内外参、深度等);

- 在3D中,用极少量标注就可以学习类特定关键点(比如"所有椅子的座面角"、"所有杯子的把手端");

- 由于 DINO 已经提供了很强的语义特征,所以需要的标注很少(few-shot)。

KITE("keypoints + instructions to execute")(86)

在上一类基础上更进一步: 不只是"检测关键点",还要能根据文字指令 找到语义关键点。

结构上有一个 grounding 模块:

- 输入:文本描述(例如"cup handle tip")+ 图像;

- 输出:对应的关键点位置;

训练时,用少量文本--关键点对来监督这个 grounding 模块,让它学会"文字↔关键点"的对齐;

这样机器人就能根据语言指令在画面中定位关键信息位置。

Dynamics learning

关键点也可以像粒子那样使用图神经网络处理,因为它们同样表示空间点(87--90)。 然而,当关键点被组织为有序列表时,它们能够编码额外的语义信息。 因此,尽管GNN具有置换不变性、适用于无序输入,但对于有序关键点,通常使用MLP以利用其顺序信息(13,91)。 无论采用哪种方法,动作都被表示为固定维度向量,并与图节点特征或关键点特征拼接,用于动力学预测(13,88,89)。

Dynamics learning:关键点怎么用来学动力学?

1 用 GNN 处理关键点

就像"粒子表示"那一节一样,关键点也是一堆空间点:

- 每个点有坐标 ( x k , y k , z k ) (x_k,y_k,z_k) (xk,yk,zk)和可能的特征 f k f_k fk;

可以把每个关键点当作图中的节点:

- 节点特征:位置+局部特征;

- 边表示关键点之间的关系(距离、连通性等);

用图神经网络(GNN)做动力学预测:

- 给定当前关键点集 p k {p_k} pk和动作 a t a_t at → 更新到下一步关键点 p k ′ {p_k'} pk′;

- 消息传递可以模拟物体不同部位间的物理约束(关节、布料邻接点之间的相互作用等)。

这类方法适合关键点集合无序 时,因为 GNN 具有置换不变性:节点交换顺序不影响输出。

2 有序关键点:为什么用 MLP?

如果我们明确规定:

- index 0 = 左上角

- index 1 = 右上角

- index 2 = 左下角 ...

那顺序本身就编码了语义:不同 index 对应不同语义位置;

如果用 GNN,它会"把所有节点当无序集合",在消息传递时不区分"这是第几号点",会丢掉这种顺序语义;

所以,在很多关键点工作中,简单的做法是:

- 把所有关键点坐标拼成一个向量: [ p 1 , p 2 , . . . , p K ] [p_1, p_2, ..., p_K] [p1,p2,...,pK];

- 扔进一个 MLP 或 Transformer 这种对位置编码敏感的网络;

- 这样网络就知道"第1个维度是关键点1,第2个是关键点2",能利用到这个顺序信息。

3.3 动作是怎么融入动力学预测里的?

就是一句话:动作向量和关键点特征拼起来,一起输入动力学网络。

假设动作是一个向量 a t ∈ R m a_t\in\mathbb R^m at∈Rm(比如末端速度、关节命令等);

对 GNN:

- 可以在每个节点特征里附加动作:

f ~ k = [ f k , a t ] \tilde f_k = [f_k, a_t] f~k=[fk,at]对 MLP:

- 把所有关键点坐标拼成一个大向量,再把动作拼在后面:

x t = [ p 1 , ... , p K , a t ] x_t = [p_1,\dots,p_K,a_t] xt=[p1,...,pK,at]然后动力学网络 F F F输出下一步关键点: p k ′ = F ( x t ) {p_k'} = F(x_t) pk′=F(xt)

关键点表示专注于任务相关特征而非完整场景几何,因此适用于需要关注特定物体区域的控制任务。 关键点表示已用于刚体与可变形物体的操作任务。 关键点通常由训练好的检测器提取。 尽管比粒子集合更紧凑,它们对遮挡敏感,并且必须保持时间上的一致检测。 轻量级结构(如MLP或图网络)常用于学习关键点的动力学与交互。 由于关键点对应一致的、抽象的任务相关结构,模型通常可以在不同物体实例间泛化。 关键点表示的紧凑性也使其能够实现快速推理、实时规划与反馈控制。

1 优势:聚焦任务相关、适合刚体+可变形物体控制

关键点只保留任务需要的地方:比如抓取点、旋钮、门把手、布角;

不用表示整个场景的每个细节(墙、桌面纹理),状态维度很小;

对刚体:

- 几个角点就能描述姿态和尺寸;

对可变形物体:

- 选一些代表性的点(布角、棱边、折痕关键处)来描述形变状态。

2 如何获得关键点:训练好的检测器

前面说的各种感知方法(监督、无监督、零样本)本质上都是学一个检测器/提取器:

- 输入观测(图像/点云/网格)

- 输出关键点坐标;

动力学模型、控制器的输入一般是检测器输出的关键点。

3 缺点:对遮挡敏感,需要时间上一致

关键点数量少,所以一旦被遮挡没看到:

- 这个点可能就"消失"或被错误检测到别处;

为了让动力学学习顺利,我们需要:同一个物理点在时间上保持一致的 index,否则:

- 第t步"关键点3是把手顶端",

- 第t+1步"关键点3变成杯口",

- 那动力学网络会学崩。

所以,关键点检测器要做到:

- 尽量能在遮挡情况下推断出位置;

- 或者对遮挡鲁棒,保持时间一致。

4 轻量级网络:适合实时动力学与交互学习

- 因为状态是少量关键点,所以输入维度很小;

- 可以用很简单的网络(小 MLP、小 GNN)就能学到动力学;

- 相比于直接在图像/体素上学动力学,计算成本低很多,适合实时。

5 跨物体实例的泛化能力

举例:杯子这个类别

- 不同杯子:高度不同、颜色不同、花纹不同;

- 但"杯口中心"、"把手末端"这种结构意义一样;

如果关键点表示是"第0点=杯口中心,第1点=把手末端",

- 动力学和控制策略只需要学"遇到第1点就抓这里",

- 不关心杯子是红的还是蓝的、玻璃还是陶瓷;

这就是结构层面的抽象 → 容易在新实例上泛化。

6 紧凑性:快!

状态维度小 → 每次前向推理非常快;

做规划(比如在关键点空间里滚动预测几百步)也很轻;

所以可以达到:

- 高频控制回路(几十 Hz、上百 Hz);

- 实时 MPC、在线策略更新等。

用一句话收个尾这整段文字的核心意思可以压缩成:

把场景抽象成少量语义关键点,是一种紧凑又任务相关的状态表示。 它们可以通过监督、无监督重建或视觉基础模型来提取,然后用 MLP/GNN 学动力学。 关键点专注于与任务有关的部位,能跨对象泛化、支持实时控制,但对遮挡敏感,检测器需要保持时间一致。

Comparing and selecting state representations 比较与选择状态表示

不同的状态表示在建模能力、样本效率、泛化能力、任务契合度、可解释性以及计算成本等方面各自具有不同的权衡(图3)。 结构化程度较低的表示(如潜在状态、像素)简化了状态估计,但会在模型偏差与泛化方面带来挑战。 这类表示通常需要更大的数据集,并且在分布外场景中可能出现"幻觉式"预测。 这些预测不准确会影响下游控制,因为基于不可靠模型输出进行优化可能导致控制性能下降。

图3. 具有不同结构先验的状态表示谱系。 动力学模型中的状态表示从非结构化(像素与潜在表示)到结构化(粒子、关键点以及以物体为中心的表示)形成一个连续谱。 随着结构化程度的提升,模型引入了更强的先验与更高层的抽象,这有助于提升泛化能力,但也需要更复杂的状态估计。 用于说明潜在状态的"瑞士卷(Swiss roll)"示意图受 Tenenbaum 等人(132)的启发,并使用 Python 绘制。

图3. 具有不同结构先验的状态表示谱系。 动力学模型中的状态表示从非结构化(像素与潜在表示)到结构化(粒子、关键点以及以物体为中心的表示)形成一个连续谱。 随着结构化程度的提升,模型引入了更强的先验与更高层的抽象,这有助于提升泛化能力,但也需要更复杂的状态估计。 用于说明潜在状态的"瑞士卷(Swiss roll)"示意图受 Tenenbaum 等人(132)的启发,并使用 Python 绘制。

相反,结构化表示(如粒子表示与以物体为中心的表示)包含诸如空间等变性等强归纳偏置,有助于提升泛化能力与预测精度。 这些模型通常只需数小时GPU训练(17,71),并且在策略优化与轨迹优化中表现更稳健。 然而,它们在状态估计方面更具挑战。 基于粒子的方法需要时间一致的三维点跟踪,但这仍然很难获得(90)。 同样,以物体为中心的表示依赖高精度感知模块,通常使状态估计成为扩展结构化模型的瓶颈。

最优的状态表示选择取决于下游任务与硬件限制。 例如,以物体为中心的表示非常适用于多刚体操控任务(94,96,101),如物体重排(23)、堆叠(93)与滑动(14),因其抽象层次高。然而,对于流体或颗粒状材料,由于无法明确界定"物体"的概念,这类表示并不适用。 粒子表示可灵活建模可变形与非刚性物体(71,74),如面团(17)、布料(102)、软玩具(20),但通常需要多视角 RGB-D 探测以获得点云。 潜在表示与像素表示(44--46)理论上可处理任意类型的实体。 但若缺乏物理先验与明确的三维结构,它们可能产生物理上不一致的预测,尤其在切割、分裂等接触丰富的任务中。 此外,具有高反光性、透明性或视觉复杂性的材料会对 RGB 重建造成困难。

可解释性是另一个关键因素。 对于像素、粒子、关键点等表示,预测轨迹可以直接可视化,因此更容易诊断错误与改进模型。 相比之下,无重建式的潜在状态模型往往缺乏这种透明性。

最后,计算成本对机器人真实部署尤为关键。 像素表示通常需要高容量模型结构,而关键点表示常可使用小型网络。 图网络方法(常用于粒子表示)在推理成本上可能随图边数线性增长或随粒子数量平方增长,导致计算开销大。 此外,在基于梯度的动作优化中对模型反向传播会进一步增加计算负担。

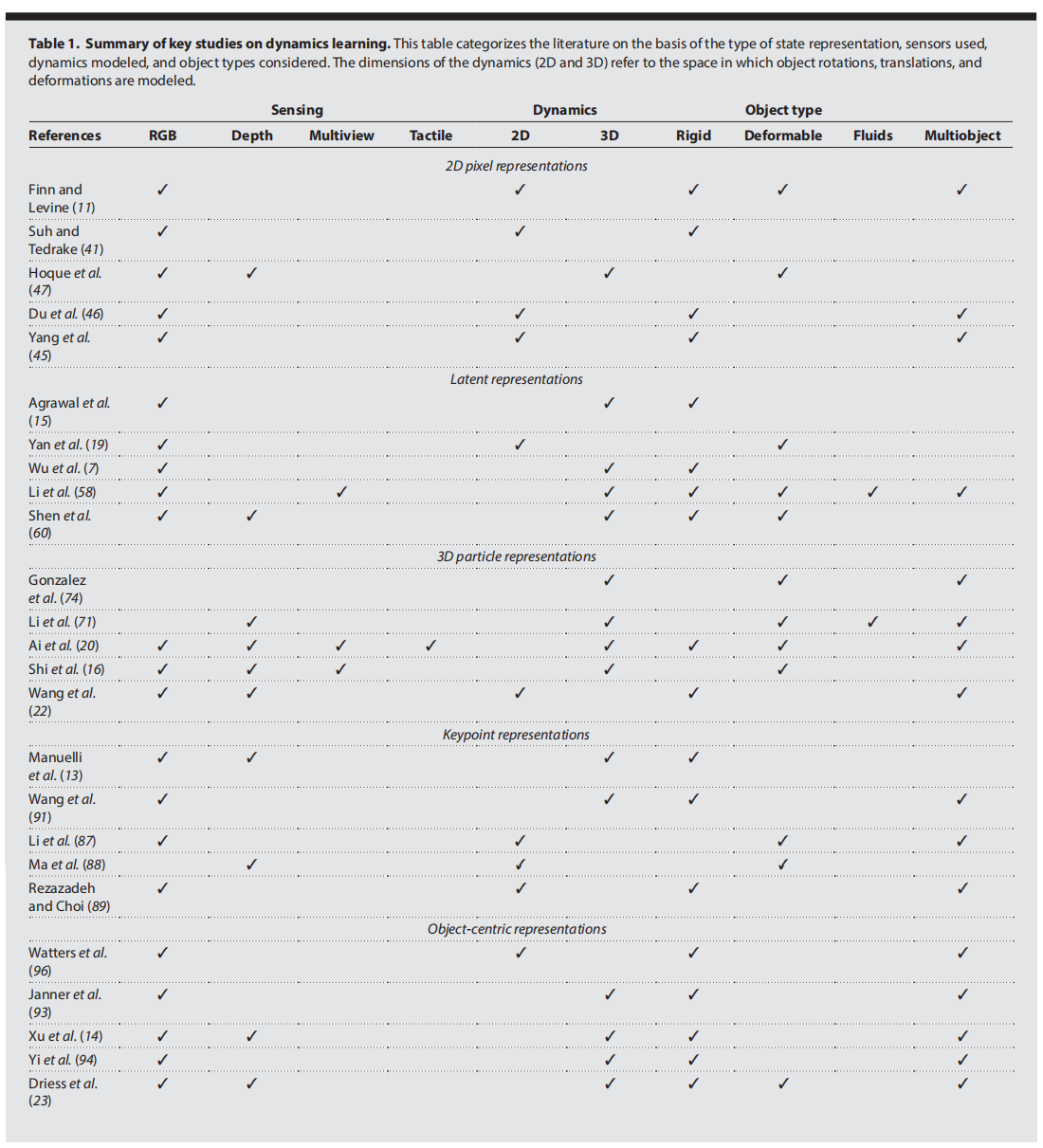

表1总结了不同状态表示在传感方式、计算需求与目标应用方面的关键权衡。 尽管现有方法在处理特定物体类型与传感输入方面表现出色,但一种能够在多样化机器人任务中泛化的统一表示仍是未来亟需探索的重要方向。

表1. 动力学学习关键研究工作的综述。 该表根据状态表示类型、所使用的传感器、所建模的动力学类型以及所涉及的物体类型对相关文献进行了分类。 其中动力学的维度(二维与三维)是指物体旋转、平移与形变被建模所在的空间维度。

CONNECTION TO ROBOTIC CONTROL

基于学习的动力学模型可以与控制模块集成,用于在预设任务目标下生成机器人的运动。 我们首先详细介绍两种利用已学习动力学模型的方法,随后讨论从这种集成中受益的典型任务。

Control methods 控制方法

基于学习的动力学模型用于控制时,主要可分为两大范式:运动规划与策略学习。

Motion planning 运动规划

运动规划的目标是在满足任务约束的前提下,从初始状态到目标状态搜索一条可行路径。 在解析模型不可用、不准确或难以获得的复杂或未知环境中,学习得到的动力学模型使规划成为可能。 运动规划方法大致可以分为路径规划与轨迹优化两类。

路径规划侧重于在不显式建模系统动力学的情况下,找到一串无碰撞的状态序列。 采样式方法,如快速扩展随机树(RRT)(103)和概率路标(PRM)(104),被广泛用于在具有复杂约束的高维空间中进行搜索。 RRT通过随机采样逐步扩展搜索树。 在此基础上,可以利用学习得到的动力学模型进行轨迹优化,将这些路径细化为动力学可行的轨迹。

轨迹优化通过在局部细化动作序列来提升任务表现,并直接利用学习到的动力学模型进行仿真与结果评估。 采样式方法(如交叉熵方法 CEM(105)与模型预测路径积分 MPPI(106))通过探索多种动作候选来进行优化,而基于梯度的方法则利用模型可微性获得的代价梯度来调整动作。 此外,学习型动力学模型还能与在线系统辨识相结合,以适应不确定的动力学(14,20,107)。

Policy learning 策略学习

与运动规划不同,策略学习旨在直接学习从观测到动作的映射。 已学习的动力学模型可以提供模拟的状态转移作为训练数据。

一种做法是生成形如 ⟨ s t , s g , a t ⟩ \langle s_t,s_g,a_t\rangle ⟨st,sg,at⟩ 的训练数据,其中状态 s t s_t st 与动作 a t a_t at 共同产生下一状态 s g s_g sg。 随后,可以训练逆动力学模型预测从 s t s_t st 到 s g s_g sg 所需的动作,从而充当目标条件(goal-conditioned)策略。 然而,在长时间滚动预测中误差可能会逐步累积;并且由于同一状态转移往往可以由多种动作实现,导致多峰的动作分布难以精确拟合。

强化学习(RL)通过反复试错交互来优化策略,以最大化累积回报。 学习到的动力学模型可以通过模拟环境转移(108)来加速这一过程,使策略在极少甚至几乎不需要真实环境交互的情况下完成训练。 但若动力学模型存在偏差,策略可能会"利用"这些不真实的模型误差,尤其是在训练数据覆盖不足的状态分布中。 这一问题可以通过在真实数据上对策略进行微调、结合模拟 rollout 的方式加以缓解(109)。

Representative robotic tasks 代表性机器人任务

基于学习的动力学模型已应用于多种任务,从物体推移到可变形物体以及多物体操作。 本节重点介绍这些模型在典型任务中的应用,以及与运动规划与策略学习技术的集成方式。

Object repositioning(物体重新放置)

物体重新放置是评估学习型动力学模型在机器人控制中表现的常用任务。 潜在表示(15,60)与像素(21)常用于单物体场景,而关键点由于刚体的自由度有限,可作为更低维的高效动力学学习表示(13)。 另一方面,多物体场景更适合采用以物体为中心的表示进行建模(23)。 在控制方面,可使用随机搜索(14,38,60)、MPPI(13,106)和CEM(11,105)等运动规划方法优化动作序列。 在线系统辨识可以处理物理属性未知的物体(20)。 此外,与前向模型联合训练的逆动力学模型可直接根据当前与目标状态推断动作(15)。

Deformable object manipulation(可变形物体操作)

可变形物体操作因形状变化维度高、接触动力学复杂而具有挑战性(24,25)。 粒子表示能够捕捉可变形物体任意几何形态(16,17,20,71,74,107,110),并可对具有显著特征的物体(如布料(88))进一步抽象为关键点。 学习型动力学模型已与轨迹优化结合,用于绳索(19,23)、布料(59)、面团(17,111)与软玩具(20)的操作。 这些模型还支持训练目标条件策略,例如在"包饺子"等长时间任务中的应用(16)。

Multiobject manipulation(多物体操作)

多物体操作需要高效规划以处理庞大的状态空间。 粒子表示(20)与物体中心表示(23)在多物体建模中表现优异,而像素表示在处理接触丰富场景时表现困难。 在利用学习到的动力学模型进行控制时,RoboPack(20)通过结合动作先验的MPPI完成物体插入操作。 基于潜在空间的RRT已与模型预测控制结合,用于长期规划与实时校正(23)。

Tool-use manipulation(工具使用操作)

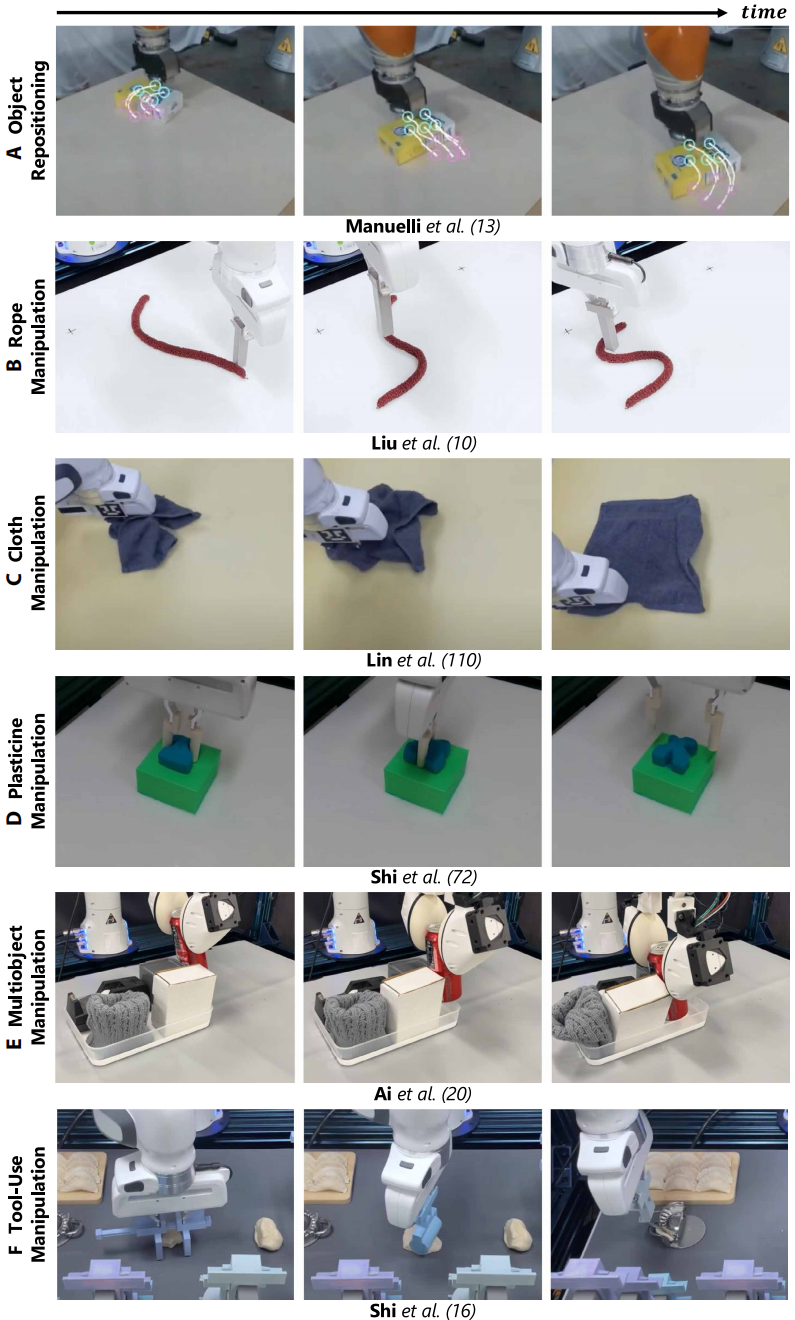

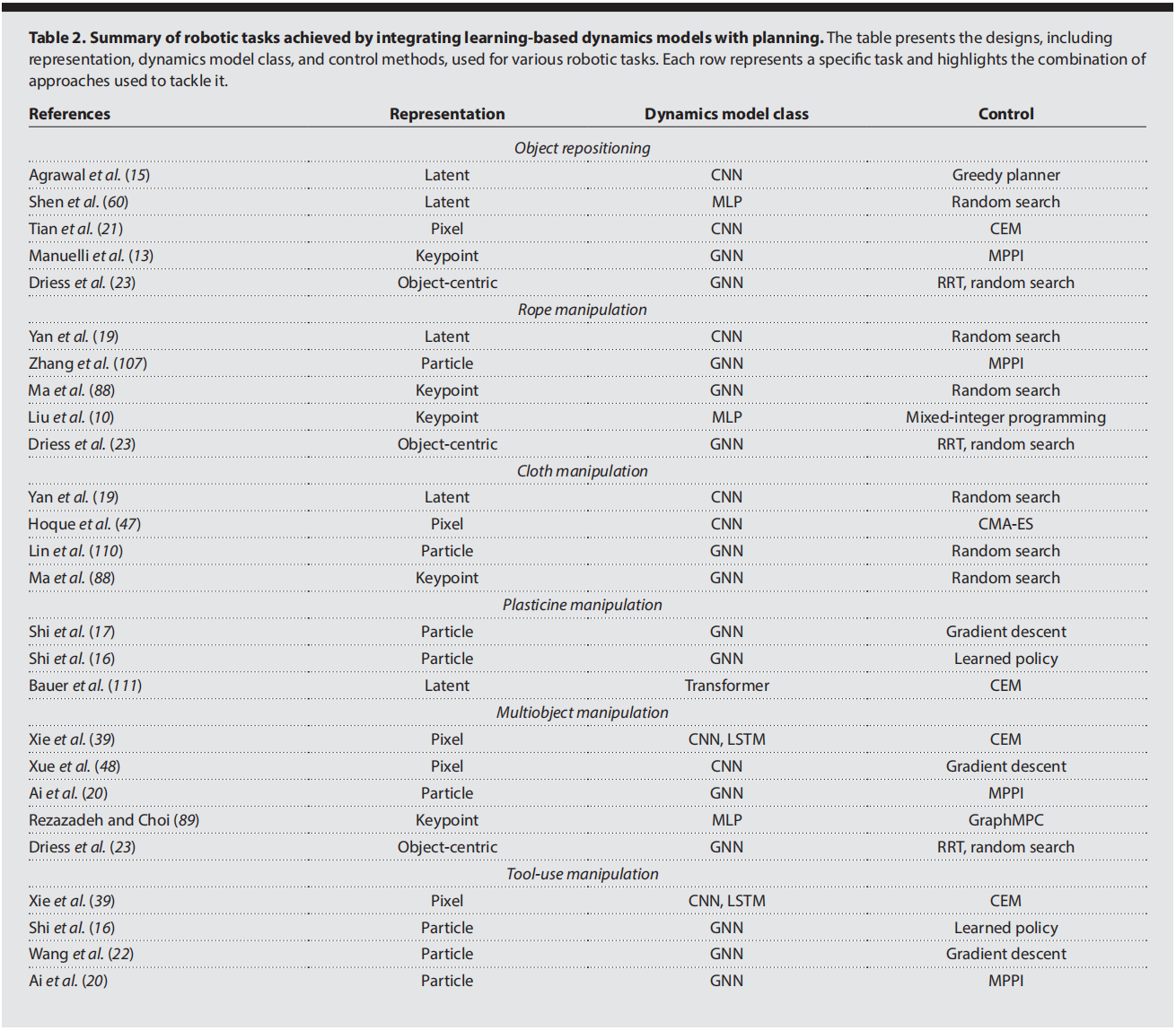

对工具使用的动力学建模可以扩展机器人的能力,使其不再局限于仅使用末端执行器直接操作物体。 粒子表示能为物体、工具和机器人末端执行器提供统一表示(16,20,22),但需要精细的3D感知;像素方法则提供一种轻量的感知替代方案(39)。 学习型模型已用于滚筒与冲压工具成型面团(16)、利用柔性工具的非抓取式箱体操作(20)以及颗粒材料操作(22)。 在需要工具选择与任务执行的复杂任务中,动作建议模型可提高基于采样的规划效率(39)。 图4展示了这些任务,表2总结了本文讨论的相关研究工作。

图4. 基于学习的动力学模型所支持的机器人操作任务。 (A) 物体重新放置,(B) 绳索操作,(C) 布料操作,(D) 橡皮泥(塑形黏土)操作,(E) 多物体操作,(F) 工具使用操作。 这些示例涵盖了刚体与可变形物体、多物体场景以及借助工具完成的操作任务。

图4. 基于学习的动力学模型所支持的机器人操作任务。 (A) 物体重新放置,(B) 绳索操作,(C) 布料操作,(D) 橡皮泥(塑形黏土)操作,(E) 多物体操作,(F) 工具使用操作。 这些示例涵盖了刚体与可变形物体、多物体场景以及借助工具完成的操作任务。

表2. 通过将基于学习的动力学模型与规划方法相结合所实现的机器人任务概览。 该表展示了针对不同机器人任务所采用的设计方案,包括状态表示、动力学模型类别以及控制方法等要素。 表中的每一行对应一个具体任务,并强调为解决该任务而采用的多种方法组合。

FUTURE DIRECTIONS

基于学习的动力学模型推动了机器人模型规划与策略学习中的自适应控制能力发展。 然而,当前系统在非结构化环境中仍远未达到人类水平的泛化能力、适应性与鲁棒性。 本节将讨论主要局限,并指出未来研究的潜在方向。

Opportunities in perception(感知方面的机会)

Partially observable domains(部分可观环境)

现实环境天然具有部分可观性,因为存在视觉遮挡和未知物理属性,如材料刚性与摩擦系数。 尽管被动历史信息(7,57)、主动感知(14)以及多模态感知(20)可提升状态估计,但在杂乱且非结构化场景中仍存在诸多挑战。 粒子等结构化表示需要高精度感知能力,而像素等低结构化模型虽无需复杂感知,却常在精度与泛化方面表现欠佳,尤其在接触动力学(45)上表现明显。 未来研究应探索新的表示方法与更鲁棒的状态估计技术,以更有效应对部分可观性问题。

1)问题是什么?

现实世界 天然是部分可观的:

- 摄像头看不见桌子背面 → 视觉遮挡;

- 物体的材料刚不刚、摩擦大不大,这些物理属性是"看不见"的。

但动力学建模又非常依赖这些东西:

- 不知道摩擦,就很难预测推一下会滑多远;

- 看不见后面的杯子,就不容易规划碰撞。

2)现在大家在做什么?

文中列了三种思路:

被动历史信息(passive history):

- 用 RNN / Transformer 等,把过去多帧的观测记在隐藏状态里;

- 虽然当前看不到,但曾经看到过,可以"在脑子里补上"。

主动感知(active perception):

- 机器人自己动一动、换个角度看、推一推物体,

- 通过行动来"探测"遮挡后面的东西或未知属性。

- 例如:用手指压一下,感觉一下硬度;从不同视角看推一下,估计摩擦。

多模态感知(multimodal):

- 不只用视觉,还用触觉、深度、力传感器等;

- 不同模态互补:视觉看形状、触觉感受材料、力觉得重量等。

但是 :在真正"乱糟糟、堆满东西"的场景里,这些方法都还不够稳。

另外两类表示的困境:

粒子等结构化表示(比如点云、3D粒子):

- 能精准建模几何和物理,但要求前端感知非常准,稍微感知错几个点,动态就乱了。

像素等低结构化表示(直接在图像上做模型):

感知端简单,但学起来难:

- 精度不高、

- 泛化差,

- 尤其在接触动力学上表现明显------光看像素,很难学到"真实的接触力"。

3)未来方向?

设计 新的状态表示,既不要像粒子那样对感知误差特别敏感,又比纯像素更有结构;

设计 更鲁棒的状态估计方法:

- 即使遮挡严重、感知噪声大,也能稳定恢复一个"够用"的内部状态;

- 可能结合:历史信息、主动视觉、多模态、先验知识等。

Multimodal perception(多模态感知)

尽管大多数现有研究依赖视觉感知,但触觉(20)与音频感知(112)等其他模态可为感知与控制提供互补信息。 然而,多模态信号的融合带来了额外挑战:不同模态间的统计分布差异使模型训练复杂化,而感知频率不一致也会在部署时造成困难。 此外,如何将不同模态的异构信号有效融合为统一表示仍是一个未解决的问题。 解决这些挑战将有助于在更广泛的任务中实现更鲁棒的动力学推理与控制性能。

1)问题是什么?

现在绝大多数工作 只依赖视觉,但我们明知道:

- 触觉可以告诉我们:软硬、粗糙、是否滑动(20);

- 声音可以告诉我们:撞上了什么、东西掉在地上、材质(112)。

这些模态对感知和控制都很有用,是视觉的天然补充。

2)多模态融合的难点在哪里?

文中点了三个坑:

分布差异大:

- 图像是一堆像素,触觉是压力阵列,声音是一维波形;

- 这些东西的"统计结构"完全不一样,把它们喂进一个模型里学联合分布,训练会变复杂。

频率不一致:

- 摄像头可能 30Hz,触觉 500Hz,音频 16kHz;

- 在线控制时,"谁对齐谁、怎么同步"是个工程+建模难题。

如何融合为统一表示?

- 我们希望得到一个统一的状态 z t z_t zt,里面同时包含视觉、触觉、音频的关键信息; *

但不同模态的"信息单位"完全不同,怎么设计网络结构/对齐机制,是个开放问题。3)未来方向?

未来可以研究:

- 多模态对齐(cross-modal alignment)、

- 多模态 Transformer / GNN、

- 不同频率下的异步融合等;

一旦搞定这些,多模态动力学模型会在更多任务里更稳定、泛化更好。

Opportunities in dynamics learning(动力学学习的机遇)

Robust dynamics models(鲁棒动力学模型)

学习得到的动力学模型中的不准确性可能会被规划或强化学习算法所利用,从而导致长时域任务的失败。 由于状态-动作空间呈组合性膨胀,在整个空间中保持鲁棒预测极具挑战性。 此外,某些状态-动作子空间难以探索或存在安全风险,从而限制了模型的反事实推理能力。 应对策略包括:使用仿真数据覆盖状态-动作空间中困难区域、引入物理先验以降低数据需求(113),以及采用概率模型表征固有随机性(7,59)。

1)问题:模型误差会被"利用"

规划器 / RL 在"玩"这个模型时,会拼命挖模型的漏洞:

- 比如模型里某些状态--动作下总代价被低估了,

- 规划器就会"专门走那里",

- 到真实世界里一试 → 崩。

2)为什么难以让模型在整个空间都准确?

状态--动作空间是组合性膨胀的:

- 比如机械臂 7 维状态 × 7 维动作 × 多物体姿态 → 数不清;

不可能在所有 ( s , a ) (s,a) (s,a) 上都有足够多数据;

有些区域:

- 难探索(机器人很难到那里)、

- 或者危险(可能撞坏设备/人), → 这些地方数据特别少,模型会特别不可信。

结果:模型的"反事实推理"(假设我从未去过这个状态,如果去会怎样)能力受限。

3)文中提出的应对策略

三条路线:

用仿真数据覆盖棘手区域

- 在模拟器里可以大胆探索困难/危险的状态--动作(例如高速撞击、极限接触);

- 把这些数据加进训练,让模型在这些区域也见过一些情况。

引入物理先验(physics priors)

在网络结构或损失里硬编码一些物理定律:

- 保守力场、动量守恒、对称性、不变量等;

有了先验,模型在数据稀疏的区域也能"合理外推",减少对大数据的依赖。

概率模型捕捉随机性

- 不只是输出一个 \\hat s_{t+1},而是输出分布 p ( s t + 1 ∣ s t , a t ) p(s_{t+1}|s_t,a_t) p(st+1∣st,at);

- 用贝叶斯网络、概率流、ensemble 等表达不确定性;

- 这样,规划/RL可以根据"不确定度"做更稳健的决策(对高不确定区域避免过度利用)。

Foundation dynamics models(动力学基础模型)

近期基础模型(114)的进展显示,大规模训练可显著提升视觉与语言模型的通用能力。 相比之下,大多数学习型动力学模型仍局限在狭窄领域,其原因是缺少带有动作标签的大规模真实数据集(19,102)。 扩大动力学模型的规模可能需要从未标注的数据(如互联网视频)中推断动作信息。 诸如学习潜在动作(51,115)等早期研究表明,这是一条值得探索的方向。

1)对比现状:视觉/语言 vs 动力学

视觉和语言有"基础模型":大模型 + 大数据 → 很强的泛化能力(114)。 动力学领域现在大多还是"小范围、小任务"的模型。

主要原因:

缺少带动作标签的大规模真实数据集(19,102)。

图像/文本可以从互联网收割海量数据;

但"带动作的动力学数据"([图像序列 + 机器人执行的动作])很难大规模采集:

- 需要真实机器人、传感器,成本高;

- 数据格式要求高。

2)加粗的方向:从未标注数据中"推动作"

扩大动力学模型的规模可能需要从未标注的数据(如互联网视频)中推断动作信息。

意思是:

想做"动力学基础模型",没法只等"机器人日志",要把视野放到 互联网视频 上:

- 例如:看大量人类操作物体的视频;

- 从中"反推"人手在干什么动作(latent actions)。

文中提到的"学习潜在动作(latent actions)(51,115)":

不直接知道真实动作指令(关节命令、力),

而是让模型自己学出一个"潜在动作空间":

- 比如:看到状态变化 ( s t → s t + 1 ) (s_t \to s_{t+1}) (st→st+1),从中抽一段向量 u t u_t ut代表"做了某种操作";

- 使得在这个潜在动作空间里,动力学变得简单/可预测。

这条路线的关键科研点:

- 如何从纯视觉序列中分离出"状态"和"动作"的概念;

- 如何在没有显式动作标签的情况下,训练出有用的 latent action 表示;

- 之后再把这个"基础动力学模型"迁移到真实机器人上。

Dynamics priors from foundation models(从基础模型获取动力学先验)

准确估计质量、摩擦、可变形性等物理属性对动力学建模至关重要,但仍然十分困难。 已有研究尝试通过视觉线索(98)、触觉感知(20)或多视角深度图(14)等途径推断这些属性。 近期基础模型表现出关于材料属性的常识性推理能力(116,117),为系统参数估计(107)提供了潜在的先验来源。 将这些先验与学习型动力学模型结合,有望减少对真实数据与在线系统识别的依赖。

1)问题:物理参数难估

质量、摩擦、可变形性等物理属性对动力学建模至关重要,但很难精确估。

- 这些参数直接决定推一下会滑多远、撞一下会不会碎;

- 但现实里很难直接量:你不可能每个新物体都拿电子秤+摩擦仪逐个测。

现有尝试:

- 用视觉线索估计:外观、纹理 → 可能推测材质(玻璃、木头、金属);

- 用触觉:压一压看"软不软";

- 用多视角深度图:估体积、结构等。

2)新的机会:基础模型里已经有"常识"

近期基础模型表现出关于材料属性的常识性推理能力(116,117)。

- 大规模视觉基础模型(例如 CLIP、VLM)看过无数图片+文字描述;

- 它们往往已经学会 "木头一般比较轻、钢锤比较重、玻璃易碎、地毯摩擦大"等常识;

- 这些常识可以看成是对物理参数的一种"先验"。

3)未来方向:把这些先验接到动力学模型上

为系统参数估计提供潜在先验来源... 将这些先验与学习型动力学模型结合,有望减少对真实数据与在线系统识别的依赖。

研究点:

给定一张物体图像,先用基础模型估一个"粗略物理标签":

- 材料+形状 → 估一个质量/密度/摩擦范围;

再把这个先验喂给动力学模型或系统识别模块:

- 相当于告诉模型:这东西可能是"中等密度、低摩擦",

- 动力学就不需要从零开始猜,数据需求减少,在线更新也更快。

Emerging representations from graphics research(来自图形学的最新表示)

计算机图形学中的场景表示为动力学学习带来了新的可能性。 基于 NeRF 的表示通过捕获多视角一致性和三维结构,弥补了直接像素表示的局限性(23,58)。 粒子模型往往难以处理平滑的连续形变,但最新的 3D 高斯散点(3DGS)(118)通过将粒子表示为高斯函数,可生成更平滑、灵活的表面,从而可能缓解这一问题。 虽然 3DGS 已被用于动态场景重建(119,120),但其与动作条件动力学模型的结合仍鲜有探索。 已有初步尝试在粒子模型中利用 3DGS 进行物体跟踪(121),但更深层的整合仍是潜在的研究方向。

1)NeRF & 3DGS 这些图形学表示对动力学有什么用?

文中先对比:

NeRF:

- 一种用神经网络表示场景的方式,输入视点→输出颜色+密度; * 强调多视角一致性和 3D 结构; *

比直接像素强,因为它有内建的3D结构。粒子模型:

- 用一堆离散点表示物体; * 做连续和光滑形变时,容易出现"块状感"、不够平滑。

3D Gaussian Splatting(3DGS):

- 把每个"粒子"当作一个高斯分布(椭球状云), * 渲染/重建出来的表面更平滑,更适合表示连续形变(118)。

目前情况:

3DGS 已经被广泛用在 动态场景重建 上(119,120)。

但是"动作条件动力学模型 + 3DGS"几乎没人认真玩过:

- 即:把3DGS当作状态表示,再学习一个"动作作用在高斯云上的动力学"。

2)文中怎么描述具体机会?

已有初步尝试在粒子模型中利用 3DGS 进行物体跟踪(121),但更深层的整合仍是潜在的研究方向。

可以理解为:

有人已经开始把3DGS用在"跟踪物体"(tracking)上:

- 随着时间和动作,更新高斯的位置和形状;

但还没有系统地:

- 用3DGS来做完整的动作条件动力学模型、控制与规划。

你的研究机会:

- 设计一个"3DGS 状态 + 动力学网络",输入动作,输出高斯的位移/形变;

- 或者,把 3DGS 和粒子/GNN等结合,既有连续外形,又有物理交互结构。

Large-scale scene representations(大规模场景表示)

多数学习型动力学模型集中于小尺度桌面环境与局部交互(10,88,111),因而在真实大范围动态场景中的适用性有限。 传统方法如 SLAM(122)能够提供全局几何地图,但缺乏动态信息。 未来方向包括构建多抽象层级的场景表示,使其同时捕获全局结构与局部交互。 需要探索利用局部交互训练动力学模型同时保持整体场景一致性的方法,并设计高效的更新机制,使其只修改受影响的场景区域(123)。

1)现状:大多停留在"小桌面"

多数学习型动力学模型集中于小尺度桌面环境与局部交互...

大部分论文都在做:

- 桌面上几个物体; * 插积木、推杯子、开抽屉;

真正的现实世界:

- 房间、楼层、甚至整栋楼; * 多个机器人、多个人、各种动态物体。

传统方法:

SLAM:构建一张全局几何地图(122);

- 很擅长"位置+静态地图"; * 但基本不管动态:东西怎么动、能不能推、怎么变形。

2)加粗的未来方向

构建多抽象层级的场景表示,使其同时捕获全局结构与局部交互。

含义:

要有一个 多层级的场景模型:

上层:

- 全局拓扑,比如房间之间的连通关系、楼层结构;

中层:

- 大物体的状态,比如门是否开着、桌子上有哪些区域;

下层:

- 桌面上几件小物体的精细几何 + 动力学交互。

需要解决的具体问题:

如何用局部交互数据 (桌面操作)来训练动力学模型,同时保证整个大场景的一致性;

如何设计"增量更新机制":

- 当你只移动了桌上的一个杯子时,

- 不需要重算整栋楼的世界模型,只更新相关局部区域(123)。

Opportunities in robotic control(机器人控制方面的机遇)

Hierarchical dynamics modeling and planning(层级化动力学建模与规划)

高度细节化的动力学模型并不总适用于规划,因为它们会导致巨大的搜索空间和高昂的计算成本。 相反,在多个抽象层级上对环境进行建模,可以在长时域任务中实现更高效的层级规划(124)。 低层级模型可用于捕获细粒度的物理交互以支持运动控制,而高层级模型可描述技能级别的转换或抽象的状态动力学,从而支持任务规划(125)。 最有效的模型通常是在满足当前决策需求的同时,保持尽可能低的复杂度的模型。 未来工作可探索在不同抽象层级上构建此类动力学模型:空间上从粒子级到物体中心表示,时间上从短时物理变化到长时间技能执行。 一个重要方向是研究如何学习统一的层级动力学模型,或如何组合并连接不同抽象层级的子模型,并将其与层级规划框架结合,从而支持跨大空间和时间尺度的决策。

1)问题:太细的动力学计划起来太贵

高度细节化的动力学模型并不总适用于规划,因为它们会导致巨大的搜索空间和高昂的计算成本。

- 如果状态里包括每个粒子的位置、每一滴液体、每个小接触点...

- 那规划时要在超高维空间里搜索动作 → 计算开销爆炸。

2)解决思路:多层级抽象

在多个抽象层级上对环境进行建模,可以在长时域任务中实现更高效的层级规划。

低层模型:

捕捉细粒度物理交互:

- 接触力、摩擦、精细轨迹;

- 用于短时间的运动控制(例如1秒内的轨迹);

高层模型:

描述技能级别的转换或抽象动力学:

- "打开门"、"抓住杯子"、"把杯子放到桌角";

- 类似离散的技能图或者抽象状态转移;

支持长时任务规划(几十秒、几分钟)。

核心原则:

"最有效的模型 = 刚好满足当前决策需求 + 尽可能简单"。

- 做长时任务→用粗抽象就够了;

- 到具体执行 → 再切换到精细动力学模型。

3)加粗的未来方向

在不同抽象层级上构建动力学模型... 学习统一的层级动力学模型或组合不同子模型,并与层级规划框架结合。

可以拆成几个研究问题:

空间抽象:

- 从粒子级 → 物体级(object-centric),甚至 → 房间级;

时间抽象:

- 从短时物理(毫秒级)→ 技能执行(秒级)→ 任务级(分钟级);

统一 or 组合:

- 学一个端到端的层级模型?

- 还是为每一层学一个子模型,然后设计接口把它们接起来?

与层级规划结合:

- 高层用 task planner 决定"哪几个技能、顺序如何";

- 低层用运动规划/轨迹优化去实现每个技能;

- 中间靠层级动力学模型保证上下层一致。

Learning to plan(学习规划)

现有研究通常获得局部准确的动力学模型,并通过设计动作空间或规划成本,将探索限制在模型支持较好的区域。 机器学习为自动化此过程提供了一条途径。 一类研究通过学习启发式搜索策略(126)或优化诸如动作空间选择(127)等代理目标来提高规划效率。 另一类方法通过学习动作生成模型,在规划过程中限制采样空间,从而减轻对全局准确动力学模型的依赖(128)。 尽管已有初步探索,但如何学习识别动力学模型的可靠区域,并在模型存在误差的情况下实现高效且鲁棒的规划,仍是未解决的挑战。

1)现状:规划时通常"手工限制"搜索空间

现有研究通常获得局部准确的动力学模型,并通过设计动作空间或规划成本,将探索限制在模型支持较好的区域。

由于模型在某些区域不准,工程师会手动:

- 限制动作范围(比如不能太快);

- 设计代价函数,让规划器尽量呆在"模型有数据的区域";

这些限制 很多是人拍脑袋设计的。

2)机器学习能帮什么?

文中列了两条思路:

学习启发式或代理目标

学一个"搜索策略"或"启发式函数"来指导规划:

- 比如学一个函数 h(s) 估计到目标的距离,用在 A* / RRT 的扩展顺序;

或学习"哪个动作子空间更值得探索"(动作空间选择、下采样策略等)。

学习动作生成模型以限制采样空间

- 训练一个模型 g ϕ ( s ) g_\phi(s) gϕ(s),给状态 s s s输出"合理动作分布",

- 在规划时,不是从整个动作空间采样,而只在 g ϕ ( s ) g_\phi(s) gϕ(s) 给出的"高概率区域"采样;

- 这样规划既快,又减少依赖"全局准确"的动力学模型。

3)加粗的未解挑战

如何学习识别动力学模型的可靠区域,并在模型存在误差的情况下实现高效且鲁棒的规划,仍是未解决的挑战。

换句话说,有两个关键问题:

学会判断"哪里模型可信":

- 比如通过不确定性估计、数据密度估计等方法;

- 在可信区域大胆搜索,不可信区域保守/绕开。

在模型有误差时,还能规划得又快又稳:

- 使用保守优化、风险敏感规划;

- 或把模型和 real-world feedback 结合,在线修正。

Performance guarantees(性能保证)

学习的动力学模型的预测误差会随时间累积,从而削弱规划性能。 诸如贝叶斯神经网络(129)和变分推断(130)等不确定性估计方法可以通过提供置信度估计来缓解这一问题。 尽管不确定性估计已用于基于模型的强化学习(109)与轨迹优化(131),但在鲁棒规划中的应用仍较为有限。 将这些技术与规划器的理论保证相结合,是实现可靠真实世界部署的一条有前景的方向。

1)问题:误差会累积,缺少理论保证

学习的动力学模型的预测误差会随时间累积,从而削弱规划性能。

- 规划一般滚动好几步、几十步甚至上百步;

- 每一步一点小误差,最后会积成很大"偏差";

- 目前很多模型只是"在实验中好用",但缺乏理论上可证明的性能保证。

2)不确定性估计技术

文中举了两类:

贝叶斯神经网络(Bayesian NN)(129):

- 把网络权重当成随机变量,输出分布而不是单点预测;

- 自然带有"置信区间"。

变分推断(Variational Inference)(130):

- 近似计算复杂后验分布的一套方法,常用于"估计模型不确定性"。

这些方法能给每一步预测提供一个"可信度"或"置信区间"。

已有应用:

- 用在基于模型的 RL(109)

- 用在轨迹优化(131) → 在这些场景里,人们已经利用不确定性做了更谨慎的探索或控制。

3)加粗的未来方向

将这些技术与规划器的理论保证相结合,是实现可靠真实世界部署的一条有前景的方向。

意思是:

不只是"经验上好用",而要:

- 把不确定性估计 * 和规划算法(MPC、RRT、DP 等)的理论分析结合起来,

目标是得到诸如:

- 在多大概率下不会撞障;

- 收敛到目标的概率有多高;

- 在什么条件下性能一定优于某个 baseline。

这是把"深度学习 + 控制理论"真正揉在一起的方向,对真实世界部署非常关键。

CONCLUSIONS

基于学习的动力学模型显著提升了机器人能力,使其能够从简单任务扩展到包含长时域规划与可变形物体的复杂场景。 状态表示的选择对动力学模型的准确性、数据效率以及状态估计需求具有关键影响。 本综述从机器人视角系统分析了动力学模型,并强调了其与感知和控制的整合。 尽管已有显著进展,构建鲁棒、可泛化且可扩展的动力学模型,使其成为机器人操作的基础工具,仍面临关键挑战。 一些根本性问题依然存在:哪种状态表示最能刻画多样化场景?如何在模型的表达能力与泛化能力之间平衡归纳偏置? 解决这些问题对于推动自适应、可解释、且鲁棒的机器人系统的发展至关重要。