入门级技术书籍

2022 年底,ChatGPT震撼上线,大语言模型技术迅速"席卷"了整个社会,人工智能技术因此迎来了一次重要进展。面对大语言模型的强大性能,我们不禁要问:支撑这些模型的背后技术究竟是什么?这一问题无疑成为了众多科研人员的思考焦点。

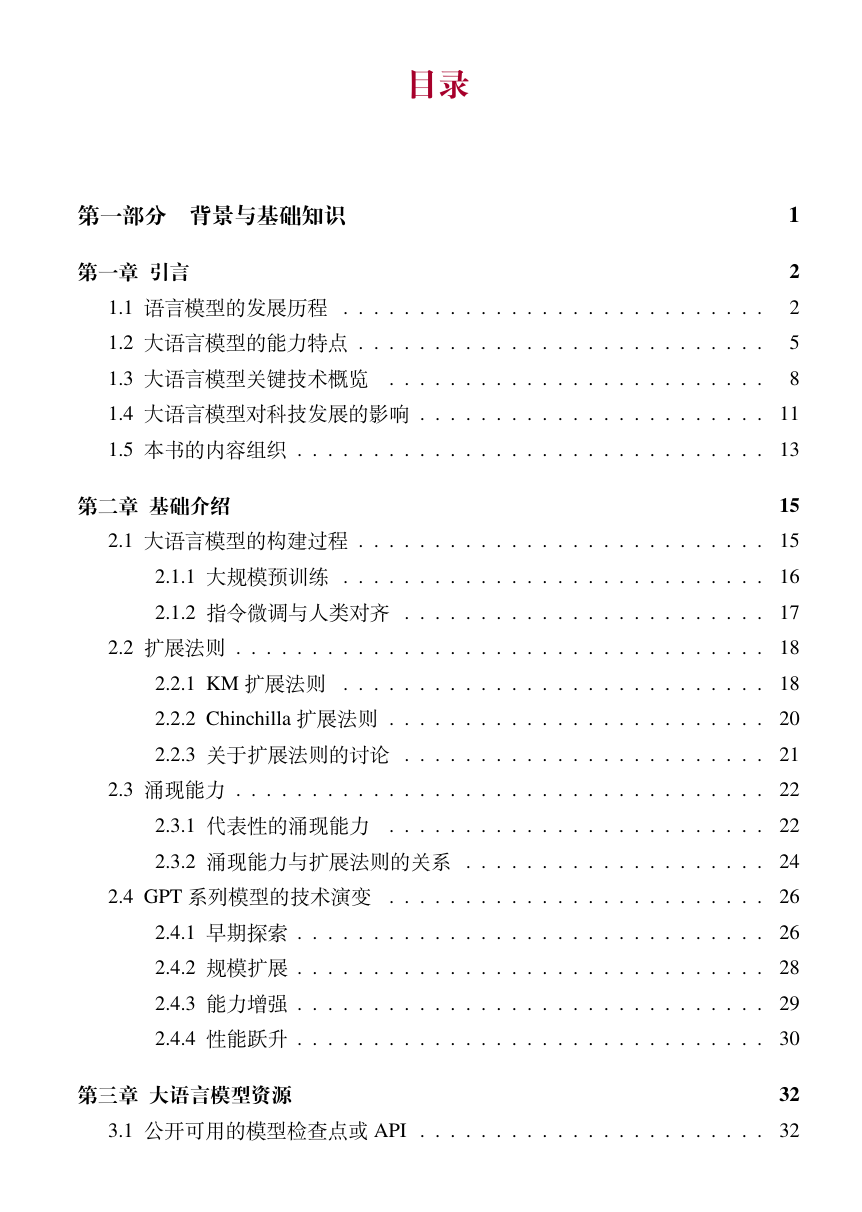

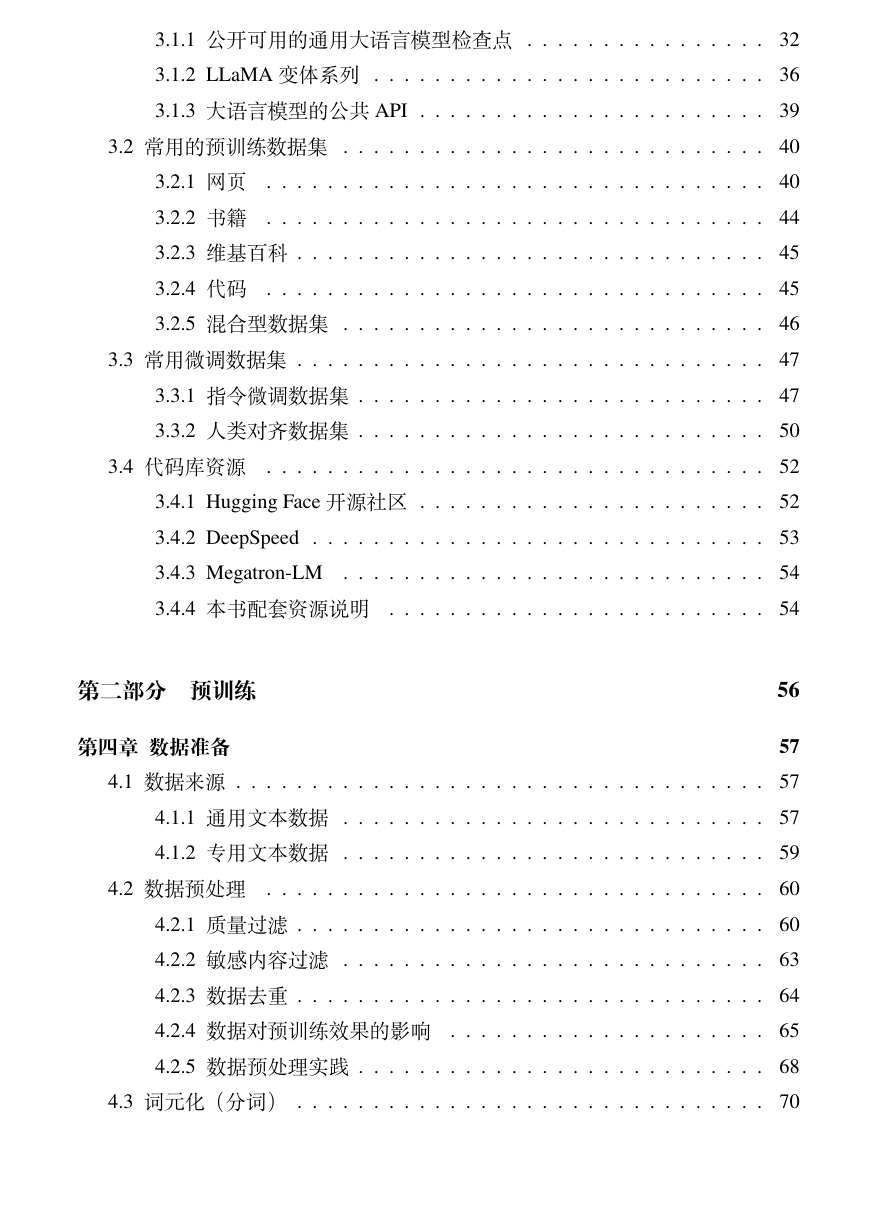

必须指出的是,大模型技术并不是一蹴而就,其发展历程中先后经历了统计语言模型、神经网络语言模型、预训练语言模型等多个发展阶段,每一步的发展都凝结了众多科研工作者的心血与成果。作为大语言模型技术的重要推动者,OpenAI公司引领了本次技术变革,让我们再次回顾其针对大模型技术的研发历程。2015年,OpenAI 公司正式创立,开始探索通用人工智能的技术路线。早期的OpenAI团队围绕强化学习、多模态、语言模型等几个重要方向进行了深入研究。其中,由Ilya Sutskever 领导的团队主要关注语言模型的研究。当谷歌2017年推出基于注意力机制的Transformer模型后,OpenAI团队迅速洞察到了其潜在的优越性,认为这种模型可能是一种大规模可扩展训练的理想架构。基于此,OpenAI团队开始构建GPT系列模型,并于2018年推出了第一代GPT模型---GPT-1,能够通过"通用文本训练-特定任务微调"的范式去解决下游任务。接下来,GPT-2和GPT-3模型通过扩大预训练数据和模型参数规模,显著提升了模型性能,并且确立了基于自然语言形式的通用任务解决路径。在GPT-3的基础上,OpenAI又通过代码训练、人类对齐、工具使用等技术对于模型性能不断升级,推出了功能强大的GPT-3.5系列模型。2022年11月,ChatGPT正式上线,能够以对话形式解决多种任务,使得用户能够通过网络API体验到语言模型的强大功能。2023年3月,OpenAI推出了标志性的GPT-4模型,将模型能力提升至全新高度,并将其扩展至拥有多模态功能的GPT-4V模型。

反观GPT系列模型的发展历程,有两点令人印象深刻。第一点是可拓展的训练架构与学习范式:Transformer架构能够拓展到百亿、千亿甚至万亿参数规模,并且将预训练任务统一为预测下一个词这一通用学习范式;第二点是对于数据质量与数据规模的重视:不同于BERT时代的预训练语言模型,这次大语言模型的成功与数据有着更为紧密的关系,高质量数据、超大规模数据成为大语言模型的关键基础。上述的思路看似简单,但能够从早期众多的技术路线中寻找到这条路线,并且坚定地去执行这条路线,这就是OpenAI成功的关键所在。回顾OpenAI的早期论文,实际上早在GPT-2的论文中,就深入讨论了基于大规模文本预训练的通用任务学习范式,让人不禁感叹OpenAI团队的技术前瞻性。虽然这种研究模式很难复制,但是值得我们去思考、学习。

OpenAI 团队自 GPT-3 开始,就很少在公开的材料中提及相关技术细节,很多技术报告主要是介绍评测相关的内容。到目前为止,关于GPT系列模型的核心技术仍然难以完全解密。虽然有众多公司在尝试复刻GPT水平的大语言模型(如Anthropic、Google 等),但是整体来说,OpenAI仍然在大模型技术上有着较大的领先性。根据SamAltman的公开采访介绍,尚未发布的GPT-5相比GPT-4将会有重要的技术进步。如果事实如此,那么GPT-5的到来将再次拉大了与当前其他大语言模型的差距,可能意味着人类向着通用人工智能又迈出了重要一步。

相信有很多人都会有一个共同的疑问:为什么GPT水平的大模型难训练?关于为何GPT级别的大模型难以训练,许多人可能会首先想到算力的限制。确实,为了训练百亿级别的高水平大模型,通常需要最少百卡级别的A100/A800(80G)资源,而为了充分探索训练过程中的各种细节,往往需要有千卡级别的A100/A800 (80G) 资源作为支撑。而对于千亿、万亿模型来说,所需要耗费的算力资源更是极为庞大。目前,学术界面临的重大挑战是真正有充足资源去尝试预训练技术的团队少之又少,因此导致了第一手经验匮乏,难以直接开展相关研究。

大模型训练涉及众多训练的细节,这些细节很多时候无法从已有科研论文中直接获取。在统计学习时代,可以针对机器学习模型进行非常充分的实证研究,例如使用栅格搜索参数的最优值、选择核函数、执行交叉验证等。通过广泛的调优实验,研究人员很快就能积累充足的训练经验,进而形成对于这些统计机器学习模型的深入理解。但是,大语言模型由于参数众多、组件复杂、训练过程也比较复杂,早期的实验探索如果不引入任何先验知识,可能会导致指数级增长的实验数量。然而,现实情况是,很多研究人员并没有足够的资源去完成一次完整的大规模预训练实验,这使得掌握大模型技术的第一手经验变得尤为困难,更不用说从零开始探索相关科研问题,极大限制了学术界在此次人工浪潮中所起到的作用。目前,能力较强的大语言模型基本都源自工业界,这一趋势随着时间的推移可能会变得更加明显。从第一手经验中"Know-How",对于科研人员来说非常重要,只有接触到技术核心,才能真正理解哪些问题是有意义的,并找到解决方案。

令人欣喜的是,无论是在学术界还是工业界,人们都逐渐认识到了"开放"的重要性,能够看到越来越多的公开的基础模型、技术代码以及学术论文,有力地推动了大模型技术的"透明化"。只有通过开放和共享,才能汇聚全人类的智慧,共同推进人工智能技术的发展。实际上,根据现有公开的资料,大模型技术也是"有章可循"的,如整体训练流程、数据清洗方法、指令微调技术、人类偏好对齐算法等。根据这些技术,在算力资源支持下,研发人员已经能够较为顺利地完成大模型的整体训练流程,并取得不错的模型效果。随着更多核心技术的揭示和开放,大模型技术的"透明化"将进一步提高。

本书适用于具有深度学习基础的高年级本科生以及低年级研究生使用,可以作为一本入门级的技术书籍。

零基础入门AI大模型必看

陆陆续续也整理了不少资源,希望能帮大家少走一些弯路!

无论是学业还是事业,都希望你顺顺利利 !

1️⃣ 大模型入门学习路线图(附学习资源)

2️⃣ 大模型方向必读书籍PDF版

3️⃣ 大模型面试题库

4️⃣ 大模型项目源码

5️⃣ 超详细海量大模型LLM实战项目

6️⃣ Langchain/RAG标题一/Agent学习资源

7️⃣ LLM大模型系统0到1入门学习教程

8️⃣ 吴恩达最新大模型视频+课件