神经网络的"身体结构"与"大脑开关"

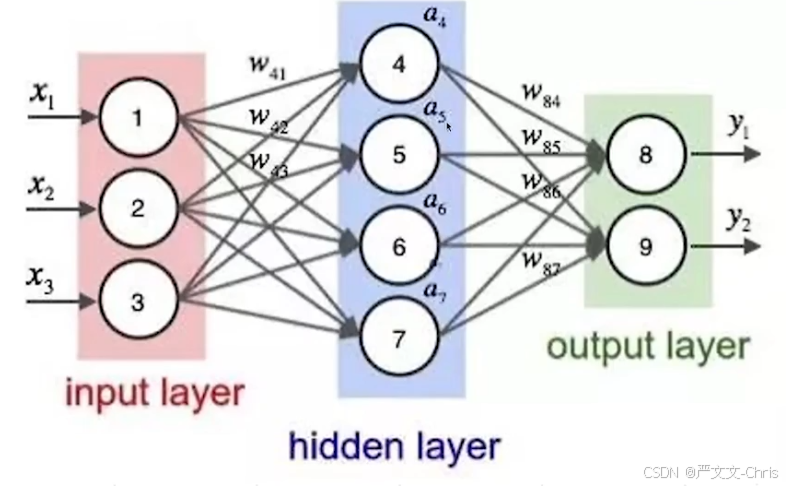

神经元网络(Neural Network),也称人工神经元网络(Artificial Neural Network,简称ANN),是一种模仿生物大脑神经元之间相互连接和传递信息的计算模型。它由大量的神经元组成,这些神经元通过连接权重相互连接,形成一个复杂的网络结构。

神经元网络通常由以下几个元素组成:

- 神经元(Neuron):神经元是网络的基本单元,它接收输入信号并产生输出信号。

- 连接(Connection):连接是神经元之间的路径,通过连接传递信号。

- 权重(Weight):权重是连接的强度,它决定了信号在神经元之间的传递效果。

- 偏置(Bias):偏置是神经元的额外输入,用于调整神经元的激活水平。

- 激活函数(Activation Function):激活函数用于对神经元的输入进行非线性变换,常见的激活函数包括 sigmoid、ReLU 等。

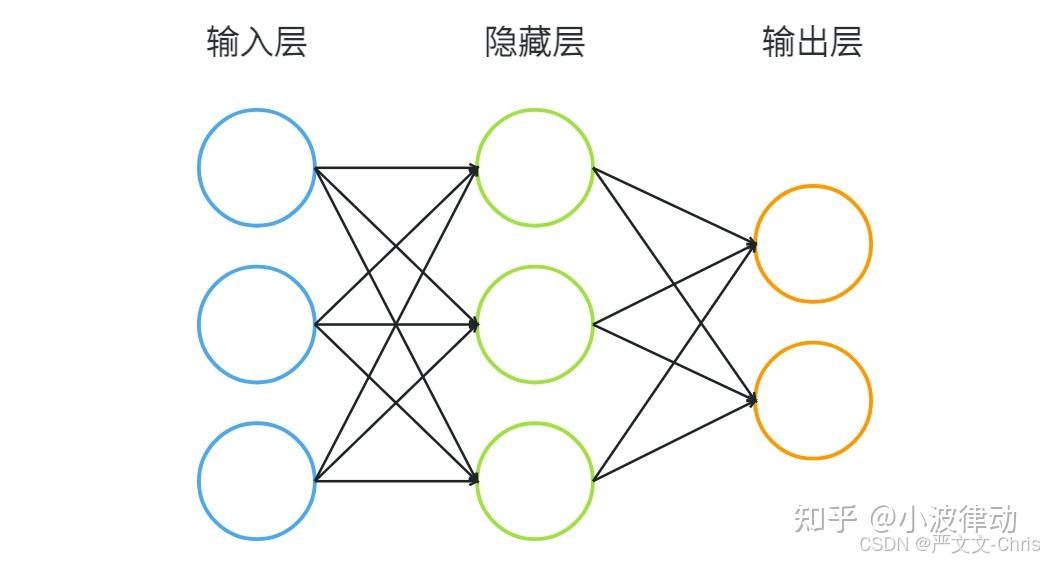

- 全连接(Fully Connected):上一层的每个神经元都跟下一层的每个神经元连接。

- 深度(Depth):指隐藏层的数量。

- 宽度(Width):指每层神经元的数量。

神经网络的四大组成部分

1. 神经元:最基本的"脑细胞"

结构:一个微型计算单元

输入 → [加权求和 + 激活函数] → 输出工作流程:

- 收集信号:从其他神经元接收输入(如:看到"圆形")

- 加权计算 :不同输入重要性不同

- "圆形"权重高(+0.9)

- "红色"权重中(+0.5)

- "有把手"权重低(-0.2)

- 判断激活:超过阈值就"兴奋"

2. 层:神经元的"朋友圈"

三种关键层:

输入层:感觉器官

- 作用:接收原始数据

- 神经元数 = 数据特征数

- 例子 :

- 图片识别:每个像素一个输入神经元

- 房价预测:[面积, 房龄, 位置] → 3个输入神经元

隐藏层:思考过程

- 作用:真正学习、提取特征的地方

- 深度学习的"深度":就是隐藏层多

- 像什么 :

- 浅层网络(2-3层)→ 初级思考

- 深层网络(100+层)→ 深度推理

输出层:给出答案

- 作用:输出最终结果

- 设计 :

- 二分类:1个神经元(概率)

- 多分类:N个神经元(每个类别的概率)

- 回归:1个神经元(数值)

3. 连接权重:神经元间的"信任度"

本质:每个连接上的数字,表示重要性

关键理解:

- 正权重:促进关系(看到猫→说"猫")

- 负权重:抑制关系(看到猫→不说"狗")

- 零权重:没连接

训练的本质:调整这些权重值,让网络预测更准

4. 偏置:每个神经元的"个性阈值"

作用:决定神经元"多容易兴奋"

类比:

- 偏置高:乐天派,容易说"是"

- 偏置低:保守派,不容易说"是"

公式中的角色:

输出 = 激活函数(权重×输入 + 偏置)⚡ 激活函数:神经元的"开关"与"性格"

为什么需要激活函数?

没有激活函数 :神经网络只是线性回归的堆叠,解决不了非线性问题

例子:

- 问题:判断一张图是猫还是狗

- 线性模型:只能画一条直线分割

- 现实:猫狗特征复杂,需要曲线边界

- 激活函数:引入"弯折",让网络能拟合复杂边界

四大经典激活函数

1. Sigmoid:温和的"S型"开关

f(x) = 1 / (1 + e^{-x})特点:

- 输出0~1之间(像概率)

- 历史最早使用

- 问题:两头饱和,梯度消失

像什么:老式收音机旋钮,转到底就没反应了

2. Tanh:改进的"双曲正切"

f(x) = (e^x - e^{-x}) / (e^x + e^{-x})特点:

- 输出-1~1之间

- 比Sigmoid梯度更强

- 仍有梯度消失问题

像什么:有正负反馈的调节器

3. ReLU:现在的主流"整流器"

f(x) = max(0, x)特点:

- 输入>0:原样输出

- 输入≤0:输出0

- 优点 :

- 计算简单(快!)

- 缓解梯度消失

- 缺点:神经元可能"死亡"(永远输出0)

像什么:二极管,单向导通

4. Softmax:输出层的"公平投票"

特点:

- 将多个输出变成概率分布

- 所有输出和为1

例子:猫/狗/兔子三分类

原始输出:[3.2, 1.3, 0.2]

Softmax后:[0.88, 0.11, 0.01] ← 88%概率是猫🔧 激活函数的三大核心作用

作用1:引入非线性

没有它 :再多层也只是线性变换的叠加

有它:网络可以拟合任意复杂函数

类比:

- 线性:只能画直线

- 非线性:能画曲线、波浪线、任意形状

作用2:控制输出范围

- Sigmoid:约束到(0,1) → 适合概率

- Tanh:约束到(-1,1) → 适合有正负的信号

- ReLU:约束到[0,∞) → 适合激活强度

作用3:决定梯度流动

- 梯度大:学习快

- 梯度小:学习慢甚至停止

- 梯度消失:深层网络的核心难题

实战选择指南

隐藏层用什么?

- 首选ReLU:90%情况,简单高效

- 特殊需求 :

- 需要负输出 → Leaky ReLU

- 更稳定 → ELU

输出层用什么?

- 二分类:Sigmoid + 1个神经元

- 多分类:Softmax + N个神经元

- 回归:线性激活(不用激活函数)

用现实世界理解神经网络组成

类比1:公司决策系统

输入层(各部门汇报)

↓

隐藏层(中层经理分析)

↓

隐藏层(高管决策)

↓

输出层(CEO最终决定)- 权重:不同意见的重要性

- 偏置:决策者的倾向性

- 激活函数:是否采纳某个建议的规则

类比2:烹饪过程

食材(输入层)

↓

切菜洗菜(第一隐藏层:初级处理)

↓

炒菜调味(第二隐藏层:高级处理)

↓

装盘(输出层)- 权重:每种调料放多少

- 激活函数:火候控制(大火爆炒vs小火慢炖)

💡 核心要点总结

神经网络 = 乐高积木

- 神经元 = 单个积木块

- 层 = 一层积木

- 权重 = 积木连接紧密度

- 偏置 = 每个积木的"个性"

- 激活函数 = 积木块的"连接规则"

激活函数 = 决策原则

- ReLU:"有利就做,不利就躺平"

- Sigmoid:"谨慎考虑,温和表态"

- Softmax:"分配注意力,重点突出"

最终真相

- 神经网络通过权重学习知识

- 通过偏置调整敏感度

- 通过激活函数获得解决复杂问题的能力

- 没有激活函数的神经网络 ≈ 高级计算器

- 有激活函数的神经网络 ≈ 能学习的智能系统

记住这个公式:

智能 = 结构(层与连接) × 参数(权重与偏置) × 非线性(激活函数)这就是为什么三个臭皮匠(简单神经元)加上好的组织方式(网络结构)和决策规则(激活函数),能顶一个诸葛亮(解决复杂问题)!

参考:神经元网络概述