GS统一存储现在支持GPUDirect存储技术了!对于需要极高算力和极高带宽的应用,如AI训练、高性能计算,以及实时分析,这项功能能够显著提升运行效能。

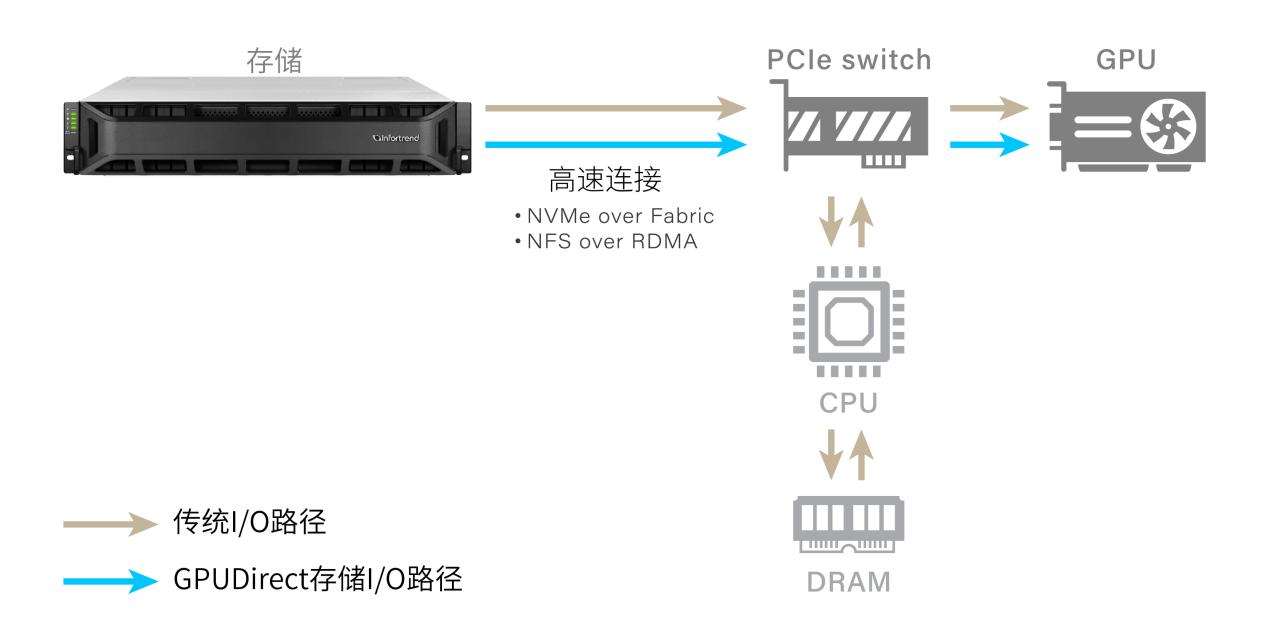

在传统架构中,数据I/O的路径为:从存储经过服务器的CPU和内存,最终到达服务器GPU。GS现在支持 NVMe over Fabric 和NFS over RDMA,通过GPUDirect存储技术建立高速率、低延迟的数据路径,绕过服务器的CPU和内存。数据从GS存储直通服务器GPU,使得GPU能够以最高效率运行。

GPUDirect存储技术优势

超低延迟:数据直接从存储传输到GPU,最大程度减少延迟,加快处理速度。

更高带宽:绕过服务器CPU让存储充分利用带宽,实现更高的传输速率。

提升GPU效率:降低GPU等待时间,更多时间用于计算,从而提高效率。

降低服务器CPU和内存的开销:避免CPU出现瓶颈,释放CPU资源用于其他系统任务。并且减轻服务器内存消耗,简化系统配置。

GPUDirect存储技术提速数据加载,加快高负载应用的运行。这些应用的性能通常受限于I/O速度,因此使用GPUDirect存储技术,业务运行时间、数据处理周期都得以有效缩短。

例如AI训练与深度学习,该项技术可以快速向GPU传输大规模数据集,加速模型开发。而对于高性能计算,能够提升模拟、科学分析及高级计算的性能。在金融、智能制造、物流领域,可以实现即时数据访问与处理,显著改善实时分析。在影视行业,更高的读写能够加快视频渲染和转码。在科研领域,该技术非常适合需要大规模数据的分析应用,如图形分析。