文章:https://arxiv.org/abs/2511.21053

代码:https://github.com/shawnliang420/AerialMind

单位:中国石油大学

引言

无人机航拍视角广、机动性强,不管是城市监控、应急救援还是环境勘察,都能派上大用场。但现在的智能追踪技术大多只适用于地面场景,想让无人机听懂人类的自然语言指令(比如"追踪路口红灯前的白色轿车"),精准锁定并跟踪目标,目前还缺乏成熟的解决方案。今天就来聊聊这个领域的突破性研究------AerialMind 基准数据集和 HawkEyeTrack 追踪算法。

一、问题背景:地面追踪技术"上天"就失灵?

咱们平时常见的目标追踪技术,比如监控里追踪嫌疑人、自动驾驶识别前车,都是在地面场景下工作的。但无人机的空中视角完全不一样,会遇到一堆地面没有的难题:

-

目标忽大忽小:无人机飞得高,目标就成了小点;飞低了又会突然变大,外观差异极大;

-

空间关系复杂:从天上看,车辆、行人的位置关系比地面视角混乱得多;

-

场景变化快:无人机自己在动,画面的角度、光线也跟着变,追踪难度翻倍;

-

指令不好懂:描述空中目标的语言更复杂,可能涉及"左边车道超速的黑色汽车"这种结合位置、动作、特征的表达。

更关键的是,之前没有专门针对无人机场景的大规模数据集,研究人员想开发相关技术都没合适的"练手素材",导致空中语言引导追踪一直是个空白。

二、方法创新:两大核心突破,解决空中追踪难题

为了填补这个空白,研究团队做了两件大事:一是建了个超实用的数据集,二是设计了个超强的追踪算法。

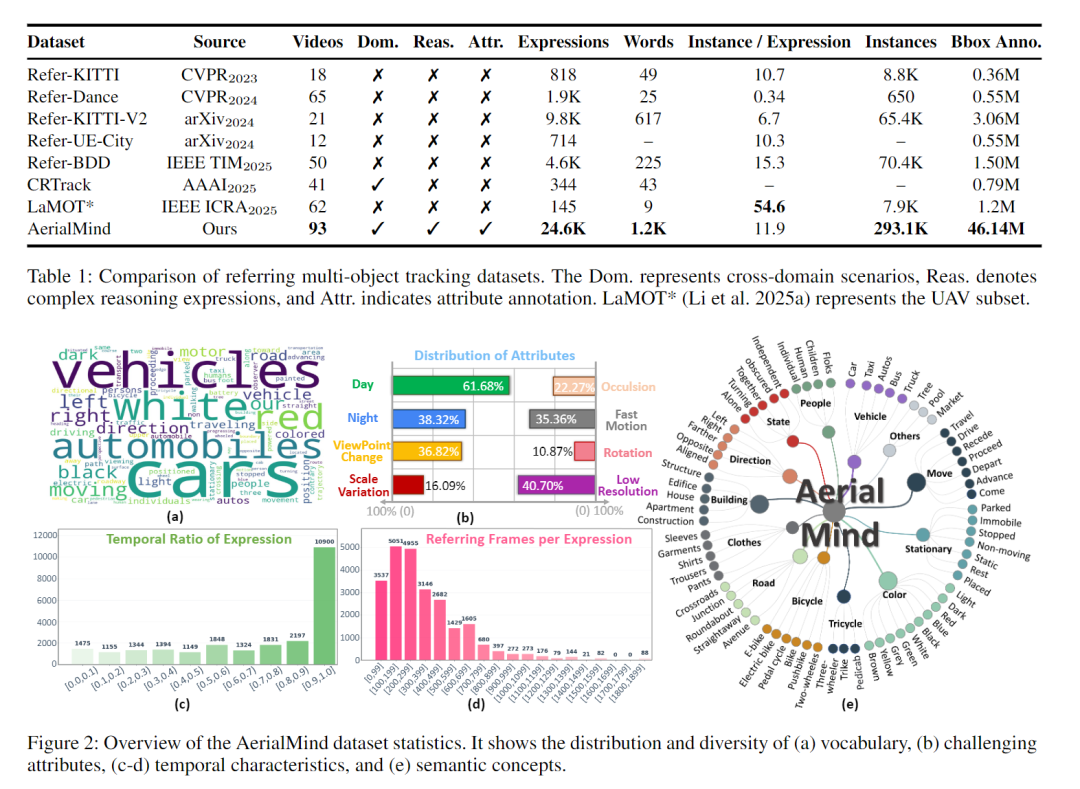

1. 首个空中专用数据集 AerialMind

这是全球第一个大规模无人机场景下的"语言引导多目标追踪"数据集,厉害之处在于:

-

规模超大:包含93段视频、24.6万条语言指令、4600多万个目标框标注,比之前的地面数据集丰富得多;

-

场景全覆盖:涵盖不同飞行高度、白天黑夜、城市道路、商业区等70多种场景;

-

标注超细致:不仅标了目标位置,还逐帧记录了"夜间、遮挡、快速移动"等8种挑战属性,方便测试算法的短板。

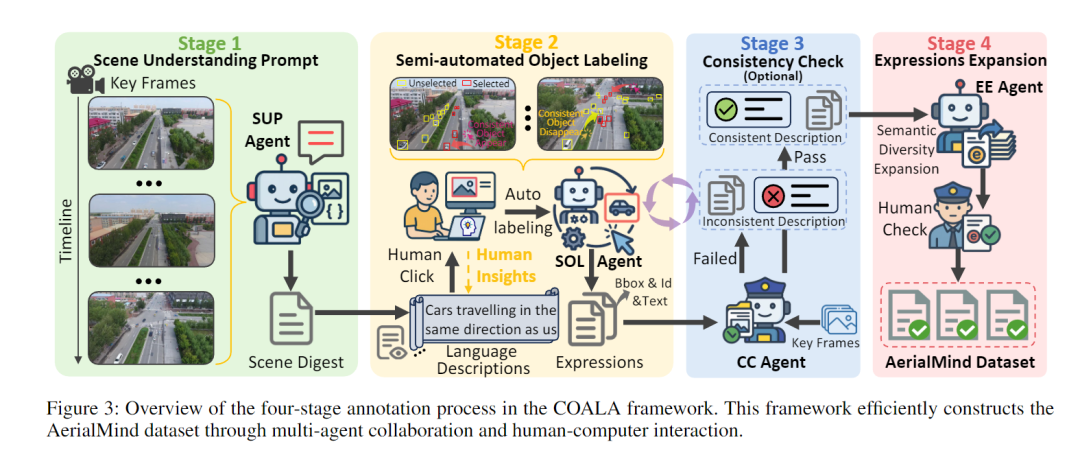

为了高效建好这个数据集,团队还发明了一个半自动化标注工具 COALA,不用人工逐帧标注:先让AI解析视频场景,生成描述模板,标注员只需点两下确定目标的出现和消失时间,AI就会自动跟踪目标轨迹,最后还能让AI生成更多样的语言指令,既省时间又保证质量。

为了高效建好这个数据集,团队还发明了一个半自动化标注工具 COALA,不用人工逐帧标注:先让AI解析视频场景,生成描述模板,标注员只需点两下确定目标的出现和消失时间,AI就会自动跟踪目标轨迹,最后还能让AI生成更多样的语言指令,既省时间又保证质量。

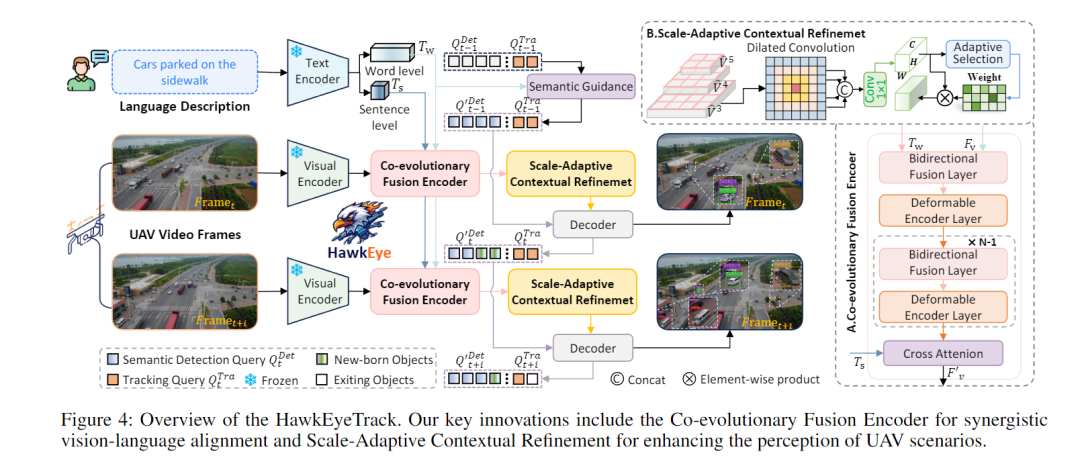

2. 超强追踪算法 HawkEyeTrack(鹰眼追踪)

这个算法专门针对无人机场景的痛点设计,有两个核心黑科技:

-

跨模态协同进化编码器:让视觉特征(看到的画面)和语言特征(听到的指令)互相促进、共同优化。不像以前的方法要么先处理画面再匹配语言,要么反过来,导致信息丢失,这个编码器能让两者"边融合边优化",精准匹配指令和目标;

-

尺度自适应上下文优化模块:解决无人机视角下目标大小多变的问题,通过多尺度特征提取,就算是远处的小目标,也能清晰识别,不会被背景干扰。

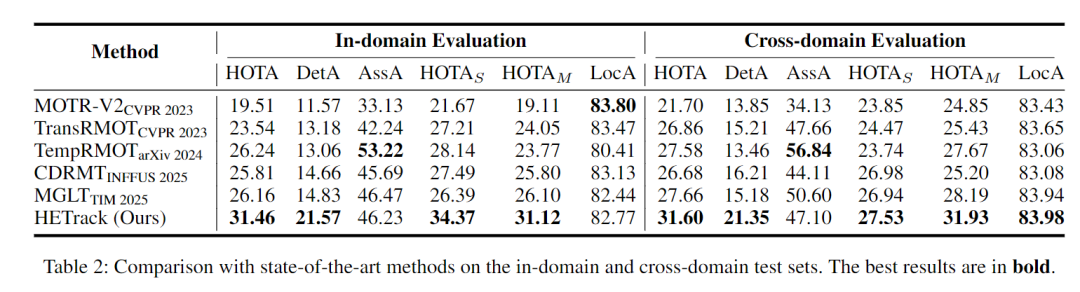

三、实验结果:性能碾压同类算法,还能"跨界"用

在AerialMind数据集上的测试显示,HawkEyeTrack 表现超亮眼:

-

核心指标 HOTA 达到31.46%,比目前最先进的地面追踪算法高出5-8个百分点;

-

应对复杂场景超稳:在"夜间""低分辨率""快速移动"这些难题上,表现比其他算法好30%以上;

-

跨场景通用:不仅在无人机场景厉害,放到地面数据集 Refer-KITTI-V2 上测试,也能排进前三,说明算法的通用性超强;

-

抗干扰能力强:就算是跨数据集测试(比如用AerialMind训练,去追踪其他无人机数据集的目标),性能也没下降,反而略有提升。

四、优势与局限:亮点突出,仍有提升空间

优势很明显:

-

填补空白:第一次给无人机语言引导追踪提供了标准化的数据集和基准算法,让后续研究有了方向;

-

实用性强:数据集和算法都贴合真实无人机应用场景,比如城市监控、交通管理,落地潜力大;

-

效率超高:COALA标注工具把标注成本大幅降低,未来还能实现全自动化标注。

局限也得正视:

-

数据集有继承缺陷:基于现有公开数据集扩展,部分原始数据存在少量标注误差;

-

没用到大模型推理:算法没结合最新大语言模型的超强推理能力,应对更复杂的指令(比如"追踪那个刚刚穿过人群的红色电动车")可能还不够;

-

计算成本较高:目前的算法在无人机这种资源有限的设备上,实时运行还有压力,需要进一步轻量化。

五、一句话总结

这是首个专门解决无人机"听懂人话追目标"的研究,既搭建了能用、好用的数据集平台,又提供了性能顶尖的算法方案,为无人机智能监控、自主导航等应用打开了新思路。