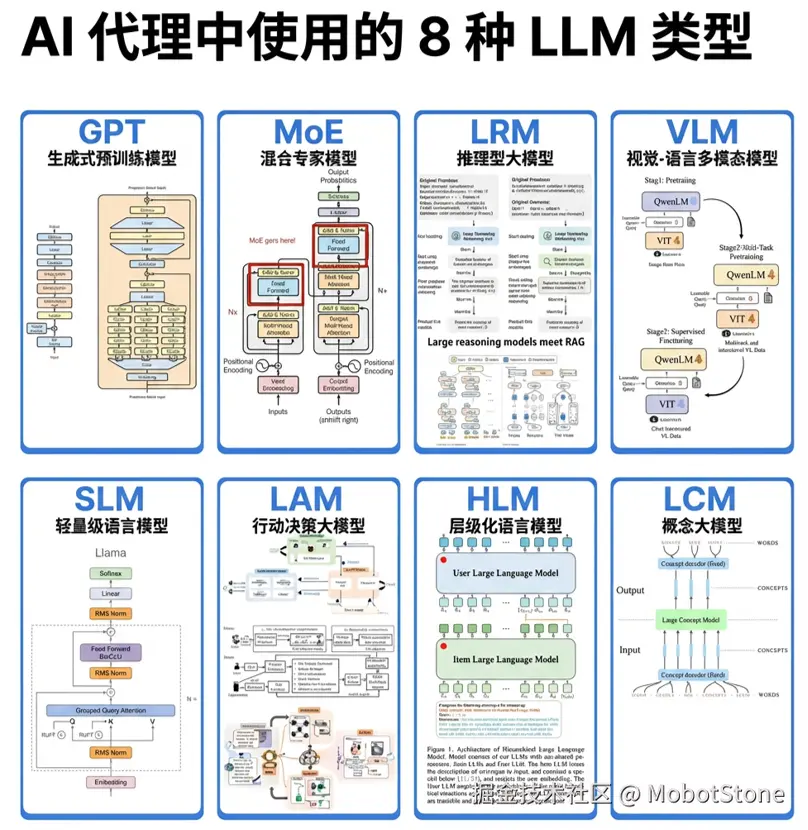

最近在玩生成式AI的朋友肯定都发现了:

不是所有的大语言模型都干同一件事。

有的擅长聊天,有的擅长思考,有的能动手操作,有的能看懂图片,甚至有些在你手机里默默运行而不会耗尽电池。

说白了,选对工具,问题就解决了一大半。

所以,如果你想搞AI智能体(Agent),那下面这几种模型你必须得懂。

1. GPT --- 什么都能干的"全能选手"

GPT就是那种"万金油"模型。写文章、做总结、翻译、讲东西、想点子、改Bug、陪聊天......它啥都行,而且说人话,不像教科书那么死板。

你可以把它想成团队里的"多面手": 虽然不是顶尖专家,但哪里需要就能顶上去,专门处理各种意外情况。

比如,你随便问它个问题:

scss

reply = gpt("用大白话给我娃解释下'过拟合'是啥。")

print(reply)对搞AI智能体的工程师来说,这为啥重要? 因为GPT就像"万能胶",负责把所有零件粘合在一起,统筹全局。

因为GPT是天然的"总调度"。它就像万能胶,把下面一堆各种工具粘在一起,还负责盯着大局,别让大家干跑偏了。

2. MoE(混合专家模型)--- 谁的活谁干,绝不瞎掺和

MoE(混合专家)模型的工作方式很像医院的分诊系统。

不同的病找不同的大夫。你不会因为骨折去找心内科医生吧?MoE就是这个思路。

当文本输入进来时,模型内部有个"导诊台"(路由器),它会判断这个问题该交给哪位"专家"来处理。

这样既聪明又省算力。

简单示意一下:

kotlin

def route(text):

if "math" in text:

return math_expert

elif "code" in text:

return code_expert

return general_expert为啥这个设计厉害? 因为它让模型"看起来很大、很强",但实际运行时不用把所有专家都叫上,省了一大笔算力开销。

3. LRM --- 会"动脑子"的推理模型

有些活儿光靠"会说话"不行,得靠一步一步动脑子。 LRM就是专门练出来"走流程思考"的模型------不是张口就来,而是掰开揉碎、慢慢推演。

适合交给它的任务有:

- 制定计划

- 解应用题(比如鸡兔同笼)

- 调用外部工具(比如查天气、算日期)

- 查资料 + 谨慎使用数据

- 分几步做决策(不能一步到位那种)

举个典型用法:

bash

result = lrm.solve("2月5日到3月1日之间有多少天?")

print(result["步骤"]) # 看它是怎么一步步算的

print(result["最终答案"]) # 最后得出结果用起来感觉很不一样------你不是在猜答案,而是在看AI"把脑子摊开给你看"。

一句话总结:GPT像文科生,LRM像理科生。一个会说,一个会算。

4. VLM --- 视觉语言模型:给AI装上"眼睛"

如果一个AI只能看文字,那它就像被关在隧道里,看不到外面的世界。

但只要让它拥有看截图、照片、图表和示意图的能力,整个世界就对它打开了大门!

这就是 VLM(视觉语言模型) 的作用。

举个例子:

ini

info = vlm("diagram.png")

print(info["summary"])AI一旦能"看见",就不再是个只会聊天的机器人了,而是变成一个真正的助手。

就像一个聪明的同事,你给他看张图,他能马上告诉你图里的重点,而不是让你费劲地描述半天。

一句话总结:VLM让AI从"聊天机器人"升级成"视觉助手"。

5. SLM --- 小型语言模型:安静运行在你设备里的"小帮手"

有人说SLM是"小模型",就以为它能力弱?大错特错!

SLM(小型语言模型)就像手机里的"隐形助手",它不显山不露水,但天天为你干活:

- 跑在你的iPhone和安卓手机上

- 嵌进微信、输入法、备忘录这些APP里

- 不用联网也能工作(断网也不怕)

- 你说完话,它"唰"一下就反应过来,快得离谱

它最适合啥场景?

- 需要立刻回应(别让用户等得发疯!)

- 隐私敏感(比如处理私密日记,不想上网传)

举个例子:

ini

note = slm("把这个变成提醒:今晚浇花。")

# 当下生成,本地处理,不传服务器,隐私安全,速度拉满!它不像GPT那样爱出风头,但它干的是"接地气"的活儿:

- 打字时帮你自动补全后半句

- 收到消息自动弹出"好的""马上到"这种快捷回复

- 在智能手表上听懂你小声嘀咕的指令

- 让老手机也能拥有"智能大脑"

未来最忙的AI,可能根本不在云端,而在你口袋里。

6. LAM ------ AI界的"行动派":不仅会思考,还会"动手"

如果说GPT是团队里的"点子王",那LAM就是那个把点子变成现实的"执行经理" 。

它不光会"说",更会"做":

- 操控手机:打开任意App,像你的手一样操作

- 指挥电脑:运行命令、操作文件、秒变极客

- 连接世界:调用API、浏览网页、抓取信息

- 控制硬件:让机器人动起来,或操作智能家居

- 端到端干活:从规划到执行,一条龙服务

它工作的流程很简单:

- 先规划(比如:"我要查明天去广州最便宜的机票")

- 再执行(自动打开飞机票网站、比对价格、给你报出结果)

ini

task = lam.plan("明天早上飞班加罗尔,找最便宜的票。")

lam.execute(task) # LAM会自动搞定全过程,你坐等结果!为什么LAM是游戏规则的改变者? 普通AI只能"讲故事 "、"写报告 ", 而 LAM 能" 动手改写现实!**

7. HLM --- 分层语言模型:一个模型搞不定,那就让多个模型"分工合作"

有些任务实在太大了,一个模型根本搞不定。

比如写一份完整的调研报告。你需要一个模型来规划报告结构,另一个模型去深挖数据和见解,第三个模型负责润色和撰写最终的文字。

HLM(分层语言模型) 就是用来解决这个问题的。它在内部将自己组织起来------就像在一个架构里同时拥有一个项目经理、一个研究员和一个撰稿人。

内部协作流程可能像这样:

ini

output = hlm("写一份竞品分析报告。")

# 内部运作:

# 规划师 → 研究员 → 撰稿人这样做有什么好处? 稳!准!狠! 这让AI智能体在处理超长、超复杂的任务时,不会写到一半就迷失方向、前言不搭后语了------因为它有层级,有"项目经理"在盯着呢!

8. LCM --- 大型概念模型:理解"言下之意",而非字面意思

咱们日常说话其实特别灵活:同一个意思,能换十几种说法。比如表达心情不好,有人说「难过」,有人说「低落」,有人说「emo了」,还有人说「今儿提不起劲儿」------字面全不一样,但本质是同一个感受。

LCM 要做的,就是帮 AI 把这些五花八门的表达,对应到最核心的概念上。它相当于在「字面含义」和「真实意图」之间搭了一座桥,让 AI 不抠字眼,而是真的懂你。

举个简单的例子:

arduino

concept = lcm("Python、C++、Java")

print(concept) # "编程语言"为啥这个能力对智能体很关键? 如果 AI 只认字词,换个说法它可能就懵;但当它懂概念 ,就能举一反三:比如你让它「整理电脑里的代码相关文件」,它不会只挑文件名带 .py .cpp 的,而是能意识到「Python、C++ 相关的内容,本质都是代码」,把该归拢的都归拢好。 对智能体来说,这种「抓本质、连关联」的能力,是它能真正「懂人」、不犯「抠字眼误解意图」这类低级错误的关键。

为什么现在必须搞懂这些模型分类?

早年的 AI 智能体,逻辑特别简单:一个模型、一句指令、一个回复------你问啥,它答啥,多走一步都不会,更别说自己规划复杂任务。

但现在早不是那个时代了。

成熟的现代智能体,本质是一套完整的协作系统:各个模型模块像人体的不同器官,各司其职又互相配合,凑在一起才是能真正解决问题的「智能体」:

- 靠 VLM 当「眼睛」,能看图片、图表、扫描件;

- 靠 LAM 当「手脚」,能实际操作软件、调用工具、执行任务;

- 靠 LRM 当「逻辑脑」,能一步步算题、做推理、验证结论;

- 靠 HLM 当「项目经理」,能拆分复杂任务、统筹多环节流程;

- 靠 LCM 当「认知中枢」,能透过字面懂本质、不抠字眼;

- 靠 MoE + SLM 当「高效代谢系统」,干活省资源、响应快;

- 最后靠 GPT 当「心脏」,把所有模块的工作串起来、兜底统筹。

换句话说:GPT 是智能体的核心,但光有核心不够------得有眼睛能看、手脚能做、脑子能想、神经能联动,才算一个完整的、能解决真实问题的智能体。

现在搞懂这8类模型,不是「闲知识」:对所有做AI工具、产品、原型的人来说,这已经是核心基本功------就像造汽车的工程师得懂发动机、变速箱、底盘各自的作用,你得知道不同模型该往什么位置放,才能搭出能用、好用的智能体。