程序名称:基于Bayes-PatchTST的综合能源负荷多变量时间序列预测

实现平台:python---Jupyter Notebook

**代码简介:**构建了基于贝叶斯优化的PatchTST能源负荷多变量时间序列预测模型。

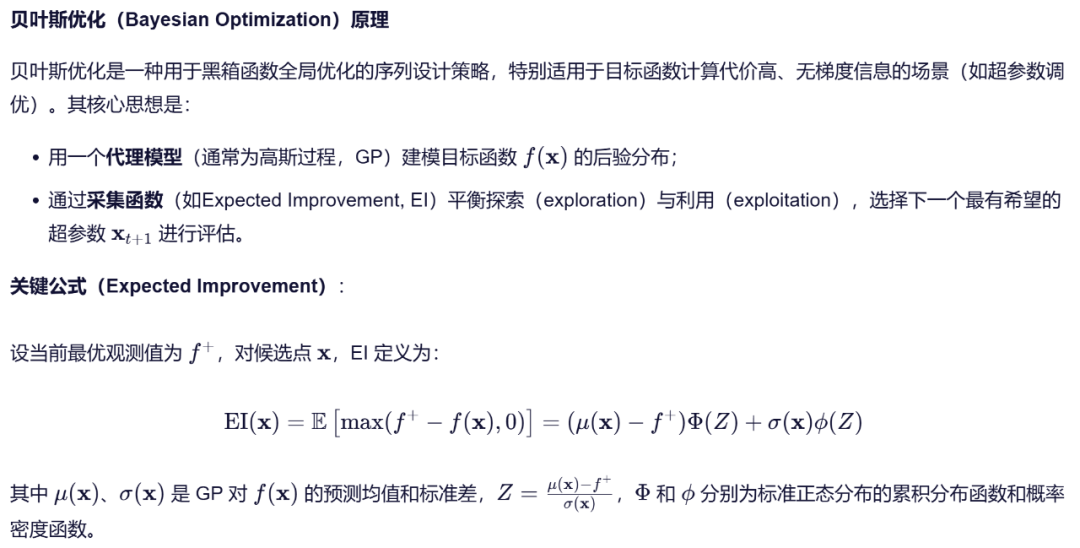

贝叶斯优化是一种高效的全局优化方法,特别适用于目标函数计算成本高、无法求导或评估耗时的场景,如机器学习模型的超参数调优。其核心思想是通过构建一个概率代理模型(如高斯过程)来近似真实的目标函数,并利用采集函数在"探索未知区域"和"利用已知优秀区域"之间取得平衡,从而以尽可能少的评估次数找到接近最优的参数组合。

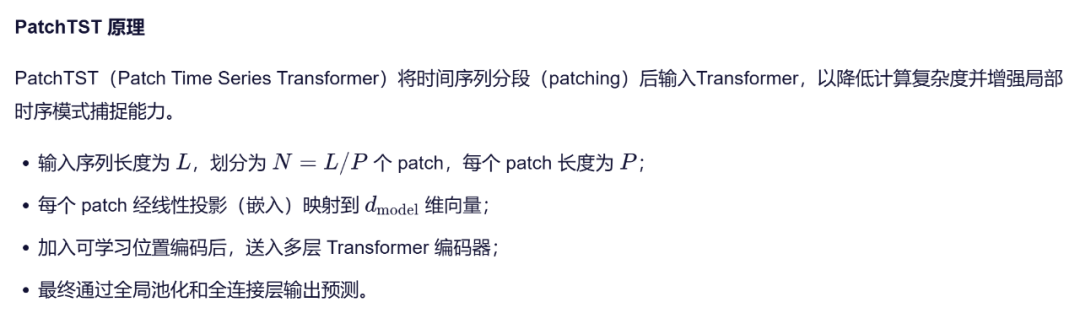

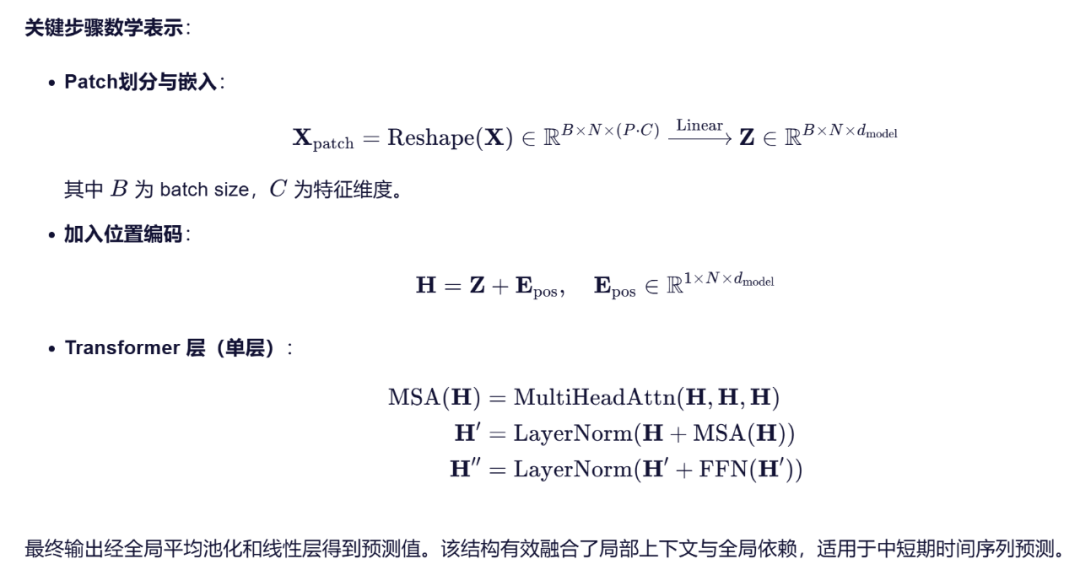

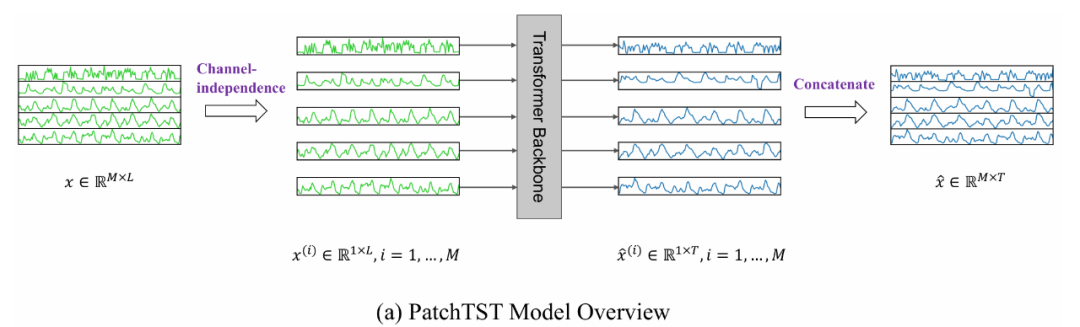

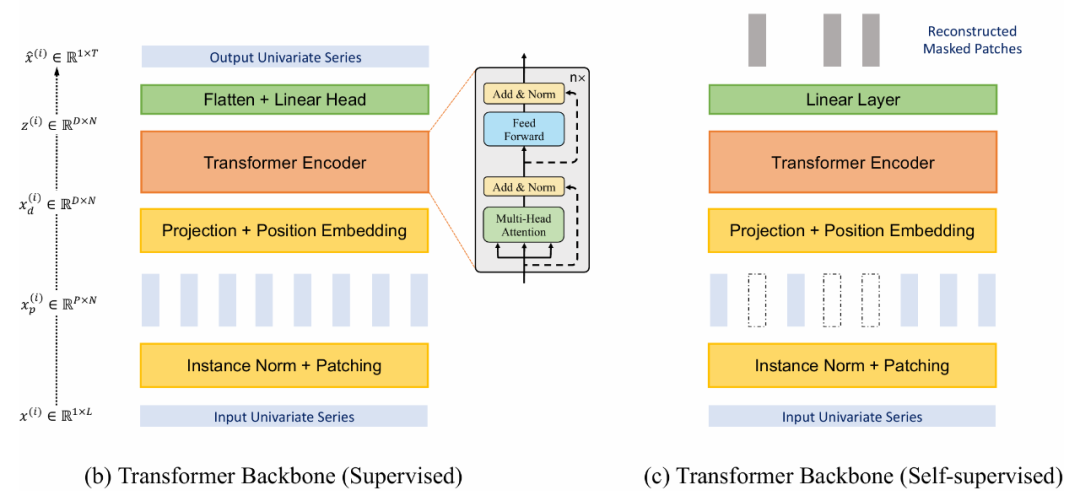

PatchTST(Patch Time Series Transformer)是一种专为时间序列预测任务设计的Transformer架构,其核心思想借鉴了计算机视觉中Vision Transformer(ViT)的"图像分块(patching)"策略,并将其适配到一维时间序列数据上。该方法由NeurIPS 2023的一篇论文《A Time Series is Worth 64 Words: Long-term Forecasting with Transformers》提出,旨在解决传统Transformer在长序列时间序列预测(Long-term Time Series Forecasting, LTSF)中存在的注意力机制效率低、对局部时序模式建模能力弱等问题。

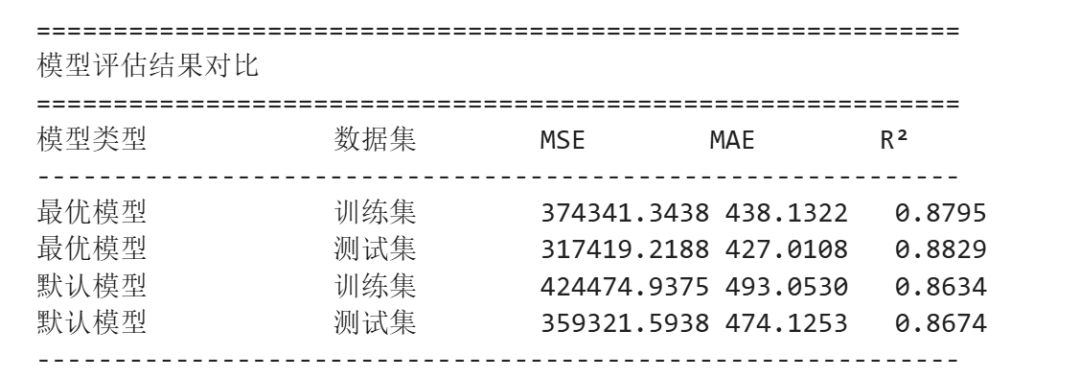

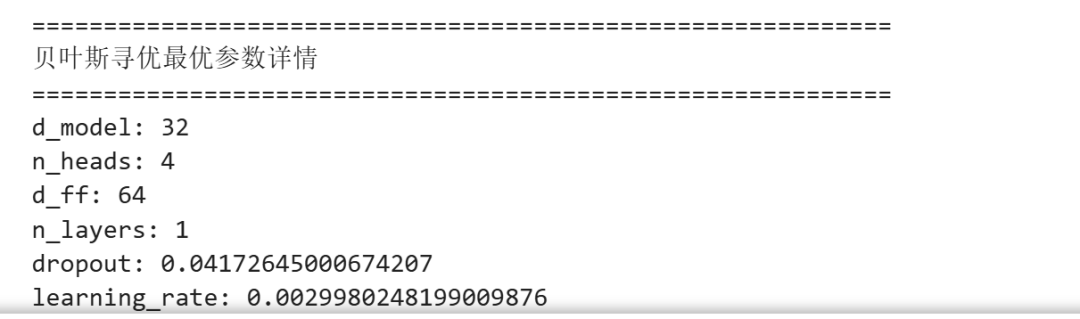

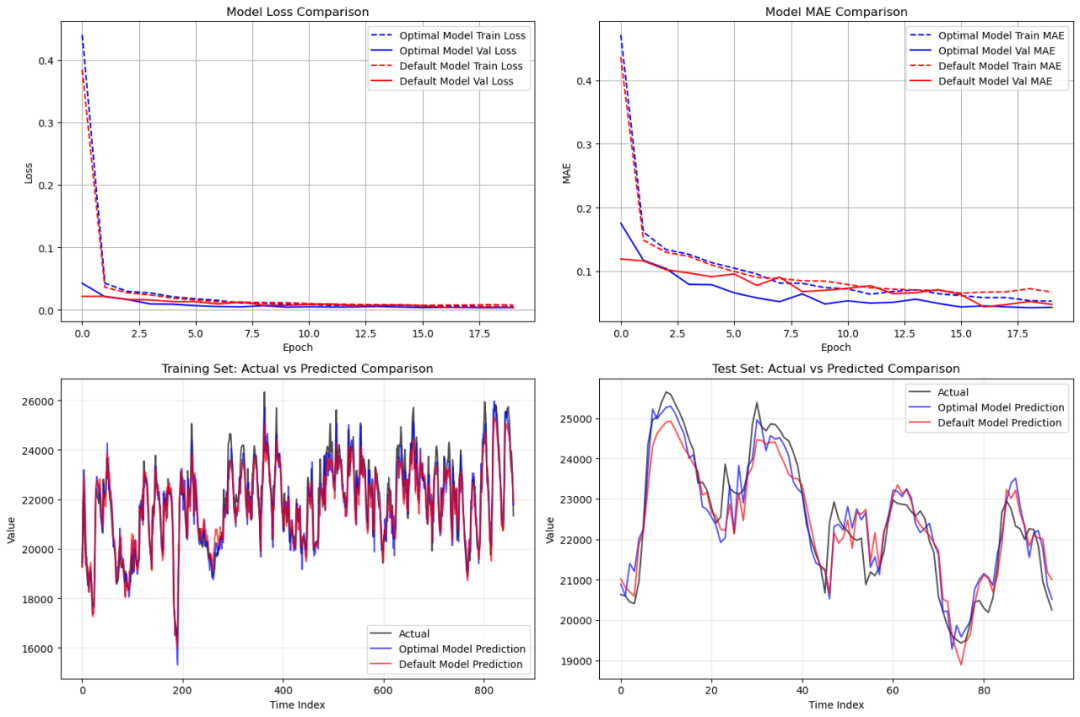

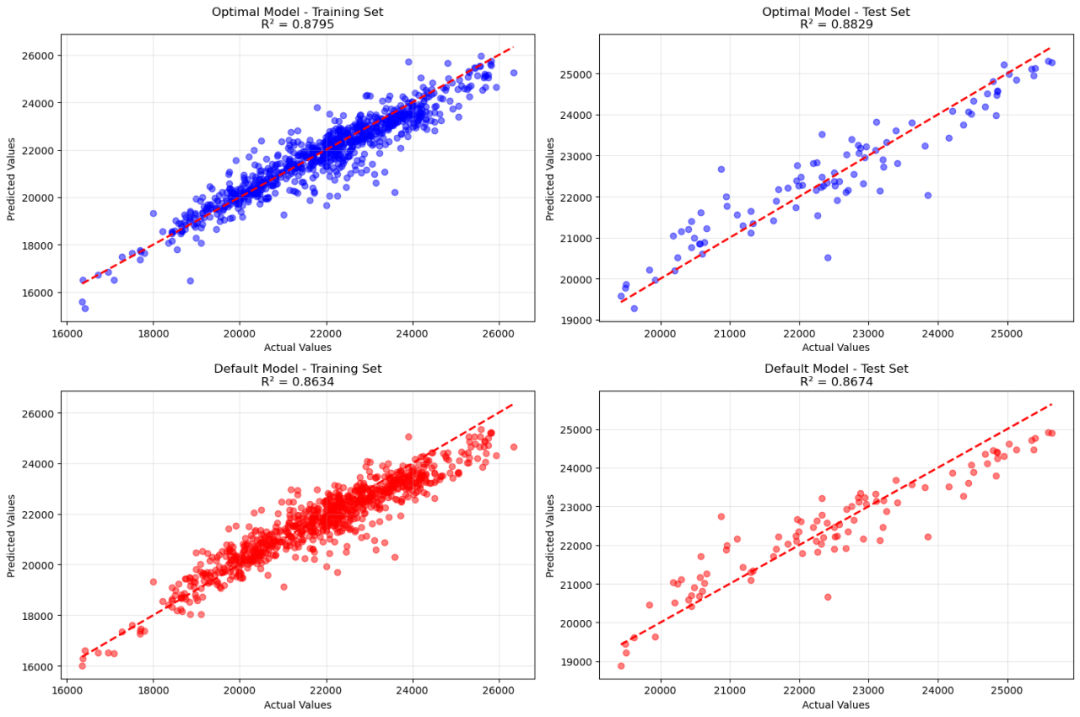

代码实现了一个基于PatchTST(Patch Time Series Transformer)架构的时间序列预测模型,并通过贝叶斯优化(Optuna)自动搜索最优超参数,以提升模型在综合能源负荷数据上的预测性能。整体流程可分为以下几个阶段:首先,在"复现控制"部分固定了Python、NumPy和TensorFlow的随机种子,确保实验结果可复现;接着,从Excel文件中读取能源负荷数据,利用滑动窗口方法构建输入-输出样本对;随后,对输入特征和目标变量分别进行Min-Max标准化处理,并按时间顺序划分训练集与测试集,避免打乱时序结构。在此基础上,定义了PatchTST模型类:该模型将输入序列划分为若干长度的patch,通过全连接层将每个patch映射到高维嵌入空间,并加入可学习的位置编码;随后堆叠多层Transformer模块(每层包含多头自注意力机制、前馈网络及LayerNorm归一化),最后通过全局平均池化和全连接层输出单步预测结果。为了优化模型性能,采用Optuna框架执行贝叶斯超参数搜索,在多次试验中自动调整d_model、n_heads、d_ff、n_layers、dropout和学习率等关键参数,并以验证集最小MSE作为优化目标。获得最优参数后,分别构建并训练最优参数模型与默认参数模型,两者均在相同数据上训练20个epoch。最后,通过对比两种模型的训练/验证损失曲线、MAE变化趋势、实际值与预测值的时间序列图以及散点图,全面评估其预测效果;同时计算MSE、MAE和R²三项指标,量化显示贝叶斯优化带来的性能提升(如MSE降低百分比等),从而验证了自动化超参数调优在时间序列预测任务中的有效性。

参考文献:《A Time Series Is Worth 64 Words: Long-Term Forecasting with Transformers》

代码获取方式: 【原创代码改进】基于贝叶斯优化的PatchTST综合能源负荷多变量时间序列预测