要配置Elasticsearch与Kibana,你需要确保两者都已正确安装并运行在同一网络中

安装 Kibana

下载

wget https://www.elastic.co/downloads/past-releases/kibana-7-6-2.tar.gz

解压到本地目录

例如: tar zvxf kibana-7.6.2-linux-x86_64.tar.gz

修改配置文件

进入 config 目录,修改 kibana.yml 文件: 修改 Kibana 服务端口(默认:5601): server.port: 25601 修改 Kibana 服务 IP(默认:localhost): server.host: "192.168.43.67" 修改 Elasticsearch 地址(默认:http://localhost:9200): elasticsearch.hosts: ["http://192.168.43.67:9200"]

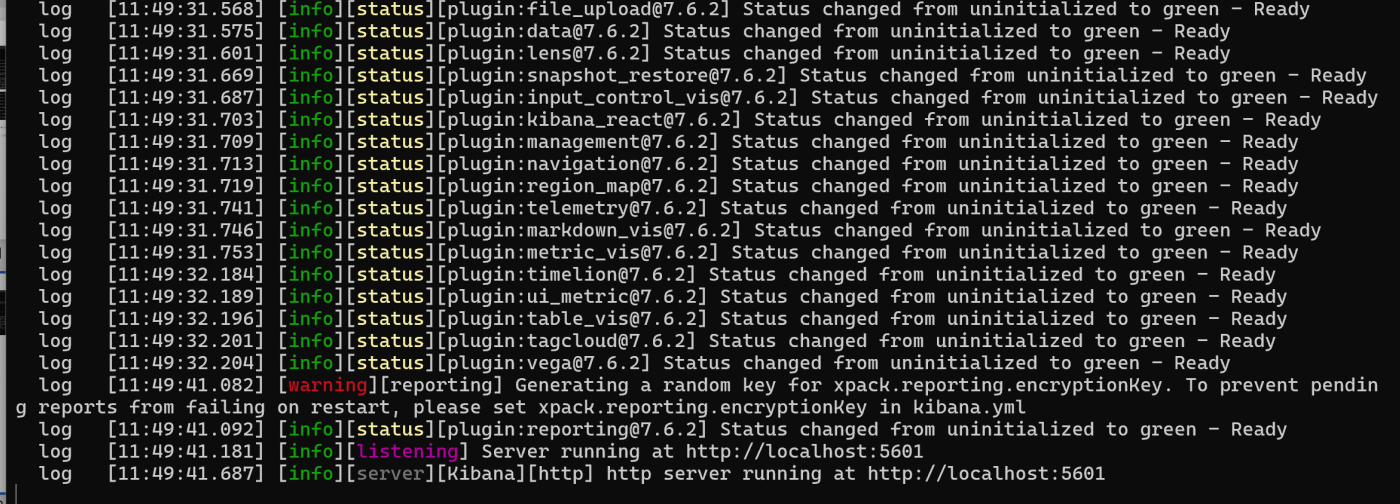

启动 Kibana

在 Linux 系统中,可以使用以下命令启动 Kibana: ./bin/kibana

到这里就安装完成了。

到这里就安装完成了。

在浏览器访问 http://localhost:5601

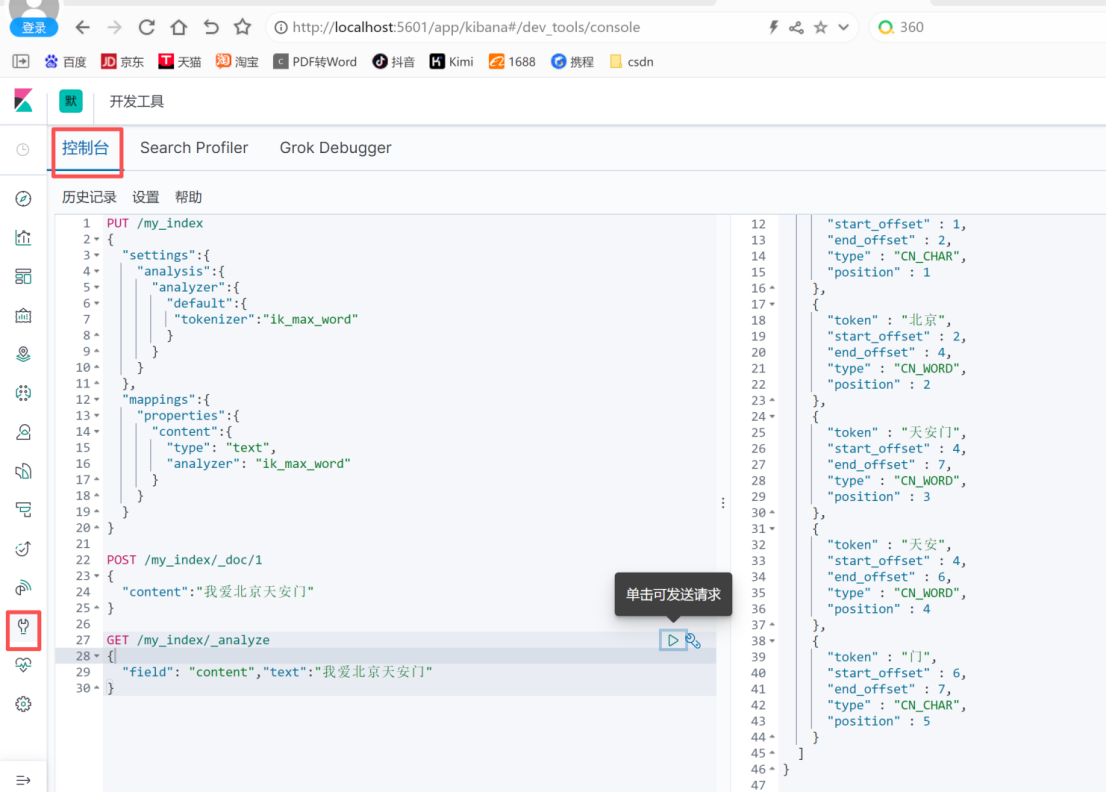

配置Elasticsearch

修改elasticsearch.yml

找到你的elasticsearch.yml配置文件,通常位于/etc/elasticsearch或<ES_HOME>/config目录下。

确保以下设置正确配置:

network.host: 0.0.0.0 # 允许任何IP地址访问

http.port: 9200 # Elasticsearch的HTTP端口

discovery.type: single-node # 单节点模式

如果你是多节点集群,使用discovery.seed_hosts和cluster.initial_master_nodes来配置集群。

配置Kibana

修改kibana.yml

找到你的kibana.yml配置文件,通常位于/etc/kibana或<KIBANA_HOME>/config目录下。

设置Kibana连接到Elasticsearch的地址和端口:

server.host: "0.0.0.0" # 允许任何IP地址访问

server.port: 5601 # Kibana的HTTP端口

elasticsearch.hosts: ["http://localhost:9200"] # Elasticsearch的地址和端口

重启服务

重新启动elasticsearch和kibana的服务

验证链接是否成功

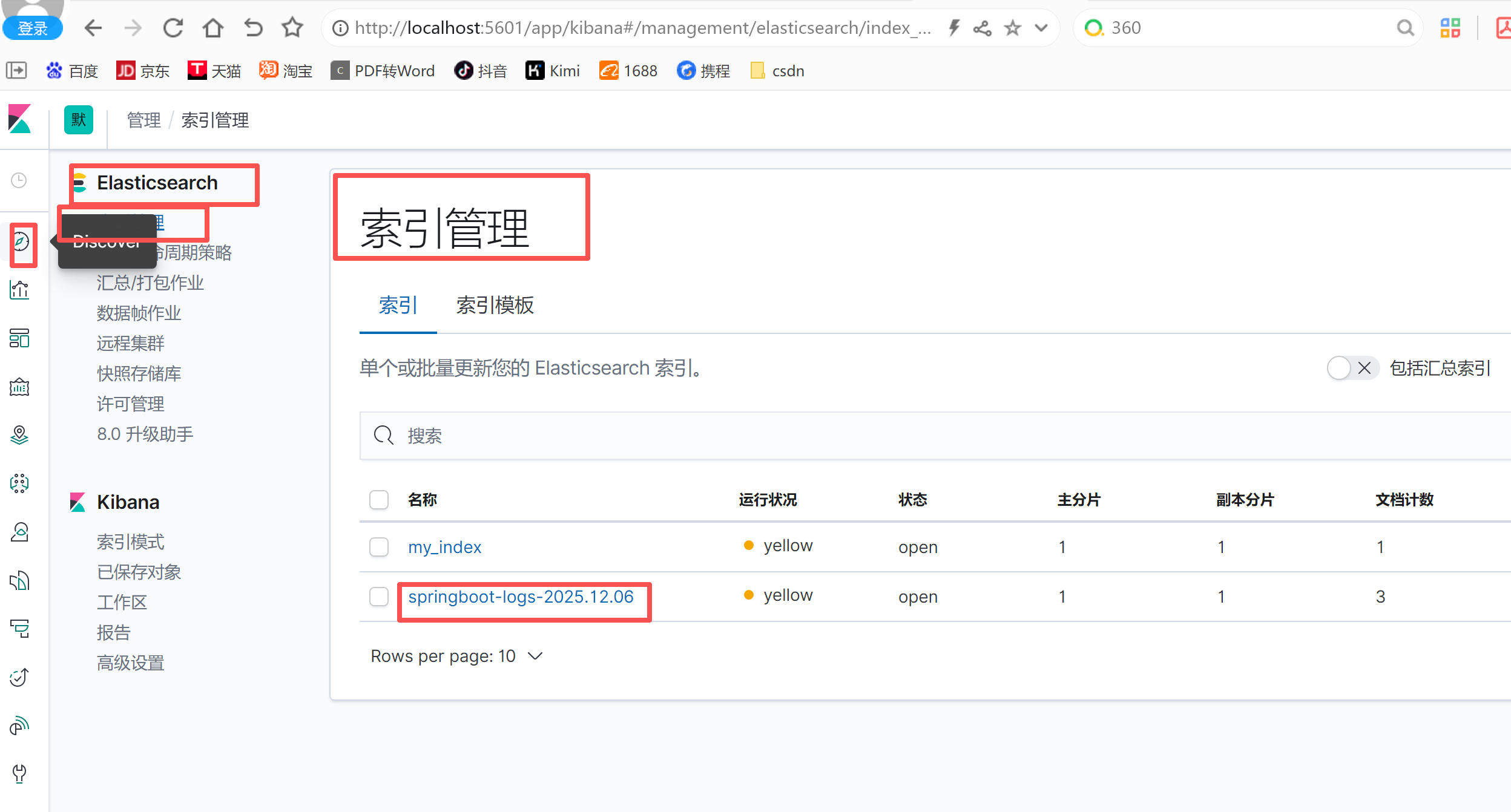

打开浏览器,访问 http://localhost:5601(或你的服务器IP和端口)。

到这elasticsearch和kibana集成完成

要配置Elasticsearch与Logstash,你需要确保两者都已正确安装并正常运行

安装Logstash

注意jdk版本兼容

下载

wget https://artifacts.elastic.co/downloads/logstash/logstash-7.6.2.tar.gz

解压即安装

tar -zxvf logstash-7.6.2.tar.gz

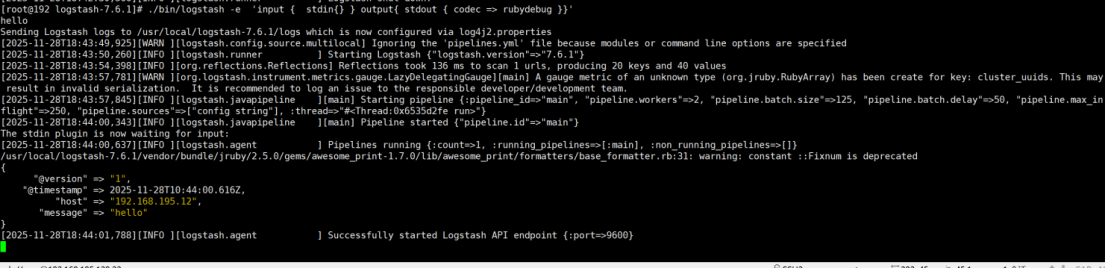

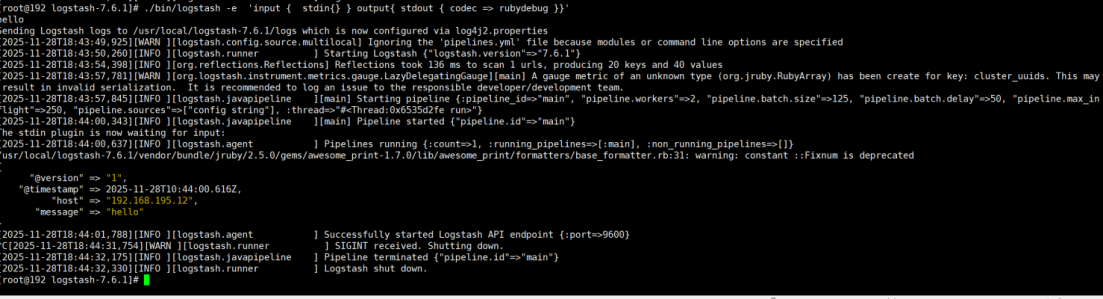

启动,并测试标准输入和标准输出

进入解压后的logstash的bin目录,执行启动命令:./bin/logstash -e 'input { stdin{} } output{ stdout { codec => rubydebug }}'

启动成功后,随便输入,比如hello,看输出结果

Ctrl+C退出

这就安装完成了。

配置文件

Logstash配置文件(通常是logstash.conf或logstash.yml)

在Logstash的conf或者bin目录下生成logstash.conf文件

如果你在使用filebeat或beats输入时,确保在配置文件中指定了正确的端口,例如:

input {

beats {

port => 5044

}

}

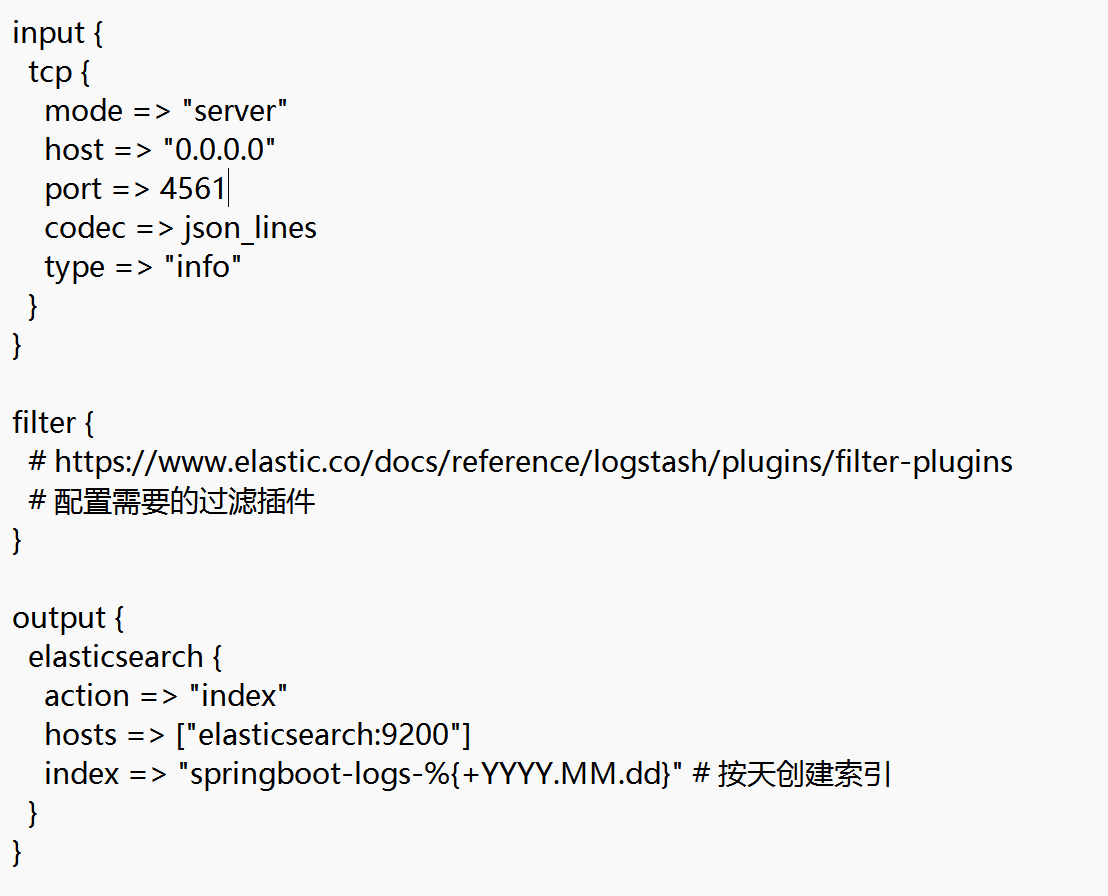

Logstash集成elasticsearch配置文件

创建了索引模式

Logstash的启动命令

确保在启动Logstash时使用了正确的命令行参数。例如,如果你使用了自定义的配置文件,确保在启动命令中指定了该文件:

bin/logstash -f /path/to/your/logstash.conf

如

bin/logstash -f /usr/local/logstash-7.6.2/config/logstash.conf

查看Logstash日志

查看Logstash的日志文件通常可以提供启动失败或端口未被监听的具体原因。默认情况下,日志文件位于logs/目录下,例如logstash-plain.log。

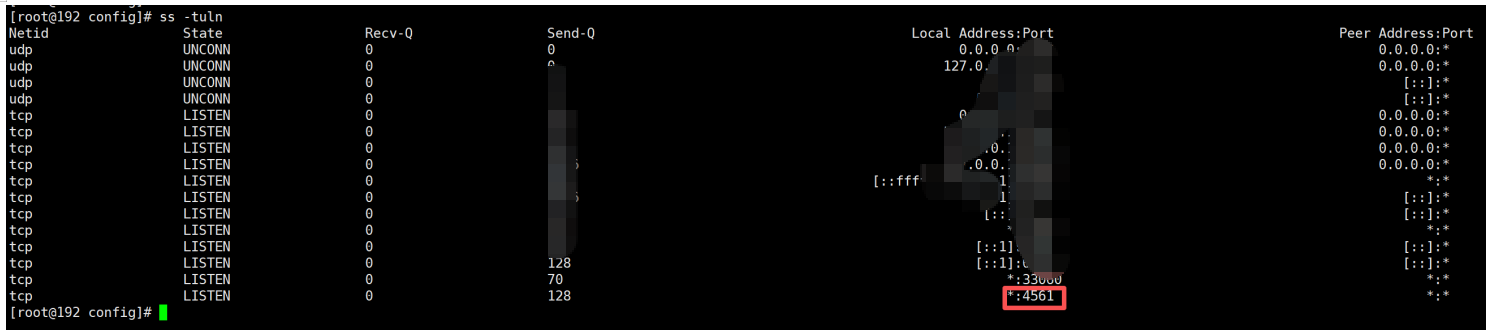

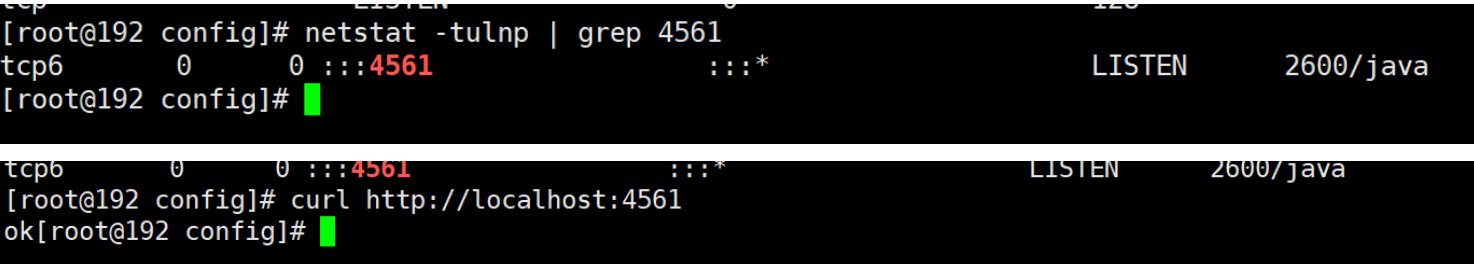

查看端口命令

ss -tuln

或者

netstat -tulnp | grep 4561

在Kibana中检查数据是否正确显示

-

打开Kibana的界面,通常在浏览器中访问:

http://<你的Kibana服务器地址>:5601 -

在Kibana中,选择"Management"(管理)> "Kibana"> "Index Patterns"(索引模式)。。

-

创建一个新的索引模式,输入你的索引名,然后点击"Create index pattern"(创建索引模式)。确保这里的索引名与你在Logstash配置中指定的索引名相匹配。

-

一旦创建了索引模式,你可以在"Discover"(发现)标签页中查看数据。如果一切正常,你应该能看到从Logstash流入的数据