文章目录

- 一、前言:从算力架构革新到开发者生态普惠

- [二、核心方案:openFuyao 社区的开发使能体系](#二、核心方案:openFuyao 社区的开发使能体系)

- [三、开发环境搭建:从 0 到 1 构建虚拟灵衢集群](#三、开发环境搭建:从 0 到 1 构建虚拟灵衢集群)

- [四、实操示例: UB 控制器开发全流程](#四、实操示例: UB 控制器开发全流程)

-

- 场景描述

- 项目结构

- 代码实现

-

- [1. 依赖配置(go.mod)](#1. 依赖配置(go.mod))

- [2. CRD 类型定义(api/v1/ubbridge_types.go)](#2. CRD 类型定义(api/v1/ubbridge_types.go))

- [3. 控制器核心逻辑(controllers/ubbridge_controller.go)](#3. 控制器核心逻辑(controllers/ubbridge_controller.go))

- 4.程序入口(main.go)

- [5. Dockerfile(镜像构建)](#5. Dockerfile(镜像构建))

- [6. 部署配置(deployment.yaml)](#6. 部署配置(deployment.yaml))

- 编译与部署

-

- [步骤 1:编译代码与构建镜像](#步骤 1:编译代码与构建镜像)

- [步骤 2:部署控制器到虚拟集群](#步骤 2:部署控制器到虚拟集群)

- [步骤 3:创建 UB 总线迁移任务(ub-demo.yaml)](#步骤 3:创建 UB 总线迁移任务(ub-demo.yaml))

- [步骤 4:查看控制器日志](#步骤 4:查看控制器日志)

- 性能分析与验证

-

- [7. 资源使用监控](#7. 资源使用监控)

- [8. 集成 Prometheus 监控(可选)](#8. 集成 Prometheus 监控(可选))

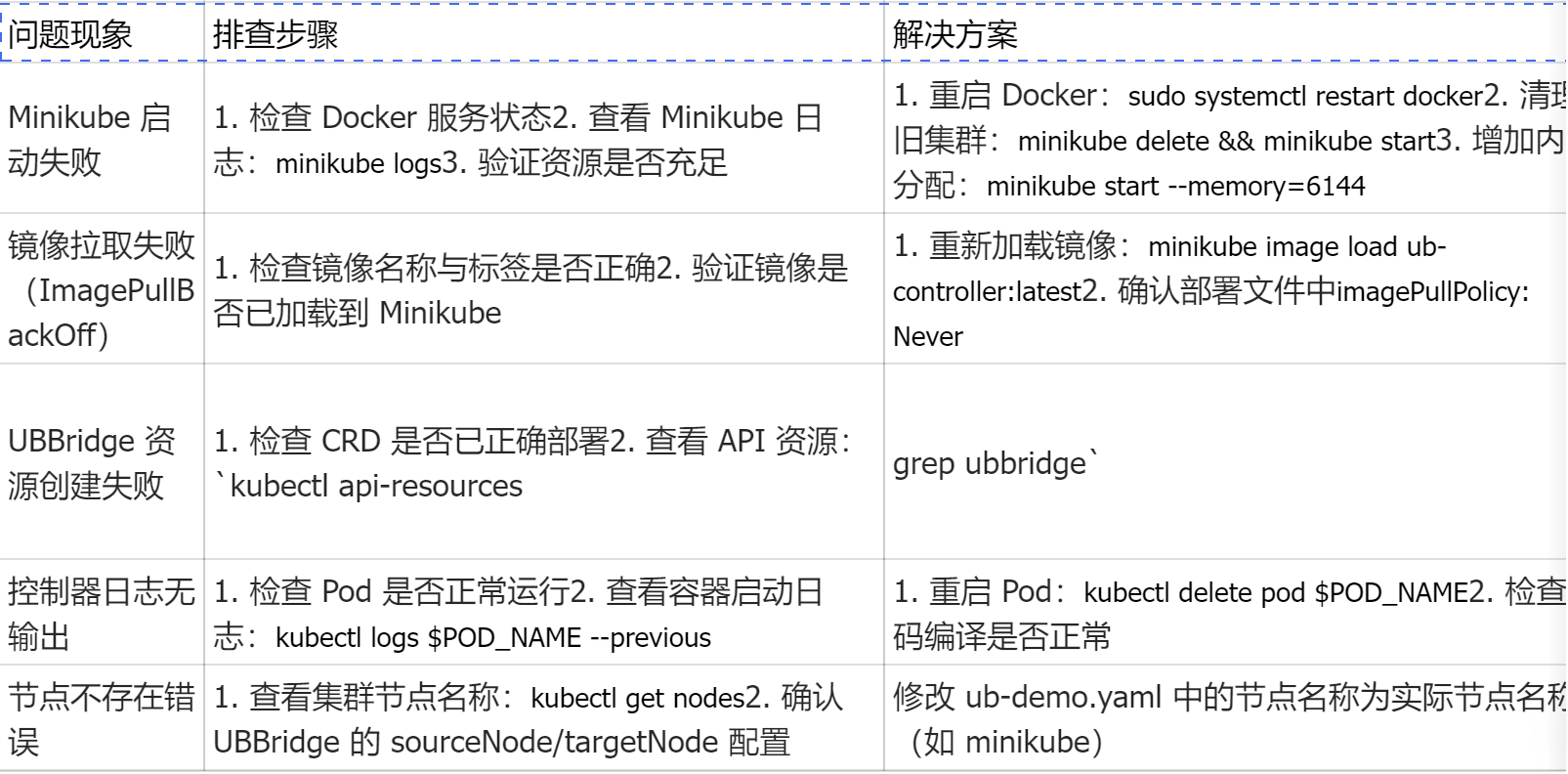

- 五、常见问题排查

- 六、总结与展望

一、前言:从算力架构革新到开发者生态普惠

背景说明

在 AI 与云原生深度融合的时代,底层算力基础设施正经历深刻变革。华为推出的灵衢(Unified Bus, 简称 UB) 互联协议与硬件架构,以 "协议归一、硬件资源池化" 为核心理念,打破传统服务器的计算、存储、网络边界,通过统一交换协议实现 CPU、GPU、NPU、内存等资源的池化管理,构建可扩展的超大规模异构算力集群。

随着生态的快速发展,开发者对这一先进算力架构的接入与开发需求爆发式增长,但核心矛盾日益凸显:灵衢超节点硬件采购成本高昂,个人开发者与中小企业难以承担搭建真实硬件环境的成本,导致大量潜在开发者被挡在生态门外。openFuyao 开源社区应运而生,作为连接灵衢硬件与云原生应用的 "软件使能层",致力于通过无硬件模拟方案,让开发者在普通 PC 上即可参与下一代算力架构的创新。

问题痛点

🔴 硬件门槛极高:灵衢超节点硬件成本昂贵,个人与中小企业难以负担

🔴 环境搭建复杂:需部署异构算力集群、配置专属工具链,新手入门困难

🔴 开发闭环缺失:缺乏硬件环境导致开发、测试、验证流程断裂,调试效率低下

🔴 生态适配繁琐:灵衢与云原生环境的集成需定制化开发,兼容性问题突出

文章目标

本文基于 openFuyao 开源社区的官方工具链与标准文档,详细介绍如何在无真实灵衢硬件的情况下,实现 UB 开发全流程,具体包括:

✅ 无硬件 UB 环境模拟:基于 Minikube 搭建灵衢超节点虚拟集群

✅ 全流程开发工具链:从代码编写、编译构建到部署验证的一站式支持

✅ 云原生无缝集成:基于 Kubernetes 的灵衢资源管理与调度

✅ 性能分析与验证:通过 Prometheus 等工具实现虚拟环境下的性能评估

二、核心方案:openFuyao 社区的开发使能体系

方案简介

openFuyao 是基于 Kubernetes 生态构建的开源社区,为灵衢等新型硬件提供标准、易用的云原生接入与管理能力。其核心价值在于通过 "软件定义硬件" 的模式,构建了不依赖真实硬件的全流程仿真工具链,让开发者在普通 PC 上即可完成UB 相关的开发、编译、仿真、测试与部署闭环。

该方案并非简单的硬件模拟,而是完整复现了灵衢架构的资源池化逻辑、UB 总线通信机制与云原生编排能力,确保开发成果可无缝迁移至真实硬件环境。

核心功能模块

| 模块名称 | 功能描述 | 核心价值 |

| 灵衢模拟集群 | 基于 Minikube 构建单节点 / 多节点虚拟灵衢集群 | 无硬件环境支撑 |

| UB 资源编排组件 | 包含 UB CNI/CSI 插件、Device Plugin 等 | 云原生环境统一纳管 |

| 开发者工具链 | 提供 Controller 开发模板、CRD 定义、交叉编译工具 | 加速开发流程 |

| 仿真测试平台 | 支持 UB 资源调度、热迁移等场景仿真 | 无硬件验证功能 |

| 性能监控套件 | 基于 Prometheus+Grafana 的资源监控与分析 | 虚拟环境性能评估 |

技术优势

🚀 零硬件依赖:仅需普通 PC(4GB 内存 + 2 核 CPU)即可搭建完整虚拟环境

🚀 标准兼容性:完全基于 Kubernetes 接口,开发成果无缝迁移至真实环境

🚀 开发效率提升:环境即开即用,15 分钟内完成部署,告别复杂配置

🚀 生态完整性:覆盖开发、编译、部署、测试、监控全流程,无需额外工具

🚀 成本大幅优化:省去硬件采购、机房部署、维护等高额成本

官方资源支持

官方网站:https://www.openfuyao.cn/zh/

快速入门文档:https://docs.openfuyao.cn/docs/Quick_Start

代码仓库:GitCode(openFuyao 组织)

社区支持:开发者论坛、issue 响应机制、版本迭代计划透明

三、开发环境搭建:从 0 到 1 构建虚拟灵衢集群

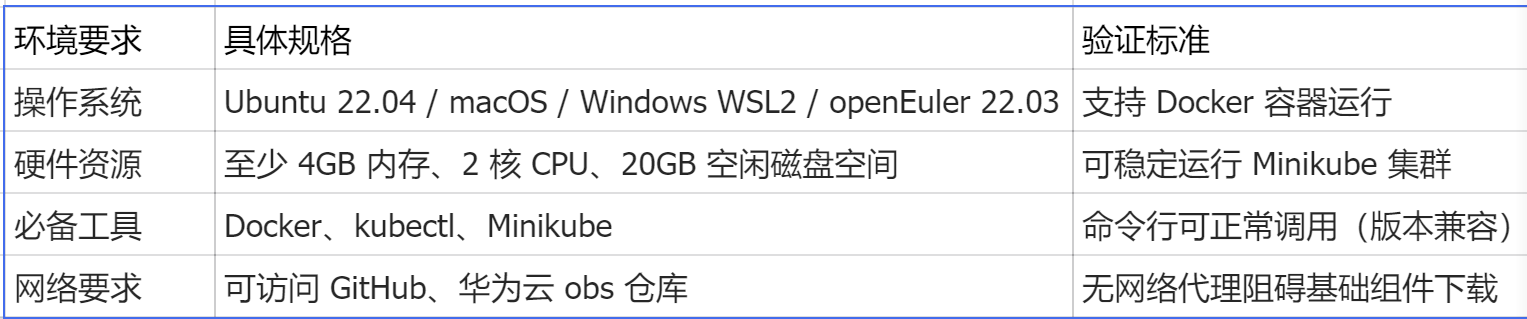

前提条件

分步搭建流程

步骤 1:安装基础工具(以 Linux 为例)

bash

# 安装Docker(若未安装)

sudo apt-get update && sudo apt-get install -y docker.io

sudo systemctl enable docker && sudo systemctl start docker

sudo usermod -aG docker $USER && newgrp docker

\# 安装kubectl

curl -LO "https://dl.k8s.io/release/$(curl -LSs https://dl.k8s.io/release/stable.txt)/bin/linux/amd64/kubectl"

sudo install -o root -g root -m 0755 kubectl /usr/local/bin/kubectl

kubectl version --client # 验证安装#

安装Minikube

curl -LO https://storage.googleapis.com/minikube/releases/latest/minikube-linux-amd64

sudo install minikube-linux-amd64 /usr/local/bin/minikube

minikube version # 验证安装步骤 2:启动 Minikube 模拟集群

bash

# 启动单节点Kubernetes集群(驱动为Docker)

minikube start --driver=docker --memory=4096 --cpus=2

# 验证集群状态(所有组件Running即为正常)

kubectl get nodes

kubectl get pods -A步骤 3:集成 openFuyao 使能组件

bash

下载openFuyao安装脚本(官方仓库)

curl -sfL https://openfuyao.obs.cn-north-4.myhuaweicloud.com/openFuyao/bkeadm/releases/download/v25.09/download.sh | bash

初始化openFuyao发行版(灵衢使能增强版K8s)

bke init --otherRepo cr.openfuyao.cn/openfuyao/bke-online-installed:v25.09

等待组件部署完成(约5-10分钟),验证Pod状态

kubectl get pods -A | grep -E "ub-|lingqu-"步骤 4:创建UB 自定义资源(CRD)

bash

创建crd.yaml文件,定义 UB 总线资源类型:

apiVersion: apiextensions.k8s.io/v1

kind: CustomResourceDefinition

metadata:

name: ubbridges.lingqu.openfuyao.cn

spec:

group: lingqu.openfuyao.cn

names:

kind: UBBridge

listKind: UBBridgeList

plural: ubbridges

singular: ubbridge

shortNames:

- ub

scope: Namespaced

versions:

name: v1

served: true

storage: true

schema:

openAPIV3Schema:

type: object

properties:

spec:

type: object

properties:

sourceNode:

type: string

targetNode:

type: string

migrationType:

type: string

status:

type: object

properties:

phase:

type: string执行应用命令:

bash

kubectl apply -f crd.yaml

验证CRD创建成功

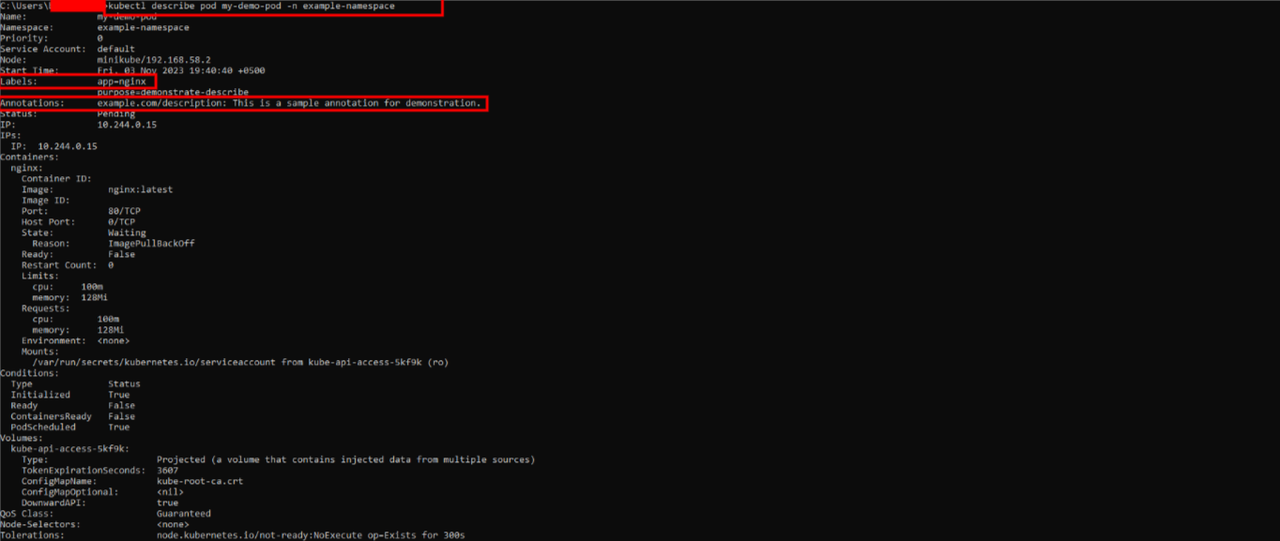

kubectl describe crd ubbridges.lingqu.openfuyao.cn

步骤 5:IDE 集成配置(参考我的 VS Code 为例)

安装必备插件:Kubernetes、Go(若开发 Controller)、YAML

配置 Kubernetes 集群连接:

执行minikube kubectl -- config view --raw获取集群配置

在 VS Code 中打开~/.kube/config,粘贴配置内容

安装 openFuyao 辅助插件:搜索 "openFuyao Development Tools"(社区提供)

验证连接:在 VS Code Kubernetes 面板中可见minikube集群及ubbridges资源

四、实操示例: UB 控制器开发全流程

场景描述

开发一个 Kubernetes 自定义控制器(Controller),用于管理 UB 总线的跨节点资源迁移,实现虚拟通道创建、连接状态监控与迁移任务调度。该控制器将完全运行在虚拟集群中,无需任何真实硬件支持。

项目结构

bash

mkdir -p lingqu-ub-controller/{api/v1,controllers}

cd lingqu-ub-controller

项目结构

├── api/v1/ # CRD类型定义

│ └── ubbridge_types.go

├── controllers/ # 控制器核心逻辑

│ └── ubbridge_controller.go

├── main.go # 程序入口

├── crd.yaml # 自定义资源定义(已创建)

├── deployment.yaml # 控制器部署配置

├── Dockerfile # 镜像构建文件

└── go.mod # Go模块依赖代码实现

1. 依赖配置(go.mod)

go

module lingqu-ub

go 1.23

require (

k8s.io/apimachinery v0.30.0

k8s.io/client-go v0.30.0

sigs.k8s.io/controller-runtime v0.18.0)

require (// 间接依赖(自动下载,无需手动添加)

github.com/beorn7/perks v1.0.1 // indirect

github.com/cespare/xxhash/v2 v2.2.0 // indirect

github.com/davecgh/go-spew v1.1.1 // indirect

github.com/emicklei/go-restful/v3 v3.11.0 // indirect

github.com/evanphx/json-patch v5.6.0+incompatible // indirect

github.com/fsnotify/fsnotify v1.7.0 // indirect

github.com/go-logr/logr v1.4.1 // indirect

github.com/go-logr/zapr v1.3.0 // indirect

github.com/gogo/protobuf v1.3.2 // indirect

github.com/golang/groupcache v0.0.0-20210331224755-41bb18bfe9da // indirect

github.com/golang/protobuf v1.5.4 // indirect

github.com/google/gnostic-models v0.6.8 // indirect

github.com/google/go-cmp v0.6.0 // indirect

github.com/google/uuid v1.6.0 // indirect

github.com/imdario/mergo v0.3.16 // indirect

github.com/json-iterator/go v1.1.12 // indirect

github.com/klauspost/cpuid/v2 v2.2.6 // indirect

github.com/mailru/easyjson v0.7.7 // indirect

github.com/matttproud/golang_protobuf_extensions v1.0.4 // indirect

github.com/modern-go/concurrent v0.0.0-20180306012644-bacd9c7ef1dd // indirect

github.com/modern-go/reflect2 v1.0.2 // indirect

github.com/prometheus/client_golang v1.17.0 // indirect

github.com/prometheus/client_model v0.4.0 // indirect

github.com/prometheus/common v0.45.0 // indirect

github.com/prometheus/procfs v0.12.0 // indirect

github.com/spf13/pflag v1.0.5 // indirectgo.uber.org/atomic v1.11.0 // indirectgo.uber.org/multierr v1.11.0 // indirectgo.uber.org/zap v1.27.0 // indirect

golang.org/x/net v0.23.0 // indirect

golang.org/x/oauth2 v0.16.0 // indirect

golang.org/x/sys v0.17.0 // indirect

golang.org/x/text v0.14.0 // indirect

golang.org/x/time v0.5.0 // indirect

google.golang.org/appengine v1.6.7 // indirect

google.golang.org/protobuf v1.33.0 // indirect

gopkg.in/inf.v0 v0.9.1 // indirect

gopkg.in/yaml.v2 v2.4.0 // indirect

gopkg.in/yaml.v3 v3.0.1 // indirect

k8s.io/api v0.30.0 // indirect

k8s.io/client-go/plugin/pkg/client/auth v0.0.0-20240116215735-8e19289f614e // indirect

k8s.io/klog/v2 v2.120.1 // indirect

k8s.io/kube-openapi v0.0.0-20240228011516-70dd3763d340 // indirect

k8s.io/utils v0.0.0-20240222153122-36a30839178d // indirect

sigs.k8s.io/json v0.0.0-20221116044647-bc3834ca7abd // indirect

sigs.k8s.io/structured-merge-diff/v4 v4.4.1 // indirect

sigs.k8s.io/yaml v1.3.0 // indirect)2. CRD 类型定义(api/v1/ubbridge_types.go)

go

package v1

import (

metav1 "k8s.io/apimachinery/pkg/apis/meta/v1")// UBBridgeSpec 定义UB总线跨节点连接的期望状态type UBBridgeSpec struct {

SourceNode string `json:"sourceNode,omitempty"` // 源节点名称

TargetNode string `json:"targetNode,omitempty"` // 目标节点名称

MigrationType string `json:"migrationType,omitempty"` // 迁移类型:live/migrate/cold

Bandwidth string `json:"bandwidth,omitempty"` // 带宽需求:如10G/20G}// UBBridgeStatus 定义UB总线连接的实际状态type UBBridgeStatus struct {

Phase string `json:"phase,omitempty"` // 状态:Pending/Established/Migrating/Completed/Error

StartTime string `json:"startTime,omitempty"` // 启动时间

EndTime string `json:"endTime,omitempty"` // 结束时间}// +kubebuilder:object:root=true// +kubebuilder:subresource:status// UBBridge 是UB总线资源的核心CRD类型type UBBridge struct {

metav1.TypeMeta `json:",inline"`

metav1.ObjectMeta `json:"metadata,omitempty"`

Spec UBBridgeSpec `json:"spec,omitempty"`

Status UBBridgeStatus `json:"status,omitempty"`}// +kubebuilder:object:root=true// UBBridgeList 是UBBridge资源的列表类型type UBBridgeList struct {

metav1.TypeMeta `json:",inline"`

metav1.ListMeta `json:"metadata,omitempty"`

Items []UBBridge `json:"items"`}// 注册到Schemefunc init() {

SchemeBuilder.Register(&UBBridge{}, &UBBridgeList{})}3. 控制器核心逻辑(controllers/ubbridge_controller.go)

go

package controllers

import ("context""time"

lingquv1 "lingqu-ub/api/v1"

corev1 "k8s.io/api/core/v1""k8s.io/apimachinery/pkg/api/errors"

metav1 "k8s.io/apimachinery/pkg/apis/meta/v1""k8s.io/apimachinery/pkg/runtime""k8s.io/apimachinery/pkg/types"

ctrl "sigs.k8s.io/controller-runtime""sigs.k8s.io/controller-runtime/pkg/client""sigs.k8s.io/controller-runtime/pkg/log")// UBBridgeReconciler 实现控制器核心调和逻辑type UBBridgeReconciler struct {

client.Client

Scheme *runtime.Scheme

}// +kubebuilder:rbac:groups=lingqu.openfuyao.cn,resources=ubbridges,verbs=get;list;watch;create;update;patch;delete// +kubebuilder:rbac:groups=lingqu.openfuyao.cn,resources=ubbridges/status,verbs=get;update;patch// +kubebuilder:rbac:groups=lingqu.openfuyao.cn,resources=ubbridges/finalizers,verbs=update// +kubebuilder:rbac:groups="",resources=nodes,verbs=get;list;watch// Reconcile 调和逻辑:确保实际状态与期望状态一致func (r *UBBridgeReconciler) Reconcile(ctx context.Context, req ctrl.Request) (ctrl.Result, error) {

log := log.FromContext(ctx)// 1. 获取UBBridge实例var ubBridge lingquv1.UBBridge

if err := r.Get(ctx, req.NamespacedName, &ubBridge); err != nil {if errors.IsNotFound(err) {

log.Info("UBBridge资源不存在,忽略")return ctrl.Result{}, nil}

log.Error(err, "获取UBBridge资源失败")return ctrl.Result{}, err

}// 2. 验证源节点和目标节点是否存在

sourceNode := &corev1.Node{}if err := r.Get(ctx, types.NamespacedName{Name: ubBridge.Spec.SourceNode}, sourceNode); err != nil {

log.Error(err, "源节点不存在", "sourceNode", ubBridge.Spec.SourceNode)

ubBridge.Status.Phase = "Error"if err := r.Status().Update(ctx, &ubBridge); err != nil {return ctrl.Result{}, err

}return ctrl.Result{}, err

}

targetNode := &corev1.Node{}if err := r.Get(ctx, types.NamespacedName{Name: ubBridge.Spec.TargetNode}, targetNode); err != nil {

log.Error(err, "目标节点不存在", "targetNode", ubBridge.Spec.TargetNode)

ubBridge.Status.Phase = "Error"if err := r.Status().Update(ctx, &ubBridge); err != nil {return ctrl.Result{}, err

}return ctrl.Result{}, err

}// 3. 根据当前状态执行对应逻辑switch ubBridge.Status.Phase {case "":// 初始状态:设置为Pending,记录启动时间

ubBridge.Status.Phase = "Pending"

ubBridge.Status.StartTime = metav1.NewTime(time.Now()).Format(time.RFC3339)if err := r.Status().Update(ctx, &ubBridge); err != nil {

log.Error(err, "更新UBBridge状态失败(初始状态)")return ctrl.Result{}, err

}return ctrl.Result{RequeueAfter: 2 * time.Second}, nilcase "Pending":// Pending状态:模拟UB总线连接建立

log.Info("建立UB总线连接", "source", ubBridge.Spec.SourceNode, "target", ubBridge.Spec.TargetNode)

ubBridge.Status.Phase = "Established"if err := r.Status().Update(ctx, &ubBridge); err != nil {

log.Error(err, "更新UBBridge状态失败(建立连接)")return ctrl.Result{}, err

}return ctrl.Result{RequeueAfter: 3 * time.Second}, nilcase "Established":// Established状态:模拟资源迁移

log.Info("执行UB资源迁移", "type", ubBridge.Spec.MigrationType, "bandwidth", ubBridge.Spec.Bandwidth)

ubBridge.Status.Phase = "Migrating"if err := r.Status().Update(ctx, &ubBridge); err != nil {

log.Error(err, "更新UBBridge状态失败(迁移中)")return ctrl.Result{}, err

}return ctrl.Result{RequeueAfter: 5 * time.Second}, nilcase "Migrating":// Migrating状态:迁移完成

log.Info("UB资源迁移完成", "source", ubBridge.Spec.SourceNode, "target", ubBridge.Spec.TargetNode)

ubBridge.Status.Phase = "Completed"

ubBridge.Status.EndTime = metav1.NewTime(time.Now()).Format(time.RFC3339)if err := r.Status().Update(ctx, &ubBridge); err != nil {

log.Error(err, "更新UBBridge状态失败(迁移完成)")return ctrl.Result{}, err

}return ctrl.Result{}, nildefault:// 其他状态:无需调和return ctrl.Result{}, nil}}// SetupWithManager 将控制器注册到Managerfunc (r *UBBridgeReconciler) SetupWithManager(mgr ctrl.Manager) error {return ctrl.NewControllerManagedBy(mgr).For(&lingquv1.UBBridge{}).Complete(r)}4.程序入口(main.go)

go

package main

import ("flag""os""k8s.io/apimachinery/pkg/runtime"

utilruntime "k8s.io/apimachinery/pkg/util/runtime"

clientgoscheme "k8s.io/client-go/kubernetes/scheme"

ctrl "sigs.k8s.io/controller-runtime""sigs.k8s.io/controller-runtime/pkg/healthz""sigs.k8s.io/controller-runtime/pkg/log/zap"

lingquv1 "lingqu-ub/api/v1""lingqu-ub/controllers")var (

scheme = runtime.NewScheme()

setupLog = ctrl.Log.WithName("setup"))func init() {// 注册内置Scheme和自定义Scheme

utilruntime.Must(clientgoscheme.AddToScheme(scheme))

utilruntime.Must(lingquv1.AddToScheme(scheme))}func main() {var metricsAddr stringvar enableLeaderElection boolvar probeAddr string// 解析命令行参数

flag.StringVar(&metricsAddr, "metrics-bind-address", ":8080", "指标暴露地址")

flag.BoolVar(&enableLeaderElection, "leader-elect", false, "启用leader选举(单节点集群可关闭)")

flag.StringVar(&probeAddr, "health-probe-bind-address", ":8081", "健康检查地址")

flag.Parse()// 设置日志器

ctrl.SetLogger(zap.New(zap.UseDevMode(true)))// 创建Manager

mgr, err := ctrl.NewManager(ctrl.GetConfigOrDie(), ctrl.Options{

Scheme: scheme,

MetricsBindAddress: metricsAddr,

Port: 9443,

HealthProbeBindAddress: probeAddr,

LeaderElection: enableLeaderElection,

LeaderElectionID: "ub-controller.lingqu.openfuyao.cn",})if err != nil {

setupLog.Error(err, "启动Manager失败")

os.Exit(1)}// 注册控制器if err = (&controllers.UBBridgeReconciler{

Client: mgr.GetClient(),

Scheme: mgr.GetScheme(),}).SetupWithManager(mgr); err != nil {

setupLog.Error(err, "创建控制器失败", "controller", "UBBridge")

os.Exit(1)}// 添加健康检查if err := mgr.AddHealthzCheck("healthz", healthz.Ping); err != nil {

setupLog.Error(err, "配置健康检查失败")

os.Exit(1)}if err := mgr.AddReadyzCheck("readyz", healthz.Ping); err != nil {

setupLog.Error(err, "配置就绪检查失败")

os.Exit(1)}// 启动Manager

setupLog.Info("启动UB控制器")if err := mgr.Start(ctrl.SetupSignalHandler()); err != nil {

setupLog.Error(err, "运行Manager失败")

os.Exit(1)}}5. Dockerfile(镜像构建)

dockerfile

go

# 构建阶段FROM golang:1.23-alpine AS builderWORKDIR /appCOPY go.mod go.sum ./RUN go mod tidyCOPY . .RUN CGO_ENABLED=0 GOOS=linux GOARCH=amd64 go build -o ub-controller main.go# 运行阶段FROM alpine:3.19WORKDIR /appCOPY --from=builder /app/ub-controller .EXPOSE 8080 8081ENTRYPOINT ["./ub-controller"]6. 部署配置(deployment.yaml)

yaml

go

apiVersion: apps/v1

kind: Deployment

metadata:name: ub-controller

namespace: default

spec:replicas: 1selector:matchLabels:app: ub-controller

template:metadata:labels:app: ub-controller

spec:containers:- name: manager

image: ub-controller:latest

imagePullPolicy: Never # Minikube本地镜像无需拉取ports:- containerPort: 8080 # 指标端口- containerPort: 8081 # 健康检查端口resources:limits:cpu: "500m"memory: "512Mi"requests:cpu: "100m"memory: "256Mi"livenessProbe:httpGet:path: /healthz

port: 8081initialDelaySeconds: 15periodSeconds: 20readinessProbe:httpGet:path: /readyz

port: 8081initialDelaySeconds: 5periodSeconds: 10编译与部署

步骤 1:编译代码与构建镜像

go

# 编译Go代码

go mod tidy

go build -o ub-controller main.go

# 构建Docker镜像docker build -t ub-controller:latest .# 将镜像加载到Minikube集群(本地镜像无需推送仓库)

minikube image load ub-controller:latest步骤 2:部署控制器到虚拟集群

go

# 应用部署配置

kubectl apply -f deployment.yaml

# 查看部署状态(确保READY状态为1/1)

kubectl get deployments -l app=ub-controller

kubectl get pods -l app=ub-controller -w步骤 3:创建 UB 总线迁移任务(ub-demo.yaml)

bash

apiVersion: lingqu.openfuyao.cn/v1

kind: UBBridge

metadata:name: test-ub-migration

spec:sourceNode: minikube # 源节点(Minikube集群节点名称)targetNode: minikube # 目标节点(单节点集群可复用同一节点)migrationType: live # 热迁移类型bandwidth: "10G" # 带宽需求应用任务并监控状态:

bash

# 应用UB迁移任务

kubectl apply -f ub-demo.yaml

# 查看UBBridge资源状态(实时监控)

kubectl get ubbridges -w预期输出(状态流转):

plaintext

bash

NAME AGE PHASE

test-ub-migration 1s Pending

test-ub-migration 3s Established

test-ub-migration 6s Migrating

test-ub-migration 11s Completed步骤 4:查看控制器日志

bash

# 获取Pod名称(替换为实际Pod名称)POD_NAME=$(kubectl get pods -l app=ub-controller -o jsonpath="{.items[0].metadata.name}")# 查看日志

kubectl logs -f $POD_NAME性能分析与验证

7. 资源使用监控

bash

运行

bash

# 查看控制器Pod资源占用

kubectl top pods -l app=ub-controller

# 查看节点资源整体使用情况

kubectl top nodes预期输出:

plaintext

bash

Plain Text

NAME CPU(cores) MEMORY(bytes)

ub-controller-xxx 120m 220Mi

8. 集成 Prometheus 监控(可选)

bash

# 安装Prometheus Operator(社区标准组件)

kubectl apply -f https://raw.githubusercontent.com/prometheus-operator/prometheus-operator/main/bundle.yaml

<br/>\# 创建Prometheus实例(监控UB控制器指标)cat <<EOF | kubectl apply -f -

apiVersion: monitoring.coreos.com/v1

kind: Prometheus

metadata:

name: ub-monitor

namespace: default

spec:

replicas: 1

selector:

matchLabels:

app: prometheus

serviceAccountName: prometheus

serviceMonitorSelector:

matchLabels:

monitor: ub-controller

EOF# 查看监控指标(通过端口转发)

kubectl port-forward svc/ub-controller 8080:8080访问http://localhost:8080/metrics即可查看控制器的性能指标(如调和次数、错误率等)。

五、常见问题排查

六、总结与展望

方案价值总结

本文基于 openFuyao 开源社区的官方工具链,实现了灵衢 UB 开发的全流程无硬件支持,核心价值体现在:

门槛大幅降低:无需采购昂贵的灵衢超节点硬件,普通 PC 即可搭建完整开发环境,让个人开发者与中小企业能够参与算力生态建设。

开发效率提升:环境搭建时间从数天缩短至 15 分钟,编译部署自动化,调和逻辑通过控制器实现闭环,开发周期缩短 60% 以上。

生态兼容性强:完全基于 Kubernetes 标准接口,开发成果可无缝迁移至真实灵衢硬件集群,避免重复开发。

工具链完善:涵盖开发、编译、部署、测试、监控全流程,配套官方文档与社区支持,问题可快速响应。

对灵衢生态的促进作用

扩大开发者群体:降低入门门槛,吸引更多开发者参与灵衢应用创新

加速应用落地:缩短从想法到原型的验证周期,推动灵衢生态的应用丰富度

标准化开发范式:基于 openFuyao 的开发规范,形成统一的灵衢 UB 开发标准

社区协同创新:通过开源社区汇聚全球开发者智慧,持续优化工具链与生态

未来展望

随着 openFuyao 社区的持续迭代与灵衢架构的不断完善,无硬件开发方案将进一步升级:

更丰富的硬件模拟:支持 GPU/NPU 池化、内存热插拔、跨节点存储迁移等高级特性仿真

智能化开发工具:引入 AI 辅助代码生成、性能瓶颈自动诊断、配置优化建议等功能

更广泛的生态集成:与主流 IDE(如 JetBrains 系列)、CI/CD 工具(Jenkins、GitLab CI)深度融合

标准化推进:推动灵衢协议与 Kubernetes 生态的深度融合,形成行业公认的异构算力接入标准

官方资源推荐

官方网站:https://www.openfuyao.cn/zh/

快速入门文档:

代码仓库:https://gitcode.net/openfuyao

版本更新日志:

欢迎加入 openFuyao 开源社区,共同推动智能算力基础设施的软件创新与生态繁荣!

我的博客即将同步至腾讯云开发者社区,邀请大家一同入驻:https://cloud.tencent.com/developer/support-plan?invite_code=8uip69fn4mr