在机器人操作、数字孪生等工业智能化场景中,精确的3D场景理解是核心技术基础。尤其在工厂环境中,零部件布局密集、尺度差异大、遮挡严重,传统分割方法往难以同时保证实例分割与部件级分割的精度。针对这一难题,《Hierarchical Image-Guided 3D Point Cloud Segmentation in Industrial Scenes via Multi-View Bayesian Fusion》提出了一种分层图像引导的3D点云分割框架,融合YOLO-World检测、SAM分割与多视角贝叶斯融合策略,在减少人工标注依赖的同时,显著提升了工业场景下的分割鲁棒性与准确性。

工业3D分割面临的核心挑战

工业场景的3D点云分割长期受以下问题制约:

-

严重遮挡与边界模糊

产线设备往往紧密排列,遮挡导致物体几何边界不完整,基于纯点云的方法易出现分割断裂或粘连。

-

多尺度物体并存

场景中同时存在机械臂、传送带等大物体与螺丝、接头等小部件,端到端模型难以兼顾粗粒度与细粒度特征。

-

标注成本高昂

点云逐点标注费时费力,且目前缺乏公开的工业部件级3D分割数据集。

-

2D-3D投影不一致

单纯依靠单视角2D分割投影到3D时,易因视角变化导致语义不一致与边缘错位。

相关工作

- 直接3D点云分割

传统方法使用分组方法,但依赖于几何邻近性和手工启发式规则,限制了对复杂场景的扩展性。近年来基于深度神经网络的分割方法广泛使用,直接从无序点云中学习特征以预测语义标签。然而,由于缺乏明确的拓扑和邻接结构,这些模型难以捕捉稳定的局部几何信息,因此需要密集的点级标注,且在大规模杂乱场景中表现不佳。此外,现有的标注3D数据集规模小,标注精细3D模型工作量大,目前尚无公开支持工业场景部件级分割的数据集。

- 基于2D监督的图像引导3D分割

为克服3D监督的限制,一些方法将3D点云投影到2D图像,并使用生成的掩码将2D语义转移到3D空间。SAM、YOLO-World、GLIP等视觉基础模型受益于大规模2D数据集和弱监督训练,能以低成本实现高质量分割。然而,SAM不提供类别标签,YOLO-World和GLIP仅提供类别预测而无像素级掩码,难以直接用于3D分割。将点云渲染为2D图像会引入遮挡和视角相关变化,常导致跨视角边界和语义不一致。缺乏鲁棒融合策略的现有方法无法确保一致的3D分割。此外,大多数基础模型训练于通用类别,不能直接适应工厂场景,现有2D图像数据集也缺乏工业环境覆盖。

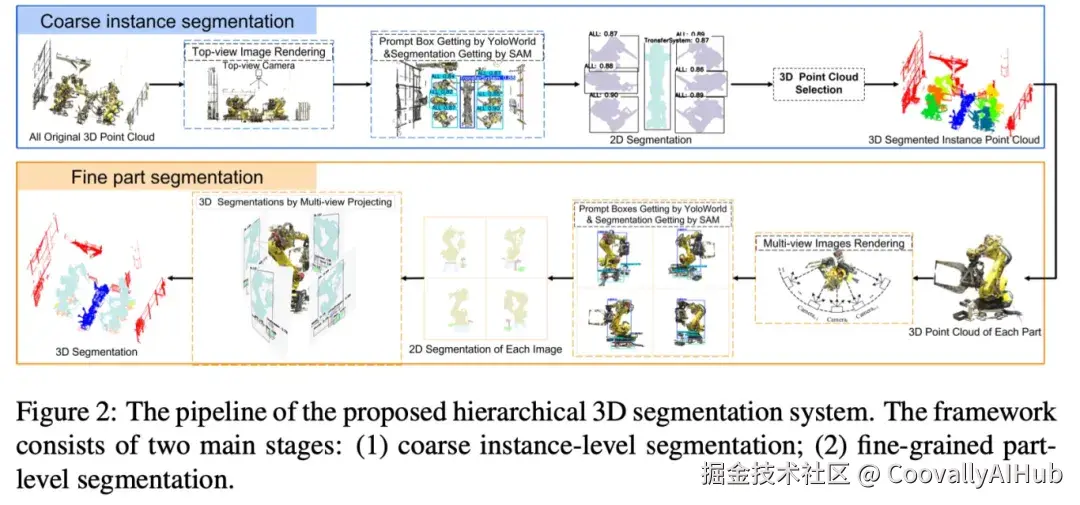

- 提出的制造场景3D点云分割方法

我们提出一种由2D预测引导的两阶段分层分割框架,逐步从粗实例到细粒度部件细化场景理解(图2)。框架始于自适应渲染,根据物体尺寸和点密度,使用尺度感知参数将3D点云投影为2D图像。在每个阶段,YOLO-World检测物体并提供提示给SAM生成2D掩码,再反投影到3D。实例级分割使用俯视图投影高效标记大物体,部件级分割通过贝叶斯更新融合多视角掩码,解决不一致性并在遮挡和视角变化下提高标签稳定性。

-

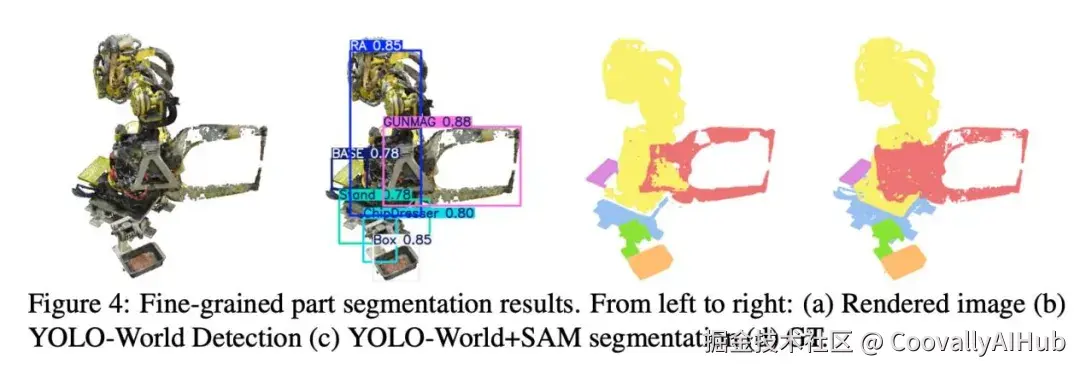

自适应2D图像渲染与分割

我们提出一种尺度自适应渲染策略,基于物体几何和密度计算点半径。渲染后的2D图像使用YOLO-World和SAM两阶段方法进行分割:YOLO-World检测物体实例或部件并生成类别感知边界框,作为SAM的提示以生成高质量像素级掩码。这种提示驱动设计使SAM能在杂乱、遮挡和尺度变化下生成准确分割。

-

通过2D掩码投影的3D点云分割

获取各阶段准确2D掩码后,我们将其几何和语义先验转移到3D空间。为适应两个阶段的不同目标,我们设计了不同的投影方法:

实例级分割(俯视图): 使用轻量高效的基于2D掩码投影的策略,快速对大规模密集点云进行粗实例分割。

部件级分割(多视角反投影): 围绕每个实例点云采样多个视角,在各视角上使用YOLO-World+SAM生成部件级2D掩码,并通过反投影和深度引导KD树匹配将其映射回3D点。

-

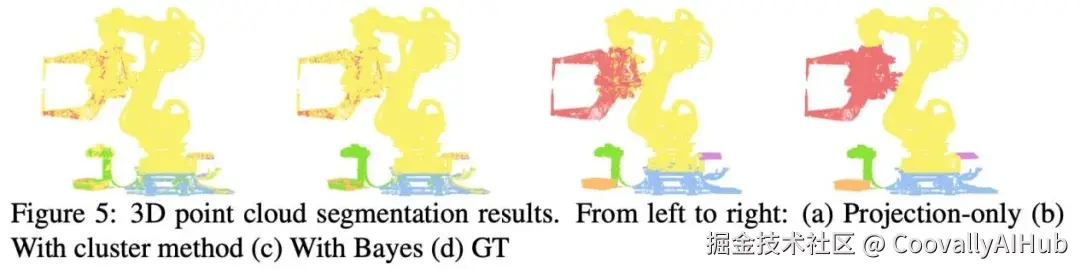

多视角掩码一致性与贝叶斯更新融合

为处理跨视角语义不一致,我们通过贝叶斯更新递归融合每个点的多视角观测,估计一致的类别分布。每个视角的观测被建模为软类别分布,并引入几何感知置信度评分以增强在遮挡和噪声下的鲁棒性。最终通过选择置信度高于阈值的类别标签,构建带标签的点集,并通过DBSCAN聚类去除异常值,进一步提升部件级分割准确性。

实验与评估

我们在真实工业场景和公开数据集上评估了系统性能。实验环境为Intel i9-13900HK CPU、NVIDIA RTX 4090 GPU、32GB RAM、Ubuntu 22.04。

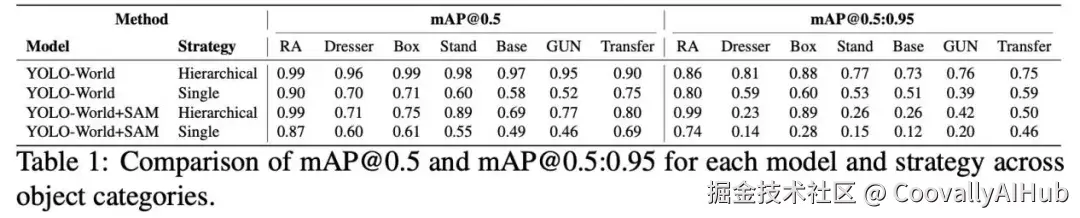

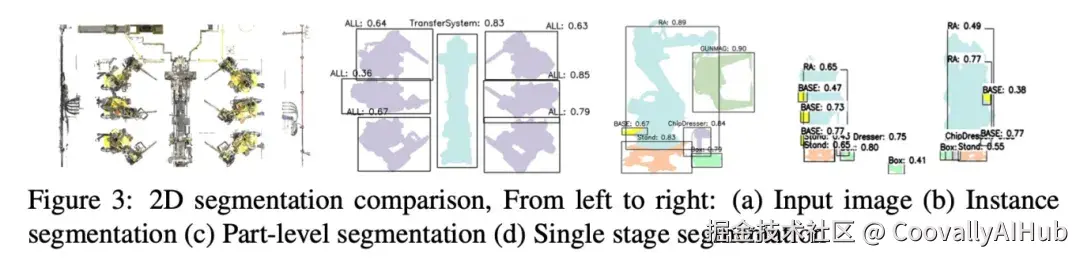

- 2D图像检测与分割评估

我们在200张图像上微调实例级YOLO-World模型(涵盖2类:传输系统和机械臂),在600张图像上训练部件级模型(涵盖6类)。实验表明,我们的分层方法在部件级掩码精度上优于直接单阶段方法,尤其在处理小结构和遮挡时表现更好。

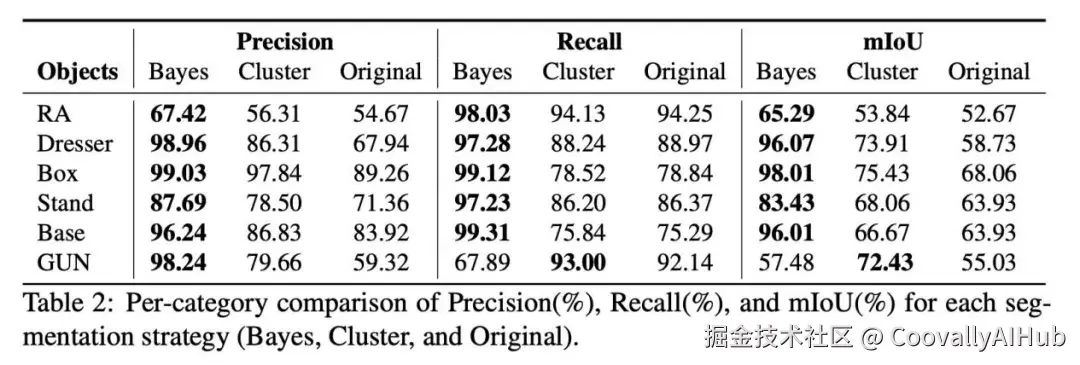

- 3D分割结果与评估

通过消融实验验证贝叶斯融合在多视角投影中处理特征不一致和遮挡的有效性。实验显示,直接投影会导致错误分割,而贝叶斯融合能显著提升边界清晰度和部件识别准确性(图5)。定量评估也显示贝叶斯融合在各类别上的mIoU均有提升(表2)。

- 全场景分割结果

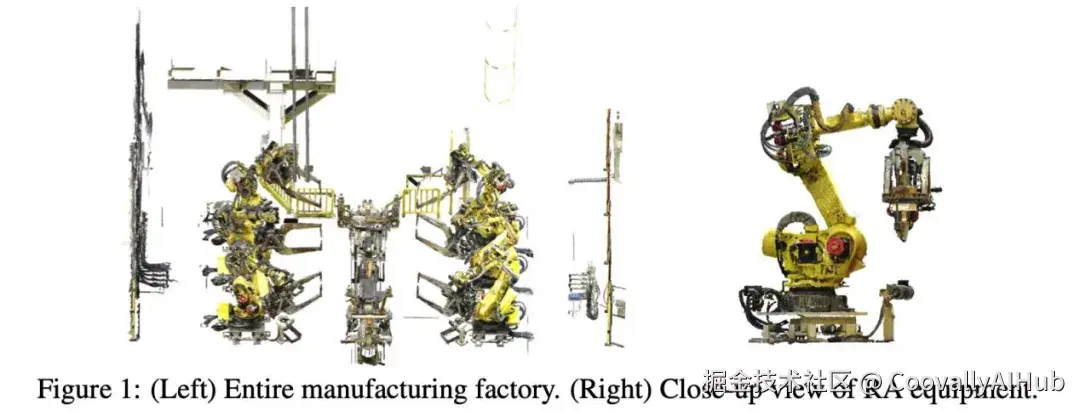

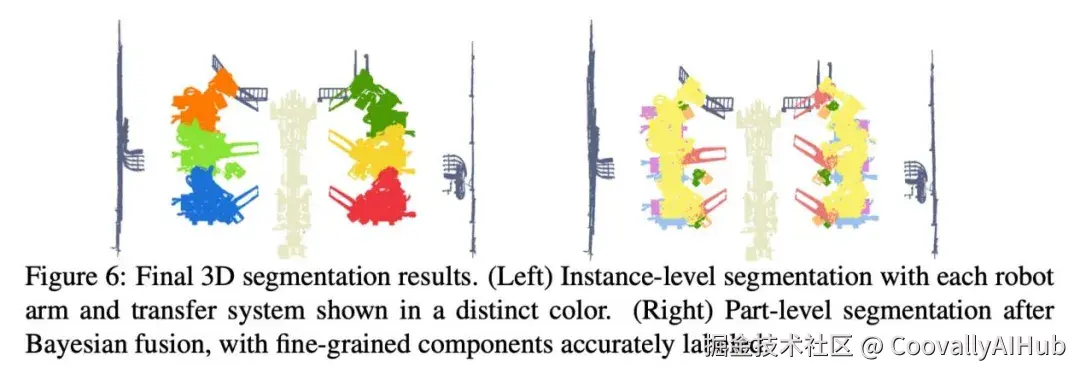

图6展示了整个工业环境的完整分割结果。实例级分割清晰分离了机械臂和传输系统,部件级分割则准确标记了所有工站的组件,展现了框架在复杂工业场景中的有效性。

- 在公开数据集上的泛化评估

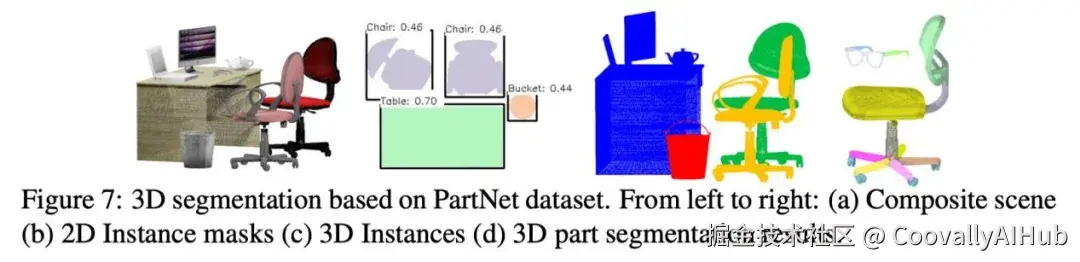

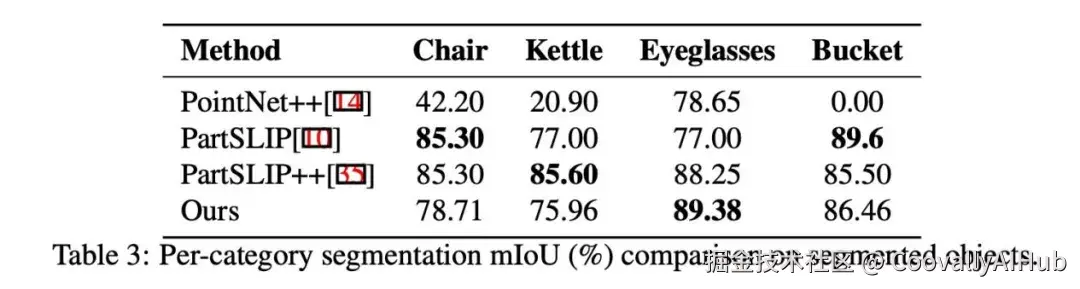

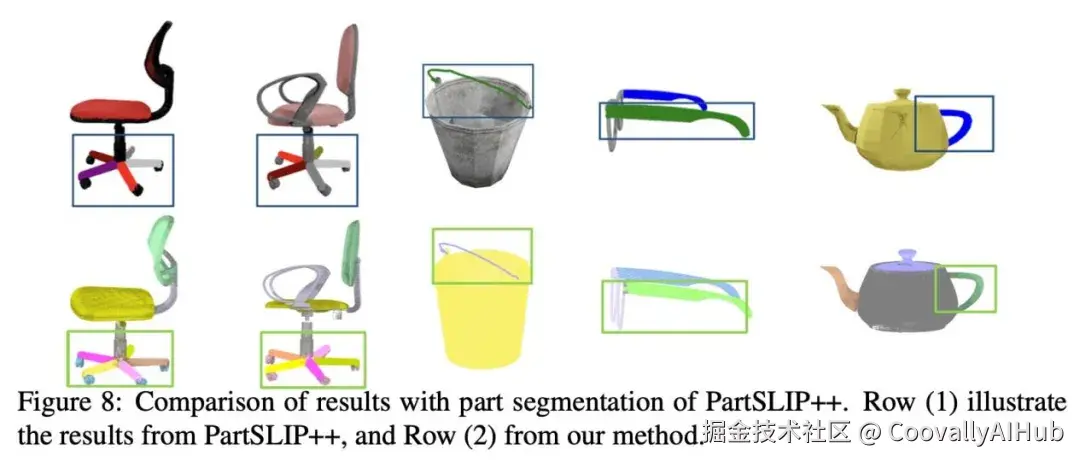

我们在PartNet数据集上进行实验,验证框架在通用3D场景中的泛化能力。通过组合多个物体构建复杂场景,并使用GLIP作为检测模型(无需微调),我们的方法取得了与其他专门方法相近的部件分割精度(表3)。

结论与未来工作

我们提出了一种由2D检测-分割引导的分层3D分割框架,通过YOLO-World提供标签与提示,结合SAM实现从物体到部件的精确分割,并利用贝叶斯融合解决跨视角一致性问题。在真实工厂数据和公开数据集上的实验验证了其在遮挡和杂乱环境下的鲁棒性。

未来工作将考虑融入深度等多模态信息,提升小部件和严重遮挡部件的分割能力,并尝试在多视角一致性建模方面进行改进,直接在2D分割层保证视角一致性,减少后续融合步骤引入的误差。