写在前面:

DingOS 粒子服务用户界面协议(PSUIP)的正式发布,DingOS AIGUI 成功实现从理论探索到实际落地的转变。欢迎大家下载安装体验。并给我们提出反馈意见!使用 SDK 即可将 PSUIP 能力在项目中集成。接入流程简单高效,支持 React、Vue 等主流框架。

三步开启 AIGUI 高效开发

- 安装依赖:执行下列代码;

npm install psuip-renderer

-

编写代码 :参考 PSUIP 官方文档(点击查看),编写携带 UI 语义的内容;

-

查看效果:启动项目后,PSUIP 渲染引擎将自动解析内容并生成界面,无需额外配置。

我们在之前的内容中已经介绍过 AIGUI 及八要素,如果说八要素是 AIGUI 的设计语言,那么元件就是这种语言中最基础的"词汇",通过灵活的排列组合,让 DingOS 能够像搭积木一样动态生成适应用户需求的界面。本期内容,我们将详细聊一聊 AIGUI 的元件体系。

从组件到元件:智能交互的"基因"进化

传统UI开发中的组件(Component)如同固定规格的砖块,虽然可复用但缺乏适应性。AIGUI体系中的元件(Element)则更像乐高积木------保持核心功能一致性的同时,具备无限的可塑性。

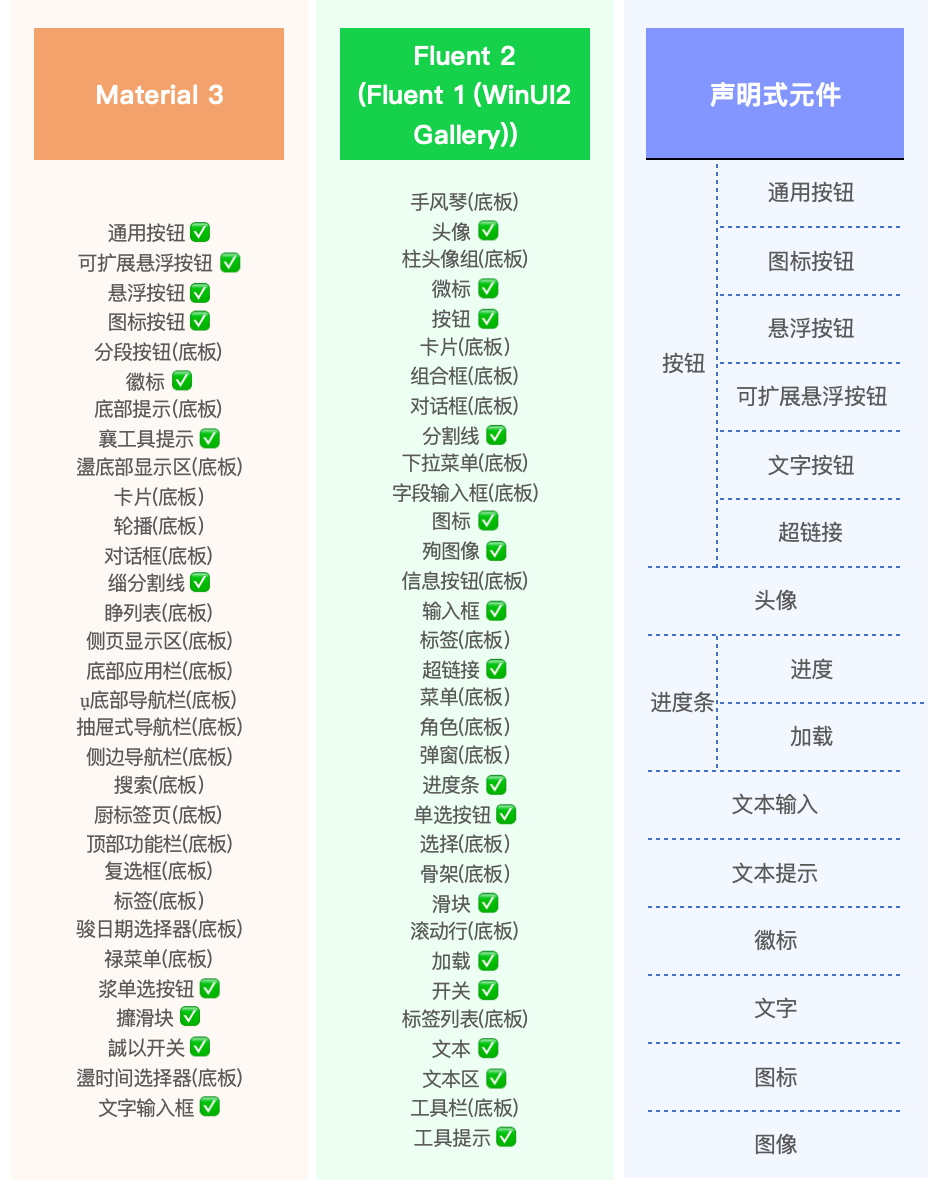

经过梳理、归类,我们定义 DingOS 元件共有 9 种类型,分别是按钮、头像、进度条、文本输入、文本提示、徽标、文字、图标、图像。这 9 种基础类型,通过实时变化、可塑地调节以及组合,可以覆盖现有主流组件库的所有类型,具体对照关系如下图。

DingOS 元件及其对主流组件库的覆盖程度

这种进化源于三大设计原则的革新:

一致性中的多样性

DingOS 的 9 类基础元件通过八要素的动态调节,能在不同场景下呈现差异化形态。例如同一个"按钮"元件,在办公场景可能呈现直角边框的商务风格,而在娱乐场景则自动切换为圆角活泼样式,这种变化不是通过替换组件实现,而是元件内在"色"、"形"等要素值的动态调整。

状态驱动的实时响应

每个元件都内置丰富的交互状态(悬停、点击、加载等),这些状态不仅改变视觉表现,更能触发情境相关的反馈。当用户在办公场景专注处理文档时,按钮的"动"要素会减少动画效果以避免干扰,同时增强"色"要素的对比度以提升可辨识度;当系统检测到用户连续多次点击输入框边缘时,文本输入元件的"度"要素会自动扩展点击热区,并微调"构"要素的间距以优化输入体验。

AI可读的设计语义

元件的每个属性都通过设计令牌(Design Token)引用样式字典中的值,这使得AI能够理解并操作界面样式。例如{color.basic.brand.3}不仅是一个颜色值,更携带了"品牌主色中等亮度"的语义信息,让生成式模型能够进行有意义的样式组合而非随机搭配。

元件的智能编排,从设计到生成

元件的实际应用经历三个阶段演化:

设计阶段

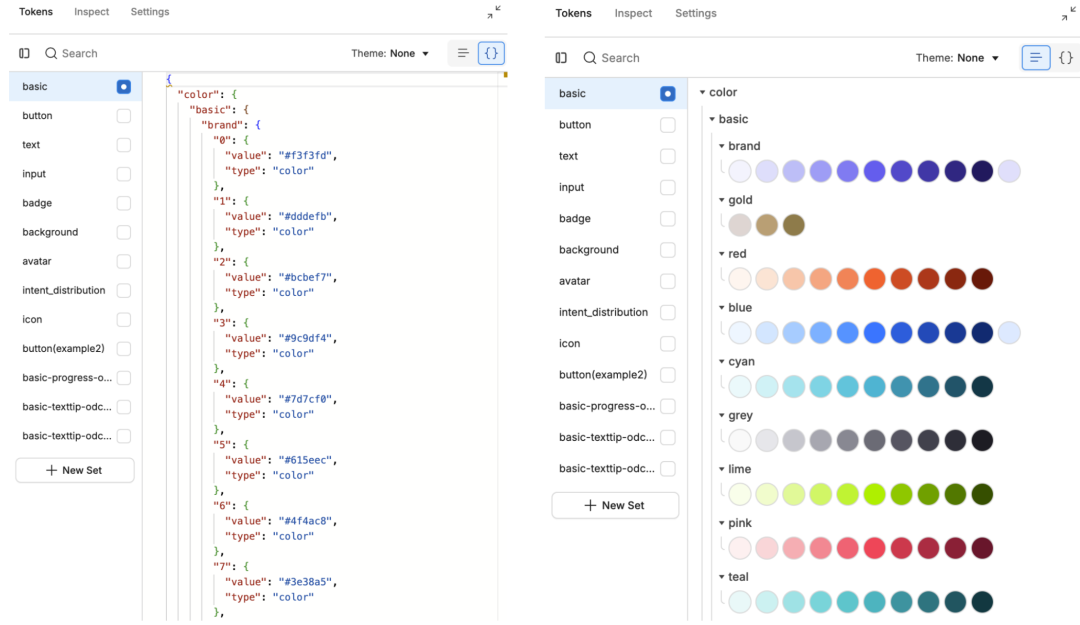

设计师使用 Token Studio 在 Figma 中创建元件库。关键创新在于:不再输出固定样式,而是定义样式可能性。例如设计按钮时,会同时设定多种状态的"形"、"色"值范围,为 AI 生成保留弹性空间。

↑ 在 Token Studio 中导入样式字典

训练阶段

元件库与用户交互数据共同训练生成式模型。样式代理学习如何组合"色"、"质"要素创造视觉和谐;布局代理掌握"构"、"度"要素的适配规则。当模型发现老年用户普遍偏好更大"度"要素值时,会自动调整相关生成策略。

运行时阶段

DingOS 根据实时情境动态生成界面:首先由布局代理按八要素规则创建底板框架,然后样式代理填充具体元件,最后 UI 偏好模型基于用户特征微调。整个过程如同搭建积木的自动组装,例如:

-

识别文档处理场景 → 选择"字"要素更突出的布局

-

学习用户点击习惯 → 优化按钮"动"要素的反馈时机

-

测到用户即将汇报 → 启用高对比度"色"要素

随着 DingOS 生态发展,通过持续学习用户满意度数据,元件逐步实现自主优化其八要素组合策略。就像生物进化一样,使用频率高的元件变体会被保留,低效组合则被淘汰,最终形成适应用户群体的最优界面基因库。元件体系将成为可自我进化的交互语言。

在 DingOS 的智能交互生态中,元件如同精密的"细胞",而底板则是承载这些细胞的"组织"------它不仅是元件组合的容器,更是实现服务与界面智能匹配的关键枢纽。通过八要素中的"构"要素,底板能根据服务类型、设备形态和用户习惯,动态调整元件布局,最终实现根据服务可动态生成的交互界面。

后续我们将深入解析 AIGUI 的"底板引擎",揭秘 DingOS 如何通过动态底板实现"千人多面"的界面生成。

在 DingOS 的愿景中,未来的交互界面将不再是被动使用的工具,而是由智能元件动态组装的服务伙伴。当每个按钮都能理解场景、每处布局都适应用户习惯时,人机交互便真正进入了"不思考的思考"境界------用户无需学习操作,系统自会呈现最合适的交互方式。这正是 AIGUI 元件体系为智能时代准备的设计语言。在服务可以"按需而取"的同时,我们也希望交互范式"按需而生"。目前,AIGUI 体系仍在不断探索中,欢迎广大合作伙伴或开发者朋友们,共同推动这一领域的创新突破与落地实践。

更多相关推荐

PSUIP 深度解析:从原理到集成,手把手教你会用PSUIP

告别静态UI!Guineration用AI打造用户专属动态界面

Gemini 3横空出世,GUI 项目何去何从?