近年来,文本转语音(TTS)合成技术进展显著,已能够为单一说话者合成高保真、听觉自然的短话语。然而,在面对长格式、多说话人对话音频的可扩展合成时,仍存在重要挑战,限制了诸如播客与多角色有声书场景下的应用边界。

传统方法即使通过串联独立合成的话语来生成此类音频,但在实现自然的对话轮流和内容感知生成方面依然不尽人意。随着行业应用需求的不断提升,行业领域已陆续出现针对多说话人长会话语音生成的研究,但多数成果尚未开源,或在生成长度与稳定性方面仍存在待解决的难题。

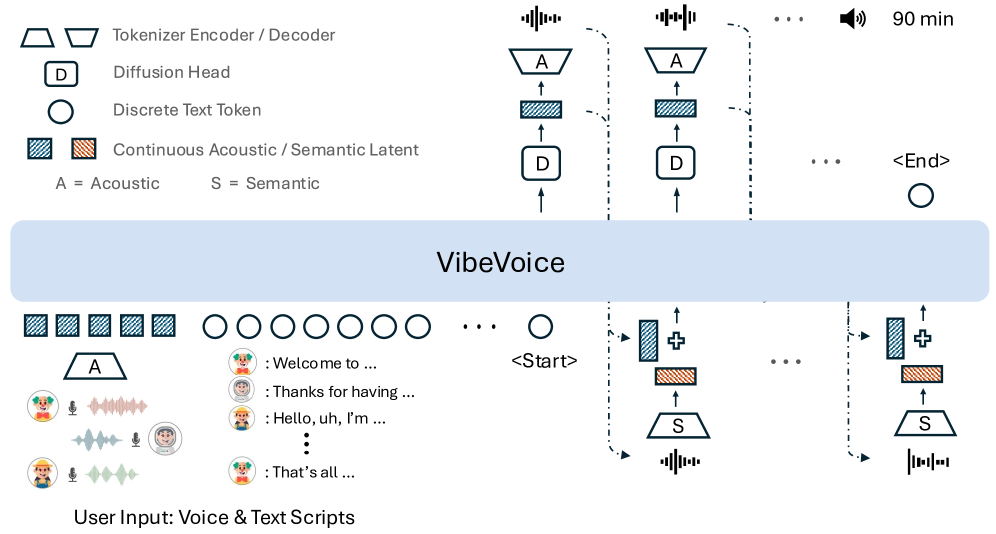

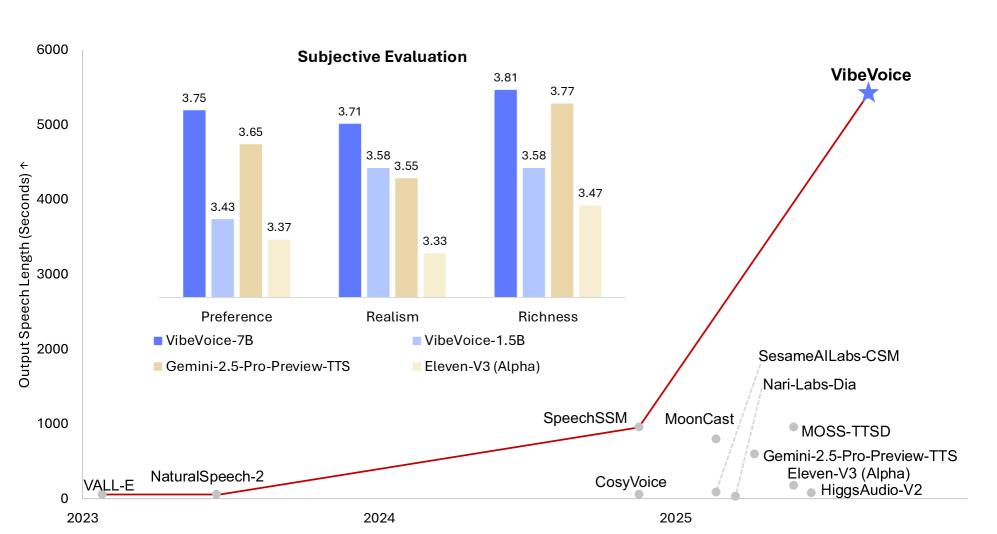

在此背景下,**微软开源了 VibeVoice,旨在实现可扩展的长格式、多说话人语音合成。**VibeVoice 采用基于下一 token 扩散(next-token diffusion)的方法来合成多说话人长语音,这是一种通过扩散自回归生成潜在向量以建模连续数据的统一方法。

为此,研究团队首创了一种新颖的连续语音分词器,与当前流行的 Encodec 模型相比,在保持相当性能的前提下,实现了 80 倍的数据压缩提升,即可实现高达 3200× 的压缩率(对应 7.5 Hz 帧率),在保障音频保真度的同时,显著提高了长序列处理的计算效率。

VibeVoice 架构图

尽管架构简洁,VibeVoice 却展现出极强的能力,**能够在 64K 上下文窗口中合成长达 90 分钟、包含最多 4 名说话人的语音,**音色更为丰富、语调更趋自然,并捕捉真实对话氛围,在跨语言应用中表现出更强的迁移能力,综合表现已超越现有的开源与专有对话模型。

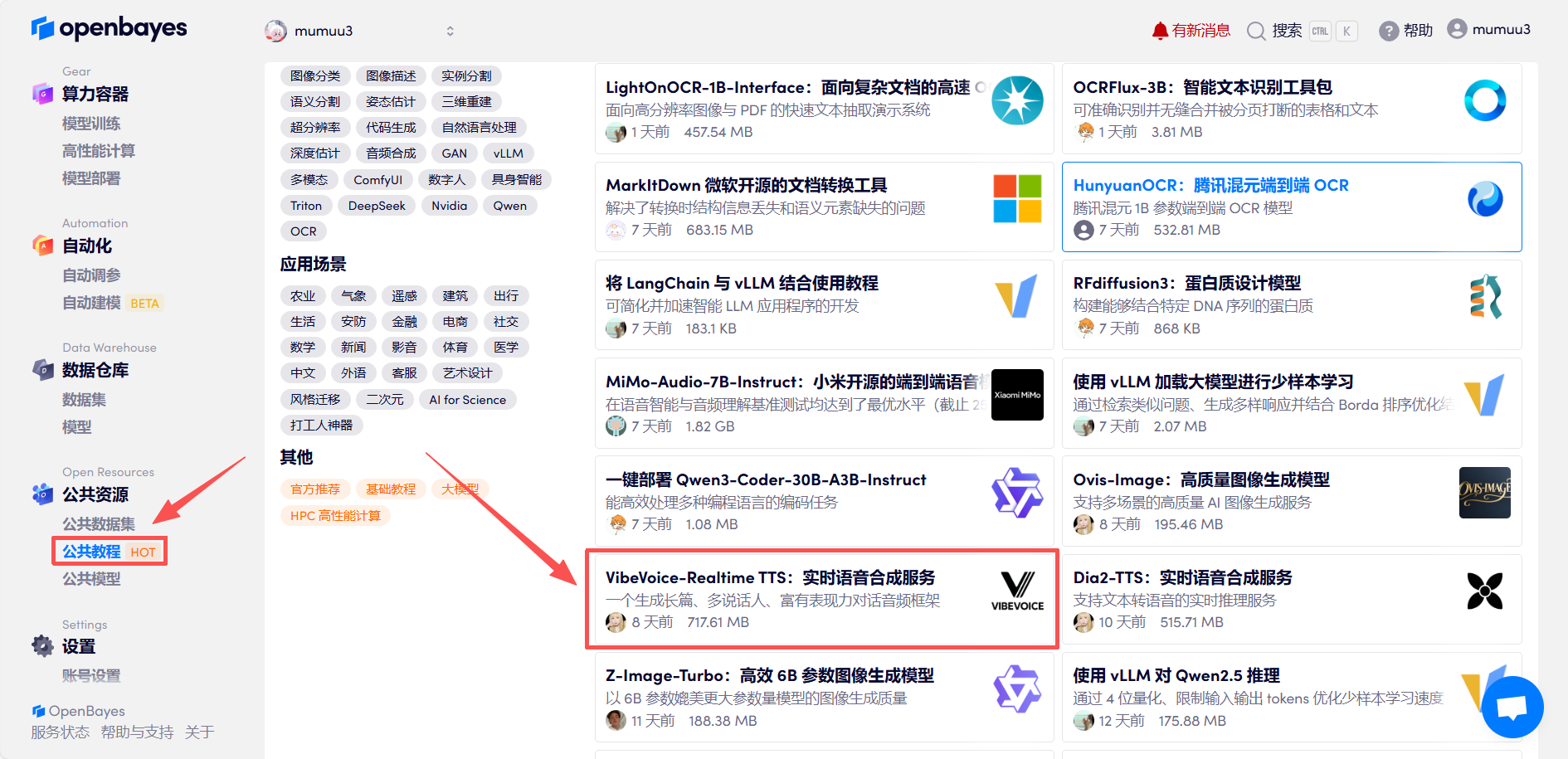

「VibeVoice-Realtime TTS:实时语音合成服务」已上线 OpenBayes 公共教程板块,快来开启你的创作之旅吧!

教程链接:

https://go.openbayes.com/Ra1vR

Demo 运行

01 Demo 运行阶段

1.登录 http://OpenBayes.com,在「公共教程」页面,选择「VibeVoice-Realtime TTS:实时语音合成服务」教程。

2.页面跳转后,点击右上角「克隆」,将该教程克隆至自己的容器中。

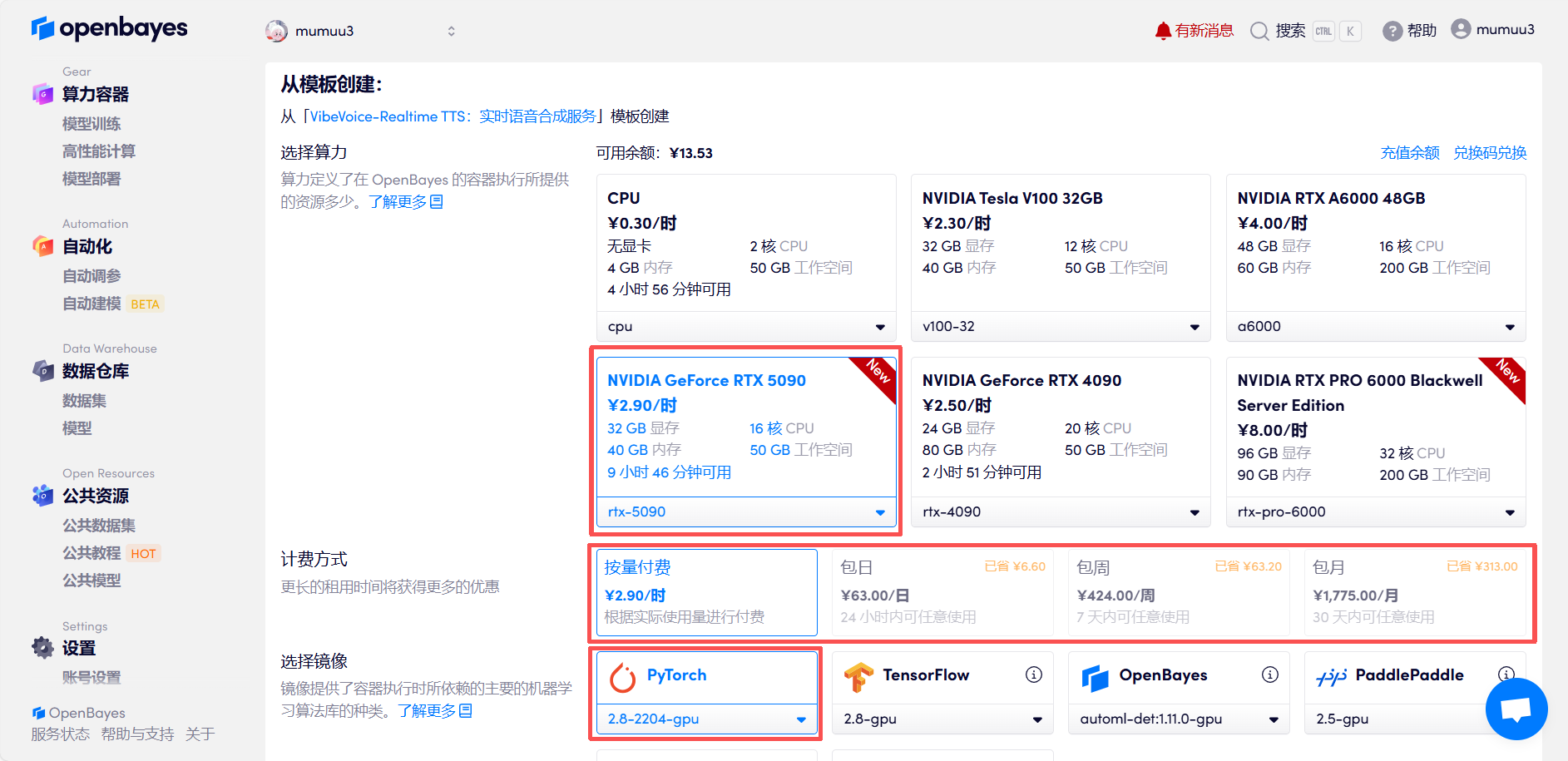

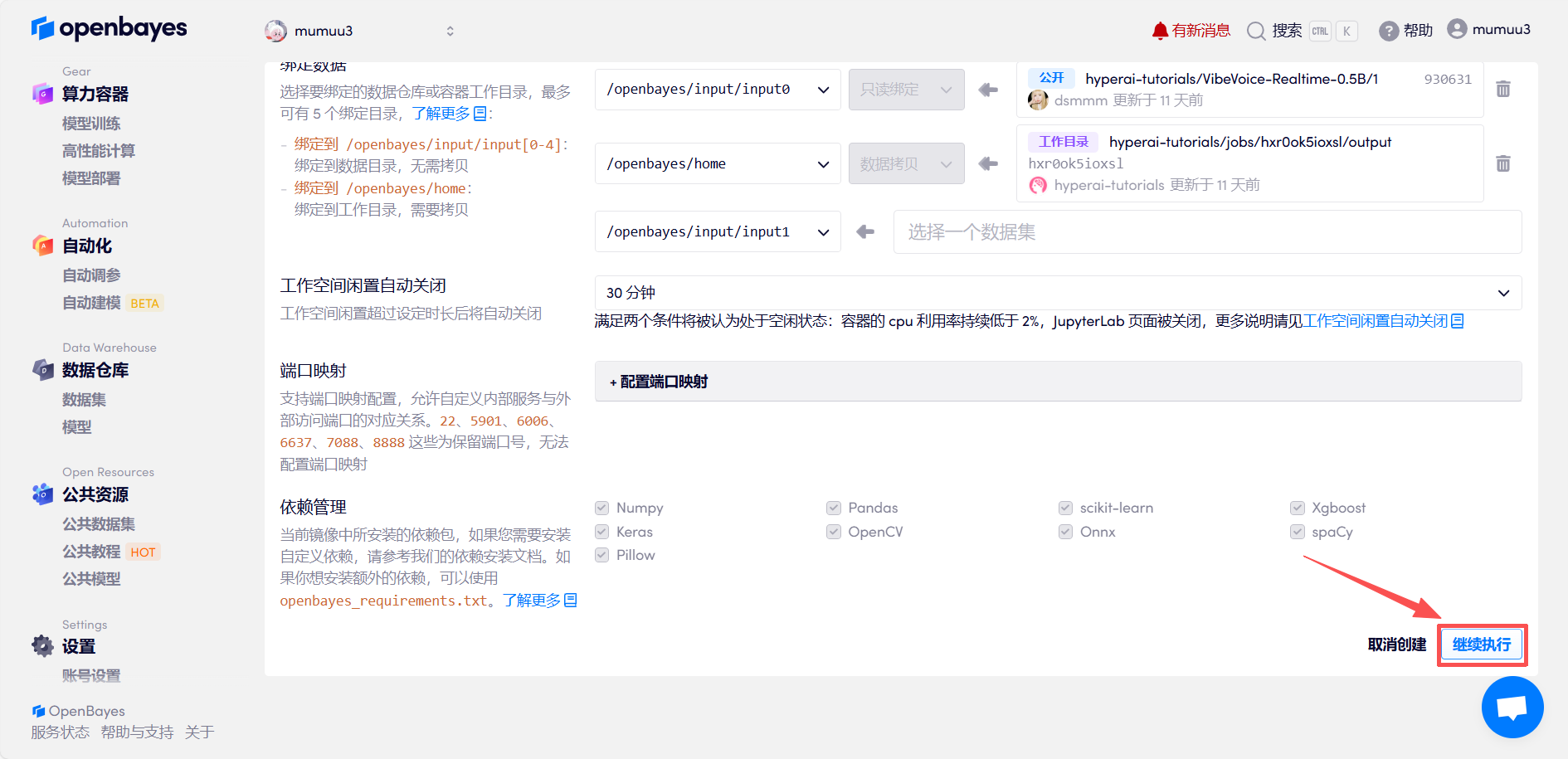

3.选择「NVIDIA GeForce RTX 5090」以及「PyTorch」镜像,按照需求选择「按量付费」或「包日/周/月」,点击「继续执行」。新用户使用下方邀请链接注册,可获得 4 小时 RTX 5090 + 5 小时 CPU 的免费时长!

小贝总专属邀请链接(直接复制到浏览器打开):

https://go.openbayes.com/9S6Dr

4.等待分配资源,首次克隆需等待 3 分钟左右的时间。当状态变为「运行中」后,点击「API 地址」旁边的跳转箭头,即可跳转至 Demo 页面。请注意,用户需在实名认证后才能使用 API 地址访问功能。

02 效果演示

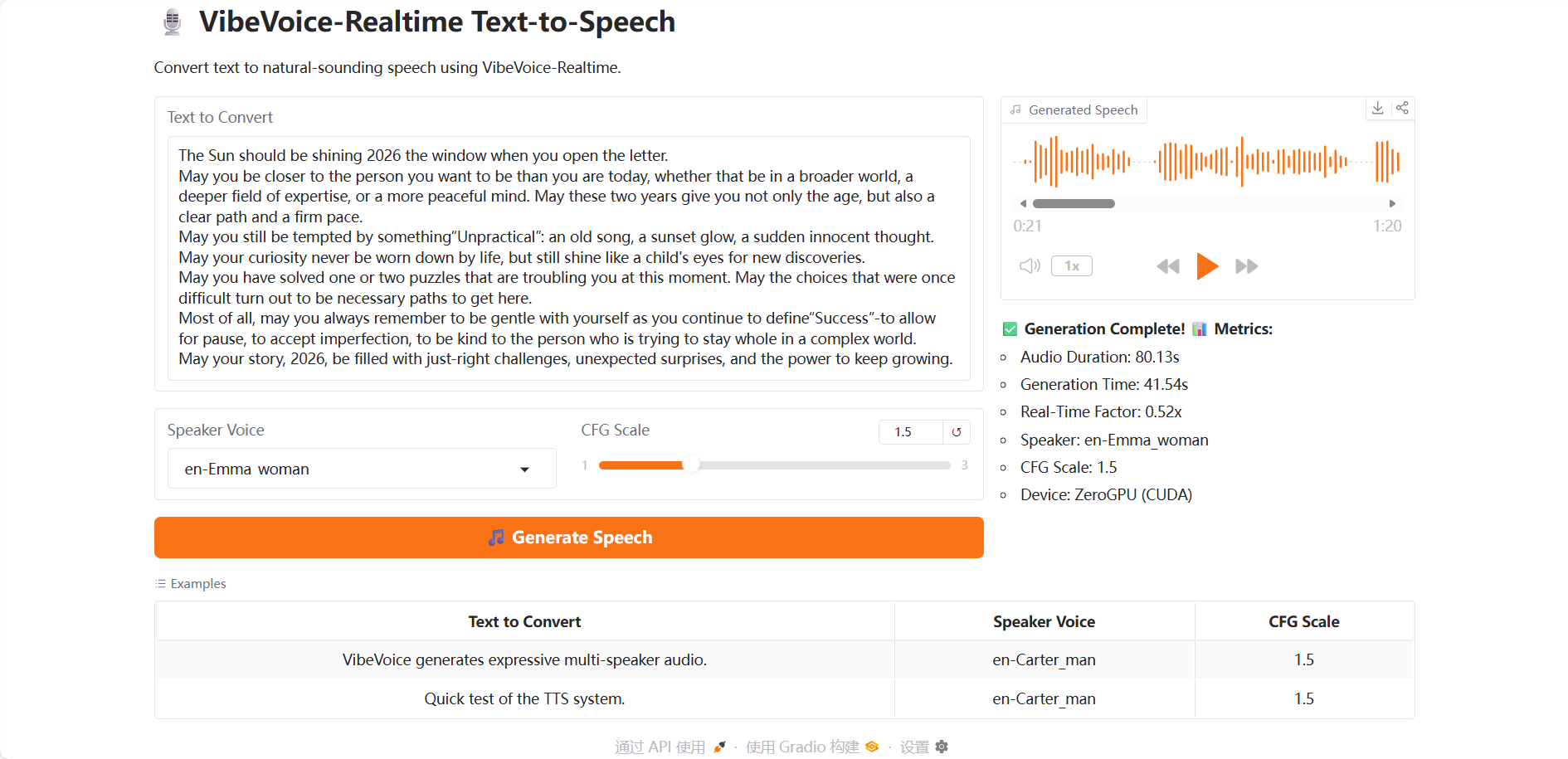

进入 Demo 运行页面后,将测试视频上传后,在「Text to Convert」处输入文本,「Speaker Voice」选项中提供了 7 种可选择的音色,调整「CFG Scale」可以控制语音风格强度,数值越大情感越强。最后点击「Generate Speech」,稍等片刻即可生成音频。

这一年接近尾声,点击播放 VibeVoice 为你送上的新年祝福吧~